Paginering

Paginering delar upp stora innehållsmängder i hanterbara sidor för bättre användarupplevelse och SEO. Lär dig hur paginering fungerar, dess påverkan på sökrankn...

Lär dig hur paginering påverkar AI-synlighet. Upptäck varför traditionell sidindelning hjälper AI-system hitta ditt innehåll medan oändlig scroll döljer det, och hur du optimerar paginering för AI-svarsgeneratorer.

Paginering innebär att dela upp stora innehållsmängder i flera länkade sidor. Ja, det påverkar AI-system avsevärt—paginering skapar distinkta, genomsökningsbara URL:er som hjälper AI-sökmotorer som ChatGPT, Perplexity och Googles SGE att upptäcka och indexera ditt innehåll mer effektivt, medan implementationer med oändlig scroll ofta döljer innehåll för AI-crawlers.

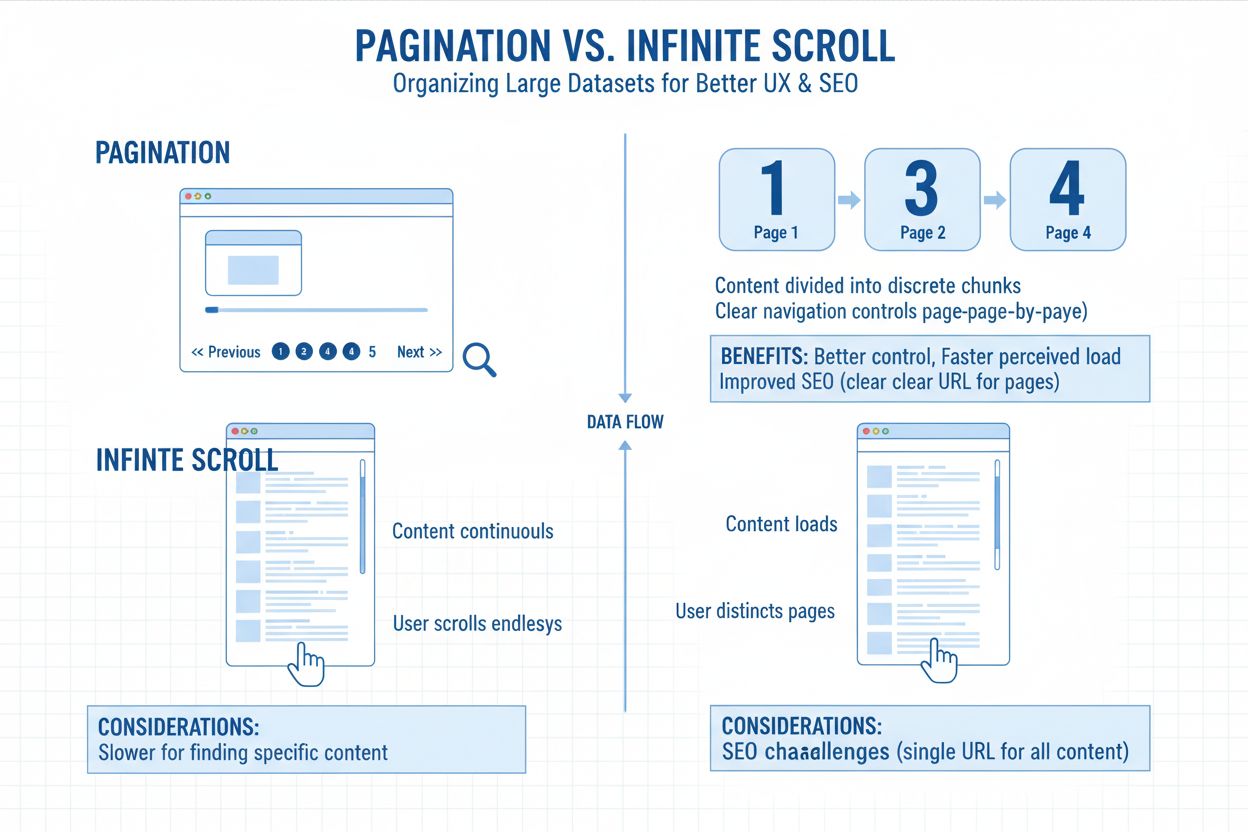

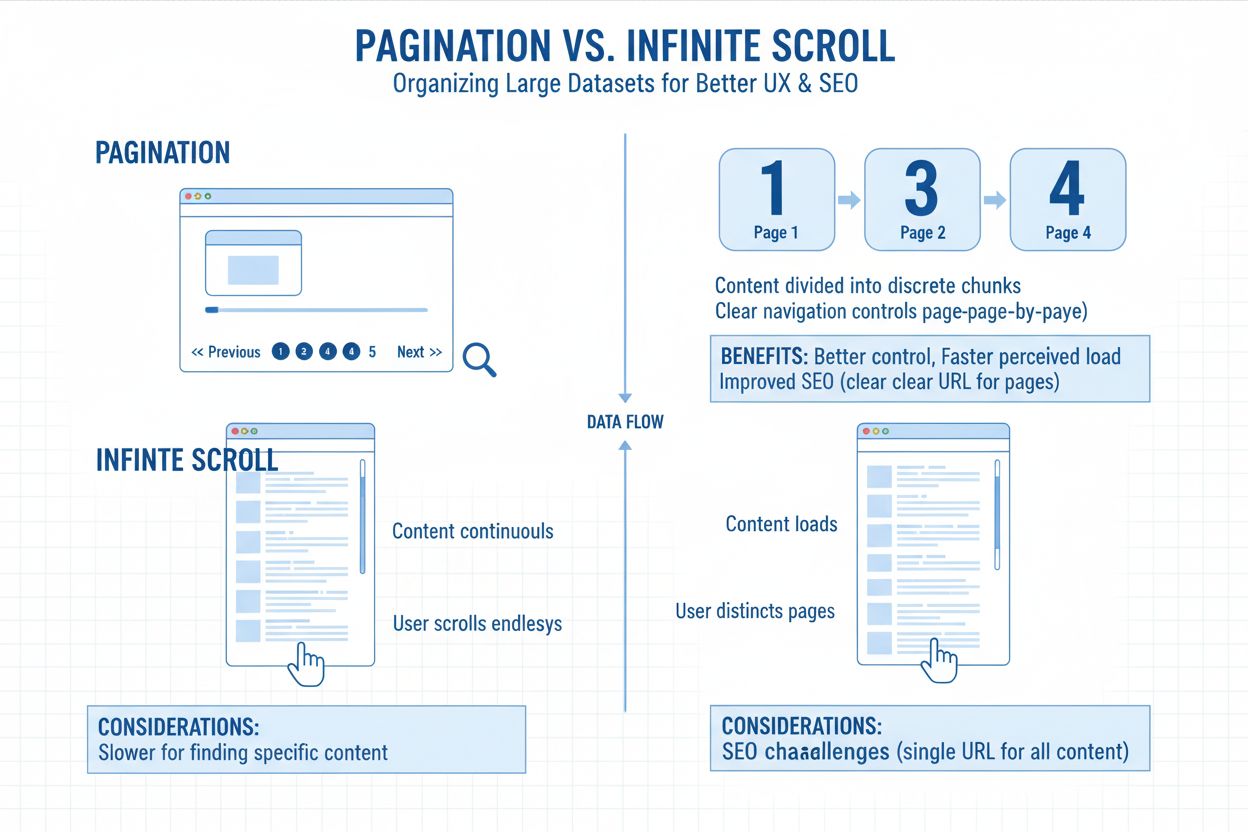

Paginering syftar på att dela upp stora mängder innehåll i flera länkade sidor istället för att visa allt på en enda, oändlig sida. Tänk på det som kapitel i en bok—varje sida innehåller en hanterbar portion av det totala innehållet, sammanlänkade via numrerade länkar eller “nästa/föregående”-knappar. Detta strukturella tillvägagångssätt återfinns överallt från produktlistningar i e-handelsbutiker till bloggarkiv, forumtrådar och sökresultat. URL-strukturen återspeglar vanligtvis denna indelning genom parametrar som ?page=2 eller rena sökvägar som /kategori/sida/2/, vilket gör att både användare och sökmotorer förstår deras position i innehållsserien. Paginering fungerar som ett grundläggande organisatoriskt verktyg som balanserar användarupplevelse med tekniska krav på tillgänglighet.

Webbplatser implementerar paginering främst för prestandaoptimering och innehållsorganisation. Att ladda hundratals eller tusentals objekt samtidigt skulle belasta serverns resurser och skapa långsamma laddningstider, vilket särskilt påverkar prestandamått som påverkar sökrankningar. Användare uppskattar möjligheten att bokmärka specifika sidor, hoppa direkt till sida 10 eller förstå hur mycket innehåll som återstår. Ur ett tekniskt perspektiv skapar uppdelning i sidor distinkta URL:er som sökmotorer kan indexera individuellt, vilket bevarar länkstyrka över webbplatsens arkitektur. Denna strukturella tydlighet blir allt viktigare i takt med att AI-system utvecklas för att förstå innehållsrelationer och tillgänglighetsmönster.

Relationen mellan paginering och AI-synlighet är en av de mest kritiska tekniska SEO-aspekterna i dagens söklandskap. Traditionella sökmotorer som Google har länge förstått paginering genom att crawla länkar och följa sekventiella sidmönster. Men AI-drivna sökmotorer och svarsgeneratorer fungerar fundamentalt annorlunda och kräver ett mer nyanserat tillvägagångssätt för innehållsorganisation. Stora språkmodeller som driver ChatGPT, Perplexity och Googles Search Generative Experience (SGE) crawlar inte nödvändigtvis sidor linjärt eller följer traditionella navigationshierarkier. Istället arbetar de genom att tokenisera och sammanfatta textuell input—ofta hämtad från offentlig data, API:er eller strukturerade databaser snarare än crawl-djupa hierarkier.

När ditt innehåll är utspritt över flera, minimalt strukturerade sidor kan AI-motorer hoppa över djupare poster eller missförstå deras relation till den bredare innehållsmängden. Om det är liten variation i metadata eller tunna semantiska signaler framstår ditt paginerade innehåll som redundant—eller förbises helt. Detta skapar ett kritiskt synlighetsgap: innehåll som rankar bra i traditionell Google-sökning kan vara helt osynligt för AI-svarsgeneratorer. Skillnaden är viktig eftersom AI-system prioriterar strukturerad, komplett och lättillgänglig data. De “scrollar” inte som en användare. De tolkar kod, URL:er och metadata för att sammanfatta eller citera innehåll med hastighet och precision. Om din sida inte exponerar innehåll via crawlbara URL:er eller rik metadata kan AI-motorerna inte hämta det till genererade svar.

Valet mellan traditionell paginering och oändlig scroll har blivit avgörande för AI:s upptäckbarhet av innehåll. Implementationer med oändlig scroll laddar innehåll via JavaScript först efter användarinteraktion, vilket skapar ett grundläggande tillgänglighetsproblem för AI-crawlers. De flesta lösningar med oändlig scroll exponerar inte innehåll via distinkta URL:er—istället laddas allt på en och samma sida genom dynamisk JavaScript-exekvering. Det innebär att AI-crawlers, som inte simulerar verkligt användarbeteende som att scrolla eller klicka, ofta missar allt utöver första vyn. Om din sida inte exponerar det extra innehållet via crawlbara URL:er eller metadata, kan AI-motorerna inte hämta det. Du kan ha 200 artiklar, 300 produkter eller dussintals case studies, men om de ligger gömda bakom JavaScript-utlösta laddningshändelser ser AI bara 12 objekt. Kanske.

Traditionell paginering är fortfarande överlägsen för AI-indexering eftersom den skapar rena, crawlbara URL:er (t.ex. /blogg/sida/4), vilket gör det möjligt för motorer att nå och segmentera hela ditt innehåll. Den signalerar ämnesstruktur genom interna länkar, med standardiserade länkar som “Nästa sida” eller “Föregående sida” för att hjälpa motorer se hur innehållet hänger ihop. Paginering minskar beroendet av JavaScript och säkerställer att ditt innehåll laddas för crawlers oavsett hur användaren interagerar med sidan. Denna strukturella tydlighet översätts direkt till bättre AI-synlighet—när ChatGPT eller Perplexity crawlar din webbplats kan de upptäcka och indexera paginerat innehåll betydligt mer effektivt än innehåll som är dolt bakom oändlig scroll.

| Aspekt | Paginering | Oändlig scroll |

|---|---|---|

| Crawl-tillgänglighet | Unika URL:er möjliggör djup indexering | Innehåll ofta dolt bakom JS-laddning |

| AI-upptäckbarhet | Flera sidor kan ranka oberoende | Vanligen endast en sida indexerad |

| Strukturerad data | Lättare att tilldela till individuella sidor | Ofta saknas eller utspädd |

| Direktlänkning | Lätt att länka till specifikt innehåll | Svårt att skapa djupa länkar |

| Sitemap-kompatibilitet | Kompatibel och komplett | Saknar ofta djupare innehåll |

| URL-struktur | Klara, distinkta URL:er per sida | En URL med dynamisk laddning |

| Innehållssynlighet | Allt innehåll tillgängligt för crawlers | Innehåll kräver JS-exekvering |

Den tekniska arkitekturen för oändlig scroll skapar grundläggande hinder för AI:s upptäckt av innehåll. När innehåll endast laddas via JavaScript och inga URL:er återspeglar nytt innehåll, ser AI-motorerna det aldrig. För en crawler existerar helt enkelt inte resten av din lista. Detta är inte en begränsning i AI-systemen—det är en konsekvens av hur oändlig scroll vanligtvis implementeras. De flesta implementationer prioriterar användarupplevelse framför teknisk tillgänglighet, och laddar innehåll dynamiskt utan att skapa motsvarande URL:er eller metadata som AI-system kan tolka.

Tänk dig ett verkligt scenario: en global modeåterförsäljare designade om sin sajt med ett snyggt oändlig scroll-gränssnitt. Sidans hastighet förbättrades, engagemangsmåtten såg bra ut, men trafiken från AI-sammanfattningar minskade dramatiskt. Deras varunummer verkade försvinna i konversationella sökverktyg. Efter en teknisk granskning blev problemet tydligt: hela katalogen låg gömd bakom oändlig scroll utan crawlbara reservlösningar. Inga sekundära sid-URL:er. Inga kompletterande länkar. Bara en lång, osynlig produktlista. Google SGE och ChatGPT kunde inte nå mer än de första dussinet produkter per kategori. Sidan såg snygg ut, men dess upptäckbarhet för AI-system var trasig.

Korrekt implementation av paginering kräver uppmärksamhet på flera tekniska faktorer som tillsammans avgör om AI-system kan upptäcka och citera ditt innehåll. Grunden är rena, logiska URL-strukturer som tydligt visar sekventiella relationer. Oavsett om du använder frågeparametrar (?page=2) eller sökvägsbaserade strukturer (/sida/2/), är konsekvens viktigare än det specifika formatet. Båda tillvägagångssätten fungerar lika bra för AI-system när de är rätt implementerade. Det viktiga är att varje paginerad URL laddar distinkt innehåll och är tillgänglig via standard-HTML-länkar som inte kräver JavaScript-exekvering.

Självrefererande kanoniska taggar är en kritisk punkt i pagineringsstrategin. Varje paginerad sida bör inkludera en kanonisk tagg som pekar på sig själv, vilket signalerar att varje sida är den föredragna versionen av sig själv. Detta bevarar självständigheten för sekventiella URL:er och gör att varje sida kan tävla om ranking baserat på sitt specifika innehåll och relevans för olika sökfrågor. Undvik den föråldrade metoden att kanonisera alla paginerade sidor till sida ett—det konsoliderar signaler men eliminerar möjligheten för individuella sidor att ranka självständigt i AI-system. När du kanoniserar allt till sida ett säger du explicit till AI att ignorera potentiellt värdefulla sidor med unika produkter, innehåll eller information.

Unik metadata för varje sida är avgörande för AI-synlighet. Använd inte generiska “Sida 2”-titlar eller duplicerade beskrivningar över din sekvens. Skriv istället sid-specifik, sökordsrik metadata som återspeglar varje sidas fokus. Exempel: istället för “Produkter - Sida 2”, använd “Damens löparskor under 1000 kr – Sida 2” eller “AI-trender inom detaljhandel – Fallstudiebibliotek (Sida 2)”. Denna tydlighet driver synlighet eftersom AI-system förstår kontext och lättare kan avgöra när ditt innehåll är relevant för specifika frågor. Varje metadata måste följa principerna tydlighet, unikhet och sökordsanpassning. Målet är att göra varje sidas syfte uppenbart för både AI-system och mänskliga läsare.

Intern länkstruktur avgör om AI-system kan upptäcka och effektivt navigera genom sekventiella sidor. En linjär struktur (sida 1 → 2 → 3) skapar långa crawl-vägar där djupa sidor ligger många klick från startsidan, vilket riskerar att värdefullt innehåll förblir oupptäckt. Smarta implementationer inkluderar kompletterande länkar som “Visa alla”-alternativ eller kategorinav som länkar direkt till nyckelsidor, vilket minskar crawl-djupet och fördelar länkstyrka jämnare. Förhållandet mellan fasetterad navigation och sekventiella sidor ökar komplexiteten, eftersom filterkombinationer kan generera tusentals URL-varianter. Korrekt intern länkning säkerställer att prioriterade sidor får tillräcklig crawl-uppmärksamhet medan mindre viktiga kombinationer nedprioriteras via strategisk användning av noindex-taggar eller kanoniska signaler.

Strategiska interna länk-kedjor från pelarinnehåll till specifika paginerade sidor guidar AI-system genom din innehållsstruktur. Från din huvudkategori-sida, länka direkt till specifika paginerade sidor med länktext som hjälper AI att förstå. Exempel: “Utforska fler e-handelsframgångar i vår fallstudieserie – sida 3.” Gör signalen meningsfull och enkel att hitta. Detta lär AI-system hur ditt innehåll hänger samman och hur det ska upptäckas. När AI-crawlers stöter på dessa kontextuella länkar, förstår de relationen mellan sidor och kan bättre avgöra vilket innehåll som är mest relevant för specifika frågor.

Dubblettinnehållsproblem uppstår när flera URL:er visar identiskt eller nästan identiskt innehåll utan ordentlig differentiering. Detta händer när sekventiella sidor saknar unika element utöver listade objekt, eller när URL-parametrar skapar flera vägar till samma innehåll. Sökmotorer och AI-system har svårt att avgöra vilken version som ska rankas och kan fragmentera synligheten över flera URL:er. Om paginerade sidor dessutom innehåller standardsidor, rubriker och footers med minimalt unikt innehåll kan de uppfattas som tunna sidor med lågt värde. Lösningen är noggrann användning av kanoniska taggar, unika metabeskrivningar för varje sida och att säkerställa att varje sida erbjuder tillräckligt distinkt värde utöver navigationselement och mallsektioner.

Endast JavaScript-implementationer är kanske det vanligaste misstaget som döljer innehåll för AI-system. Om din sajt använder ramverk som React eller Angular för att rendera sidkontroller på klientsidan utan serverside rendering, kan AI-crawlers missa allt innehåll utöver sida ett. Säkerställ att navigationslänkar finns i den initiala HTML:en som AI-systemen får, inte bara genereras via JavaScript efter sidladdning. Använd progressiv förbättring—grundläggande HTML-länkar som JavaScript kan förstärka med smidigare interaktioner och animationer. Testa din implementation med verktyg som visar exakt vad crawlers ser jämfört med vad JavaScript-aktiverade webbläsare visar. Detta avslöjar luckor i crawlbarheten som kan kosta dig AI-synlighet.

Att följa pagineringseffektivitet kräver övervakning av hur AI-system interagerar med ditt flersidiga innehåll. Till skillnad från traditionell SEO där Google Search Console ger direkta insikter, kräver AI-synlighetsövervakning andra metoder. Verktyg som Screaming Frog SEO Spider kan crawla din webbplats på liknande sätt som AI-system kan nå den, kartlägga sidstrukturer och identifiera föräldralösa sidor eller crawl-djupsproblem. DeepCrawl och Sitebulk erbjuder avancerad analys med visualisering av sidsamband. Google Search Console ger insikter ur Googles perspektiv och visar vilka paginerade URL:er som indexeras och mönster för crawlfrekvens.

Viktiga nyckeltal för paginerat innehåll är om djupa sidor syns i AI-genererade svar, hur ofta AI-system citerar ditt paginerade innehåll och om olika sidor rankar för olika long-tail-sökningar. Följ dina varumärkesomnämnanden i AI-svar—om AI-system konsekvent citerar din sida ett men aldrig nämner djupare sidor, behöver din pagineringsstruktur optimeras. Spåra vilka paginerade sidor som driver mest trafik från AI-källor. Denna data visar om din pagineringsstrategi effektivt exponerar innehåll för AI-system eller om en omstrukturering krävs. Regelbundna revisioner fångar problem innan de påverkar synligheten, särskilt efter uppdateringar eller byte av ramverk.

Landskapet för AI-drivna sökningar utvecklas snabbt, med nya system och funktioner som lanseras regelbundet. Pagineringstrategier som fungerar idag bör fortsätta vara effektiva i takt med att AI-system blir mer sofistikerade, men att ligga steget före kräver förståelse för nya trender. AI-drivna sökalgoritmer har blivit allt skickligare på att förstå innehållsrelationer och avgöra vilka paginerade sidor som förtjänar indexeringsprioritet. Googles neurala matchning och BERT-baserade förståelse hjälper sökmotorer att känna igen att sida två i en kategori erbjuder andra produkter än sida ett, även om omkringliggande text är liknande. Denna förbättrade förståelse innebär att välstrukturerad sidindelning med meningsfulla skillnader mellan sidor gagnas mer än någonsin av självständig indexering.

Samtidigt upptäcker AI lättare verkligt tunt eller duplicerat innehåll på paginerade sidor, vilket gör det svårare att fuska med knappt differentierade sidor. Maskininlärningsalgoritmer förutspår användarintention mer exakt och kan lyfta fram djupa paginerade sidor för specifika long-tail-sökningar när just de sidorna matchar sökintention bäst. Den praktiska implikationen är att varje paginerad sida måste erbjuda verkligt unikt värde—distinkta produkter, annat innehåll eller meningsfulla variationer—snarare än bara mekanisk uppdelning av identisk information. I takt med att AI-system fortsätter utvecklas är grundprincipen densamma: distinkta URL:er, crawlbara länkar, unikt värde per sida och tydlig metadata kommer fortsatt avgöra pagineringens effektivitet för AI-synlighet.

Följ hur ditt innehåll visas i AI-genererade svar i ChatGPT, Perplexity och andra AI-sökmotorer. Se till att ditt varumärke citeras när AI-system besvarar frågor om din bransch.

Paginering delar upp stora innehållsmängder i hanterbara sidor för bättre användarupplevelse och SEO. Lär dig hur paginering fungerar, dess påverkan på sökrankn...

Content pruning är den strategiska borttagningen eller uppdateringen av underpresterande innehåll för att förbättra SEO, användarupplevelse och synlighet i sök....

Index-täckning mäter vilka webbsidor som indexeras av sökmotorer. Lär dig vad det innebär, varför det är viktigt för SEO och hur du övervakar och åtgärdar index...