Vad är för-rendering för AI-sök?

Lär dig hur för-rendering hjälper din webbplats att synas i AI-sökresultat från ChatGPT, Perplexity och Claude. Förstå den tekniska implementeringen och fördela...

Server-side-renderingsstrategier som är specifikt optimerade för AI-crawlers tillgång. AI-förgenerering levererar förgenererad statisk HTML till artificiella intelligens-crawlers samtidigt som den dynamiska upplevelsen för mänskliga användare bibehålls, vilket säkerställer att AI-system kan få fullständig åtkomst till och indexera innehåll som annars skulle vara dolt bakom JavaScript-krav.

Server-side-renderingsstrategier som är specifikt optimerade för AI-crawlers tillgång. AI-förgenerering levererar förgenererad statisk HTML till artificiella intelligens-crawlers samtidigt som den dynamiska upplevelsen för mänskliga användare bibehålls, vilket säkerställer att AI-system kan få fullständig åtkomst till och indexera innehåll som annars skulle vara dolt bakom JavaScript-krav.

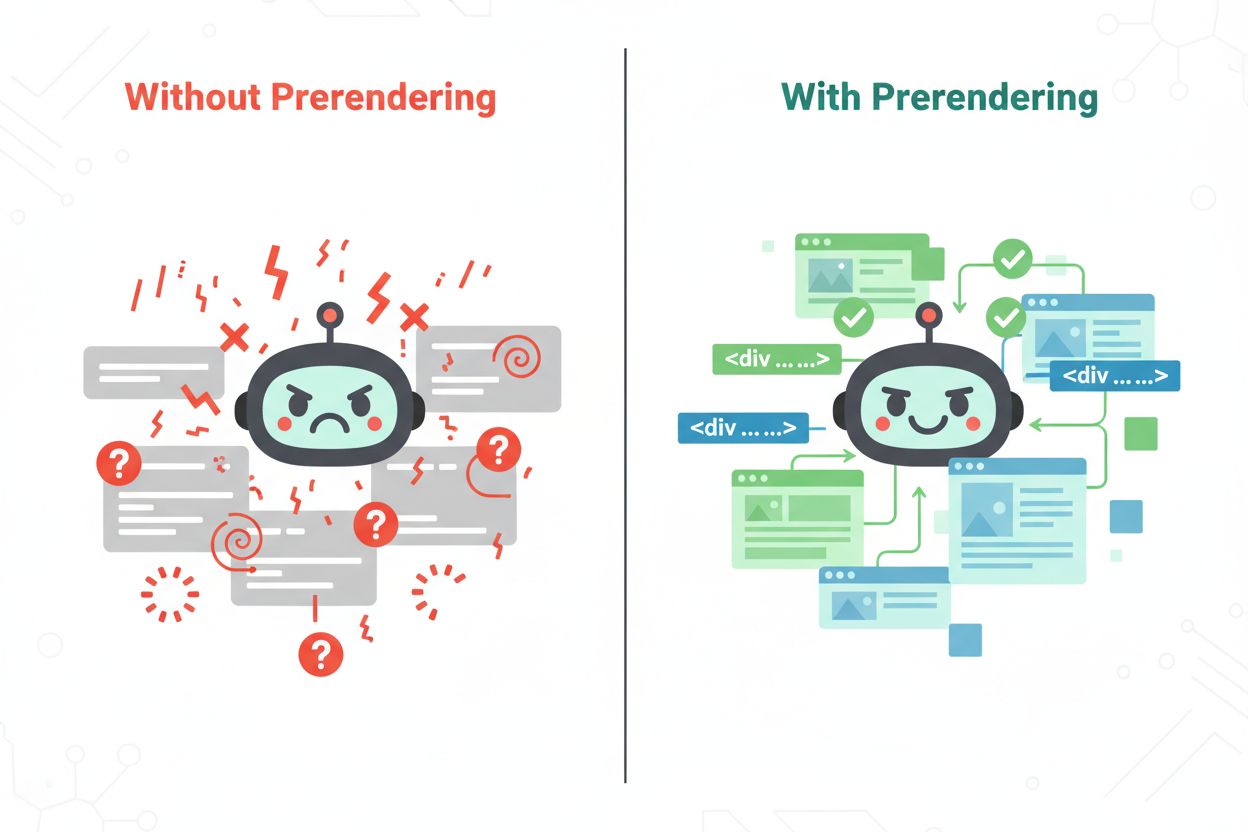

AI-förgenerering är en server-side-renderingsstrategi som är specifikt utformad för att optimera hur artificiella intelligens-crawlers får tillgång till och indexerar dynamiskt webbplatsinnehåll. Till skillnad från traditionella webbcrawlers som främst tjänar mänskliga användare har AI-crawlers från tjänster som GPTBot, ClaudeBot och PerplexityBot unika krav för att förstå sidans innehåll, särskilt när detta genereras dynamiskt via JavaScript. Den grundläggande utmaningen ligger i att många moderna webbplatser är starkt beroende av JavaScript på klientsidan för att rendera sitt innehåll, vilket skapar synlighetsproblem för AI-system som behöver förstå vilken information som faktiskt finns tillgänglig på en sida. AI-förgenerering åtgärdar denna lucka genom att leverera förgenererad statisk HTML direkt till AI-crawlers, vilket säkerställer att de får fullt renderat innehåll utan att behöva köra JavaScript. Detta tillvägagångssätt har blivit allt viktigare i takt med att generativa AI-system utökar sina träningsdatakällor och företag inser värdet av att vara korrekt indexerade av dessa nya AI-drivna sök- och upptäcktsystem. Att förstå och implementera AI-förgenerering är nu en avgörande del av modern SEO och strategi för synlighet av innehåll.

Den grundläggande utmaningen som AI-förgenerering löser uppstår ur hur JavaScript-tunga webbplatser interagerar med olika typer av crawlers. Traditionella AI-crawlers, till skillnad från moderna webbläsarbaserade crawlers, kan ofta inte eller väljer att inte köra JavaScript-kod, vilket innebär att de endast ser det initiala HTML-skalet av en sida snarare än det fullt renderade innehåll som användare upplever. Detta skapar en betydande synlighetslucka där dynamiskt innehåll—produktlistningar, personliga rekommendationer, realtidsdata och interaktiva element—förblir osynligt för AI-system. Tabellen nedan illustrerar hur olika renderingsmetoder påverkar AI-crawlers synlighet jämfört med användarupplevelsen:

| Renderingstyp | AI-crawler-synlighet | Användarupplevelse |

|---|---|---|

| Klientbaserad rendering | Dålig – ser endast HTML-skal, missar dynamiskt innehåll | Utmärkt – full interaktivitet och responsivitet |

| Serverbaserad rendering | Bra – får förgenererad HTML med innehåll | Bra – snabb initial inladdning med full funktionalitet |

| Förgenerering | Utmärkt – optimerad statisk HTML för crawlers | Utmärkt – kan kombineras med klientbaserad hydrering |

Specifika AI-crawlers som GPTBot (OpenAI), ClaudeBot (Anthropic) och PerplexityBot har alla olika crawlingförmågor och begränsningar för JavaScript-exekvering. Även om vissa nyare AI-crawlers har förbättrad hantering av JavaScript har många fortfarande problem med komplex dynamisk rendering, vilket gör förgenerering till en pålitlig lösning för att säkerställa konsekvent synlighet hos samtliga större AI-system. Skillnaden mellan vad en AI-crawler ser och vad en mänsklig användare ser kan avgöra om du inkluderas i AI-träningsdata eller blir i praktiken osynlig för generativa AI-system.

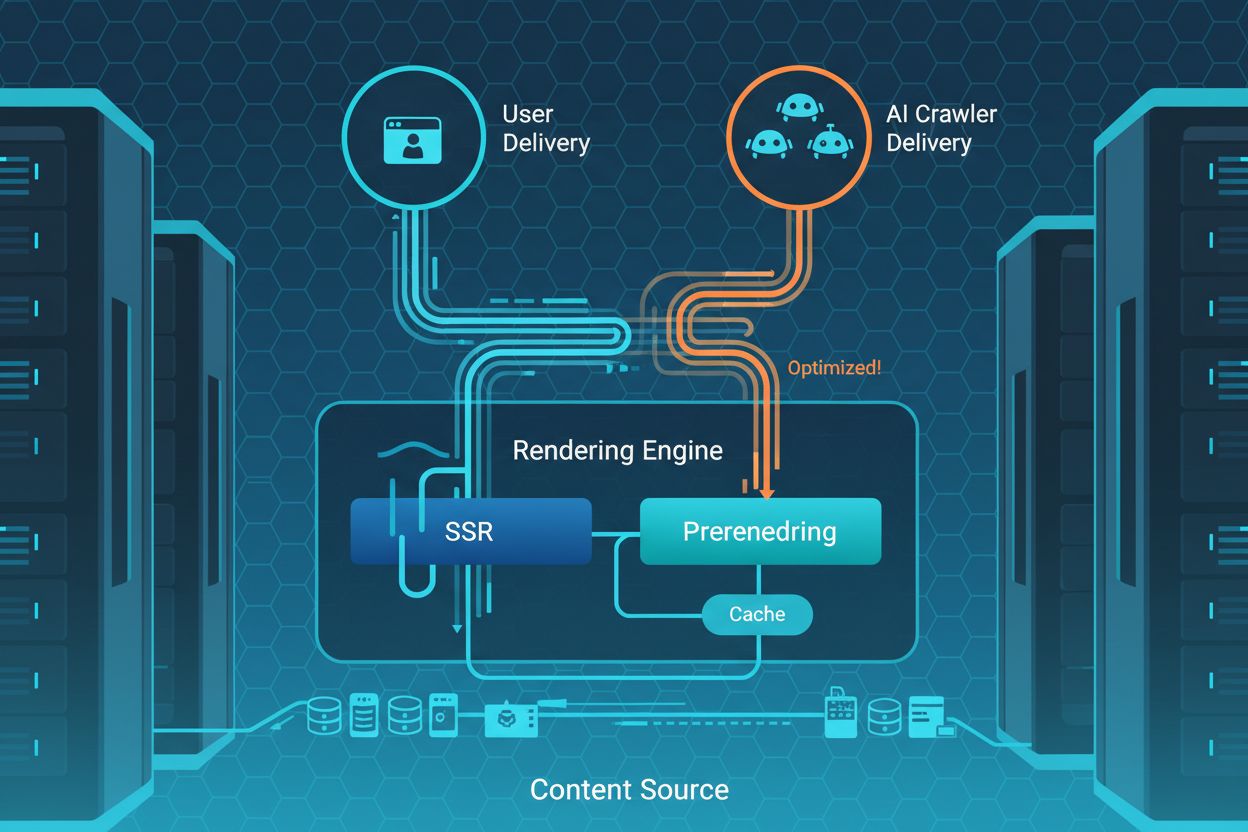

AI-förgenerering fungerar genom att snappa upp förfrågningar från identifierade AI-crawlers och leverera förgenererade statiska HTML-versioner av dina sidor, istället för de dynamiska JavaScript-beroende versionerna som levereras till vanliga användare. Den tekniska processen följer ett enkelt flöde: när en AI-crawler gör en förfrågan till din server identifierar ett detekteringssystem den som en AI-bot genom analys av user agent; systemet hämtar därefter antingen en cachad förgenererad version av sidan eller genererar en på begäran; och levererar slutligen den statiska HTML:n direkt till crawlern utan krav på någon JavaScript-exekvering. Tjänster som Prerender.io har gjort detta tillvägagångssätt populärt genom att erbjuda mellanvarulösningar som automatiserar processen, fångar fullt renderade sidor och levererar dem till crawlers samtidigt som den ursprungliga dynamiska upplevelsen för mänskliga besökare bibehålls. Konceptet “hydrering”—där en statisk HTML-sida förbättras med JavaScript-interaktivitet efter inladdning—gör att webbplatser kan bibehålla rika användarupplevelser samtidigt som de erbjuder rent, crawl-vänligt innehåll till AI-system. Detta dubbla leveranssätt innebär att du inte behöver välja mellan dynamisk funktionalitet och AI-synlighet; istället kan du optimera för båda målgrupperna samtidigt. Förgenereringsprocessen kan utlösas vid behov, schemalagt eller baserat på händelser, beroende på hur ofta ditt innehåll förändras och vilka synlighetskrav du har.

Implementering av AI-förgenerering ger flera betydande fördelar för organisationer som vill maximera sin synlighet hos AI-system och säkerställa att deras innehåll indexeras och citeras korrekt:

Förbättrad crawlbarhet: AI-crawlers får fullt renderat, statiskt HTML-innehåll som inte kräver någon JavaScript-exekvering, vilket säkerställer att 100 % av ditt innehåll är åtkomligt och indexerbart av AI-system oavsett deras tekniska kapacitet.

Snabbare indexering: Förgenererat innehåll är omedelbart tillgängligt för crawlers utan bearbetningsfördröjningar, vilket gör att AI-system kan upptäcka och indexera dina sidor snabbare än med dynamiskt innehåll som kräver rendering.

Bättre innehållsnoggrannhet: Genom att leverera optimerade statiska versioner säkerställer du att AI-crawlers ser exakt det innehåll du vill visa, vilket minskar risken för missförstånd eller felaktig tolkning av dina sidor.

Minskad crawlbudgetförlust: AI-crawlers slösar inte resurser på att försöka köra JavaScript eller hantera dynamiskt innehåll; de kan istället fokusera på att crawla fler av dina sidor och förbättra den övergripande täckningen.

Förbättrade AI-citat: Med bättre synlighet och mer korrekt innehållsrepresentation är din webbplats mer benägen att bli korrekt citerad och refererad i AI-genererade svar, vilket förbättrar varumärkessynlighet i generativa AI-resultat.

Att implementera AI-förgenerering kräver ett strategiskt tillvägagångssätt som tar hänsyn till din webbplatsarkitektur, hur ofta innehållet uppdateras och specifika affärsmål. Börja med att konfigurera din robots.txt-fil för att identifiera vilka AI-crawlers du vill optimera för, och överväg att använda user agent-specifika regler för att leverera förgenererat innehåll endast till AI-bots samtidigt som du bibehåller standardupplevelsen för mänskliga besökare och traditionella sökmotorer. Strukturerad datamarkering (Schema.org) blir ännu viktigare i en förgenereringsstrategi, eftersom det hjälper AI-system att förstå den semantiska betydelsen av ditt innehåll utöver HTML-strukturen. För de flesta webbplatser beror valet mellan full server-side rendering (SSR) och selektiv förgenerering på hur dynamiskt ditt innehåll är: om innehållet förändras ofta eller är högt personaliserat är det mer praktiskt att förgenerera specifika sidor eller använda förgenerering vid behov än att konvertera hela arkitekturen till SSR. E-handelssajter tjänar ofta på att förgenerera produktsidor och kategorisidor, SaaS-företag bör fokusera på att förgenerera landningssidor och dokumentation, medan medieföretag typiskt förgenererar artikelsidor och startsidans innehåll. Principerna för progressiv förbättring bör vägleda din implementering—se till att din webbplats fungerar för AI-crawlers även om JavaScript misslyckas, och lägg sedan till dynamiska förbättringar för mänskliga användare. Verktyg som Prerender.io kombinerat med övervakningslösningar såsom AmICited.com för att spåra AI-citat skapar en heltäckande strategi för att maximera din närvaro i AI-genererat innehåll och säkerställa att din investering i förgenerering ger mätbara resultat.

AI-förgenerering optimerar specifikt innehållsleveransen för AI-crawlers genom att leverera förgenererad statisk HTML, medan traditionell SSR renderar sidor dynamiskt för varje förfrågan. Förgenerering är mer effektivt för AI-system som inte kör JavaScript, medan SSR är bättre för personaliserat eller ofta förändrat innehåll som kräver realtidsrendering.

GPTBot (OpenAI), ClaudeBot (Anthropic) och PerplexityBot är de främsta AI-crawlers som gynnas av förgenerering. Dessa system har begränsade möjligheter att köra JavaScript, så förgenerering säkerställer att de får fullt renderat innehåll utan att behöva bearbeta komplex klientkod.

Nej, AI-förgenerering påverkar inte användarupplevelsen negativt. Strategin levererar statisk HTML endast till identifierade AI-crawlers medan mänskliga användare fortsätter att få den fulla dynamiska, interaktiva versionen av din webbplats med all JavaScript-funktionalitet intakt.

Genom att säkerställa att AI-crawlers kan få fullständig åtkomst till och förstå ditt innehåll ökar förgenerering sannolikheten att din webbplats indexeras korrekt och citeras i AI-genererade svar. Bättre tillgänglighet till innehållet leder till mer korrekt representation i AI-träningsdata och genererade svar.

E-handelssidor med dynamiska produktsidor, SaaS-företag med JavaScript-tung dokumentation, mediapublicister med artikelinnehåll samt alla webbplatser som är starkt beroende av klientbaserad JavaScript-rendering tjänar avsevärt på att implementera AI-förgenerering.

Ja, tjänster som Prerender.io erbjuder mellanvarulösningar som implementerar förgenerering utan att kräva stora arkitekturförändringar. Dessa verktyg fångar upp AI-crawler-förfrågningar och levererar förgenererade versioner samtidigt som din befintliga webbplatsstruktur bibehålls för mänskliga användare.

Uppdateringsfrekvensen beror på hur ofta ditt innehåll förändras. För statiskt innehåll räcker det med en förgenerering. För dynamiskt innehåll bör du implementera förgenerering vid behov, schemalagda uppdateringar (dagligen eller veckovis) eller händelsebaserad förgenerering när innehållet ändras.

Ja, AI-förgenerering adresserar en annan utmaning än traditionell SEO. Medan SEO optimerar för Google och mänsklig sökning, säkerställer AI-förgenerering synlighet för AI-crawlers och LLM:er, som har andra tekniska krav och blir allt viktigare för innehållsupptäckt.

Följ hur AI-system som ChatGPT, Perplexity och Google AI Overviews citerar och refererar till ditt innehåll. AmICited hjälper dig att mäta och förbättra din närvaro i AI-genererade svar.

Lär dig hur för-rendering hjälper din webbplats att synas i AI-sökresultat från ChatGPT, Perplexity och Claude. Förstå den tekniska implementeringen och fördela...

Lär dig hur JavaScript-rendering påverkar din webbplats synlighet i AI-sökmotorer som ChatGPT, Perplexity och Claude. Upptäck varför AI-crawlers har svårt med J...

Lär dig hur du gör ditt innehåll synligt för AI-crawlers som ChatGPT, Perplexity och Googles AI. Upptäck tekniska krav, bästa praxis och övervakningsstrategier ...