Hur AI-sökmotorer fungerar: Arkitektur, hämtning och generering

Lär dig hur AI-sökmotorer som ChatGPT, Perplexity och Google AI Overviews fungerar. Upptäck LLM:er, RAG, semantisk sökning och realtidsmekanismer för informatio...

En AI-sökmotor är en plattform som använder artificiell intelligens, naturlig språkbehandling och stora språkmodeller för att tolka användarfrågor och generera direkta, konverserande svar som syntetiserats från webbkällor, istället för att visa traditionella listor med länkar. Dessa plattformar utnyttjar retrieval-augmented generation (RAG) för att tillhandahålla aktuell, citerad information med realtidsåtkomst till webben.

En AI-sökmotor är en plattform som använder artificiell intelligens, naturlig språkbehandling och stora språkmodeller för att tolka användarfrågor och generera direkta, konverserande svar som syntetiserats från webbkällor, istället för att visa traditionella listor med länkar. Dessa plattformar utnyttjar retrieval-augmented generation (RAG) för att tillhandahålla aktuell, citerad information med realtidsåtkomst till webben.

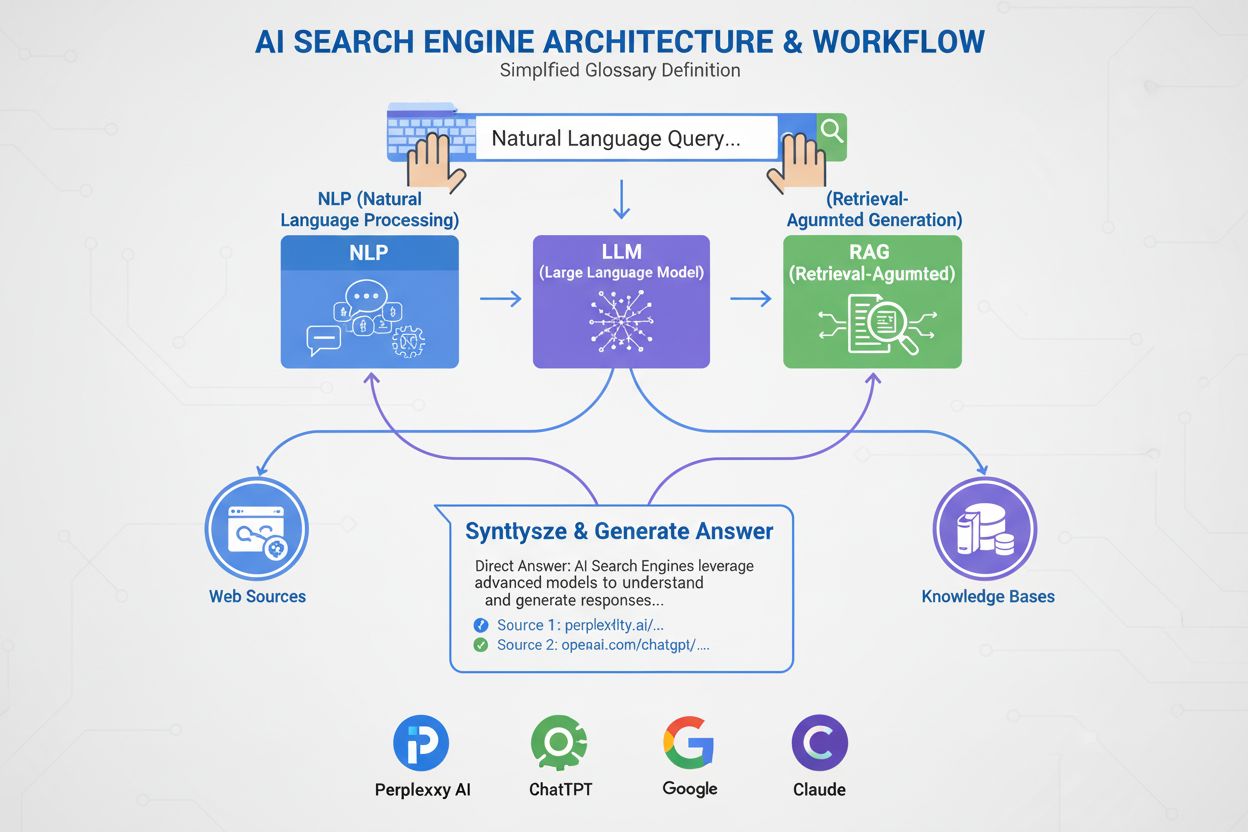

En AI-sökmotor är en plattform som använder artificiell intelligens, naturlig språkbehandling (NLP) och stora språkmodeller (LLM) för att tolka användarfrågor och generera direkta, konverserande svar syntetiserade från webbkällor. Till skillnad från traditionella sökmotorer som visar listor med länkar, ger AI-sökmotorer kortfattade sammanfattningar på klarspråk som direkt adresserar användarens avsikt. Dessa plattformar utnyttjar retrieval-augmented generation (RAG) för att kombinera realtidsinhämtning från webben med generativ AI-syntes, vilket gör att de kan leverera aktuell, citerad information. AI-sökmotorer utgör ett grundläggande skifte i hur människor upptäcker information online, från nyckelordsbaserade länklistor till semantisk förståelse och direkta svar. Tekniken bakom dessa system integrerar flera AI-discipliner—inklusive semantisk sökning, entitetsigenkänning och konverserande AI—för att skapa en mer intuitiv och effektiv sökupplevelse.

Framväxten av AI-sökmotorer markerar en betydande utveckling i tekniken för informationssökning. Under decennier har sökmotorer verkat utifrån ett nyckelordsparadigm, där relevans avgjordes av förekomsten och frekvensen av sökord i indexerade dokument. Men uppkomsten av stora språkmodeller och framsteg inom naturlig språkförståelse har fundamentalt förändrat möjligheterna. Den globala marknaden för AI-sökmotorer nådde 15,23 miljarder USD år 2024 och förväntas ha en årlig tillväxttakt (CAGR) på 16,8 % till 2032, enligt marknadsundersökningar. Denna explosiva tillväxt återspeglar både företagsanvändning och konsumenternas efterfrågan på intelligentare, konverserande sökupplevelser.

Generativ AI har omformat hur människor hittar information online, och fört sökandet bortom den bekanta listan med blå länkar mot mer direkta, konverserande svar. Branschledare som Google och Microsoft Bing har snabbt integrerat AI i sina plattformar för att hålla jämna steg med stigande stjärnor som Perplexity och You.com. Enligt McKinsey-undersökningar har cirka 50 % av Googles sökningar redan AI-sammanfattningar, en andel som väntas stiga till över 75 % till 2028. Detta skifte är mer än bara en förändring av användargränssnittet—det omdefinierar innehållsstrategi och sökmotoroptimering till en ny era kallad “generative engine optimization” (GEO).

Övergången speglar ett bredare organisatoriskt införande av AI-teknik. 78 % av organisationerna uppgav att de använde AI under 2024, upp från 55 % året innan, enligt Stanfords AI Index Report. För sök- och marknadsföringsproffs innebär detta att synlighet nu är beroende av att förstå hur AI-system analyserar, kondenserar och återger innehåll till sammanfattningar på klarspråk. Utmaningen är att AI-genererade svar ofta leder trafiken bort från de ursprungliga webbplatserna helt och hållet, vilket skapar både möjligheter och utmaningar för innehållsskapare och varumärken som vill synas i detta nya landskap.

AI-sökmotorer fungerar genom en sofistikerad, flerstegs pipeline som kombinerar inhämtning, ranking och syntes. Processen börjar med frågeförståelse, där systemet analyserar användarens inmatning med naturlig språkbehandling för att extrahera betydelse, avsikt och kontext. Istället för att behandla frågan som en enkel nyckelordssträng skapar systemet flera representationer: en lexikal form för exakt matchning, en tät inbäddning för semantisk sökning och en entitetsform för matchning mot kunskapsgrafer.

När frågan är förstådd använder de flesta AI-sökmotorer retrieval-augmented generation (RAG), ett kärnmönster som adresserar stora språkmodellers grundläggande svagheter. RAG utför ett livesökningssteg, där relevanta dokument och avsnitt hämtas från webbindex eller API:er. Dessa kandidater omrankas sedan med mer sofistikerade modeller som gemensamt utvärderar frågan och kandidaten för att producera förfinade relevanspoäng. De bäst rankade resultaten matas in i en stor språkmodell som kontext, vilken syntetiserar ett konverserande svar samtidigt som den håller sig trogen mot de hämtade källorna.

Hybrida inhämtning pipelines är standard bland ledande plattformar. Dessa kombinerar lexikal sökning (nyckelordsbaserad, med algoritmer som BM25) med semantisk sökning (bäddningsbaserad, med vektorsimilaritet). Lexikal sökning är bäst för precision vid exakta matchningar, ovanliga termer och namngivna entiteter, medan semantisk sökning är bäst för återkallande av konceptuellt relaterat innehåll. Genom att slå samman båda tillvägagångssätten och använda cross-encoder omrankning, uppnår AI-sökmotorer högre noggrannhet än någon metod ensam. Sista syntessteget använder en stor språkmodell för att komponera ett sammanhängande, mänskligt liknande svar som integrerar information från flera källor, samtidigt som noggrannhet och citering bibehålls.

| Aspekt | Traditionella sökmotorer | AI-sökmotorer |

|---|---|---|

| Resultatformat | Länklister med korta utdrag | Konverserande sammanfattningar med direkta svar |

| Frågebehandling | Nyckelordsmatchning och ranking | Semantisk förståelse och avsiktsanalys |

| Inlärningsmekanism | Arbetar från noll vid varje fråga | Lär sig kontinuerligt av användarinteraktioner och feedback |

| Informationsinhämtning | Lexikal/nyckelordsbaserad matchning | Hybrid (lexikal + semantisk + entitetsbaserad) |

| Indataformat | Endast text | Text, bilder, röst och video (multimodal) |

| Realtidsuppdateringar | Indexbaserat, periodisk crawlning | Realtidsåtkomst till webben via RAG |

| Citeringsbeteende | Inga källhänvisningar; användaren hittar källor själv | Integrerade källhänvisningar och källattribution |

| Användarinteraktion | Enskild fråga, statiska resultat | Flerstegs-konversationer med följdfrågor |

| Hantera bias | Kuratorer organiserar information | AI-syntes kan introducera utvecklarbias |

| Hallucinationsrisk | Låg (länkar är faktiska) | Högre (LLM kan generera felaktig information) |

Olika AI-sökmotorer implementerar distinkta arkitekturer med unika optimeringsimplikationer. Googles AI Overviews och AI Mode använder en query fan-out-strategi, där en användarfråga delas upp i flera underfrågor riktade mot olika avsiktsdimensioner. Dessa underfrågor körs parallellt mot olika datakällor—webbindex, kunskapsgrafer, YouTube-transkriptioner, Google Shopping-flöden och specialindex. Resultaten aggregeras, avdubbleras och rankas innan de syntetiseras till en översikt. För GEO-praktiker innebär detta att innehåll måste adressera flera aspekter av en fråga på extraherbara sätt för att överleva fan-out-processen.

Bing Copilot representerar ett mer traditionellt sökbaserat tillvägagångssätt, där Microsofts mogna Bing-rankningsinfrastruktur kombineras med GPT-klass syntes ovanpå. Plattformen använder dual-lane retrieval, där BM25-lexikal sökning kombineras med tät vektorbaserad semantisk sökning. Resultaten passerar en kontextuell cross-encoder omrankare som fokuserar på relevans på styckenivå snarare än hela sidor. Denna arkitektur innebär att klassiska SEO-signaler—crawlbarhet, kanoniska taggar, ren HTML, sidladdningshastighet—fortfarande är mycket viktiga, eftersom de avgör vilka kandidater som når grunduppsättningen. Bing Copilot betonar också extraherbarhet: avsnitt med tydlig avgränsning, listor, tabeller och definitionsliknande formuleringar citeras oftare.

Perplexity AI verkar medvetet transparent och visar källor tydligt före själva det genererade svaret. Plattformen genomför realtidssökningar, ofta både från Google och Bing-index, och utvärderar kandidater utifrån en blandning av lexikal och semantisk relevans, tematisk auktoritet och svarsextraherbarhet. Forskning som analyserar 59 olika faktorer som påverkar Perplexitys rankningsbeteende visar att plattformen prioriterar direkt svarformat—sidor som uttryckligen återger frågan i en rubrik, följt direkt av ett kort, informationsrikt svar, är överrepresenterade i citeringsuppsättningar. Entitetsframträdande och länkning spelar också en stor roll; Perplexity favoriserar avsnitt där viktiga entiteter är tydligt namngivna och kontextuellt länkade till relaterade begrepp.

ChatGPT Search tar ett opportunistiskt tillvägagångssätt och genererar sökfrågor dynamiskt samt anropar Bings API för att hämta specifika URL:er. Till skillnad från plattformar med bestående index hämtar ChatGPT innehåll i realtid, vilket innebär att inkludering helt beror på realtidsåtkomlighet. Om en webbplats blockeras av robots.txt, är långsam att ladda, döljs bakom klientbaserad rendering eller är semantiskt ogenomskinlig, kommer den inte att användas i syntesen. Denna arkitektur prioriterar tillgänglighet och tydlighet: sidor måste vara tekniskt crawlbara, lättviktiga och semantiskt transparenta så att ad hoc-hämtningar ger ren, tolkbar text.

Naturlig språkbehandling (NLP) är grundteknologin som gör att AI-sökmotorer kan gå bortom nyckelordsmatchning. NLP gör att systemen kan analysera struktur, semantik och avsikt bakom sökfrågor, förstå kontext samt känna igen synonymer och relaterade begrepp. När en användare frågar “bästa ställen att äta nära mig med uteservering” förstår ett NLP-drivet system att frågan gäller restauranger med uteplatser, trots att de orden inte används. Denna semantiska förståelse gör att AI-sökmotorer kan leverera relevanta resultat även när avsikten är mindre uppenbar eller uttryckt konverserande.

Stora språkmodeller (LLM) driver syntessteget i AI-sökmotorer. Tränade på enorma datamängder förutspår LLM nästa mest logiska ord baserat på kontext, vilket gör att de kan producera sammanhängande, grammatiskt korrekt text som liknar mänsklig prosa. Dock innebär användningen av LLM också risker. De kan hallucinera—presentera felaktigheter som fakta—eftersom de genererar text utifrån sannolikhetsbaserad kunskap snarare än att hämta från aktuella källor. Därför är retrieval-augmented generation (RAG) avgörande: genom att förankra LLM-syntesen i nyhämtade, auktoritativa källor motverkar AI-sökmotorer hallucinationsrisk och förbättrar faktakvalitet. Vissa plattformar har infört rad-för-rad-citering för att ytterligare motverka hallucination, även om de citerade artiklarna inte alltid är korrekta eller existerar.

AI-sökmotorer skiljer sig från traditionella sökmotorer på flera grundläggande sätt. För det första ger de sammanfattningar istället för länkar. Vanliga sökmotorer visar resultat som listor med länkar och korta utdrag, medan AI-sökmotorer genererar kortfattade sammanfattningar som direkt besvarar frågor, vilket sparar användaren från att behöva bläddra och klicka sig igenom flera webbplatser. För det andra lär sig AI-sök över tid, medan traditionell sök börjar om vid varje fråga. AI-sökmotorer är designade för att kontinuerligt lära sig och anpassa sig utifrån användarinteraktioner och ny data, vilket förbättrar deras prestanda över tid. Traditionella sökmotorer arbetar från början med varje ny fråga, utan hänsyn till tidigare frågor eller användarinteraktioner.

För det tredje fokuserar AI-sök på semantik, medan traditionell sök fokuserar på nyckelord. Vanliga sökmotorer förlitar sig främst på nyckelordsmatchning för att tolka frågor, medan AI-sökmotorer fokuserar på semantik—den bredare betydelsen av ord i sitt sammanhang. Detta gör att AI-sökmotorer bättre kan förstå användarens avsikt och leverera resultat som ligger närmare det användaren söker. För det fjärde accepterar AI-sökmotorer flera indataformat, medan traditionell sök endast accepterar text. Vissa AI-sökmotorer har multimodala funktioner, vilket innebär att de kan bearbeta och förstå information i andra format än text, till exempel bilder, video och ljud. Detta ger en mer intuitiv och flexibel sökupplevelse än att bara skriva nyckelord.

AI-sökmotorernas framväxt omformar hur varumärken närmar sig synlighet och innehållsstrategi. Istället för att enbart konkurrera om nyckelordsplaceringar måste publicister och företag nu ta hänsyn till hur AI-system analyserar, kondenserar och återger deras innehåll till sammanfattningar på klarspråk. Detta har lett till en ny era av “generative engine optimization” (GEO), där målet inte bara är att ranka utan att bli inhämtad, syntetiserad och citerad av AI-system.

Forskning visar att även GEO-prestandan för branschledare kan ligga 20 till 50 procent efter SEO-prestandan, enligt McKinsey-analyser. Denna skillnad speglar den omogna karaktären av GEO-strategier och komplexiteten i att optimera för flera AI-plattformar samtidigt. För varumärken är konsekvenserna betydande: synlighet i AI-sök beror på att innehållet är inhämtbart (dyker upp i sökresultat), extraherbart (strukturerat så att AI-system lätt kan tolka och citera det) och trovärdigt (visar expertis, auktoritet och pålitlighet). Övervakningsverktyg som AmICited spårar nu varumärkesomnämnanden över AI-plattformar—inklusive Perplexity, ChatGPT, Google AI Overviews och Claude—för att mäta denna nya typ av synlighet och identifiera optimeringsmöjligheter.

AI-sökningslandskapet utvecklas snabbt, med stora konsekvenser för hur information upptäcks, distribueras och monetariseras. Den globala marknaden för AI-sökmotorer förväntas växa med 16,8 % CAGR till 2032, drivet av ökad företagsanvändning och konsumenternas efterfrågan på konverserande, intelligenta sökupplevelser. När AI-sökmotorerna mognar kan vi förvänta oss flera viktiga trender.

För det första kommer konsolidering och specialisering sannolikt att accelerera. Medan generalistplattformar som Google, Bing och Perplexity fortsätter att dominera, kommer specialiserade AI-sökmotorer för nischområden—juridik, medicin, teknik, e-handel—att bli fler. Dessa specialiserade motorer kommer erbjuda djupare ämnesexpertis och mer korrekt syntes för nischade frågor. För det andra kommer citerings- och attributionsmekanismer bli mer sofistikerade och standardiserade. När regulatoriska krav ökar och publicister kräver tydligare attribution, kommer AI-sökmotorer sannolikt att införa mer detaljerade citeringssystem som gör det enklare för användare att spåra påståenden till källor och för publicister att mäta synlighet.

För det tredje kommer definitionen och mätningen av “synlighet” att förändras i grunden. I SEO-eran betydde synlighet rankingposition och klickfrekvens. I GEO-eran betyder synlighet att bli inhämtad, syntetiserad och citerad—mått som kräver nya mätramverk och verktyg. AmICited och liknande plattformar banar väg för denna nya mätning, där varumärkesomnämnanden över flera AI-plattformar spåras och insikter ges om hur ofta och i vilket sammanhang varumärken förekommer i AI-genererade svar.

För det fjärde kommer spänningen mellan AI-sök och traditionell sök att tillta. När AI-sökmotorer tar en allt större del av användarens uppmärksamhet och trafik, kommer traditionella sökmotorer att pressas att utvecklas eller riskera irrelevans. Googles integration av AI i sin kärnsöktjänst är ett strategiskt svar på detta hot, men den långsiktiga vinnaren är ännu oklar. Publicister och varumärken måste optimera för både traditionell och AI-sök samtidigt, vilket skapar en mer komplex och resurskrävande innehållsstrategi.

Slutligen kommer förtroende och noggrannhet bli avgörande. När AI-sökmotorer blir primära informationskällor ökar kraven på noggrannhet och biashantering. Regelverk kring AI-transparens och ansvarstagande kommer sannolikt att växa fram, vilket kräver att AI-sökmotorer redovisar sin träningsdata, rankningsfaktorer och citeringsmetoder. För varumärken och publicister innebär detta att E-E-A-T-signaler—expertis, erfarenhet, auktoritet och trovärdighet—blir ännu viktigare för synlighet i både traditionell och AI-sök.

+++ showCTA = true ctaHeading = “Övervaka ditt varumärkes synlighet i AI-sökmotorer” ctaDescription = “Att förstå AI-sökmotorer är bara första steget. Spåra var och hur ditt varumärke syns i ChatGPT, Perplexity, Google AI Overviews och Claude med AmICiteds övervakningsplattform för AI-sök. Mät din GEO-prestanda, identifiera citeringsmöjligheter och optimera ditt innehåll för nästa generations sök.” ctaPrimaryText = “Kontakta oss” ctaPrimaryURL = “/contact/” ctaSecondaryText = “Prova nu” ctaSecondaryURL = “https://app.amicited.com ” +++

Traditionella sökmotorer visar resultat som listor med länkar och utdrag, medan AI-sökmotorer genererar konverserande sammanfattningar som direkt besvarar frågor. AI-sökmotorer använder naturlig språkbehandling och stora språkmodeller för att semantiskt förstå användarens avsikt istället för att bara förlita sig på nyckelordsmatchning. De lär sig kontinuerligt av användarinteraktioner och kan bearbeta flera indataformat inklusive text, bilder och röst. Dessutom erbjuder AI-sökmotorer ofta realtidsåtkomst till webben via retrieval-augmented generation (RAG), vilket gör att de kan leverera aktuell information med källhänvisningar.

Retrieval-augmented generation (RAG) är en teknik som gör det möjligt för stora språkmodeller att hämta och införliva färsk information från externa källor innan de genererar svar. RAG adresserar de grundläggande begränsningarna hos LLM:er—hallucinationer och kunskapsgränser—genom att förankra svaren i realtidsinhämtad data. I AI-sökmotorer fungerar RAG genom att först utföra en livesökning eller hämtningssteg, där relevanta dokument eller utdrag samlas in, för att sedan syntetisera ett svar baserat på dessa hämtade objekt. Detta tillvägagångssätt säkerställer att svaren är både aktuella och spårbara till specifika källor, vilket möjliggör citering och förbättrar faktakvalitet.

Ledande AI-sökmotorer inkluderar Perplexity (känd för transparenta källhänvisningar), ChatGPT Search (drivs av GPT-4o med realtidsåtkomst till webben), Google Gemini och AI Overviews (integrerade med Googles sökinfrastruktur), Bing Copilot (baserad på Microsofts sökindex) och Claude (Anthropics modell med selektiv webbsökning). Perplexity prioriterar realtidsinhämtning och synlig källattribution, medan ChatGPT genererar sökfrågor opportunistiskt. Googles tillvägagångssätt använder query fan-out för att täcka flera avsiktsdimensioner, och Bing CoPilot kombinerar traditionella SEO-signaler med generativ syntes. Varje plattform har distinkta inhämtningsarkitekturer, citeringsbeteenden och optimeringskrav.

AI-sökmotorer följer en flerstegsprocess: först analyseras användarfrågan med naturlig språkbehandling för att förstå avsikten; därefter hämtas relevanta dokument eller avsnitt från webbindex eller API:er med hjälp av hybridinhämtning (kombinerar lexikal och semantisk sökning); tredje steget innebär att kandidater omrankas utifrån relevans och extraherbarhet; slutligen syntetiseras ett konverserande svar med en stor språkmodell, där källhänvisningar infogas till ursprungsdokumenten. Citeringsmekanismen varierar mellan plattformarna—vissa visar källor inline, andra visar källistor och vissa integrerar källhänvisningar i själva svarstexten. Kvaliteten och noggrannheten på källhänvisningarna beror på hur väl de hämtade avsnitten matchar de syntetiserade påståendena.

Generative engine optimization (GEO) är metoden att optimera innehåll och varumärkessynlighet specifikt för AI-sökmotorer, till skillnad från traditionell SEO som fokuserar på nyckelordsplaceringar i länkbaserade sökresultat. GEO handlar om att göra innehåll åtkomligt, extraherbart och citerbart för AI-system. Centrala GEO-strategier inkluderar att strukturera innehåll för tydlighet och direkta svar, använda naturligt språk som matchar användarens avsikt, implementera entitetsmärkning och schema, säkerställa snabba laddningstider och bygga tematisk auktoritet. Enligt McKinsey-undersökningar har cirka 50% av Googles sökningar redan AI-sammanfattningar, en andel som väntas öka till över 75% till 2028, vilket gör GEO allt viktigare för varumärkessynlighet.

AI-sökmotorer kan både öka och minska webbtrafiken beroende på hur innehållet är optimerat. När innehåll citeras i AI-genererade svar får det synlighet och trovärdighet, men användarna kan få sitt svar direkt utan att klicka sig vidare till källan. Forskning visar att AI Overviews kan leda bort trafik från ursprungliga webbplatser, även om de också ger attribution och källänkar. För varumärken innebär skiftet att synlighet nu beror på att bli inhämtad, syntetiserad och citerad av AI-system—inte bara på att ranka i traditionella sökresultat. Övervakningsverktyg som AmICited spårar varumärkesomnämnanden över AI-plattformar (Perplexity, ChatGPT, Google AI Overviews, Claude) för att mäta denna nya typ av synlighet och optimera därefter.

Naturlig språkbehandling (NLP) är grundläggande för hur AI-sökmotorer förstår och bearbetar användarfrågor. NLP gör det möjligt för systemen att analysera struktur, semantik och avsikt bakom sökfrågor snarare än att bara matcha nyckelord. Det gör att AI-sökmotorer kan förstå sammanhang, särskilja betydelser och känna igen synonymer och relaterade begrepp. NLP driver också syntessteget, där språkmodeller genererar grammatiskt korrekta, sammanhängande svar som låter naturliga för användaren. Dessutom hjälper NLP AI-sökmotorer att extrahera och strukturera information från webbsidor, identifiera nyckelentiteter, relationer och påståenden som kan användas i genererade svar.

AI-sökmotorer hanterar realtidsinformation genom retrieval-augmented generation (RAG), som utför livesökningar eller API-anrop för att hämta aktuell data vid frågetillfället istället för att enbart förlita sig på träningsdata. Plattformar som Perplexity och Googles AI Mode söker aktivt på webben i realtid för att säkerställa att svaren speglar den senaste informationen. ChatGPT använder Bings sök-API för att komma åt aktuellt webbinnehåll när surfning är aktiverad. Aktualitetssignaler ingår också i rankningsalgoritmer—sidor med nyligen publicerat och uppdaterat innehåll väger tyngre för tidskänsliga frågor. Dock förlitar sig vissa AI-sökmotorer fortfarande delvis på träningsdata, vilket kan släpa efter verkliga händelser, vilket gör realtidsinhämtning till en viktig skillnadsfaktor mellan plattformarna.

Börja spåra hur AI-chatbotar nämner ditt varumärke på ChatGPT, Perplexity och andra plattformar. Få handlingsbara insikter för att förbättra din AI-närvaro.

Lär dig hur AI-sökmotorer som ChatGPT, Perplexity och Google AI Overviews fungerar. Upptäck LLM:er, RAG, semantisk sökning och realtidsmekanismer för informatio...

Upptäck de bästa gratis AI-sökmotorerna, inklusive Perplexity, ChatGPT, Google Gemini och fler. Jämför funktioner, kapacitet och prissättning för AI-svarsgenera...

Lär dig hur du skickar in och optimerar ditt innehåll för AI-sökmotorer som ChatGPT, Perplexity och Gemini. Upptäck indexeringsstrategier, tekniska krav och bäs...