Content SEO

Content SEO är den strategiska skapandet och optimeringen av högkvalitativt innehåll för att förbättra sökmotorrankningar och organisk synlighet. Lär dig hur du...

Maskering är en vilseledande black-hat SEO-teknik där olika innehåll presenteras för sökmotorer än för mänskliga användare, med avsikt att manipulera sökrankningar och vilseleda både algoritmer och besökare. Denna praxis bryter mot sökmotorernas riktlinjer och kan leda till allvarliga straff, inklusive borttagning från index.

Maskering är en vilseledande black-hat SEO-teknik där olika innehåll presenteras för sökmotorer än för mänskliga användare, med avsikt att manipulera sökrankningar och vilseleda både algoritmer och besökare. Denna praxis bryter mot sökmotorernas riktlinjer och kan leda till allvarliga straff, inklusive borttagning från index.

Maskering är en vilseledande black-hat SEO-teknik där en webbplats presenterar olika innehåll eller URL:er för sökmotorers crawlers än vad som visas för mänskliga användare. Det primära syftet med maskering är att manipulera sökmotorrankningar genom att visa optimerat, nyckelordsrikt innehåll för botar samtidigt som helt annat eller sämre innehåll visas för faktiska besökare. Denna praxis bryter direkt mot sökmotorernas riktlinjer, särskilt Googles Webmaster Guidelines, och utgör ett av de allvarligaste överträdelserna inom SEO. Själva termen “maskering” syftar på handlingen att dölja eller förklä den verkliga naturen av en webbsidas innehåll, så att det verkar mer relevant för sökalgoritmer än det faktiskt är för riktiga användare. Vid implementering innebär maskering vanligtvis serverbaserade detekteringsmekanismer som identifierar om en begäran kommer från en sökmotorcrawler eller en mänsklig webbläsare, och serverar sedan villkorligt olika svar baserat på denna identifiering.

Maskering uppstod i början av 2000-talet som en av de första utbredda black-hat SEO-teknikerna och blev framträdande under den tid då sökmotorernas algoritmer var mindre sofistikerade och upptäcktsmöjligheterna var begränsade. Tidiga utövare upptäckte att genom att servera nyckelordsfyllt, optimerat innehåll till Googlebot samtidigt som de visade rena, användarvänliga sidor för besökare, kunde de uppnå högre placeringar utan att skapa genuint värdefullt innehåll. Denna teknik blev särskilt populär bland spammare, vuxeninnehållssidor och spelsajter som ville ha snabba rankningsvinster. Men i takt med att sökmotorerna utvecklades och tog fram mer avancerade detekteringsalgoritmer blev maskering alltmer riskabelt. I mitten av 2010-talet hade Google avsevärt förbättrat sin förmåga att identifiera maskering genom avancerade crawlsimuleringar och maskininlärningsmodeller. En banbrytande studie från 2012 av forskare vid UC San Diego visade att cirka 35% av maskerade sökresultat använde ren user-agent-maskering, vilket visar teknikens utbredning vid den tiden. Idag är maskering betydligt ovanligare på grund av strängare straff och bättre upptäckt, även om nya hot som AI-inriktad maskering har skapat nya varianter av denna vilseledande praxis.

Maskering fungerar genom serverbaserad detektering och villkorlig innehållsleverans och utnyttjar flera tekniska signaler för att särskilja sökmotorers crawlers från mänskliga användare. De vanligaste detekteringsmetoderna inkluderar user-agent-analys, där servern undersöker user-agent-strängen som skickas av den begärande klienten för att identifiera kända sökmotorbotar som Googlebot, Bingbot eller Slurp. En annan vanlig mekanism är IP-baserad detektering, som identifierar besökarens IP-adress och jämför den med kända IP-intervall som tillhör stora sökmotorer. Servern kan även undersöka HTTP-headers, inklusive Accept-Language-headern, Referer-headern och annan begäranmetadata för att fatta beslut om dirigeringsväg. När servern avgör om begäran kommer från en crawler eller en användare, körs villkorlig logik för att servera olika innehållsversioner. Till exempel kan en maskerad sida servera en sida fylld med målnyckelord och optimerad metadata till Googlebot, medan den samtidigt serverar ett bildgalleri eller helt orelaterat innehåll till mänskliga besökare som går in på samma URL. Vissa sofistikerade implementationer använder JavaScript-baserad maskering, där minimalt innehåll laddas initialt för användare, men sökmotorer får förgenererad HTML med fullt, optimerat innehåll. Andra använder omdirigeringsbaserad maskering, där HTTP-omdirigeringar eller meta-refresh-taggar används för att skicka crawlers till en URL och användare till en helt annan sida.

User-Agent-maskering är den vanligaste formen av maskering och står för cirka 35% av upptäckta maskerade sajter enligt forskning. Denna teknik upptäcker user-agent-strängen — en textidentifierare som webbläsare och crawlers skickar med varje begäran — och serverar olika innehåll beroende på om user-agent tillhör en känd sökmotorbot. Till exempel kan en sajt upptäcka “Googlebot” i user-agent-strängen och servera en optimerad sida, medan en annan version visas för Chrome-, Firefox- eller Safari-webbläsare. IP-baserad maskering identifierar besökarens IP-adress och jämför den med kända IP-intervall som används av sökmotorer. När en begäran kommer från en sökmotors IP-intervall levererar servern optimerat innehåll; annars serveras alternativt innehåll. Denna metod är särskilt vilseledande eftersom den kan rikta sig mot specifika konkurrenters IP-adresser och visa dem annat innehåll än det som visas i sökresultaten. Dold text och länkar innebär användning av CSS eller JavaScript för att dölja nyckelordsrikt text eller länkar för användare men hålla dem synliga för crawlers. Utvecklare kan matcha textfärg med bakgrundsfärg, placera text utanför skärmen eller använda display:none i CSS för att dölja innehåll. HTTP Accept-Language-maskering undersöker språkpreferens-headern i HTTP-begäranden för att särskilja crawlers från användare och serverar lokaliserat eller optimerat innehåll baserat på språksignaler. Doorway-sidor är tunna, nyckelordsoptimerade sidor som är designade specifikt för att ranka för vissa sökfrågor, och som sedan omdirigerar användare till en annan, orelaterad sida. CNAME-maskering (DNS-maskering) använder DNS-poster för att dölja tredjepartsdomäner som förstapart, så att spårare kan samla in data samtidigt som de verkar vara en del av den legitima sajten. Referrer-baserad maskering ändrar innehåll beroende på den hänvisande webbplatsen och visar olika versioner för användare som kommer från sökresultat jämfört med de som kommer direkt eller från andra källor.

| Aspekt | Maskering | Förgenerering | Flexibel sampling | Progressiv förbättring | Personalisering |

|---|---|---|---|---|---|

| Syfte | Vilseledande manipulation | Legitim optimering | Transparent åtkomst | Förbättrad användarupplevelse | Användarfokuserad anpassning |

| Innehåll till crawlers | Annorlunda/optimerat | Samma som användare | Full åtkomst till innehåll | Kärninnehåll tillgängligt | Grundinnehåll identiskt |

| Innehåll till användare | Annorlunda/sämre | Samma som crawlers | Samma som crawlers | Förbättrad upplevelse | Anpassat men transparent |

| Efterlevnad sökmotor | Bryter mot riktlinjer | Följer riktlinjer | Följer riktlinjer | Följer riktlinjer | Följer riktlinjer |

| Upptäcktsrisk | Hög/oundviklig | Ingen | Ingen | Låg | Ingen |

| Straffrisk | Allvarlig (borttagning från index) | Ingen | Ingen | Ingen | Ingen |

| Användningsområde | Spam/manipulation | JavaScript-sajter | Betalinnehåll | Dynamiskt innehåll | Användarpreferenser |

| Svårighet att återhämta sig | Månader/år | N/A | N/A | N/A | N/A |

Trots väldokumenterade straff och upptäcktsrisker fortsätter vissa webbplatsägare att använda maskering av flera skäl. Snabba lösningar för tekniska begränsningar är en huvudorsak — sajter med tung användning av JavaScript, Flash eller bildtunga layouter använder ibland maskering för att visa crawlers en textversion medan användare ser den visuella designen. Istället för att optimera JavaScript-rendering eller omstrukturera innehållet erbjuder maskering en genväg som verkar lösa problemet tillfälligt. Rankningsmanipulation driver en annan stor del av maskeringsanvändandet, där sajtägare avsiktligt serverar nyckelordsfyllt, optimerat innehåll till sökmotorer och visar annat innehåll för användare, i hopp om att få ranking de inte förtjänat via legitim optimering. Dold skadlig aktivitet sker när hackare komprometterar webbplatser och använder maskering för att dölja omdirigeringar, skadlig kod eller phishingförsök från sajtägare och säkerhetsskannrar men ändå lura användare. Strävan efter konkurrensfördelar motiverar vissa som tror att de kan överträffa konkurrenter genom att visa sökmotorer konstlat optimerat innehåll. Bristande medvetenhet om straff och upptäcktsmöjligheter gör att vissa sajtägare implementerar maskering utan att fullt ut förstå konsekvenserna. Forskning från UC San Diegos studie 2012 visade att nära 45% av maskerade sajter förblev aktiva även efter tre månaders observation, vilket antyder att vissa aktörer tror att de kan undvika upptäckt på obestämd tid.

Sökmotorer utdömer allvarliga straff för webbplatser som ertappas med maskering, med konsekvenser från rankningsförlust till total borttagning från index. Algoritmiska straff sker automatiskt när sökmotorernas algoritmer upptäcker maskeringssignaler, vilket leder till stora rankningsfall för drabbade sidor eller hela domänen. Dessa straff kan märkas inom dagar efter upptäckt och ofta bestå i månader även efter att maskeringen tagits bort. Manuella åtgärder innebär direkt granskning av Googles spamteam, vilket kan leda till ännu strängare straff än algoritmisk upptäckt. När Google utfärdar en manuell åtgärd för maskering får den drabbade sajten en notis i Google Search Console, och återhämtning kräver en omprövningsbegäran med detaljerade bevis på rättelser. Total borttagning från index är den allvarligaste konsekvensen, där Google tar bort hela webbplatsen från sitt sökindex och raderar all organisk synlighet. Sajter som tagits bort från index har ofta svårt att återfå förtroendet och kan behöva byta domän för att återhämta sig. Domänövergripande påverkan innebär att straff ofta påverkar inte bara enskilda sidor utan hela domänen, vilket skadar rankningen för alla nyckelord och sökningar. Skada på varumärkets rykte sträcker sig utöver sökrankningar — användare som upptäcker att de blivit lurade av maskering tappar förtroendet för varumärket, vilket leder till ökad avvisningsfrekvens, negativa omdömen och långsiktig trovärdighetsförlust. Trafikras följer efter borttagning från index eller kraftiga rankningsfall, där drabbade sajter förlorar 80–95% av trafiken inom veckor. Återhämtning från maskeringsstraff kräver vanligtvis 6–12 månaders konsekvent, regelrätt optimeringsarbete, och vissa sajter återfår aldrig sina tidigare positioner.

Att upptäcka maskering kräver att man jämför innehåll som serveras till sökmotorer med det som är synligt för användare via flera testmetoder och verktyg. Manuell jämförelse innebär att besöka en sida i en vanlig webbläsare och sedan kontrollera vad Googlebot ser via Google Search Consoles URL-inspektionsverktyg eller Fetch as Google-funktionen. Betydande skillnader mellan dessa två vyer indikerar möjlig maskering. Automatiska maskeringsdetekteringsverktyg som SiteChecker och DupliChecker analyserar sidor med flera user-agenter och IP-adresser och flaggar dolt text, misstänkta omdirigeringar och innehållsskillnader. Serverlogganalys avslöjar mönster i hur servern svarar på olika user-agenter och IP-adresser, där maskering ofta visar olika svarsmönster för crawler- jämfört med användarbegäranden. SERP-utdragsjämförelse innebär att kontrollera om metabeskrivningen och titeltaggen i sökresultaten faktiskt finns på den levande sidan — skillnader tyder på maskering. Crawl-övervakningsverktyg spårar hur sökmotorer interagerar med din sajt och identifierar plötsliga indexeringsförändringar, blockerade resurser eller ovanligt crawlerbeteende. Säkerhetsgranskningar upptäcker obehörig maskering orsakad av hackade sajter och identifierar injicerade omdirigeringar, skadlig kod eller dolt innehåll. Google Search Console-övervakning varnar sajtägare om manuella åtgärder, indexeringsproblem och täckningsproblem som kan indikera maskering. Regelbundna innehållsrevisioner där cachade versioner av sidor jämförs med aktuella levande versioner kan avslöja när innehåll har ändrats specifikt för crawlers.

Ett kritiskt växande hot är AI-inriktad maskering, där webbplatser serverar olika innehåll specifikt till AI-crawlers och språkmodeller som ChatGPT, Perplexity, Claude och Googles AI Overviews. Färsk forskning från SPLX år 2025 visade hur AI-inriktad maskering kan lura AI-webbläsare att citera falsk information, förgifta AI-träningsdata och skapa desinformation i stor skala. Detta utgör en betydande utmaning för plattformar som AmICited som övervakar varumärkens och domäners synlighet i AI-genererade svar. AI-inriktad maskering fungerar genom att upptäcka user-agent-strängar från AI-crawlers och servera dem vilseledande eller påhittat innehåll, samtidigt som legitimt innehåll visas för vanliga användare. Detta gör det möjligt för illvilliga aktörer att manipulera vad AI-system citerar och rekommenderar, och skapar en ny vektor för att sprida desinformation. Hotet är särskilt oroande eftersom AI-system i allt större utsträckning används för forskning, beslutsfattande och innehållsgenerering, vilket gör dem attraktiva mål för manipulation. Upptäckt av AI-inriktad maskering kräver specialiserad övervakning som jämför innehåll som serveras till AI-crawlers med det som är synligt för mänskliga användare och identifierar inkonsekvenser som tyder på vilseledande praxis. Organisationer som använder AI-övervakningsverktyg måste vara medvetna om att maskering kan äventyra noggrannheten i AI-citationer och rekommendationer, vilket gör det nödvändigt att implementera robusta detekterings- och verifieringsmekanismer.

Organisationer bör implementera omfattande strategier för att förhindra maskering och upprätthålla efterlevnad av sökmotorernas riktlinjer. Transparent innehållsleverans säkerställer att alla användare och crawlers får identiskt eller väsentligen liknande innehåll, med eventuella variationer som är legitima och deklarerade. Korrekt JavaScript-implementering använder progressiv förbättring och serverbaserad rendering för att säkerställa att kärninnehållet är tillgängligt för crawlers utan att JavaScript måste köras. Strukturerad datamärkning med Schema.org-vokabulär hjälper sökmotorer att förstå innehållet utan att behöva förlita sig på visuell presentation, vilket minskar frestelsen att maskera. Regelbundna säkerhetsgranskningar identifierar obehörig maskering orsakad av hackade webbplatser och åtgärdar omedelbart eventuella upptäckta sårbarheter. Efterlevnadsövervakning innebär regelbundna kontroller med verktyg som Google Search Console, Screaming Frog och maskeringsdetekteringstjänster för att säkerställa att ingen maskering förekommer. Personalutbildning informerar utvecklare och innehållsansvariga om maskeringsrisker och godkända alternativ för att lösa tekniska utmaningar. Dokumentation och policyer etablerar tydliga riktlinjer som förbjuder maskering och specificerar godkända metoder för innehållsoptimering. Granskning av tredjepartsleverantörer säkerställer att externa tjänster, plugins eller verktyg inte oavsiktligt implementerar maskering. Incidenthanteringsplanering förbereder organisationer på att snabbt identifiera och åtgärda eventuella maskeringsfall på sina sajter och därmed minimera straffets varaktighet.

Framtiden för maskeringsdetektering kommer sannolikt att innebära allt mer sofistikerade maskininlärningsmodeller som kan identifiera subtila innehållsvariationer och vilseledande mönster med högre precision. Sökmotorer satsar stort på avancerad crawlsimuleringsteknik som renderar sidor exakt som användare ser dem, vilket gör det praktiskt taget omöjligt att servera olika innehåll till crawlers. AI-driven anomalidetektering kommer att identifiera misstänkta mönster i serverrespons, user-agent-hantering och innehållsleverans som tyder på maskeringsförsök. Framväxten av AI-inriktad maskering som en egen hotkategori kommer att driva utvecklingen av specialiserade detekteringsverktyg inriktade på att identifiera innehåll som specifikt serveras till AI-crawlers. Blockkedjebaserade verifieringssystem kan så småningom erbjuda kryptografiskt bevis på innehållets äkthet, vilket gör maskering tekniskt omöjligt. Integrering av beteendeanalys i detekteringssystemen kommer att identifiera sajter som uppvisar mönster som överensstämmer med maskering även om enskilda sidor verkar regelrätta. När AI-system blir allt mer centrala för informationssökning och beslutsfattande ökar insatserna för att upptäcka och förhindra maskering avsevärt. Organisationer som proaktivt implementerar transparent, regelrätt innehållsleverans kommer att behålla konkurrensfördelar både i traditionell sökning och i nya AI-sökkanaler. Konvergensen mellan traditionella SEO-straff och AI-övervakningskrav innebär att maskering kommer att bli ännu mindre gångbart som strategi, med upptäckt och konsekvenser som blir allt hårdare och snabbare.

Maskering döljer medvetet innehåll för sökmotorer med vilseledande avsikt, medan legitim personalisering serverar samma grundinnehåll till alla användare och crawlers, med valfria förbättringar synliga för specifika målgrupper. Personalisering är transparent och följer riktlinjer; maskering är vilseledande och bryter mot riktlinjerna. Sökmotorer kan komma åt och utvärdera hela innehållet vid personalisering, medan maskering avsiktligt förhindrar denna åtkomst.

Sökmotorer upptäcker maskering genom att jämföra innehåll som serveras till crawlers med det som är synligt för mänskliga användare via avancerade crawlsimuleringar, maskininlärningsalgoritmer och genom att korskontrollera SERP-utdrag med faktiskt sidinnehåll. De analyserar user-agent-strängar, IP-adresser och serverrespons för att identifiera inkonsekvenser. Moderna detekteringssystem flaggar plötsliga rankningsförändringar, dolt text, misstänkta omdirigeringar och skillnader mellan metadata och sidinnehåll.

De vanligaste typerna inkluderar user-agent-maskering (upptäcka crawler-identifikationssträngar), IP-baserad maskering (servera olika innehåll baserat på besökarens IP-adress), dold text och länkar (använda CSS eller JavaScript för att dölja innehåll) och HTTP accept-language-maskering (upptäcka språkhuvuden). Forskning visar att cirka 35% av upptäckta maskerade sidor använder ren user-agent-maskering, vilket gör det till den vanligaste metoden trots att den är lätt att upptäcka.

Ja, återhämtning är möjlig men kräver omfattande insatser. Webbplatsägare måste ta bort allt maskerat innehåll, återställa identiskt innehåll för användare och crawlers, åtgärda eventuella säkerhetssårbarheter och skicka en omprövningsbegäran till Google med detaljerade bevis på åtgärder. Återhämtning tar vanligtvis månader och kräver kontinuerlig övervakning för att förhindra återfall. Processen innebär granskning av alla sidor, implementering av transparenta optimeringsrutiner och återuppbyggnad av sökmotorernas förtroende.

Maskering utgör ett betydande hot mot AI-övervakningsplattformar som AmICited genom att lura AI-crawlers att citera falsk eller vilseledande information. AI-inriktad maskering serverar specifikt olika innehåll till AI-webbläsare (som OpenAI:s Atlas) än till vanliga användare, vilket förgiftar AI-träningsdata och orsakar desinformation. Detta framväxande hot kräver avancerad upptäckt för att säkerställa att AI-system citerar korrekt, autentiskt innehåll istället för maskerade vilseledande versioner.

Forskning visar att cirka 3% av webbplatser använder maskeringstekniker, även om upptäcktsfrekvensen varierar beroende på metodologi. Studier visar att ungefär 35% av upptäckta maskerade sidor använder specifikt user-agent-maskering. Förekomsten har dock minskat avsevärt sedan 2015 tack vare förbättrade detekteringssystem och strängare straff, vilket gör maskering betydligt ovanligare 2025 än tidigare år.

Det finns inga legitima användningsområden för faktisk maskering, men flera godkända alternativ tjänar liknande syften: förgenerering för JavaScript-sajter, flexibel sampling för betalinnehåll, hreflang-taggar för internationellt innehåll och progressiv förbättring för dynamiska sidor. Dessa metoder ger transparenta lösningar utan att lura sökmotorer och upprätthåller efterlevnad av riktlinjer samtidigt som tekniska utmaningar löses.

Börja spåra hur AI-chatbotar nämner ditt varumärke på ChatGPT, Perplexity och andra plattformar. Få handlingsbara insikter för att förbättra din AI-närvaro.

Content SEO är den strategiska skapandet och optimeringen av högkvalitativt innehåll för att förbättra sökmotorrankningar och organisk synlighet. Lär dig hur du...

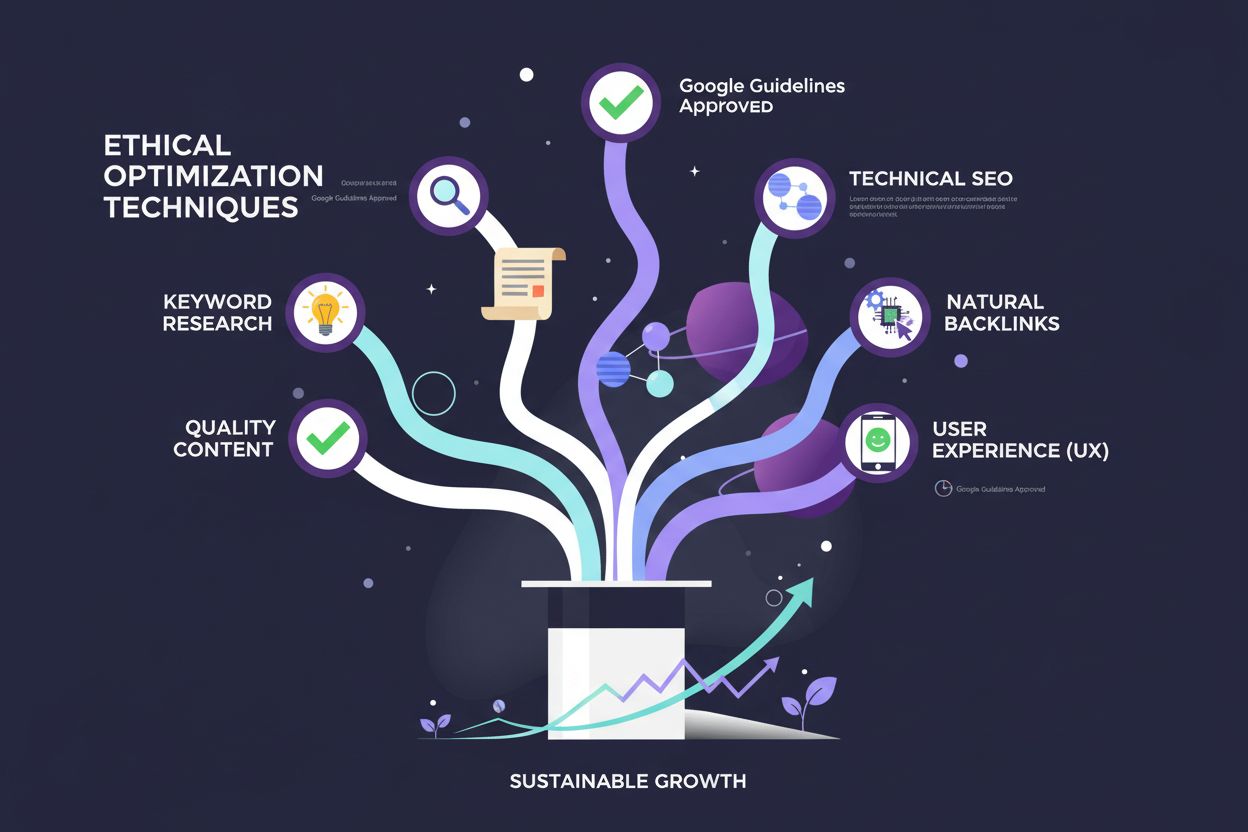

White Hat SEO definition: etisk sökmotoroptimering enligt Googles riktlinjer. Lär dig hållbara tekniker för kvalitetsinnehåll, naturliga bakåtlänkar och långsik...

Lär dig vad keyword stuffing är, varför det är skadligt för SEO, hur Google upptäcker det och bästa praxis för att undvika denna black-hat-taktik som skadar ran...