Robots.txt för AI: Hur du styr vilka botar som får tillgång till ditt innehåll

Lär dig hur du använder robots.txt för att styra vilka AI-botar som får tillgång till ditt innehåll. Komplett guide till att blockera GPTBot, ClaudeBot och andr...

En strategisk metod som gör det möjligt för webbplatsägare att selektivt tillåta vissa AI-robotar medan andra blockeras, baserat på affärsmål, innehållslicensavtal och värdebedömning. Istället för att använda generella policyer utvärderas varje robot individuellt för att avgöra om den genererar trafik, respekterar licensvillkor eller stämmer överens med intäktsmål. Publicister använder verktyg som robots.txt, HTTP-headers och plattformspecifika kontroller för att genomföra detaljerade åtkomstpolicyer. Denna metod balanserar innovationsmöjligheter med innehållsskydd och rättvis ersättning.

En strategisk metod som gör det möjligt för webbplatsägare att selektivt tillåta vissa AI-robotar medan andra blockeras, baserat på affärsmål, innehållslicensavtal och värdebedömning. Istället för att använda generella policyer utvärderas varje robot individuellt för att avgöra om den genererar trafik, respekterar licensvillkor eller stämmer överens med intäktsmål. Publicister använder verktyg som robots.txt, HTTP-headers och plattformspecifika kontroller för att genomföra detaljerade åtkomstpolicyer. Denna metod balanserar innovationsmöjligheter med innehållsskydd och rättvis ersättning.

Explosionen av AI-robotar har fundamentalt förändrat det decennier gamla förhållandet mellan webbplatsägare och botar. I många år fungerade internet genom ett enkelt utbyte: sökmotorer som Google indexerade innehåll och ledde trafik tillbaka till ursprungskällan, vilket skapade en symbiotisk relation som belönade kvalitetsinnehåll. Idag arbetar en ny generation AI-robotar—including GPTBot, ClaudeBot, PerplexityBot och dussintals andra—under andra regler. Dessa botar skrapar innehåll, inte för att indexera det för upptäckt, utan för att mata det direkt till AI-modeller som genererar svar utan att skicka användarna tillbaka till ursprungskällan. Effekten är tydlig: enligt Cloudflare har OpenAI:s GPTBot ett crawl-till-referral-förhållande på cirka 1 700:1, medan Anthropics ClaudeBot når 73 000:1, vilket betyder att för varje besökare som skickas tillbaka till publicistens sida crawlas tusentals sidor för träningsdata. Detta brustna utbyte har tvingat publicister att ompröva sina robotåtkomstpolicyer och gå från det binära valet “tillåt alla” eller “blockera alla” till en mer nyanserad strategi: differentierad robotåtkomst. Istället för generella policyer utvärderar nu smarta publicister varje robot individuellt och ställer kritiska frågor om värde, licensiering och anpassning till affärsmål.

Att förstå olika typer av AI-robotar är avgörande för att genomföra en effektiv differentierad åtkomststrategi, då varje typ har olika syfte och påverkan på din verksamhet. AI-robotar delas in i tre huvudkategorier: träningsrobotar (GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider) som samlar in innehåll för modellträning; sökerobotar (OAI-SearchBot, PerplexityBot, Google-Extended) som indexerar innehåll för AI-baserade sökresultat; samt användarinitierade agenter (ChatGPT-User, Claude-Web, Perplexity-User) som hämtar innehåll endast när användare explicit begär det. Värdeerbjudandet skiljer sig dramatiskt mellan dessa kategorier. Träningsrobotar genererar vanligtvis minimal trafik tillbaka till din sida—de extraherar värde utan ömsesidig nytta—och är därför ofta kandidater för blockering. Sökerobotar kan däremot driva meningsfull referraltrafik och nya prenumeranter, likt traditionella sökmotorer. Användarinitierade agenter hamnar mitt emellan och aktiveras bara om användare aktivt interagerar med AI-system. The Atlantic, en av världens största digitala publicister, införde en sofistikerad poängmodell för att utvärdera robotar, där de spårade både trafikvolym och prenumerationskonverteringar för varje bot. Deras analys visade att vissa robotar ger betydande värde, medan andra genererar i princip noll trafik men kräver mycket bandbredd. Detta datadrivna tillvägagångssätt gör att publicister kan fatta välgrundade beslut istället för att förlita sig på antaganden.

| Robottyp | Exempel | Huvudsyfte | Typiskt trafikvärde | Rekommenderad åtkomst |

|---|---|---|---|---|

| Träning | GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider | Modellträning | Mycket låg (1 700:1 till 73 000:1) | Ofta blockerad |

| Sök | OAI-SearchBot, PerplexityBot, Google-Extended | AI-sökindexering | Medel till hög | Ofta tillåten |

| Användarinitierad | ChatGPT-User, Claude-Web, Perplexity-User | Direkta användarförfrågningar | Variabelt | Fall till fall |

Att införa differentierad robotåtkomst kräver en kombination av tekniska verktyg och strategiska beslut, med flera metoder beroende på teknisk kapacitet och affärsbehov. Det mest grundläggande verktyget är robots.txt, en enkel textfil i webbplatsens rotkatalog som kommunicerar åtkomstpreferenser via User-agent-direktiv. Även om robots.txt är frivillig och endast 40–60 % av AI-botar respekterar den, är det första försvarslinjen och kostar inget att implementera. För publicister som vill ha starkare efterlevnad finns Cloudflares hanterade robots.txt, som automatiskt skapar och uppdaterar robotdirektiv och lägger till dem före din befintliga fil, vilket eliminerar behovet av manuell underhållning. Utöver robots.txt finns flera andra åtgärder för ökad kontroll:

Den mest effektiva strategin kombinerar flera lager: robots.txt för följsamma robotar, WAF-regler för genomdrivning och övervakningsverktyg för att följa upp och identifiera nya hot.

Att implementera differentierad robotåtkomst kräver mer än tekniska åtgärder – det kräver en sammanhängande affärsstrategi som är anpassad till din intäktsmodell och konkurrensposition. The Atlantics tillvägagångssätt är ett praktiskt ramverk: de utvärderar varje robot utifrån två huvudmått—trafikvolym och prenumerationskonverteringar—och ställer frågan om roboten genererar tillräckligt värde för att motivera åtkomst. För en publicist med 800 kr årligt prenumerantvärde motsvarar en robot som driver 1 000 nya prenumeranter 800 000 kr i årliga intäkter, vilket fundamentalt förändrar åtkomstbeslutet. Men trafik- och prenumerationsdata är bara en del av ekvationen. Publicister måste även beakta:

De mest strategiska publicisterna använder nivåindelade åtkomstpolicyer: tillåter sökerobotar som driver trafik, blockerar träningsrobotar som inte gör det, och förhandlar licensavtal med AI-aktörer av högt värde. Detta maximerar både synlighet och intäkter, samtidigt som immateriella rättigheter skyddas.

Även om differentierad robotåtkomst erbjuder stora fördelar är verkligheten mer komplex än teorin, med flera grundläggande utmaningar som begränsar effektiviteten och kräver kontinuerlig hantering. Den viktigaste begränsningen är att robots.txt är frivillig—robotar som följer den gör det av eget val, inte av tvång. Forskning visar att robots.txt endast stoppar 40–60 % av AI-botar, ytterligare 30–40 % fångas av blockering av user agent, och 10–30 % av robotarna agerar utan restriktion. Vissa AI-företag och illvilliga aktörer ignorerar medvetet robots.txt, då innehållsåtkomst anses mer värdefullt än regelefterlevnad. Dessutom utvecklas roboternas kringgåendetekniker ständigt: avancerade botar förfalskar user agents för att verka som legitima webbläsare, använder distribuerade IP-adresser för att undvika upptäckt och utnyttjar headless browsers som imiterar mänskligt beteende. Google-Extended-dilemmat illustrerar komplexiteten: att blockera Google-Extended hindrar ditt innehåll från att tränas på Gemini AI, men Google AI Overviews (som syns i sökresultat) använder vanliga Googlebot-regler, vilket innebär att du inte kan välja bort AI Overviews utan att offra söksynligheten. Övervakning och genomdrivning kräver också betydande resurser—att följa nya robotar, uppdatera policyer och validera effekter kräver fortlöpande arbete. Slutligen är den juridiska situationen osäker: även om upphovsrättslagen teoretiskt skyddar innehåll är efterlevnad mot AI-företag kostsam och utfallet osäkert, vilket lämnar publicister med teknisk kontroll men utan juridisk säkerhet.

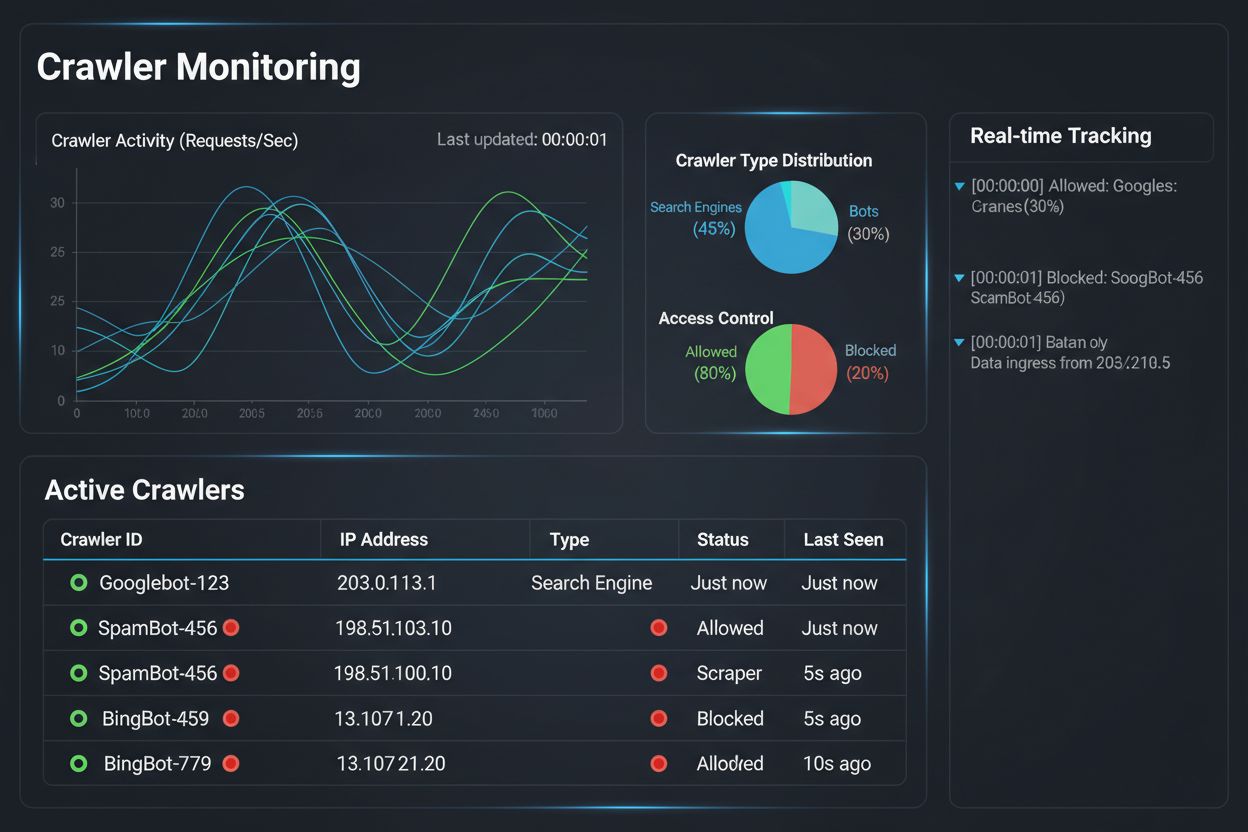

Att införa en strategi för differentierad robotåtkomst är bara halva jobbet; den andra halvan handlar om att förstå den faktiska effekten av dina policyer genom övervakning och mätning. Här blir AmICited.com en central del av din robot-hanteringsstrategi. AmICited är specialiserade på att övervaka hur AI-system refererar till och citerar ditt varumärke i GPT:er, Perplexity, Google AI Overviews och andra AI-plattformar—och ger insyn i vilka robotar som faktiskt använder ditt innehåll och hur det syns i AI-genererade svar. Istället för att förlita dig på serverloggar och gissningar visar AmICiteds dashboard exakt vilka AI-system som har åtkomst till ditt innehåll, hur ofta, och viktigast av allt, om ditt innehåll citeras eller bara absorberas i träningsdata utan attribution. Denna kunskap informerar direkt dina åtkomstbeslut: om en robot besöker ditt innehåll men aldrig citerar det i AI-svar är blockering ett tydligt affärsbeslut. AmICited möjliggör även konkurrensjämförelser och visar hur din synlighet i AI-system står sig mot konkurrenternas, så att du ser om dina policyer är för restriktiva eller för tillåtande. Plattformens realtidslarm varnar dig när nya AI-system börjar referera till ditt innehåll, så att du snabbt kan justera policyer. Genom att kombinera AmICiteds övervakningsmöjligheter med Cloudflares skydd får publicister fullständig insyn och kontroll: de ser vilka robotar som besöker deras innehåll, mäter affärseffekten och justerar policyer därefter. Detta datadrivna arbetssätt gör robot-hantering till en strategisk affärsfunktion istället för ett tekniskt krav.

Landskapet för differentierad robotåtkomst förändras snabbt, med nya standarder och affärsmodeller som omformar relationen mellan publicister och AI-företag kring innehåll. IETF:s förslag om AI-preferenser är en viktig utveckling och etablerar standardiserade sätt för webbplatser att kommunicera sina preferenser kring AI-träning, inferens och sökanvändning. Istället för att förlita sig på robots.txt—en 30 år gammal standard avsedd för sökmotorer—ger denna nya ram explicit och detaljerad kontroll över hur AI-system får använda innehåll. Parallellt vinner tillståndsbaserade affärsmodeller mark, där Cloudflares Pay Per Crawl-initiativ är pionjärer med en modell där AI-företag betalar för åtkomst och därmed förvandlar robotar från hot till intäktskällor. Detta skifte från blockering till licensiering innebär en grundläggande förändring av internets ekonomi: istället för att slåss om åtkomst förhandlar publicister och AI-företag om rättvis ersättning. Autentisering och verifieringsstandarder för robotar går också framåt, där kryptografiska metoder gör att publicister kan verifiera robotidentitet och förhindra förfalskade förfrågningar. Framöver kan vi förvänta oss ökade regulatoriska ramverk kring AI-träningsdata, potentiellt med krav på explicit samtycke och ersättning för innehållsanvändning. Sammanflödet av dessa trender—tekniska standarder, licensmodeller, autentiseringsmetoder och regulatoriskt tryck—tyder på att differentierad robotåtkomst kommer att utvecklas från en defensiv strategi till en sofistikerad affärsfunktion där publicister aktivt hanterar, övervakar och monetiserar AI-robotars åtkomst. De publicister som redan idag implementerar heltäckande övervakning och strategiska policyer kommer att vara bäst positionerade för att dra nytta av framtidens möjligheter.

Att blockera alla robotar tar bort ditt innehåll från AI-system helt, vilket eliminerar både risker och möjligheter. Differentierad åtkomst gör det möjligt att utvärdera varje robot individuellt, blockera de som inte ger värde och tillåta de som driver trafik eller utgör licensieringsmöjligheter. Detta nyanserade tillvägagångssätt maximerar både synlighet och intäkter samtidigt som immateriella rättigheter skyddas.

Du kan övervaka robotaktivitet via serverloggar, Cloudflares analysdashboard eller specialiserade övervakningsverktyg som AmICited.com. AmICited spårar specifikt vilka AI-system som har åtkomst till ditt innehåll och hur ditt varumärke syns i AI-genererade svar, vilket ger affärsnivåinsikter utöver tekniska loggar.

Nej. Att blockera AI-träningsrobotar som GPTBot, ClaudeBot och CCBot påverkar inte din Google- eller Bing-rankning. Traditionella sökmotorer använder andra robotar (Googlebot, Bingbot) som arbetar oberoende. Blockera endast dessa om du vill försvinna helt ur sökresultaten.

Ja, detta är det mest strategiska tillvägagångssättet för många publicister. Du kan tillåta sökfokuserade robotar som OAI-SearchBot och PerplexityBot (som driver trafik) och samtidigt blockera träningsrobotar som GPTBot och ClaudeBot (som vanligtvis inte gör det). Detta bibehåller synlighet i AI-sökresultat samtidigt som innehållet skyddas från att användas i träningsdatamängder.

Medan större robotar från OpenAI, Anthropic och Google respekterar robots.txt, ignorerar vissa botar den medvetet. Om en robot inte respekterar din robots.txt behöver du ytterligare åtgärder som WAF-regler, IP-blockering eller Cloudflares bot-hanteringsfunktioner. Därför är övervakningsverktyg som AmICited viktiga – de visar vilka robotar som faktiskt respekterar dina policyer.

Granska dina policyer minst en gång per kvartal, eftersom AI-företag regelbundet introducerar nya robotar. Anthropic slog ihop sina 'anthropic-ai'- och 'Claude-Web'-botar till 'ClaudeBot', vilket gav den nya boten tillfällig obegränsad åtkomst till webbplatser som inte hade uppdaterat sina regler. Regelbunden övervakning med verktyg som AmICited hjälper dig att ligga steget före förändringar.

Googlebot är Googles sökrobot som indexerar innehåll för sökresultat. Google-Extended är en kontrolltoken som specifikt styr om ditt innehåll används för Gemini AI-träning. Du kan blockera Google-Extended utan att påverka sökrankningen, men observera att Google AI Overviews (som syns i sökresultat) använder vanliga Googlebot-regler, så du kan inte välja bort AI Overviews utan att förlora söksynlighet.

Ja, framväxande licensmodeller som Cloudflares Pay Per Crawl gör det möjligt för publicister att ta betalt av AI-företag för innehållsåtkomst. Detta förvandlar robotar från hot till intäktskällor. Dock krävs förhandling med AI-företag och det kan innebära juridiska avtal. AmICiteds övervakning hjälper dig identifiera vilka robotar som utgör de mest värdefulla licensieringsmöjligheterna.

Spåra vilka AI-system som har åtkomst till ditt innehåll och hur ditt varumärke syns i AI-genererade svar. Få insikter i realtid om robotbeteende och mät affärseffekten av dina differentierade åtkomstpolicyer.

Lär dig hur du använder robots.txt för att styra vilka AI-botar som får tillgång till ditt innehåll. Komplett guide till att blockera GPTBot, ClaudeBot och andr...

Lär dig hur du granskar AI-crawlers åtkomst till din webbplats. Upptäck vilka botar som kan se ditt innehåll och åtgärda hinder som förhindrar AI-synlighet i Ch...

Lär dig hur du konfigurerar robots.txt för AI-crawlers inklusive GPTBot, ClaudeBot och PerplexityBot. Förstå AI-crawlerkategorier, blockeringsstrategier och bäs...