Hur dynamisk rendering påverkar AI: Effekt på crawlbarhet och synlighet

Lär dig hur dynamisk rendering påverkar AI-crawlare, ChatGPT, Perplexity och Claude synlighet. Upptäck varför AI-system inte kan rendera JavaScript och hur du o...

Dynamisk rendering är en serverbaserad teknik som upptäcker om en begäran kommer från en användare eller en sökmotorbot och serverar därefter olika versioner av samma innehåll—klientsidesrenderad JavaScript för användare och helt serverrenderad statisk HTML för botar. Detta tillvägagångssätt optimerar genomsökningsbarhet och indexering samtidigt som full användarupplevelse bibehålls.

Dynamisk rendering är en serverbaserad teknik som upptäcker om en begäran kommer från en användare eller en sökmotorbot och serverar därefter olika versioner av samma innehåll—klientsidesrenderad JavaScript för användare och helt serverrenderad statisk HTML för botar. Detta tillvägagångssätt optimerar genomsökningsbarhet och indexering samtidigt som full användarupplevelse bibehålls.

Dynamisk rendering är en serverbaserad innehållsleveransmetod som upptäcker vilken typ av begäran som görs till en webbplats—om det är från en mänsklig användare eller en sökmotorbot—och serverar optimerade versioner av innehållet därefter. När en användare besöker en sida får de den fullständiga klientsidesrenderade versionen med all JavaScript, interaktiva element och dynamiska funktioner intakta. När däremot en sökmotorbot eller AI-crawler begär samma sida, upptäcker servern detta genom identifiering av user-agent och vidarebefordrar begäran till en renderingsmotor som omvandlar JavaScript-tungt innehåll till statisk, fullt renderad HTML. Denna statiska version serveras sedan till boten, vilket eliminerar behovet för boten att exekvera JavaScript-kod. Tekniken uppstod som en praktisk lösning på utmaningen att sökmotorer har svårt att bearbeta JavaScript i stor skala, och den har blivit allt viktigare i takt med att AI-drivna sökplattformar såsom ChatGPT, Perplexity, Claude och Google AI Overviews ökat sina genomsökningsaktiviteter på webben.

Dynamisk rendering introducerades formellt för SEO-communityt av Google under I/O-konferensen 2018, när John Mueller presenterade det som en lösning för indexeringsproblem relaterade till JavaScript. Då erkände Google att även om Googlebot tekniskt sett kunde rendera JavaScript, krävde det stora mängder datorkraft och ledde till förseningar i upptäckt och indexering av innehåll. Bing följde efter i juni 2018 och uppdaterade sina Webmaster Guidelines för att rekommendera dynamisk rendering, särskilt för stora webbplatser med begränsningar i JavaScript-bearbetning. Tekniken fick snabbt genomslag bland företagssajter och JavaScript-tunga applikationer som en pragmatisk kompromiss mellan att behålla rika användarupplevelser och säkerställa sökmotoråtkomst. Googles inställning förändrades dock påtagligt 2022, när företaget uppdaterade sin officiella dokumentation och tydligt slog fast att dynamisk rendering är en tillfällig lösning och inte en långsiktig strategi. Denna förändring speglar Googles preferens för mer hållbara rendering-metoder såsom server-side rendering (SSR), statisk rendering och hydrering. Trots denna omklassificering används dynamisk rendering fortfarande i stor utsträckning på webben, särskilt bland stora e-handelsplattformar, single-page-applikationer och innehållstunga webbplatser som inte omedelbart kan migrera till alternativa renderingarkitekturer.

Dynamisk rendering bygger på tre kärnkomponenter som samverkar: user-agent-detektion, innehållsroutning och rendering och caching. När en begäran kommer till en webbserver identifieras först om den ursprungligen kommer från en mänsklig användare eller en automatisk bot. Detta sker genom analys av user-agent-strängen i HTTP-begäranshuvudet, som innehåller information om klienten. Sökmotorbotar som Googlebot, Bingbot och AI-crawlare från plattformar som Perplexity och Claude identifierar sig själva med specifika user-agent-strängar. När en bot upptäckts skickar servern begäran till en dynamisk renderings-tjänst eller mellanprogram, som vanligtvis använder en headless browser (såsom Chromium eller Puppeteer) för att rendera sidans JavaScript och konvertera den till statisk HTML. Renderingsprocessen exekverar all JavaScript-kod, laddar dynamiskt innehåll och genererar den slutliga DOM (Document Object Model) som normalt skulle skapas i användarens webbläsare. Den resulterande statiska HTML:en cachas sedan för att undvika onödig renderingsbelastning och levereras direkt till boten. För mänskliga användare kringgår begäran hela denna renderingspipeline och serveras den ursprungliga klientsidesrenderade versionen, så de får hela den interaktiva upplevelsen med animationer, uppdateringar i realtid och dynamiska funktioner.

| Aspekt | Dynamisk rendering | Server-side rendering (SSR) | Statisk rendering | Client-side rendering (CSR) |

|---|---|---|---|---|

| Innehåll till användare | Klientsidesrenderad (JavaScript) | Serverrenderad (HTML) | Förbyggd statisk HTML | Klientsidesrenderad (JavaScript) |

| Innehåll till botar | Serverrenderad (HTML) | Serverrenderad (HTML) | Förbyggd statisk HTML | Klientsidesrenderad (JavaScript) |

| Implementeringskomplexitet | Måttlig | Hög | Låg | Låg |

| Resurskrav | Medel (rendering endast för botar) | Hög (rendering för alla begäranden) | Låg (ingen rendering behövs) | Låg (endast klienten) |

| Prestanda för användare | Beror på JavaScript | Utmärkt | Utmärkt | Varierande |

| Prestanda för botar | Utmärkt | Utmärkt | Utmärkt | Dålig |

| Crawl budget-effekt | Positiv (snabbare botbearbetning) | Positiv (snabbare botbearbetning) | Positiv (snabbast) | Negativ (långsam rendering) |

| SEO-rekommendation | Tillfällig lösning | Långsiktigt föredragen | Långsiktigt föredragen | Rekommenderas ej för SEO |

| Bästa användningsfall | Stora JS-tunga sajter med budgetbegränsning | Moderna webbapplikationer | Bloggar, dokumentation, statiskt innehåll | Användarfokuserade appar utan SEO-behov |

| Underhållsbörda | Låg–måttlig | Hög | Låg | Låg |

Anledningen till att dynamisk rendering existerar är en kritisk utmaning i modern webb: JavaScript-rendering i stor skala. JavaScript möjliggör rika, interaktiva användarupplevelser med realtidsuppdateringar, animationer och komplex funktionalitet, men det innebär stora hinder för sökmotorbotar. När en sökmotorbot möter en sida byggd med exempelvis React, Vue eller Angular måste boten exekvera JavaScript-koden för att se det slutgiltiga innehållet. Denna process är både datorkraftskrävande och tidsödande. Google har öppet erkänt denna utmaning, bland annat genom Martin Splitt, Google Search Advocate: “Även om Googlebot kan köra JavaScript vill vi inte förlita oss på det.” Anledningen är att Google har en begränsad crawl budget—en viss mängd tid och resurser som tilldelas varje webbplats. Enligt en studie från Botify som analyserade 6,2 miljarder Googlebot-begäranden över 413 miljoner webbsidor, går cirka 51% av sidorna på stora företagswebbplatser oindekserade på grund av crawl budget-begränsningar. När JavaScript saktar ner genomsökningen upptäcks och indexeras färre sidor. Dessutom finns en render budget separat från crawl budget, vilket innebär att även om en sida genomsökts kan Google skjuta upp JavaScript-renderingen tills resurser finns, vilket kan försena indexering med timmar eller dagar. Detta är särskilt problematiskt för e-handelssajter med snabbt skiftande lager eller nyhetssajter som publicerar hundratals artiklar dagligen, där snabb indexering är avgörande för synlighet och trafik.

Crawl budget är ett av de viktigaste men mest missförstådda begreppen inom SEO. Google beräknar crawl budget med formeln: Crawl Budget = Crawl Capacity + Crawl Demand. Crawl capacity beror på sidladdningstid och serverfel, medan crawl demand beror på sidans popularitet och uppdateringsfrekvens. När en webbplats implementerar dynamisk rendering förbättras crawl capacity direkt genom att minska tiden botar spenderar på varje sida. Forskning visar att sidor med renderingstider under 3 sekunder får cirka 45% mer frekvent ominedning jämfört med sidor med 500–1000 ms laddningstid, och cirka 130% mer crawling än sidor som överstiger 1000 ms. Genom att servera för-renderad statisk HTML till botar istället för JavaScript-tungt innehåll kan dynamisk rendering drastiskt minska laddningstiden för crawlare, så de kan bearbeta fler sidor inom sin budget. Denna effektivitet leder direkt till förbättrad indexering. För stora webbplatser med tusentals eller miljontals sidor kan det innebära skillnaden mellan att få 50% av sidorna indexerade eller 80% eller mer. Dessutom säkerställer dynamisk rendering att JavaScript-laddat innehåll omedelbart blir synligt för botar i stället för att skjutas upp i en sekundär renderingskö. Detta är särskilt viktigt för innehåll som ändras ofta, så att botar ser den aktuella versionen istället för en cachad eller föråldrad rendering.

Framväxten av AI-drivna sökplattformar som ChatGPT, Perplexity, Claude och Google AI Overviews har gett den dynamiska rendering-diskussionen en ny dimension. Dessa plattformar har egna crawlare som bearbetar webbinnehåll för att generera AI-baserade svar och sammanfattningar. Till skillnad från traditionella sökmotorer som främst indexerar sidor för ranking, behöver AI-crawlare komma åt och förstå innehållet på djupet för att skapa korrekta, kontextuella svar. Dynamisk rendering blir extra viktig i detta sammanhang eftersom den säkerställer att AI-crawlare kan nå ditt innehåll effektivt och fullständigt. När AmICited övervakar ditt varumärkes synlighet i AI-genererade svar på dessa plattformar, är den avgörande faktorn om AI-crawlaren kunde komma åt och förstå ditt innehåll. Om din webbplats är starkt beroende av JavaScript och saknar dynamisk rendering kan AI-crawlare få svårt att nå ditt innehåll, vilket minskar sannolikheten att ditt varumärke syns i AI-svar. Webbplatser med rätt implementerad dynamisk rendering säkerställer däremot att AI-crawlare får fullt renderat, tillgängligt innehåll och därmed ökar sannolikheten för citering och synlighet. Detta gör dynamisk rendering till inte bara en SEO-fråga utan en central del av Generative Engine Optimization (GEO)-strategin. Organisationer som använder AmICited för att övervaka sin synlighet i AI-sök bör se dynamisk rendering som en grundläggande teknisk implementation för att maximera exponeringen i alla AI-plattformar.

Att implementera dynamisk rendering kräver noggrann planering och tekniskt utförande. Första steget är att identifiera vilka sidor som kräver dynamisk rendering—vanligtvis prioriterade sidor som startsidor, produktsidor och innehåll som genererar mycket trafik eller förändras ofta. Alla sidor behöver inte dynamisk rendering; statiska sidor med minimalt JavaScript kan ofta genomsökas effektivt ändå. Nästa steg är att välja en renderingslösning. Populära alternativ är Prerender.io (en betaltjänst som hanterar rendering och caching), Rendertron (Googles open source-lösning baserad på headless Chromium), Puppeteer (ett Node.js-bibliotek för att styra headless Chrome) och specialiserade plattformar som Nostra AI’s Crawler Optimization. Varje lösning har olika kompromisser kring kostnad, komplexitet och underhåll. Efter att ha valt renderingsverktyg måste utvecklare konfigurera user-agent-detekteringsmiddleware på servern för att identifiera bot-begäranden och vidarebefordra dem. Detta innebär oftast att kontrollera user-agent-strängen mot en lista av kända botar och proxyfodra bot-begäranden till renderingsmotorn. Caching är kritiskt—för-renderat innehåll bör cachas aggressivt för att undvika onödig rendering, vilket annars motverkar optimeringen. Slutligen ska implementationen verifieras med Google Search Consoles URL-inspektionsverktyg och Mobilvänlighetstestet för att säkerställa att botar får det renderade innehållet korrekt.

De huvudsakliga fördelarna med dynamisk rendering är betydande och väldokumenterade. Förbättrad genomsökningsbarhet är den mest omedelbara vinsten—genom att eliminera JavaScript-bearbetning kan botar genomsöka fler sidor snabbare. Bättre indexeringsgrad följer naturligt, då fler sidor upptäcks och indexeras inom crawl budget. Snabbare botbearbetning minskar serverbelastningen från rendering, eftersom rendering sker en gång och cachas istället för vid varje botbesök. Bibehållen användarupplevelse särskiljer dynamisk rendering från andra lösningar—användare får fortsatt hela, interaktiva versionen av sajten utan försämring. Lägre implementeringskostnad jämfört med server-side rendering gör det tillgängligt för organisationer med begränsade resurser. Dock finns tydliga nackdelar. Komplexitet och underhållsbörda kan vara betydande, särskilt för stora webbplatser med tusentals sidor eller komplex struktur. Caching-utmaningar uppstår när innehållet ofta ändras—cachen måste då ogiltigförklaras och återskapas korrekt. Risk för inkonsekvens mellan användar- och bot-versionerna kan leda till indexeringsproblem om det inte hanteras noggrant. Resursförbrukning för renderings- och cacheinfrastruktur ger ökade driftkostnader. Viktigast är att Googles officiella hållning är att dynamisk rendering är en tillfällig lösning, inte en långsiktig strategi, så organisationer bör se det som en övergångsstrategi medan man planerar migrering till mer hållbara rendering-metoder.

Dynamisk renderings framtid är nära kopplad till bredare trender inom webb- och sökmotorteknik. I takt med att JavaScript-ramverk fortsätter dominera modern webbutveckling kvarstår behovet av lösningar som balanserar rika användarupplevelser och bot-tillgänglighet. Men branschen rör sig långsamt mot mer hållbara metoder. Server-side rendering blir allt mer praktiskt i och med ramverk som Next.js, Nuxt och Remix gör SSR mer tillgängligt för utvecklare. Statisk rendering och inkrementell statisk regenerering ger utmärkt prestanda för innehåll som inte ändras ofta. Hydrering—där en sida först renderas på servern och sedan får interaktivitet på klienten—är ett mellanting som får ökad spridning. Googles uppdaterade riktlinjer rekommenderar uttryckligen dessa alternativ framför dynamisk rendering, vilket signalerar att sökjätten ser dynamisk rendering som en övergångslösning snarare än ett permanent mönster. Framväxten av AI-drivna sökplattformar ger ytterligare en dimension. I takt med att dessa plattformar blir bättre på genomsökning och innehållsförståelse ökar vikten av tillgängligt, välstrukturerat innehåll. Dynamisk rendering kommer sannolikt vara relevant för organisationer med äldre system eller särskilda begränsningar, men nya projekt bör prioritera hållbara renderingstrategier från början. För organisationer som använder AmICited för att övervaka AI-sök-synlighet är slutsatsen tydlig: även om dynamisk rendering kan öka din omedelbara synlighet i AI-svar, bör planering för migrering till mer hållbara rendering-metoder vara en del av din långsiktiga Generative Engine Optimization-strategi. Sammanflätningen av traditionell SEO, teknisk prestandaoptimering och AI-sök-synlighet gör renderingsstrategin till en central affärsfråga för synlighet i alla sökplattformar.

Nej, Google säger uttryckligen att dynamisk rendering inte är cloaking så länge innehållet som serveras till botar och användare är väsentligen likadant. Cloaking innebär att man medvetet serverar helt olika innehåll för att lura sökmotorer, medan dynamisk rendering serverar samma innehåll i olika format. Att servera helt olika sidor (som katter till användare och hundar till botar) skulle dock räknas som cloaking och bryter mot Googles policy.

Dynamisk rendering minskar de datorkapacitetsresurser som krävs för att sökmotorbotar ska bearbeta JavaScript, vilket gör att de kan genomsöka fler sidor inom sin tilldelade crawl budget. Genom att servera förgenererad statisk HTML istället för JavaScript-tungt innehåll kan botar komma åt och indexera sidor snabbare. Forskning visar att sidor med renderingstider under 3 sekunder får cirka 45% mer frekvent ominedning jämfört med långsammare sidor, vilket direkt förbättrar indexeringsgraden.

Server-side rendering (SSR) förrenderar innehåll på servern för både användare och botar, vilket förbättrar prestandan för alla men kräver betydande utvecklingsresurser. Dynamisk rendering förrenderar endast för botar medan användare får den vanliga klientsidesrenderade versionen, vilket gör det mindre resurskrävande att implementera. Google rekommenderar dock numera SSR, statisk rendering eller hydration som långsiktiga lösningar istället för dynamisk rendering, som anses vara en tillfällig lösning.

Dynamisk rendering är idealiskt för stora JavaScript-tunga webbplatser med snabbt förändrat innehåll, såsom e-handelsplattformar med ständigt uppdaterat lager, single-page-applikationer och sajter med komplexa interaktiva funktioner. Webbplatser med crawl budget-problem—där Google misslyckas med att genomsöka betydande delar av deras innehåll—är särskilt lämpade. Enligt forskning missar Google cirka 51% av sidorna på stora företagswebbplatser på grund av crawl budget-begränsningar.

AI-crawlare som används av plattformar som ChatGPT, Perplexity och Claude behandlar webbinnehåll på liknande sätt som traditionella sökmotorbotar och kräver fullt tillgängligt HTML-innehåll för optimal indexering. Dynamisk rendering hjälper dessa AI-system att få åtkomst till och förstå JavaScript-genererat innehåll mer effektivt, vilket ökar sannolikheten att din webbplats dyker upp i AI-genererade svar och sammanfattningar. Detta är särskilt viktigt för AmICited-övervakning, eftersom korrekt rendering säkerställer att ditt varumärke syns i AI-sökresultat.

Populära lösningar för dynamisk rendering inkluderar Prerender.io (betaltjänst), Rendertron (öppen källkod), Puppeteer och specialiserade plattformar som Nostra AI's Crawler Optimization. Dessa verktyg identifierar bot-user agents, genererar statiska HTML-versioner av sidor och cachar dem för snabbare leverans. Implementeringen innebär oftast installation av en renderer på din server, konfiguration av middleware för user-agent-detektion och verifiering via Google Search Consoles URL-inspektionsverktyg.

Nej, dynamisk rendering har ingen påverkan på användarupplevelsen eftersom besökare fortsätter att få den fullständiga, klientsidesrenderade versionen av din webbplats med alla interaktiva element, animationer och dynamiska funktioner intakta. Användare ser aldrig den statiska HTML-versionen som serveras till botar. Tekniken är specifikt utformad för att optimera botars genomsökningsmöjligheter utan att kompromissa med den rika, interaktiva upplevelsen som mänskliga besökare förväntar sig och uppskattar.

Google rekommenderade dynamisk rendering 2018 som en praktisk lösning på JavaScript-renderingsbegränsningar i stor skala. Från och med 2022 har Google dock uppdaterat sina riktlinjer och tydliggjort att dynamisk rendering är en tillfällig lösning, inte en långsiktig strategi. Rekommendationsförändringen speglar Googles preferens för mer hållbara metoder som server-side rendering, statisk rendering eller hydration. Dynamisk rendering är fortfarande giltigt för vissa fall men bör ses som en del av en bredare prestandaoptimeringsstrategi snarare än en fristående lösning.

Börja spåra hur AI-chatbotar nämner ditt varumärke på ChatGPT, Perplexity och andra plattformar. Få handlingsbara insikter för att förbättra din AI-närvaro.

Lär dig hur dynamisk rendering påverkar AI-crawlare, ChatGPT, Perplexity och Claude synlighet. Upptäck varför AI-system inte kan rendera JavaScript och hur du o...

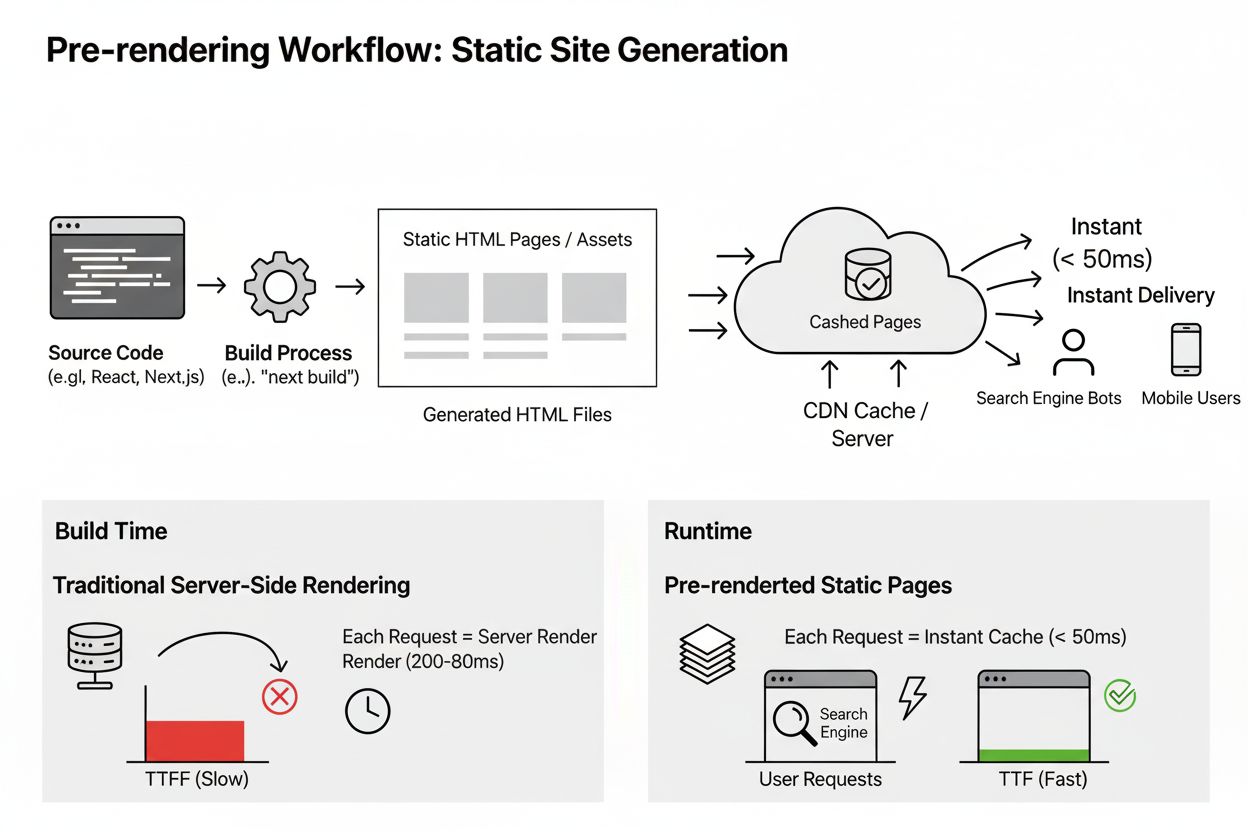

För-rendering genererar statiska HTML-sidor vid byggtillfället för omedelbar leverans och förbättrad SEO. Lär dig hur denna teknik gynnar AI-indexering, prestan...

Lär dig hur för-rendering hjälper din webbplats att synas i AI-sökresultat från ChatGPT, Perplexity och Claude. Förstå den tekniska implementeringen och fördela...