Vad är GPTBot och Bör Du Tillåta Det? Komplett Guide för Webbplatsägare

Lär dig vad GPTBot är, hur det fungerar och om du bör tillåta eller blockera OpenAI:s webcrawler. Förstå effekten på din varumärkesexponering i AI-sökmotorer oc...

OpenAIs officiella webbspindel som samlar in träningsdata för AI-modeller som ChatGPT och GPT-4. Webbplatsägare kan kontrollera åtkomst via robots.txt med direktiven ‘User-agent: GPTBot’. Spindeln följer standardprotokoll för webben och indexerar endast offentligt tillgängligt innehåll.

OpenAIs officiella webbspindel som samlar in träningsdata för AI-modeller som ChatGPT och GPT-4. Webbplatsägare kan kontrollera åtkomst via robots.txt med direktiven 'User-agent: GPTBot'. Spindeln följer standardprotokoll för webben och indexerar endast offentligt tillgängligt innehåll.

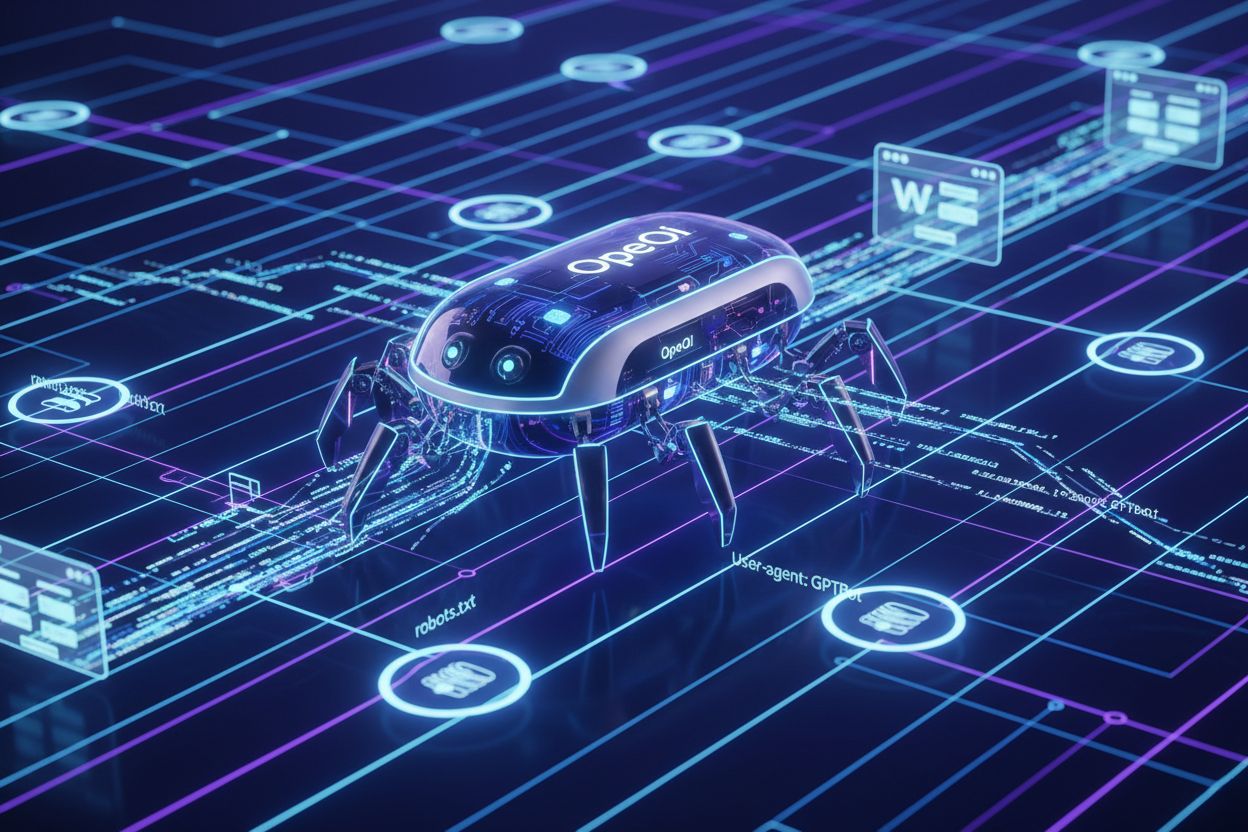

GPTBot är OpenAIs officiella webbspindel, utformad för att indexera offentligt tillgängligt innehåll från hela internet för att träna och förbättra AI-modeller som ChatGPT och GPT-4. Till skillnad från generella sökmotorspindlar som Googlebot har GPTBot ett specifikt uppdrag: att samla in data som hjälper OpenAI att förfina sina språkmodeller och ge bättre AI-drivna svar till användare. Webbplatsägare kan identifiera GPTBot via dess distinkta user agent string (“GPTBot/1.0”), som syns i serverloggar och analysplattformar när spindeln besöker deras sidor. GPTBot följer robots.txt-filen, vilket innebär att webbplatsägare kan styra om spindeln får åtkomst till deras innehåll genom att lägga till specifika direktiv i denna fil. Spindeln indexerar endast offentligt tillgängligt innehåll och försöker inte kringgå autentisering eller komma åt skyddade områden på webbplatser. Att förstå GPTBots syfte och beteende är viktigt för webbplatsägare som vill fatta välgrundade beslut om de ska tillåta eller blockera denna spindel från att nå deras digitala tillgångar.

GPTBot arbetar genom att systematiskt genomsöka webbsidor, analysera innehållet och skicka data tillbaka till OpenAIs servrar för bearbetning och modellträning. Spindeln kontrollerar först webbplatsens robots.txt-fil för att avgöra vilka sidor den har tillåtelse att besöka och följer de direktiv som webbplatsägaren angett innan någon indexering sker. När GPTBot identifierar sig via sin user agent-sträng laddar den ner och bearbetar sidans innehåll, extraherar text, metadata och strukturell information som bidrar till träningsdatamängder. Spindeln kan generera betydande bandbreddsförbrukning; vissa webbplatser rapporterar 30TB eller mer i månatlig spindeltrafik från alla bots tillsammans, även om GPTBots individuella påverkan varierar beroende på webbplatsens storlek och innehållets relevans.

| Spindelnamn | Syfte | Följer robots.txt | Påverkan på SEO | Dataanvändning |

|---|---|---|---|---|

| GPTBot | Träna AI-modeller | Ja | Indirekt (AI-synlighet) | Träningsdata |

| Googlebot | Sökindexering | Ja | Direkt (ranking) | Sökresultat |

| Bingbot | Sökindexering | Ja | Direkt (ranking) | Sökresultat |

| ClaudeBot | Träna AI-modeller | Ja | Indirekt (AI-synlighet) | Träningsdata |

Webbplatsägare kan övervaka GPTBots aktivitet genom serverloggar genom att söka efter den specifika user agent-strängen, vilket gör det möjligt att spåra crawl-frekvens och identifiera potentiella prestandapåverkan. Spindelns beteende är utformat för att vara varsamt mot serverresurser, men webbplatser med hög trafik kan ändå märka av betydande bandbreddsförbrukning när flera AI-spindlar arbetar samtidigt.

Många webbplatsägare väljer att blockera GPTBot på grund av oro för innehållsanvändning utan ersättning, eftersom OpenAI använder insamlat material för att träna kommersiella AI-modeller utan att ge någon direkt fördel eller ersättning till innehållsskapare. Serverbelastning är en annan stor oro, särskilt för mindre webbplatser eller de med begränsad bandbredd, då AI-spindlar kan använda betydande resurser—vissa rapporterar över 30TB månatlig spindeltrafik från alla bots, där GPTBot står för en ansenlig andel. Dataexponering och säkerhetsrisker oroar innehållsskapare som befarar att deras skyddade information, affärshemligheter eller känsliga data kan indexeras och användas i AI-träning, vilket potentiellt kan hota konkurrensfördelar eller bryta mot sekretessavtal. Den juridiska situationen kring AI-träningsdata är fortfarande oklar, med obesvarade frågor om GDPR-efterlevnad, CCPA-åtaganden och upphovsrättsintrång som skapar risker för både OpenAI och webbplatser som tillåter obegränsad crawling. Statistik visar att cirka 3,5 % av webbplatser aktivt blockerar GPTBot, medan över 30 stora publikationer bland de 100 största webbplatserna blockerar spindeln, inklusive The New York Times, CNN, Associated Press och Reuters—vilket visar att auktoritativa innehållsskapare ser betydande risker. Kombinationen av dessa faktorer har gjort blockering av GPTBot till en allt vanligare metod bland förlag, medieföretag och innehållsrika webbplatser som vill skydda sin immateriella egendom och bibehålla kontrollen över hur deras innehåll används.

Webbplatsägare som tillåter GPTBot ser det strategiska värdet i ChatGPT-synlighet, då plattformen har cirka 800 miljoner veckovisa användare som ofta interagerar med AI-genererade svar som kan hänvisa till eller sammanfatta indexerat innehåll. När GPTBot genomsöker en webbplats ökar sannolikheten för att dess innehåll citeras, sammanfattas eller refereras i ChatGPT-svar, vilket ger varumärkesnärvaro i AI-gränssnitt och når användare som i allt högre utsträckning vänder sig till AI-verktyg istället för traditionella sökmotorer. Forskning visar att AI-söktrafik konverterar 23 gånger bättre än traditionell organisk söktrafik, vilket innebär att användare som hittar innehåll via AI-sammanfattningar och rekommendationer har betydligt högre engagemang och konverteringsgrad jämfört med vanliga sökmotorbesökare. Att tillåta GPTBot är också en form av framtidssäkring, eftersom AI-drivet sök och innehållsupptäckt blir allt mer dominerande för hur användare hittar information online, vilket gör tidig satsning på AI-synlighet till en konkurrensfördel. Webbplatsägare som satsar på GPTBot-positionering drar även nytta av Generative Engine Optimization (GEO), en framväxande disciplin som fokuserar på att optimera innehåll för AI-system snarare än traditionella sökalgoritmer och kan driva betydande långsiktig tillväxt i trafiken. Genom att tillåta GPTBot positionerar sig framtidsinriktade förlag och företag för att fånga trafik från det snabbt växande segmentet användare som förlitar sig på AI-verktyg för informationsupptäckt och beslutsfattande.

Att blockera GPTBot är enkelt och kräver bara ändringar i din webbplats robots.txt-fil, som ligger i din rotkatalog och styr spindelåtkomst över hela domänen. Det enklaste sättet är att lägga till en totalblockering för alla OpenAI-spindlar:

User-agent: GPTBot

Disallow: /

Om du vill blockera GPTBot från specifika kataloger men tillåta åtkomst till andra, använd riktade direktiv:

User-agent: GPTBot

Disallow: /private/

Disallow: /admin/

Disallow: /api/

För att blockera alla OpenAI-relaterade spindlar, inklusive GPTBot, ChatGPT-User och ChatGPT-Plugins:

User-agent: GPTBot

User-agent: ChatGPT-User

User-agent: ChatGPT-Plugins

Disallow: /

Utöver ändringar i robots.txt kan webbplatsägare använda alternativa blockeringsmetoder som IP-baserad blockering via brandväggar, Web Application Firewalls (WAF) som filtrerar förfrågningar efter user agent och hastighetsbegränsning som stryper spindlars bandbreddsanvändning. För maximal kontroll kombinerar vissa webbplatser flera metoder—robots.txt som primär mekanism och IP-blockering som sekundärt skydd mot spindlar som ignorerar robots.txt. Efter implementering av någon blockeringsstrategi, verifiera effekten genom att kontrollera dina serverloggar för GPTBot user agent-strängar för att bekräfta att spindeln inte längre når ditt innehåll.

Vissa branscher löper särskilda risker med obegränsad åtkomst för AI-spindlar och bör noga överväga om blockering av GPTBot ligger i linje med deras affärsintressen och skyddsstrategier för innehåll:

Dessa branscher bör införa blockeringsstrategier för att upprätthålla konkurrensfördelar, skydda skyddad information och säkerställa efterlevnad av dataskyddsregler.

Webbplatsägare bör regelbundet övervaka sina serverloggar för att identifiera GPTBot-aktivitet och spåra mönster i spindelbeteendet, vilket ger insyn i hur AI-system får åtkomst till och potentiellt använder deras innehåll. GPTBot-identifiering är enkel—spindeln identifierar sig via user agent-strängen “GPTBot/1.0” i HTTP-förfrågningshuvuden, vilket gör den lätt att särskilja från andra spindlar i serverloggar och analysverktyg. De flesta moderna analysverktyg och SEO-övervakningsprogram (inklusive Google Analytics, Semrush, Ahrefs och specialiserade bot-övervakningsplattformar) kategoriserar och rapporterar automatiskt GPTBot-aktivitet och ger webbplatsägare möjlighet att spåra crawl-frekvens, bandbreddsanvändning och besökta sidor utan manuell logganalys. Genom att analysera serverloggar direkt får man detaljerad information om GPTBot-förfrågningar, inklusive tidsstämplar, besökta URL:er, svarskoder och bandbreddsanvändning, vilket ger djupgående insikter om spindelbeteende. Regelbunden övervakning är avgörande eftersom spindelbeteendet kan förändras över tid, nya AI-spindlar kan dyka upp och blockeringsåtgärder behöver periodisk verifiering för att säkerställa att direktiven fungerar som tänkt. Webbplatsägare bör etablera grundvärden för normal spindeltrafik och undersöka avvikelser som kan tyda på ökad AI-aktivitet eller potentiella säkerhetsproblem som kräver åtgärd.

OpenAI har gjort offentliga åtaganden om ansvarsfull AI-utveckling och datahantering, inklusive tydliga uttalanden om att GPTBot respekterar webbplatsägares inställningar enligt robots.txt-filer och andra tekniska direktiv. Företaget betonar datasekretess och ansvarsfulla AI-principer, och erkänner att innehållsskapare har legitima intressen i att styra hur deras verk används och ersätts, även om OpenAIs nuvarande tillvägagångssätt inte ger direkt ersättning till de vars innehåll crawlas. OpenAIs dokumenterade policy bekräftar att GPTBot respekterar robots.txt-direktiv, vilket betyder att företaget har byggt in efterlevnadsmekanismer i sin spindelinfrastruktur och förväntar sig att webbplatsägare använder standardteknik för åtkomstkontroll. Företaget har också uttryckt vilja att föra dialog med förlag och innehållsskapare om dataanvändning, även om formella licensavtal och ersättningsmodeller fortfarande är begränsade. OpenAIs policyer utvecklas kontinuerligt som svar på juridiska processer, regulatoriskt tryck och branschfeedback, vilket tyder på att framtida versioner av GPTBot kan inkludera ytterligare skydd, transparensåtgärder eller ersättningsmodeller. Webbplatsägare bör följa OpenAIs officiella kommunikation och policyuppdateringar för att förstå hur företagets syn på crawlning och dataanvändning kan förändras över tid.

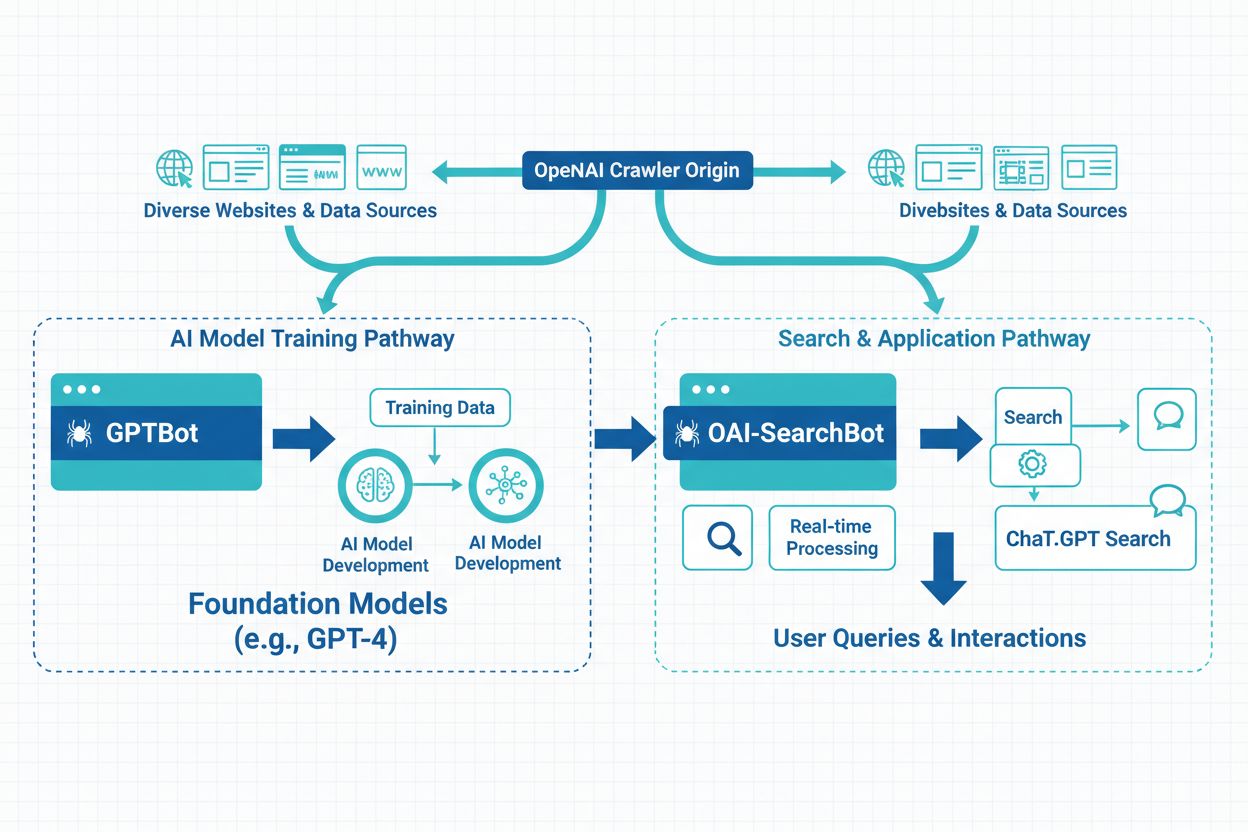

OpenAI driver tre olika typer av spindlar med olika syften: GPTBot (generell webbcrawling för modellträning), ChatGPT-User (crawlar länkar som delas av ChatGPT-användare) och ChatGPT-Plugins (får åtkomst via plugin-integrationer)—alla med olika user agent-strängar och åtkomstmönster. Utöver OpenAIs spindlar finns det många andra AI-spindlar från konkurrerande bolag: Google-Extended (Googles AI-träningsspindel), CCBot (Commoncrawl), Perplexity (AI-sökmotor), Claude (Anthropics AI-modell) och nya spindlar från andra AI-bolag, alla med olika syften och dataanvändning. Webbplatsägare står inför valet mellan selektiv blockering (blockera specifika spindlar som GPTBot men tillåta andra) och omfattande blockering (stoppa alla AI-spindlar för att behålla full kontroll över innehållsanvändning). Ökningen av AI-spindlar innebär att blockering av endast GPTBot kanske inte räcker för att skydda innehållet från AI-träning, eftersom andra spindlar fortfarande kan få åtkomst och indexera samma material via alternativa metoder. Vissa webbplatsägare använder nivåindelade strategier, där de blockerar de mest aggressiva eller kommersiellt betydelsefulla spindlarna men tillåter mindre eller forskningsinriktade spindlar. Att förstå skillnaderna mellan dessa spindlar hjälper webbplatsägare att fatta informerade beslut om vilka de ska blockera utifrån sina specifika farhågor kring dataanvändning, konkurrens och affärsmål.

ChatGPTs inflytande på sökbeteende omformar hur användare hittar information, med 800 miljoner veckovisa användare som i allt högre grad vänder sig till AI-verktyg istället för traditionella sökmotorer, vilket fundamentalt förändrar konkurrensen kring synlighet. AI-genererade sammanfattningar och utvalda utdrag i ChatGPT-svar fungerar nu som alternativa upptäcktsvägar, vilket innebär att innehåll som rankar högt i traditionella sökresultat kan förbises om det inte väljs ut för AI-genererade svar. Generative Engine Optimization (GEO) har blivit avgörande för framtidstänkande innehållsskapare och fokuserar på att optimera struktur, tydlighet och auktoritet för att öka chansen att inkluderas i AI-genererade svar och sammanfattningar. De långsiktiga synlighetskonsekvenserna är betydande: webbplatser som blockerar GPTBot kan förlora möjligheter att synas i ChatGPT-svar, vilket kan minska trafiken från den snabbt växande gruppen AI-drivna sökanvändare, medan de som tillåter åtkomst positionerar sig för AI-driven upptäckt. Forskning visar att 86,5 % av innehållet i Googles topp 20-sökresultat innehåller delvis AI-genererade element, vilket visar att AI-integration har blivit standard snarare än undantag i söklandskapet. Konkurrenspositionering beror allt mer på synlighet både i traditionella sökmotorer och AI-system, vilket gör strategiska beslut om GPTBot-åtkomst avgörande för långsiktig SEO-framgång och organisk tillväxt. Webbplatsägare måste väga skyddet av sitt innehåll mot risken att förlora synlighet i AI-system som snabbt blir primära verktyg för informationsupptäckt världen över.

GPTBot är OpenAIs officiella webbspindel utformad för att samla in träningsdata till AI-modeller som ChatGPT och GPT-4. Till skillnad från Googlebot, som indexerar innehåll för sökresultat, samlar GPTBot in data specifikt för att förbättra språkmodeller. Båda spindlarna följer robots.txt-direktiv och får endast tillgång till offentligt tillgängligt innehåll, men de tjänar fundamentalt olika syften i det digitala ekosystemet.

Beslutet beror på dina affärsmål och din innehållsstrategi. Blockera GPTBot om du har skyddat innehåll, verkar inom reglerade branscher eller har oro kring immateriella rättigheter. Tillåt GPTBot om du vill synas i ChatGPT (800 miljoner veckovisa användare), dra nytta av AI-söktrafik (som konverterar 23 gånger bättre än organisk), eller vill framtidssäkra din digitala närvaro för AI-drivet sök.

Lägg till dessa rader i din robots.txt-fil för att blockera GPTBot från hela din webbplats: User-agent: GPTBot / Disallow: /. För att blockera specifika kataloger, ersätt snedstrecket med katalogsökvägen. För att blockera alla OpenAI-spindlar, lägg till separata User-agent-poster för GPTBot, ChatGPT-User och ChatGPT-Plugins. Ändringarna får omedelbar verkan och är enkla att återställa.

GPTBots påverkan varierar beroende på din webbplats storlek och innehållets relevans. Medan påverkan från enskilda spindlar oftast är hanterbar kan flera AI-spindlar som arbetar samtidigt förbruka betydande bandbredd—vissa webbplatser rapporterar över 30TB månatlig spindeltrafik från alla bots. Övervaka dina serverloggar för att spåra GPTBot-aktivitet och implementera begränsningar eller IP-blockering om bandbreddsförbrukningen blir problematisk.

Ja, du kan använda riktade robots.txt-direktiv för att blockera GPTBot från specifika kataloger eller sidor medan du tillåter åtkomst till andra. Till exempel kan du neka åtkomst till /private/ och /admin/-kataloger och samtidigt tillåta resten av webbplatsen. Denna selektiva metod låter dig skydda känsligt innehåll samtidigt som du bibehåller synligheten i AI-system för publika sidor.

Kontrollera dina serverloggar efter användaragentsträngen 'GPTBot/1.0' i HTTP-förfrågningshuvuden. De flesta analysplattformar (Google Analytics, Semrush, Ahrefs) kategoriserar och rapporterar automatiskt GPTBot-aktivitet. Du kan också använda SEO-övervakningsverktyg som specifikt spårar AI-spindelaktivitet. Regelbunden övervakning hjälper dig att förstå crawl-frekvens och identifiera eventuella prestandapåverkan.

Det juridiska landskapet utvecklas fortfarande. Att tillåta GPTBot väcker frågor kring GDPR-efterlevnad, CCPA-åtaganden och upphovsrättsintrång, även om OpenAI hävdar att de följer robots.txt-direktiv. Att blockera GPTBot är juridiskt okomplicerat men kan begränsa din synlighet i AI-system. Konsultera juridisk expertis om du verkar inom reglerade branscher eller hanterar känslig data för att avgöra bästa tillvägagångssätt för din situation.

Att tillåta GPTBot påverkar inte direkt traditionella Google-rankningar, men ökar din synlighet i ChatGPT-svar och andra AI-drivna sökresultat. Med 800 miljoner ChatGPT-användare och AI-söktrafik som konverterar 23 gånger bättre än organisk, positionerar tillåtelse av GPTBot dig för långsiktig synlighet i AI-system. Att blockera GPTBot kan minska möjligheten att synas i AI-genererade svar och därmed begränsa trafiken från den snabbast växande sökkanalen.

Spåra hur ditt varumärke syns i ChatGPT, Perplexity, Google AI och andra AI-plattformar. Få insikter i realtid om AI-citeringar och synlighet med AmICited.

Lär dig vad GPTBot är, hur det fungerar och om du bör tillåta eller blockera OpenAI:s webcrawler. Förstå effekten på din varumärkesexponering i AI-sökmotorer oc...

Lär dig de viktigaste skillnaderna mellan GPTBot och OAI-SearchBot crawlers. Förstå deras syften, crawl-beteenden och hur du hanterar dem för optimal synlighet ...

Lär dig vad SearchGPT är, hur det fungerar och dess påverkan på sök, SEO och digital marknadsföring. Utforska funktioner, begränsningar och framtiden för AI-dri...