Vad är vektorsökning och hur fungerar det?

Lär dig hur vektorsökning använder maskininlärningsinbäddningar för att hitta liknande objekt baserat på betydelse snarare än exakta nyckelord. Förstå vektordat...

Vektorsökning är en metod för att hitta liknande objekt i en datamängd genom att representera data som matematiska vektorer och jämföra dem med hjälp av avståndsmått som cosinuslikhet eller euklidiskt avstånd. Detta tillvägagångssätt möjliggör semantisk förståelse bortom nyckelordsjämförelser, vilket låter system upptäcka relationer och likheter baserat på betydelse istället för exakta textmatchningar.

Vektorsökning är en metod för att hitta liknande objekt i en datamängd genom att representera data som matematiska vektorer och jämföra dem med hjälp av avståndsmått som cosinuslikhet eller euklidiskt avstånd. Detta tillvägagångssätt möjliggör semantisk förståelse bortom nyckelordsjämförelser, vilket låter system upptäcka relationer och likheter baserat på betydelse istället för exakta textmatchningar.

Vektorsökning är en metod för att hitta liknande objekt i en datamängd genom att representera data som matematiska vektorer och jämföra dem med hjälp av avståndsmått för att mäta semantisk likhet. Till skillnad från traditionell nyckelordsbaserad sökning som förlitar sig på exakta textmatchningar, förstår vektorsökning betydelsen och kontexten bakom data genom att omvandla den till högdimensionella numeriska representationer kallade vektor-inbäddningar. Detta tillvägagångssätt gör det möjligt för system att upptäcka relationer och likheter baserat på semantiskt innehåll snarare än ytstrukturer, vilket gör tekniken särskilt kraftfull för applikationer som kräver kontextuell förståelse. Vektorsökning har blivit grundläggande för moderna AI-system och möjliggör semantisk sökning, rekommendationsmotorer, avvikelsedetektering och retrieval-augmented generation (RAG) på plattformar som ChatGPT, Perplexity, Google AI Overviews och Claude.

I grunden omvandlar vektorsökning data till numeriska representationer där närhet i rummet indikerar semantisk likhet. Varje datapunkt – oavsett om det är text, bild eller ljud – omvandlas till en vektor, vilket i princip är en array av tal som representerar egenskaper eller betydelse. Till exempel kan ordet “restaurang” representeras som [0.2, -0.5, 0.8, 0.1], där varje tal fångar olika aspekter av ordets semantiska betydelse. Den grundläggande principen är att semantiskt liknande objekt får vektorer som placeras nära varandra i detta högdimensionella utrymme, medan olikartade objekt hamnar längre bort. Denna matematiska struktur gör det möjligt för datorer att jämföra begrepp baserat på betydelse snarare än exakta nyckelordsmatchningar, vilket gör att en sökning på “bästa matställen” kan ge resultat för “topprankade restauranger” även utan exakt ordöverensstämmelse.

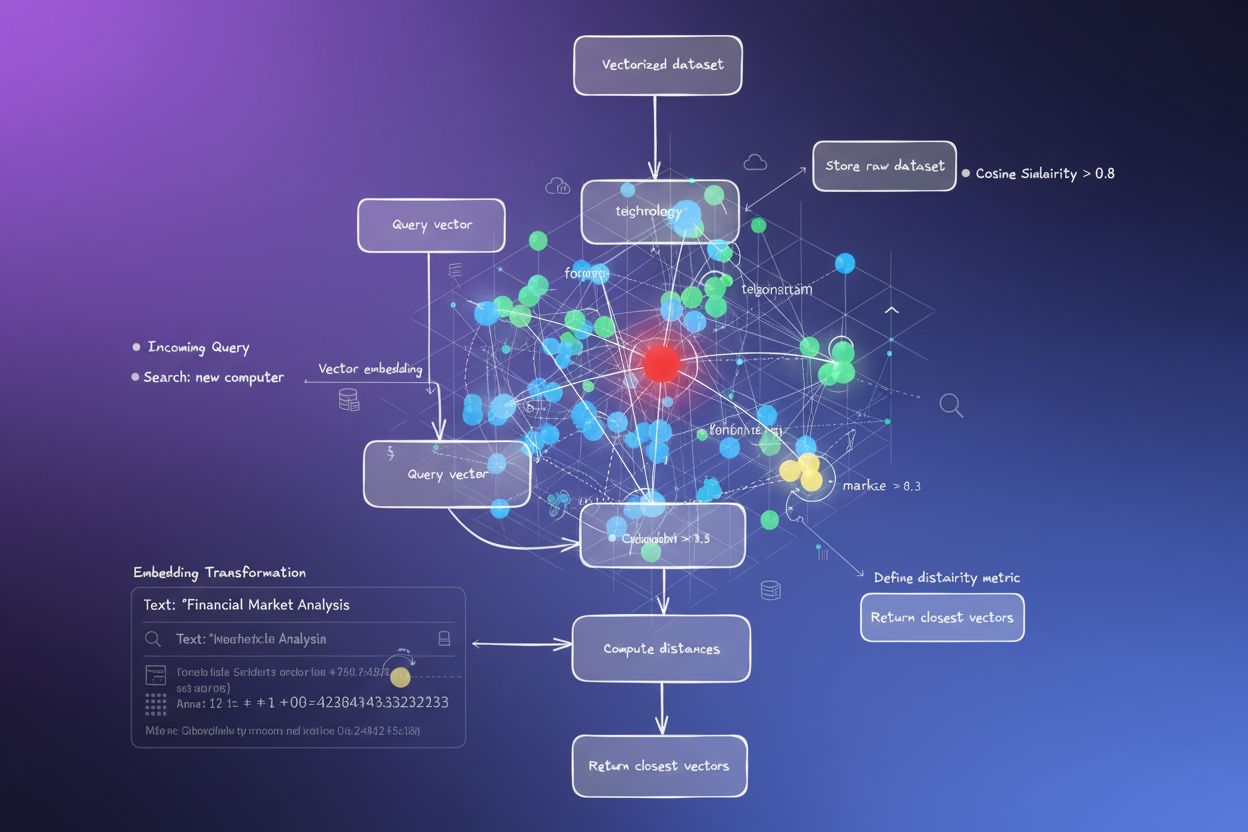

Processen att omvandla data till vektorer kallas inbäddning och utförs av maskininlärningsmodeller som tränats på stora datamängder. Dessa modeller lär sig att mappa liknande koncept till närliggande platser i vektorrummet genom exponering för miljontals exempel. Vanliga inbäddningsmodeller inkluderar Word2Vec, som lär sig ordrelationer från kontext; BERT (Bidirectional Encoder Representations from Transformers), som fångar kontextuell betydelse; och CLIP (Contrastive Language-Image Pre-training), som hanterar multimodal data. De resulterande inbäddningarna har vanligtvis mellan 100 och 1 000+ dimensioner och skapar en rik matematisk representation av semantiska relationer. När en användare gör en sökning omvandlas deras fråga till en vektor med samma inbäddningsmodell, och systemet beräknar sedan avstånden mellan frågevektorn och alla lagrade vektorer för att identifiera de mest liknande objekten.

Vektorsökning bygger på avståndsmått för att kvantifiera hur lika två vektorer är. De tre huvudsakliga måtten är cosinuslikhet, euklidiskt avstånd och skalärproduktlikhet, alla med olika matematiska egenskaper och användningsområden. Cosinuslikhet mäter vinkeln mellan två vektorer, från -1 till 1, där 1 innebär identisk riktning (maximal likhet) och 0 innebär ortogonala vektorer (ingen relation). Detta mått är särskilt värdefullt för NLP-applikationer eftersom det fokuserar på semantisk riktning oavsett storlek på vektorn, vilket gör det idealiskt för att jämföra dokument av olika längd. Euklidiskt avstånd beräknar den raka linjen mellan vektorer i ett multidimensionellt rum och tar hänsyn till både storlek och riktning. Detta mått är känsligt för skala och passar när vektorns storlek har betydelse, som i rekommendationssystem där köpfrekvens spelar roll.

Skalärproduktlikhet kombinerar aspekter av båda måtten, beaktar både storlek och riktning och är samtidigt beräkningseffektivt. Många stora språkmodeller använder skalärprodukt vid träning, vilket gör det till lämpligt val för dessa tillämpningar. Valet av rätt avståndsmått är avgörande – forskning visar att det bästa resultatet fås när samma mått används vid sökning som vid träning av inbäddningsmodellen. Till exempel tränades all-MiniLM-L6-v2-modellen med cosinuslikhet, så att använda cosinuslikhet i ditt index ger de mest exakta resultaten. Organisationer som implementerar vektorsökning måste noggrant matcha sitt valda mått med inbäddningsmodell och användningsområde för att säkerställa både noggrannhet och prestanda.

| Aspekt | Vektorsökning | Nyckelordssökning | Hybridsökning |

|---|---|---|---|

| Matchningsmetod | Semantisk likhet baserat på betydelse | Exakt ord- eller frasmatchning | Kombinerar både semantisk och nyckelordsmatchning |

| Förståelse av fråga | Förstår avsikt och kontext | Kräver att exakta nyckelord finns med | Utnyttjar båda tillvägagångssätten för helhetsresultat |

| Synonymhantering | Hittar automatiskt synonymer och relaterade termer | Missar synonymer om de inte indexeras explicit | Fångar synonymer genom båda metoder |

| Prestanda på vaga frågor | Utmärkt – förstår avsikt | Svagt – kräver exakta nyckelord | Mycket bra – täcker båda tolkningar |

| Beräkningskostnad | Högre – kräver inbäddning och likhetsberäkningar | Lägre – enkel strängmatchning | Måttlig – kör båda sökningarna parallellt |

| Skalbarhet | Kräver specialiserade vektordatabaser | Fungerar med traditionella databaser | Kräver hybridsystem |

| Användningsområden | Semantisk sökning, rekommendationer, RAG, avvikelsedetektering | Exakt frassökning, strukturerad data | Företagssök, AI-övervakning, varumärkesbevakning |

| Exempel | Sökning på “hälsosamma middagstips” hittar “näringsrik matlagning” | Hittar endast resultat med exakta orden “hälsosam” och “middag” | Hittar både exakta träffar och semantiskt relaterat innehåll |

Att implementera vektorsökning innebär flera sammankopplade steg som omvandlar rådata till sökbara semantiska representationer. Det första steget är datainhämtning och förbehandling, där råa dokument, bilder eller annan data rensas och normaliseras. Därefter sker vektoromvandling, där en inbäddningsmodell omvandlar varje dataobjekt till en numerisk vektor, oftast mellan 100 och 1 000+ dimensioner. Dessa vektorer lagras sedan i en vektordatabas eller indexstruktur optimerad för högdimensionell data. När en sökfråga kommer in genomgår den samma inbäddningsprocess för att skapa en frågevektor. Systemet använder sedan avståndsmått för att beräkna likhetsvärden mellan frågevektorn och alla lagrade vektorer, och rankar resultaten efter närhet till frågan.

För att göra processen effektiv i stor skala används Approximate Nearest Neighbor (ANN)-algoritmer som HNSW (Hierarchical Navigable Small World), IVF (Inverted File Index) eller ScaNN (Scalable Nearest Neighbors). Dessa algoritmer kompromissar något med noggrannheten för att uppnå snabbhet och möjliggör sökningar bland miljontals eller miljarder vektorer på millisekunder istället för sekunder. HNSW till exempel organiserar vektorer i en flerskiktad grafstruktur där högre lager innehåller långdistansförbindelser för snabb sökning, medan lägre lager innehåller kortare förbindelser för precision. Detta hierarkiska tillvägagångssätt minskar sökkomplexiteten från linjär O(n) till logaritmisk O(log n), vilket gör storskalig vektorsökning praktisk. Valet av algoritm beror på faktorer som datamängdens storlek, frågevolym, latenskrav och tillgängliga beräkningsresurser.

Vektorsökning har blivit avgörande för AI-övervakningsplattformar som AmICited som spårar varumärkesomnämnanden över AI-system. Traditionell nyckelordsbaserad övervakning skulle missa omformuleringar, kontextuella referenser och semantiska variationer av varumärkesnamn eller domänadresser. Vektorsökning gör det möjligt för dessa plattformar att upptäcka när ditt varumärke nämns i AI-genererade svar även när exakt formulering skiljer sig. Om din domän till exempel är “amicited.com” kan vektorsökning identifiera omnämnanden som “plattform för AI-promptövervakning” eller “varumärkes-synlighet i generativ AI” som kontextuellt relaterade till ditt företag, även utan explicita URL-omnämnanden. Denna semantiska förståelse är avgörande för heltäckande AI-citationsspårning över ChatGPT, Perplexity, Google AI Overviews och Claude.

Marknaden för vektorsökningsteknik växer explosionsartat, vilket speglar företagens insikt om dess värde. Enligt marknadsundersökningar värderades vektordatabasmarknaden till 1,97 miljarder dollar år 2024 och förväntas nå 10,60 miljarder dollar 2032, med en årlig tillväxttakt (CAGR) på 23,38 %. Dessutom rapporterade Databricks 186 % tillväxt i användningen av vektordatabaser redan under det första året efter deras vektorsöknings-lansering i december 2023. Denna snabba tillväxt visar att företag alltmer ser vektorsökning som kritisk infrastruktur för AI-applikationer. För organisationer som övervakar sin närvaro i AI-system ger vektorsökning den semantiska förståelse som krävs för att fånga alla meningsfulla omnämnanden, inte bara exakta nyckelordsträffar.

Vektorsökningens prestanda i stor skala beror till stor del på sofistikerade indexeringstekniker som balanserar hastighet, noggrannhet och minnesanvändning. HNSW (Hierarchical Navigable Small World) har blivit en av de mest populära metoderna och organiserar vektorer i en flerskiktad graf där varje lager innehåller allt kortare förbindelser. Algoritmen inleder sökningar på det översta lagret med långdistansförbindelser för snabb traversering, och går sedan ned genom lager med allt mer precisa kopplingar. Forskning visar att HNSW uppnår topprestanda med återkallningsgrad över 99 % samtidigt som den bibehåller fördröjning under millisekunden. HNSW kräver dock mycket minne – tester visar att indexering av 1 miljon vektorer med HNSW kan kräva 0,5–5 GB beroende på parametrar, vilket gör minnesoptimering viktig för stora implementationer.

IVF (Inverted File Index) erbjuder ett alternativt tillvägagångssätt genom att klustra vektorer och indexera dem mot klustercentra. Denna teknik minskar sökutrymmet genom att fokusera på relevanta kluster istället för att söka igenom alla vektorer. ScaNN (Scalable Nearest Neighbors), utvecklad av Google Research, är optimerad särskilt för inre produktsökning och ger utmärkt prestanda för rekommendationssystem. Produktkvantisering (PQ) komprimerar vektorer genom att dela dem i subvektorer och kvantisera varje del självständigt, vilket minskar minnesbehovet 10–100 gånger till priset av viss precision. Organisationer som implementerar vektorsökning måste noggrant välja indexeringstekniker utifrån sina specifika krav – om de prioriterar återkallningsprecision, sökhastighet, minnesoptimering eller en kombination. Fältet utvecklas snabbt, med nya algoritmer och optimeringstekniker som ständigt uppstår för att hantera de beräkningsmässiga utmaningarna med högdimensionella vektoroperationer.

Definitionen och tillämpningen av vektorsökning fortsätter att utvecklas i takt med att AI-system blir mer sofistikerade och företagsanvändningen ökar. Framtiden pekar mot hybridsöksystem som kombinerar vektorsökning med traditionell nyckelordssökning och avancerade filtreringsfunktioner. Dessa hybridlösningar drar nytta av den semantiska förståelsen i vektorsökning samtidigt som de behåller precisionen och igenkänningsfaktorn hos nyckelordsmatchning, vilket ger överlägsna resultat för komplexa frågor. Dessutom blir multimodal vektorsökning en avgörande kapabilitet som gör det möjligt för system att söka över text, bilder, ljud och video samtidigt med hjälp av gemensamma inbäddningsutrymmen. Denna utveckling kommer att möjliggöra mer intuitiva och heltäckande sökupplevelser över olika datatyper.

För organisationer som övervakar sin närvaro i AI-system har utvecklingen av vektorsökning djupgående konsekvenser. När AI-plattformar som ChatGPT, Perplexity, Google AI Overviews och Claude i allt högre grad förlitar sig på vektorsökning för innehållshämtning och rankning, blir det lika viktigt att förstå hur ditt varumärke förekommer semantiskt som att synas på traditionella nyckelord. Skiftet mot semantisk förståelse innebär att varumärkesbevakning och AI-citationsspårning måste utvecklas bortom enkel nyckelordsdetektion för att fånga kontextuella omnämnanden och semantiska relationer. Organisationer som investerar i att förstå vektorsökning och dess tillämpningar kommer att ha bättre förutsättningar att optimera sin synlighet i generativa AI-system. Konvergensen mellan vektorsökningsteknik och AI-övervakningsplattformar innebär ett grundläggande skifte i hur varumärken förstår och hanterar sin närvaro i AI-drivna informationslandskap.

Traditionell nyckelordssökning letar efter exakta ordmatchningar i dokument, medan vektorsökning förstår semantisk betydelse och kontext. Vektorsökning omvandlar text till numeriska representationer kallade inbäddningar, vilket gör det möjligt att hitta relevanta resultat även när exakta nyckelord inte matchar. Om du till exempel söker efter "trådlösa hörlurar" med vektorsökning får du även träffar på "Bluetooth-öronsnäckor" eftersom de delar liknande semantisk betydelse, medan nyckelordssökning skulle missa denna koppling.

Vektor-inbäddningar är numeriska representationer av data (text, bilder, ljud) som omvandlats till talarrayer som fångar semantisk betydelse. De skapas med hjälp av maskininlärningsmodeller som Word2Vec, BERT eller transformerbaserade modeller som lär sig att placera liknande koncept nära varandra i ett högdimensionellt utrymme. Till exempel skulle orden "kung" och "drottning" ha inbäddningar som ligger nära varandra eftersom de delar semantiska relationer, medan "kung" och "banan" skulle ligga långt ifrån varandra.

De tre huvudsakliga avståndsmåtten är cosinuslikhet (mäter vinkeln mellan vektorer), euklidiskt avstånd (mäter rak linje mellan vektorer) och skalärproduktlikhet (tar hänsyn till både storlek och riktning). Cosinuslikhet är vanligast för NLP-applikationer eftersom den fokuserar på semantisk riktning oavsett vektorns storlek. Valet av mått bör matcha det som användes för att träna din inbäddningsmodell för bästa noggrannhet.

Vektorsökning gör det möjligt för AI-övervakningsplattformar som AmICited att spåra varumärkesomnämnanden över AI-system (ChatGPT, Perplexity, Google AI Overviews, Claude) genom att förstå semantisk kontext snarare än exakta nyckelords-matchningar. Detta möjliggör upptäckt av omformuleringar, relaterade koncept och kontextuella referenser till ditt varumärke, vilket ger en heltäckande överblick över hur din domän förekommer i AI-genererade svar på flera plattformar.

ANN-algoritmer som HNSW (Hierarchical Navigable Small World) möjliggör snabba likhetsökningar bland miljontals vektorer genom att hitta ungefärliga snarare än exakta närmaste grannar. Dessa algoritmer använder hierarkiska grafstrukturer för att minska sökkomplexiteten från linjär till logaritmisk, vilket gör vektorsökning praktiskt för storskaliga applikationer. HNSW organiserar vektorer i flerskiktade grafer där långdistansförbindelser finns på högre nivåer för snabbare traversering.

Företag genererar enorma mängder ostrukturerad data (e-post, dokument, supportärenden) som traditionell nyckelordssökning har svårt att organisera effektivt. Vektorsökning möjliggör semantisk förståelse av denna data och driver applikationer som intelligent sökning, rekommendationssystem, avvikelsedetektering och retrieval-augmented generation (RAG). Enligt marknadsundersökningar förväntas marknaden för vektordatabaser växa från 2,65 miljarder dollar 2025 till 8,95 miljarder dollar 2030, vilket speglar företagets användning.

Vektordatabaser är specialiserade system optimerade för lagring, indexering och sökning av högdimensionell vektordata. De implementerar effektiva indexeringstekniker som HNSW, IVF (Inverted File Index) och ScaNN för att möjliggöra snabba likhetsökningar i stor skala. Exempel inkluderar Milvus, Pinecone, Weaviate och Zilliz Cloud. Dessa databaser hanterar den beräkningsmässiga komplexiteten hos vektoroperationer, vilket gör det möjligt för organisationer att bygga produktionsklara semantiska sök- och AI-applikationer utan att behöva hantera infrastrukturens komplexitet.

Börja spåra hur AI-chatbotar nämner ditt varumärke på ChatGPT, Perplexity och andra plattformar. Få handlingsbara insikter för att förbättra din AI-närvaro.

Lär dig hur vektorsökning använder maskininlärningsinbäddningar för att hitta liknande objekt baserat på betydelse snarare än exakta nyckelord. Förstå vektordat...

Lär dig hur vektorembeddningar gör det möjligt för AI-system att förstå semantisk betydelse och matcha innehåll med sökfrågor. Utforska teknologin bakom semanti...

Semantisk sökning tolkar frågans innebörd och kontext med hjälp av NLP och maskininlärning. Lär dig hur det skiljer sig från sökordssökning, driver AI-system oc...