阻止(或允许)AI爬虫的完整指南

了解如何通过robots.txt、服务器级拦截和高级防护方法阻止或允许GPTBot、ClaudeBot等AI爬虫。完整的技术指南,附有示例。

AI爬虫与机器人完整参考指南。识别GPTBot、ClaudeBot、Google-Extended及其他20+ AI爬虫,包含User Agent、爬取频率与屏蔽策略。

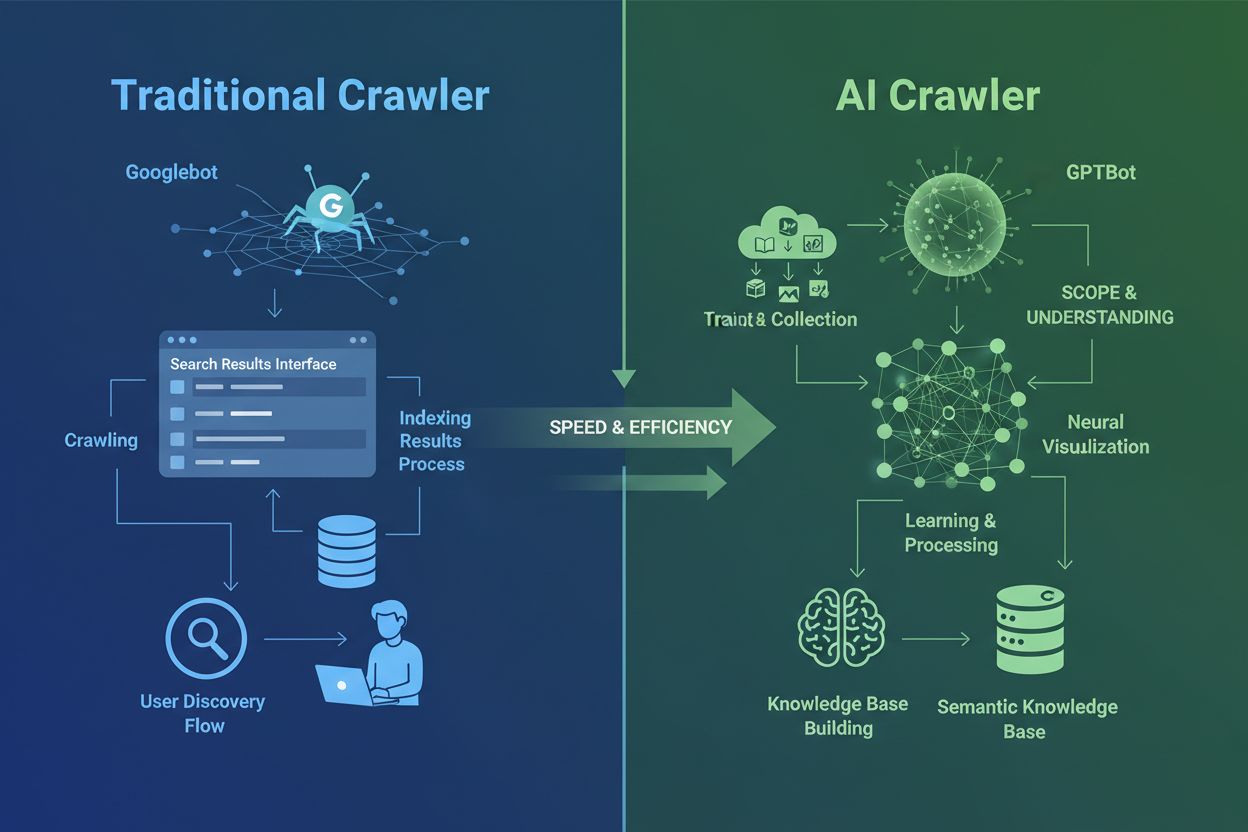

AI爬虫与您过往熟悉的传统搜索引擎爬虫有本质区别。Googlebot和Bingbot通过索引内容帮助用户通过搜索结果找到信息,而AI爬虫(如GPTBot、ClaudeBot)则专门收集数据用于训练大语言模型。这一区别至关重要:传统爬虫为人类发现内容铺路,AI爬虫则为人工智能系统的知识库提供数据。根据最新数据,AI爬虫现已占据网站全部Bot流量近80%,其中训练型爬虫消耗大量内容,却极少为出版方带来推荐流量。与难以处理动态JavaScript网站的传统爬虫不同,AI爬虫采用先进的机器学习技术,能够像人类读者一样理解内容的语境、含义、语气和目的,无需手动配置。这代表着网页索引技术的巨大飞跃,网站所有者需彻底重新思考对爬虫的管理策略。

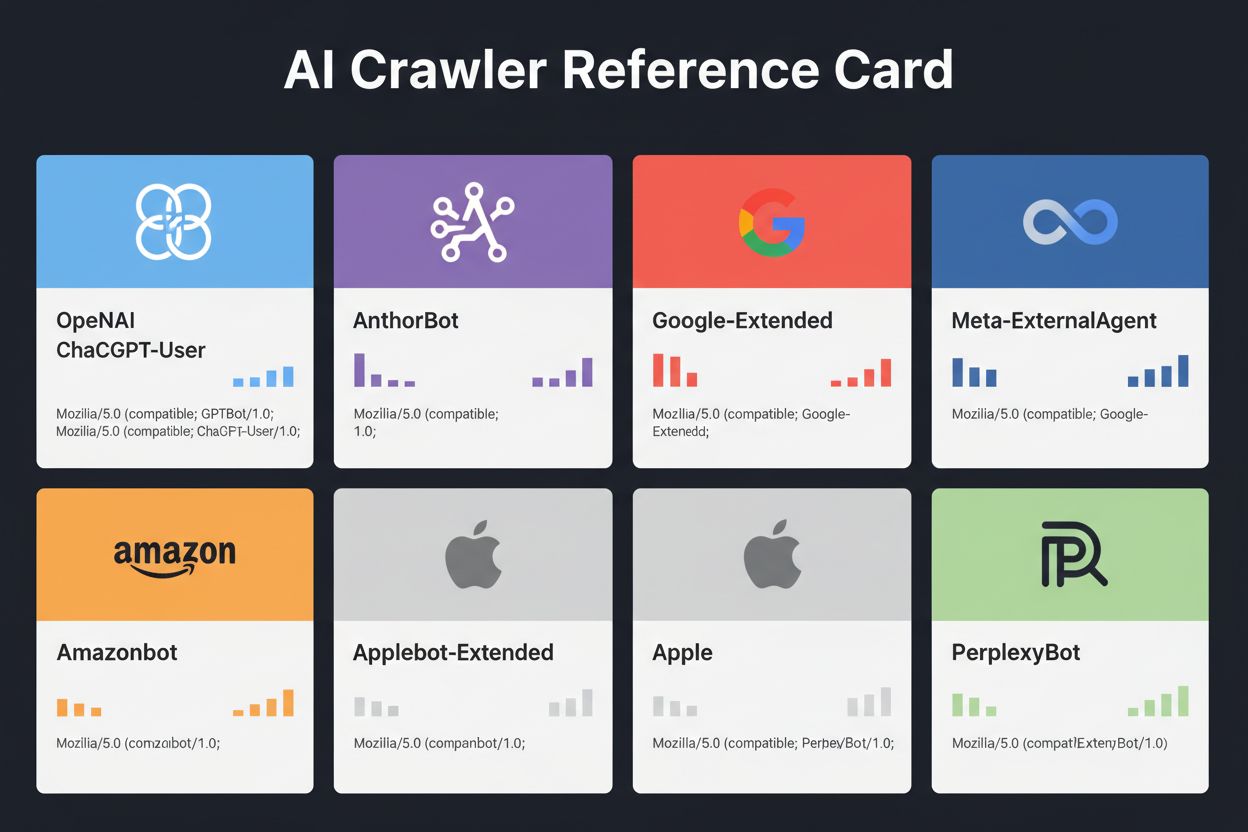

随着各大科技公司争相打造自有大语言模型,AI爬虫的格局日益拥挤。OpenAI、Anthropic、Google、Meta、亚马逊、苹果、Perplexity等都运营着多个专用爬虫,各自服务于不同AI生态的不同功能。公司部署多种爬虫,是因不同用途需要不同行为:有的专注于大规模训练数据收集,有的处理实时搜索索引,还有的在用户请求时按需抓取内容。理解这一生态,需要认清三大爬虫类别:用于模型训练的数据采集爬虫、为AI搜索体验索引内容的搜索/引用型爬虫、以及当用户通过AI助手请求内容时触发的用户主动型爬虫。下表为主流玩家的简要概览:

| 公司 | 爬虫名称 | 主要用途 | 抓取速率 | 用于训练数据 |

|---|---|---|---|---|

| OpenAI | GPTBot | 模型训练 | 100页/小时 | 是 |

| OpenAI | ChatGPT-User | 实时用户请求 | 2400页/小时 | 否 |

| OpenAI | OAI-SearchBot | 搜索索引 | 150页/小时 | 否 |

| Anthropic | ClaudeBot | 模型训练 | 500页/小时 | 是 |

| Anthropic | Claude-User | 实时网页访问 | <10页/小时 | 否 |

| Google-Extended | Gemini AI训练 | 可变 | 是 | |

| Gemini-Deep-Research | 研究功能 | <10页/小时 | 否 | |

| Meta | Meta-ExternalAgent | AI模型训练 | 1100页/小时 | 是 |

| Amazon | Amazonbot | 服务改进 | 1050页/小时 | 是 |

| Perplexity | PerplexityBot | 搜索索引 | 150页/小时 | 否 |

| Apple | Applebot-Extended | AI训练 | <10页/小时 | 是 |

| Common Crawl | CCBot | 开放数据集 | <10页/小时 | 是 |

OpenAI运营着三类功能明确的爬虫,是ChatGPT生态中最活跃、部署最广的AI爬虫之一:

GPTBot - OpenAI的主力训练爬虫,系统性收集公开数据,用于训练和改进包括ChatGPT、GPT-4o在内的GPT模型。抓取速率约为100页/小时,遵守robots.txt指令。OpenAI在https://openai.com/gptbot.json公布官方IP,可用于验证。

ChatGPT-User - 当真实用户让ChatGPT浏览特定网页时出现。该爬虫由用户操作触发,速率可达2400页/小时。通过ChatGPT-User访问的内容不会用于模型训练,有助于在ChatGPT搜索结果中实时提升可见性。

OAI-SearchBot - 专为ChatGPT搜索功能设计,不采集训练数据,仅索引内容用于实时搜索结果,速率约150页/小时。当用户提出相关问题时,有助于您的内容出现在ChatGPT搜索结果中。

OpenAI的爬虫遵守robots.txt且仅来自官方IP段,相较于部分不透明的竞争者,管理相对简单。

Anthropic(Claude AI背后的公司)运营着多类爬虫,功能和透明度各异。虽然官方文档不如OpenAI详细,但通过服务器日志分析可明了其行为:

ClaudeBot - Anthropic的主力训练爬虫,采集网页内容以提升Claude知识和能力。抓取速率约500页/小时,是若要防止内容被用于Claude训练时的主要屏蔽对象。完整User Agent为Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; ClaudeBot/1.0; +claudebot@anthropic.com)。

Claude-User - 当Claude用户请求实时网页访问时激活,按需抓取,量极小。遵守认证,不尝试绕过访问限制,对资源消耗影响轻微。

Claude-SearchBot - 支持Claude内部搜索功能,使您的内容在用户提问时能被检索到。抓取量极低,主要用于索引而非模型训练。

对Anthropic爬虫的一个关键担忧是爬取与推荐流量比例失衡:Cloudflare数据显示,Anthropic每带来1次推荐流量,爬虫平均已抓取38,000至70,000页内容。这种巨大不对等引发了关于内容使用公平补偿的重要问题。

Google的AI爬虫策略与竞争者截然不同,严格区分搜索索引与AI训练。Google-Extended专门负责为Gemini(原Bard)及其他AI产品采集训练数据,与传统Googlebot完全独立:

Google-Extended的User Agent为:Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Google-Extended/1.0。这种区分对网站所有者极为有利,您可通过robots.txt屏蔽Google-Extended,而不会影响Google搜索排名或AI Overviews收录。Google官方声明屏蔽Google-Extended对搜索排名无影响,尽管部分站长有相关担忧,建议持续关注。Gemini-Deep-Research则支持Gemini的研究功能,抓取量极低,对服务器资源影响微乎其微。Google爬虫的重大技术优势在于可执行JavaScript并渲染动态内容,能有效抓取React、Vue、Angular等应用,而OpenAI和Anthropic的爬虫则无法做到。对于运行JS重应用的网站,这一区别对AI可见性尤为重要。

除科技巨头外,还有许多组织运营着值得注意的AI爬虫。Meta-ExternalAgent于2024年7月低调上线,用于Meta AI模型训练及提升Facebook、Instagram、WhatsApp等产品。其抓取速率约1100页/小时,虽行为激进但公众关注度较低。Bytespider由字节跳动(TikTok母公司)运营,自2024年4月上线后迅速成为互联网上最激进的爬虫之一。第三方监测显示Bytespider比GPTBot和ClaudeBot更为频繁,部分报告称其不总是遵守robots.txt,故建议采用基于IP的屏蔽。

Perplexity爬虫包括用于搜索索引的PerplexityBot和用于实时抓取的Perplexity-User。虽然有传闻称Perplexity有时无视robots.txt,但公司宣称会遵守。Amazonbot为Alexa问答功能提供支持,遵守robots.txt协议,速率约1050页/小时。Applebot-Extended于2024年6月推出,决定Applebot已索引内容是否将被用于AI训练,但不直接抓取网页。CCBot由Common Crawl(非营利组织)运营,为OpenAI、Google、Meta、Hugging Face等多家AI公司提供开放网页归档。xAI(Grok)、Mistral、DeepSeek等新兴爬虫正陆续出现在服务器日志中,AI爬虫生态持续扩展。

下表为已验证AI爬虫的用途、User Agent及robots.txt屏蔽语法。该表定期基于服务器日志和官方文档更新,并已尽量比对官方IP列表:

| 爬虫名称 | 公司 | 用途 | User Agent | 抓取速率 | IP验证 | robots.txt语法 |

|---|---|---|---|---|---|---|

| GPTBot | OpenAI | 训练数据采集 | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; GPTBot/1.3; +https://openai.com/gptbot) | 100/小时 | ✓官方 | User-agent: GPTBot Disallow: / |

| ChatGPT-User | OpenAI | 实时用户请求 | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko); compatible; ChatGPT-User/1.0 | 2400/小时 | ✓官方 | User-agent: ChatGPT-User Disallow: / |

| OAI-SearchBot | OpenAI | 搜索索引 | Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36; compatible; OAI-SearchBot/1.3 | 150/小时 | ✓官方 | User-agent: OAI-SearchBot Disallow: / |

| ClaudeBot | Anthropic | 训练数据采集 | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; ClaudeBot/1.0; +claudebot@anthropic.com) | 500/小时 | ✓官方 | User-agent: ClaudeBot Disallow: / |

| Claude-User | Anthropic | 实时网页访问 | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Claude-User/1.0) | <10/小时 | ✗暂无 | User-agent: Claude-User Disallow: / |

| Claude-SearchBot | Anthropic | 搜索索引 | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Claude-SearchBot/1.0) | <10/小时 | ✗暂无 | User-agent: Claude-SearchBot Disallow: / |

| Google-Extended | Gemini AI训练 | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Google-Extended/1.0) | 可变 | ✓官方 | User-agent: Google-Extended Disallow: / | |

| Gemini-Deep-Research | 研究功能 | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Gemini-Deep-Research) | <10/小时 | ✓官方 | User-agent: Gemini-Deep-Research Disallow: / | |

| Bingbot | Microsoft | Bing搜索 & Copilot | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; bingbot/2.0) | 1300/小时 | ✓官方 | User-agent: Bingbot Disallow: / |

| Meta-ExternalAgent | Meta | AI模型训练 | meta-externalagent/1.1 (+https://developers.facebook.com/docs/sharing/webmasters/crawler) | 1100/小时 | ✗暂无 | User-agent: Meta-ExternalAgent Disallow: / |

| Amazonbot | Amazon | 服务改进 | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Amazonbot/0.1) | 1050/小时 | ✓官方 | User-agent: Amazonbot Disallow: / |

| Applebot-Extended | Apple | AI训练 | Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/605.1.15; compatible; Applebot-Extended | <10/小时 | ✓官方 | User-agent: Applebot-Extended Disallow: / |

| PerplexityBot | Perplexity | 搜索索引 | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; PerplexityBot/1.0) | 150/小时 | ✓官方 | User-agent: PerplexityBot Disallow: / |

| Perplexity-User | Perplexity | 实时抓取 | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Perplexity-User/1.0) | <10/小时 | ✓官方 | User-agent: Perplexity-User Disallow: / |

| Bytespider | 字节跳动 | AI训练 | Mozilla/5.0 (Linux; Android 5.0) AppleWebKit/537.36; compatible; Bytespider | <10/小时 | ✗暂无 | User-agent: Bytespider Disallow: / |

| CCBot | Common Crawl | 开放数据集 | CCBot/2.0 (https://commoncrawl.org/faq/ ) | <10/小时 | ✓官方 | User-agent: CCBot Disallow: / |

| DuckAssistBot | DuckDuckGo | AI搜索 | DuckAssistBot/1.2; (+http://duckduckgo.com/duckassistbot.html) | 20/小时 | ✓官方 | User-agent: DuckAssistBot Disallow: / |

| Diffbot | Diffbot | 数据提取 | Mozilla/5.0 (Windows; U; Windows NT 5.1; en-US; rv:1.9.1.2) Gecko/20090729 Firefox/3.5.2 Diffbot/0.1 | <10/小时 | ✗暂无 | User-agent: Diffbot Disallow: / |

| MistralAI-User | Mistral | 实时抓取 | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; MistralAI-User/1.0) | <10/小时 | ✗暂无 | User-agent: MistralAI-User Disallow: / |

| ICC-Crawler | NICT | AI/ML训练 | ICC-Crawler/3.0 (Mozilla-compatible; https://ucri.nict.go.jp/en/icccrawler.html ) | <10/小时 | ✗暂无 | User-agent: ICC-Crawler Disallow: / |

并非所有AI爬虫用途相同,理解这些区别对于制定有效的屏蔽策略至关重要。训练型爬虫约占全部AI Bot流量的80%,专门采集内容构建大语言模型训练集。一旦您的内容进入训练集,将永久被模型吸收,用户可能无需再访问您的网站即可获得答案。GPTBot、ClaudeBot、Meta-ExternalAgent等训练型爬虫抓取量大、模式系统化,几乎不带来推荐流量。

搜索/引用型爬虫则为AI搜索体验建索引,并可能通过引用为出版方带来一定流量。当用户在ChatGPT或Perplexity提问时,这类爬虫帮助内容浮现。与训练型爬虫不同,OAI-SearchBot、PerplexityBot等搜索爬虫抓取量适中,聚焦检索,并有可能带来署名与链接。用户主动型爬虫仅在用户通过AI助手指定URL或请求分析页面时才被触发,按需、低频抓取,不会用于模型训练。理解这些类别,有助于按业务优先级科学决策允许与屏蔽哪些爬虫。

管理AI爬虫的第一步,是了解实际有哪些爬虫访问了您的网站。服务器访问日志详细记录了每个请求,包括标识爬虫的User Agent字符串。大多数主机面板都自带日志分析工具,您也可直接读取原始日志。Apache服务器日志通常位于/var/log/apache2/access.log,Nginx则在/var/log/nginx/access.log。利用grep可筛选爬虫活动:

grep -i "gptbot\|claudebot\|google-extended\|bytespider" /var/log/apache2/access.log | head -20

此命令可显示最近20条主流AI爬虫的请求。Google Search Console能显示Google自家爬虫的抓取统计。Cloudflare Radar提供全球AI Bot流量洞察,有助于识别活跃爬虫。若要判断爬虫是真实还是伪造,请将请求IP与主要公司公布的官方IP比对。OpenAI的IP见https://openai.com/gptbot.json,亚马逊为https://developer.amazon.com/amazonbot/ip-addresses/,其他公司也有类似列表。伪造合法User Agent却来自未验证IP的请求应立即屏蔽,因其极可能是恶意抓取。

robots.txt是控制爬虫访问的主要工具。只需将文本文件放在网站根目录,便可告知爬虫可访问的区域。屏蔽指定AI爬虫示例:

# 屏蔽OpenAI的GPTBot

User-agent: GPTBot

Disallow: /

# 屏蔽Anthropic的ClaudeBot

User-agent: ClaudeBot

Disallow: /

# 屏蔽Google的AI训练(非搜索)

User-agent: Google-Extended

Disallow: /

# 屏蔽Common Crawl

User-agent: CCBot

Disallow: /

也可以允许爬虫但设置抓取速率,防止服务器过载:

User-agent: GPTBot

Crawl-delay: 10

Disallow: /private/

表示GPTBot每10秒抓取一次,且禁止访问/private/目录。若需兼顾搜索与训练爬虫:

# 允许传统搜索引擎

User-agent: Googlebot

Allow: /

User-agent: Bingbot

Allow: /

# 屏蔽所有AI训练爬虫

User-agent: GPTBot

User-agent: ClaudeBot

User-agent: CCBot

User-agent: Google-Extended

User-agent: Bytespider

User-agent: Meta-ExternalAgent

Disallow: /

# 允许AI搜索爬虫

User-agent: OAI-SearchBot

Allow: /

User-agent: PerplexityBot

Allow: /

大部分主流AI爬虫会遵守robots.txt,但部分激进爬虫可能完全无视该协议,因此仅依赖robots.txt难以实现完全防护。

robots.txt仅具建议性,无法强制执行,不遵守协议的爬虫可随意忽略指令。要防御此类爬虫,建议在服务器层面实施基于IP的屏蔽。这种方式更可靠,因为伪造IP比伪造User Agent难得多。可将官方公布IP列入白名单,其它类似AI爬虫请求一律屏蔽。

对于Apache服务器,可通过.htaccess实现爬虫屏蔽:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} (GPTBot|ClaudeBot|anthropic-ai|Bytespider|CCBot) [NC]

RewriteRule .* - [F,L]

</IfModule>

匹配到指定User Agent时,返回403 Forbidden,无论robots.txt如何设置。防火墙规则可进一步增强防护,例如只允许官方IP访问。大多数web应用防火墙和主机商都支持制定规则,仅允许官方IP访问AI爬虫,其它全部拒绝。HTML meta标签可实现页面级控制,亚马逊等爬虫支持noarchive指令:

<meta name="robots" content="noarchive">

表示不允许页面被用于模型训练,但可被索引。请选择符合自身技术条件和目标爬虫特性的屏蔽方式。基于IP的屏蔽最为可靠,但配置较复杂;robots.txt最易部署,但对违规爬虫无效。

实施屏蔽后,必须定期监控以确保策略生效,并及时发现新型爬虫。建议每周检查服务器日志,关注包含“bot”“crawler”“spider”或如“GPT”“Claude”“Perplexity”等关键字的User Agent。可设定流量告警,及时发现异常Bot访问。Google Search Console可监控Googlebot和Google-Extended的活动。Cloudflare Radar提供全球AI爬虫流量趋势,有助于识别新兴爬虫。

要验证robots.txt是否生效,请直接访问yoursite.com/robots.txt,确认所有指令已正确配置。对于服务器级屏蔽,检查访问日志确认被屏蔽爬虫请求是否已拦截。若仍发现被屏蔽爬虫的请求,说明其无视指令或伪造User Agent。可通过分析Analytics与服务器日志进一步验证。每季度复查屏蔽名单尤为重要,因AI爬虫生态变化极快,新爬虫不断出现、现有爬虫更换User Agent、公司随时可能上线新Bot。定期审查与更新屏蔽策略,确保实施始终有效。

管理爬虫访问固然重要,了解AI系统实际如何引用您的内容也同样关键。AmICited.com可全面监控您的品牌与内容在ChatGPT、Perplexity、Google Gemini等AI平台中的出现与引用情况。它不仅仅帮助您屏蔽爬虫,更让您了解AI爬虫对可见性与权威的真实影响。平台追踪AI系统的引用频率、品牌在AI答案中的出现率,以及这些可见性如何转化为流量和权威。通过监控AI引用,您能根据实际可见性数据而非主观猜测,科学决策允许哪些爬虫。AmICited.com还可与您的内容策略集成,告诉您哪些主题和内容类型最易获得AI引用。以数据驱动优化内容AI发现,同时保护最有价值的知识产权。理解AI引用数据,有助于您在内容开放与保护之间做出最优决策。

是否允许AI爬虫,完全取决于您自身的业务需求和优先级。允许AI爬虫的情形: 如果您运营新闻或博客站点,AI答案带来大量流量;企业因被AI引用而受益、希望参与AI训练以影响行业认知;或对内容被AI使用表示接受。新闻出版、教育内容创作者、行业专家等通常因AI引用带来流量与权威而欢迎AI爬虫。

屏蔽AI爬虫的情形: 若拥有专有内容或商业机密,服务器资源有限、无法承受激进爬虫抓取;担忧内容被无偿使用或希望完全掌控知识产权用途;或因Bot流量影响性能。电商平台、SaaS厂商、付费内容出版商等常选择屏蔽训练型爬虫。核心权衡在于内容保护与AI平台可见性之间。屏蔽训练型爬虫可保护内容,但可能降低AI答案中的品牌可见性。屏蔽搜索型爬虫则影响AI搜索结果的曝光。许多出版商采用有选择的屏蔽策略:允许OAI-SearchBot与PerplexityBot等搜索/引用爬虫,同时屏蔽GPTBot、ClaudeBot等激进训练型爬虫。这种做法平衡了AI搜索曝光与内容防护。建议根据自身商业模式、内容战略与资源状况做出决策。

AI爬虫生态仍在快速扩张,越来越多公司入局,老牌玩家也不断推出新Bot。xAI的Grok爬虫已出现在服务器日志,助力其AI平台拓展。Mistral的MistralAI-User支持Mistral AI实时内容抓取。DeepSeek的DeepSeekBot显示中国AI公司也开始竞争。类似OpenAI Operator的浏览器型AI助手带来全新挑战:它们没有独特User Agent,表现为普通Chrome流量,传统方式无法屏蔽。这类智能浏览器代表AI爬虫进化前沿,可像人类用户一样交互,执行JavaScript并操作复杂界面。

未来AI爬虫可能更为智能,控制手段更加细化,甚至出现全新AI内容访问标准。保持信息更新至关重要——新爬虫层出不穷,老爬虫行为也在不断演化。关注ai.robots.txt项目(GitHub) 等社区更新的AI爬虫名单,定期检查服务器日志寻找未知User Agent,订阅各大AI公司关于爬虫与IP更新的通告。AI爬虫生态将持续进化,您的管理策略也需动态调整。定期监控、季度复查、关注行业新动向,才能持续掌控AI系统访问与使用您内容的方式。

AI爬虫(如GPTBot和ClaudeBot)专门收集内容用于训练大语言模型,而搜索引擎爬虫(如Googlebot)则索引内容让人们能通过搜索结果找到它。AI爬虫为AI系统的数据源提供知识,而搜索爬虫帮助用户发现您的内容。关键区别在于目的:训练 vs 检索。

不会,屏蔽AI爬虫不会影响您的传统搜索排名。AI爬虫(如GPTBot和ClaudeBot)与搜索引擎爬虫(如Googlebot)完全独立。您可以屏蔽Google-Extended(用于AI训练),同时仍允许Googlebot(用于搜索)。每个爬虫用途不同,屏蔽一个不会影响另一个。

检查服务器访问日志,查看哪些User Agent正在访问您的网站。查找GPTBot、ClaudeBot、CCBot和Bytespider等Bot名称。大多数主机控制面板都提供日志分析工具。您也可以通过Google Search Console监控爬取活动,但它只显示Google的爬虫。

并不是所有AI爬虫都同等遵守robots.txt。OpenAI的GPTBot、Anthropic的ClaudeBot和Google-Extended通常会遵循robots.txt规则。Bytespider和PerplexityBot有报告称它们可能不会始终如一地遵守robots.txt指令。对于不遵守robots.txt的爬虫,您需要通过防火墙或.htaccess文件在服务器层面进行基于IP的屏蔽。

这取决于您的目标。如果您有专有内容或服务器资源有限,可屏蔽训练型爬虫。如果希望在AI驱动的搜索结果和聊天机器人中获取可见性(从而带来流量和权威),可以允许搜索爬虫。许多企业采取有选择性的策略,允许特定爬虫而屏蔽如Bytespider等较为激进的爬虫。

新的AI爬虫不断涌现,建议至少每季度检查和更新一次屏蔽名单。关注GitHub上的ai.robots.txt项目等社区维护的名单。每月检查服务器日志,识别未被当前配置覆盖的新爬虫。AI爬虫生态变化迅速,您的策略也应随之调整。

可以,通过将请求的IP地址与主要公司的官方IP列表进行比对。OpenAI的地址为https://openai.com/gptbot.json,亚马逊为https://developer.amazon.com/amazonbot/ip-addresses/,其他公司也有类似列表。如果某个爬虫伪造了合法的User Agent但来自未验证IP,应立即屏蔽,因为它很可能是恶意抓取。

AI爬虫可能会消耗大量带宽与服务器资源。Bytespider和Meta-ExternalAgent属于最激进的爬虫之一。有出版商报告称,通过屏蔽AI爬虫,带宽消耗从每日800GB降至200GB,月节省约$1,500。请在爬虫高峰时段监控服务器资源,必要时对激进Bot实施速率限制。

了解如何通过robots.txt、服务器级拦截和高级防护方法阻止或允许GPTBot、ClaudeBot等AI爬虫。完整的技术指南,附有示例。

2025年AI爬虫全面指南。识别GPTBot、ClaudeBot、PerplexityBot及20+其他AI机器人。学习如何通过robots.txt和高级技术阻止、允许或监控爬虫。...

了解如何使用robots.txt控制哪些AI机器人访问您的内容。完整指南,涵盖如何屏蔽GPTBot、ClaudeBot及其他AI爬虫的实用案例与配置策略。...

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.