实体识别

实体识别是AI NLP能力,能够识别和分类文本中的命名实体。了解其工作原理、在AI监测中的应用及其在现代AI系统中的作用。...

实体理解已成为现代人工智能系统的核心能力,使机器能够在非结构化文本中识别并理解关键人物、地点和概念。从驱动理解用户意图的搜索引擎,到能够回答关于特定人物和组织复杂问题的聊天机器人,实体识别为有意义的人机交互奠定了基础。这一技术能力在各行各业都至关重要——金融机构用其进行合规监控,医疗系统借助其管理患者档案,电商平台依赖其理解产品提及和客户反馈。了解 AI 系统如何抽取和解释实体,对于构建或部署生产环境下的 NLP 应用至关重要。

命名实体识别(NER)是自然语言处理中的一项任务,旨在识别并将文本中的命名实体——具体、有意义的信息单元——分类到预定义的类别中。这些实体代表语言中具有语义分量的具体对象:执行动作的人物、做出决策的组织、事件发生的地点、锚定事件的时间表达、量化交易的货币值,以及被购买和销售的产品。实体分类至关重要,因为它将原始文本转化为机器可推理和操作的结构化知识;没有它,系统无法区分“苹果公司”和“apple(苹果水果)”,也无法理解“John Smith”与“J. Smith”指的是同一个人。准确分类实体的能力,使得知识图谱构建、信息抽取、问答系统和关系检测等下游应用成为可能。

| 实体类型 | 定义 | 示例 |

|---|---|---|

| PERSON | 具体的个人 | “Steve Jobs”, “Marie Curie” |

| ORGANIZATION | 公司、机构、团体 | “Microsoft”, “United Nations”, “Harvard University” |

| LOCATION | 地理位置和区域 | “New York”, “Amazon River”, “Silicon Valley” |

| DATE | 时间表达和时间段 | “2024年1月15日”, “下周二”, “2023年第三季度” |

| MONEY | 金额和货币 | “五千万美元”, “€100”, “5000日元” |

| PRODUCT | 商品、服务与创作 | “iPhone 15”, “Windows 11”, “ChatGPT” |

现代 AI 系统通过复杂的多阶段流程处理实体,起始于分词(tokenization),即将原始文本分解为离散词元,为下游处理提供基本单元。每个词元随后通过词嵌入(word embeddings)转化为数值向量,捕捉其语义信息,并输入到能够理解上下文和关系的神经网络架构中。以 Transformer 为代表的基于 Transformer 的模型已成为当代 NLP 的主流架构,它们并行处理整个序列,能够捕捉长距离依赖和复杂的上下文关系,这对准确的实体理解至关重要。Transformer 内部的自注意力机制使每个词元能够动态衡量序列中其他词元的重要性,从而形成丰富的上下文表示,使得词义随上下文变化——这正是“bank”在“river bank”和“savings bank”中被区别理解的原因。预训练语言模型(如 BERT、GPT)先在大规模语料库上学习通用语言模式,然后在实体识别任务上微调,利用已学到的语法、语义和世界知识表示。实体识别系统的最终层通常采用序列标注方法——常见为条件随机场(CRF)或简单的分类头——基于神经网络学习到的上下文表征为每个词元分配实体标签。这一架构使 AI 系统不仅能识别文本中的实体,还能理解它们之间的关系及其在更广泛上下文中的作用。

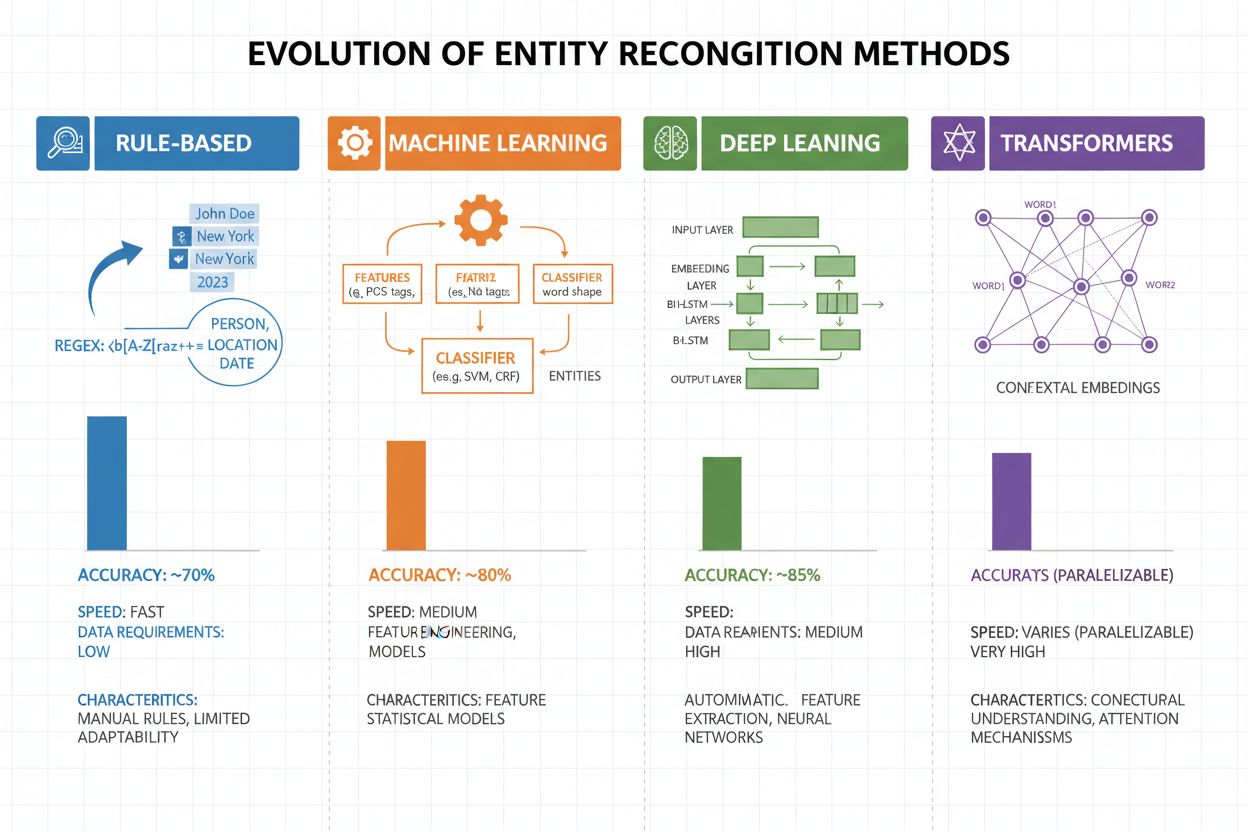

过去二十年,实体识别经历了从简单的基于规则方法到复杂神经架构的巨大变革。早期系统依赖手工规则和词典,通过正则表达式和模式匹配识别实体——这些方法可解释性强、对训练数据需求低,但泛化能力差、维护成本高。机器学习的兴起带来了监督方法,如支持向量机(SVM)和条件随机场(CRF),通过特征工程学习标注数据,显著提升了准确率,但仍需领域专家设计有效特征。深度学习方法,尤其是 LSTM 和 BiLSTM,通过直接从原始文本学习表示,自动完成特征提取,无需人工设计特征,准确率大幅提升,但对标注数据需求更大。基于 Transformer 的模型(如 BERT、RoBERTa)利用自注意力机制捕捉长距离依赖和上下文细节,实现了业界领先的效果(BERT 在 CoNLL-2003 上 F1 达 90.9%),并推动了大规模预训练模型的迁移学习。复杂度与准确率的权衡发生了巨大变化:规则系统在资源受限或高度专业化领域仍有价值,而在计算资源和数据充足时,Transformer 模型已成为主流,轻量级模型如 DistilBERT 则适用于对延迟有要求的生产系统。

基于 Transformer 的模型通过并行自注意力机制彻底革新了实体识别,可同时关注句中所有词元,实现比以往架构更丰富的上下文理解。BERT 及其变体(如 RoBERTa、DistilBERT、ALBERT)在大规模无标注语料上进行双向预训练,学习通用的语言表征,捕捉语法和语义信息,然后通过较小规模的标注数据在下游 NER 任务上微调。预训练与微调范式对实体识别尤为有效:在数十亿词元上预训练的模型,能形成对语言结构和实体模式的鲁棒表示,仅需数千标注样本即可适应特定领域,远低于从零训练所需数据量。Transformer 在实体理解上的强大表现源于其多头注意力机制,不同注意力头可专注于不同类型的实体关系——有的捕捉语法边界,有的捕捉实体与上下文的语义关联。多语言实体识别因 mBERT、XLM-RoBERTa 等模型的出现而变革,这些模型在 100 多种语言上预训练,实现了低资源语言的零样本和小样本迁移及跨语言实体链接。新兴模型如 GLiNER(通用指令式命名实体识别语言模型)进一步突破,通过自然语言提示即可识别任意实体类型,无需任务特定微调,推动实体理解向更灵活、更泛化的方向发展。

尽管取得了长足进展,实体识别系统在实际部署中仍面临诸多挑战,歧义和上下文敏感性尤为棘手——“Apple”一词需结合上下文判断指代水果还是科技公司,即使最先进的模型在噪声或歧义文本中也常常难以实现语义消歧。**词表外实体(OOV)**是另一大难点:模型在标准数据集上训练时,可能从未见过罕见实体、新兴领域专有名词或拼写错误,导致这些实体被误分类或完全无法识别。领域适应问题同样突出,新闻领域(如 CoNLL-2003)训练的模型在生物医学、法律或社交媒体文本上表现不佳,因为实体分布和语言模式差异巨大,需为每个新领域付出昂贵的重标注和微调成本。边界识别错误普遍存在,尤其是多词实体和嵌套结构,如区分“New York City”与“New York”,或处理“Apple Inc. 的首席执行官”这样的嵌套实体。多语言复杂性进一步加剧挑战,不同语言的大小写、词形变化和命名习惯不同,使得英语训练的模型在其他语言上常常失效。专业领域数据稀缺(如罕见疾病名、新兴技术、专有公司术语)也成为瓶颈,人工标注成本高昂,迫使实践者权衡精度和训练投入。

实体理解已成为各行业不可或缺的能力,彻底改变了组织从非结构化文本中提取价值的方式。在信息抽取与知识图谱构建中,实体识别实现了文档到结构化数据库的自动填充,支撑能理解人物、地点和概念间关系的搜索引擎与推荐系统。医疗机构利用实体理解,从临床记录中识别药物名、剂量、症状和患者人口信息,提升临床决策支持,助力药物警戒系统大规模识别不良反应。金融机构通过实体识别抽取新闻和财报中的股票代码、金额和市场事件,使算法交易和风险管理平台能够实时响应市场变化。法律科技公司运用实体理解自动识别合同中的主体、日期、义务和责任条款,将律师的文件审查时间从数周缩短到数小时。客户服务和聊天机器人平台通过实体识别提取用户意图和相关上下文——如订单号、产品名和问题类型——实现更精准的分流和更快的问题解决。电商平台用实体理解从用户评价和搜索查询中识别产品名、品牌、特性和规格,提升商品发现和个性化推荐。内容推荐系统通过实体识别了解用户互动的实体,实现更复杂的协同过滤和基于内容的推荐,推动用户参与和收入增长。

要实现生产级实体理解系统,需在数据准备、模型选择与评估上精益求精。首先需高质量标注数据:明确实体类型定义,采用标注者一致性指标确保标注质量,每种实体类型至少需 500-1000 个标注样本,专业领域则需更多。模型选择需结合实际约束:规则系统在定义清晰领域下可解释性强、延迟低,传统机器学习模型(CRF、SVM)在中等数据下表现良好,而基于 Transformer 的模型(如 BERT、RoBERTa)虽需更多算力和数据,却能实现业界领先效果。训练和微调策略应包括数据增强以应对类别失衡、交叉验证防止过拟合、精细调参(如学习率、批大小)优化表现。系统评估需采用精确率(正确识别实体)、召回率(发现所有实体的比例)、F1 分数(两者的调和均值),并分别对每种实体类型评估以发现薄弱环节。部署时需考虑延迟需求(批量或实时处理)、可扩展性、与现有数据管道的集成,部署后还应持续监控性能漂移、误报率和用户反馈,及时启动再训练。

实体理解工具生态完善,可满足各种规模和需求。开源库如 spaCy 提供生产级 NER 流水线,在标准测试集上 F1 高达 89.22%,文档完备,非常适合具备机器学习能力的团队;NLTK 适合教育和基础 NER 需求;Hugging Face Transformers 则能轻松调用和微调最先进的预训练模型,适应特定领域。云端托管服务无需基础设施部署:Google Cloud Natural Language API、AWS Comprehend、IBM Watson NLP 等预训练实体识别服务,支持多语言和多实体类型,无缝集成云端数据管道。专业框架如 Flair(基于 PyTorch,序列标注支持优秀)、DeepPavlov(多语言、多领域预训练模型)适合需高度定制的研究和开发团队。选择自建还是使用现成工具,需权衡数据安全(本地部署或云端)、精度需求、领域专用性和团队能力:标准实体类型可用托管 API,定制化需求可用开源库,只有当现有方案无法满足精度或延迟要求时,才需自建模型。

实体理解的未来正被大语言模型塑造,带来前所未有的灵活性与性能。GPT-4、Claude 等模型展现了卓越的小样本和零样本实体识别能力,企业仅需极少样本甚至自然语言描述即可定义自定义实体类型,大幅降低标注负担,加速价值转化。多模态实体理解正成为新前沿,融合文本、图像和结构化数据,能在文档、发票、网页中识别更丰富的实体,推动自动文档处理、视觉搜索等新应用。实时处理能力的提升,借助模型蒸馏和边缘部署,使复杂实体识别在移动和物联网设备上变为现实,催生增强现实、实时翻译、自动驾驶等新场景。领域微调的进步也让生物医学、法律、金融等专业领域专用模型精度大幅超越通用模型,领域自适应预训练、迁移学习等技术不断降低门槛。随着这些技术日益成熟,实体理解将成为 AI 系统的隐形基础,使机器获得类人语义理解能力,开拓我们尚未想象的可能性。

随着 ChatGPT、Perplexity、Google AI Overviews 等 AI 系统日益融入信息获取和消费方式,了解这些系统如何识别和引用实体——包括您的品牌——变得至关重要。实体理解正是 AI 系统识别和处理公司、产品、人物及概念提及的机制。监控 AI 系统如何通过实体识别理解和引用您的品牌,能让您洞察:

这正是 AmICited 所关注的——跟踪 AI 系统如何在多个 AI 平台中将您的品牌作为实体进行识别和引用。理解实体识别,能帮助您更好地了解 AI 系统对您业务的认知与传播方式。

实体识别(NER)是在文本中识别并分类实体(如将“Apple”识别为组织),而实体链接则是将这些实体与知识库或权威参考进行关联(如将“Apple”链接到 Apple Inc. 的维基百科页面)。实体识别是第一步,实体链接则增加了语义基础。

最先进的基于 Transformer 的模型如 BERT,在 CoNLL-2003 等标准测试集上可达到 90.9% 的 F1 分数。但准确率在不同领域差异很大——在新闻领域训练的模型在生物医学或社交媒体文本上表现较差。实际准确率高度依赖于领域适应和数据质量。

可以,像 mBERT 和 XLM-RoBERTa 这样的多语言模型可同时支持 100 多种语言。但由于大小写惯例、形态变化和可用训练数据的差异,不同语言的表现会有差异。对于关键应用,单语言模型通常优于多语言模型。

基于规则的系统使用手工设计的模式和词典(速度快、可解释,但脆弱)。基于机器学习的系统通过标注数据学习(更灵活、更具泛化能力,但需要训练数据和特征工程)。现代深度学习方法自动提取特征,准确率更高。

基于规则的系统只需定义模式。传统机器学习模型需要 300-500 个标注样本。基于 Transformer 的模型可在 800+ 样本上工作,但受益于迁移学习——通过微调,预训练模型仅需 100-200 个领域样本即可获得不错的效果。

主要挑战包括:歧义(同一词有不同含义)、词表外实体、领域适应(在一个领域训练的模型在另一个领域表现不佳)、边界识别错误、多语言复杂性,以及专业领域的数据稀缺。这些都需要精心的系统设计和领域调优。

上下文至关重要——“bank”在“river bank”和“savings bank”中的含义不同。现代 Transformer 使用自注意力机制,综合所有周围词元的上下文,从而根据语言和语义环境消除歧义。上下文处理不良是实体识别错误的重要原因。

未来发展包括:大语言模型实现零样本实体识别、多模态理解结合文本和图像、边缘设备上的实时处理,以及领域微调的进步。实体理解将成为支撑机器类人语义理解的基础隐形层。

AmICited 跟踪 ChatGPT、Perplexity 和 Google AI Overviews 等 AI 系统中的实体提及。实时了解 AI 如何理解并引用您的品牌。

实体识别是AI NLP能力,能够识别和分类文本中的命名实体。了解其工作原理、在AI监测中的应用及其在现代AI系统中的作用。...

了解AI系统如何在文本中识别、抽取和理解实体之间的关系。探索实体关系抽取技术、自然语言处理方法及其在现实世界中的应用。...

了解如何在AI搜索中提升实体可见性。掌握知识图谱优化、结构化数据标记和实体SEO策略,提升品牌在ChatGPT、Perplexity和Google AI Overviews中的影响力。...

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.