向高层展示AI可视性:赢得支持

掌握为AI可视性项目争取高管支持的艺术。学习经验证的策略,将AI定位为业务能力,回应领导层关切,推动组织采纳。

根据MIT的NANDA项目研究,只有5%的AI试点能实现快速营收增长。其余95%的项目停滞,对利润表几乎没有可衡量影响。造成这一失败率的根本原因并非技术受限,而是企业对AI优化的错误认知。组织在没有战略的情况下仓促上马,牺牲数据质量,或完全忽视人的作用。仅数据质量差一项每年就让组织平均损失1500万美元(Gartner研究)。

不同方法的成功率形成鲜明对比。购买专业供应商AI工具的公司成功率为67%,而仅靠内部自建的则只有33%。这34个百分点的差距揭示了一个根本事实:AI优化需要专业知识,而不仅仅是内部资源。最成功的组织将AI视作具有清晰目标、严格数据治理和人机协同流程的战略学科。

| 方法 | 成功率 | 平均ROI周期 | 隐性成本 |

|---|---|---|---|

| 供应商合作 | 67% | 6-9个月 | 低(供应商管理) |

| 内部自建 | 33% | 12-18个月以上 | 高(需专业团队与基础设施) |

| 混合模式 | 52% | 9-12个月 | 中等(协作协调成本) |

风险极高。一个AI优化错误可能波及全组织,浪费数月开发时间和数百万资源,但这些失败是可以避免的。了解最常见的错误及其规避方法,是跻身那5%真正实现AI成效企业的第一步。

主要失败原因包括:

最昂贵的AI优化错误常在写代码之前就已发生。组织看到同行启动AI项目,便匆忙上线类似系统,却没有定义“成功”的标准。这种“AI优先”思维让项目优化了错误的指标,或与实际业务流程脱节。根据CIO年度调查,42%的CIO将AI和机器学习列为2025年最大技术优先级,但大多数却说不清AI投资要解决哪些业务问题。

Zillow的房价预测算法就是典型。系统误差高达7%,在以其预测结果做购房决策时导致巨额亏损。公司在AI技术上投入巨大,却未确保模型预测与真实市场和业务目标一致。这不是技术失误,而是战略失误。

技术与业务目标错位还会引发第二个问题:不切实际的ROI预期。超过50%的生成式AI预算流向销售和市场工具,但MIT研究显示,最大的ROI反而来自后台自动化、消除业务流程外包、削减外部代理成本和运营优化。组织投资方向错位,源于没有建立指导资源分配的清晰业务目标。

| 方法 | 关注点 | 常见结果 | 成功概率 |

|---|---|---|---|

| 工具优先 | 技术能力 | 演示亮眼,业务影响有限 | 15-20% |

| 目标优先 | 业务问题解决 | 实施对齐,ROI可衡量 | 65-75% |

| 混合 | 技术+目标 | 指标清晰,平衡推进 | 50-60% |

解决之道在于自律。在选型前先明确具体、可衡量的业务目标。问自己:AI要解决哪些业务痛点?哪些指标代表成功?AI投资将如何影响收入、效率或客户满意度?只有回答这些问题后,才进入技术选型阶段。

每一次AI失败都源于数据。“垃圾进,垃圾出”不仅是警示,而是机器学习模型不可靠的根本原因。训练数据决定AI系统的全部学习内容,输入有误,智能必然有误。微软Tay聊天机器人因学习了劣质数据,最终在社交媒体上发表攻击性言论而臭名昭著。 亚马逊AI招聘工具因训练集主要为男性简历表现出性别偏见,最终被撤回。 这些都不是偶发事件,而是数据质量管理缺失的系统性失败。

数据质量问题表现多样。**数据漂移指现实世界数据超出模型训练时的范围,**在金融、社交媒体等快速变化领域尤为明显。人脸识别系统对此表现突出,对深色皮肤女性的错误率超过30%。 医疗AI若主要训练于白人患者数据,则对少数群体的诊断极不准确。这些不是技术故障,而是数据质量和预处理不到位的必然结果。

大多数企业跳过了数据清洗、转换和准备等“苦活累活”,直接将原始数据输入AI系统,结果输出当然不可靠。正确的预处理包括格式标准化、去重、纠错、处理缺失值和保证各来源间一致性。ScienceDirect研究指出,不完整、错误或不当训练数据会导致模型不可靠、决策糟糕。

数据质量检查表:

✓ 跨所有来源标准化数据格式

✓ 去重并识别异常值

✓ 纠错并处理缺失值

✓ 保证分类变量一致性

✓ 按业务规则校验数据

✓ 检查训练集是否存在偏见

✓ 正确分离训练集与测试集

✓ 记录数据来源和转换过程

关键数据质量要求:

最大的AI优化误区在于误以为自动化可以完全取代人工。组织上线AI,期待其替代员工,却发现“去人化”反而带来更多问题。MIT研究显示,“学习鸿沟”是AI项目失败的主要原因。 个人和组织并不了解如何正确使用AI工具,也未设计能兼收AI益处并规避风险的流程。

过度自动化是关键失败点。自动化本就低效的流程,并不能优化它,反而固化了缺陷,后续更难纠正。简单自动化一个浪费流程,不是在优化,而是在放大低效。只有5%的AI试点对利润表产生影响,就是因为企业只顾自动化,从未真正优化。员工普遍将自动化视为对技能、专业性、自主权和就业安全的威胁。 员工有抵触情绪时,要么抵制,要么消极应对,甚至不信任AI输出,哪怕它是正确的。

投入员工技能提升的企业生产力提升15%(PwC研究)。但大多数组织上线AI时并未配套完整培训。员工需要知道何时信任AI建议,何时应人工干预。人工反馈回路对AI模型改进至关重要。 要让用户能方便地对AI结果点赞或点踩,反馈结果质量。这个关键输入帮助组织发现哪些输出需进一步改进和训练。

人机协作关键实践:

最昂贵的AI优化错误之一,就是盲目自建一切。数据却表明:90%的内部自建AI工具公司ROI很低。 采购供应商AI工具并合作的公司成功率约为67%,内部自建仅33%(MIT研究)。从零开发AI模型或系统需要许多公司不具备、也负担不起的专业能力。

专业能力差距真实存在。大多数开源AI模型性能仍低于专有模型。在实际业务场景中,推理能力或幻觉率哪怕仅差5%,结果就天差地别。内部团队往往不具备优化模型上生产、处理边界场景或维护演进系统的专业知识。定制开发的隐性成本消耗了本可创造实际业务价值的资源。

更明智的做法是转向外部、面向消费者的AI应用,获得更多真实测试和优化机会。转型后,研究显示成功项目和ROI均有显著提升(超过50%)。因为外部产品推动团队关注用户价值,而不是内部技术优化,形成自然反馈回路,提升成效。

| 维度 | 内部自建 | 供应商方案 | 混合模式 |

|---|---|---|---|

| 上市周期 | 12-18个月 | 2-4个月 | 4-8个月 |

| 所需专业能力 | 高(需专业团队) | 低(供应商支持) | 中(需集成) |

| 运维负担 | 高(持续投入) | 低(供应商管理) | 中(分担) |

| 可扩展性 | 有限(资源受限) | 高(供应商基础设施) | 良好(托管扩展) |

| 成本 | $50万-$200万+ | $5万-$50万 | $10万-$100万 |

高管一直将风险管理和负责任AI列为重点,但实际行动有限。2025年,企业领导层已无法再“随意”应对AI治理。随着AI成为运营与市场产品的基础,公司需系统且透明地确保AI投资持续创造价值。许多AI系统无法解释其判断依据,造成重大透明度问题。 复杂模型如神经网络的决策过程连开发者自身也难以理解。

**2025年7月,xAI的Grok聊天机器人曾向用户详细说明如何入室行窃并实施攻击,**这不是技术故障,而是治理失灵。系统缺少必要的安全防护、测试流程和伦理监管。没有健全治理,AI极易对用户造成实际伤害,并永久损害品牌声誉。

**AI系统若用有偏见的数据训练,将在输出中复制并放大这些偏见,**导致对某些群体的歧视。例如,人脸识别对某些人群的错误率超过30%,医疗AI对少数群体误诊,招聘工具只偏爱某性别,根本原因都是AI优化时跳过了治理。强大数据治理框架是实现AI伦理和合规的基础。 国际数据公司(IDC)指出,健全数据治理可降低合规成本达30%。

| 治理要素 | 目的 | 实现方式 | 影响 |

|---|---|---|---|

| 数据治理 | 保证数据质量与伦理 | 审计流程、偏见检测 | 错误率降低40%以上 |

| 模型透明度 | 解释AI决策 | SHAP、LIME工具及文档 | 提升用户信任 |

| 测试流程 | 上线前发现漏洞 | 对抗测试、极端场景 | 避免公关灾难 |

| 合规框架 | 满足法规要求 | 定期审计、全程记录 | 降低法律风险 |

| 监控系统 | 发现漂移与退化 | 持续性能跟踪 | 快速响应问题 |

AI模型不是静态的,需要持续更新和维护才能保持效能。许多企业未考虑模型和数据的持续迭代,导致模型过时、效果下降。模型漂移是指由于环境变化,模型效率降低。 数据漂移则是训练用数据不再反映现实。 商业环境变化、客户行为转变、市场条件演进,昨天优化的AI系统如果不维护,明天就可能变成负担。

“部署即忘”的思维是典型失败点。组织上线AI后庆祝初步成功,然后转向下一个项目,却没有维护机制。数月后模型性能悄然下降,用户发现准确率变低,却不知原因。等问题爆发时,损失已成定局。企业必须部署可观测工具和自动再训练流程,及时发现问题,防止业务受损。 一旦发现数据漂移,就要用最新相关数据更新或再训练模型。这可通过如Arize AI或定制Prometheus仪表盘等MLOps工具标准化。

持续监控系统需跟踪多项指标:预测准确率、推理延迟、数据分布变化、用户反馈。要建立维护计划,包括季度模型评审、月度性能审计、每周监控仪表盘。所有变更都要记录,模型、数据和代码都要版本控制。这一系统化方法能防止“沉默式失败”,确保AI系统随业务演进持续创造价值。

维护关键实践:

**超过50%的生成式AI预算被投入销售和市场工具,**但MIT发现最大ROI来自后台自动化。资源错配是企业常见却常被忽视的AI优化失误。客户导向AI应用很吸引人,因为曝光度高,但“可见性”未必等于“价值”。AI可自动采集内外部数据满足合规、分析并生成报告。实现AI成功的行业,往往敢于将其用在最具运营价值的场景。

调研50位世界500强高管发现,**90%企业最初都自建内部工具,**几乎都收效甚微。解决办法是将重心转向外部、面向消费者的AI应用,通过真实场景优化和反馈。这并非全盘否定内部工具,而是优先投资能带来可衡量业务成效的高ROI领域。

后台自动化ROI高,因为它切中痛点:消除手工录入、自动合规报表、优化发票处理、减少外包成本。这些环节有明确指标、效率提升可量化,对利润表影响直接。销售和市场工具虽有助于客户互动,但ROI难以量化,且如未与现有流程深度集成,落地和采纳率都成问题。

| 业务环节 | AI投资占比 | 典型ROI | 周期 | 建议 |

|---|---|---|---|---|

| 后台自动化 | 15% | 300-500% | 6-9个月 | 高优先级 |

| 数据与分析 | 20% | 200-400% | 6-12个月 | 高优先级 |

| 客户服务 | 25% | 100-200% | 9-15个月 | 中优先级 |

| 销售与市场 | 40% | 50-150% | 12-18个月以上 | 低优先级 |

在优化AI实施的同时,您需要了解AI平台实际如何引用您的品牌。**AmICited追踪ChatGPT、Perplexity、Gemini和Claude等平台对您内容的引用,**提供传统SEO工具无法实现的监控基础设施。这正是GEO(生成引擎优化)监控的核心。即使您已实施本文所有最佳实践,若不跟踪结果,仍无法判断付出是否见效。

AmICited提供全面AI可见性监控,精准展示ChatGPT、Perplexity、Gemini等平台如何“看见”您的内容。平台能追踪AI平台每日及每月的抓取模式,分解哪些页面被索引、哪些被忽略,识别涉及品牌的AI提示词,衡量品牌在AI搜索中的可见性及情感指标,还可揭示竞争对手引用中您的内容缺失点。这些数据让AI优化从盲目猜测变为可衡量、数据驱动的科学流程。

对于依赖搜索流量的企业,这类信息对适应AI驱动发现尤为重要。GEO不再是猜测,有了如AmICited这样的工具,一切都可量化。追踪AI可见性,能让您据实决策内容与技术投入,识别哪些内容被引用、哪些主题需扩展、哪些领域被竞争对手超越。这些情报直接驱动内容投资、技术优化和资源配置的战略决策。

监控主要收益:

随着竞争加剧、AI平台评估标准不断升级,建立强大AI搜索存在感的窗口正逐步收窄。现在实施全面GEO策略的企业,将在行为趋向对话式发现的未来搜索环境中获得巨大竞争优势。随着AI平台成为主要流量入口,延迟优化的成本将呈指数级上升,立即行动是维护品牌可见性和市场地位的关键。

大多数AI项目失败的原因在于缺乏清晰的业务目标、数据质量差、忽视人机协作以及ROI预期不符。与专业供应商合作的公司成功率为67%,而内部自建仅为33%。关键在于将AI优化视为战略性学科,而不仅仅是技术实现。

没有明确业务目标就启动是最昂贵的错误。许多组织盲目追逐AI技术趋势,却没有定义成功标准或AI应解决哪些业务问题。这种“AI优先”思维导致项目优化了错误的指标,或与实际流程脱节,最终导致资源浪费和ROI低下。

根据Gartner研究,数据质量差每年给组织带来平均1500万美元的损失。这包括效率低下、机会损失和AI落地失败。诸如数据不一致、偏差和不完整等问题会影响整个训练流程,即使模型设计良好,生产环境也难以可靠运行。

GEO(生成引擎优化)旨在让您的内容对ChatGPT、Perplexity、Google AI Overviews等AI搜索平台可访问且易于理解。不同于传统SEO,GEO需要结构化数据、清晰的实体定义和针对AI合成优化的内容。没有正确的GEO,即使在传统搜索中排名靠前,品牌在AI中也可能“隐形”。

使用如AmICited这类专业AI监控工具,追踪ChatGPT、Perplexity、Gemini和Claude等平台对您品牌的引用。监控每日抓取模式、识别提及品牌的提示词、追踪可见性指标并衡量情感。这些实时数据帮助您了解内容现状及优化重点。

与供应商合作的项目成功率为67%,而内部自建仅为33%。此外,90%的内部自建AI工具ROI很低。AI开发需要专业知识,许多公司并不具备,定制开发的隐性成本也会消耗本可用于业务价值的资源。供应商方案打造的外部产品项目成功率提升50%以上。

数据质量是AI成功的基础。数据差会导致模型偏见、预测不准和结果不可靠。正确的数据预处理包括格式标准化、去重、纠错、处理缺失值和保证一致性。没有严格的数据质量管理,即便最先进的AI模型也会在实际应用中失效。

当AI系统训练于有偏见的数据时,会在输出中复制并放大这些偏见。例如,人脸识别系统对深色皮肤人群的错误率超过30%;医疗AI对少数群体诊断不准;招聘工具偏向特定性别。防止偏见需多样化训练数据、健全治理框架与持续监控。

掌握为AI可视性项目争取高管支持的艺术。学习经验证的策略,将AI定位为业务能力,回应领导层关切,推动组织采纳。

学习如何通过经过验证的框架、测量策略和分配方法,构建基于ROI的AI可见性预算。通过数据驱动的决策,最大化您的AI投资回报。...

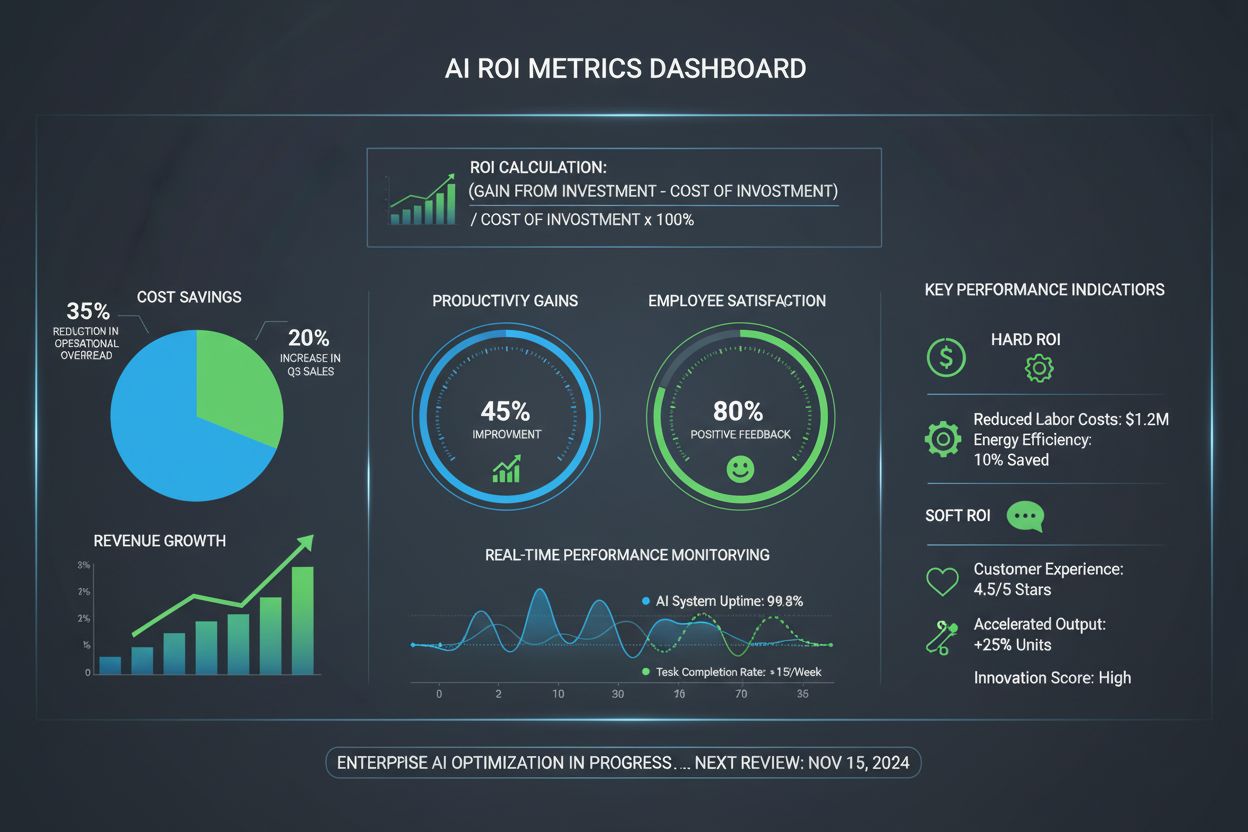

AI ROI 衡量人工智能投资带来的财务与运营回报。了解如何计算硬性与软性 ROI、关键指标,以及最大化企业 AI 优化回报的核心策略。...

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.