AI内容质量阈值:标准与评估指标

了解AI内容质量阈值是什么、如何衡量,以及它为何对于监控ChatGPT、Perplexity等AI答案生成器中的AI生成内容至关重要。

了解为何对于 AI 模型来说,数据质量比数量更重要。学习资源配置策略、成本影响以及优化 AI 训练数据投资的实用框架。

机器学习领域的传统观念一直认为“数据越多越好”。然而,最新研究对此提出了有力挑战,数据质量在决定 AI 模型性能上远超数量。2024 年一项 arxiv 研究(2411.15821)针对小型语言模型,发现训练数据质量的作用远大于数据量,揭示了数据数量与模型准确度之间比想象中更微妙的关系。其成本影响也极为显著:企业若在数据采集上投入巨资却忽略质量,往往会在存储、处理和算力开销上浪费资源,模型表现却收效甚微。

数据质量并非单一概念,而是涵盖多个关键要素的多维框架。准确性指数据是否真实反映现实、标签是否正确。一致性要求数据在整个数据集中遵循统一格式和标准。完整性衡量所需信息是否齐全,无明显缺失。相关性判断数据是否直接针对 AI 需要解决的问题。可靠性表示数据来源的可信度及其随时间的稳定性。最后,噪声是指会误导模型训练的不必要波动或错误。理解这些维度有助于企业战略性地优先投入数据筛选工作。

| 质量维度 | 定义 | 对 AI 的影响 |

|---|---|---|

| 准确性 | 标签和数据表达的正确性 | 直接影响预测可靠性,错误标签引发系统性误差 |

| 一致性 | 格式统一、结构标准化 | 支撑稳定训练,格式混乱会干扰学习算法 |

| 完整性 | 所有必要信息齐全无遗漏 | 缺失值减少有效训练数据,影响泛化能力 |

| 相关性 | 数据直指问题领域 | 高相关数据优于大量通用数据 |

| 可靠性 | 数据来源可信且稳定 | 不可靠来源带来系统偏差,削弱模型健壮性 |

| 噪声 | 不必要的波动和测量错误 | 控制噪声可提升鲁棒性,噪声过大则性能下降 |

一味追求数据数量而不设质量防线,会引发一连串远超模型表现本身的问题。Rishabh Iyer 的研究表明,标签噪声实验导致准确率大幅下降——错误标注的数据会削弱模型性能,绝非中性训练样本。除了准确性隐患,企业还需为无价值数据集付出持续增长的存储和处理成本,以及因多余算力消耗带来的环境成本。医学影像领域就是一个警示:数千张标签错误的 X 光片,可能训练出自信却危险的诊断模型,威胁患者健康。廉价低质数据的“虚假经济”在模型重训、调试、部署失败等隐性成本暴露后便一目了然。

在实际 AI 应用中,领域专属高质量数据始终优于通用大规模数据。以电影评论情感分类器为例:1 万条精心筛选的电影评论数据集,远优于从财经新闻、社交媒体、产品评论中随机抽取的 10 万条通用情感样本。训练数据对具体问题领域的相关性远比规模重要,因为模型会学习训练分布下的特定模式。若数据与目标场景无关,模型就会学到虚假关联,无法泛化到真实应用。企业应优先收集精确匹配问题领域的小型数据集,胜过囤积需大量筛选和预处理的庞大通用数据集。

最佳数据策略不是走极端,而是找到“黄金分割区”——数据数量与质量针对具体问题恰到好处。即便标签完美,数据过少也会导致模型拟合不足,无法捕捉现实复杂性;而数据再多但质量差,则只会增加算力浪费、训练不稳定。arxiv 研究具体揭示了这种平衡:重复率 25% 时,最小化重复提高了 0.87% 的准确率,而 100% 重复则导致准确率暴跌 40%。理想平衡取决于算法类型、问题复杂度、算力资源和目标领域的自然变异性。数据分布应反映现实变异,而非人为统一,这能教会模型应对生产环境下的多样性。

并非所有新增数据都有益——区分有效增强与有害劣化是制定数据策略的关键。有控制的扰动与增强技术能提升模型健壮性,让算法学会应对旋转、光照、标签微变等实际多样性。手写数字集 MNIST 就证明了这一点:用增强版本(旋转、缩放、扭曲)训练的模型,泛化能力远胜只用原始图片训练者。然而,严重损坏(如随机噪声、系统性错标或无关数据注入)则只会损害性能、浪费资源。关键区别在于“有意为之”:增强是为反映真实变化而设计,垃圾数据则是无差别噪声,会干扰学习。企业在扩充数据集时,必须区分两者。

对于资源有限的团队,主动学习是一项强大解决方案,它在保持甚至提升模型性能的同时大幅减少所需数据。与其被动采集并标注所有可用数据,不如让主动学习算法识别出最有学习价值的未标注样本,极大减轻人工标注负担。通过集中精力在最具影响力的样本上,企业能用更少的数据实现优异模型表现。主动学习让 AI 开发变得平民化,即便没有大规模标注预算,也能靠策略性数据选择构建高效模型。高效少量学习让企业迭代更快、降低成本,将资源用于质量保障而非无止境的数据采集。

制定数据策略时,必须从根本上优先质量而非数量。企业应投入健全的数据验证流程,提前发现并修正错误,自动检查一致性、完整性和准确性。数据分析工具能在大规模下发现质量问题,揭示错标、缺失、无关样本等模式,便于训练前修正。主动学习则减少人工审核数据量,同时保证审核样本的信息量最大。生产环境下持续监控模型表现,可揭示训练数据质量问题是否转化为现实失误,并实现快速反馈。最佳策略是在采集和筛选之间取得平衡,认识到 1000 条完美标注数据往往优于 10 万条噪音数据,无论是模型性能还是总体拥有成本。

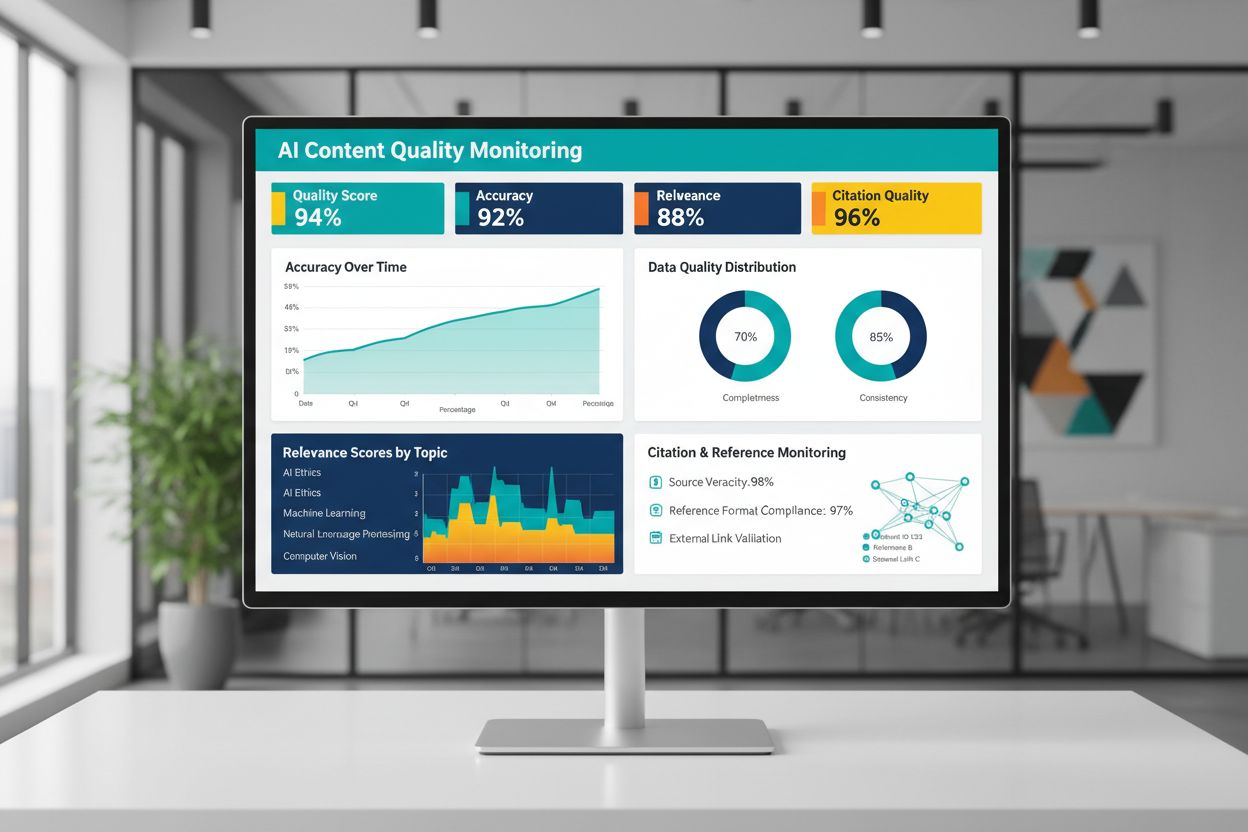

AI 生成或训练内容的质量,根本上取决于训练数据质量,因此持续监控 AI 输出对可靠性至关重要。像 AmICited.com 这样的平台正满足这一关键需求,通过监控 AI 答案和引用准确度,直接反映内容质量及可信度。若 AI 系统用低质量、引用错误或不准确信息训练,输出也会继承这些缺陷,甚至大规模传播错误信息。监控工具不仅要跟踪准确性指标,还应关注相关性、一致性及 AI 输出主张的证据支持。企业部署 AI 时,必须建立反馈机制,及时发现输出偏离质量标准,便于快速重训或调整底层数据。投资监控基础设施能及早发现质量下滑,防止影响用户或损害品牌信誉。

将数据质量原则转化为行动,需要从评估、测量到迭代的结构化流程。首先,评估当前基线——通过审核和分析了解训练数据现状。根据具体应用,设定明确的质量指标,无论是准确性阈值、一致性标准还是相关性准则。实施数据治理,明确责任归属、验证流程和质量关卡,确保数据进入训练前得到把关。与其一上来处理海量数据,不如先用小规模精选数据集,便于建立质量标准和流程。通过对比模型改进前后的表现,量化质量投入成效,为持续投资提供证据。随着流程完善再逐步扩充采集规模,确保每一步质量提升都能带来实际表现提升。

不是。最新研究显示,数据质量往往比数量更重要。质量差、标注错误或无关的数据甚至在大规模下也会削弱模型性能。关键是要在拥有足够训练数据和维持高质量标准之间找到平衡点。

数据质量涵盖多个维度:准确性(标签正确)、一致性(格式统一)、完整性(无缺失值)、相关性(与问题对齐)、可靠性(数据来源可信)、噪声水平。根据您的实际应用定义专属指标,并实施验证关卡,在训练前捕捉质量问题。

理想规模取决于算法复杂度、问题类型和可用资源。与其追求最大规模,不如锁定“黄金分割区”——数据能反映真实模式、又不会被无关或冗余样本拖累。建议从小型精选数据集起步,根据性能提升逐步扩展。

数据增强通过有控制的扰动(旋转、轻微变形、光照变化)保持标签真实性,同时教会模型应对现实多变性。这不同于垃圾数据——增强是有目的且反映真实变化,使模型更能适应实际部署条件。

主动学习能识别出对模型最有学习价值的未标注样本,从而大幅减少标注负担。无需标注全部数据,而是集中人力在最具影响力的样本上,从而用更少标注数据实现优异性能。

优先保证质量而非数量。投资于数据验证流程、数据分析工具和治理机制,确保训练数据高质量。研究表明,1000个完美标注样本往往优于10万个噪音样本,无论模型表现还是总拥有成本。

低质量数据会带来多重成本:模型重训练、调试、部署失败、存储压力和算力浪费。在医疗影像等关键领域,低质量训练数据甚至会导致严重错误。廉价劣质数据的“假性低成本”在考虑这些隐性代价后就会暴露。

实施 AI 输出的持续监控,跟踪准确性、相关性、一致性和引用质量。像 AmICited 这样的平台可以监控 AI 系统信息引用和引用准确性。建立生产表现与训练数据质量的反馈机制,实现快速改进。

了解AI内容质量阈值是什么、如何衡量,以及它为何对于监控ChatGPT、Perplexity等AI答案生成器中的AI生成内容至关重要。

了解AI系统如何超越传统SEO指标评估内容质量。学习语义理解、事实准确性与对LLM和AI摘要至关重要的质量信号。

社区讨论 AI 搜索引用内容的质量要求。了解 ChatGPT、Perplexity 及其他 AI 平台对内容需要满足的质量门槛。

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.