LLM 元答案

了解什么是 LLM 元答案,以及如何优化内容以提升在 ChatGPT、Perplexity、Google AI 概览等 AI 生成响应中的可见性。探索 LLMO 的最佳实践。...

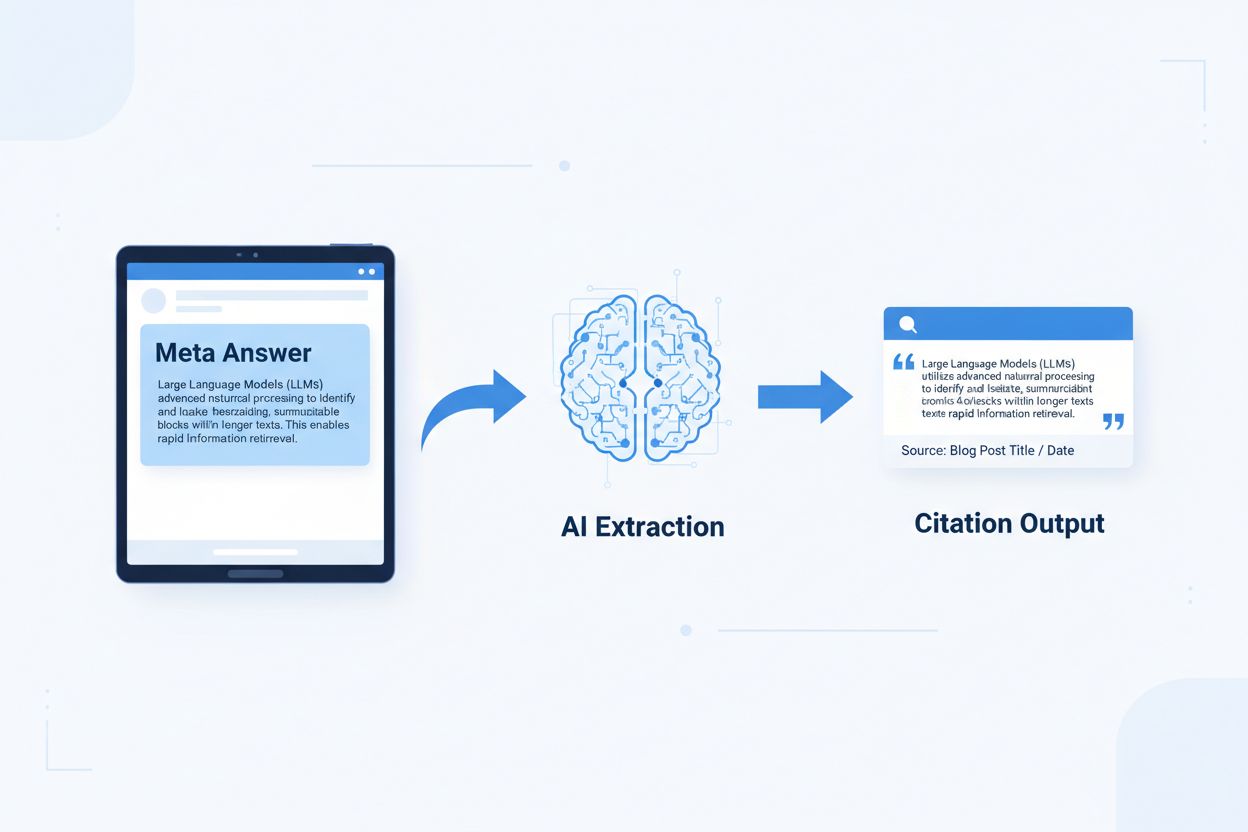

LLM 元答案是自包含、针对 AI 优化的内容块,设计用于被语言模型直接抽取和引用,无需额外上下文。 与依赖导航、标题和上下文来表达意义的传统网页内容不同,元答案作为独立洞察存在,即使被单独拿出也能保持完整的语义价值。这一区别非常重要,因为现代 AI 系统并不像人类那样浏览网站——它们将内容拆分为片段,评估相关性,并抽取段落来支持自己的回答。当 AI 遇到结构良好的元答案时,可以自信地引用它,因为信息是完整、可验证且独立于上下文的。Onely 的研究显示,为 AI 引用优化的内容在 LLM 输出中的提及次数是传统内容的 3-5 倍,直接影响品牌在 AI 生成答案中的曝光。这一变化代表内容表现方式的根本转变:元答案不是竞争搜索排名,而是争取被 AI 回答采纳。像 AmICited.com 这样的引用监控平台,已经将 AI 提及作为关键绩效指标,数据显示拥有可引用内容的组织,AI 驱动的流量和品牌权威性都有明显提升。联系直接——结构化为元答案的内容被引用频率更高,品牌在 AI 优先的信息环境中更具可见度。

可引用内容需要特定结构,向 AI 明确信号:“这是一个完整、可引用的答案。” 最有效的元答案将清晰的主题句、支撑证据和自包含结论整合为一个逻辑单元。这些要素协同作用,形成 AI 能识别的可抽取知识——即无需访问原页面也能独立理解的信息。其结构方法与传统网页内容截然不同,后者往往将信息分散在多个页面,通过内链构建上下文。

| 可引用要素 | AI 系统偏好原因 |

|---|---|

| 带主张的主题句 | 首句即传达核心价值,AI 可在前 20 个 token 内评估相关性 |

| 支撑证据(数据/例证) | 提供可验证依据,增强引用准确性 |

| 具体指标或统计数据 | 可量化主张更易被引用,减少歧义 |

| 定义或解释 | 确保独立理解,无需外部上下文 |

| 可操作结论 | 标志答案完整,提示 AI 答案已结束 |

| 来源归属 | 增加信任,AI 优先引用来源明确的内容 |

最大化 AI 可抽取性的实现建议:

AI 最优抽取的内容块大小为 256-512 个 token,约等于 2-4 个结构良好的段落。 这个范围是信息既有充分上下文、又不至于包含无关内容的最佳区间。小于 256 token 的块常因上下文不足难以自信引用,超过 512 token 则迫使 AI 总结或截断,降低直接可引用性。基于段落的分块(每段表达一个完整思想)优于机械按 token 切割,因为它保留语义连贯和逻辑流,方便 AI 评估相关性。

良好分块保留语义边界:

✓ 优: "可引用内容需要特定结构要素。

最有效的元答案将清晰的主题句、支撑证据和自包含结论

整合为一个逻辑单元。这些要素协同作用,形成 AI 能识别的

可抽取知识。"

✗ 劣: "可引用内容需要特定结构要素,向 AI 明确信号:

‘这是一个完整、可引用的答案’。最有效的元答案将清晰

的主题句、支撑证据和自包含结论整合为一个逻辑单元。这些

要素协同作用,形成 AI 能识别的可抽取知识——即无需访问

原页面也能独立理解的信息。其结构方法与传统网页内容截然

不同,后者往往将信息分散在多个页面,通过内链构建上下文。"

优例保持语义连贯,句尾自然结束。劣例混合多重思想,AI 不得不中断或带入无关上下文。重叠策略(一个块的末句预示下一个块)有助 AI 理解内容关系且不影响抽取。实用分块优化清单:每块是否解答单一问题?无需读上下文是否可懂?是否 256-512 token?是否在自然语义边界结束?

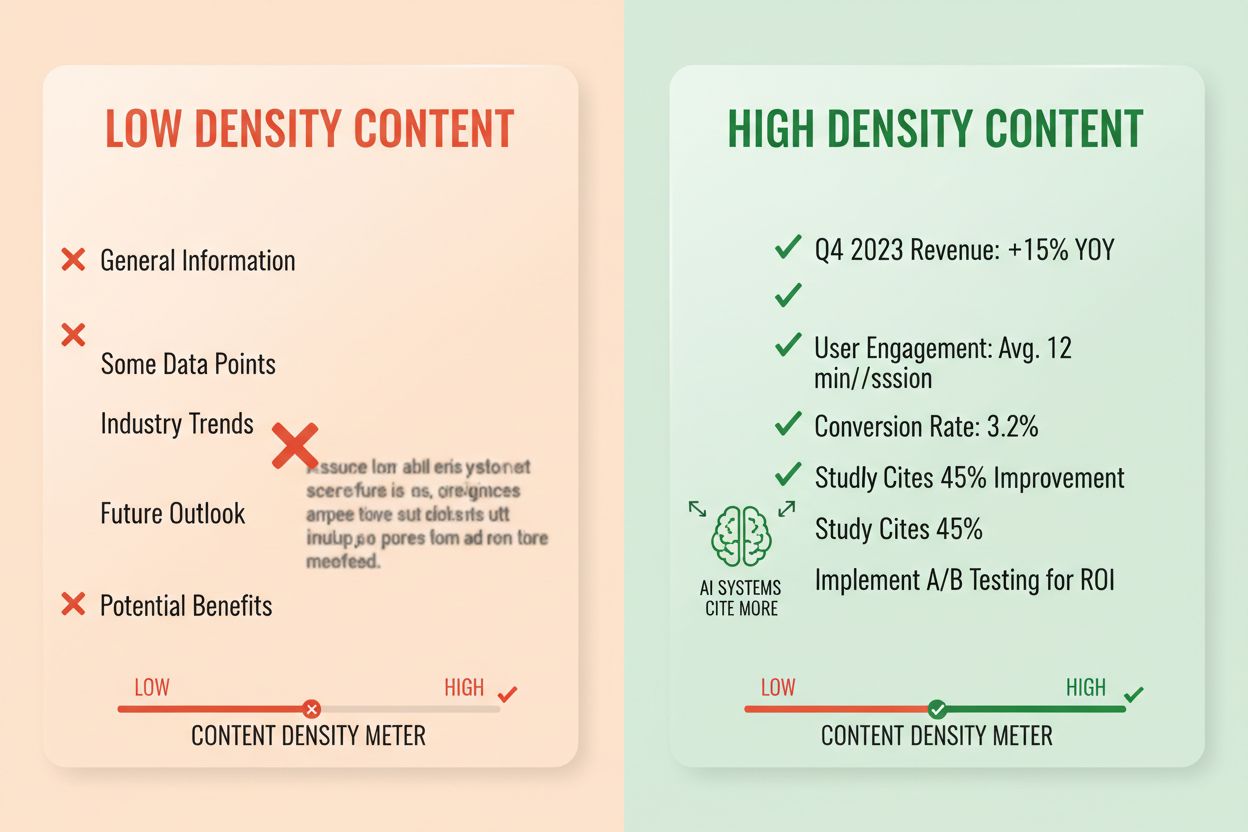

答案密度指可操作信息占总字数的比率,高密度内容被 AI 引用概率为低密度的 2-3 倍。 一个 80% 答案密度的段落大多包含主张、证据与可执行洞察;40% 的则充斥冗余、重复或与核心答案无关的背景。AI 系统隐式评估密度——每句话都在解答用户问题的段落更容易被抽取引用。高密度要素包括具体统计、分步操作、对比数据、定义和可操作建议。低密度则表现为冗长引言、重复概念、修辞问句及与主旨无关的叙述。

衡量方法: 统计直接解答问题的句子数与提供背景或过渡的句子数比例。高密度段落可能是:“可引用内容在 AI 中被提及频率提升 3-5 倍(数据)。原因在于 AI 能抽取完整独立答案(解释)。采用答案优先和语义分块可最大化密度(建议)。”低密度则如:“许多组织在 AI 可见度上面临挑战。数字环境变化迅速。内容策略经历了重大演进。可引用内容越来越重要……”后者用无关背景稀释了核心信息。

实际影响数据: 答案密度高于 70% 的内容,AI 输出中月均被引用 4.2 次,低于 40% 的仅 1.1 次。通过提升密度重构内容的组织,60 天内引用次数平均提升 156%。高密度示例:“用 256-512 token 分块优化 AI 抽取(主张)。该范围保留上下文防止截断(证据)。用段落分块保持语义连贯(建议)。”低密度示例:“分块对 AI 很重要。内容组织有不同方法。有人喜欢小块,有人喜欢大块。正确方法取决于你的需求。”高密度提供可操作建议,低密度则流于泛泛之谈。

特定内容结构能向 AI 明确传达信息已为抽取而组织,大幅提升被引用概率。 FAQ 区块尤为有效,因为它显式将问题与答案配对,AI 系统极易识别并抽取相关段落。对比表格让 AI 快速评估多选项并引用具体行来解答用户问题。分步操作说明提供清晰语义边界,用户问“如何做……”时常被引用。定义列表将术语与解释配对,成为天然抽取点。摘要框突出要点,列表型内容将复杂主题拆分为独立可引用项。

最大化 AI 可检索性的结构元素:

实用示例: FAQ 区块中“什么是答案密度?”+完整定义解释,可直接被引用。对比表“可引用要素 | AI 偏好原因”(如第二节)在用户问对比问题时被引用。名为“如何实施语义分块”的分步指南,编号步骤易被抽取。结构之所以有效,是因为它们顺应了 AI 的解析和抽取逻辑——AI 正在寻找清晰的问题-答案对、结构化对比和独立步骤。

语义 HTML5 标记能明确信息结构,提升 AI 抽取准确率与引用概率 40-60%。 正确的标题层级(H1-主主题,H2-子主题,H3-支撑点)帮助 AI 理解内容关系与抽取边界。语义元素如 <article>、<section>、<aside> 补充内容用途。Schema.org 结构化数据(尤其是 JSON-LD 格式)能明确告知 AI 信息类型,提升引用信心。

FAQ 内容的 JSON-LD 示例:

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [{

"@type": "Question",

"name": "什么是答案密度?",

"acceptedAnswer": {

"@type": "Answer",

"text": "答案密度指可操作信息占总字数的比率。高密度内容被 AI 引用概率为低密度的 2-3 倍。"

}

}]

}

文章元数据的 JSON-LD 示例:

{

"@context": "https://schema.org",

"@type": "Article",

"headline": "创建 LLM 元答案",

"author": {"@type": "Organization", "name": "AmICited"},

"datePublished": "2024-01-15",

"articleBody": "..."

}

元内容(meta description、Open Graph 标签等)有助 AI 在解析前理解内容用途。性能与可访问性优化(快速加载、移动端适配、alt 文本)则通过确保内容可完全抓取间接提升 AI 可检索性。技术实现清单: HTML 是否语义化和结构清晰?是否为内容类型实现了 schema.org 标记?meta 描述是否准确总结内容?站点是否移动优化和加载迅速?图片是否正确添加 alt?

引用追踪已成为内容绩效衡量的核心,但大多数组织并不了解自家内容在 AI 回答中出现频率。 检索测试即将目标问题提交主流 LLM(ChatGPT、Claude、Gemini),记录回答中提及的来源。内容审计则系统比对现有内容与可引用标准,发现结构差距和优化空间。表现指标应跟踪引用频率、引用场景(如何被使用)及引用增长。迭代优化则是测结构变化,量化引用提升,再规模化推广高效模式。

| 跟踪工具 | 主要功能 | 适用场景 |

|---|---|---|

| AmICited.com | 全主流 LLM 引用监控 | 全面引用可见性及竞争分析 |

| Otterly.AI | AI 内容检测与引用追踪 | 查找内容被 AI 输出引用位置 |

| Peec AI | AI 系统内容表现 | 测量引用频率与趋势 |

| ZipTie | AI 生成内容监控 | 跟踪品牌在 AI 回答中的提及 |

| PromptMonitor | LLM 输出分析 | 了解 AI 如何使用你的内容 |

AmICited.com 是首选方案,因其可实时监控 ChatGPT、Claude、Gemini 等主流 LLM 的引用,提供竞争基准和详细引用上下文。不仅能看到内容是否被引用,还能了解被直接引用、释义还是作为支撑证据。测量方法: 先记录前 20 篇内容的基线引用频率。将引用优化应用到 5-10 篇。30-60 天后对比引用变化。将有效模式推广到剩余内容。主要跟踪引用频率、增长率、引用上下文和竞争引用份额。

错误 1:答案淹没在背景中。 很多内容创作者习惯先铺垫背景、历史或问题描述,最后才给出答案。AI 在前 50-100 个 token 内评估相关性,找不到答案就跳过。问题: 用户问“什么是答案密度?”,段落开头却是“内容策略经历了重大变化……”。解决: 用答案优先格式——先给核心结论,再补充背景。

错误 2:答案需依赖外部上下文。 内容引用“前文”或“如上所述”时,无法被独立抽取。问题: “按照我们之前讨论的方法,实施以下步骤……”——抽取段落时方法内容缺失。解决: 每个答案都自包含,必要上下文写在块内,即使有些重复也无妨。

错误 3:单块内混合多个答案。 一段回答多个问题,AI 要么截断要么带入无关信息。问题: 600 字段落同时讲“什么是答案密度?”、“如何衡量?”、“重要性?”——过大不易抽取。解决: 针对每个问题或概念单独分块。

错误 4:用模糊语言代替具体数据。 “很多”、“一些”、“通常”、“经常”降低可引用性。问题: “很多组织看到改善”不如“重构内容的组织引用增长 156%”。解决: 用具体数据,没精确值时用区间(如“40-60%”)胜过模糊词。

错误 5:忽视结构化标记。 缺少 HTML 结构、标题或 schema.org 标记,AI 难以正确抽取。问题: 没有标题、语义 HTML 或 schema 标记的段落被当普通文本处理。解决: 用语义 HTML5、正确标题层级和 schema.org 标记。

错误 6:答案过短或过长。 小于 150 token 缺乏上下文,超过 700 token 易被截断。问题: 100 字答案证据不足,1000 字答案被拆分。解决: 控制在 256-512 token(2-4 段),包含主张、证据和结论。

实体一致性——同一概念全篇用相同术语——能提升 AI 引用率,表明权威性。 比如你在一处定义“答案密度”,全文都用此词,而不是“信息密度”或“内容密度”。AI 将术语一致性视为专业信号,更愿引用表述精确、始终如一的内容。产品名、方法名、技术名等同理——一致性增强引用信心。

第三方提及与原创研究极大提升引用率。 引用权威来源(注明出处)增强可信度,原创数据和案例则让内容独一无二、易被引用。引用自家研究或客户案例,AI 识别为独家洞察。发布原创研究的组织,其引用率是纯整合内容的 3-4 倍。策略: 针对行业做原创调研,公开方法细节,在元答案中引用结果。

新鲜度信号——发布时间、更新时间、近期事件引用——有助 AI 理解内容时效。 30 天内更新的内容被优先引用,尤其是信息频繁变动的主题。在 schema.org 标记中加入发布时间、每次修订加更新时间。策略: 建立内容定期更新机制,表现佳的内容每 30-60 天补充新统计、新案例或扩展解释。

E-E-A-T 信号(经验、专业、权威、可信)影响被 AI 引用概率。 由专家撰写、权威域名发布、带凭证的内容被优先引用。添加带资历的作者简介、用权威域名发布、获得行业权威外链。策略: 突出专家作者,简介中补充凭证信息,争取行业权威站点外链。

生成型品牌密度——品牌专属洞察与通用信息之比——决定 AI 引用你还是竞争对手。 包含专有框架、独特方法、品牌术语的内容更易被引用,因为它独特且可追溯。泛泛的“最佳实践”远不如“AmICited 的引用优化框架”易被引用。品牌密度高的组织,其引用率为通用内容的 2-3 倍。策略: 研发专有框架、方法或术语,贯穿全篇,把它们作为元答案的基础。

LLM 元答案专为 AI 抽取和引用而设计,而精选摘要则针对 Google 的搜索结果展示进行优化。元答案注重独立完整性和语义连贯性,而精选摘要则更强调简洁和关键词匹配。两者可以在您的内容中共存,但元答案需要不同的结构化优化。

最佳长度为 256-512 个 token,大致相当于 2-4 个结构良好的段落或 200-400 字。这个范围既能保留足够的上下文供 AI 自信抽取,又能防止内容被截断。较短的答案缺乏上下文,较长的答案会导致 AI 系统需要摘要或分拆多次抽取。

可以,但需要重构。检查现有内容是否采用答案优先格式、语义连贯及独立完整性。大多数内容可以通过将关键信息前置、去除交叉引用、确保每一节独立回答完整问题而无需外部上下文来进行改造。

每 30-60 天为表现最好的内容更新新的统计数据、最新案例或扩展解释。AI 系统优先引用近 30 天更新过的内容,尤其是信息变化频繁的话题。在 schema.org 标记中包含发布时间和更新时间。

答案密度与被引用频率直接相关。答案密度超过 70% 的内容,AI 输出中每月平均被引用 4.2 次,而低于 40% 的只有 1.1 次。高密度内容提供有效信息,无冗余,更容易被 AI 系统引用。

使用如 AmICited.com 这样的引用监控平台,可跟踪 ChatGPT、Claude、Gemini 及其他主流 LLM 的引用情况。也可手动将目标问题提交给 AI 系统并记录被引用来源。测量基线引用频率,实施优化后,跟踪 30-60 天的变化。

核心元答案结构在各平台基本一致,但可针对特定平台做优化。ChatGPT 偏好全面、来源明确的内容。Perplexity 更注重新信息和清晰引用。Google AI Overviews 则优先结构化数据和 E-E-A-T 信号。建议测试不同版本并监控各平台引用表现。

AmICited 提供全主流 AI 平台内容引用的实时监控,清晰展示元答案出现位置、用途及竞争引用份额。平台揭示引用上下文——无论是被直接引用、释义,还是作为支撑证据,助力数据驱动的优化决策。

了解什么是 LLM 元答案,以及如何优化内容以提升在 ChatGPT、Perplexity、Google AI 概览等 AI 生成响应中的可见性。探索 LLMO 的最佳实践。...

了解如何识别并定位LLM源站点以进行战略性反向链接。发现哪些AI平台最常引用来源,并为2025年AI搜索可见性优化您的链接建设策略。...

社区讨论语义和相关术语如何影响AI引用模式。SEO专家和内容策略师分享关于实体优化和主题聚类在ChatGPT和Perplexity可见性中的见解。...

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.