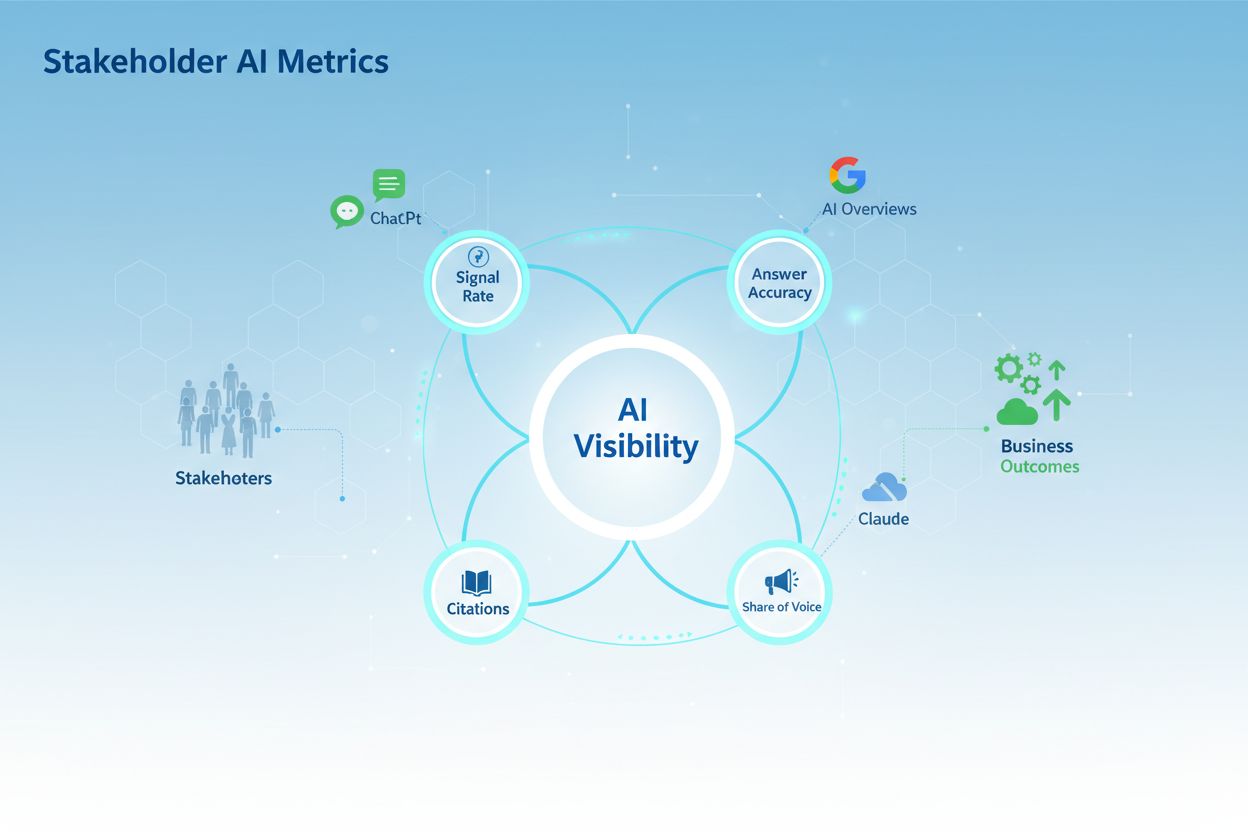

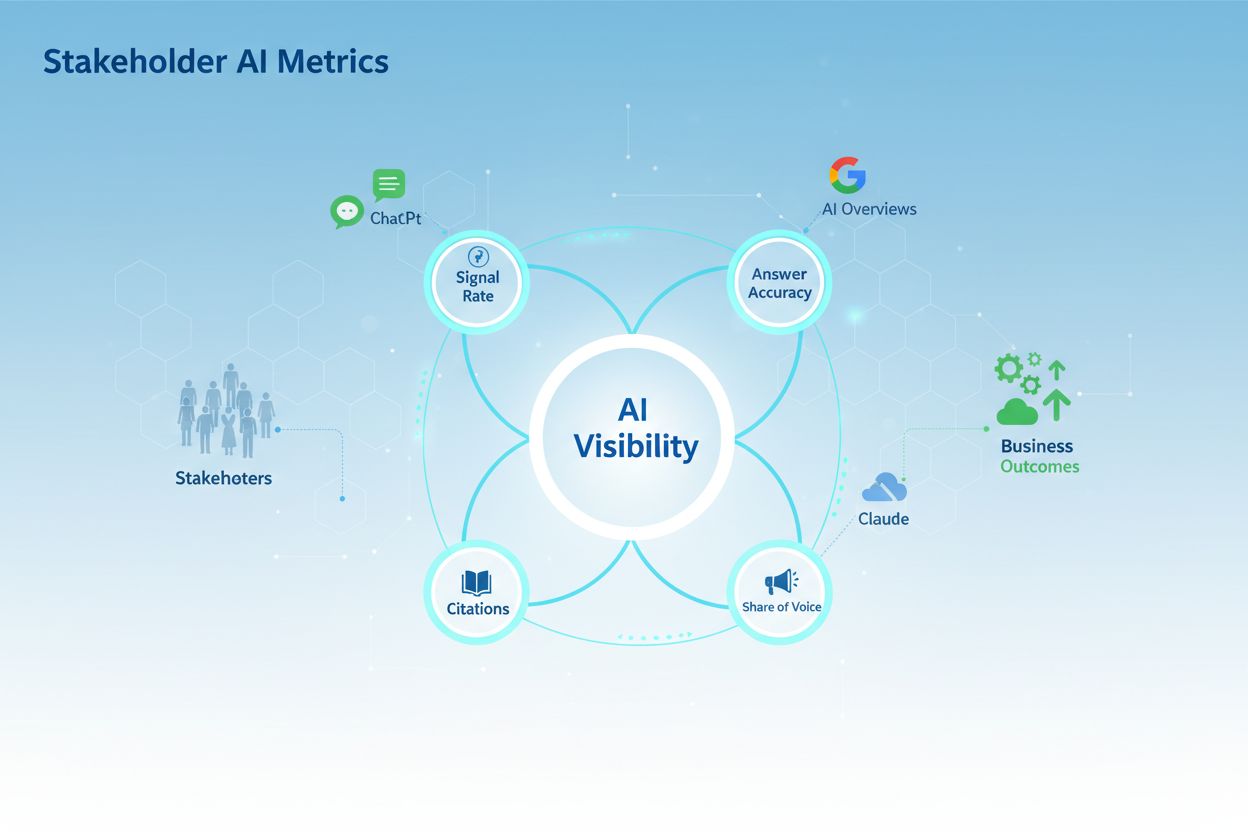

利益相关者关注的AI可见性关键指标

了解利益相关者最关心的4大AI可见性核心指标:信号率、准确率、引用率和声量份额。掌握品牌AI可见性测量与报告方法。...

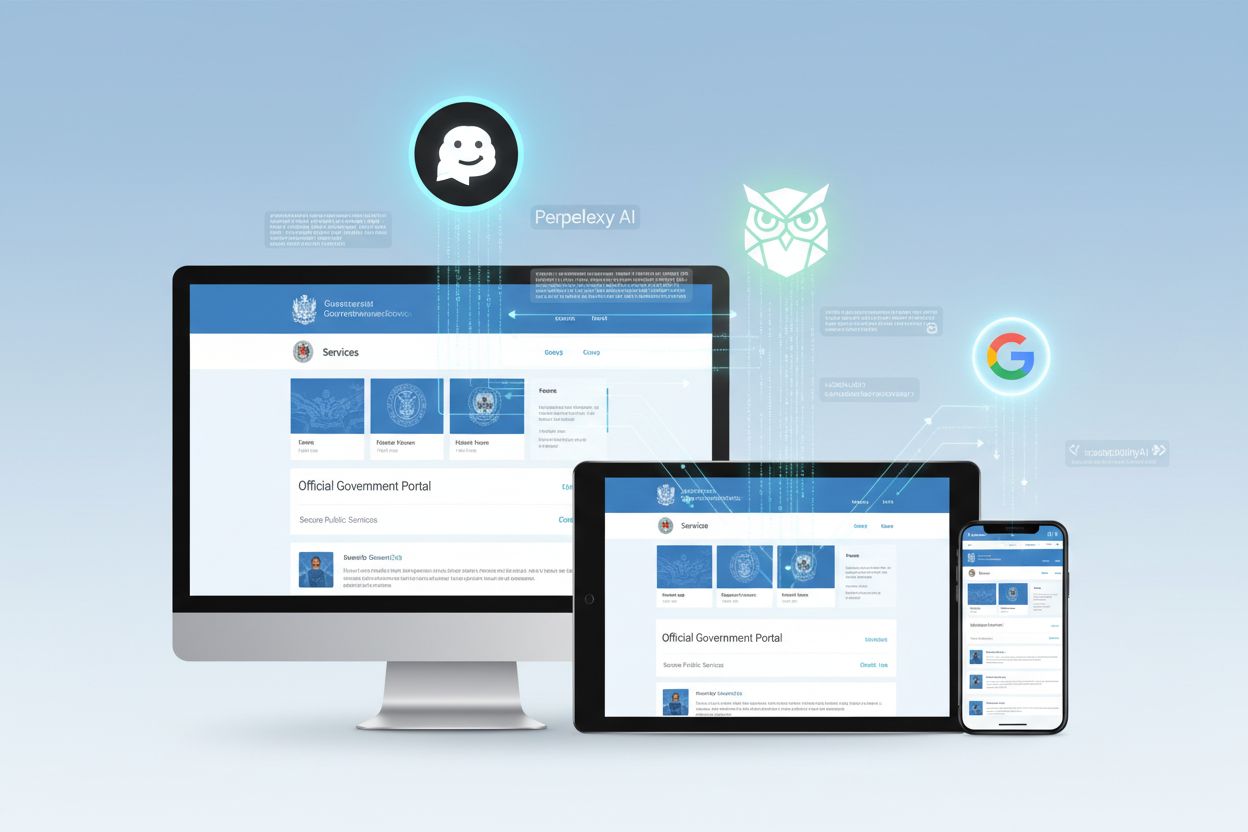

政府AI可见性指的是人工智能系统(包括GPT、Perplexity和Google AI Overviews)在回应公众咨询时,发现、访问和引用政府数据和资源的程度。这种可见性至关重要,因为政府机构掌握着从医疗法规到社会服务等各类权威信息,但大量数据对现代AI系统来说仍然“隐形”。当公民向AI助手询问政府项目、福利或政策时,他们理应获得来自官方渠道的准确、最新答案,而不是过时或不完整的信息。公众对政府的信任取决于AI系统能否正确引用和归属政府数据,从而在日益智能化的信息环境中维护官方信息的完整性。AI透明度成为民主治理的基石,因为公民可以验证AI推荐是否基于合法的政府来源。AmICited.com作为关键的监测平台,跟踪政府数据在各大AI系统中的引用和参考方式,帮助机构了解其在AI生态系统中的可见性和影响力。通过建立对政府AI引用的清晰可见性,公共部门组织能够更好地服务公民,并保持对自身信息的权威。

政府机构依旧面临着由数十年分散IT投资造成的数据孤岛困扰,关键信息被封锁在彼此不兼容的传统系统中,难以与现代AI平台顺畅沟通。这些过时系统主要为传统网页界面和文档管理而设计,无法满足AI系统所需的语义理解和实时数据访问。技术碎片化的代价极其高昂:仅因流程落后、未能通过AI集成而被浪费的经济效益每年约达1400亿美元。除了效率损失,传统系统还带来重大安全隐患,因为政府数据需人工提取并与面向公众的AI系统共享,增加了数据泄露和未经授权访问的风险。挑战进一步加剧在于,许多政府网站缺乏结构化数据、元数据和API基础设施,AI爬虫难以正确索引和理解政府信息。

| 传统政府IT | AI就绪基础设施 |

|---|---|

| 数据库孤立,互操作性差 | 集成数据平台,API和结构化格式 |

| 手工数据提取和共享流程 | 自动化、安全的数据管道 |

| 非结构化文档和PDF | 语义网标准与机器可读格式 |

| 被动安全措施 | 隐私设计与持续监控 |

| 实时数据访问有限 | 实时数据流与动态内容交付 |

相比盲目追求AI技术,成功的政府组织遵循战略性、分阶段的实施路线图,优先考虑规划与组织准备,而非单纯的技术能力。这种方法认识到,公共部门引入AI需要在IT部门、一线员工到公民等多方利益相关者间进行细致协调。

五步实施路线图:

战略机会识别:全面审计政府运作,找出AI可带来显著公共价值的高影响力场景,如缩短申请处理时间、提升服务可及性或加强数据驱动的政策决策。

全面准备:评估现有数据基础设施,识别传统系统集成难题,建立治理框架,在技术部署前提升全员AI素养。

战略试点设计:在特定部门或服务领域开展受控试点,并设定明确成功指标,让团队在低风险环境下应对现实实施中的挑战。

组织变革管理:制定培训计划,回应员工对岗位流失的担忧,建立清晰沟通渠道和反馈机制,确保员工和利益相关者在转型过程中被倾听。

影响评估:确立与政府目标一致的KPI,持续监测AI系统表现,跟踪公民满意度,衡量成本节省,并根据证据调整实施策略。

这种技术次之、组织优先的方法确保AI落地真正服务于公共需求,而不是沦为为找问题而生的昂贵方案。

随着全球政府认识到AI系统在影响公民决策方面的重要性,伦理AI治理已成为必需。加拿大的算法影响评估框架提供了实用模型,将AI系统分为四个影响级别——最低、中等、高和极高——并针对每一层级设定相应的治理要求与监督机制。这种分级方法使政府能按比例分配资源,对刑事司法等高风险系统采取严格审查,而对低影响应用采取合理监管。爱沙尼亚通过其数据追踪系统率先推行隐私设计,对数字基础设施中所有政府数据访问进行监控,为45万公民提供了对哪些机构、因何目的访问其个人信息的完全透明。算法问责制要求政府机构记录AI系统决策过程,建立审计追踪,并能够向受影响公民解释推荐依据。AmICited.com在透明生态中扮演重要角色,监测政府数据在公共AI系统中的引用与参考方式,帮助机构核实其信息是否被准确呈现并得到合理归属。没有强有力的监测和治理框架,政府AI系统有可能损害公众信任,并加剧对弱势群体的不公正偏见。

全球多个政府已证明,经过深思熟虑的战略性AI实施能显著提升公共价值。澳大利亚内政部部署了Targeting 2.0系统,该AI平台提升了边境安全和欺诈检测,最终避免了30亿澳元潜在损失,同时缩短了合法旅客和申请人的处理时间。英国的国家公路聊天机器人则通过处理道路状况与交通事故的日常咨询,释放了人力应对需判断与同理心的复杂紧急事件。爱沙尼亚的Bürokratt平台代表了分布式、GDPR合规的政府AI方式,公民可用AI助手处理常规行政事务,同时严格保护数据隐私,确保敏感决策留给人工。马里兰州的AI治理方法建立了明确的问责结构和定期AI系统审计,成为其他美国州效仿的典范。日本数字厅通过AI成功数字化儿童咨询服务,将等候时间从数周缩短至数小时,同时对需专业干预的案例保持人工监督。这些多元案例表明,政府AI的成功依赖于以公民需求为中心的深思熟虑实施,而非技术本身的复杂度,且要保持透明和对重要决策的人工把控。

随着AI系统逐步成为公民获取信息的主要接口,政府网站的AI可发现性优化已与传统搜索引擎优化同等重要。政府网站需实施结构化数据标记、全面元数据和机器可读格式,使AI爬虫能够理解并正确索引政府信息,确保公民向AI助手咨询政府服务时获得准确权威的答案。目前许多政府网站的信息格式更适合人工阅读——如PDF、非结构化文本和复杂导航层级——AI系统难以解析和理解。REI Systems率先推进联邦网站AI可访问性优化,证明只需相对简单的技术改进即可大幅提升政府在AI响应中的可见性。AmICited.com监测各大平台上的政府AI可见性,帮助机构了解其信息在AI回应中出现的频率,并识别应提升数据可发现性的缺口。政府网站采用正确的语义网标准、API基础设施和可访问性功能后,AI系统更有可能引用官方政府来源,而不是二手资料或过时信息。这种优化不仅保障公民直接从官方渠道获取权威信息,也帮助机构维护自身信息的呈现与解释权。

政府AI影响评估需建立与公共部门目标一致的KPI,超越单纯效率指标,涵盖公民满意度、公平性和民主问责等更广泛衡量标准。爱沙尼亚的评估框架具有实践价值,从时间效率(节省员工时间)、成本效益(投资回报)、创新潜力(是否带来新服务模式)和可衡量影响(公民结果的量化提升)四个维度评估AI举措。系统化评估有助于政府机构识别哪些AI应用带来真正公共价值,哪些需要调整或终止,避免浪费投资于无法服务公民需求的技术。跨机构知识共享加速学习,让一个部门的成功经验可被适配和推广,最大化AI初始投资回报。持续改进与监测体系——如AmICited.com等工具对AI可见性和引用模式的跟踪——让机构可基于真实表现数据而非假设来优化AI系统。积累政府AI实施的有效经验,为可持续、长期 adoption 奠定基础,使其不受领导更迭和预算周期影响。

尽管潜在益处显著,政府机构在采纳AI时面临着远超技术层面的重大障碍。员工关切是重要障碍之一,31%政府员工担心AI影响岗位安全,这需要透明沟通,阐释AI如何辅助而非取代人类。人才短缺进一步加剧挑战,38%政府组织反映难以招聘具备AI实施和维护能力的专家。成本低估也是关键障碍,政府机构常发现AI实际实施费用为预估的5-10倍,导致预算紧张并引发对后续投资的政治阻力。数据隐私和安全问题为最大制约,60%政府领导人认为其是AI采用的首要障碍,这反映了在网络威胁日益增加时代保护公民信息的合理担忧。有效的变革管理策略需通过利益相关方参与、对AI能力与局限的透明沟通、员工培训投入、以及保障公民隐私且促进创新的治理框架,直接应对上述障碍。成功的政府机构通常在变革管理上投入巨大,建立与员工和公民的持续沟通机制,并通过早期可见成果建立AI信心,之后再向更高风险领域扩展。

政府AI可见性是指ChatGPT、Perplexity和Google AI Overviews等AI系统发现和引用政府数据的难易程度。这一点非常重要,因为公民在向AI助手咨询政策、福利和服务时应得到来自官方政府渠道的准确权威信息。如果可见性较差,AI系统可能会提供过时或不完整的信息,而不是引导公民访问官方政府资源。

政府网站应实施结构化数据标记、全面的元数据、机器可读格式及完善的API基础设施。这包括采用语义网标准、确保内容可被AI爬虫访问,并将信息以AI系统易于理解和准确归属官方来源的方式进行组织。

主要障碍包括数据隐私和安全问题(60%的政府领导人提及)、人才短缺(38%)、员工对岗位流失的担忧(31%)、成本低估(实际成本通常为预测的5-10倍)以及数字基础设施不足(45%)。解决这些障碍需要战略规划、变革管理和明确的治理框架。

成功的方法包括建立算法影响评估框架(如加拿大的分级体系)、实施隐私设计原则、为公民创建透明机制以监控数据访问、确立清晰的治理框架,并对重要决策保持人工监督。定期审计及利益相关方参与也很关键。

路线图包括:(1)以公共价值为核心的战略机会识别,(2)全面准备基础设施与治理,(3)具有明确成功指标的战略试点设计,(4)针对员工关切的组织变革管理,(5)通过持续改进的影响评估。该方法强调规划和组织准备优先于技术部署。

政府应建立与公共部门目标一致的KPI,包括时间效率、成本效益、创新潜力及可衡量的公民成果。爱沙尼亚的框架在这四维度对AI系统进行评估。持续监控、利益相关方反馈和透明报告有助于机构识别有效举措并依据证据调整实施策略。

数据治理是政府AI成功的基础。它确保数据质量,建立明确的所有权和访问控制,保护公民隐私,遵守如GDPR等法规,并实现系统间的安全共享。没有强有力的数据治理,政府AI系统将面临数据泄露、偏见和公众信任丧失的风险。

AmICited跟踪政府数据如何在包括ChatGPT、Perplexity和Google AI Overviews在内的主流AI系统中被引用和参考。它帮助政府机构了解其在AI生态系统中的可见性,发现官方信息应更易被发现的空白点,并确保AI系统正确归属政府数据。这种监测支持透明度和问责制。

了解利益相关者最关心的4大AI可见性核心指标:信号率、准确率、引用率和声量份额。掌握品牌AI可见性测量与报告方法。...

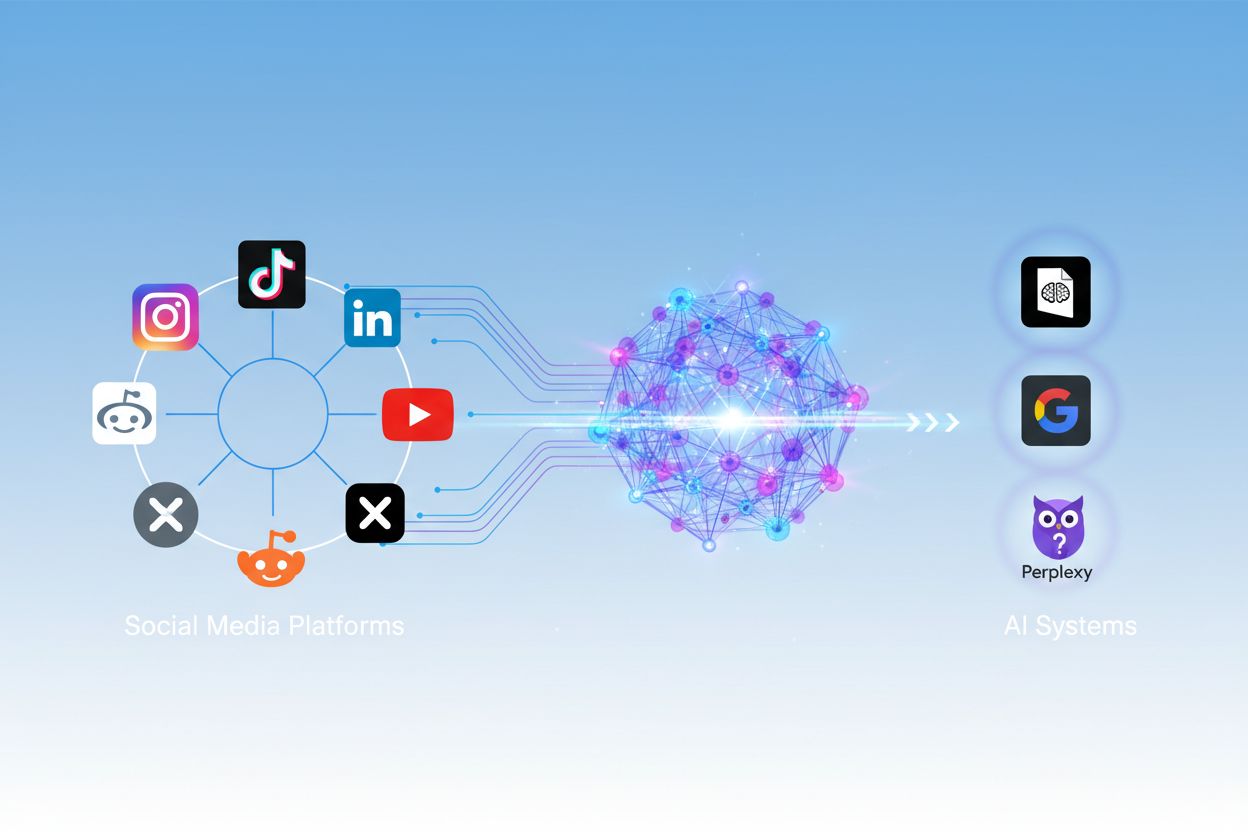

了解如何整合社交媒体与AI可见性战略。发现统一监控工具以及最大化品牌在ChatGPT、Gemini和Perplexity等AI系统中的存在感的最佳实践。...

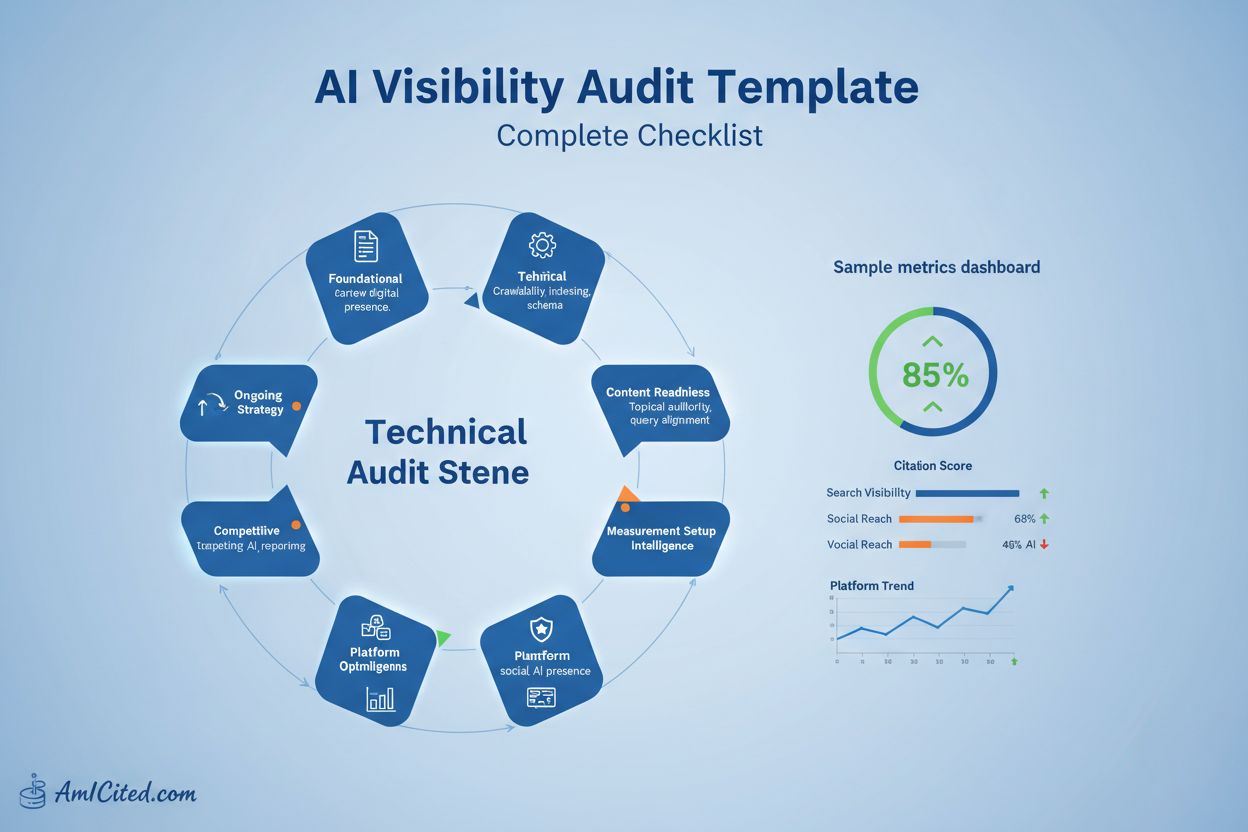

完整的 AI 可见性审计模板和检查清单。审查您的品牌在 ChatGPT、Perplexity、Google AI 概览等平台上的表现。分步指南,配套工具、时间表和可下载资源。...

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.