YMYL(你的金钱,你的生活)

YMYL 内容需要高 E-E-A-T 标准。了解什么是“你的金钱,你的生活”内容、其对 SEO 和 AI 可见性的重要性,以及如何为搜索和 AI 平台优化 YMYL 页面。...

Your Money or Your Life (YMYL,关乎钱财与生命) 内容涵盖直接影响用户福祉的话题,包括健康、金融、安全和公共信息——而医疗健康位于谷歌审查等级的顶端。自2024年3月谷歌核心算法更新后,搜索巨头将低质量内容的可见性降低了40%,表明对不可靠医学信息的前所未有打击。然而,医疗健康机构面临的挑战已根本转变:内容不仅要对搜索引擎可见,还要对大型语言模型(LLM)可见,因为LLM正日益成为健康信息查询者的首选入口。如今5%的谷歌搜索与健康相关,且58%的患者正在使用AI工具获取健康信息,医疗健康服务者面临着关键的可见性鸿沟——他们的内容在传统搜索中排名靠前,却可能在患者真正使用的AI系统里完全“隐形”。这种“双重可见性”要求,是医疗健康内容策略的全新前沿。

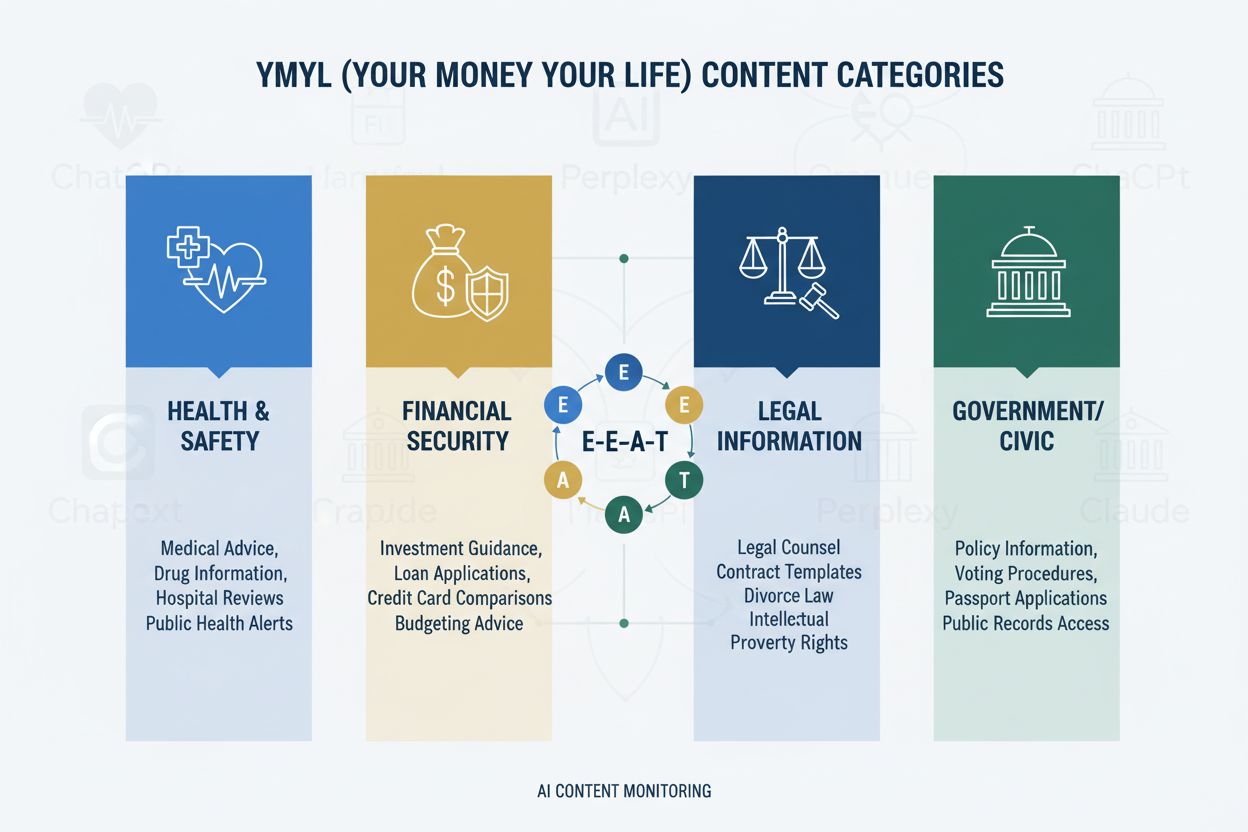

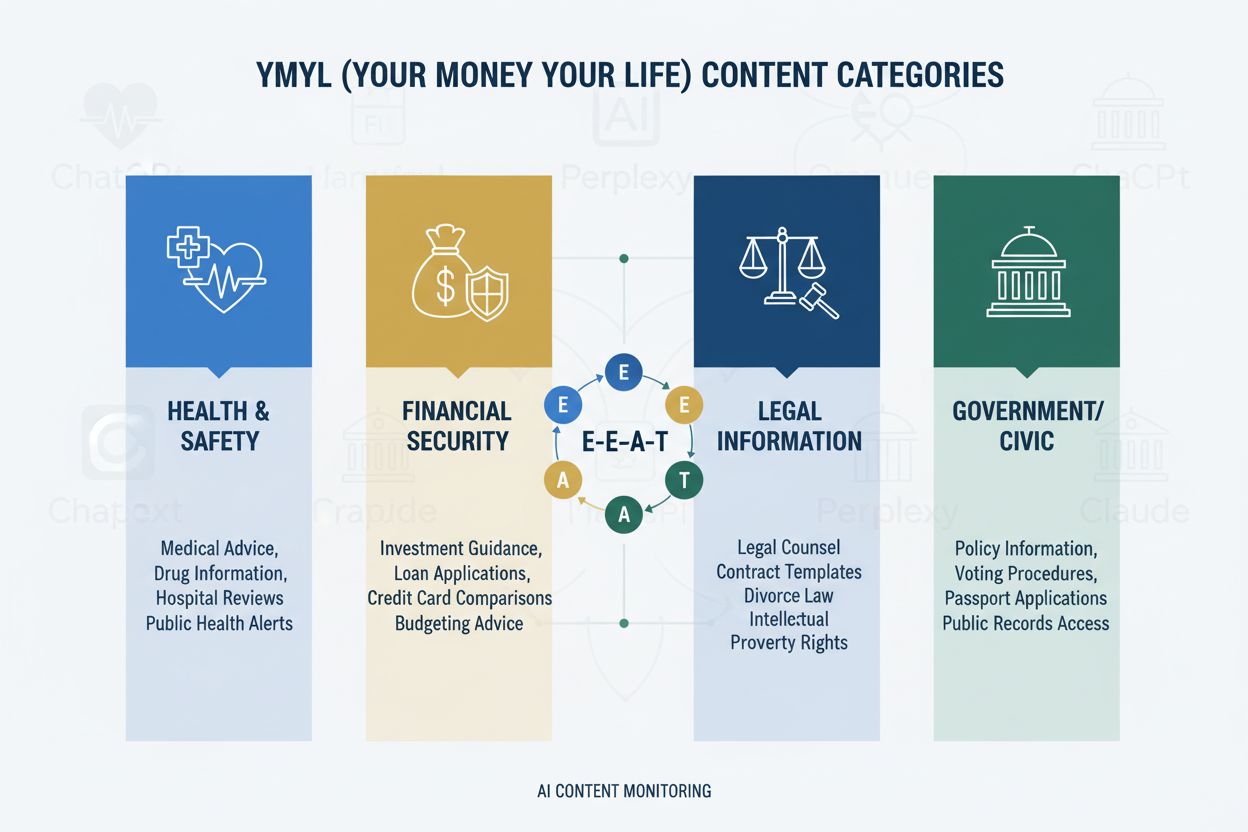

YMYL框架将内容分为四大关键领域:健康(疾病、治疗、健康管理)、金融(投资建议、财务规划)、安全(应急措施、安全保障)和公共事务(选举、法律事项)——其中医疗健康因直接影响人类福祉而获最高审查等级。谷歌的E-E-A-T框架(经验、专业性、权威性与可信度)则作为评估标准,要求医疗健康内容展现真正的医学知识、专业资质及可验证的准确性。质量评估指南明确强调,医疗健康内容必须由合格医学专家创作或审核,并需清晰展示作者资质及机构背书。医疗健康机构必须理解,E-E-A-T不是可选项——它是搜索可见性和LLM收录的基础要求。下表为YMYL各类别影响力层级:

| YMYL类别 | 影响等级 | 审查强度 | 与医疗健康相关性 |

|---|---|---|---|

| 健康 | 极高 | 最高 | 直接关系患者安全 |

| 金融 | 高 | 高 | 保险、费用 |

| 安全 | 高 | 高 | 紧急应对 |

| 公共事务 | 中 | 中 | 卫生政策 |

尽管LLM技术先进,但在处理医学信息时错误率惊人,斯坦福HAI研究记录到医疗健康领域回答中30-50%为无依据陈述。即使是带检索增强(RAG)的GPT-4,在用权威来源训练后,仍有50%的回答存在无依据主张——这种“幻觉”现象可能表现为推荐不存在的医疗设备、给出错误的治疗方案,或捏造药物相互作用。曾有知名案例,Men’s Journal发布的AI生成文章包含18项具体医学错误,其中不乏可能危害读者的危险治疗建议。根本问题在于AI缺乏“经验”——即区别于统计模式匹配系统的临床第一手知识。若没有结构良好、权威专家认证的内容,LLM会自信地生成似是而非但潜在危险的医学建议。

AI Overviews及类似LLM驱动的答案系统,以直接回答的方式改变了患者获取健康信息的方式,用户无需访问网站,传统驱动医疗健康网站流量的点击彻底消失。内容可见性如今取决于是否被AI回答引用,而非排名位置——医疗健康提供者的文章可能被AI综合进答案却从未获得流量或署名。LLM会同时综合多来源信息,构建出网站间争夺AI摘要“入选”权的新信息架构,而非搜索排名榜首。医疗健康服务者必须认识到模型份额(SOM)——即AI回答中引用自己内容的比例——已成为关键可见性指标,取代了传统点击率。这一范式转变要求彻底重构内容策略:不再单纯追求点击,而是优化被引用的质量、准确性和结构清晰度,令内容成为LLM优选的数据源。

LLM最善于处理的医学内容需层次分明的结构,符合临床决策流程:疾病定义→症状表现→诊断标准→治疗方案→预后。递进式结构——先讲简单再讲复杂——有助于LLM构建准确的知识模型,避免混淆相似但不同的疾病。问题导向内容设计(如“什么是X疾病?”优先于“如何治疗?”)符合LLM从多文档检索和综合信息的过程。语义丰富度与概念互联——明确关联疾病、治疗与风险因素——帮助LLM理解原本隐性的关系。应用Schema.org医学标注(MedicalCondition, MedicalProcedure, MedicalTreatment)可为LLM提供可靠解析和引用的数据结构。模仿专家解说的自然语言——既保留医学术语,又确保通俗易懂——可同时向LLM和读者传递权威信号。医疗健康机构应对现有内容进行结构审查,传统SEO内容往往缺乏LLM准确综合所需的层级清晰与语义丰富。

多平台布局可极大增强权威信号,单一网站难以做到,因为LLM会识别多个权威渠道展现的专业一致性。医学问答平台如HealthTap和Figure 1提供医生与患者直接互动,带有认证资质和实时参与,LLM据此判定真实专业能力。专业网络如Doximity及医学LinkedIn社群,体现同行认可和职业地位,LLM在权威评估时高度加权。医学维基百科等协作知识库,表明愿意无商业动机地贡献医学知识,是LLM认可的重要信任信号。详尽的作者资质页——包括执业认证、出版物、临床经验和机构隶属——应在主站点展示,并在各平台间保持一致链接。跨平台一致性(资质、专长与临床观点)强化可信度;不同平台间的矛盾会引发LLM的怀疑。医疗健康机构应制定多平台权威建设策略,视所有平台为相互强化的信号源,确保医生专业能力在整个数字生态系统中清晰可见、易于验证。

传统医疗健康分析——如有机流量、点击率、排名追踪——完全忽略了AI可见性问题,让内容在传统指标下看似成功,实则在LLM中“隐形”,形成危险盲区。模型份额(SOM)成为关键新指标,衡量AI关于某一疾病的回答中,有多少引用了贵机构内容。有效监测需跨多LLM平台(ChatGPT、Claude、Perplexity及新兴竞品)系统化测试,用本专业一致的问题,统计引用频率及回答中的引用位置。引用质量与频率同等重要——作为主参考源被引用,权重远高于被列为次要参考,而且LLM能区分被引用的专业性与泛泛信息。监测工具既有手动测试(运行问题并记录结果),也有自动化平台,可追踪SOM随时间变化并预警可见性波动。间接指标如品牌搜索量、患者反馈提及AI推荐、来自AI平台的转诊模式等,亦可辅助验证SOM趋势。医疗健康机构应立即建立SOM基线,因竞争格局正在迅速变化,早期可见性优势将持续累积。

医疗健康机构应先从单一专科领域试点,而非一开始全面转型,这样团队可积累经验、完善流程后再扩展。以LLM视角开展内容审查,需评估现有文章的结构清晰度、语义丰富性、问题导向架构与作者资质,经常发现原本高排名内容缺乏LLM所需结构。跨AI平台可见性测试,用专科特定问题建立SOM基线,识别哪些疾病与治疗目前可见、哪些“隐形”。问题导向架构的实施,包括重构或新建内容,优先回答患者关心的问题(“我为何有此症状?”),再做临床解释。医生个人资质页应为每位贡献者建立,包括执业认证、专业方向、发表作品与临床经历,并在所有署名内容中保持一致链接。疾病内容聚类——围绕症状、诊断、治疗方案、预后等互联内容——帮助LLM理解完整疾病信息,避免内容零散。分阶段推进,便于医疗健康机构衡量成效、优化策略、积累内生能力后再推广至更多专科。

HIPAA合规始终至关重要,即使内容被LLM收录,患者隐私保护同样适用,无论信息由搜索引擎还是AI系统访问,病例示例须彻底匿名及去标识化。医学免责声明与准确性要求必须明确且突出,清晰说明AI综合信息不能取代专业医疗咨询,个人情况可能与通用建议不同。事实核查与来源引用成为合规关键,医疗健康机构需对所发布信息负责,LLM会将错误信息放大至成千上万次用户互动。AI生成医学内容的监管审查日益严格,FDA和FTC开始重点关注AI系统如何呈现医学信息;医疗健康机构必须确保所有内容(无论人工撰写还是AI辅助)都符合监管标准。必须由合格医生进行人工医学审核,并有明确的审核流程,体现对准确性与安全性的重视。责任考量不仅限于传统医疗差错,还包括LLM综合并呈现给患者的信息引发的潜在责任;医疗健康机构应咨询法律顾问,明确内容在AI系统中的使用责任。合规与安全在追求AI可见性过程中绝不能沦为次要。

AI将在加速中持续重塑医疗健康信息发现,LLM在医学推理能力日益增强,正逐步成为患者研究健康状况的核心工具。现在调整内容策略的医疗健康机构,将在新生态中树立可信地位,迟疑者则将被患者实际使用的AI系统“屏蔽隐形”。先行者优势显著,通过权威信号积累、更高的模型份额和AI回答中的持续曝光赢得患者信任——这些优势随LLM识别与优先可靠来源的能力提升而持续放大。传统SEO与LLM优化的整合不是二选一,而是互补策略,因搜索引擎也在加速融合LLM技术,患者依然会使用多种信息渠道。长期可持续发展依赖于真实专业能力,而非优化技巧;那些投资于真实医学知识、透明资质和准确信息的医疗健康机构,无论信息发现机制如何变化都将拥有一席之地。医疗健康内容格局已彻底转变,能将这一转型视为机遇而非威胁的机构,将定义未来患者健康信息的发现之路。

YMYL(Your Money Your Life,关乎钱财与生命)指的是可能显著影响人们健康、财务稳定或安全的内容。医疗健康是最高级别审查的类别,因为医学错误信息可能导致严重伤害甚至死亡。谷歌对YMYL内容应用更严格的算法标准,而患者越来越多地使用LLM查询健康信息,使YMYL合规成为可见性的关键。

LLM会从多个来源综合信息,直接给出答案,而搜索引擎只是对各页面进行排名。医疗健康内容现在不仅要为谷歌排名,还需为AI系统结构化,便于被引用。这意味着您的内容可能通过AI回答教育成千上万人,但不会获得直接网站流量,这需要完全不同的优化思路。

E-E-A-T代表经验(Experience)、专业性(Expertise)、权威性(Authoritativeness)及可信度(Trustworthiness)。医疗健康内容需要最高的E-E-A-T标准,强调第一手医学经验和经过验证的资历。谷歌的质量评估指南提及E-E-A-T多达137次,反映其在搜索和LLM系统中提升医疗健康内容可见性的重要性。

研究显示,AI在医疗健康领域中有30-50%的陈述缺乏支持,且会出现“幻觉”现象。AI缺乏实际医学经验,无法与现行医学标准进行比对验证。因此,人类医学审核和专家署名依然不可或缺——AI应辅助医疗专业人员,而非取代他们。

可以用本专业常见患者问题在ChatGPT、Claude和Perplexity等平台测试内容。追踪模型份额(SOM)指标——被AI回答引用您内容的百分比。AmICited.com可自动监测这一过程,实时展示您的医疗品牌在多平台LLM中的展现情况。

传统SEO着重于针对关键词排名页面。LLM优化强调内容覆盖的全面性、语义丰富性和良好的结构化,便于AI系统理解和引用。两者互为补充——医疗健康机构需整合策略,同时优化搜索引擎和LLM的表现。

AI只能作为辅助医学专家的工具,不能取而代之。所有医疗健康内容在发布前必须由合格医学专家审核和批准。医学内容所涉及的风险极高,不能仅依赖AI生成,必须有专家监督和核查。

AmICited.com可监测医疗品牌和医学内容在ChatGPT、Perplexity、Google AI Overviews等LLM平台中的AI回答呈现情况。它提供可见性指标,追踪模型份额(SOM),并给出优化建议,帮助医疗健康机构确保其专业知识能被AI驱动的患者检索到。

YMYL 内容需要高 E-E-A-T 标准。了解什么是“你的金钱,你的生活”内容、其对 SEO 和 AI 可见性的重要性,以及如何为搜索和 AI 平台优化 YMYL 页面。...

了解如何为 ChatGPT、Perplexity 和 Google AI Overviews 等 AI 搜索引擎优化你的 Your Money or Your Life (YMYL) 内容。掌握 E-E-A-T 信号、内容准确性和 AI 可见性策略。...

了解什么是 AI 搜索中的 YMYL 主题,它们如何影响你的品牌在 ChatGPT、Perplexity 和 Google AI Overviews 中的可见性,以及为何监测这些主题对你的域名至关重要。...

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.