AI 的 JavaScript 渲染

了解 JavaScript 渲染如何影响 AI 可见性。发现 AI 爬虫为何无法执行 JavaScript,哪些内容会被隐藏,以及预渲染解决方案如何确保你的内容出现在 ChatGPT、Perplexity 及其他 AI 搜索结果中。...

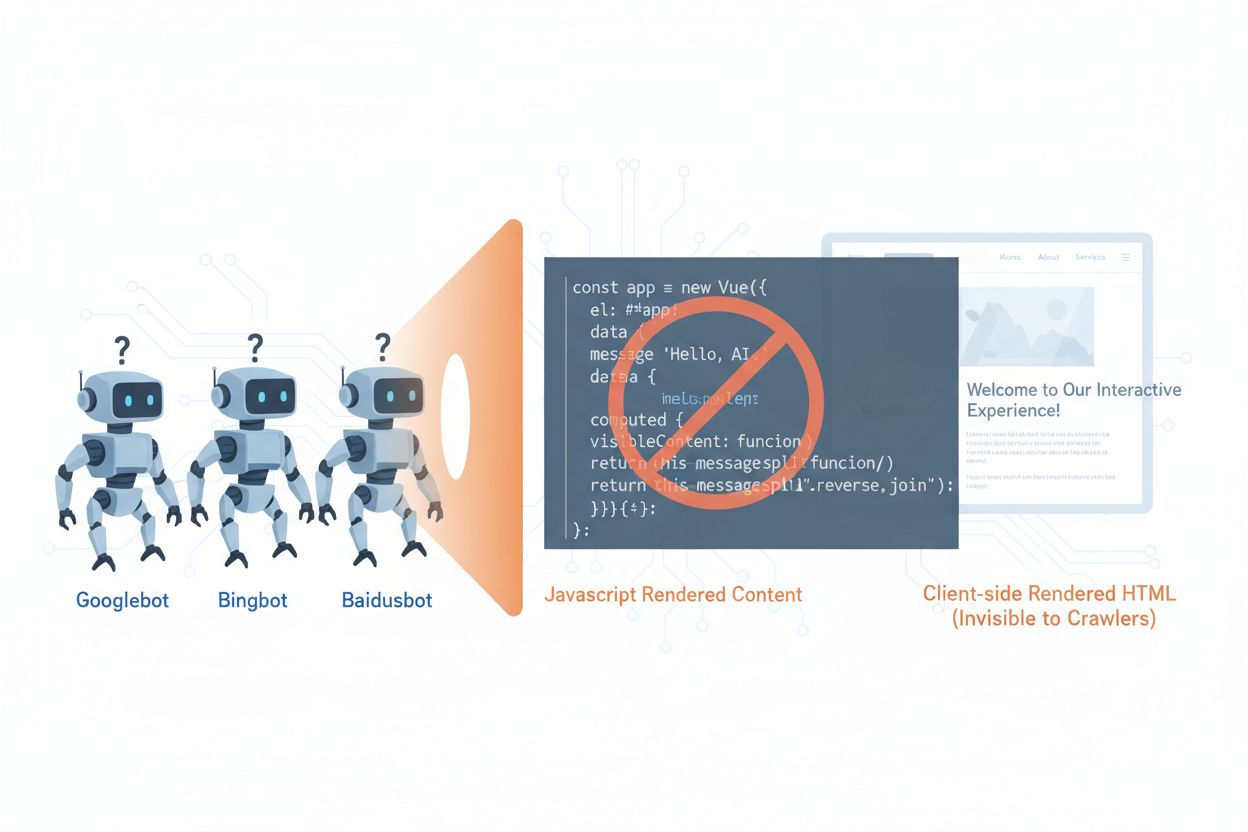

AI爬虫如GPTBot、ClaudeBot和PerplexityBot,彻底改变了网络内容的发现与索引方式,但它们面临一个关键限制:无法执行JavaScript。这意味着所有通过JavaScript动态渲染的内容——如现代单页应用(SPA)、动态产品页和交互式仪表盘——对这些爬虫来说完全不可见。最新数据显示,AI爬虫目前大约占到谷歌爬虫流量的28%,已成为您网站抓取预算的重要组成部分,也是内容可访问性的关键因素。当AI爬虫请求页面时,它们只会收到初始HTML外壳,而看不到渲染后的内容,相当于看到的是一个空白或不完整的站点版本。这造成了一个悖论:您的内容对启用JavaScript的真实用户完全可见,但对那些日益主导内容发现、摘要和排名的AI系统却是不可见的。

AI爬虫在JavaScript执行上的局限,源自浏览器与爬虫处理网页内容的根本架构差异。浏览器拥有完整的JavaScript引擎,可执行代码、操作DOM(文档对象模型)并渲染最终视觉效果;而AI爬虫通常由于资源和安全原因,基本不具备JavaScript执行能力。异步加载——即内容在初次页面加载后通过API获取——是另一大挑战,因为爬虫只收到初始HTML,内容尚未到达。**单页应用(SPA)**进一步加剧了这一问题,它们完全依赖客户端路由和渲染,爬虫收到的仅是JavaScript包。下面对比不同渲染方式在AI爬虫可见性方面的表现:

| 渲染方式 | 工作原理 | AI爬虫可见性 | 性能 | 成本 |

|---|---|---|---|---|

| CSR(客户端渲染) | 浏览器执行JavaScript渲染内容 | ❌ 差 | 用户体验快 | 基础设施低 |

| SSR(服务器端渲染) | 服务器在每次请求时渲染HTML | ✅ 优秀 | 首次加载慢 | 基础设施高 |

| SSG(静态站点生成) | 构建时预生成内容 | ✅ 优秀 | 最快 | 中等(构建时) |

| 预渲染 | 按需缓存静态HTML | ✅ 优秀 | 快 | 中等(平衡) |

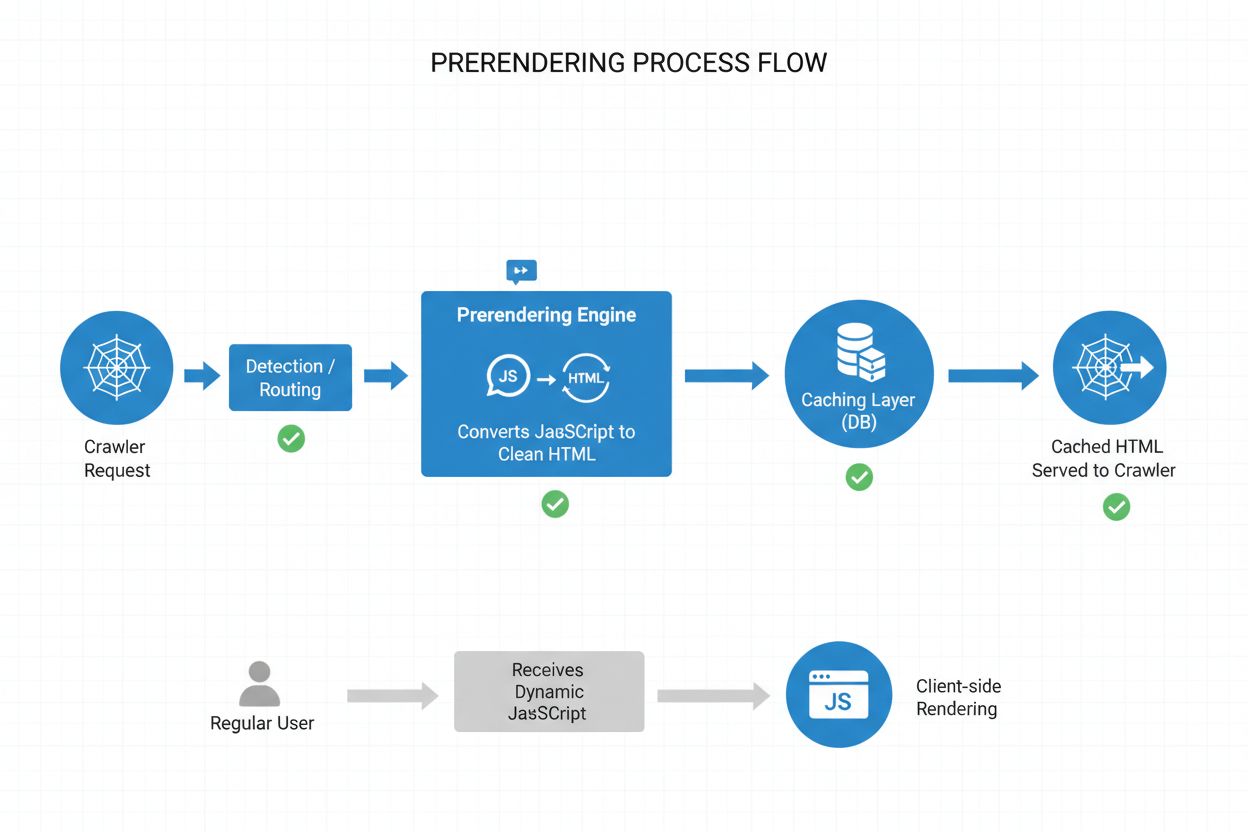

预渲染在高成本服务器端渲染与构建时静态生成之间,提供了优雅的中间方案。它不是在每个请求(SSR)或构建时(SSG)渲染页面,而是在爬虫或机器人请求页面时按需生成静态HTML快照,并缓存渲染结果。这样,AI爬虫收到的是包含全部内容的静态HTML,而普通用户则继续获得动态、交互式的网站体验,彼此互不影响。预渲染极具成本效益,因为它仅为实际被爬虫请求的页面渲染,避免了全站预渲染或维护昂贵SSR基础设施的开销。维护负担极低——您的应用代码无需更改,预渲染层在后台透明运行,非常适合希望提升AI爬虫可访问性但又不想大改架构的团队。

预渲染流程通过一套精巧但直接的机制,确保AI爬虫能获取优化内容,而用户体验不受影响。当请求到达服务器时,系统会检测User-Agent,判断是AI爬虫(GPTBot、ClaudeBot、PerplexityBot)还是普通浏览器。如果是AI爬虫,则路由到预渲染引擎,该引擎启动无头浏览器实例,执行所有JavaScript,等待异步内容加载,并生成完整静态HTML快照。这个HTML随后被缓存(通常24-48小时),直接返回给爬虫,完全绕过应用本身并减少服务器负载。与此同时,普通浏览器请求会直接绕过预渲染层,获取动态应用,确保用户获得实时更新和动态功能的完整交互体验。整个过程对用户和爬虫都是透明的——爬虫看到完整渲染内容,用户端体验无变化,基础设施高效,因为预渲染只针对爬虫流量激活。

虽然预渲染和服务器端渲染(SSR)都能解决JavaScript可见性问题,但二者在实现、成本和可扩展性上有显著区别。SSR每次请求都渲染内容,服务器需启动JavaScript运行环境,执行全部应用代码,并为每位访客生成HTML——大量访问时成本高昂,还会导致所有用户的首字节时间(TTFB)上升。相比之下,预渲染缓存渲染页面,仅在内容变更或缓存失效时重新生成,大幅减轻服务器负载,提升爬虫和用户的响应速度。SSR适用于高度个性化或频繁变化的数据场景,每位用户都需独特HTML;而预渲染则更适合内容相对静态或更新不频繁的页面——如产品页、博客、文档及营销内容。许多高级实现采用混合模式:AI爬虫和静态内容走预渲染,个性化用户体验用SSR,交互功能用客户端渲染。这样既保证AI爬虫可访问性,又兼顾用户性能和基础设施成本。

结构化数据(JSON-LD格式)对于帮助AI爬虫理解内容含义和上下文至关重要,但很多实现未考虑AI爬虫的局限。如果结构化数据通过JavaScript注入页面(如Google Tag Manager等标签管理器常见做法),AI爬虫因无法执行JavaScript,压根看不到这些数据结构。结果就是丰富摘要、产品信息、组织详情等语义标记对AI系统不可见,尽管传统搜索引擎已能处理JavaScript。解决方法很简单:保证所有关键结构化数据都直接出现在服务器渲染的HTML中,而不是通过JavaScript注入。这可能意味着将JSON-LD代码从标签管理器移到应用服务器模板,或用预渲染捕获JavaScript注入的结构化数据,并作为静态HTML提供给爬虫。AI爬虫极度依赖结构化数据来提取事实、关系和实体信息,因此服务端结构化数据的实现对于AI搜索引擎和知识图谱集成至关重要。

实施预渲染需要在覆盖范围、成本和维护之间做好平衡。建议按以下步骤进行:

有效监控是确保预渲染正常运作、AI爬虫能顺利访问内容的关键。日志分析是核心工具——检查服务器日志,识别AI爬虫User-Agent的请求,跟踪它们访问了哪些页面,了解抓取行为及错误模式。大多数如Prerender.io的预渲染服务都提供仪表盘,显示缓存命中率、渲染成功/失败率和性能数据,让您清晰了解预渲染内容的服务效果。关键指标包括:缓存命中率(缓存响应占比)、渲染成功率(页面无错误渲染占比)、平均渲染时长和爬虫流量。为渲染失败或异常抓取模式设置告警,及时发现页面JavaScript或动态内容的问题。将预渲染指标与AI搜索引擎流量及内容可见性结合分析,可以量化预渲染的实际效果,并持续优化。

想让预渲染长期有效,需关注细节并持续维护。避免以下常见陷阱:

随着AI爬虫日益成为内容发现和知识提取的核心,优化其可访问性的重要性也将持续提升。虽然当前AI爬虫的JavaScript执行能力有限,但诸如Comet和Atlas浏览器等新技术表明,未来爬虫渲染能力会增强,预渲染依然因其性能和可靠性受到青睐。现在实施预渲染,不仅能解决当前AI爬虫难题,还是内容未来适配的保障,确保无论AI系统如何演进,您的站点始终可访问。传统SEO与AI爬虫优化的融合,意味着要抢占先机,必须兼顾人类与AI用户,内容多格式可访问,并保有灵活适应变革的能力。预渲染作为一种务实、可扩展的解决方案,有效弥合了现代JavaScript应用与AI搜索、发现系统的可访问性鸿沟,是任何前瞻性SEO与内容策略的必备组件。

预渲染按需生成静态HTML快照并进行缓存,而服务器端渲染(SSR)则在每一次请求时都渲染内容。对于大多数应用场景,预渲染更具成本效益且易于扩展,而SSR更适用于需要为每位用户生成独特HTML的高度个性化或频繁变化的内容。

不会,预渲染只影响爬虫如何查看您的内容。普通用户仍然会像以前一样获得动态、交互式的JavaScript应用。预渲染在后台透明运行,对用户端功能和性能没有任何影响。

缓存过期时间取决于您的内容更新频率。高流量且频繁更新的页面可能需要12-24小时的缓存窗口,而静态内容可以设置更长的时长。大多数预渲染服务允许您为每个页面或模板单独配置缓存时间。

可以,预渲染非常适合动态内容。您可以为频繁变化的页面设置较短的缓存过期时间,或实现缓存失效策略,在内容更新时刷新预渲染页面,从而确保爬虫看到的是相对新鲜的内容。

主要需要优化的AI爬虫有GPTBot(ChatGPT)、ClaudeBot(Claude)和PerplexityBot(Perplexity)。您还应继续针对传统爬虫如Googlebot和Bingbot进行优化。大多数预渲染服务都支持为所有主流AI与搜索爬虫进行配置。

如果您已经在使用SSR,那么AI爬虫已经能够较好地访问您的内容。不过,预渲染依然可以通过减少服务器负载、提升性能和提供缓存层,使您的基础设施更高效、可扩展。

监控您的预渲染服务仪表盘,关注缓存命中率、渲染成功率和性能指标。检查服务器日志中AI爬虫的请求,确认其收到的是完整渲染的HTML。跟踪AI搜索可见性和内容引用的变化趋势。

预渲染的成本因服务和使用量而异。大多数服务商按每月渲染页面数量提供分级定价。与维护服务器端渲染基础设施相比,预渲染的成本通常低得多,是大多数网站性价比很高的解决方案。

了解 JavaScript 渲染如何影响 AI 可见性。发现 AI 爬虫为何无法执行 JavaScript,哪些内容会被隐藏,以及预渲染解决方案如何确保你的内容出现在 ChatGPT、Perplexity 及其他 AI 搜索结果中。...

了解 JavaScript 如何影响 AI 爬虫可见性。发现为什么 AI 机器人无法渲染 JavaScript、哪些内容会被隐藏,以及如何优化你的网站以适应传统搜索和 AI 平台。...

了解如何让 ChatGPT、Perplexity 以及谷歌 AI 等 AI 爬虫能够看到你的内容。发现针对 AI 搜索可见性的技术要求、最佳实践以及监控策略。...