差异化爬虫访问

了解如何根据业务目标有选择地允许或屏蔽AI爬虫。实施差异化爬虫访问,在保护内容的同时保持在AI系统中的可见性。为出版商管理GPTBot、ClaudeBot及其他AI爬虫提供战略指南。...

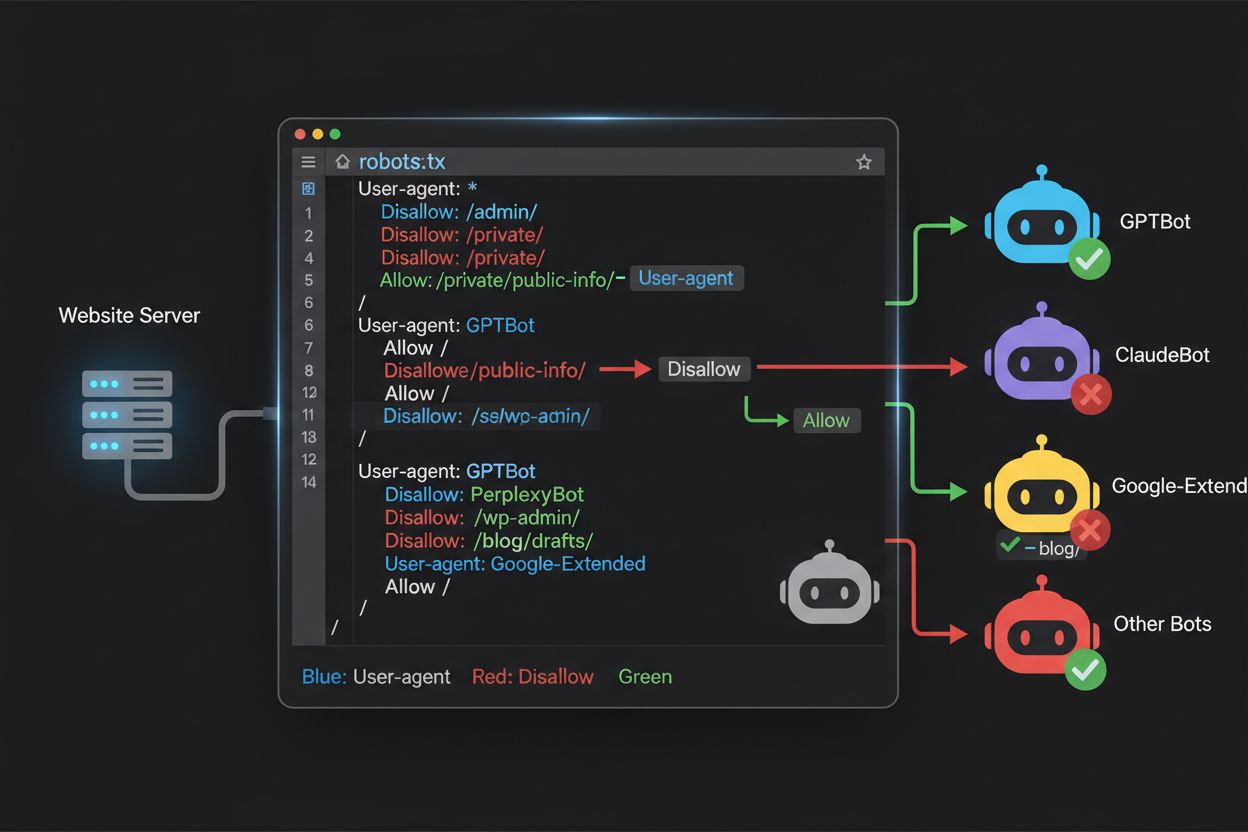

了解如何使用robots.txt控制哪些AI机器人访问您的内容。完整指南,涵盖如何屏蔽GPTBot、ClaudeBot及其他AI爬虫的实用案例与配置策略。

过去两年,网络爬虫的格局发生了根本性变化,从传统的搜索引擎索引扩展到了复杂的AI模型训练领域。Google的Googlebot长期以来一直是出版网站的常客,如今新一代爬虫却带着截然不同的目的和内容消耗模式而来。OpenAI的GPTBot的爬取与引用比例大约为1,700:1,意味着它爬取1,700个页面仅带来一次回流;而Anthropic的ClaudeBot则更极端,达到73,000:1——与Google的14:1(爬取行为能带来实际流量)形成鲜明对比。这种根本差异让内容创作者必须做出紧迫的商业决策:允许这些机器人无限制地访问,意味着您的内容会被用来训练与您流量和收入直接竞争的AI模型,而您的站点几乎得不到任何回报或流量。出版方如今需要主动决定,AI机器人访问带来的价值主张是否符合自身商业模式,使robots.txt配置从技术层面上升为战略性业务议题。

AI爬虫可分为三大类,各自用途不同,屏蔽策略也应有区别。训练型爬虫旨在大量吞吐内容以训练基础AI模型——包括OpenAI的GPTBot、Anthropic的ClaudeBot、Google的Google-Extended、Perplexity的PerplexityBot、Meta的Meta-ExternalAgent、Apple的Applebot-Extended,以及如Amazonbot、Bytespider、cohere-ai等新兴玩家。搜索型爬虫则用于AI驱动的搜索体验,通常会为出版方带来流量回访;代表有OpenAI的OAI-SearchBot、Anthropic的Claude-Web、Perplexity的搜索功能。用户触发型代理则是在用户主动请求信息时按需访问内容,如用户直接在ChatGPT-User或Claude-Web发起的交互。理解这一分类至关重要,因为您的屏蔽策略应反映业务优先级——您可能欢迎能带来流量的搜索爬虫,同时屏蔽无偿消耗内容的训练爬虫。每家AI公司都有自己的专用爬虫队列,区别往往体现在User-Agent字符串,准确识别和针对性屏蔽是高效robots.txt配置的关键。

| 公司 | 训练型爬虫 | 搜索型爬虫 | 用户触发型代理 |

|---|---|---|---|

| OpenAI | GPTBot | OAI-SearchBot | ChatGPT-User |

| Anthropic | ClaudeBot, anthropic-ai | Claude-Web | claude-web |

| Google-Extended | — | (使用标准Googlebot) | |

| Perplexity | PerplexityBot | PerplexityBot | Perplexity-User |

| Meta | Meta-ExternalAgent | — | Meta-ExternalFetcher |

| Apple | Applebot-Extended | — | Applebot |

维护一份准确、最新的AI机器人User-Agent列表对于高效robots.txt配置至关重要,而这一领域变化极快,新模型不断推出、各公司也会调整爬虫策略。主要的训练型爬虫包括GPTBot(OpenAI主力训练爬虫)、ClaudeBot(Anthropic训练爬虫)、anthropic-ai(Anthropic备用标识)、Google-Extended(Google AI训练标识)、PerplexityBot(Perplexity爬虫)、Meta-ExternalAgent(Meta训练爬虫)、Applebot-Extended(Apple AI训练版)、CCBot(Common Crawl爬虫)、Amazonbot(Amazon爬虫)、Bytespider(字节跳动爬虫)、cohere-ai(Cohere训练爬虫)、DuckAssistBot(DuckDuckGo AI助手爬虫)、YouBot(You.com爬虫)。以流量回访为目的的搜索型爬虫通常有OAI-SearchBot、Claude-Web及PerplexityBot的搜索模式。难点在于,这份名单不是静态的——新AI公司不断涌现,现有公司针对新品推出新爬虫,User-Agent字符串也偶有变更或扩展。出版方应将robots.txt视为需要季度复查和更新的“活文件”,可考虑订阅行业追踪资源或通过服务器日志监控陌生的User-Agent,以便及时发现新AI爬虫。User-Agent列表若不及时更新,可能导致新训练爬虫漏网,或者误封本应引流的合法搜索爬虫。

robots.txt文件位于域名根目录(yourdomain.com/robots.txt),通过简单明了的语法向遵守该协议的机器人声明爬取偏好。每条规则以User-Agent指令开头,指定适用的爬虫,随后是一条或多条Disallow指令,指明该爬虫禁止访问的路径。要屏蔽所有主流AI训练型爬虫,同时保留传统搜索引擎的访问权限,需为每个要屏蔽的训练型爬虫(如GPTBot、ClaudeBot、anthropic-ai、Google-Extended、PerplexityBot、Meta-ExternalAgent、Applebot-Extended等)单独建立User-Agent片段,并加上"Disallow: /",使其无法访问站点内容。同时,确保如Googlebot、Bingbot及OAI-SearchBot等搜索型爬虫未被屏蔽,以便继续索引您的内容并带来流量。合理配置的robots.txt还应包含Sitemap指向您的XML站点地图,帮助搜索引擎高效发现并索引内容。配置准确性极为重要——任何语法错误、字符遗漏或User-Agent写错都可能让您的防护策略失效,导致敏感内容被爬取或流量来源被误封。部署前务必测试验证,确保robots.txt真正发挥应有作用。

# 屏蔽AI训练爬虫

User-agent: GPTBot

Disallow: /

User-agent: ClaudeBot

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Google-Extended

Disallow: /

User-agent: PerplexityBot

Disallow: /

User-agent: Meta-ExternalAgent

Disallow: /

User-agent: Applebot-Extended

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: Amazonbot

Disallow: /

User-agent: Bytespider

Disallow: /

User-agent: cohere-ai

Disallow: /

User-agent: DuckAssistBot

Disallow: /

User-agent: YouBot

Disallow: /

# 允许传统搜索引擎

User-agent: Googlebot

Allow: /

User-agent: Bingbot

Allow: /

# 站点地图

Sitemap: https://yoursite.com/sitemap.xml

许多出版方面临一个微妙的选择:既希望在AI搜索结果中保持可见、获得流量回访,又不想内容被用来训练与自己业务竞争的AI基础模型。这需要区分同一家公司的搜索型爬虫和训练型爬虫——例如允许OpenAI的OAI-SearchBot(为ChatGPT搜索功能提供流量)但屏蔽GPTBot(用于底层模型训练);同样地,可以允许PerplexityBot的搜索爬虫,屏蔽其训练行为,或者允许Claude-Web进行用户触发搜索,同时屏蔽ClaudeBot的训练活动。业务动因非常明确:搜索型爬虫的爬取与回流比通常很低,因为它们设计为向您的网站输送流量,而训练型爬虫则大规模消耗内容,几乎无回报。此策略需要精心配置和持续监控,因为各公司偶尔会调整爬虫策略或推出新的User-Agent,模糊搜索与训练的界限。采用该策略的出版方应定期审查服务器日志,核实目标爬虫确实能访问内容,被屏蔽的爬虫被有效拦截,并随着AI生态变化及时调整robots.txt配置。

# 允许AI搜索爬虫

User-agent: OAI-SearchBot

Allow: /

User-agent: Perplexity-User

Allow: /

User-agent: ChatGPT-User

Allow: /

# 屏蔽训练爬虫

User-agent: GPTBot

Disallow: /

User-agent: ClaudeBot

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Google-Extended

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: Meta-ExternalAgent

Disallow: /

即使是经验丰富的网站管理员,也常因配置失误而让robots.txt策略功亏一篑,使内容暴露于原本想要屏蔽的爬虫。第一类常见错误是写了单独的User-Agent行却没有随后的Disallow指令——如只写"User-Agent: GPTBot"后直接进入下一个规则,没有指定GPTBot禁止访问的路径,实际等于未屏蔽任何内容。第二类错误是文件位置、命名或大小写不正确;文件必须命名为小写"robots.txt",放在域名根目录,并以200状态码返回——放在子目录或命名为"Robots.txt"/“robots.TXT"都无法被爬虫识别。第三类错误是在规则块中插入空行,许多robots.txt解析器会将其视为规则结束,导致后续指令被忽略或错误应用。第四类错误是路径大小写敏感;User-Agent名称不区分大小写,但Disallow路径区分——“Disallow: /Admin"不会屏蔽”/admin"或”/ADMIN"。第五类是通配符用法错误——星号(*)可匹配任意字符,但很多人误写成"Disallow: .pdf",应写为"Disallow: /.pdf"或"Disallow: /*pdf"才能正确匹配扩展名。另外,有些站点规则过于复杂,多个Disallow指令相互冲突,或未考虑URL参数和查询字符串,导致正常内容被误封或敏感内容未被屏蔽。部署前用robots.txt专用验证工具测试,可及时发现并修正这些错误。

常见错误提示:

Google-Extended在robots.txt配置中是一个特殊案例,因为它本质上是一个控制令牌而非传统爬虫,理解其差异对做出正确屏蔽决策非常关键。不同于用于Google搜索内容索引的Googlebot,Google-Extended是用来控制您的内容是否可用于训练Google的Gemini AI模型及驱动搜索结果中的AI Overviews功能。屏蔽Google-Extended将阻止您的内容被用于Gemini训练及AI Overview生成,但不会影响您在传统Google搜索中的可见性——Googlebot仍会正常索引您的内容。这里的权衡很重要:屏蔽Google-Extended使您的内容不会出现在AI Overviews中(这部分在Google搜索结果中日益突出,能带来大量流量),但能保护内容不被用于竞争性AI模型训练。反过来,允许Google-Extended则可能获得AI Overview流量,但您的内容也会被用于Gemini训练,未来可能与自身内容竞争。出版方应结合自身情况权衡——依赖直接流量的新闻机构或内容创作者可能更适合屏蔽Google-Extended,而追求曝光和流量的站点则可以开放。这个决定应有意识地做出,因为它会长期影响您在Google搜索生态中的可见性和流量模式。

在将robots.txt配置上线前进行测试至关重要,因为错误可能对搜索可见性和内容保护策略造成深远影响。Google Search Console内置了robots.txt测试工具,可验证特定User-Agent能否访问指定URL——您可以输入如"GPTBot"和某个路径,Google会反馈该机器人按当前配置能否访问。Merkle Robots.txt Tester也有类似功能,界面友好,并详细解释规则如何被解析。TechnicalSEO.com也提供免费测试工具,能显示不同机器人如何被规则处理。如需更全面监控,Knowatoa AI Search Console专门跟踪AI爬虫活动,并能针对目标爬虫验证配置。测试流程建议先在预发布环境上传robots.txt,确保关键页面未被误封,被屏蔽的AI机器人确实无法访问,并监控服务器日志,排查异常爬虫行为。测试还应确认Sitemap指向正确,搜索引擎可正常抓取内容——目标是屏蔽AI训练爬虫而不影响合法搜索流量。只有在彻底测试后再上线,并在首周持续监控日志,确保无意外问题。

常用测试工具:

虽然robots.txt是第一道防线,但其本质上依赖“自觉遵守”——愿意遵守协议的爬虫才会按规则行事,恶意或不规范的机器人可能无视robots.txt并直接抓取您的内容。行业数据显示,robots.txt大约能阻挡40-60%的不受欢迎爬虫,即有40-60%的爬虫会无视协议或有意规避。对内容保护要求更高的出版方,需要叠加其他防护层。Cloudflare的Web应用防火墙(WAF)可根据User-Agent、IP或行为模式建立规则,屏蔽无视robots.txt的爬虫。服务器级工具如.htaccess(Apache服务器)或Nginx同类配置,可在应用层之前即拦截目标User-Agent或IP段。已知爬虫IP段可直接封禁,但需持续维护更新。Fail2ban等工具能自动屏蔽高频请求或异常行为IP。务必注意,配置这些防护措施时需谨慎,过度屏蔽可能误伤正常用户,包括通过VPN或公司代理访问的真实访客。最佳实践是将robots.txt作为“礼貌请求”,服务器级User-Agent屏蔽针对无视robots.txt的爬虫,再结合行为分析拦截伪装User-Agent或分布式IP的高级爬虫。出版方应逐步部署这些防护层,逐一测试,确保既达成内容保护目的,又不影响正常用户访问。

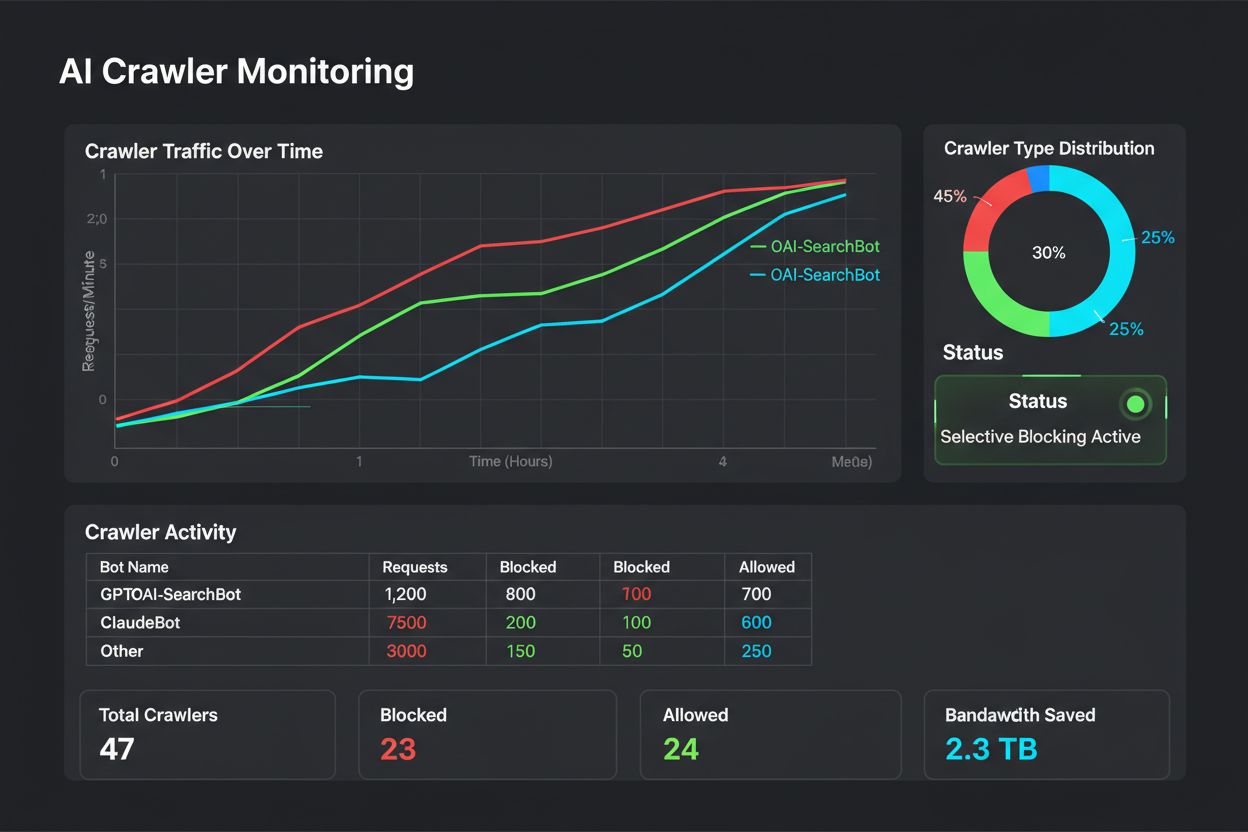

了解实际访问您网站的是什么,是检验robots.txt配置有效性和发现需屏蔽新爬虫的关键。首选方法是分析服务器日志——如Apache/Nginx访问日志,详细记录了每次请求的User-Agent、IP、时间和资源。可用grep等命令行工具搜索特定User-Agent,例如"grep ‘GPTBot’ /var/log/apache2/access.log"可列出所有GPTBot请求,便于验证屏蔽效果。更深入的分析可统计不同爬虫的访问频率、访问页面、是否遵守robots.txt指令。自动化监控系统可持续分析日志,发现新或异常爬虫并及时预警,尤其适合快速变化的AI爬虫生态。一些出版方使用ELK Stack、Splunk等日志聚合平台集中分析多台服务器的爬虫活动。AI爬虫环境变化快,监控不是一次性任务,而是持续性责任——新爬虫不断出现,老爬虫User-Agent也会变化,爬取行为随公司策略动态调整。建议建立定期监控机制(如每周或每月日志复查),主动适应变化,及时调整robots.txt规则。

针对AI爬虫的robots.txt配置,本质上是一次收入相关的战略决策,理应获得与其他重大商业决策同等的重视。允许训练型爬虫任意访问您的内容,意味着AI模型会用您的数据训练,最终可能与您的流量和收入直接竞争——如果您的商业模式依赖直接流量、搜索可见性或广告收入,这等于无偿为对方训练产品。反之,全面屏蔽AI爬虫则会丧失AI搜索和助手带来的曝光和流量,这一部分在用户内容获取途径中正越来越重要。最佳策略取决于您的业务模式:广告驱动型出版方可以选择允许带流量的搜索爬虫,屏蔽训练爬虫;付费订阅型出版方则可能更激进地屏蔽大部分AI爬虫,防止内容被AI系统摘要或复制。以品牌曝光和行业影响力为主的出版方则可能欢迎AI搜索作为分发渠道。关键在于有意识地决策——许多出版方此前未针对AI爬虫配置robots.txt,意味着默认允许所有爬虫,相当于被动贡献内容用于AI训练。建议结合schema标记,确保内容被AI系统引用时获得合理归属,帮助流量和信用回流到您的网站。robots.txt配置应是您商业策略的有机组成部分,需随AI生态和自身业务优先级变化定期复审和调整。

AI爬虫领域正以前所未有的速度演进——新公司不断推出AI产品,老公司不断增加新爬虫,User-Agent字符串随时变化或扩展。您的robots.txt不能一劳永逸,而应成为至少每季度复查和更新的“活文件”。建议建立流程,定期关注行业关于新AI爬虫的公告,订阅相关行业通讯或博客,定期审查服务器日志,发现陌生User-Agent及时研判其用途和商业模式,判断是否需要屏蔽,并同步更新robots.txt。同时监控配置效果,关注爬虫流量变化、爬虫请求与用户流量的比率、以及AI搜索带来的自然流量或回流变化。有些出版方通过几个月的实际数据发现,初始屏蔽策略需要调整——比如屏蔽某爬虫带来副作用,或允许某些爬虫后获得了意外流量收益。建议基于实际结果不断迭代优化。最后,将您的robots.txt策略告知团队相关成员——SEO、内容和业务管理团队都应明白为何屏蔽或允许特定爬虫,以便在组织发展过程中保持策略一致性和主动性。持续关注爬虫管理,才能确保您的内容保护策略与业务目标始终保持一致,应对不断变化的AI生态。

不会。屏蔽GPTBot、ClaudeBot和CCBot等AI训练爬虫不会影响您在Google或Bing搜索的排名。传统搜索引擎有不同的爬虫(Googlebot、Bingbot),它们各自独立运作。只有在您想彻底从搜索结果中消失时才应屏蔽它们。

OpenAI(GPTBot)、Anthropic(ClaudeBot)、Google(Google-Extended)、Perplexity(PerplexityBot)等主流爬虫官方声明会遵守robots.txt指令。但规模较小或透明度较低的机器人可能会忽略您的配置,因此需要有分层防护策略。

这取决于您的策略。仅屏蔽训练爬虫(GPTBot、ClaudeBot、CCBot)可以保护您的内容不被用于模型训练,同时允许以搜索为主的爬虫帮助您出现在AI搜索结果中。完全屏蔽则会让您彻底从AI生态中消失。

建议至少每季度检查一次配置。AI公司经常推出新爬虫。Anthropic近期将 'anthropic-ai' 和 'Claude-Web' 机器人合并为 'ClaudeBot',新机器人对尚未更新规则的网站拥有临时无限制访问权限。

Robots.txt是位于域名根目录下的文件,适用于所有页面,而meta robots标签是HTML页面内的指令,仅作用于单个页面。Robots.txt优先被检查,可直接阻止爬虫访问页面,meta标签只有在页面被访问时才会被读取。两者结合使用可实现全面控制。

可以。您可以在robots.txt中使用路径特定的Disallow规则(如 'Disallow: /premium/' 仅屏蔽高级内容),或在单独页面上使用meta robots标签。这样可以保护敏感内容,同时允许爬虫访问其他区域。

如果机器人无视robots.txt,您需要采用其他保护措施,如服务器级屏蔽(.htaccess)、IP封锁或WAF规则。Robots.txt大约能阻止40-60%的不受欢迎爬虫,因此分层防护对全面防御非常重要。

可以使用Google Search Console的robots.txt测试工具、Merkle Robots.txt Tester或TechnicalSEO.com等工具验证您的配置。通过监控服务器日志中的爬虫活动,确保被屏蔽的机器人确实无法访问,被允许的机器人能够正常访问您的内容。

Robots.txt只是第一步。使用AmICited追踪哪些AI系统正在引用您的内容、引用频率,并确保在GPTs、Perplexity、Google AI Overviews等平台上实现正确归属。

了解如何根据业务目标有选择地允许或屏蔽AI爬虫。实施差异化爬虫访问,在保护内容的同时保持在AI系统中的可见性。为出版商管理GPTBot、ClaudeBot及其他AI爬虫提供战略指南。...

了解如何通过robots.txt、服务器级拦截和高级防护方法阻止或允许GPTBot、ClaudeBot等AI爬虫。完整的技术指南,附有示例。

了解如何实施选择性AI爬虫屏蔽,保护您的内容不被训练机器人抓取,同时在AI搜索结果中保持可见性。为出版方提供的技术策略。...

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.