AI专用的Robots.txt:如何控制哪些机器人访问您的内容

了解如何使用robots.txt控制哪些AI机器人访问您的内容。完整指南,涵盖如何屏蔽GPTBot、ClaudeBot及其他AI爬虫的实用案例与配置策略。...

在AI驱动的内容消费时代,单靠robots.txt作为防护机制的不足日益显现。传统搜索引擎通常会遵守robots.txt指令,而现代AI爬虫则基于完全不同的动机和执行机制,使得简单的文本策略难以保护内容。根据Cloudflare的分析,AI爬虫现已占到网站所有机器人流量的近80%,其中训练爬虫消耗大量内容,却几乎不带来跳转流量——OpenAI爬虫的抓取与跳转流量比为400:1,而Anthropic的比例高达38,000:1。对于出版商和内容所有者而言,这种不对称关系构成了严重的商业威胁,因为基于其内容训练的AI模型会直接减少自然流量,削弱知识产权的价值。

**Web应用防火墙(WAF)**作为反向代理部署在用户与Web服务器之间,实时检查每个HTTP请求,并根据可配置的规则过滤不需要的流量。与依赖爬虫自愿遵守的robots.txt不同,WAF在基础设施层强制执行保护措施,因此对控制AI爬虫访问更为有效。以下对比表展示了WAF与传统安全方法的区别:

| 功能 | Robots.txt | 传统防火墙 | 现代WAF |

|---|---|---|---|

| 执行层级 | 建议/自愿 | 基于IP封锁 | 应用感知检测 |

| AI爬虫检测 | 只匹配user-agent | 机器人识别有限 | 行为分析+指纹识别 |

| 实时适应 | 静态文件 | 需手动更新 | 持续威胁情报 |

| 精细化控制 | 仅路径级 | 大范围IP | 请求级策略 |

| 机器学习 | 无 | 无 | 高级机器人分类 |

WAF通过设备指纹、行为分析和机器学习等技术,对爬虫的意图和复杂度进行细致分类,实现比简单允许/拒绝规则更精确的管控。

AI爬虫分为三大类,各自带来不同威胁,需要不同的防护策略。训练爬虫(如GPTBot、ClaudeBot、Google-Extended)系统性收集网页内容,用于构建大语言模型数据集,占AI爬虫流量的约80%,对出版商零跳转价值。搜索与引用爬虫(如OAI-SearchBot、PerplexityBot)为AI搜索体验建立索引,可能通过引用带来部分流量,但远低于传统搜索引擎。用户触发型爬虫仅在用户通过AI助手主动请求内容时激活,流量极小,且为一次性请求而非系统性爬取。主要威胁包括:

现代WAF采用先进的技术检测方法,远超传统的user-agent字符串匹配,可高精度识别与分类AI爬虫。这些系统利用行为分析,检查请求速率、访问序列、响应特征等,以区分机器人与真人用户。设备指纹识别技术则分析HTTP头、TLS签名、浏览器特征,识别试图伪装的user-agent。机器学习模型可基于数百万请求训练,实时检测新爬虫特征和新型机器人策略,无需手动更新规则。此外,WAF还可以将请求IP与主要AI公司公布的官方IP列表交叉验证——OpenAI在https://openai.com/gptbot.json公布验证IP,亚马逊则在https://developer.amazon.com/amazonbot/ip-addresses/公布相关IP——确保只有来自合法来源的认证爬虫被允许通过。

要有效为AI爬虫实施WAF规则,需结合user-agent拦截、IP验证和行为策略形成多层防护。以下代码示例演示了基本的WAF规则配置:拦截已知训练爬虫,同时允许合法搜索功能:

# WAF规则:拦截AI训练爬虫

规则名:Block-AI-Training-Crawlers

条件1:HTTP User-Agent匹配(GPTBot|ClaudeBot|anthropic-ai|Google-Extended|Meta-ExternalAgent|Amazonbot|CCBot|Bytespider)

动作:拦截(返回403 Forbidden)

# WAF规则:允许验证过的搜索爬虫

规则名:Allow-Verified-Search-Crawlers

条件1:HTTP User-Agent匹配(OAI-SearchBot|PerplexityBot)

条件2:源IP在验证IP范围内

动作:允许

# WAF规则:限制可疑机器人流量

规则名:Rate-Limit-Suspicious-Bots

条件1:请求速率超过100次/分钟

条件2:User-Agent包含bot标识

条件3:无验证IP匹配

动作:挑战(验证码)或拦截

组织应谨慎设置规则优先级,确保更具体的规则(如合法爬虫IP验证)优先于广泛拦截规则。需定期测试与监控规则效果,因为爬虫的user-agent和IP列表经常变更。许多WAF厂商提供专为AI爬虫管理设计的预置规则集,可大幅降低部署复杂度,实现全面防护。

IP验证与白名单机制是区分合法AI爬虫与伪造请求的最可靠方式,因为user-agent易被伪造,而IP大规模伪造则难度极大。主流AI公司以JSON格式发布官方IP列表,可实现自动验证,无需人工维护——OpenAI分别为GPTBot、OAI-SearchBot、ChatGPT-User提供独立IP清单,亚马逊则发布Amazonbot的完整IP列表。WAF规则可设置仅允许这些官方IP来源的请求,有效阻止恶意方仅通过伪造user-agent头部绕过保护。对于采用服务器级拦截(如.htaccess或防火墙规则)的组织,将IP验证与user-agent匹配结合,可形成独立于WAF配置的深度防护。此外,部分爬虫会遵守如<meta name="robots" content="noarchive">等HTML meta标签,提醒合规爬虫内容不得用于模型训练,为希望实现页面级细粒度管控的出版商提供补充手段。

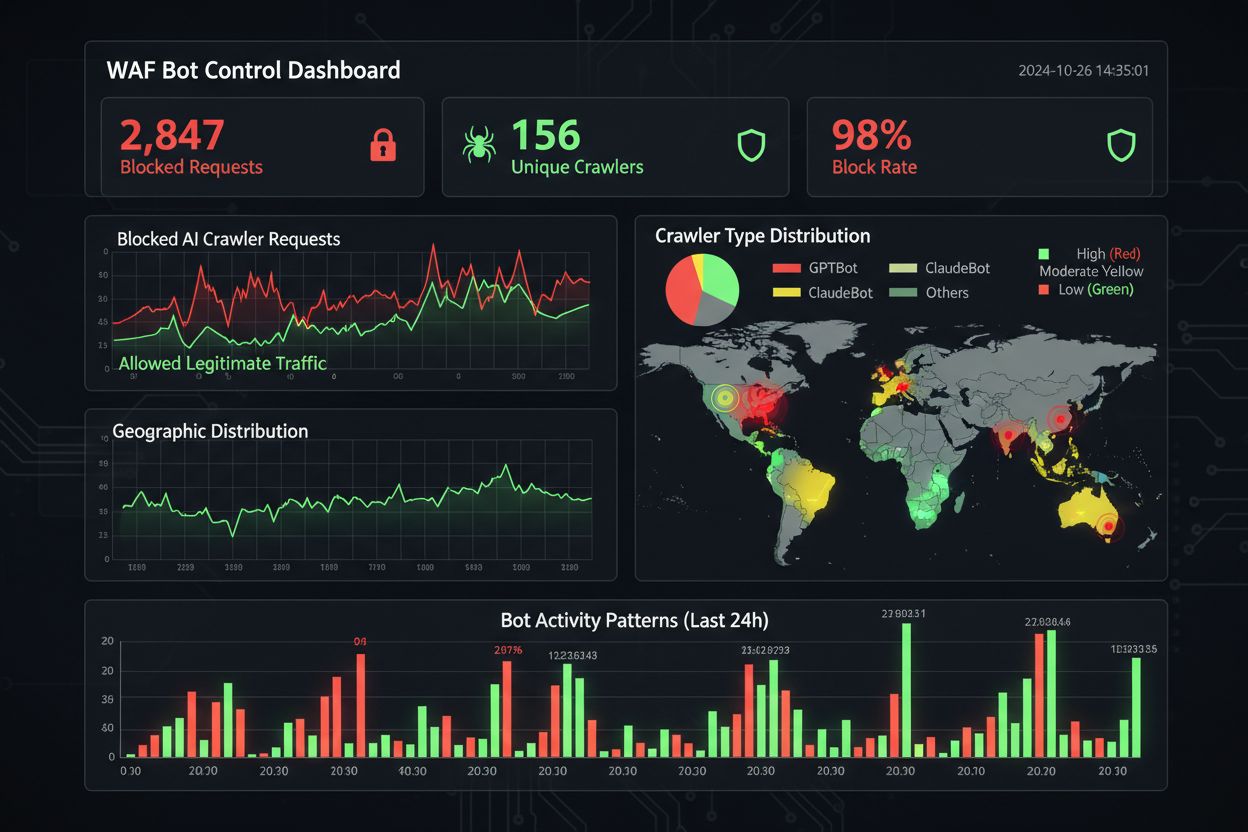

高效的监控与合规管理需要持续掌握爬虫活动,确保拦截规则按预期生效。组织应定期分析服务器访问日志,识别哪些爬虫在访问网站,及被拦截的爬虫是否仍有请求——Apache日志通常位于/var/log/apache2/access.log,Nginx日志在/var/log/nginx/access.log,可用grep快速筛查可疑模式。分析平台日益能区分机器人与真人流量,便于团队衡量拦截爬虫对核心指标(如跳出率、转化追踪、SEO表现)的影响。Cloudflare Radar等工具可全球监控AI机器人流量,及时发现未纳入黑名单的新型爬虫。从合规角度看,WAF日志可生成审计记录,证明组织已采取合理安全措施保护客户数据和知识产权,对于GDPR、CCPA等数据保护法规愈加重要。每季度审查爬虫拦截名单至关重要,因为新的AI爬虫不断涌现,现有爬虫user-agent也会更新——社区维护的GitHub ai.robots.txt项目

是追踪新威胁的宝贵资源。

在保护内容与实现业务目标之间,需要谨慎分析哪些爬虫该拦截、哪些应放行,过度拦截可能会降低在新兴AI渠道的曝光度。拦截GPTBot、ClaudeBot等训练爬虫有助于保护知识产权,但不会影响流量,因为这些爬虫原本不带来跳转流量。但拦截OAI-SearchBot、PerplexityBot等搜索爬虫,可能会降低AI搜索结果中的引用与曝光度——是否拦截需结合您的内容策略和受众。部分出版商正探索新策略,如允许搜索爬虫但拦截训练爬虫,或推行按次付费爬取模式,让AI公司为内容访问付费。AmICited.com等工具帮助出版商追踪内容在AI答案中的引用,为拦截决策提供数据参考。最优WAF配置需结合业务模型:新闻出版商或许更关注拦截训练爬虫以保护内容,同时允许搜索爬虫以提升曝光度;SaaS公司则可能会全面拦截AI爬虫,防止竞争对手分析定价与功能。实施WAF规则后,应持续监控流量模式和收入指标,确保保护策略与实际业务结果一致。

对比AI爬虫管理的WAF方案时,需关注多项能力,这些能力区分了企业级平台与基础产品。Cloudflare的AI Crawl Control与WAF集成,针对已知AI爬虫提供预置规则,可实现拦截、放行或按次付费等策略,且规则优先级确保WAF规则先于其他安全层执行。AWS WAF Bot Control提供基础与定向两级防护,定向级可通过浏览器探测、指纹识别和行为分析检测未自报身份的复杂机器人,并可选用机器学习分析流量。Azure WAF通过其托管规则集实现类似能力,但AI专属特性不如Cloudflare和AWS突出。除此之外,DataDome等专业机器人管理方案专为AI爬虫行为训练了高级机器学习模型,尽管成本较高。选择方案时,应结合现有基础设施、预算及所需防护深度——已使用Cloudflare的组织可无缝集成,AWS用户则可在现有WAF架构下启用Bot Control。

AI爬虫管理最佳实践强调采用多重防护机制的深度防御策略,切忌依赖单一手段。组织应每季度审查封禁名单,及时捕捉新爬虫与user-agent更新,保持服务器日志分析,验证拦截效果,并定期测试WAF配置,确保规则顺序正确。WAF技术的未来将进一步集成AI驱动的威胁检测,实时适应新型爬虫策略,并与更广泛的安全生态系统集成,提供上下文感知的保护。随着数据抓取与AI训练数据合规要求趋严,WAF将从可选安全组件转变为合规必需品。组织应及早为AI爬虫实施全面WAF防护,防范即将普及的浏览器型AI代理和无头浏览器爬虫——若因疏于防护造成流量损失、数据分析失真甚至潜在法律风险,所付代价远高于建立稳健防护体系的投入。

Robots.txt是一个依赖爬虫自愿遵守的建议性文件,而WAF规则是在基础设施层面强制执行的,对所有请求都适用,无论爬虫是否遵守。WAF可实现实时检测与拦截,而robots.txt是静态的,容易被不合规爬虫绕过。

是的,许多AI爬虫会无视robots.txt指令,因为它们旨在最大化训练数据的收集。虽然大型公司的合规爬虫通常会遵守robots.txt,但不良行为者及部分新兴爬虫则不会。这也是WAF规则能提供更可靠保护的原因。

检查您的服务器访问日志(通常位于/var/log/apache2/access.log或/var/log/nginx/access.log),查找包含bot标识的user-agent字符串。Cloudflare Radar等工具可提供AI爬虫流量的全球可视化,分析平台也越来越能区分机器人流量与真人访客。

拦截GPTBot等训练爬虫不会直接影响SEO,因为它们不会带来跳转流量。但拦截OAI-SearchBot等搜索爬虫可能会降低您在AI搜索结果中的曝光度。Google的AI摘要遵循标准Googlebot规则,因此拦截Google-Extended不会影响常规搜索收录。

Cloudflare的AI Crawl Control、AWS WAF Bot Control以及Azure WAF都提供有效的解决方案。Cloudflare拥有最丰富的AI专属功能,内置规则并支持按次付费爬取。AWS提供高级机器学习检测,Azure则有完善的托管规则。选择时应结合自身基础设施与预算。

至少每季度审查并更新WAF规则,因为新的AI爬虫会不断出现,现有爬虫也会更新user-agent字符串。建议每月检查服务器日志,识别新的爬虫,并关注GitHub上的ai.robots.txt社区项目,及时跟踪新威胁。

可以,这是一种常见策略。您可以配置WAF规则,拦截如GPTBot和ClaudeBot等训练爬虫,同时允许OAI-SearchBot和PerplexityBot等搜索爬虫访问。这样既能防止内容被用于模型训练,又能保持在AI搜索中的曝光度。

WAF价格因服务商而异。Cloudflare提供起价为$20/月的WAF,内含AI爬虫控制功能。AWS WAF根据Web ACL和规则计费,基础防护一般每月$5-10。Azure WAF随Application Gateway提供。与保护内容和保持准确分析价值相比,实施成本很低。

了解如何使用robots.txt控制哪些AI机器人访问您的内容。完整指南,涵盖如何屏蔽GPTBot、ClaudeBot及其他AI爬虫的实用案例与配置策略。...

了解如何根据业务目标有选择地允许或屏蔽AI爬虫。实施差异化爬虫访问,在保护内容的同时保持在AI系统中的可见性。为出版商管理GPTBot、ClaudeBot及其他AI爬虫提供战略指南。...

了解如何通过robots.txt、服务器级拦截和高级防护方法阻止或允许GPTBot、ClaudeBot等AI爬虫。完整的技术指南,附有示例。

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.