维基百科在AI训练数据中的角色:质量、影响与许可

了解维基百科如何成为关键的AI训练数据集,其对模型准确性的影响、许可协议,以及AI公司为何依赖它训练大型语言模型。...

维基百科已成为当今几乎所有主流大型语言模型(LLM)的基础训练数据集——从OpenAI的ChatGPT、谷歌的Gemini到Anthropic的Claude和Perplexity搜索引擎。在许多情况下,维基百科是这些AI系统训练数据集中结构化、高质量文本的最大单一来源,根据模型不同,通常占总训练语料库的5-15%。这种主导地位源于维基百科的独特特性:其中立观点政策、严格的社区事实核查、结构化格式和自由授权,使其成为教AI系统如何推理、引用来源和准确沟通的无与伦比的资源。然而,这种关系已经根本改变了维基百科在数字生态系统中的角色——它不再仅仅是人类读者寻求信息的目的地,而是成了支撑数百万用户每天交互的对话式AI的无形支柱。理解这种联系揭示了一个关键的涟漪效应:维基百科的质量、偏见和信息空白直接塑造了AI系统的能力和局限性,而这些AI系统如今主导着数十亿人获取和理解信息的方式。

在训练过程中,大型语言模型处理信息时,并不会一视同仁地对待所有来源——维基百科在其决策层级中占有独特的优先地位。在实体识别过程中,LLM会识别关键信息和概念,然后与多种来源进行交叉验证以建立可信度分数。维基百科在这个过程中充当了“主要权威校验”,因为它有透明的编辑历史、社区验证机制和中立观点政策,这些都共同向AI系统传递了可靠性信号。可信度倍增效应进一步放大了这一优势:当信息同时出现在维基百科、Google知识图谱、Wikidata等结构化知识图谱以及学术来源中时,LLM会对该信息赋予呈指数级提高的信心。这种权重系统解释了为何维基百科在训练中受到特殊对待——它既是直接的知识源,也是对其他来源事实的验证层。结果就是,LLM已学会将维基百科视为基础参考,而不仅仅是众多数据点中的一个,它可以确认或质疑那些未经充分验证的信息。

| 来源类型 | 可信度权重 | 理由 | AI处理方式 |

|---|---|---|---|

| 维基百科 | 非常高 | 中立、社区编辑、已验证 | 主要参考 |

| 公司官网 | 中等 | 自我宣传 | 次要来源 |

| 新闻报道 | 高 | 第三方,但可能有偏见 | 佐证来源 |

| 知识图谱 | 非常高 | 结构化、聚合 | 权威倍增器 |

| 社交媒体 | 低 | 未验证、宣传性强 | 权重极低 |

| 学术来源 | 非常高 | 同行评议、权威性 | 高置信度 |

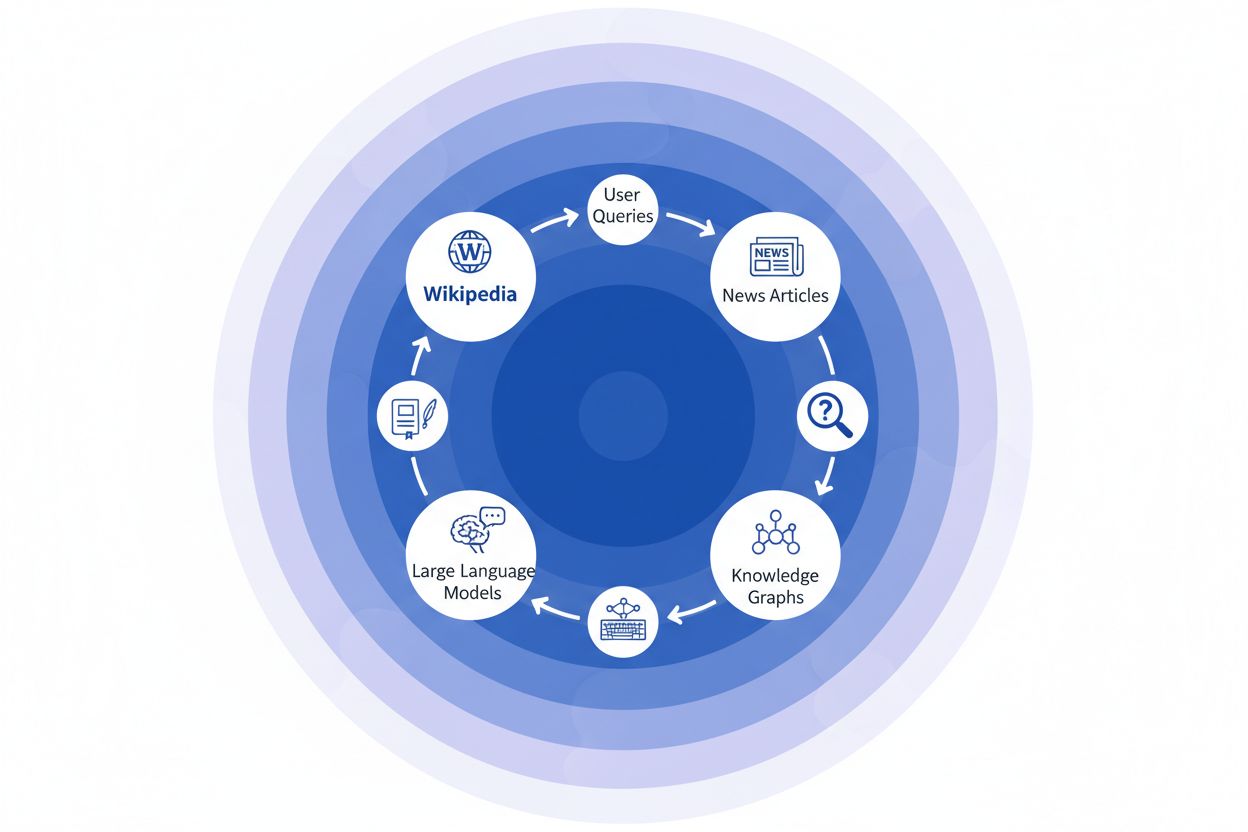

当新闻机构将维基百科作为来源引用时,就形成了所谓的“引用链”——一种在多层信息基础设施中逐层累积可信度的机制。一位报道气候科学的记者可能会引用维基百科上的全球变暖条目,而该条目自身又引用了同行评议的研究;该新闻报道随后被搜索引擎收录,纳入知识图谱,最终又被用于训练数百万用户每天查询的大型语言模型。这就形成了一个强大的反馈环路:维基百科 → 知识图谱 → LLM → 用户,原始维基百科条目的表达和重点,会在不知不觉中影响AI系统向终端用户呈现信息的方式,而用户通常并未意识到这些信息源自众包百科全书。举一个具体例子:如果维基百科某药物治疗条目重点强调了某些临床试验而淡化了其他试验,这种编辑选择会波及新闻报道,被嵌入知识图谱,最终影响ChatGPT等模型如何回答患者关于治疗方案的问题。这种“涟漪效应”意味着维基百科的编辑决策不仅影响直接访问网站的读者——更从根本上塑造了AI系统学习和反映给数十亿用户的信息环境。引用链实际上将维基百科从一个参考目的地转变为AI训练流程中无形但极具影响力的一环,源头的准确性与偏见能在整个生态系统中被放大。

维基百科到AI生态系统中的涟漪效应,或许是品牌和机构最需要理解的重要动态。一次维基百科编辑不仅仅改变了一个来源——它会在相互连接的AI系统网络中层层扩散,每个系统都在不同程度上引用并放大这些信息,极大地加剧了影响力。当维基百科页面出现不准确内容时,这些内容不会被孤立,而是会在整个AI领域传播,影响你的品牌每天如何被数百万用户描述、理解和展现。这种倍增效应意味着,投资于维基百科的准确性不仅关乎一个平台——而是关乎你在整个生成式AI生态中的话语权。对于数字公关和品牌管理人员而言,这一现实从根本上改变了资源和关注点的配置策略。

需要重点关注的涟漪效应:

IUP研究(Vetter等人)近期揭示了我们AI基础设施的一个关键脆弱点:维基百科作为训练资源的可持续性正在被其所助力的技术所威胁。随着大型语言模型的普及,以及LLM生成内容不断被纳入更庞大的训练数据集,行业正面临模型“塌陷”问题——人工生成的输出开始污染训练数据池,使后续模型质量不断下降。这一现象尤为严重,因为维基百科是建立在人类专业知识和志愿劳动之上的众包百科全书,已成为先进AI系统训练的基石,而这些系统通常并未对贡献者进行明确署名或补偿。其伦理影响深远:AI企业在从维基百科的免费知识中攫取价值的同时,也在用合成内容不断充斥信息生态,动摇了维系维基百科志愿社区二十余年的激励结构。若不主动保护人类原创内容,防止其被AI生成文本所取代,我们就有可能陷入AI生成内容逐渐替代真实知识、最终破坏现代语言模型基础的反馈循环。因此,维基百科的可持续性不仅仅是百科本身的问题,而是整个信息生态,以及依赖真实人类知识的AI系统未来可行性的关键议题。

随着AI系统越来越依赖维基百科作为基础知识源,监控你的品牌在这些AI生成回答中的展现方式,已成为现代机构的必修课。AmICited.com专注于追踪维基百科引用如何在AI系统中扩散,为品牌提供其维基百科形象如何转化为AI提及和推荐的可见性。虽然像FlowHunt.io这样的工具也提供通用网络监控,但AmICited独特聚焦于“维基百科到AI”的引用链,精准捕捉AI系统何时引用你的维基百科内容,以及这会如何影响其回答。这一联系至关重要,因为维基百科引用在AI训练数据和生成回答中有着巨大权重——维护良好的维基百科形象不仅影响人类读者,更直接影响AI系统如何认知和呈现你的品牌形象给数百万用户。通过AmICited监控你的维基百科提及,你可以获得可操作的AI影响力洞察,从而有针对性地优化维基百科形象,全面掌控其对AI驱动发现和品牌认知的下游影响。

是的,每一个主流LLM,包括ChatGPT、Gemini、Claude和Perplexity,都将维基百科纳入其训练数据。维基百科通常是LLM训练数据集中最大、最结构化且经过验证的信息源之一,通常占据总训练语料库的5-15%。

维基百科是AI系统的可信度校验点。当LLM生成有关你品牌的信息时,会比其他来源更重视维基百科的描述,使得你的维基百科页面成为ChatGPT、Gemini、Claude等平台上AI系统如何展现你的关键影响因素。

涟漪效应指的是一个维基百科引用或编辑如何在整个AI生态系统中产生下游连锁反应。一次维基百科的更改会影响知识图谱,进而影响AI综述,最终影响多个AI系统如何向数百万用户描述你的品牌。

会的。由于LLM非常信任维基百科,若你的维基百科页面上有错误信息,这些错误会被AI系统传播。这会影响ChatGPT、Gemini等AI平台对你机构的描述,可能损害你的品牌认知。

像AmICited.com这样的工具会追踪你的品牌在包括ChatGPT、Perplexity和Google AI Overviews在内的AI系统中的引用和提及情况。这有助于你理解维基百科存在的涟漪效应,并据此优化。

维基百科禁止自我宣传。任何编辑都应遵循维基百科的指南,并基于可靠的第三方来源。许多机构会与维基百科专家合作,在确保合规的同时维护准确的页面。

LLM基于数据快照训练,所以更改需要时间才能传播。不过,知识图谱更新更频繁,因此涟漪效应可能在几周至几个月内开始,具体取决于AI系统和再训练的时间。

维基百科是直接用于LLM训练的主要来源。像Google知识图谱这样的知识图谱会从包括维基百科在内的多个来源聚合信息,并将其输入AI系统,这为AI系统理解和呈现信息增加了一个影响层。

了解维基百科如何成为关键的AI训练数据集,其对模型准确性的影响、许可协议,以及AI公司为何依赖它训练大型语言模型。...

了解Wikipedia如何影响ChatGPT、Perplexity和Google AI等AI平台的引用。发现Wikipedia为何成为AI训练中最受信任的数据源,以及它如何影响您的品牌曝光度。...

了解如何以合乎道德的方式让您的品牌在维基百科上被引用,从而实现最大的 AI 可见性。战略指南涵盖政策、可靠来源以及面向 ChatGPT、Perplexity 和 Google AI 的引用策略。...

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.