AI搜索引擎

了解AI搜索引擎是什么、它们与传统搜索有何不同,以及它们对品牌曝光度的影响。探索如Perplexity、ChatGPT、Google Gemini和Claude等平台。...

了解 ChatGPT、Perplexity 和 Google AI Overviews 等 AI 搜索引擎的工作原理。探索 LLM、RAG、语义搜索和实时检索机制。

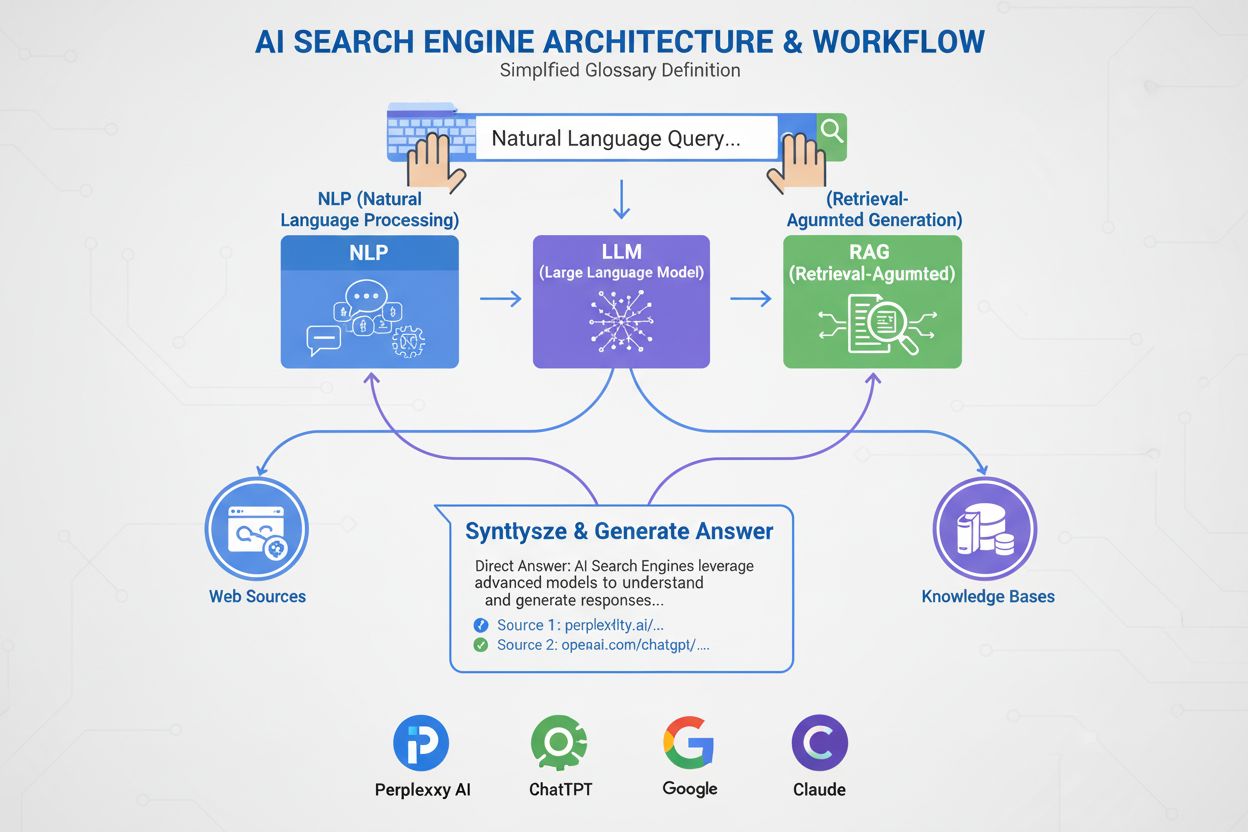

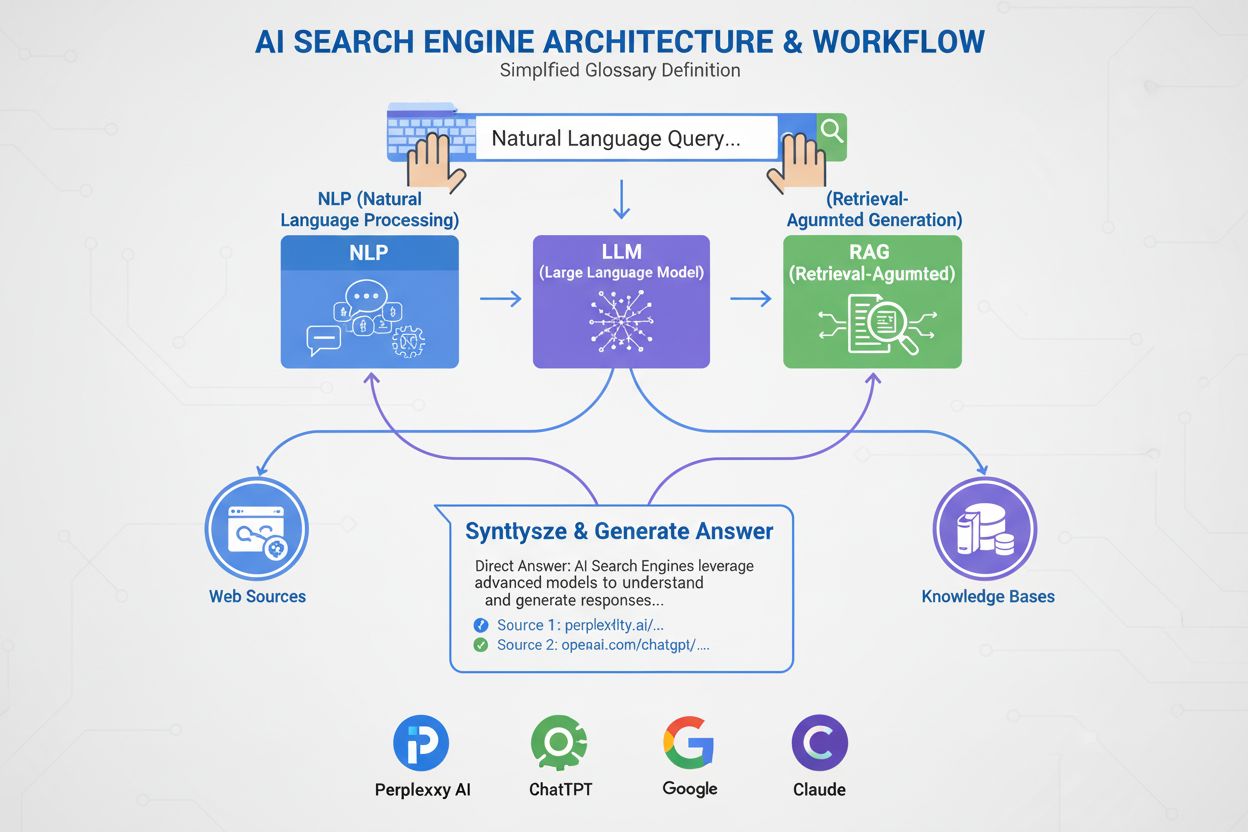

AI 搜索引擎结合了大型语言模型(LLM)与检索增强生成(RAG),以理解用户意图并实时从网络检索相关信息。它们通过语义理解、向量嵌入和知识图谱处理查询,能够生成带有来源引用的对话式答案,这与传统只返回网站排名列表的搜索引擎不同。

AI 搜索引擎代表着从传统基于关键词的搜索向对话式、意图驱动的信息检索的根本转变。不同于谷歌传统搜索引擎通过抓取、索引并对网站进行排名以返回链接列表,ChatGPT、Perplexity、Google AI Overviews 和 Claude 等 AI 搜索引擎能够结合多种技术生成原创答案。这些平台能够理解用户真正想要什么,从权威来源检索相关信息,并将其整合为连贯、有引用的回答。支撑这些系统的技术正在改变人们在线获取信息的方式,ChatGPT 每天处理 20 亿条查询,AI Overviews 出现在全球 18% 的谷歌搜索中。了解这些系统的工作原理,对内容创作者、市场营销人员以及希望在新搜索格局中获得曝光的企业而言至关重要。

AI 搜索引擎通过三个相互关联的系统协同工作,提供准确且有来源的答案。第一个组成部分是大型语言模型(LLM),它通过海量文本数据训练,理解语言模式、结构和细微差别。像OpenAI 的 GPT-4、Google 的 Gemini、Anthropic 的 Claude等模型,采用无监督学习在数十亿份文档上训练,使其能够根据训练中学到的统计模式预测下一个词。第二个组成部分是嵌入模型,它将词语和短语转换为称为向量的数值表示。这些向量捕捉了语义意义和概念间的关系,使系统能理解“游戏本”和“高性能电脑”语义相关,即使它们并无完全相同的关键词。第三个关键组成部分是检索增强生成(RAG),它通过实时从外部知识库检索当前信息,补充 LLM 的训练数据。这一点至关重要,因为 LLM 具有训练截止日期,无法在没有 RAG 的情况下访问实时信息。这三大组件协同作用,使 AI 搜索引擎能够提供最新、准确、有来源的答案,而不是幻觉或过时信息。

检索增强生成使 AI 搜索引擎能够基于权威来源生成答案,而非仅依赖训练数据。当你向 AI 搜索引擎提交查询时,系统首先使用嵌入模型将你的问题转化为向量表示,然后与同样被转化为向量的已索引网页内容数据库进行对比,利用余弦相似度等技术识别最相关的文档。RAG 系统检索到这些文档后,与原始查询一起传递给 LLM。LLM 会结合新检索到的信息和自身训练数据,生成直接引用所查阅来源的答案。这种方式解决了多个关键问题:确保答案最新且有事实依据,允许用户通过检查来源验证信息,同时给予内容创作者被 AI 答案引用的机会。Azure AI Search 和 AWS Bedrock是企业级 RAG 实现,展示了组织如何搭建定制 AI 搜索系统。RAG 的质量极大依赖于检索系统对相关文档的识别能力,因此语义排序与混合搜索(结合关键词与向量搜索)已成为提升准确率的重要技术。

语义搜索让 AI 搜索引擎能够理解含义,而不仅仅是匹配关键词。传统搜索引擎只找精确关键词匹配,而语义搜索则分析查询背后的意图和语境。当你搜索“带好相机的实惠智能手机”时,语义搜索引擎明白你想要的是价位低且拍照好的手机,即便结果不包含这些原词。实现这一点依赖于向量嵌入,即将文本转化为高维数值数组。像BERT(双向编码器表示)和OpenAI 的 text-embedding-3-small等高级模型,可将词语、短语乃至整份文档转化为向量,使语义相关内容在向量空间中彼此靠近。系统随后利用如余弦相似度等数学方法计算向量相似度,找出最契合查询意图的文档。这种方式远比关键词匹配有效,因为它能捕捉概念间的关系。例如,系统能理解“游戏本”与“带 GPU 的高性能电脑”相关,尽管没有共同关键词。知识图谱进一步通过构建概念间的结构化语义关系网络,将“笔记本”与“处理器”“内存”“GPU”等关联,增强理解能力。正是这种多层语义理解方法,使 AI 搜索引擎能针对复杂对话式查询返回相关结果,而传统搜索引擎则常常无能为力。

| 搜索技术 | 工作原理 | 优势 | 局限性 |

|---|---|---|---|

| 关键词搜索 | 查询与索引内容中的精确词语或短语匹配 | 快速、简单、可预测 | 无法处理同义词、拼写错误和复杂意图 |

| 语义搜索 | 通过 NLP 和嵌入理解含义和意图 | 处理同义词、语境和复杂查询 | 需要更多计算资源 |

| 向量搜索 | 将文本转化为数值向量并计算相似度 | 精准相似度匹配、可扩展 | 注重数学距离,弱化语境理解 |

| 混合搜索 | 结合关键词与向量搜索方法 | 准确性与召回率兼得 | 实现和调优更复杂 |

| 知识图谱搜索 | 利用概念间结构化关系 | 丰富结果的推理与语境 | 需要人工策划和维护 |

AI 搜索引擎相比传统 LLM 的一大优势是能够访问实时网络信息。当你向ChatGPT咨询最新事件时,它会通过名为ChatGPT-User 的机器人实时抓取网页,获取最新信息。Perplexity同样实时搜索互联网,从顶级来源收集见解,这也是其能回答训练数据截止后事件的原因。Google AI Overviews依托谷歌现有的网页索引和抓取基础设施检索最新信息。这种实时检索能力对于保持准确性和相关性至关重要。检索过程包括多个环节:首先,系统通过查询扇出将你的问题分解成多个相关子查询,以便检索更全面的信息;接着,系统利用关键词和语义匹配搜索已索引的网页内容,识别相关页面;然后,利用语义排序算法对检索到的文档按相关性重新排序,依据意义而非关键词频率;最后,系统从这些文档中提取最相关片段,传递给 LLM 生成答案。整个过程在数秒内完成,因此用户期望 AI 搜索的响应时间在 3-5 秒之间。检索流程的速度和准确性直接影响最终答案质量,因此高效信息检索是 AI 搜索引擎架构的关键组成。

RAG 系统检索到相关信息后,大型语言模型会利用这些信息生成响应。LLM 并不以人的方式“理解”语言,而是利用统计模型根据训练时学到的模式预测下一个词。当你输入查询时,LLM 会将其转为向量表示,并通过包含数百万节点的神经网络处理。这些节点在训练过程中学会了被称为权重的连接强度,决定各连接间的影响力。LLM 不会只返回下一个词的单一预测值,而是给出概率排名列表。例如,可能预测下一个词为“学习”的概率为 4.5%,为“预测”的概率为 3.5%。系统并不总是选择最高概率的词,而是有时选取次高概率词,使回答更自然、富有创造性。这种随机性由温度参数控制,范围从 0(确定性)到 1(极具创造性)。生成第一个词后,系统重复此过程,直到生成完整回应。这种逐 token 生成方式使得 AI 回答往往更具对话感和自然性——本质上,模型是在预测对话的最可能延续。生成答案的质量既取决于检索信息的优劣,也取决于 LLM 训练的先进程度。

不同 AI 搜索平台在这些核心技术的实现上有不同的策略与优化手段。ChatGPT(由 OpenAI 开发)占据了81% 的 AI 聊天机器人市场份额,每天处理20 亿条查询。ChatGPT 结合了 OpenAI 的 GPT 模型与 ChatGPT-User 的实时网页检索,尤其擅长处理复杂多步查询和对话上下文的保持。Perplexity以透明的来源引用为特色,向用户准确展示每部分答案的信息来源,其顶级引用包括Reddit(6.6%)、YouTube(2%)、Gartner(1%),体现了其对权威和多样来源的侧重。Google AI Overviews直接集成在谷歌搜索结果顶部,全球 18% 的谷歌查询会展现 AI Overviews,并由谷歌的Gemini模型驱动,尤其适用于信息类查询,88% 触发 Overviews 的查询属于信息类。Google 的 AI 模式(2024 年 5 月上线)将整个搜索结果页围绕 AI 生成答案重组,美国和印度已有1 亿月活用户。Claude(由 Anthropic 开发)注重安全与准确,用户表示其能提供细致、富有推理的答案。各平台在速度、准确性、来源透明度与用户体验间作出不同权衡,但都依赖于 LLM、嵌入和 RAG 的基础架构。

向 AI 搜索引擎提交查询时,将经过复杂的多阶段处理流程。第一阶段为查询分析,系统将你的问题分解为关键词、实体和短语等基本部分。自然语言处理技术如分词、词性标注和命名实体识别用于明确你的问题。例如,在“适合游戏的最佳笔记本”这一查询中,系统识别“笔记本”为主要实体,“游戏”为意图驱动因素,并推断你需要高内存、强处理器和 GPU。第二阶段是查询扩展与扇出,系统生成多个相关查询,以获取更全面信息。不仅搜索“最佳游戏本”,还会并行搜索“游戏本参数”“高性能笔记本”“笔记本 GPU 要求”等,大幅提升信息覆盖度。第三阶段为检索与排序,系统用关键词和语义匹配搜索索引内容,再按相关性排序。第四阶段为片段提取,系统从检索文档中提取最相关片段,而非将整份文档传递给 LLM。这很关键,因为 LLM 有 token 限制——GPT-4 接收约 128,000 token,但你可能有一万页文档。仅提取最相关片段,既保证传递给 LLM 的信息质量,又能满足 token 限制。最后阶段为答案生成与引用,LLM 生成响应并包含所参考来源。整个流程需在数秒内完成,以满足用户响应时间预期。

AI 搜索引擎与谷歌等传统搜索引擎的根本区别在于核心目标和方法。传统搜索引擎旨在帮助用户查找现有信息,通过爬网、索引网页,并依据链接、关键词和用户互动等相关性信号进行排名。谷歌流程分三步:爬网(发现页面)、索引(分析并存储页面信息)、排名(确定哪些页面最相关)。其目标是返回网站列表,而非生成新内容。AI 搜索引擎则旨在基于训练数据与实时网络信息生成原创、综合的答案。虽然传统搜索也用到RankBrain 和 BERT等 AI 算法提升排名,但并不试图生成新内容。AI 搜索引擎根本上是通过预测词序列生成新文本。这一区别对曝光有深远影响。传统搜索需跻身前十才能获得点击,而在 AI 搜索中,40% 被 AI Overviews 引用的来源在谷歌传统搜索中排名低于前十,被 Google AI Mode 引用的 URL 仅有 14% 在传统谷歌搜索前十。也就是说,即使你的内容在传统搜索排名不佳,也可能被 AI 答案引用。此外,品牌网络提及与被 Google AI Overviews 引用的相关性高达0.664,远高于外链(0.218),表明在 AI 搜索中,品牌曝光和声誉比传统 SEO 指标更重要。

AI 搜索格局正在快速演变,对信息发现方式及企业曝光策略产生重大影响。预计到 2028 年,AI 搜索流量将超过传统搜索访客,最新数据显示2025 年 6 月 AI 平台带来了 11.3 亿次推荐访问,同比增长 357%。更重要的是,AI 搜索流量转化率达 14.2%,而谷歌仅为 2.8%,尽管目前只占全球流量的1%,但价值远超传统流量。市场正向少数主导平台集中:ChatGPT 占据 81% 的 AI 聊天市场份额,Google Gemini 拥有 4 亿月活用户,Perplexity 超过 2200 万月活用户。新功能不断扩展 AI 搜索能力——ChatGPT 的 Agent Mode 允许用户在平台内直接委托复杂任务如订票,Instant Checkout 实现聊天中直接购买产品。ChatGPT Atlas 于 2025 年 10 月上线,将 ChatGPT 拓展到全网,实现即时答案和建议。这一切表明,AI 搜索正从传统搜索的替代品,演变为集信息发现、决策与电商于一体的综合平台。对于内容创作者和市场人,这一转变需要根本性的策略调整。不再只是优化关键词排名,而要在训练数据中建立相关模式、通过提及和引用塑造品牌权威、确保内容新鲜、全面且结构良好。AmICited 等工具可帮助企业监测其内容在各 AI 平台的曝光,追踪引用模式并衡量 AI 搜索可见度——这些都是适应新格局的核心能力。

了解AI搜索引擎是什么、它们与传统搜索有何不同,以及它们对品牌曝光度的影响。探索如Perplexity、ChatGPT、Google Gemini和Claude等平台。...

社区讨论 AI 搜索引擎的工作原理。市场营销人员对于 LLM、RAG 和语义搜索与传统搜索的真实体验。

探索 AI 搜索引擎与传统搜索的关键区别。了解 ChatGPT、Perplexity 和 Google AI Overviews 如何区别于基于关键词的搜索结果。