理解用户提示如何影响AI回应——这对品牌可见性意味着什么?

社区讨论用户提示如何影响AI回应及品牌可见性。市场人员分析提示模式及其对在ChatGPT和Perplexity答案中出现的意义。

了解提示的措辞、清晰度和具体性如何直接影响 AI 回复质量。学习提升 ChatGPT、Perplexity 及其他 AI 系统的提示工程技巧。

用户提示通过措辞清晰度、具体性、语气和上下文显著影响 AI 回复质量。对提示进行细微调整,能极大提升 AI 答案的准确性、相关性和实用性。

用户提示是人类与人工智能系统交流的主要机制,其质量直接决定了 AI 生成回复的实用性和准确性。当你与 ChatGPT、Perplexity 或其他语言模型等 AI 系统互动时,你如何表达问题,从根本上决定了 AI 对你意图的理解以及它将生成何种答案。提示质量与回复质量之间的关系并非偶然——这是已被人工智能研究广泛证实的直接因果关系。理解这种关系对于希望高效利用 AI 的任何人来说都至关重要,无论是用于业务运营、内容创作还是信息检索。

提示的影响不仅仅体现在词语选择上。**清晰度、具体性、上下文和语气共同引导 AI 模型生成与你实际需求相符的回复。**模糊的提示可能只会得到泛泛而谈、缺乏深度或相关性的答案。反之,一个结构合理、指令明确、上下文恰当的提示则能激发更深入的见解和更有针对性的信息。这一原则适用于所有 AI 系统,从通用模型到专业答案引擎。你在提示中投入的精确度,直接决定了你收到的输出有多精准。

**提示的清晰度是获得有用 AI 回复的基础。**如果你提供的指令含糊不清,AI 模型就必须猜测你的需求,这常常导致误解和不相关的答案。AI 系统无法像人类一样主动提出澄清性问题,因此它完全依赖于你在提示中提供的信息来理解你的意图。这意味着,减少语言中的歧义,是提升回复质量最有效的方法之一。

对比如下:“请介绍一下营销”与“有哪些面向千禧一代客户的小型企业创新数字营销策略?”第一个提示过于模糊,可能只会得到营销原理的泛泛介绍。第二个提示则提供了具体的上下文——目标受众(小型企业)、目标群体(千禧一代)、期望形式(三种策略)——这能引导 AI 给出更聚焦、更具操作性的回复。**这种额外的具体性不仅提升了回复质量,甚至从根本上改变了 AI 生成内容的性质。**无论你是用 ChatGPT 头脑风暴、Perplexity 做研究,还是用其他 AI 系统检索信息,这一原则都适用。

| 提示类型 | 示例 | 预期输出质量 |

|---|---|---|

| 模糊 | “介绍一下 AI” | 泛泛、宽泛概述 |

| 具体 | “实施 AI 在医疗领域的主要挑战有哪些?” | 聚焦、细致、行业相关 |

| 有上下文 | “对于一个 50 人的初创公司,提升客户服务的 5 大 AI 工具有哪些?” | 针对性强、可操作、贴合商业需求 |

| 详细 | “解释提示工程如何提升 AI 回复准确率,并举例说明” | 全面、结构化、含丰富示例 |

**具体性是提升 AI 回复质量最强有力的杠杆之一。**在提示中加入具体细节、约束和上下文,本质上是在为 AI 设定护栏,让它专注于你的实际需求。模糊的提示容易让 AI 偏离主题,提供虽然准确但与你实际需求无关的信息。相反,具体的提示为 AI 设定了明确的目标,使其能精准作答。

在处理复杂话题或追求特定业务目标时,具体性的作用更加明显。与其问“如何提升我的网站?”,不如问“有哪些针对 B2B SaaS 项目管理软件公司、能提升搜索排名的五大站内 SEO 优化技术?”第二个提示包含了多层次具体性:企业类型(B2B SaaS)、行业(项目管理)、目标(搜索排名)、重点(站内 SEO)。这些细节能帮助 AI 模型聚焦真正有用的信息。提示工程的研究表明,对具体性的微调能带来显著不同且更优质的回复。

**你的提示语气和风格会微妙却显著地影响 AI 回复的语气和风格。**因为语言模型训练时会识别并模仿语言中的风格模式。当你使用正式语言时,AI 通常会以正式的方式回应;如果你用对话式语言,回复也会变得更随和。这不仅仅是正式与否,还包括礼貌、创造力、技术深度等风格维度。

研究发现,即便是语气上的细小调整也会影响回复质量。例如,使用礼貌用语的提示(如“请问能否解释……”)通常会得到更高质量的回复,而语气生硬或命令式的提示则不然。原因并非 AI 会因无礼而“受伤”,而是因为礼貌的语言通常意味着提问方式更加清晰和周全。当你花时间以礼貌措辞表达需求时,往往也更具体、更明确。此外,提示的风格还可以暗示 AI 你期望的回复格式——无论是技术解释、创意思考、步骤指导还是摘要。

**在提示中提供上下文和背景信息能极大提升 AI 生成相关且准确回复的能力。**上下文不仅帮助 AI 理解你在问什么,还能理解你为什么问、打算如何使用答案。这样,AI 就能针对你的实际情况定制回复,而非仅仅提供可能不适用的通用信息。

比如,询问营销策略时,AI 的回答会因为你的身份不同而大相径庭——你是一个预算 5,000 美元的初创企业,还是预算 50 万美元的成熟公司,或是资源有限的非营利机构。提前提供这些背景,可让 AI 给出真正适合你的建议。同理,如果你在询问技术实现,提前说明你的技术栈、团队规模和时间表,也能让 AI 给出切实可行的建议。上下文能将泛泛建议转化为个性化指导,因此有经验的 AI 用户总会在提示中投入时间补充相关背景信息。

**与 AI 协作时,最有效的方法是将提示开发视为一个迭代过程,而非一次性互动。**你可以先提出初始提示,评估回复效果,找出优缺点,再根据这些见解不断完善提示。通过这种迭代方法,你能逐步提升从同一个 AI 系统获得的回复质量。每一次完善,都能让你更接近适合自身需求的最佳提示。

迭代优化包括几个步骤。首先,基于自身需求制定初始提示。其次,分析 AI 回复,发现其是否理解了你的意图、是否达到了所需细节、是否关注了正确的主题。第三,你根据这些观察调整提示,例如增加具体性、补充上下文、调整语气或完全重构问题。第四,测试优化后的提示并评估新回复。如此循环,直到回复达到你的预期标准。擅长这一迭代过程的机构或个人,往往能比把每个提示都当作独立互动的人,持续获得更佳的 AI 输出效果。

**不同类型的提示适用于不同目标,理解何时用哪种类型对你的需求至关重要。**Zero-shot(零样本)提示让 AI 在没有任何示例的情况下完成任务,完全依赖预训练知识。Few-shot(少样本)提示则提供一到多个期望输出格式或方法的示例,帮助 AI 理解你想要的模式。Chain-of-thought(思维链)提示要求 AI 明确展示其推理步骤,这对于复杂问题求解尤为有效。Meta-prompt(元提示)则引导 AI 反思自身推理或能力,有助于其改进思路。

这些提示类型会带来不同的回复。例如,零样本提示适合翻译句子或回答直接事实性问题。少样本提示适合让 AI 遵循特定格式输出,比如你想让它生成特定格式的 JIRA 工单时,就可以提供几个格式良好的示例。思维链提示在解决复杂数学题或需要细致推理时尤为重要,因为此时推理过程本身与最终答案同等重要。**为你的任务选择合适的提示类型,能显著提升 AI 回复的质量和实用性。**许多高级用户还会在单一提示中结合多种类型——如提供示例(少样本)、要求逐步推理(思维链)、并请求对方法的反思(元提示)——以获得最佳结果。

**真实案例显示,微小的提示调整可极大提升 AI 回复质量。**比如,一位企业主想了解营销策略。初始提示“介绍一下营销”只会让 AI 给出营销原理、渠道和策略的泛泛概述。虽然准确,却缺乏针对性,也不够实用。

若将提示优化为“有哪些适合资金有限、以可持续时尚产品为主、面向环保意识强且年龄在 25-40 岁消费者的电商初创企业的高性价比数字营销策略?”,则加入了多项具体约束(资金有限、高性价比)、业务模式(电商)、产品类别(可持续时尚)、目标受众(环保意识强、25-40 岁)。AI 针对该提示会专注于真正适合初创企业、契合目标群体价值观、且适合该产品类别的策略。两者之间的实用性差距极大,而唯一变化就只是让提示更具体、更具上下文。

再举一个技术问题的例子。与其问“如何优化我的网站?”,不如问“针对目前主关键词排名第二页、且本人只懂基础 HTML 且无开发人员的 WordPress 博客,应该优先实施哪些五大技术 SEO 改进?”这个优化后的提示提供了平台(WordPress)、当前表现(排名第二页)、提问者技能(基础 HTML)、约束条件(无开发人员)。AI 因此可以推荐提问者能实际操作的方案,而不是需要开发者的泛泛建议。

**虽然提示质量极大影响回复质量,但即便是最完美的提示,也不能保证每次都得到完全一致的回复。**语言模型本身具有一定的随机性——它们的回复是概率生成的,因此同一提示在不同场合可能会产生略有不同的答案。这种随机性其实是一种特性,而非缺陷,因为它能让 AI 生成更具创造性和多样性的回复。但当你需要高度一致、可靠的输出(比如集成系统或自动化流程时),这种可变性就需要被考虑在内。

要获得更高的一致性,你可以调低许多 AI 系统中的 temperature 参数(温度越低,回复越稳定和聚焦),提供非常具体的格式说明,或用少样本提示给出格式示例。**目标是设计出能以最小变化反复输出高质量、相关内容的提示。**对于将 AI 集成进业务、需要稳定可靠表现的企业来说,这种一致性与质量的平衡尤为重要。

**了解提示工程的局限性,与了解其强大同样重要。**即使提示设计得再完美,也无法突破 AI 模型训练数据和能力的根本限制。如果模型训练数据中没有某一主题的信息,再怎么完善提示也不可能获得准确答案。同样,如果任务超出了模型本身的能力范围,更好的提示也无法让 AI 做到。

此外,AI 模型有时会自信地给出错误信息,这被称为“幻觉”。虽然精心设计的提示可以降低出现幻觉的概率,但无法完全消除。因此,当需要将 AI 回复用于重要决策时,务必对关键内容进行核实。有些提示之所以有效,可能只是因为模型训练时包含了类似示例,而非模型真正理解了底层原理。清楚这些局限,能帮助你更有效地利用 AI,避免在关键任务中过度依赖其输出。

社区讨论用户提示如何影响AI回应及品牌可见性。市场人员分析提示模式及其对在ChatGPT和Perplexity答案中出现的意义。

了解什么是提示工程,其如何与 ChatGPT、Perplexity 等 AI 搜索引擎协作,并探索优化 AI 搜索结果、获取更好答案的关键技术。...

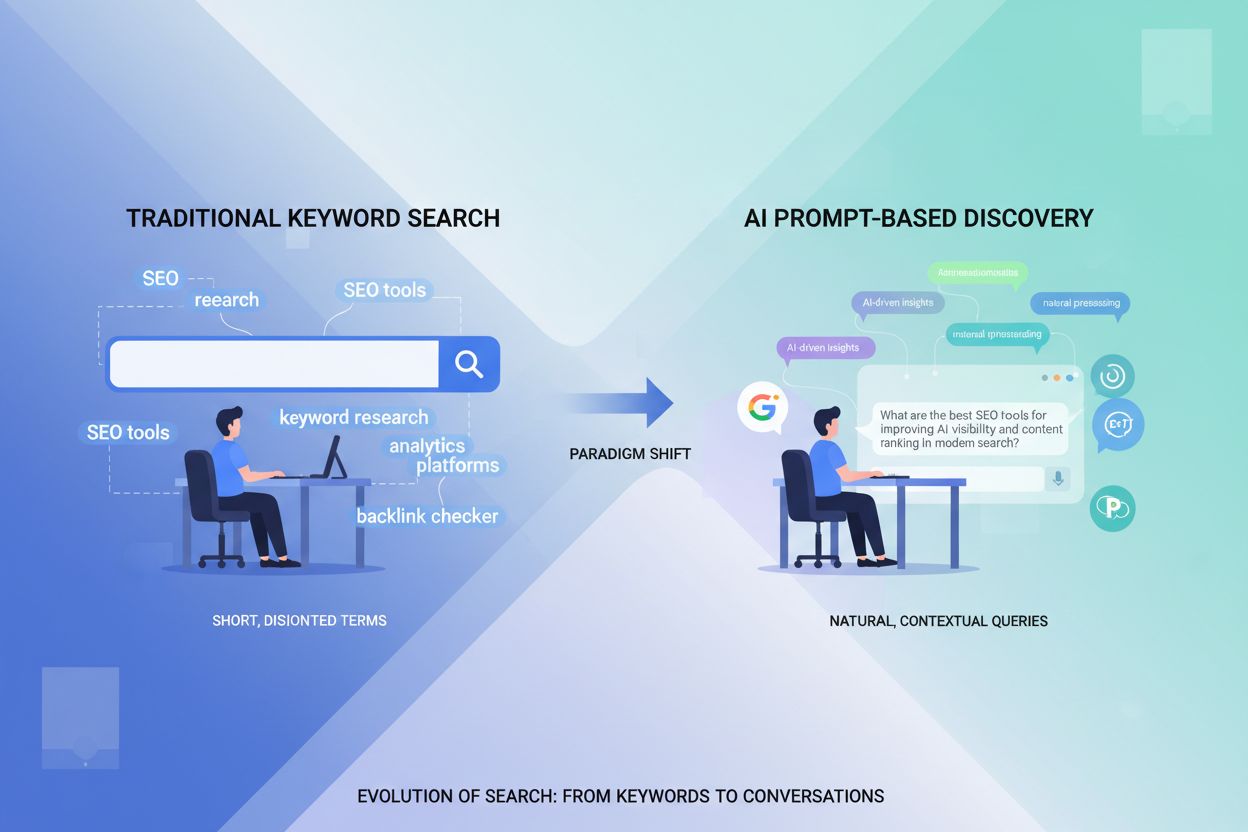

了解在以 AI 为驱动的搜索中,提示词研究如何取代传统关键词研究。学习两者的方法论差异,并优化您的内容以适应 ChatGPT、Gemini 和 Perplexity 等生成式引擎。...

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.