AI 源选择

了解 AI 系统如何选择和排序引用来源。探索决定 ChatGPT、Perplexity、Google AI Overviews 等 AI 平台在回答中引用哪些网站的算法、信号和因素。...

了解人工智能中的源选择偏差,它如何影响机器学习模型、真实案例,以及检测和缓解这一关键公平性问题的策略。

源选择偏差是指训练数据无法代表整体人群或真实世界分布,导致 AI 模型对被低估群体或情境做出不准确预测的现象。

源选择偏差 是人工智能领域的一个基本问题,发生在用于训练机器学习模型的数据无法准确代表其服务对象的真实世界人群或分布时。这类偏差产生于数据集的选择方式,系统性地排除了某些群体、情境或特征,或使其代表性不足。结果是,AI 模型从不完整或失衡的数据中学习模式,导致对被低估群体的预测不准确、不公平,甚至带有歧视性。理解这种偏差对于任何开发、部署或依赖 AI 系统的人来说都至关重要,因为它直接影响到自动化决策的公平性、准确性和可靠性。

源选择偏差不同于其他形式的偏见,因为它起源于数据收集阶段本身。它不是在模型开发过程中由算法选择或人为假设导致的,而是深植于训练数据集的基础中。这使得它尤其隐蔽,因为即使算法再先进,训练于有偏源数据上的模型也会在预测中延续并放大这些偏见。当 AI 系统应用于医疗、金融、刑事司法、招聘等高风险领域时,这一问题尤为严重,因为偏见预测会对个人和社区产生重大影响。

源选择偏差在数据收集与整理过程中,通过几种不同机制形成。最常见的路径是 覆盖偏差,即某些人群或情境被系统性地排除在训练数据集之外。例如,如果一个人脸识别系统主要用浅色皮肤者的图像训练,那么它对深色皮肤面孔的覆盖就很差,导致这些群体的错误率更高。这通常是因为数据收集者接触多样化人群的能力有限,或在收集数据时无意识地优先考虑了某些群体。

另一个关键机制是 非响应偏差,也叫参与偏差,指某些群体在数据收集过程中参与意愿较低。比如用于预测消费者偏好的调查数据集:如果特定人口群体明显更少响应调查,他们的偏好在训练数据中就会被低估。这样看似均衡的数据实际上反映的是参与模式,而非真实人群特征。以医疗为例,如果临床试验数据主要来自有条件接受先进医疗设施的城市人口,训练出的 AI 模型就难以适用于农村或服务不足的社区。

抽样偏差 是第三种机制,指数据收集时没有采取适当的随机化。数据收集者可能仅选择最先获得的样本,或采用便利抽样方法。这会引入系统性误差,因为所选样本无法代表更广泛的人群。例如,若贷款违约预测 AI 模型仅以某一地区或时间段的数据训练,就难以准确预测其他地区或时期的违约情况。

| 偏差类型 | 机制 | 真实案例 |

|---|---|---|

| 覆盖偏差 | 系统性排除某些人群 | 仅用浅色皮肤者训练的人脸识别 |

| 非响应偏差 | 数据收集参与度缺口 | 仅用城市人群训练的医疗模型 |

| 抽样偏差 | 选择时缺乏随机性 | 仅用单一地区数据训练的贷款模型 |

| 时间偏差 | 仅用特定时期的数据 | 只用疫情前数据训练、应用于疫情后模型 |

| 来源多样性偏差 | 数据来源有限 | 仅来自单一医院系统的医学影像数据集 |

AI 系统中的源选择偏差会产生深远影响,既影响个人,也影响组织。在 医疗 领域,源选择偏差导致诊断系统对某些患者群体表现显著较差。研究表明,皮肤癌诊断的 AI 算法在深色皮肤患者中准确率远低于浅色皮肤患者,有的研究显示准确率仅为后者的一半。这种差异直接导致诊断延误、治疗建议不当和难以改善的健康结局。训练数据主要来源于某一人口群体时,模型只学到该群体的特定模式,难以泛化到其他人群。

在 金融服务 领域,信用评分和贷款算法中的源选择偏差加剧了历史歧视。若模型训练于反映过去歧视性贷款记录的历史数据,它在做出新决策时会复制同样的偏见。如果某些群体因系统性歧视过去常被拒绝贷款,而这些历史数据被用于 AI 训练,模型就会继续否决相似群体的贷款申请。这样,历史不公被嵌入到算法决策中,影响个人的资金获取及经济机会。

招聘与人才筛选 也是源选择偏差导致严重危害的关键领域。用于简历筛选的 AI 工具被发现对种族和性别存在偏见,一些系统中带有白人特征的名字被优先选中的概率高达 85%。当训练数据来自带有历史歧视或同质化的招聘记录时,AI 模型就学会复制这些偏见。招聘数据中的源选择偏差导致大规模的职场歧视,限制了被低估群体的机会,降低了职场多样性。

在 刑事司法 领域,预测性警务系统中的源选择偏差导致某些社区被过度监控。训练数据若基于本身对边缘群体有偏见的历史逮捕记录,模型就会放大这些偏见,对这些社区预测更高犯罪率。由此形成反馈循环:偏见预测导致某些地区警力加强,进而产生更多逮捕数据,进一步加深模型中的偏见。

检测源选择偏差需要系统化方法,结合定量分析、定性评估与持续监控。第一步是进行 全面的数据审计,检查训练数据的来源、收集方式和代表性。这包括记录数据来源、收集过程,以及该过程是否系统性地排除了某些群体或情境。需提出关键问题:所有相关人口群体是否都被代表?是否存在某些群体参与障碍?数据收集的时间或地理范围是否限制了代表性?

人口均衡性分析 提供了检测源选择偏差的定量方法。需将训练数据中关键特征的分布与模型服务对象的实际人群分布进行对比。如果训练数据严重低估某些群体、年龄段、区域或其他特征,就有源选择偏差。例如,若训练数据中女性比例仅为 5%,但目标人群为 50%,这就显示出严重的覆盖偏差,极可能导致模型对女性表现不佳。

性能分组分析 也是关键检测技术,即分别评估模型在不同群体和子人群中的表现。即使整体准确率看似可接受,分组表现可能差异巨大。如果模型总体准确率为 95%,但对某一群体仅为 70%,说明训练数据中的源选择偏差使模型只学会了多数群体的模式,忽视了少数群体。此分析不仅要看整体准确率,也要关注“公平性”指标,如均等机会、差异影响等。

对抗性测试 则是有意构造测试用例以暴露潜在偏见,包括用被低估群体、极端情况或训练数据中罕见的情境进行测试。通过对模型进行多样化压力测试,可发现源选择偏差导致的盲区。例如,若模型主要用城市数据训练,应大量用农村数据测试其表现;若训练数据来自特定时期,应用不同时间段的数据检测时间偏差。

缓解源选择偏差需在 AI 开发全流程多层次介入,从数据收集到模型评估与部署。最有效的方法是 数据为中心的缓解,即从源头提升训练数据的质量与代表性。首先要 多样化数据收集,主动将被低估群体和情境纳入数据集。不应仅依赖便利抽样或现有数据集,组织应有针对性地收集,确保所有相关人口和应用场景得到足够代表。

重采样与重加权技术 是应对现有数据不平衡的实用方法。随机过采样可复制被低估群体的样本,随机欠采样则减少被高估群体样本。更复杂的分层采样可同时保证多个维度的比例代表性。重加权则在模型训练时提高被低估样本的权重,引导算法关注少数群体模式。这些技术应与多样化数据收集结合使用,而非仅靠对有限数据的重采样。

合成数据生成 也是缓解源选择偏差的有效途径,尤其是在难以或成本较高地收集真实数据时。生成对抗网络(GAN)、变分自编码器(VAE)等技术可以为被低估群体生成逼真的合成样本。更有针对性的 SMOTE(合成少数类过采样技术)可通过现有少数样本插值生成新样本。但合成数据需谨慎使用并充分验证,否则可能引入新的偏差。

公平感知算法 则是训练阶段的缓解策略,这类算法在学习过程中明确加入公平约束,确保模型在所有群体上表现均衡,而非只关注多数群体。例如,对抗去偏网络通过引入对抗网络,确保模型预测无法推断受保护特征(如种族、性别);公平正则化通过损失函数惩罚歧视性行为。这些方法可在准确性与公平性之间权衡,选择符合伦理优先级的平衡点。

持续监控与再训练 则确保源选择偏差不会随时间出现或加剧。即使最初训练数据很具代表性,模型服务的真实分布也可能因人口变迁、经济变化等因素发生变化。建立模型在不同群体上的表现监控系统,能及时发现偏差,一旦性能下降,可通过用最新数据再训练恢复公平性。这一过程强调,缓解偏差不是一次性任务,而是持续责任。

在 AI 答案监控与品牌曝光跟踪 的背景下,理解源选择偏差愈发重要。随着 ChatGPT、Perplexity 等 AI 问答生成器成为用户主要信息来源,其引用的信息和内容受训练数据影响。若 AI 系统训练数据存在源选择偏差,其生成的答案也会体现这种偏见。例如,若 AI 系统的训练数据过度代表某些网站、出版物或观点,低估了其他来源,那么 AI 生成的答案就更倾向于引用和放大被高估来源的信息。

这对品牌监控和内容可见性有直接影响。如果您的品牌、域名或网址在主流 AI 系统训练数据中代表性不足,您的内容可能被系统性地排除或低估于 AI 答案中。反之,若竞争品牌或虚假信息来源在训练数据中被高估,它们在 AI 答案中获得的曝光会不成比例。监控您的品牌在不同平台 AI 答案中的出现频率,可帮助发现这些系统中的源选择偏差是否影响了您的品牌可见性和声誉。通过追踪被引用来源、内容出现频率及信息准确性,可识别 AI 系统如何在行业和品牌层面展现潜在偏见。

人工智能中的源选择偏差是源自数据收集阶段、并贯穿整个机器学习应用流程的关键公平性问题。当训练数据系统性地排除或低估某些人群、情境或特征,模型便会对这些群体做出不准确或不公平预测。其影响深远,涉及医疗健康、金融服务、就业机会和刑事司法决策。检测源选择偏差需全面数据审计、人口均衡性分析、性能分组分析和对抗性测试。缓解偏差需多管齐下,包括多样化数据收集、重采样与重加权、合成数据生成、公平感知算法及持续监控。组织应认识到,解决源选择偏差不是可选项,而是构建公平、准确、值得信赖的 AI 系统(无论应用于哪个群体或场景)的基础。

了解 AI 系统如何选择和排序引用来源。探索决定 ChatGPT、Perplexity、Google AI Overviews 等 AI 平台在回答中引用哪些网站的算法、信号和因素。...

社区讨论 AI 系统中的来源选择偏见。营销人员和研究人员的真实经验,帮助理解和应对 AI 偏爱的引用模式。

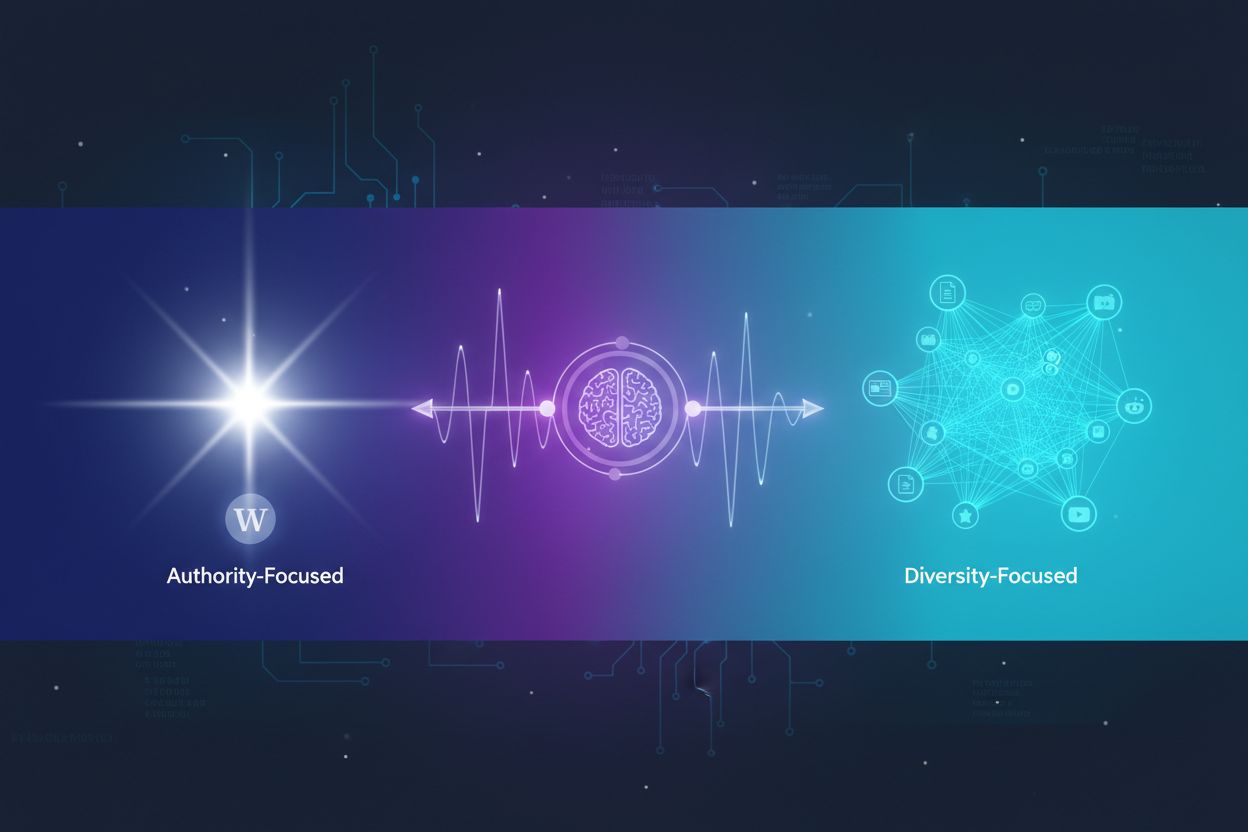

了解AI系统如何在引用多个来源和集中于权威来源之间做出决策。掌握ChatGPT、Google AI Overviews、Perplexity和Gemini等平台的引用模式,并优化您的内容以提升在AI中的可见度。...

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.