向量搜索

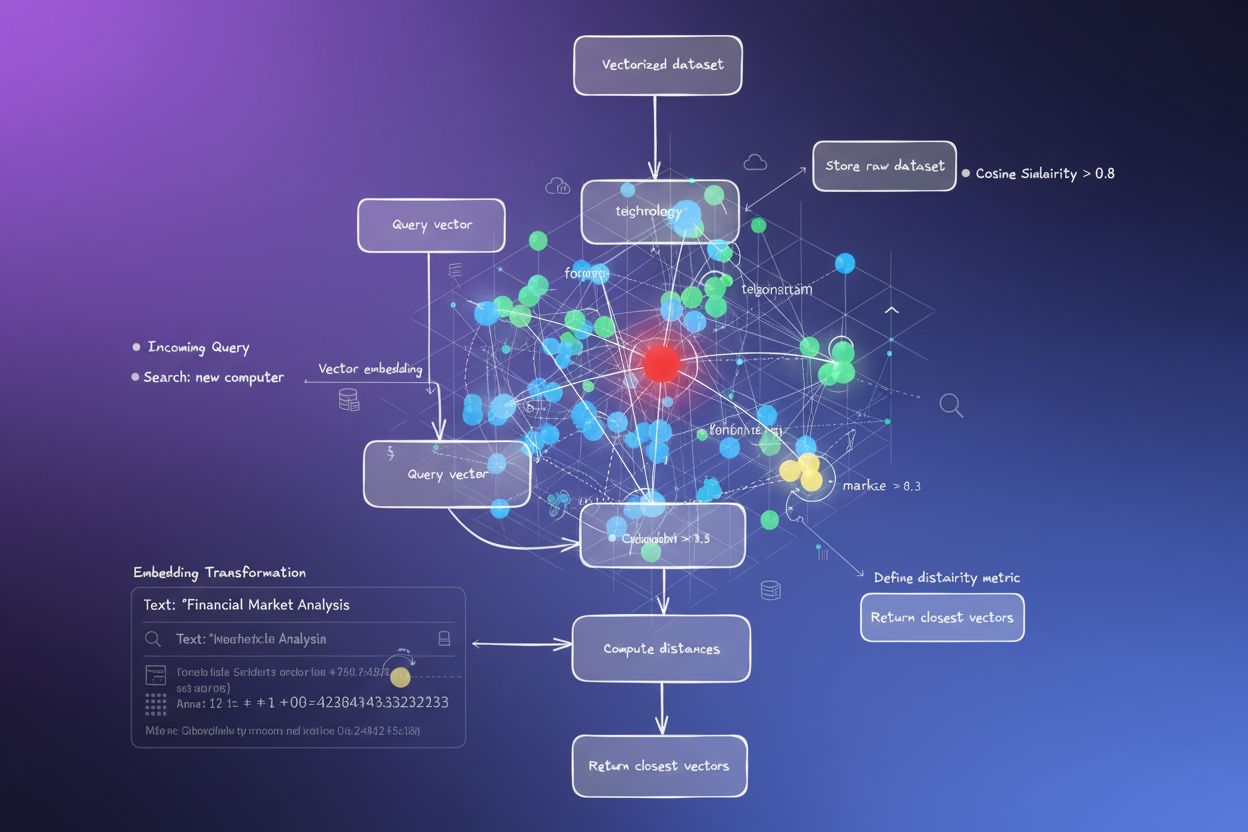

向量搜索利用数学向量表示,通过衡量语义关系来查找相似数据。了解嵌入、距离度量和 AI 系统如何利用向量搜索实现语义理解。...

余弦相似度是一种数学度量,通过计算两个非零向量之间夹角的余弦值来衡量它们的相似程度,得分范围从-1到1。它广泛应用于机器学习、自然语言处理和人工智能系统,用于衡量文本嵌入和向量表示之间的语义相似性,而不受向量大小的影响。

余弦相似度是一种数学度量,通过计算两个非零向量之间夹角的余弦值来衡量它们的相似程度,得分范围从-1到1。它广泛应用于机器学习、自然语言处理和人工智能系统,用于衡量文本嵌入和向量表示之间的语义相似性,而不受向量大小的影响。

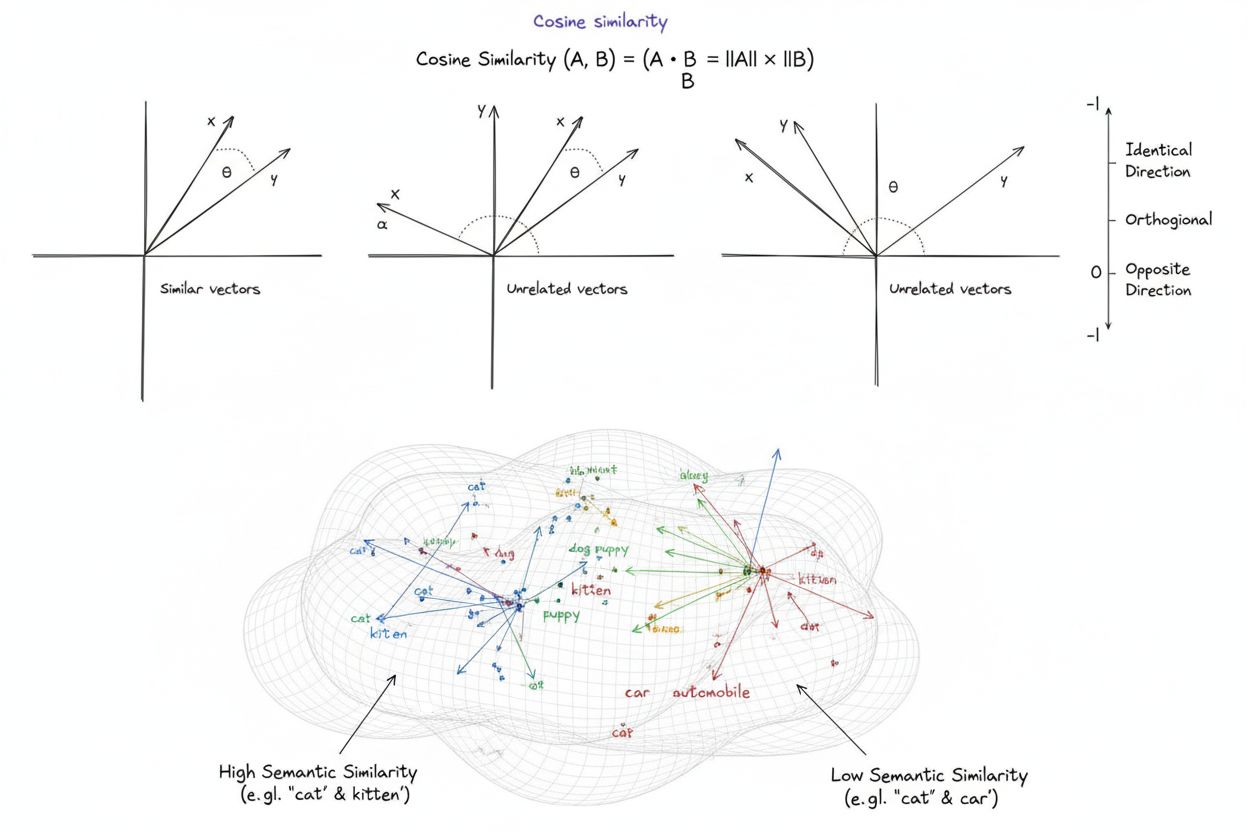

余弦相似度是一种数学度量,通过在多维空间中计算两个非零向量之间的夹角余弦来判断它们的相似程度。该度量产生的分数范围为**-1到1**,其中1表示向量方向完全一致,0表示向量正交(垂直)即没有方向相关性,-1表示向量完全相反。在实际应用中,余弦相似度尤其有价值,因为它衡量的是方向对齐而非绝对距离,从而与向量大小无关。这一特性使其在比较文本嵌入、文档向量和语义表示时非常实用,避免了数据长度或规模对相似性判断的影响。该度量已成为现代人工智能、自然语言处理与机器学习系统的基础,驱动了从搜索引擎到推荐算法再到大语言模型应用的方方面面。

余弦相似度的概念源自基础线性代数和三角学,其中两个向量夹角的余弦提供了它们方向对齐程度的归一度量。其数学基础依赖于向量的点积(内积)和模长,形成了一种既高效又理论严谨的归一化相似性指标。历史上,余弦相似度在20世纪70~80年代的信息检索领域崭露头角,当时研究者需要高效方法在大规模文本语料库中比较文档向量。随着机器学习和深度学习在2010年代的兴起,特别是神经网络用于生成高维向量嵌入以表示文本、图像等数据类型后,该度量被广泛采用。如今,研究表明,在实施AI驱动系统的企业中,超过78%的数据管道采用余弦相似度或相关向量比较指标。其数学简洁性与计算效率的结合,使其成为NLP应用中衡量语义相似性的事实标准,OpenAI、Google、Anthropic等主流平台均将其作为核心算法之一。

余弦相似度的计算遵循严格的数学公式:余弦相似度 = (A · B) / (||A|| × ||B||),其中A · B代表向量A和B的点积,而**||A||和||B||分别是它们的模或欧氏范数。进行点积时,将两个向量对应分量相乘后求和。例如,若向量A为[3, 2, 0, 5],向量B为[1, 0, 0, 0],则点积为(3×1)+(2×0)+(0×0)+(5×0)=3。向量的模为各分量平方和的平方根;A的模为√(3²+2²+0²+5²)=√38≈6.16。最终的余弦相似度分数等于点积除以模的乘积,得到-1到1之间的归一化值。这种归一化至关重要,使得度量与向量长度无关,可公平比较不同规模的向量。在如OpenAI text-embedding-ada-002**模型产生的1536维嵌入等高维空间中,余弦相似度依然计算高效,仅需基本的乘法、加法和开方运算,即便在数百万向量中也能高效执行。

在自然语言处理领域,余弦相似度成为衡量文本表示语义关系的核心。当文本通过如BERT、Word2Vec、GloVe或GPT系列嵌入等模型转化为向量嵌入后,每个词、短语或文档都成为高维空间中的一个点,其语义通过向量的位置和方向编码。余弦相似度衡量这些语义表示的对齐程度,使系统能够理解“医生”与“护士”虽然词汇不同但语义相关。这对于语义搜索至关重要,用户的查询会被转为向量,与文档向量比较以找到最相关的结果,无需精确关键词匹配。在ChatGPT、Claude、Perplexity等大语言模型中,余弦相似度支撑着从训练数据或外部知识库检索相关上下文的机制。其对向量模的无敏感性在NLP中尤为重要,因为文档长短不应决定相关性——一篇简明的文章在语义上可能比冗长文档更贴合查询。研究表明,在比较文本嵌入时,余弦相似度在约**85%**的NLP基准测试中优于欧氏距离等其他指标,成为AI行业语义理解任务的首选。

| 指标 | 计算方法 | 取值范围 | 对模的敏感性 | 最佳应用场景 | 计算复杂度 |

|---|---|---|---|---|---|

| 余弦相似度 | (A·B) / ( | A | × | ||

| 欧氏距离 | √(Σ(Aᵢ - Bᵢ)²) | 0到∞ | 是(依赖模) | 空间数据、聚类、物理距离 | O(n) - 高效 |

| 点积 | Σ(Aᵢ × Bᵢ) | -∞到∞ | 是(对规模敏感) | 原始相似性度量,未归一化 | O(n) - 非常高效 |

| 杰卡德相似度 | |A ∩ B| / |A ∪ B| | 0到1 | 否(基于集合) | 分类数据、推荐系统 | O(n) - 高效 |

| 曼哈顿距离 | Σ|Aᵢ - Bᵢ| | 0到∞ | 是(依赖模) | 网格数据、特征比较 | O(n) - 高效 |

| 皮尔逊相关系数 | Cov(A,B) / (σₐ × σᵦ) | -1到1 | 否(归一化) | 统计关系、时间序列 | O(n) - 高效 |

向量数据库如Pinecone、Weaviate、Milvus和Qdrant专门用于用余弦相似度作为主相似性度量,存储与检索高维向量。这些数据库优化支持数百万乃至数十亿向量,实现大规模实时语义搜索。当查询被提交到向量数据库时,会先转化为嵌入,与所有存储向量通过余弦相似度比较,并按相似度得分排序。为应对大规模数据集的性能需求,向量数据库采用近似最近邻(ANN)算法,如HNSW和DiskANN,以牺牲微小准确性换取显著速度提升。例如,Timescale的pgvectorscale扩展实现的StreamingDiskANN,其延迟比专用向量数据库如Pinecone低28倍,查询吞吐量高16倍,同时以75%更低成本维持99%召回率。在语义搜索应用中,余弦相似度让系统理解用户意图超越字面关键词匹配——如查询“健康饮食习惯”时,会检索到“营养建议”“均衡饮食”等内容,因为它们的嵌入方向接近,虽用词不同。此能力彻底改变了信息检索,实现了基于语义的相关结果推荐,满足用户意图。

检索增强生成(RAG)代表了大语言模型获取和利用信息的新范式,余弦相似度是其核心。在典型的RAG流程中,用户提交查询后,系统先用与知识库一致的嵌入模型将查询转为向量嵌入。通过余弦相似度,系统将查询向量与知识库所有文档向量比较,按相关性排序。得分最高的文档被检索出来,作为上下文交给LLM生成基于真实数据的响应。这种做法解决了独立LLM的诸多局限:如知识截止、幻觉等问题,以及无法访问实时或专有数据。通过余弦相似度实现智能检索,RAG系统确保LLM基于最新、可验证的信息作答。主流RAG实现包括OpenAI ChatGPT插件、Anthropic Claude检索、Google AI Overviews和Perplexity答案生成引擎。研究显示,基于余弦相似度检索的RAG系统,回答准确率比独立LLM提高约40-60%,幻觉率降低可达70%。由于RAG系统需在百万级文档中实时比较相似性,余弦相似度的计算简洁性尤为关键,使得大规模应用成为可能。

高效应用余弦相似度需关注若干关键因素。首先,数据预处理至关重要——向量在计算前需归一化,以确保尺度一致和计算有效,特别是在处理来自不同来源的高维输入时。需去除或标记零向量(全为零的向量),因余弦相似度对其数学上未定义,否则会导致除零错误。在生产系统中,建议将余弦相似度与杰卡德相似度或欧氏距离等其他指标结合,满足多维相似性需求,而非单独依赖。部署前应在近似生产环境中充分测试,特别是API和搜索引擎等实时场景,因性能和准确性直接影响用户体验。常用库大幅简化实现:Scikit-learn 提供 sklearn.metrics.pairwise.cosine_similarity(),NumPy 可用 np.dot() 和 np.linalg.norm() 直接实现公式,TensorFlow 和 PyTorch 支持大规模计算的GPU加速版本,PostgreSQL配合pgvector 实现数据库级余弦相似度查询。对于监控AI提及和品牌曝光的企业,余弦相似度可精准比较查询嵌入和品牌/域名存储向量,实现平台如ChatGPT、Perplexity、Google AI Overviews等内容的追踪。

尽管被广泛采用,余弦相似度仍有诸多挑战需注意。其对零向量未定义,因此需在数据预处理和校验时剔除,否则会在运行时导致错误。对于方向一致但语义无关的向量,尤其是在嵌入模型训练不足或数据单一时,余弦相似度可能产生高分误判(“伪相似”)。在诸如AI监控等应用中,这种误判可能导致品牌漏检或误报。该指标的对称性——即无法区分比较顺序——在某些需关心方向性的场景中并不理想。此外,现实中得分为0不一定代表完全无关;在语言等复杂场景下,正交向量间仍可能存在微妙的语义联系。其对归一化高度依赖,若数据未妥善归一化,结果会被扭曲,因此应确保所有向量一致预处理。最后,余弦相似度有时难以独立胜任复杂相似性场景,需与其他指标和领域规则结合,才能获得更健壮的效果。

随着嵌入模型愈发先进、向量架构主导机器学习,余弦相似度在AI系统中的作用持续演变。新趋势包括与混合搜索结合,将向量相似性与传统全文检索融合,从而兼具语义理解和关键词匹配能力。多模态嵌入(将文本、图像、音频、视频等统一在同一向量空间表示)日益依赖余弦相似度测量跨模态关系,实现如图文检索、视频理解等应用。更高效的近似最近邻算法(如DiskANN、HNSW)持续提升余弦相似度检索的可扩展性,使超大规模语义检索成为现实。量化技术通过降低向量维度且保留余弦相似度关系,使大规模检索可落地边缘设备和资源有限环境。在AI监测与品牌追踪中,余弦相似度地位日益重要,帮助企业洞悉ChatGPT、Perplexity、Claude、Google AI Overviews等系统如何引用和提及自身内容。未来,或将出现可根据领域特性自适应的余弦相似度,以及与可解释性框架集成,帮助用户理解为何判定两向量相似。随着向量数据库成熟并成为AI基础设施,余弦相似度仍将是主流语义比对指标,但可能与领域特定的相似性度量协同,满足多样化应用需求。

对于像AmICited这样监测品牌和域名在AI系统中提及的平台,余弦相似度是关键技术基石。在监控ChatGPT、Perplexity、Google AI Overviews、Claude等系统对特定域名或品牌的引用时,余弦相似度可精准衡量用户查询与AI回复之间的语义相关性。通过将品牌提及、域名URL和查询内容转为向量嵌入,余弦相似度可判断AI回复是真正引用某品牌还是仅涉及相关概念。这对于企业了解自身在AI生成内容中的曝光度,以及追踪自身知识产权被AI系统归属与引用的方式至关重要。该指标的高效性使其适用于数百万AI交互的实时监控,让企业在内容被引用时可即时收到提醒。此外,余弦相似度还支持对比分析——企业不仅能监测是否被提及,还能比较自身与竞争对手在被AI引用频率和相关性上的差异,为AI系统行为和内容来源模式提供竞争情报。

余弦相似度得分为1表示两个向量完全朝相同方向,意味着它们完全相似。得分为0表示向量正交(垂直),说明没有方向上的关联或相似性。得分为-1表示向量完全朝相反方向,代表完全不相似。在实际NLP应用中,接近1的分数表示语义上相似的文本,接近0的分数则表示内容无关。

在文本嵌入中偏好使用余弦相似度,因为它衡量的是向量之间的夹角而非绝对距离,因此对向量大小不敏感。这对于NLP非常重要,因为文档长度不应影响语义相似性——短查询和长文章在语义上也可以同样相关。相比之下,欧氏距离对大小敏感,并且在高维空间中表现较差,因为向量往往趋于收敛。余弦相似度还具有更高的计算效率,并且自然限定在-1到1之间,避免溢出问题。

在RAG系统中,余弦相似度在检索阶段通过比较查询嵌入与文档嵌入(在向量数据库中)来提供动力。当用户提交查询时,系统使用与存储文档相同的嵌入模型将其转换为向量。然后通过余弦相似度按相关性对文档进行排序,得分越高匹配越好。排名靠前的文档被检索并作为上下文传递给LLM,从而实现更准确且事实依据更充分的响应。该过程帮助RAG系统克服大模型的诸如知识过时和幻觉等局限。

余弦相似度存在若干局限:当向量模为零时未定义,需要预处理以去除零向量。对于方向一致但语义无关的向量,尤其是在嵌入训练不足时,可能产生误导性高的相似度分数。该指标是对称的,无法区分比较顺序,这在某些应用场景可能是问题。此外,在现实中得分为0不一定表示完全不相似,尤其是在语言等复杂领域,正交向量仍可能存在语义联系。

余弦相似度的计算公式为:(A · B) / (||A|| × ||B||),其中A · B是向量A和B的点积,||A||和||B||是它们的模(欧氏范数)。点积通过将对应分量相乘后求和得到。向量的模是其各分量平方和的平方根。该公式的结果被归一化到-1和1之间,使其与向量长度无关,适合比较不同规模的向量。

在如AmICited这样的AI监测平台中,余弦相似度对于追踪品牌和域名在ChatGPT、Perplexity、Google AI Overviews等AI系统中的提及至关重要。通过将品牌提及和查询转换为向量嵌入,余弦相似度衡量AI生成回复与被监测内容之间的紧密程度。这让企业能够监测自身域名是否出现在AI答复中,评估提及的语义相关性,并追踪AI系统对其内容与竞争对手内容的引用情况。该指标的高效性使其适用于对数百万AI交互的实时监测。

主要AI平台和工具利用余弦相似度包括OpenAI的嵌入模型、Google的语义搜索算法、Perplexity的答案生成系统和Claude的检索机制。像Pinecone、Weaviate、Milvus等向量数据库将余弦相似度作为主要的相似性指标。Scikit-learn、TensorFlow、PyTorch和NumPy等开源库都内置了余弦相似度函数。PostgreSQL配合pgvector扩展也能大规模计算余弦相似度。这些工具共同驱动了推荐系统、聊天机器人、语义搜索引擎与RAG等AI应用。

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.