什么是 AI 抓取预算?理解 AI 机器人资源分配

了解 AI 的抓取预算是什么意思、它与传统搜索抓取预算有何不同,以及它为何对您的品牌在 AI 生成答案和 AI 搜索引擎中的可见性至关重要。...

确保AI爬虫在其爬取限制内高效访问并索引网站最重要内容的技术。爬取预算优化管理爬取能力(服务器资源)与爬取需求(机器人请求)之间的平衡,以最大化在AI生成答案中的可见性,同时控制运营成本和服务器负载。

确保AI爬虫在其爬取限制内高效访问并索引网站最重要内容的技术。爬取预算优化管理爬取能力(服务器资源)与爬取需求(机器人请求)之间的平衡,以最大化在AI生成答案中的可见性,同时控制运营成本和服务器负载。

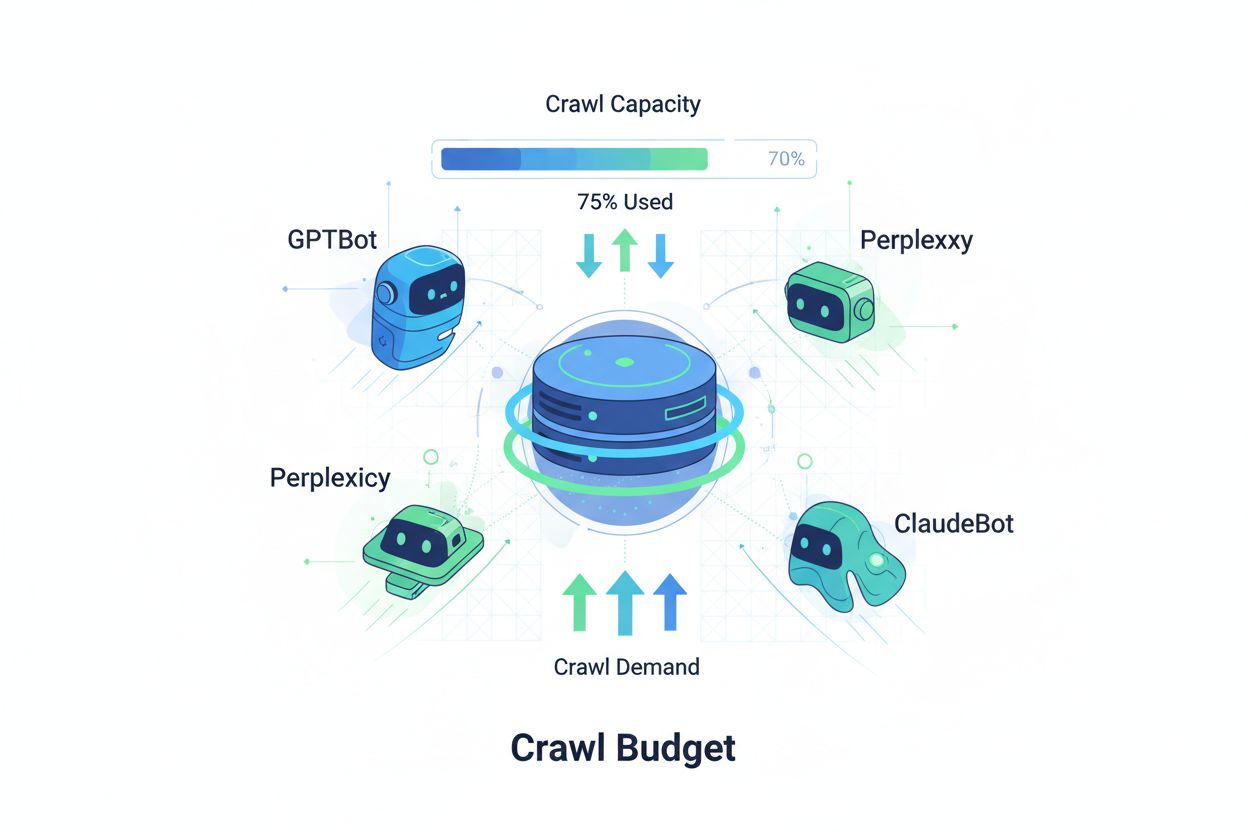

爬取预算是指搜索引擎和AI机器人分配给您网站的爬取资源(以请求次数和带宽计算)。传统上,这一概念主要应用于Google的爬取行为,但AI驱动的机器人出现后,彻底改变了组织对爬取预算管理的思考方式。爬取预算方程包含两个关键变量:爬取能力(机器人能爬取的最大页面数)和爬取需求(机器人实际想爬取的页面数)。在AI时代,这一动态变得极其复杂,因为GPTBot(OpenAI)、Perplexity Bot和ClaudeBot(Anthropic)等机器人与传统搜索引擎爬虫争夺服务器资源。这些AI机器人与Googlebot有着不同的优先级和模式,往往消耗更多带宽,追求不同的索引目标,使得爬取预算优化不再是可选项,而是维持网站性能和控制运营成本的必需手段。

AI爬虫在爬取模式、频率和资源消耗上与传统搜索引擎机器人有本质区别。Googlebot会遵守爬取预算限制,并采用复杂的节流机制,而AI机器人往往更激进,甚至多次请求同一内容,并不太关注服务器负载信号。研究表明,OpenAI的GPTBot在某些大型内容网站上的带宽消耗是Google爬虫的12-15倍,尤其是内容库庞大或页面更新频繁的网站。这种激进行为源自AI训练需求——这些机器人需要持续摄取新内容以提升模型性能,其爬取理念与以检索为导向的搜索引擎截然不同。服务器影响显著:不少组织报告AI机器人流量直接导致带宽成本、CPU利用率和服务器负载大幅上升。而且,多个AI机器人同时爬取的累积效应会降低用户体验、拖慢页面加载速度并增加主机费用,使得区分传统与AI爬虫成为业务层面的关键考量,而非技术细节。

| 特性 | 传统爬虫(Googlebot) | AI爬虫(GPTBot, ClaudeBot) |

|---|---|---|

| 爬取频率 | 自适应,尊重预算 | 激进,持续爬取 |

| 带宽消耗 | 适中,优化处理 | 高,资源密集型 |

| 对robots.txt的遵守 | 严格遵守 | 遵守情况不一 |

| 缓存行为 | 高级缓存 | 频繁重复请求 |

| User-Agent标识 | 明确、一致 | 有时伪装或混淆 |

| 业务目标 | 搜索索引 | 模型训练/数据获取 |

| 成本影响 | 较低 | 显著高(高12-15倍) |

理解爬取预算需掌握其两大基础组成:爬取能力与爬取需求。爬取能力指您的服务器在一定时间内可承受的最大URL爬取数,由多个相关因素决定,包括:

爬取需求则是机器人实际想爬取的页面数,受内容特性和机器人优先级驱动,影响因素包括:

当爬取需求超过爬取能力时,优化挑战随之出现——机器人需抉择爬取哪些页面,可能遗漏重要内容更新。反之,能力远大于需求则浪费服务器资源。目标是实现爬取效率:最大化重要页面的爬取,最小化对低价值内容的浪费。AI时代,这种平衡更加复杂,不同类型机器人以不同优先级争夺相同服务器资源,需要复杂策略为各方有效分配爬取预算。

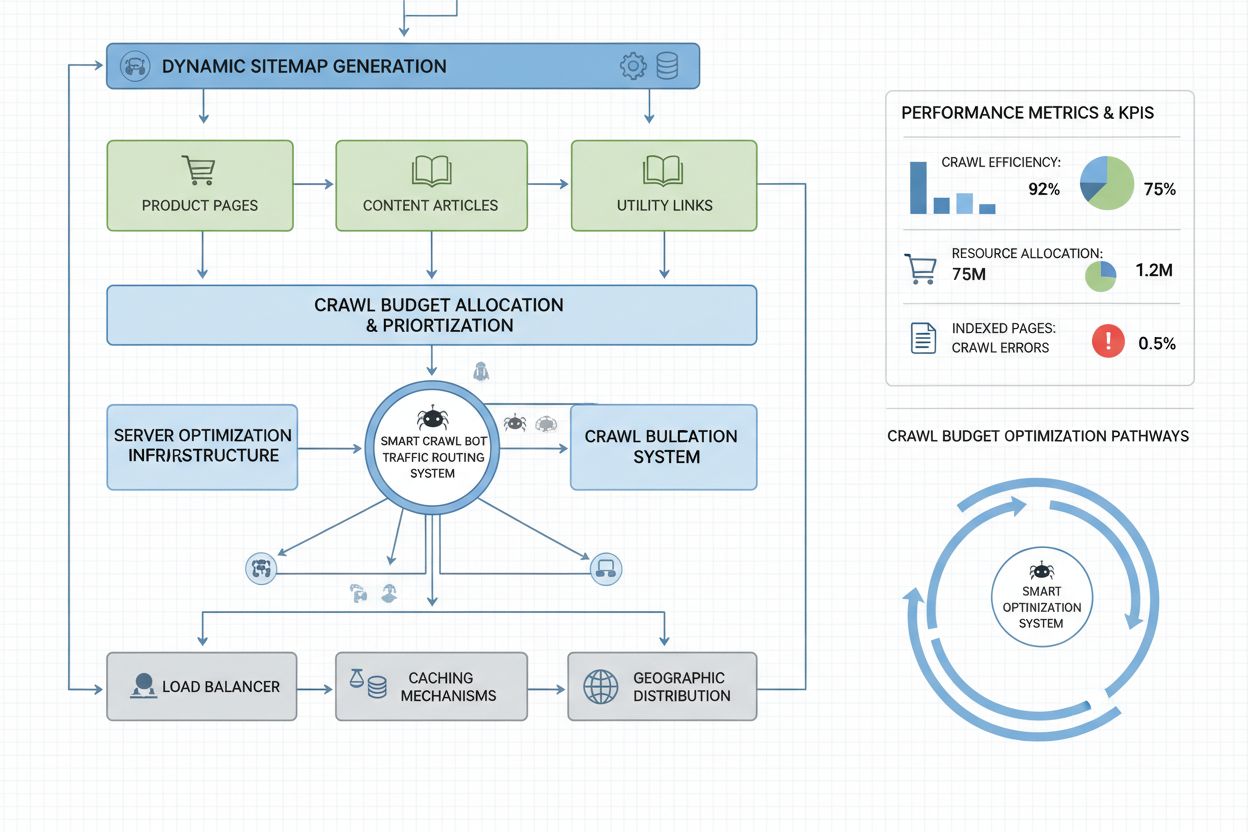

衡量爬取预算表现通常从Google Search Console开始,在“设置”中查看爬取统计,包括每日爬取请求、下载字节数和响应时间。要计算爬取效率比,用成功爬取数(HTTP 200响应)除以总爬取请求数,健康站点通常效率为85-95%。基本公式为:(成功爬取 ÷ 总爬取请求数)× 100 = 爬取效率%。除谷歌数据外,实用监控还包括:

针对AI爬虫的监控,AmICited.com等工具能专门追踪GPTBot、ClaudeBot和Perplexity Bot的活跃情况,洞察这些爬虫优先访问哪些页面及访问频率。此外,对AI机器人爬取激增设置自定义告警,有助于及时响应异常资源消耗。关键指标是每页爬取成本:用爬虫消耗的总服务器资源除以唯一被爬取页面数,能判断预算是否高效用于优质内容,还是浪费在低价值页面。

针对AI机器人的爬取预算优化需结合技术执行与战略决策,主要战术包括:

具体采用哪种战术,取决于您的商业模式与内容策略。电商网站可能会屏蔽AI爬虫抓取商品页,以防竞争对手训练模型,而内容发布者则倾向于开放抓取以获取AI答案中的曝光。若AI爬虫流量确实导致服务器压力,可在robots.txt中针对User-Agent直接屏蔽:如User-agent: GPTBot后接Disallow: /,即可彻底阻止OpenAI爬虫访问。但这会失去在ChatGPT等AI应用中的曝光机会。一种更灵活的策略是选择性屏蔽:允许AI爬虫访问公开内容,屏蔽敏感区、归档或无价值内容,既提升可见性又保护资源。

管理数百万页面的企业级网站,需采用超越基础robots.txt的高级优化策略。动态站点地图是关键进步,可根据内容新鲜度、重要性得分和爬取历史实时生成站点地图。与其用静态XML地图罗列全部页面,不如优先突出最近更新、高流量和高转化页面,保证机器人把预算用在最关键内容上。URL分区将网站划分为不同“爬取区”,每个区采用针对性优化——如新闻区用高频更新地图确保每日内容及时被抓取,常青内容区则减少更新频率。

服务器端优化包括实施爬取感知缓存策略,对机器人提供缓存内容,对用户则返回最新页面,从而减少机器人重复请求的负载。内容分发网络(CDN)结合爬虫定向路由可隔离机器人和用户流量,防止爬虫消耗实际访问所需带宽。按User-Agent限速可对AI机器人请求进行节流,同时确保Googlebot和用户流量正常。对于超大规模站点,可采用多区域分布式爬取预算管理,避免单点故障,实现地理负载均衡。基于机器学习的爬取预测分析历史模式,预测机器人下次可能访问哪些页面,从而主动优化这些页面的性能与缓存。这些企业级策略将爬取预算从瓶颈转变为可控资源,使大型组织能在服务数十亿页面时兼顾机器人和用户的最佳体验。

是否允许AI爬虫访问,是一项关乎可见性、竞争力和运营成本的重大业务战略选择。允许AI爬虫带来诸多好处:您的内容有机会出现在AI生成的答案中,或从ChatGPT、Claude、Perplexity等AI应用获得流量;品牌获得新分发渠道的曝光;被AI系统引用还能带来SEO信号。但这些好处伴随成本:服务器负载和带宽消耗增加,竞争对手可能用您的内容训练AI模型,以及对信息在AI答案中呈现和归属的控制力下降。

屏蔽AI爬虫能消除上述成本,但也失去曝光机会,甚至让竞争对手在AI渠道占据市场。最佳策略取决于您的商业模式:内容发布者和新闻机构通常愿意允许爬取以获得AI摘要分发流量;SaaS和电商网站或许选择屏蔽以防产品信息被训练;教育与科研机构则倾向于开放以最大化知识传播。混合策略是折中:允许公开内容被爬取,屏蔽敏感区、用户生成内容或专有信息,这样既保留可见性又保护核心资产。此外,通过AmICited.com等工具监控您的内容是否被AI系统引用——如已开放爬取却未见引用,继续允许爬取的意义不大,屏蔽反而更划算,因为您承担了成本却没有获得曝光。

高效的爬取预算管理需借助专业工具,洞察机器人行为,实现数据驱动的优化决策。Conductor和Sitebulb为企业级爬取分析工具,可模拟搜索引擎抓取流程,发现爬取低效、错误页面浪费及优化机会。Cloudflare可在网络层实现机器人管理,细致控制哪些机器人能访问站点,并为AI爬虫单独设定限速。针对AI爬虫监控,AmICited.com是最全面的解决方案,能追踪GPTBot、ClaudeBot、Perplexity Bot等AI爬虫,详细统计其访问页面、访问频次及内容是否出现在AI答案中。

服务器日志分析始终是爬取预算优化的基础——Splunk、Datadog或开源ELK Stack等工具,可解析原始访问日志,按User-Agent分流量,识别资源消耗最大和最受爬取页面。自定义仪表盘跟踪爬取趋势,有助于评估优化成效或新型机器人出现。Google Search Console持续为Google爬取行为提供关键信息,Bing站长工具则为微软爬虫提供类似数据。最成熟的组织往往采用多工具协同监控策略,结合Google Search Console(传统搜索数据)、AmICited.com(AI爬虫跟踪)、服务器日志分析(全面机器人可见性)及Conductor(爬取模拟与效率分析),实现全方位洞察。这种分层监控模式,可让您基于完整数据而非猜测做出优化决策。定期监控(理想为每周一次)可及时发现异常爬取高峰、错误率上升或新型激进爬虫,快速响应,防止爬取预算问题影响性能或成本。

像GPTBot和ClaudeBot这样的AI机器人与Googlebot的优先级不同。Googlebot会遵守爬取预算限制并实施先进的节流机制,而AI机器人往往表现出更激进的爬取模式,带宽消耗是Googlebot的12-15倍。AI机器人更注重持续内容摄取以用于模型训练,而非搜索索引,这使得它们的爬取行为本质上不同,因此需要独特的优化策略。

研究表明,OpenAI的GPTBot在某些拥有大量内容库的网站上消耗的带宽是Google爬虫的12-15倍。具体消耗取决于您的网站规模、内容更新频率以及有多少AI机器人同时爬取。多个AI机器人同时爬取会显著增加服务器负载和主机成本。

可以,您可以使用robots.txt屏蔽特定AI爬虫而不影响传统SEO。但屏蔽AI爬虫意味着在ChatGPT、Claude、Perplexity等AI应用生成的答案中失去可见性。是否屏蔽取决于您的商业模式——内容发布者通常有利于允许爬取,而电商网站可能会屏蔽以防止竞争对手用于训练。

爬取预算管理不善可能导致重要页面未被爬取或索引、新内容索引变慢、服务器负载和带宽成本增加、机器人流量消耗资源导致用户体验下降,以及在传统搜索和AI生成答案中错失可见性机会。拥有数百万页面的大型网站最容易受到这些影响。

为获得最佳效果,建议每周监控爬取预算指标,在重大内容发布或遇到异常流量高峰时每天监控。使用Google Search Console获取传统爬取数据,AmICited.com追踪AI爬虫,以及服务器日志来获得全面的机器人可见性。定期监控可让您在问题影响网站性能前及时发现。

robots.txt对AI机器人的有效性不一。Googlebot会严格遵守robots.txt,但AI机器人遵守情况各异——有些遵守,有些则忽略。为获得更可靠的控制,可对特定User-agent实施屏蔽、在服务器级别进行速率限制,或使用Cloudflare等CDN机器人管理工具实现更细致的控制。

爬取预算直接影响AI可见性,因为AI机器人无法引用或参考未被爬取的内容。如果您的重要页面因预算限制未被爬取,就不会出现在AI生成答案中。优化爬取预算可确保优质内容被AI机器人发现,提升在ChatGPT、Claude和Perplexity等回答中的被引用概率。

通过动态站点地图优先突出最近更新、高流量和高转化潜力的页面。使用robots.txt屏蔽如归档和重复等低价值页面。实现简洁的URL结构和策略性内部链接,引导机器人优先访问重要内容。通过AmICited.com等工具监控AI机器人实际爬取的页面,不断优化策略。

了解 AI 的抓取预算是什么意思、它与传统搜索抓取预算有何不同,以及它为何对您的品牌在 AI 生成答案和 AI 搜索引擎中的可见性至关重要。...

关于 AI 抓取预算管理的社区讨论。如何处理 GPTBot、ClaudeBot 和 PerplexityBot,同时不影响可见性。

抓取预算是搜索引擎在一定时间内抓取您网站页面的数量。了解如何优化抓取预算,从而提升索引效率和SEO表现。

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.