如何应对 AI 搜索引擎的重复内容问题

了解在使用 AI 工具时如何管理和防止重复内容。发现规范标签、重定向、检测工具及维护网站内容唯一性的最佳实践。

重复内容是指在多个URL上出现完全相同或高度相似的内容,无论是在同一网站内部还是跨不同域名。这个问题会让搜索引擎感到困惑,削弱页面的权重权威,从而对SEO表现和在传统搜索及AI搜索结果中的可见性产生负面影响。

重复内容是指在多个URL上出现完全相同或高度相似的内容,无论是在同一网站内部还是跨不同域名。这个问题会让搜索引擎感到困惑,削弱页面的权重权威,从而对SEO表现和在传统搜索及AI搜索结果中的可见性产生负面影响。

重复内容是指在多个URL上出现完全相同或高度相似的内容,无论是在同一网站内部(内部重复)还是跨不同域名(外部重复)。这是SEO领域的基础性问题:当搜索引擎遇到多个版本的同一素材时,必须判断哪个版本最相关并将其收录和展示在搜索结果中。行业专家援引的研究显示,约25-30%的网络内容为重复内容,这成为数字营销中最普遍的挑战之一。该问题不仅存在于传统搜索引擎,还延伸到AI驱动的搜索系统(如Perplexity、ChatGPT、Google AI Overviews和Claude),在这些系统下,重复内容会造成内容权威和原创来源的混淆。页面被认定为重复内容,通常需与另一页面在措辞、结构、格式上高度重叠,几乎无原创信息,也未比其他页面显著增加价值。

自搜索引擎优化早期以来,重复内容的概念经历了巨大演变。90年代搜索引擎初现时,因网络体量较小、结构分散,重复内容并不突出。随着互联网扩展和内容管理系统发展,生成多个指向相同内容的URL变得极为容易。Google关于重复内容的官方立场(多次由其站长团队发布)明确表示:他们不会惩罚善意的重复内容,但会通过算法选择规范版本进行收录和排名。这一区别至关重要:Google不会对技术性重复内容进行人工惩罚,但重复内容依然会因权重稀释和抓取预算浪费而削弱SEO表现。

电商平台、内容管理系统及URL参数跟踪在2000年代和2010年代的兴起,使重复内容问题急剧增加。会话ID、排序和筛选参数几乎能生成无限的URL组合,内容却完全相同。与此同时,内容分发成为行业惯例,出版商会在多个域名上重复发布内容。2023-2024年,AI搜索引擎和大语言模型的出现,为重复内容带来了新挑战。这类系统不仅要决定哪个URL排名,还要在多个内容副本中决定引用哪个作为权威来源。这也为类似AmICited等品牌监测平台带来了机会,以跟踪重复内容如何影响AI搜索引擎的可见性。

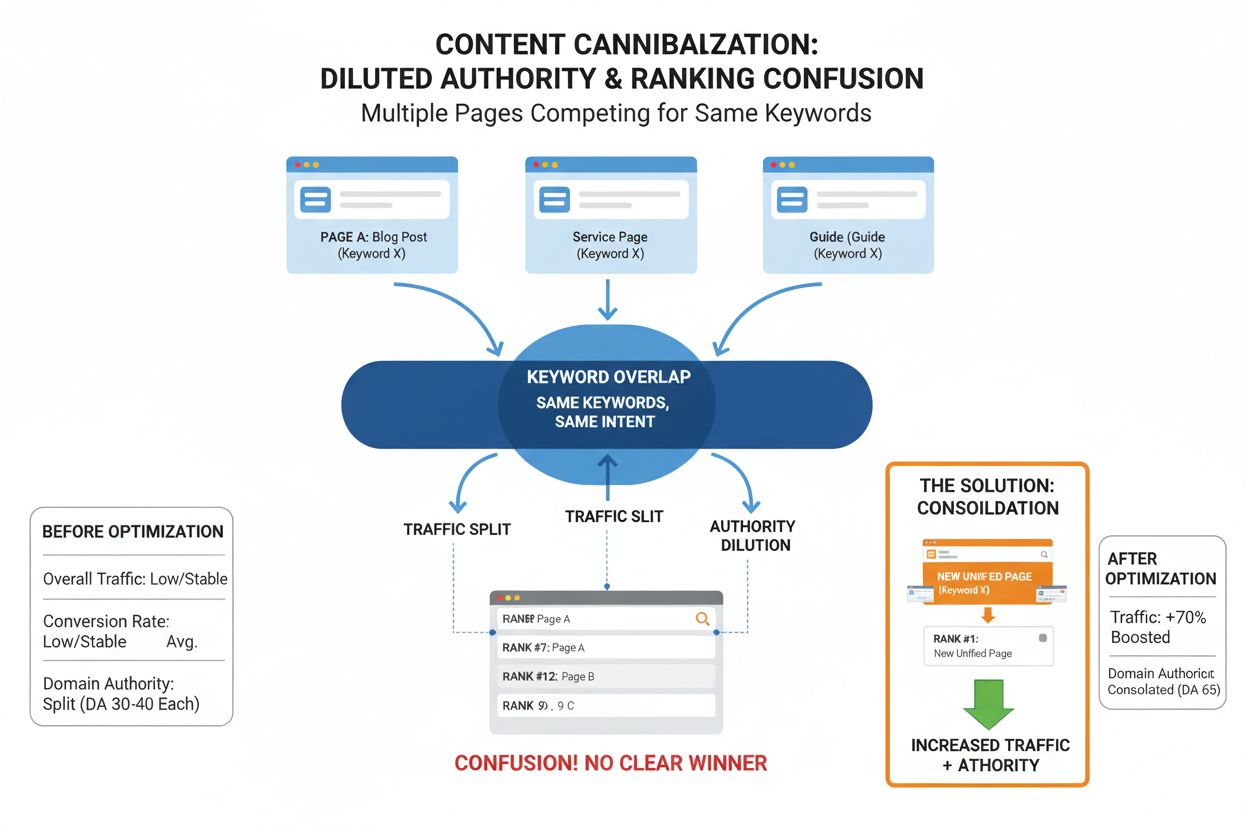

重复内容通过多种机制负面影响SEO,降低网站可见性和排名潜力。首要问题是权重稀释:当多个URL拥有相同内容时,指向这些页面的外链被分散,难以集中在某个权威页面上。例如,如果一个版本有50个外链,另一个有30个外链,你就错失了将80个外链集中到一个页面的机会。这种分散大大削弱了关键词排名竞争力。

遇到重复内容时,搜索引擎还面临收录挑战,需要决定收录哪个版本。如果Google选择了质量较低或权威性不足的URL,你期待被排名的页面可能完全无排名。此外,重复内容还会浪费抓取预算——即搜索引擎分配的有限抓取时间和资源。行业研究发现,仅修复重复内容这一项就能让受影响网站自然流量提升20%及以上。这种显著提升是因为搜索引擎能将抓取资源集中用于独特、高价值内容,而非浪费在重复页面上。

影响还延伸到点击率和用户体验。当多个相同内容的版本出现在搜索结果时,用户可能点击到质量较差的页面,造成跳出率上升、互动信号降低。对于AI搜索引擎和大模型来说,重复内容更易引发权威和来源归属的混淆。当ChatGPT或Perplexity遇到多份相同内容时,系统需判断哪个URL才是权威引用来源,不确定性导致AI可能引用非首选URL,或在不同AI响应间归属不一致。

| 问题类型 | 成因 | 内部/外部 | 最佳解决方案 | 信号强度 |

|---|---|---|---|---|

| URL参数 | 跟踪、筛选、排序(如?color=blue&size=10) | 内部 | 规范标签或GSC参数设置 | 强 |

| 域名变体 | HTTP/HTTPS,www/非www | 内部 | 301重定向至首选版本 | 非常强 |

| 分页 | 内容分布在多页 | 内部 | 自指向规范标签 | 中等 |

| 会话ID | 访客跟踪附加在URL | 内部 | 自指向规范标签 | 强 |

| 内容分发 | 授权内容在其他域名发布 | 外部 | 规范标签+分发版noindex | 中等 |

| 内容抓取 | 未授权复制到其他域名 | 外部 | DMCA投诉+规范标签 | 弱(需强制执行) |

| 斜杠结尾 | URL带/不带斜杠 | 内部 | 301重定向统一格式 | 非常强 |

| 打印版 | 单独URL的打印内容 | 内部 | 规范标签指向主版 | 强 |

| 落地页 | 付费推广用相似页面 | 内部 | 落地页加noindex | 强 |

| 测试环境 | 测试站点被收录 | 内部 | HTTP认证或noindex | 非常强 |

理解重复内容的技术表现,有助于实施有效解决方案。URL参数是技术性重复内容最常见的根源之一,尤其在电商及内容型网站。当网站用参数筛选内容(如example.com/shoes?size=9&color=blue),每个参数组合都生成一个新URL,内容却高度相似。一个产品页有五种尺码、十种颜色,理论上会生成50个几乎相同的URL。搜索引擎需抓取和处理每个变体,消耗抓取预算,分散排名权重。

域名配置问题是另一大重复内容来源。许多网站可通过多种域名访问:http://example.com、https://example.com、http://www.example.com、https://www.example.com。若未正确配置,这四种版本都可能被分别收录。同理,斜杠结尾不一致(URL结尾带或不带/)和URL大小写(Google区分大小写)也会产生重复。一个页面可能通过example.com/products/shoes/、example.com/products/shoes、example.com/Products/Shoes及example.com/products/Shoes/等多种形式被收录。

会话ID和跟踪参数更进一步加重问题。网站在URL中添加会话标识或跟踪代码(如?utm_source=twitter&utm_medium=social&utm_campaign=promo),每个唯一组合都成为新URL。虽这些参数用于跟踪流量,但对搜索引擎而言即构成重复内容。分页也会带来重复问题,尤其是页面间内容重叠或搜索引擎难以理清分页关系时。

AI驱动的搜索引擎和大语言模型的崛起,让重复内容问题具备了新维度。当Perplexity、ChatGPT、Google AI Overviews和Claude遇到多份相同内容时,需判断引用哪个源、如何归属信息。这对品牌监测与可见性追踪有重大影响。像AmICited这样的平台在监测品牌被AI引用时,必须考虑重复内容对引用统计的影响。

例如,公司在官网(company.com/blog/article)发布一篇文章,同时内容被分发到其他三个域名,AI系统引用时可能选择任一版本。从品牌可见性看,引用非首选URL会分散品牌权威,甚至将流量导向竞争对手或低质量转载网站。跨域名重复内容还会让AI系统难以判断原创作者。如果竞争对手在你的内容被收录前先抓取并发布,AI系统可能会错误归属内容。

在AI搜索时代,权重整合比以往更重要。通过规范标签或301重定向合并重复内容,不仅能提升传统搜索排名,还能提高AI系统正确识别与引用首选URL的概率。这对品牌保护和行业影响力尤为重要,被引用为权威来源直接关系到公信力与流量。使用AmICited等工具监测AI可见性的组织,会更加理解重复内容如何影响AI多平台响应。

重复内容既有技术原因也有主观原因,各自需不同的解决方法。技术层面,服务器配置不当是主要根源。若服务器未统一域名格式,首页可能通过example.com、www.example.com、example.com/index.html、example.com/index.php等多种形式访问并被收录。内容管理系统常因分类、标签等功能生成大量重复页。例如同一博文被分配多个分类,可能通过不同分类URL访问同一内容。

电商平台则通过产品筛选、排序生成大量重复内容。顾客按尺码、颜色、价格等筛选,每种组合都生成新URL,若未加以规范,一个产品可能有上百个重复页面。分页在连载文章或产品列表中也常见,尤其是页面内容有重叠或搜索引擎处理分页关系不佳时。

主观性重复多出于业务需求,但无意中带来SEO隐患。内容分发(多域名授权转载)会造成外部重复,付费推广落地页常复制已有内容并稍作修改以匹配关键词,打印版则生成内容完全一致的新URL。这些做法虽合理,但需通过规范标签或noindex加以管理。

未授权内容抓取是最棘手的外部重复。竞争对手或内容聚合网站复制并发布你的内容,若其域名权重更高,甚至可能超越原站排名。这将导致流量和权威流向他人,对站点伤害极大。

解决重复内容需多维度方案,按成因和场景选择。最强力方式是301重定向,可永久将一个URL转向另一个,并将权重全部传递给目标URL。该方案适用于统一域名格式(如HTTP转HTTPS、非www转www)。大多数主机和CMS后台均支持301重定向设置。

规范标签(canonical tag)适用于需保留多个URL供用户访问,但希望搜索引擎只优先一个版本的场景。只需在重复页面头部添加<link rel="canonical" href="https://preferred-url.com">即可。适合URL参数、分页、内容分发场景。规范标签可让搜索引擎将权重和反链集中到指定URL,且重复页面仍可被访问。

noindex标签可让页面对用户可见,对搜索引擎不可见。适用于落地页、打印版、测试环境、搜索结果页等无需被收录的页面。只需在页面头部添加<meta name="robots" content="noindex">,无需重定向或规范标签。

内容差异化则从根本上规避重复。将每个页面打造成独特且有价值的内容,避免多个类似页面。可以通过原创观点、专家引用、案例分析、实用步骤等方式提升内容独特性,将潜在重复页面转变为互补内容。

对于外部抓取导致的重复内容,可通过Google的法律申诉工具提交DMCA投诉,或直接联系对方网站要求删除或按规范标签注明原始来源。如无法联系,必要时可诉诸法律手段保护知识产权。

随着搜索技术进步和新平台涌现,重复内容的定义与影响持续演变。过去,重复内容问题主要困扰于Google、Bing、Yahoo等传统搜索引擎。如今,AI驱动的搜索引擎和大语言模型让这一挑战更为复杂。这些系统不仅要识别内容重复,还要判断哪个版本才是权威引用来源。

未来趋势表明,重复内容管理对品牌可见性和AI权威性将变得更为重要。随着越来越多用户依赖AI搜索,控制内容被引用的版本将成为核心能力。组织需制定主动的重复内容管理策略,不仅服务于传统SEO,更专门针对AI引用优化,包括确保规范URL明确、首选版本易被AI抓取、品牌归属不容混淆。

AI监测工具(如AmICited)集成进标准SEO流程,标志着重复内容管理的进化。这类平台帮助企业全面了解重复内容如何影响AI多引擎可见性。随着AI系统在判断原创来源和内容归属方面日益智能,规范标签和重复内容管理的重要性将持续提升。率先主动管理重复内容的组织,将在未来AI搜索格局中赢得可见性和权威。

新兴技术如区块链内容验证、去中心化身份系统等,未来有望为重复内容管理和原创证明提供新工具。但在可见的将来,规范标签、301重定向、noindex仍然是最有效的传统解决方案。关键在于持续、规范地实施这些措施,并在传统搜索及AI搜索系统中监控其效果,确保品牌始终拥有最佳的可见性和权威。

内部重复内容是指同一网站内多个URL包含相同或高度相似的内容,比如同一产品描述出现在多个页面,或通过不同URL参数访问同一页面。外部重复内容是指相同内容出现在不同的域名上,通常是内容分发或未经授权的抓取。两者都会对SEO产生负面影响,但内部重复更容易通过技术手段如规范标签和301重定向加以控制。

Google通常不会对重复内容进行人工惩罚,除非属于有意大规模操纵搜索排名的行为。然而,重复内容依然会通过让搜索引擎难以判断该收录和排名哪个版本、分散反向链接权重、浪费抓取预算等方式损害SEO表现。关键区别在于,Google主要通过算法筛选而非对技术性失误进行处罚。

重复内容会让AI系统(如ChatGPT、Perplexity和Claude)在判断权威来源时遇到挑战。当多个URL拥有相同内容时,AI模型可能难以识别原始来源,可能引用权重较低的版本,或对内容归属产生混淆。这对于品牌监测平台来说尤为重要,因为重复内容会导致AI响应中品牌可见性分散。

常见原因包括用于跟踪或筛选的URL参数(如?color=blue&size=large)、域名变体(HTTP/HTTPS、带www/不带www)、多页分页、内容分发、会话ID、打印友好版、服务器配置错误等。技术问题如斜杠结尾、URL大小写不一致、索引页(index.html/index.php)也会导致重复。此外,将内容复制用于落地页或其他网站未经许可转载你的内容,也是重复内容的重要来源。

规范标签是一种HTML元素(rel="canonical"),用于指定在多个URL有相同或相似内容时,哪个URL是首选版本。通过在重复页面添加指向主版本的规范标签,向搜索引擎表明应收录和排名哪个页面,从而将权重和反链集中到一个URL,无需重定向,适用于需要多URL对用户开放但希望搜索引擎只优先一个版本的场景。

可以通过Google Search Console的索引覆盖报告发现被标记为重复内容的问题页面。Semrush Site Audit、Screaming Frog、Conductor等工具可扫描全站并标记内容重复度达85%以上的页面。对于外部重复内容,可用Copyscape等服务在全网查找你的内容副本。定期检查页面标题、meta描述、H1等也有助于发现内部重复。

重复内容会浪费网站的抓取预算——即搜索引擎分配给网站的有限抓取时间和资源。当Googlebot遇到多个相同内容的版本时,会把资源花在重复页面上,导致新内容或更新页面没被及时发现和收录。对于大型网站,这会显著减少被收录的独立页面数量。通过规范标签、301重定向或noindex标签合并重复内容,可以将抓取预算集中到重要内容上,提升收录和排名潜力。

了解在使用 AI 工具时如何管理和防止重复内容。发现规范标签、重定向、检测工具及维护网站内容唯一性的最佳实践。

社区讨论 AI 系统如何以不同于传统搜索引擎的方式处理重复内容。SEO 专业人士分享关于内容独特性在 AI 可见性中的见解。...

内容同类竞争是指网站多个页面争夺同一关键词,导致权威性和排名被稀释。了解如何识别并解决这一关键SEO问题。

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.