动态渲染如何影响 AI:对可抓取性和可见性的影响

了解动态渲染如何影响 AI 爬虫、ChatGPT、Perplexity 和 Claude 的可见性。发现为什么 AI 系统无法渲染 JavaScript 以及如何针对 AI 搜索进行优化。...

动态渲染是一种服务器端技术,通过检测请求是否来自用户或搜索引擎机器人,从而分别为其提供不同版本的同一内容——为用户提供客户端渲染的 JavaScript,为机器人提供完全服务器端渲染的静态 HTML。这种方法在保证完整用户体验的同时,优化了可抓取性和索引效率。

动态渲染是一种服务器端技术,通过检测请求是否来自用户或搜索引擎机器人,从而分别为其提供不同版本的同一内容——为用户提供客户端渲染的 JavaScript,为机器人提供完全服务器端渲染的静态 HTML。这种方法在保证完整用户体验的同时,优化了可抓取性和索引效率。

动态渲染是一种服务器端内容分发技术,用于检测访问请求的类型——是来自真实用户还是搜索引擎爬虫——并据此为其提供优化后的内容版本。用户访问页面时,会获得包含所有 JavaScript、交互元素及动态功能的完整客户端渲染版本;而当搜索引擎爬虫或AI 爬虫请求同一页面时,服务器通过用户代理(user-agent)识别,将请求路由至渲染引擎,将 JavaScript 密集的内容转换为静态、完全渲染的 HTML。该静态版本随后被提供给爬虫,无需其自行执行 JavaScript 代码。这一技术作为应对搜索引擎大规模处理 JavaScript 挑战的实用方案而出现,并随着 ChatGPT、Perplexity、Claude 和 Google AI Overviews 等AI 搜索平台的爬虫活动日益频繁,变得愈发重要。

动态渲染在 2018 年 Google I/O 大会上由 John Mueller 正式向 SEO 社区介绍,作为应对 JavaScript 索引难题的权宜之计。当时,Google 承认虽然 Googlebot 技术上可以渲染 JavaScript,但在全网规模下这样做会消耗大量计算资源,导致内容发现与索引延迟。Bing 也在 2018 年 6 月更新其站长指南,推荐大型网站在 JavaScript 处理受限时采用动态渲染。该技术作为兼顾丰富用户体验与保证搜索引擎可访问性的务实方案,在企业网站和 JS 密集型应用中快速普及。然而,至 2022 年 Google 官方文档明确表示,动态渲染只是权宜之计,并非长期方案。这标志着 Google 更倾向于服务器端渲染(SSR)、静态渲染和水合等更可持续的渲染方式。尽管如此,动态渲染目前仍被大量大型电商平台、单页应用及内容密集型网站采用,尤其是在短期内无法迁移到其他架构的场景下。

动态渲染涉及三大核心环节:用户代理检测、内容路由和渲染与缓存。每当有请求到达 Web 服务器,第一步是识别请求来源——人类用户还是自动化爬虫。这一识别通过分析 HTTP 请求头中的user-agent 字符串实现,该字符串包含了发起请求客户端的信息。Googlebot、Bingbot 及 Perplexity、Claude 等平台的 AI 爬虫都通过特定 user-agent 标识自身。一旦检测到爬虫,服务器便将请求路由至动态渲染服务或中间件,这通常会用无头浏览器(如 Chromium 或 Puppeteer)渲染页面 JavaScript,并转换为静态 HTML。在渲染过程中,所有 JavaScript 代码被执行,动态内容加载,生成最终的 DOM(文档对象模型),即用户浏览器本应看到的内容。最终生成的静态 HTML 会被缓存,避免重复渲染,并直接返回给爬虫。对于真实用户,请求则完全绕过该渲染流程,直接获得客户端渲染版本,确保所有动画、实时更新和动态功能的互动体验完整无损。

| 方面 | 动态渲染 | 服务器端渲染(SSR) | 静态渲染 | 客户端渲染(CSR) |

|---|---|---|---|---|

| 用户内容交付 | 客户端渲染(JavaScript) | 服务器渲染(HTML) | 预构建静态 HTML | 客户端渲染(JavaScript) |

| 爬虫内容交付 | 服务器渲染(HTML) | 服务器渲染(HTML) | 预构建静态 HTML | 客户端渲染(JavaScript) |

| 实现复杂度 | 中等 | 高 | 低 | 低 |

| 资源需求 | 中(仅为爬虫渲染) | 高(所有请求渲染) | 低(无需渲染) | 低(仅客户端) |

| 用户性能表现 | 依赖 JavaScript | 极佳 | 极佳 | 可变 |

| 爬虫性能表现 | 极佳 | 极佳 | 极佳 | 较差 |

| 抓取预算影响 | 积极(爬虫更快处理) | 积极(爬虫更快处理) | 积极(最快) | 消极(渲染慢) |

| SEO 推荐度 | 临时权宜 | 长期首选 | 长期首选 | 不推荐用于 SEO |

| 最佳适用场景 | 大型 JS 密集型且预算有限网站 | 现代 Web 应用 | 博客、文档、静态内容 | 仅面向用户、无 SEO 需求的应用 |

| 维护负担 | 低至中等 | 高 | 低 | 低 |

动态渲染存在的根本原因,源自现代 Web 开发中的一个关键难题:大规模 JavaScript 渲染。JavaScript 虽为用户带来丰富的交互体验、实时更新与复杂功能,却给搜索引擎爬虫带来了极大障碍。以 React、Vue、Angular 等框架构建的网站,爬虫需执行 JavaScript 才能看到最终渲染内容,而这一过程既耗时又消耗大量算力。Google 的搜索推动者 Martin Splitt 曾公开表示:“即使 Googlebot 能执行 JavaScript,我们也不希望过度依赖它。”原因在于 Google 存在有限的抓取预算——即分配给每个网站的抓取时间与算力。Botify 针对 62 亿 Googlebot 请求、4.13 亿页面的研究显示,大型企业网站约有51% 页面未被抓取,主要受限于抓取预算。当 JavaScript 拖慢抓取进度时,被发现和索引的页面就更少。此外,还有独立于抓取预算的渲染预算,即便页面已被抓取,Google 也可能推迟渲染 JavaScript,导致索引延迟数小时甚至数天。对于库存快速变化的电商或每日发布数百篇文章的新闻站,这种延迟会直接影响曝光与流量。

抓取预算是 SEO 中最关键却常被误解的概念之一。Google 按如下公式计算抓取预算:抓取预算 = 抓取容量 + 抓取需求。抓取容量取决于页面加载速度和服务器错误,抓取需求则看页面受欢迎程度与更新频率。动态渲染通过减少爬虫处理每页所需时间,直接提升抓取容量。研究表明,渲染时间低于 3 秒的页面比加载 500-1000 毫秒的页面获得约45% 更高的重新抓取频率,比超过 1000 毫秒的页面高出约130% 的抓取频率。通过为爬虫提供预渲染静态 HTML 而非 JS 密集内容,极大缩短了爬虫的页面加载时间,让其在预算内处理更多页面。这种效率直接提升索引率。对于拥有数千乃至百万页面的大站来说,这意味着从 50% 索引提升至 80% 甚至更高。此外,动态渲染确保JavaScript 加载的内容能第一时间被爬虫发现,而不会因排队等待渲染而延迟索引。对于频繁变动的内容尤为重要,可确保爬虫抓取到的是最新版本,而非过期缓存。

AI 搜索平台如 ChatGPT、Perplexity、Claude 及 Google AI Overviews 的兴起,使动态渲染变得更具现实意义。这些平台拥有各自的爬虫,用于抓取网页内容,生成 AI 回答及摘要。与传统搜索引擎主要用于排名不同,AI 爬虫需要深度访问和理解内容以生成准确、相关的回答。在这种语境下,动态渲染尤为关键,因为它确保 AI 爬虫能高效且完整地访问你的内容。当AmICited监控你的品牌在这些平台的 AI 生成回答中的曝光时,内容能否被引用的根本因素就是 AI 爬虫是否顺利访问并理解了你的网站内容。如果网站严重依赖 JavaScript 且未做动态渲染,AI 爬虫可能很难获取内容,导致品牌难以在 AI 回答中出现。反之,合理实施动态渲染的网站能让 AI 爬虫获取到完整、可访问的内容,大幅提升被引用和曝光的概率。这使动态渲染不仅是 SEO 问题,更成为**生成引擎优化(GEO)**战略中的核心。正在用 AmICited 监控 AI 搜索曝光的组织,应把动态渲染视为实现全平台可见性的基础技术措施。

实施动态渲染需严密规划和技术落地。首先应识别哪些页面需要动态渲染——通常为首页、产品页及高流量或经常变动的内容页。并非所有页面都需动态渲染;对于 JavaScript 很少的静态页面,爬虫通常能直接抓取。接下来需选择渲染方案。主流工具包括 Prerender.io(付费托管渲染与缓存)、Rendertron(Google 基于无头 Chromium 的开源渲染器)、Puppeteer(Node.js 控制无头 Chrome 的库),以及 Nostra AI 的 Crawler Optimization 等专业平台。不同方案在成本、复杂度与维护上各有取舍。选定渲染工具后,开发者需在服务器上配置用户代理检测中间件,识别爬虫请求并路由到渲染服务,通常要将 user-agent 与已知爬虫列表比对,将匹配请求代理到渲染器。缓存至关重要——需对预渲染内容进行强缓存,避免重复渲染,否则优化目的将落空。最后,务必用 Google Search Console 的 URL 检查工具、移动友好性测试等工具验证爬虫能否正确获取渲染内容。

动态渲染的核心优势已被充分验证。提升抓取能力是首要优点——消除 JavaScript 处理负担后,爬虫可更快抓取更多页面,索引率大幅提高。爬虫处理效率提升也减轻了服务器负载,因为渲染只需执行一次并缓存,而非每次访问都重复渲染。用户体验完全不变,区别于其他方案,用户依然能获得完整、丰富的互动站点。实施成本低于服务器端渲染,使中小型开发团队也能采用。但动态渲染也有明显局限。复杂性与维护压力,尤其是页面量大、内容结构复杂的网站,会显著提升。缓存难题,内容频繁变更时缓存需及时失效与重建。用户与爬虫版本不一致的风险,如果管理不善,可能导致索引异常。渲染与缓存设施的资源消耗也会带来一定运维成本。更重要的是,Google 官方态度将动态渲染定位为临时权宜之计,组织应将其视为过渡方案,同时规划迁移至更可持续的渲染方式。

动态渲染的未来紧密关联于 Web 开发和搜索引擎技术的整体趋势。随着JavaScript 框架持续主导现代开发,在丰富用户体验与爬虫可访问性间“搭桥”的需求依然存在。但行业正逐步转向更可持续的方案。服务器端渲染因 Next.js、Nuxt、Remix 等框架的普及变得更易落地。静态渲染与增量静态再生为内容不常变的网站带来极致性能。水合(先服务器渲染再客户端增强)也日益流行。Google 的最新指南明确推荐这些替代方式,表明其将动态渲染视为过渡措施,而非长期架构模式。AI 搜索平台的崛起则为此演进再添新维度。平台的爬虫越来越智能,对可访问、结构化良好的内容需求更高。动态渲染对于有遗留系统或特定限制的组织依然具有现实意义,但新项目应优先采用更可持续的渲染策略。对于正用 AmICited 监控 AI 搜索可见性的组织,战略启示是:动态渲染可提升短期 AI 曝光,但应同步规划向更可持续渲染方式迁移,将其纳入长期生成引擎优化战略。传统 SEO、技术性能优化与 AI 搜索可见性的融合,意味着渲染策略已不再是技术细节,而是影响全平台发现能力的核心业务决策。

不会,只要为爬虫和用户提供的内容在实质上相似,Google 明确表示动态渲染不属于隐形。隐形是指故意为搜索引擎提供完全不同的内容以欺骗其索引,而动态渲染是在不同格式下提供相同内容。不过,如果为用户提供猫相关页面而为爬虫提供狗相关页面,这将被视为隐形并违反 Google 政策。

动态渲染减少了搜索引擎爬虫处理 JavaScript 所需的计算资源,使其能在分配的抓取预算内抓取更多页面。通过为爬虫提供预渲染的静态 HTML 而不是大量 JavaScript 内容,爬虫可以更快地访问和索引页面。研究显示,渲染时间低于3秒的页面与较慢页面相比,获得约45%更高的重新抓取频率,从而直接提高索引率。

服务器端渲染(SSR)为用户和爬虫都在服务器上预渲染内容,提高整体性能,但需要较多开发资源。动态渲染只为爬虫预渲染,用户则看到正常的客户端渲染版本,实施成本较低。然而,Google 目前推荐 SSR、静态渲染或水合(hydration)作为长期方案,动态渲染被视为临时应急方法。

动态渲染特别适用于大型、JavaScript 密集且内容频繁变动的网站,如库存实时更新的电商平台、单页应用和拥有复杂交互功能的站点。对于因抓取预算问题导致 Google 未能抓取大量内容的网站,是非常理想的选择。研究表明,Google 因抓取预算限制,约有51%的大型企业站点页面未被抓取。

ChatGPT、Perplexity 和 Claude 等平台的 AI 爬虫与传统搜索引擎类似,需要完全可访问的 HTML 内容以实现最佳索引。动态渲染帮助这些 AI 系统更高效地访问和理解由 JavaScript 生成的内容,提高你的网站在 AI 生成回答及摘要中出现的概率。对于 AmICited 监控尤其重要,正确渲染确保你的品牌能出现在 AI 搜索结果中。

主流动态渲染解决方案包括 Prerender.io(付费服务)、Rendertron(开源)、Puppeteer 以及 Nostra AI 的专用 Crawler Optimization 平台。这些工具检测爬虫的 user agent,生成页面的静态 HTML 并缓存以加快分发。一般需要在服务器上安装渲染器,配置 user agent 检测中间件,并通过 Google Search Console 的 URL 检查工具进行验证。

不会,动态渲染对用户体验没有任何影响,因为访客仍然获得完整的客户端渲染版本,包括所有交互元素、动画和动态功能。用户不会看到为爬虫准备的静态 HTML。该技术专为提升爬虫抓取而设计,不会影响人类访客期望和喜爱的丰富交互体验。

Google 在 2018 年推荐动态渲染,是为了解决大规模 JavaScript 渲染的实际难题。但自 2022 年起,Google 更新了官方指南,明确动态渲染只是临时应对措施,并非长期解决方案。这一变化反映了 Google 对服务器端渲染、静态渲染和水合等可持续方案的偏好。动态渲染在特定场景下仍适用,但应作为更广泛性能优化策略的一部分,而非独立方案。

了解动态渲染如何影响 AI 爬虫、ChatGPT、Perplexity 和 Claude 的可见性。发现为什么 AI 系统无法渲染 JavaScript 以及如何针对 AI 搜索进行优化。...

服务器端渲染(SSR)是一种网页技术,服务器在发送给浏览器之前渲染出完整HTML页面。了解SSR如何提升SEO、页面速度和AI索引能力,从而实现更佳内容可见性。...

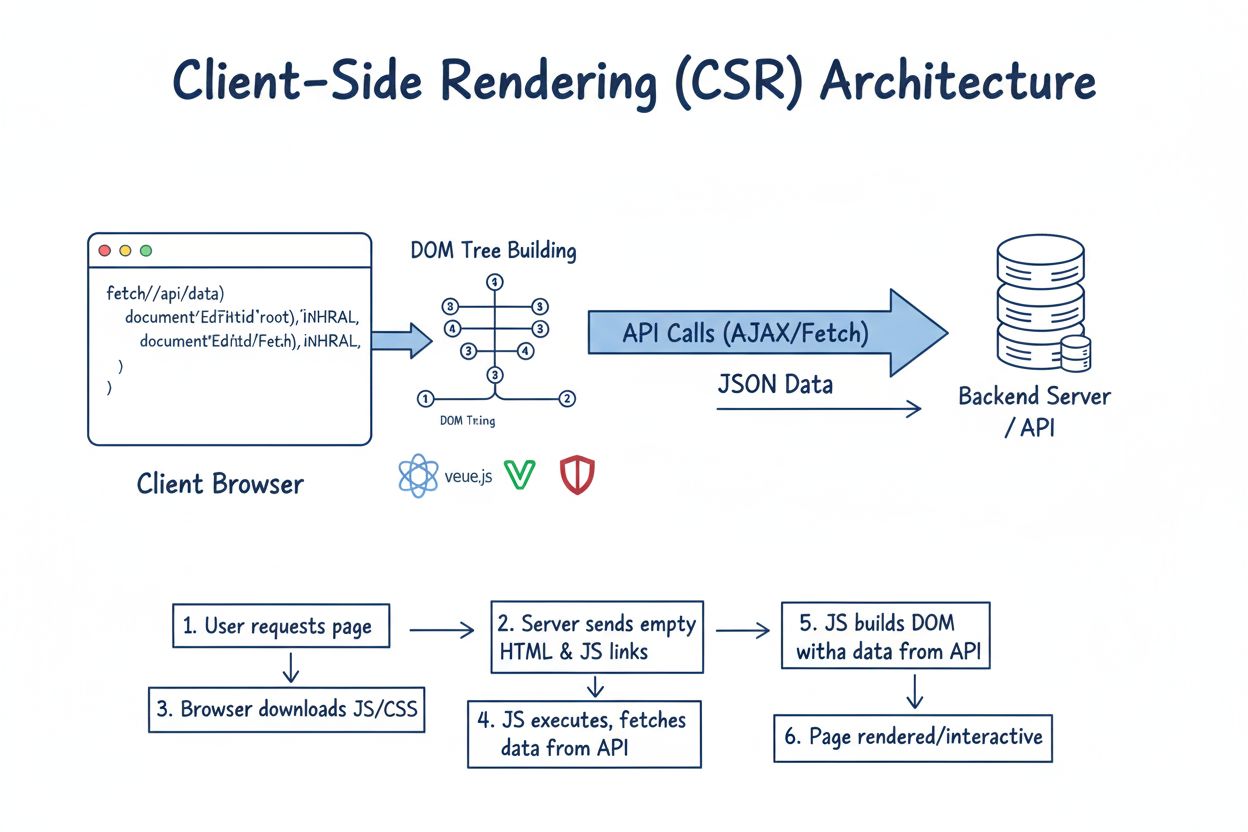

了解什么是客户端渲染(CSR)、其工作原理、优缺点,以及它对 SEO、AI 索引和 2024 年网页应用性能的影响。

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.