AI 爬虫分析

了解什么是 AI 爬虫分析,以及服务器日志分析如何追踪 AI 爬虫行为、内容访问模式和在 ChatGPT、Perplexity、Google AI Overviews 等 AI 搜索平台中的可见性。...

日志文件分析是对服务器访问日志进行检查的过程,以了解搜索引擎爬虫和AI机器人如何与网站交互,从而揭示爬取模式、技术问题以及SEO优化机会。

日志文件分析是对服务器访问日志进行检查的过程,以了解搜索引擎爬虫和AI机器人如何与网站交互,从而揭示爬取模式、技术问题以及SEO优化机会。

日志文件分析是对服务器访问日志进行系统性检查,以了解搜索引擎爬虫、AI机器人和用户如何与网站交互。这些日志由Web服务器自动生成,详细记录了每一次对你网站的HTTP请求,包括请求者的IP地址、时间戳、请求URL、HTTP状态码和user-agent字符串。对于SEO专业人士来说,日志文件分析是了解爬虫行为的权威信息来源,能够揭示Google Search Console或传统爬虫等表层工具无法捕捉的模式。与模拟爬取或汇总分析数据不同,服务器日志提供了无过滤、第一方的实时证据,准确反映搜索引擎和AI系统在你网站上的实际操作。

随着数字环境的发展,日志文件分析的重要性呈指数级增长。全球互联网流量中,超过51%由机器人产生(ACS,2025),AI爬虫如GPTBot、ClaudeBot和PerplexityBot已成为网站的常客,理解爬虫行为不再是可选项,而是保持在传统搜索和新兴AI搜索平台中可见性的必需。日志文件分析弥补了你对网站情况的主观认知与实际发生的客观事实之间的差距,使你能做出数据驱动的决策,直接影响搜索排名、收录速度及整体自然流量表现。

日志文件分析数十年来一直是技术SEO的基石,但近年来其重要性显著提升。过去,SEO人员主要依赖Google Search Console和第三方爬虫来了解搜索引擎行为。然而,这些工具存在明显局限:Google Search Console仅提供Google爬虫的汇总、抽样数据;第三方爬虫模拟爬虫行为,无法捕捉真实交互;且两者都无法有效追踪非Google爬虫或AI机器人。

AI驱动的搜索平台的兴起彻底改变了格局。根据Cloudflare 2024年研究,Googlebot占所有AI与搜索爬虫流量的39%,而AI专属爬虫已成为增长最快的部分。Meta的AI机器人贡献了52%的AI爬虫流量,远超Google(23%)和OpenAI(20%)。这意味着,网站目前会被数十种不同类型的机器人访问,许多爬虫并不遵循传统SEO协议或标准robots.txt规则。日志文件分析是唯一能完整捕捉这些行为的方法,成为现代SEO战略不可或缺的一环。

全球日志管理市场预计将从2025年的32.285亿美元增长至2029年大幅提升,复合年增长率(CAGR)为14.6%。这一增长反映了企业愈发认识到日志分析在安全、性能监控及SEO优化中的关键价值。各组织正大力投资自动化日志分析工具和AI平台,以实现对数百万日志实时处理,将原始数据转化为可推动业务决策的可执行洞察。

当用户或机器人请求你网站的一个页面时,Web服务器会处理该请求并记录关于交互的详细信息。这个过程是自动且持续进行的,形成了所有服务器活动的完整审计记录。理解这一原理对于正确解读日志文件数据至关重要。

流程通常从爬虫(无论是Googlebot、AI机器人还是用户浏览器)发送HTTP GET请求到你的服务器开始,请求中包含user-agent字符串以标识请求方。服务器接收请求后进行处理,并返回HTTP状态码(如200代表成功、404代表未找到、301代表永久重定向等)以及请求内容。每次交互都会在服务器的访问日志中生成一条带有时间戳的记录,包含IP地址、请求URL、HTTP方法、状态码、响应大小、来源和user-agent字符串。

HTTP状态码对于SEO分析尤为重要。状态码200表示页面成功返回;3xx表示重定向;4xx表示客户端错误(如404未找到);5xx表示服务器错误。通过分析日志中状态码的分布,能发现阻碍爬虫访问内容的技术问题。例如,某爬虫访问重要页面时多次收到404响应,说明存在断链或内容丢失等需紧急修复的问题。

User-agent字符串同样关键,可用于识别访问你网站的机器人类型。每个爬虫有专属的user-agent标识,如Googlebot的user-agent中含“Googlebot/2.1”,GPTBot含“GPTBot/1.0”,ClaudeBot含“ClaudeBot”。解析这些字符串后,你可以按爬虫类型对日志数据进行分段,分析不同爬虫对内容的关注点及其爬取模式差异。这种精细化分析有助于针对不同搜索平台和AI系统采取有针对性的优化策略。

| 方面 | 日志文件分析 | Google Search Console | 第三方爬虫 | 分析工具 |

|---|---|---|---|---|

| 数据来源 | 服务器日志(第一方) | Google爬取数据 | 模拟爬取 | 用户行为追踪 |

| 完整性 | 100%所有请求 | 抽样、汇总数据 | 仅模拟 | 仅人类流量 |

| 机器人覆盖 | 全部爬虫(Google、Bing、AI机器人) | 仅Google | 模拟爬虫 | 无机器人数据 |

| 历史数据 | 完整历史(保留期不同) | 时间有限 | 单次爬取快照 | 可用历史数据 |

| 实时洞察 | 支持自动化实时 | 报告有延迟 | 不支持实时 | 报告有延迟 |

| 抓取预算可见性 | 精确抓取模式 | 高层摘要 | 估算 | 不适用 |

| 技术问题 | 详细(状态码、响应时间) | 可见性有限 | 模拟问题 | 不适用 |

| AI机器人追踪 | 支持(GPTBot、ClaudeBot等) | 不支持 | 不支持 | 不支持 |

| 成本 | 免费(服务器日志) | 免费 | 付费工具 | 免费/付费 |

| 配置复杂度 | 中到高 | 简单 | 简单 | 简单 |

日志文件分析已成为了解搜索引擎和AI系统如何与网站交互不可或缺的手段。与仅展示Google视角及汇总数据的Google Search Console不同,日志文件能完整捕捉所有爬虫活动。这种全景视角对于识别抓取预算浪费至关重要:搜索引擎往往把大量资源浪费在低价值页面,而非重要内容。研究表明,大型网站常有30-50%的抓取预算耗费在分页存档、筛选导航或过期内容等非核心URL上。

AI驱动的搜索崛起让日志文件分析变得更加重要。随着GPTBot、ClaudeBot、PerplexityBot等AI机器人频繁访问网站,理解其行为已成为优化AI结果可见性的关键。这些机器人行为与传统爬虫有显著不同——可能无视robots.txt规则、抓取更频繁或偏好特定内容类型。日志文件分析是唯一能揭示这些行为模式的方法,使你能针对AI抓取优化网站,并通过有针对性的规则管理机器人访问。

技术SEO问题也能通过日志分析被及时发现。重定向链、5xx服务器错误、页面加载缓慢、JavaScript渲染问题等都会在服务器日志中留下痕迹。分析这些模式后,你可以优先修复直接影响搜索引擎可访问性和收录速度的问题。例如,若日志显示Googlebot在抓取特定板块时反复收到503服务不可用错误,则可精准定位技术优化重点。

获取服务器日志是日志文件分析的第一步,具体方式取决于你的主机环境。对于自建服务器(如Apache或NGINX),日志通常存储在/var/log/apache2/access.log或/var/log/nginx/access.log目录下,可通过SSH或服务器文件管理器直接访问。对于托管WordPress主机(如WP Engine、Kinsta),日志文件一般可在主机后台或通过SFTP获取,但部分服务商为保障服务器性能可能限制访问。

**内容分发网络(CDN)**如Cloudflare、AWS CloudFront、Akamai需要特殊配置来获取日志。Cloudflare提供Logpush功能,可将HTTP请求日志发送到指定存储桶(如AWS S3、Google云存储、Azure Blob Storage)以供分析。AWS CloudFront则可配置标准日志存储到S3桶。这些CDN日志对于了解内容经CDN分发后机器人如何访问至关重要,因为它们记录了边缘节点的请求,而非源服务器。

共享主机环境通常日志访问受限。如Bluehost、GoDaddy等通过cPanel提供部分日志,但这些日志通常旋转频繁且可能缺失关键字段。若在共享主机环境下需进行全面日志分析,建议升级至VPS或具备完整日志访问权限的托管方案。

获取日志后,数据准备尤为重要。原始日志文件包含来自所有来源的请求——用户、爬虫、爬取器及恶意流量。SEO分析时需排除无关流量,聚焦搜索引擎及AI机器人行为,通常包括:

日志文件分析可发现其他SEO工具无法察觉的洞察,为战略优化决策提供基础。其中最有价值的是抓取模式分析,能准确显示搜索引擎访问了哪些页面及频率。通过跟踪抓取频率的变化,可判断Google对某一板块关注度的提升或下降。抓取频率突然下降可能预示技术问题或页面权重变化,频率上升则说明优化有成效。

抓取预算利用率也是关键洞察。分析2xx成功响应与4xx、5xx错误响应的比例,可定位爬虫遇到问题的站点部分。例如某目录持续返回404错误,即在断链上浪费抓取预算。类似地,若爬虫大量访问分页URL或筛选导航,也是在低价值内容上消耗预算。日志分析能量化这种浪费,帮助你评估优化措施的潜在影响。

孤立页面发现是日志文件分析独有优势。孤立页面是指未被站内链接的URL,游离于站点结构之外。传统爬虫因无法通过内链发现这些页面而常常遗漏,而日志文件显示搜索引擎实际仍在抓取它们——往往因外部链接或旧sitemap所致。识别这些孤立页面后,你可决定是重新纳入结构、重定向,还是彻底删除。

AI机器人行为分析日益重要。通过按AI机器人user-agent对日志分段,可看出这些机器人偏好哪些内容、抓取频率及是否遇到技术障碍。例如,若GPTBot频繁抓取FAQ页面而极少访问博客,说明AI系统更重视FAQ类内容作为训练数据。这一洞察可指导内容策略,助你优化AI可见性。

成功的日志文件分析既需合适的工具,也需科学的方法。Screaming Frog Log File Analyzer是最受欢迎的专业工具之一,界面友好、支持大体量日志处理、可识别爬虫模式并可视化抓取数据。Botify则为企业级日志分析方案,集成SEO指标,可将机器人行为与排名、流量关联。seoClarity的Bot Clarity将日志分析直接集成进SEO平台,便于与其他SEO数据联动。

对于高流量或架构复杂的组织,AI驱动的日志分析平台如Splunk、Sumo Logic、Elastic Stack具备自动模式识别、异常检测和预测分析等高级功能。这些平台可实时处理数百万日志条目,自动识别新型机器人并标记可能的安全威胁或技术异常。

日志文件分析最佳实践包括:

随着AI搜索日益重要,通过日志文件分析监控AI机器人已成SEO关键任务。记录哪些AI机器人访问了你的网站、访问了哪些内容及抓取频率,有助于了解你的内容如何被AI搜索工具和生成式AI模型利用。基于这些数据,你可决定是否允许、屏蔽或限制特定AI爬虫,通过robots.txt或HTTP头进行管理。

抓取预算优化或许是日志文件分析最具影响力的应用。对于拥有成千上万页面的大型网站,抓取预算是有限资源。通过分析日志文件,你可以识别出被过度抓取而不重要的页面,以及应被更频繁抓取但实际被忽略的页面。常见的抓取预算浪费场景包括:

通过robots.txt规则、规范标签、noindex标签或技术优化解决这些问题,可以将抓取预算引导到高价值内容,提高重要页面的收录速度及搜索可见性。

AI驱动搜索的快速发展正在重塑日志文件分析的未来。随着更多AI机器人进入生态并行为日趋复杂,日志文件分析对理解内容如何被AI系统发现、访问和利用将变得更加重要。主要趋势包括:

基于机器学习的实时日志分析将让SEO人员在数分钟内发现并响应抓取问题,而非数天。自动化系统将能识别新型机器人、标记异常模式并建议优化动作,无需人工干预。这种从被动到主动的转变,将助力SEO持续保持最佳抓取与收录状态。

与AI可见性追踪集成,将日志数据与AI搜索表现数据打通。SEO不再单独分析日志,而是把爬虫行为与AI生成结果中的实际可见性相关联,精准了解抓取模式如何影响AI搜索排名。这一集成将带来对内容从抓取到AI训练再到用户展现全过程的前所未有洞察。

伦理化机器人管理将日益重要。随着组织需权衡授予哪些AI机器人内容访问权,日志文件分析能实现对机器人访问的精细管理,使内容发布者能允许有益的AI爬虫,同时屏蔽无价值或不归属的机器人。像LLMs.txt等新兴协议将为机器人访问政策提供结构化表达方式,而日志分析则可验证其执行合规性。

隐私友好的分析将不断发展,以在满足GDPR等法规的同时保障详细抓取洞察。更先进的匿名化技术和注重隐私的分析工具,将使组织在不保留或暴露个人数据的情况下提取有价值的日志洞察。随着日志分析普及及数据保护法规趋严,这一点尤为重要。

传统SEO与AI搜索优化的融合,意味着日志文件分析在未来数年内仍将是技术SEO战略的核心。今天掌握日志文件分析的组织,将在搜索不断演进中稳占先机。

日志文件分析提供来自你服务器的完整、未抽样数据,捕获所有爬虫的每一次请求,而Google Search Console的爬取统计仅显示Google爬虫的汇总、抽样数据。日志文件能提供更为细致的历史数据,并洞察非Google机器人(包括GPTBot、ClaudeBot等AI爬虫)的行为,因此在了解真实爬虫行为和识别GSC可能遗漏的技术问题方面更全面。

对于高流量网站,建议每周进行日志文件分析,以便及早发现问题并监控爬取模式变化。小型网站每月复查一次有助于建立趋势并识别新的机器人活动。不论站点规模如何,通过自动化工具实施持续监控,有助于实时发现异常,确保能够快速应对抓取预算浪费或影响搜索可见性的技术问题。

可以,日志文件分析是追踪AI机器人流量最有效的方法之一。通过检查服务器日志中的user-agent字符串和IP地址,你可以识别哪些AI机器人访问了你的网站、访问了哪些内容以及访问频率。这些数据对于了解你的内容如何被AI驱动的搜索工具和生成式AI模型利用至关重要,从而帮助你优化AI可见性,并通过robots.txt规则管理机器人访问。

日志文件分析可揭示众多技术SEO问题,包括抓取错误(4xx与5xx状态码)、重定向链、页面加载缓慢、站内未链接的孤立页面、低价值URL上的抓取预算浪费、JavaScript渲染问题以及重复内容问题。它还可识别伪装机器人活动,并协助发现合法爬虫遇到可访问性障碍的情形,使你能够优先修复直接影响搜索引擎可见性和收录的问题。

日志文件分析能准确显示搜索引擎抓取了哪些页面及其频率,揭示抓取预算被低价值内容(如分页存档、筛选导航、过期URL)浪费的情况。通过识别这些低效,你可以调整robots.txt文件、优化重要页面的内部链接,并实施规范标签,将抓取重心引导至高价值内容,确保搜索引擎专注于对业务最重要的页面。

服务器日志文件通常包括IP地址(识别请求来源)、时间戳(请求发生时间)、HTTP方法(通常为GET或POST)、请求URL(被访问的具体页面)、HTTP状态码(200、404、301等)、响应字节大小、来源信息和user-agent字符串(识别爬虫或浏览器)。这些详尽的数据帮助SEO人员还原每次服务器交互的全过程,并发现影响可抓取性和收录的模式。

伪装的机器人冒充合法搜索引擎爬虫,但其IP地址不在搜索引擎发布的官方IP段内。识别方法是将user-agent字符串(如“Googlebot”)与Google、Bing等官方公布的IP段进行对比。Screaming Frog Log File Analyzer等工具可自动验证机器人真伪。伪装机器人会浪费抓取预算并增加服务器压力,因此建议通过robots.txt或防火墙规则屏蔽。

了解什么是 AI 爬虫分析,以及服务器日志分析如何追踪 AI 爬虫行为、内容访问模式和在 ChatGPT、Perplexity、Google AI Overviews 等 AI 搜索平台中的可见性。...

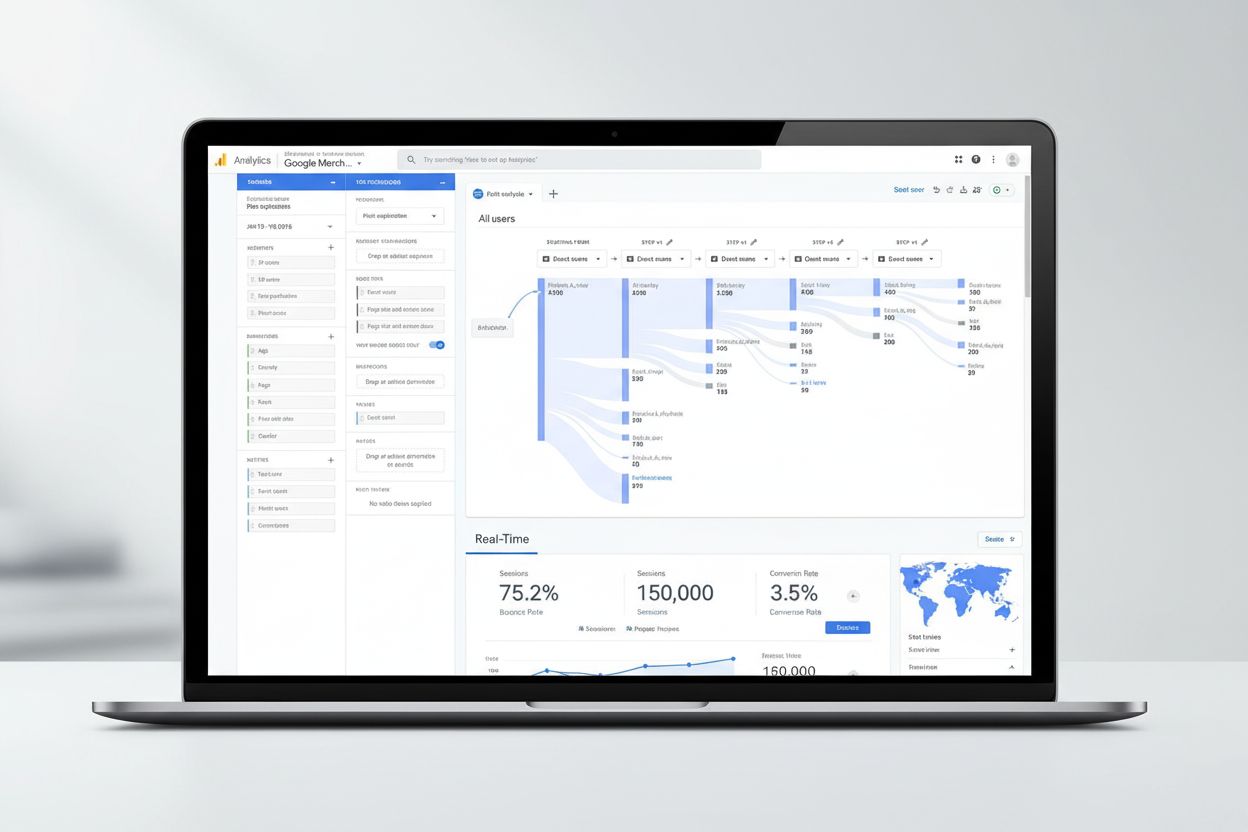

Google Analytics 是谷歌免费的网络分析平台,可追踪网站流量、用户行为和转化。了解其工作原理、关键指标、GA4 特性,以及其在数字营销中的作用。...

了解如何通过服务器日志、工具和最佳实践,追踪并监控AI爬虫在你网站上的活动。识别GPTBot、ClaudeBot及其他AI机器人。

Cookie 同意

我们使用 cookie 来增强您的浏览体验并分析我们的流量。 See our privacy policy.