Server-side rendering vs CSR: Indvirkning på AI-synlighed

Opdag hvordan SSR- og CSR-renderingstrategier påvirker AI-crawleres synlighed, brandcitater i ChatGPT og Perplexity samt din samlede AI-søgepræsentation.

Komplet referenceguide til AI-crawlere og bots. Identificer GPTBot, ClaudeBot, Google-Extended og 20+ andre AI-crawlere med brugeragenter, crawl-hastigheder og blokeringsstrategier.

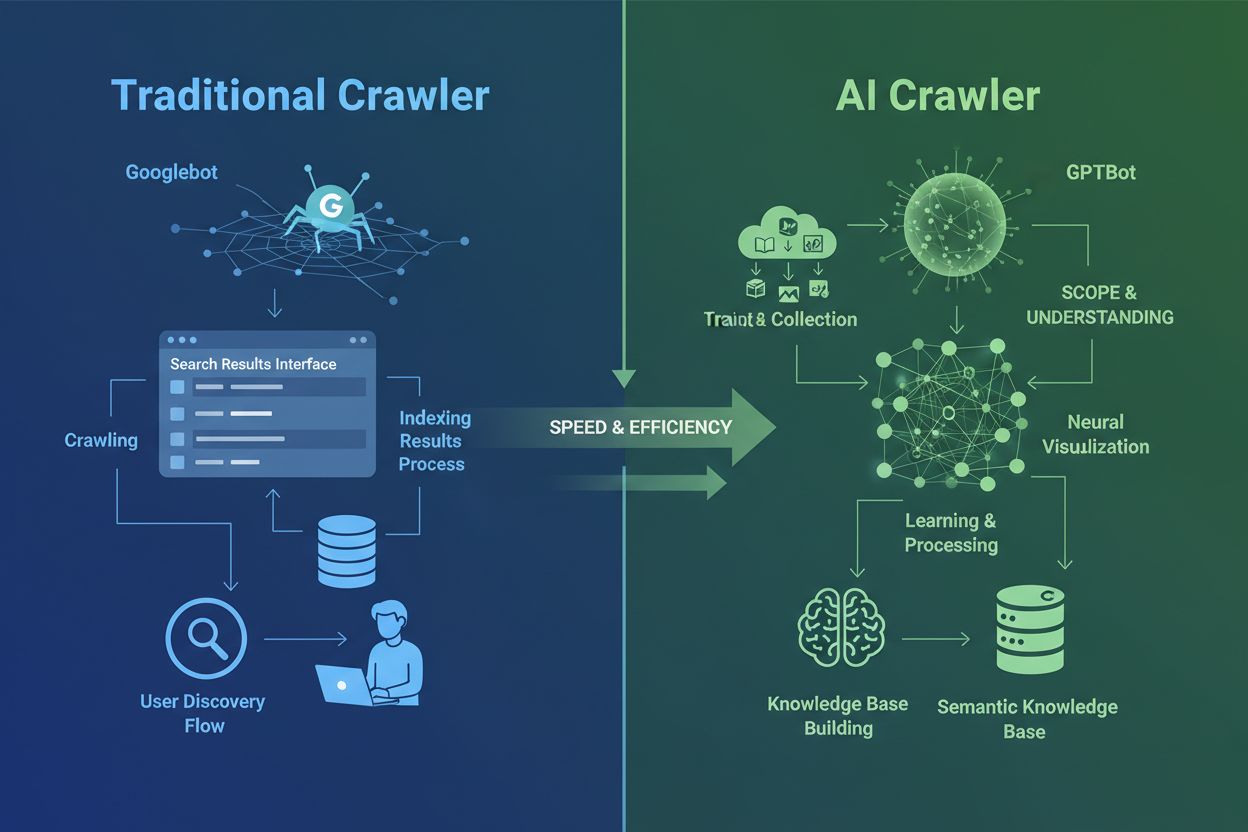

AI-crawlere er grundlæggende forskellige fra de traditionelle søgemaskine-crawlere, du har kendt i årtier. Mens Googlebot og Bingbot indekserer indhold for at hjælpe brugere med at finde information via søgeresultater, indsamler AI-crawlere som GPTBot og ClaudeBot data specifikt for at træne store sprogmodeller. Denne forskel er afgørende: traditionelle crawlere skaber veje til menneskelig opdagelse, mens AI-crawlere fodrer de kunstige intelligensers vidensbaser. Ifølge nyere data udgør AI-crawlere nu næsten 80% af al bottrafik til websites, hvor træningscrawlere forbruger store mængder indhold, men sender minimal henvisningstrafik tilbage til udgivere. I modsætning til traditionelle crawlere, som har svært ved dynamiske JavaScript-tunge sider, anvender AI-crawlere avanceret maskinlæring til at forstå indhold kontekstuelt, omtrent som et menneske ville læse det. De kan tolke mening, tone og formål uden manuelle konfigurationsopdateringer. Dette repræsenterer et kvantespring i webindekseringsteknologi, der kræver, at websiteejere genovervejer deres strategi for crawler-styring fuldstændigt.

Landskabet for AI-crawlere er blevet stadig mere overfyldt, efterhånden som store teknologivirksomheder kapløber om at bygge deres egne store sprogmodeller. OpenAI, Anthropic, Google, Meta, Amazon, Apple og Perplexity driver hver især flere specialiserede crawlere, som udfører forskellige funktioner i deres respektive AI-økosystemer. Virksomheder implementerer flere crawlere, fordi forskellige formål kræver forskellig adfærd: nogle crawlere fokuserer på indsamling af store mængder træningsdata, andre håndterer realtids-søgeindeksering, og andre igen henter indhold on-demand, når brugere anmoder om det. Forståelsen af dette økosystem kræver kendskab til tre primære crawler-kategorier: træningscrawlere, der indsamler data til modeludvikling, søge- og citationscrawlere, der indekserer indhold til AI-drevne søgeoplevelser, og brugerudløste fetchers, der aktiveres, når brugere specifikt anmoder om indhold gennem AI-assistenter. Tabellen herunder giver et hurtigt overblik over de største aktører:

| Virksomhed | Crawler-navn | Primært formål | Crawl-hastighed | Træningsdata |

|---|---|---|---|---|

| OpenAI | GPTBot | Modeltræning | 100 sider/time | Ja |

| OpenAI | ChatGPT-User | Realtids-brugeranmodninger | 2400 sider/time | Nej |

| OpenAI | OAI-SearchBot | Søgeindeksering | 150 sider/time | Nej |

| Anthropic | ClaudeBot | Modeltræning | 500 sider/time | Ja |

| Anthropic | Claude-User | Realtids webadgang | <10 sider/time | Nej |

| Google-Extended | Gemini AI træning | Variabel | Ja | |

| Gemini-Deep-Research | Research-funktion | <10 sider/time | Nej | |

| Meta | Meta-ExternalAgent | AI-modeltræning | 1100 sider/time | Ja |

| Amazon | Amazonbot | Serviceforbedring | 1050 sider/time | Ja |

| Perplexity | PerplexityBot | Søgeindeksering | 150 sider/time | Nej |

| Apple | Applebot-Extended | AI-træning | <10 sider/time | Ja |

| Common Crawl | CCBot | Åbent datasæt | <10 sider/time | Ja |

OpenAI driver tre forskellige crawlere, hver med specifikke roller i ChatGPT-økosystemet. Forståelse af disse crawlere er væsentlig, fordi OpenAI’s GPTBot er en af de mest aggressive og udbredte AI-crawlere på internettet:

GPTBot – OpenAI’s primære træningscrawler, der systematisk indsamler offentligt tilgængelige data for at træne og forbedre GPT-modeller, herunder ChatGPT og GPT-4o. Denne crawler arbejder med ca. 100 sider i timen og respekterer robots.txt-direktiver. OpenAI offentliggør officielle IP-adresser på https://openai.com/gptbot.json til verifikationsformål.

ChatGPT-User – Denne crawler optræder, når en reel bruger interagerer med ChatGPT og beder den om at gennemse en specifik webside. Den arbejder med meget højere hastighed (op til 2400 sider/time), fordi den udløses af brugerhandlinger frem for systematisk crawling. Indhold tilgået gennem ChatGPT-User bruges ikke til modeltræning, hvilket gør den værdifuld for realtidssynlighed i ChatGPT-søgeresultater.

OAI-SearchBot – Designet specifikt til ChatGPT’s søgefunktionalitet, indekserer denne crawler indhold til realtidssøgeresultater uden at indsamle træningsdata. Den arbejder med omkring 150 sider i timen og hjælper dit indhold med at fremstå i ChatGPT-søgninger, når brugere stiller relevante spørgsmål.

OpenAI’s crawlere respekterer robots.txt-direktiver og opererer fra verificerede IP-ranges, hvilket gør dem relativt nemme at styre sammenlignet med mindre gennemsigtige konkurrenter.

Anthropic, virksomheden bag Claude AI, driver flere crawlere med forskellige formål og grader af gennemsigtighed. Virksomheden har været mindre åben med dokumentationen end OpenAI, men deres crawler-adfærd er veldokumenteret via serverlog-analyser:

ClaudeBot – Anthropics vigtigste træningscrawler, der indsamler webindhold for at forbedre Claudes vidensbase og evner. Denne crawler arbejder med cirka 500 sider i timen og er det primære mål, hvis du vil forhindre dit indhold i at blive brugt til Claudes modeltræning. Den fulde brugeragent-streng er Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; ClaudeBot/1.0; +claudebot@anthropic.com).

Claude-User – Aktiveres, når Claude-brugere anmoder om realtids webadgang, og denne crawler henter indhold on-demand i meget lille volumen. Den respekterer autentificering og forsøger ikke at omgå adgangsbegrænsninger, hvilket gør den relativt harmløs ressource-mæssigt.

Claude-SearchBot – Understøtter Claudes interne søgefunktioner og hjælper dit indhold med at dukke op i Claudes søgeresultater, når brugere stiller spørgsmål. Denne crawler arbejder ved meget lav volumen og tjener primært indekseringsformål frem for træning.

En væsentlig bekymring ved Anthropics crawlere er crawl-to-refer-forholdet: Cloudflare-data viser, at for hver henvisning Anthropic sender tilbage til et website, har deres crawlere allerede besøgt cirka 38.000 til 70.000 sider. Denne massive ubalance betyder, at dit indhold bliver forbrugt langt mere aggressivt end det bliver citeret, hvilket rejser vigtige spørgsmål om rimelig kompensation for indholdsbrug.

Googles tilgang til AI-crawling adskiller sig markant fra konkurrenterne, da virksomheden opretholder en streng adskillelse mellem søgeindeksering og AI-træning. Google-Extended er den specifikke crawler, der indsamler data til træning af Gemini (tidligere Bard) og andre Google AI-produkter, helt adskilt fra den traditionelle Googlebot:

Brugeragent-strengen for Google-Extended er: Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Google-Extended/1.0. Denne adskillelse er tilsigtet og gavnlig for websiteejere, da du kan blokere Google-Extended via robots.txt uden at påvirke din synlighed i Google Søgning overhovedet. Google udtaler officielt, at blokering af Google-Extended har nul indflydelse på søgerangeringer eller inklusion i AI Overviews, selvom nogle webmastere har rapporteret bekymringer, der bør overvåges. Gemini-Deep-Research er en anden Google-crawler, der understøtter Geminis research-funktion og arbejder i meget lav volumen med minimal indvirkning på serverressourcer. En væsentlig teknisk fordel ved Googles crawlere er deres evne til at afvikle JavaScript og gengive dynamisk indhold, i modsætning til de fleste konkurrenter. Det betyder, at Google-Extended kan crawle React-, Vue- og Angular-applikationer effektivt, mens OpenAI’s GPTBot og Anthropics ClaudeBot ikke kan. For websiteejere med JavaScript-tunge applikationer har denne forskel stor betydning for AI-synlighed.

Ud over de største teknologivirksomheder driver adskillige andre organisationer AI-crawlere, der fortjener opmærksomhed. Meta-ExternalAgent, stille lanceret i juli 2024, skraber webindhold til træning af Metas AI-modeller og forbedring af produkter på tværs af Facebook, Instagram og WhatsApp. Denne crawler arbejder med cirka 1100 sider i timen og har fået mindre offentlig opmærksomhed end konkurrenterne trods sin aggressive adfærd. Bytespider, drevet af ByteDance (TikToks moderselskab), er siden lanceringen i april 2024 blevet en af internettets mest aggressive crawlere. Tredjeparts-overvågning tyder på, at Bytespider crawler langt mere aggressivt end GPTBot eller ClaudeBot, selvom de præcise forhold varierer. Nogle rapporter indikerer, at den ikke altid respekterer robots.txt-direktiver, hvilket gør IP-baseret blokering mere pålidelig.

Perplexitys crawlere omfatter PerplexityBot til søgeindeksering og Perplexity-User til realtids-indhentning af indhold. Perplexity har fået anekdotiske rapporter om at ignorere robots.txt-direktiver, selvom virksomheden hævder at overholde dem. Amazonbot driver Alexas spørgsmål-og-svar-funktioner og respekterer robots.txt-protokollen, med cirka 1050 sider i timen. Applebot-Extended, introduceret i juni 2024, bestemmer hvordan indhold, der allerede er indekseret af Applebot, vil blive brugt til Apples AI-træning, selvom den ikke direkte crawler websider. CCBot, drevet af Common Crawl (en non-profit-organisation), bygger åbne webarkiver, som bruges af flere AI-virksomheder, herunder OpenAI, Google, Meta og Hugging Face. Nye crawlere fra virksomheder som xAI (Grok), Mistral og DeepSeek er begyndt at optræde i serverlogs og signalerer fortsat ekspansion af AI-crawler-økosystemet.

Nedenfor ses en omfattende referencetabel over verificerede AI-crawlere, deres formål, brugeragent-strenge og robots.txt-blokeringssyntaks. Tabellen opdateres løbende baseret på serverlog-analyse og officiel dokumentation. Hver post er verificeret mod officielle IP-lister, når det er tilgængeligt:

| Crawler-navn | Virksomhed | Formål | User Agent | Crawl-hastighed | IP-verifikation | Robots.txt syntaks |

|---|---|---|---|---|---|---|

| GPTBot | OpenAI | Indsamling af træningsdata | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; GPTBot/1.3; +https://openai.com/gptbot) | 100/t | ✓ Officiel | User-agent: GPTBot Disallow: / |

| ChatGPT-User | OpenAI | Realtids-brugeranmodninger | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko); compatible; ChatGPT-User/1.0 | 2400/t | ✓ Officiel | User-agent: ChatGPT-User Disallow: / |

| OAI-SearchBot | OpenAI | Søgeindeksering | Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36; compatible; OAI-SearchBot/1.3 | 150/t | ✓ Officiel | User-agent: OAI-SearchBot Disallow: / |

| ClaudeBot | Anthropic | Indsamling af træningsdata | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; ClaudeBot/1.0; +claudebot@anthropic.com) | 500/t | ✓ Officiel | User-agent: ClaudeBot Disallow: / |

| Claude-User | Anthropic | Realtids webadgang | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Claude-User/1.0) | <10/t | ✗ Ikke tilgængelig | User-agent: Claude-User Disallow: / |

| Claude-SearchBot | Anthropic | Søgeindeksering | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Claude-SearchBot/1.0) | <10/t | ✗ Ikke tilgængelig | User-agent: Claude-SearchBot Disallow: / |

| Google-Extended | Gemini AI træning | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Google-Extended/1.0) | Variabel | ✓ Officiel | User-agent: Google-Extended Disallow: / | |

| Gemini-Deep-Research | Research-funktion | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Gemini-Deep-Research) | <10/t | ✓ Officiel | User-agent: Gemini-Deep-Research Disallow: / | |

| Bingbot | Microsoft | Bing søgning & Copilot | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; bingbot/2.0) | 1300/t | ✓ Officiel | User-agent: Bingbot Disallow: / |

| Meta-ExternalAgent | Meta | AI-modeltræning | meta-externalagent/1.1 (+https://developers.facebook.com/docs/sharing/webmasters/crawler) | 1100/t | ✗ Ikke tilgængelig | User-agent: Meta-ExternalAgent Disallow: / |

| Amazonbot | Amazon | Serviceforbedring | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Amazonbot/0.1) | 1050/t | ✓ Officiel | User-agent: Amazonbot Disallow: / |

| Applebot-Extended | Apple | AI-træning | Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/605.1.15; compatible; Applebot-Extended | <10/t | ✓ Officiel | User-agent: Applebot-Extended Disallow: / |

| PerplexityBot | Perplexity | Søgeindeksering | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; PerplexityBot/1.0) | 150/t | ✓ Officiel | User-agent: PerplexityBot Disallow: / |

| Perplexity-User | Perplexity | Realtids-indhentning | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; Perplexity-User/1.0) | <10/t | ✓ Officiel | User-agent: Perplexity-User Disallow: / |

| Bytespider | ByteDance | AI-træning | Mozilla/5.0 (Linux; Android 5.0) AppleWebKit/537.36; compatible; Bytespider | <10/t | ✗ Ikke tilgængelig | User-agent: Bytespider Disallow: / |

| CCBot | Common Crawl | Åbent datasæt | CCBot/2.0 (https://commoncrawl.org/faq/ ) | <10/t | ✓ Officiel | User-agent: CCBot Disallow: / |

| DuckAssistBot | DuckDuckGo | AI-søgning | DuckAssistBot/1.2; (+http://duckduckgo.com/duckassistbot.html) | 20/t | ✓ Officiel | User-agent: DuckAssistBot Disallow: / |

| Diffbot | Diffbot | Dataudtræk | Mozilla/5.0 (Windows; U; Windows NT 5.1; en-US; rv:1.9.1.2) Gecko/20090729 Firefox/3.5.2 Diffbot/0.1 | <10/t | ✗ Ikke tilgængelig | User-agent: Diffbot Disallow: / |

| MistralAI-User | Mistral | Realtids-indhentning | Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; MistralAI-User/1.0) | <10/t | ✗ Ikke tilgængelig | User-agent: MistralAI-User Disallow: / |

| ICC-Crawler | NICT | AI/ML-træning | ICC-Crawler/3.0 (Mozilla-compatible; https://ucri.nict.go.jp/en/icccrawler.html ) | <10/t | ✗ Ikke tilgængelig | User-agent: ICC-Crawler Disallow: / |

Ikke alle AI-crawlere tjener samme formål, og forståelse af disse forskelle er afgørende for at træffe informerede blokkeringsbeslutninger. Træningscrawlere udgør ca. 80% af al AI-bottrafik og indsamler indhold specifikt til at bygge datasæt til udvikling af store sprogmodeller. Når dit indhold først er i et træningsdatasæt, bliver det en permanent del af modellens viden, hvilket potentielt reducerer brugernes behov for at besøge dit site for svar. Træningscrawlere som GPTBot, ClaudeBot og Meta-ExternalAgent arbejder med høj volumen og systematiske crawling-mønstre, men returnerer minimal til ingen henvisningstrafik til udgivere.

Søge- og citationscrawlere indekserer indhold til AI-drevne søgeoplevelser og kan faktisk sende noget trafik tilbage gennem citationer. Når brugere stiller spørgsmål i ChatGPT eller Perplexity, hjælper disse crawlere med at fremhæve relevante kilder. I modsætning til træningscrawlere arbejder søgecrawlere som OAI-SearchBot og PerplexityBot ved moderat volumen med retrieval-fokuseret adfærd og kan inkludere attribution og links. Brugerudløste fetchers aktiveres kun, når brugere specifikt anmoder om indhold gennem AI-assistenter. Når nogen indsætter en URL i ChatGPT eller beder Perplexity analysere en bestemt side, henter disse fetchers indholdet on-demand. Brugerudløste fetchers arbejder ved meget lav volumen med enkeltstående forespørgsler frem for automatiseret systematisk crawling, og de fleste AI-virksomheder bekræfter, at disse ikke bruges til modeltræning. Forståelse af disse kategorier hjælper dig med at træffe strategiske beslutninger om, hvilke crawlere du vil tillade, og hvilke du vil blokere, baseret på dine forretningsprioriteter.

Det første skridt i at styre AI-crawlere er at forstå, hvilke der faktisk besøger dit website. Dine serveradgangslogs indeholder detaljerede optegnelser over hver anmodning, inklusiv brugeragent-strengen, der identificerer crawleren. De fleste hostingkontrolpaneler tilbyder loganalyseværktøjer, men du kan også tilgå rå logs direkte. For Apache-servere findes logs typisk på /var/log/apache2/access.log, mens Nginx-logs normalt ligger på /var/log/nginx/access.log. Du kan filtrere disse logs med grep for at finde crawler-aktivitet:

grep -i "gptbot\|claudebot\|google-extended\|bytespider" /var/log/apache2/access.log | head -20

Denne kommando viser de 20 seneste anmodninger fra større AI-crawlere. Google Search Console giver crawler-statistik for Googles bots, men viser kun Googles crawlere. Cloudflare Radar tilbyder globale indsigter i AI-bottrafikmønstre og kan hjælpe dig med at identificere de mest aktive crawlere. For at verificere om en crawler er legitim eller spoofet, tjek anmodningens IP-adresse mod officielle IP-lister udgivet af de store virksomheder. OpenAI offentliggør verificerede IP’er på https://openai.com/gptbot.json, Amazon på https://developer.amazon.com/amazonbot/ip-addresses/, og andre har lignende lister. En falsk crawler, der udgiver sig for at være en legitim brugeragent fra en ikke-verificeret IP-adresse, bør blokeres straks, da det sandsynligvis er skadelig scraping-aktivitet.

Robots.txt-filen er dit primære værktøj til at styre crawler-adgang. Denne simple tekstfil, placeret i dit websites rodmappe, fortæller crawlere, hvilke dele af dit site de må tilgå. For at blokere specifikke AI-crawlere skal du tilføje poster som disse:

# Bloker OpenAI's GPTBot

User-agent: GPTBot

Disallow: /

# Bloker Anthropics ClaudeBot

User-agent: ClaudeBot

Disallow: /

# Bloker Googles AI-træning (ikke søgning)

User-agent: Google-Extended

Disallow: /

# Bloker Common Crawl

User-agent: CCBot

Disallow: /

Du kan også tillade crawlere, men sætte ratelimits for at forhindre serveroverbelastning:

User-agent: GPTBot

Crawl-delay: 10

Disallow: /private/

Dette fortæller GPTBot at vente 10 sekunder mellem anmodninger og holde sig ude af din private mappe. For en balanceret tilgang, der tillader søgecrawlere men blokerer træningscrawlere:

# Tillad traditionelle søgemaskiner

User-agent: Googlebot

Allow: /

User-agent: Bingbot

Allow: /

# Bloker alle AI-træningscrawlere

User-agent: GPTBot

User-agent: ClaudeBot

User-agent: CCBot

User-agent: Google-Extended

User-agent: Bytespider

User-agent: Meta-ExternalAgent

Disallow: /

# Tillad AI-søgecrawlere

User-agent: OAI-SearchBot

Allow: /

User-agent: PerplexityBot

Allow: /

De fleste anerkendte AI-crawlere respekterer robots.txt-direktiver, selvom nogle aggressive crawlere ignorerer dem fuldstændigt. Derfor er robots.txt alene utilstrækkelig til fuld beskyttelse.

Robots.txt er vejledende og ikke håndhævelig, hvilket betyder, at crawlere kan ignorere dine direktiver, hvis de ønsker det. For stærkere beskyttelse mod crawlere, der ikke respekterer robots.txt, implementer IP-baseret blokering på serverniveau. Denne tilgang er mere pålidelig, fordi det er sværere at spoofe en IP-adresse end en brugeragent-streng. Du kan allowliste verificerede IP’er fra officielle kilder og blokere alle andre anmodninger, der hævder at være AI-crawlere.

For Apache-servere kan du bruge .htaccess-regler til at blokere crawlere på serverniveau:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} (GPTBot|ClaudeBot|anthropic-ai|Bytespider|CCBot) [NC]

RewriteRule .* - [F,L]

</IfModule>

Dette returnerer et 403 Forbidden-svar til matchende brugeragenter, uanset robots.txt-indstillinger. Firewall-regler giver et andet beskyttelseslag ved at allowliste verificerede IP-områder fra officielle kilder. De fleste webapplikations-firewalls og hostingudbydere giver dig mulighed for at oprette regler, der tillader anmodninger fra verificerede IP’er og blokerer andre, der hævder at være AI-crawlere. HTML meta-tags giver granulær kontrol på sideniveau. Amazon og nogle andre crawlere respekterer noarchive-direktivet:

<meta name="robots" content="noarchive">

Dette fortæller crawlere ikke at bruge siden til modeltræning, mens andre indekseringsaktiviteter muligvis tillades. Vælg din blokeringsmetode baseret på dine tekniske evner og de specifikke crawlere, du ønsker at målrette. IP-baseret blokering er mest pålidelig, men kræver mere teknisk opsætning, mens robots.txt er lettest at implementere, men mindre effektiv mod ikke-kompatible crawlere.

Implementering af crawler-blokeringer er kun halvdelen af ligningen; du skal verificere, at de faktisk fungerer. Regelmæssig overvågning hjælper dig med at fange problemer tidligt og identificere nye crawlere, du ikke har stødt på før. Tjek dine serverlogs ugentligt for usædvanlig botaktivitet og kig efter brugeragent-strenge, der indeholder “bot”, “crawler”, “spider” eller firmanavne som “GPT”, “Claude” eller “Perplexity”. Opsæt alarmer for pludselige stigninger i bottrafik, som kan indikere nye crawlere eller aggressiv adfærd fra eksisterende bots. Google Search Console viser crawl-statistik for Googles bots, hvilket hjælper dig med at overvåge Googlebot og Google-Extended-aktivitet. Cloudflare Radar giver globale indsigter i AI-crawler-trafikmønstre og kan hjælpe med at identificere nye crawlere, der rammer dit site.

For at verificere, at dine robots.txt-blokeringer virker, tilgå din robots.txt-fil direkte på ditdomæne.dk/robots.txt og bekræft, at alle brugeragenter og direktiver vises korrekt. For serverblokeringer, overvåg dine access logs for anmodninger fra blokerede crawlere. Hvis du ser anmodninger fra crawlere, du har blokeret, ignorerer de enten dine direktiver eller spoofe deres brugeragenter. Test dine implementeringer ved at tjekke crawler-adgang i dine analyser og serverlogs. Kvartalsvise gennemgange er vigtige, fordi AI-crawler-landskabet udvikler sig hurtigt. Nye crawlere dukker jævnligt op, eksisterende crawlere opdaterer deres brugeragenter, og virksomheder introducerer nye bots uden varsel. Planlæg regelmæssige gennemgange af din blokliste for at holde styr på tilføjelser og sikre, at din implementering er opdateret.

Selvom styring af crawler-adgang er vigtig, er det lige så afgørende at forstå, hvordan AI-systemer faktisk citerer og refererer dit indhold. AmICited.com tilbyder omfattende overvågning af, hvordan dit brand og indhold optræder i AI-genererede svar på ChatGPT, Perplexity, Google Gemini og andre AI-platforme. I stedet for blot at blokere crawlere hjælper AmICited.com dig med at forstå den reelle effekt af AI-crawlere på din synlighed og autoritet. Platformen sporer, hvilke AI-systemer der citerer dit indhold, hvor ofte dit brand optræder i AI-svar, og hvordan denne synlighed omsættes til trafik og autoritet. Ved at overvåge dine AI-citationer kan du træffe informerede beslutninger om, hvilke crawlere du vil tillade, baseret på faktiske synlighedsdata frem for antagelser. AmICited.com integreres med din overordnede indholdsstrategi og viser dig, hvilke emner og indholdstyper der genererer flest AI-citationer. Denne datadrevne tilgang hjælper dig med at optimere dit indhold til AI-opdagelse, samtidig med at du beskytter din mest værdifulde intellektuelle ejendom. Forståelse af dine AI-citations-målinger giver dig mulighed for at træffe strategiske beslutninger om crawler-adgang,

AI-crawlere som GPTBot og ClaudeBot indsamler indhold specifikt for at træne store sprogmodeller, mens søgemaskine-crawlere som Googlebot indekserer indhold, så folk kan finde det via søgeresultater. AI-crawlere fodrer AI-systemernes vidensbaser, mens søgecrawlere hjælper brugere med at opdage dit indhold. Den væsentligste forskel er formålet: træning versus genfinding.

Nej, blokering af AI-crawlere vil ikke skade dine traditionelle søgeresultater. AI-crawlere som GPTBot og ClaudeBot er helt adskilt fra søgemaskine-crawlere som Googlebot. Du kan blokere Google-Extended (til AI-træning), mens du stadig tillader Googlebot (til søgning). Hver crawler tjener et andet formål, og blokering af én påvirker ikke den anden.

Tjek dine serveradgangslogs for at se, hvilke brugeragenter der besøger dit site. Kig efter botnavne som GPTBot, ClaudeBot, CCBot og Bytespider i brugeragent-strenge. De fleste hostingkontrolpaneler tilbyder loganalyseværktøjer. Du kan også bruge Google Search Console til at overvåge crawl-aktivitet, selvom den kun viser Googles crawlere.

Ikke alle AI-crawlere respekterer robots.txt ens. OpenAI's GPTBot, Anthropics ClaudeBot og Google-Extended følger generelt robots.txt-reglerne. Bytespider og PerplexityBot har modtaget rapporter, der antyder, at de måske ikke altid respekterer robots.txt-direktiver. For crawlere, der ikke respekterer robots.txt, skal du implementere IP-baseret blokering på serverniveau via din firewall eller .htaccess-fil.

Beslutningen afhænger af dine mål. Bloker træningscrawlere, hvis du har proprietært indhold eller begrænsede serverressourcer. Tillad søgecrawlere, hvis du ønsker synlighed i AI-drevne søgeresultater og chatbots, som kan give trafik og etablere autoritet. Mange virksomheder vælger en selektiv tilgang ved at tillade specifikke crawlere og blokere aggressive som Bytespider.

Nye AI-crawlere dukker jævnligt op, så gennemgå og opdater din blokliste mindst kvartalsvist. Følg ressourcer som ai.robots.txt-projektet på GitHub for lister, der vedligeholdes af fællesskabet. Tjek serverlogs månedligt for at identificere nye crawlere, der besøger dit site, men ikke er i din nuværende konfiguration. AI crawler-landskabet udvikler sig hurtigt, og din strategi bør følge med.

Ja, tjek anmodningens IP-adresse mod officielle IP-lister udgivet af de store virksomheder. OpenAI offentliggør verificerede IP'er på https://openai.com/gptbot.json, Amazon på https://developer.amazon.com/amazonbot/ip-addresses/, og andre har lignende lister. En crawler, der efterligner en legitim brugeragent fra en ikke-verificeret IP-adresse, bør blokeres straks, da det sandsynligvis er skadelig scraping.

AI-crawlere kan forbruge betydelig båndbredde og serverressourcer. Bytespider og Meta-ExternalAgent er blandt de mest aggressive crawlere. Nogle udgivere rapporterer, at de har reduceret båndbreddeforbruget fra 800GB til 200GB dagligt ved at blokere AI-crawlere og derved sparer cirka 1.500 dollars om måneden. Overvåg dine serverressourcer i perioder med intensiv crawling, og implementér eventuelt rate limiting for aggressive bots.

Følg, hvilke AI-crawlere der citerer dit indhold, og optimer din synlighed på tværs af ChatGPT, Perplexity, Google Gemini og flere.

Opdag hvordan SSR- og CSR-renderingstrategier påvirker AI-crawleres synlighed, brandcitater i ChatGPT og Perplexity samt din samlede AI-søgepræsentation.

Lær hvordan du tillader AI-bots som GPTBot, PerplexityBot og ClaudeBot at crawle dit website. Konfigurer robots.txt, opsæt llms.txt og optimer for AI-synlighed....

Lær hvordan du blokerer eller tillader AI-crawlere som GPTBot og ClaudeBot ved hjælp af robots.txt, server-niveau blokering og avancerede beskyttelsesmetoder. K...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.