Findes der et AI-søgeindeks? Sådan indekserer AI-motorer indhold

Lær hvordan AI-søgeindekser fungerer, forskellene mellem ChatGPT, Perplexity og SearchGPT's indekseringsmetoder, og hvordan du optimerer dit indhold for AI-søge...

Opdag de grundlæggende forskelle mellem AI-indeksering og Google-indeksering. Lær hvordan LLM’er, vektorembeddings og semantisk søgning omformer informationssøgning, og hvad det betyder for din indholds synlighed.

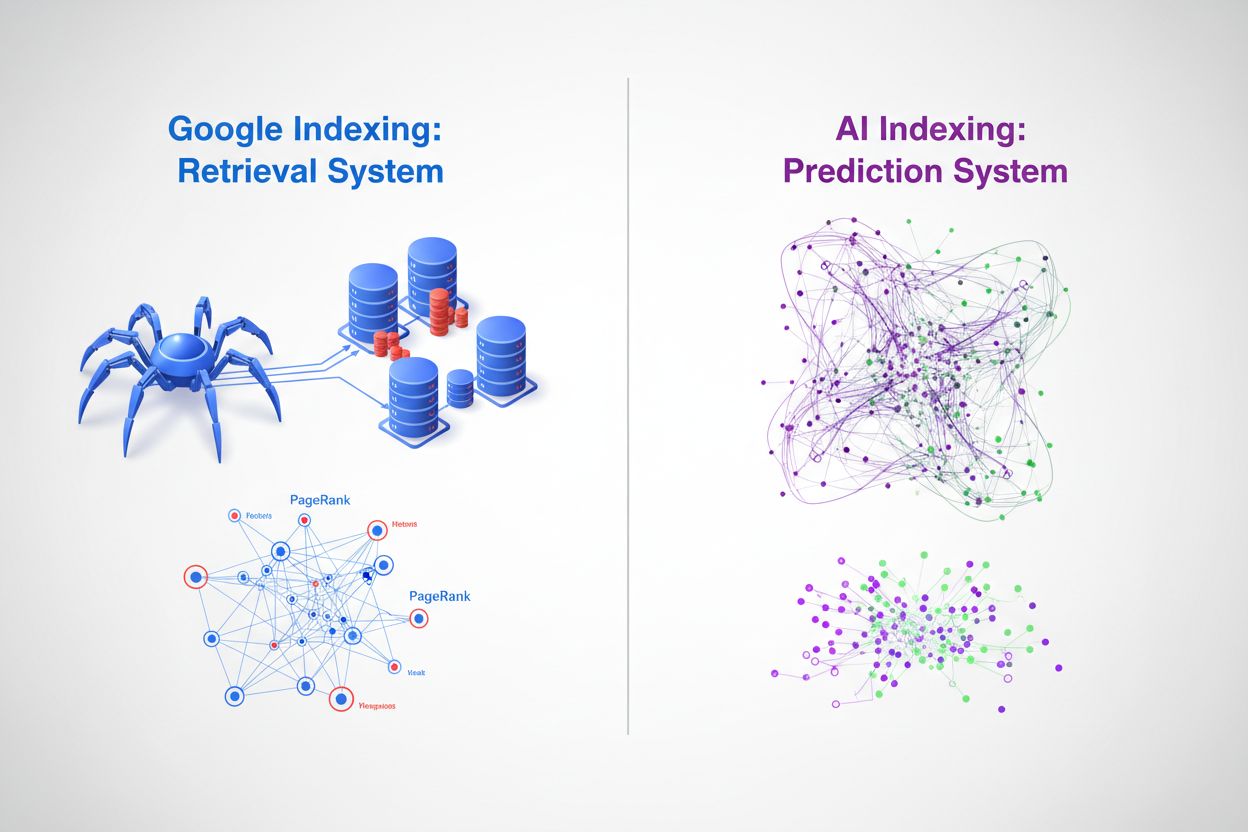

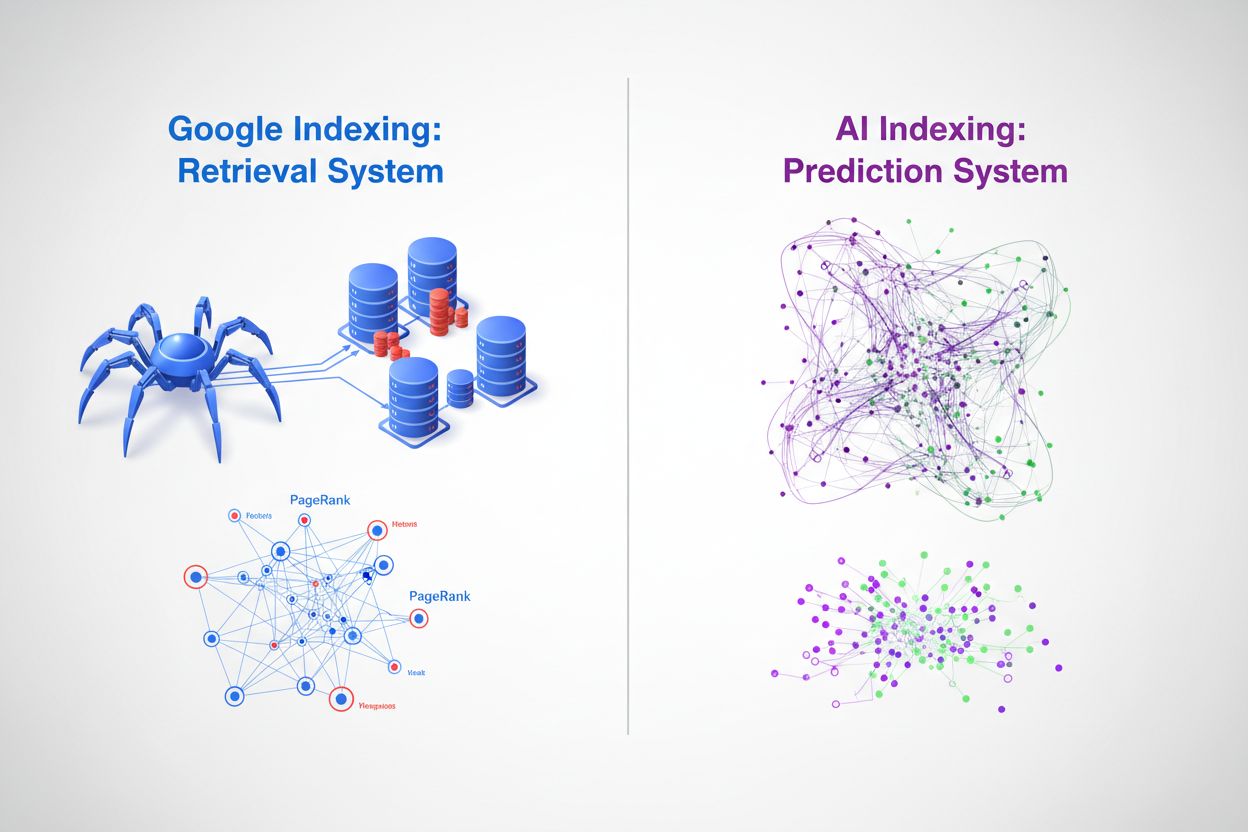

I deres kerne repræsenterer Google-indeksering og AI-indeksering fundamentalt forskellige metoder til at organisere og genfinde information. Googles traditionelle søgemaskine fungerer som et genfindingssystem—den crawler nettet, katalogiserer indhold og returnerer rangerede links, når brugere forespørger specifikke nøgleord. I modsætning hertil fungerer AI-indeksering via store sprogmodeller (LLM’er) som ChatGPT, Gemini og Copilot som et forudsigelsessystem—det koder enorme mængder træningsdata ind i neurale netværk og genererer direkte kontekstuelt relevante svar. Hvor Google spørger “hvor er denne information?”, spørger AI “hvad er det mest relevante svar?” Denne forskel ændrer grundlæggende, hvordan indhold opdages, rangeres og præsenteres for brugere, hvilket skaber to parallelle, men i stigende grad sammenkoblede informationsøkosystemer.

Googles indekseringsproces følger en veletableret pipeline, der har domineret søgning i over to årtier. Googlebot-crawlere gennemgår systematisk nettet, følger links fra side til side og indsamler indhold, som derefter behandles gennem Googles indekseringsinfrastruktur. Systemet udtrækker nøglesignaler såsom søgeord, metadata og linkstruktur, og gemmer disse oplysninger i massive distribuerede databaser. Googles proprietære PageRank-algoritme vurderer siders vigtighed baseret på antallet og kvaliteten af links, der peger på dem, ud fra princippet om, at vigtige sider modtager flere links fra andre vigtige sider. Søgeords-match forbliver centralt for relevansvurdering—når en bruger indtaster en forespørgsel, identificerer Googles system sider, der indeholder de nøjagtige eller semantisk lignende termer, og rangerer dem baseret på hundredvis af rangeringsfaktorer, herunder domæneautoritet, indholdsaktualitet, brugeroplevelsessignaler og emnerelevans. Denne tilgang er fremragende til hurtigt at finde specifik information og har vist sig yderst effektiv for navigations- og transaktionsforespørgsler, hvilket forklarer Googles 89,56% markedsandel for søgning og behandling af 8,5-13,7 milliarder forespørgsler dagligt.

| Aspect | Google-indeksering | Detaljer |

|---|---|---|

| Primær mekanisme | Webcrawling & indeksering | Googlebot gennemgår systematisk websider |

| Rangeringsalgoritme | PageRank + 200+ faktorer | Links, søgeord, aktualitet, brugeroplevelse |

| Datarepræsentation | Søgeord & links | Teksttokens og hyperlink-relationer |

| Opdateringsfrekvens | Kontinuerlig crawling | Realtidsindeksering af nyt/opdateret indhold |

| Forespørgselsbehandling | Søgeords-match | Nøjagtig og semantisk søgeordsmatch |

| Markedsandel | 89,56% globalt | 8,5-13,7 mia. forespørgsler dagligt |

AI-modeller anvender en fundamentalt anderledes indekseringsmekanisme centreret omkring vektorembeddings og semantisk forståelse i stedet for søgeordsmatch. Under træningen behandler LLM’er milliarder af teksttokens og lærer at repræsentere begreber, relationer og betydninger som højdimensionelle vektorer i en proces kaldet embedding-generering. Disse embeddings opfanger semantiske relationer—f.eks. “konge” minus “mand” plus “kvinde” nærmer sig “dronning”—hvilket gør modellen i stand til at forstå kontekst og hensigt frem for blot at matche tegnstrenge. Indekseringsprocessen i AI-systemer involverer flere nøglemekanismer:

Denne tilgang gør det muligt for AI-systemer at forstå brugerhensigt, selv når forespørgsler bruger anden terminologi end kildematerialet, og at syntetisere information på tværs af flere begreber for at generere nye svar. Resultatet er et fundamentalt anderledes genfindingsparadigme, hvor “indekset” er distribueret i de neurale netværks vægte, snarere end lagret i en traditionel database.

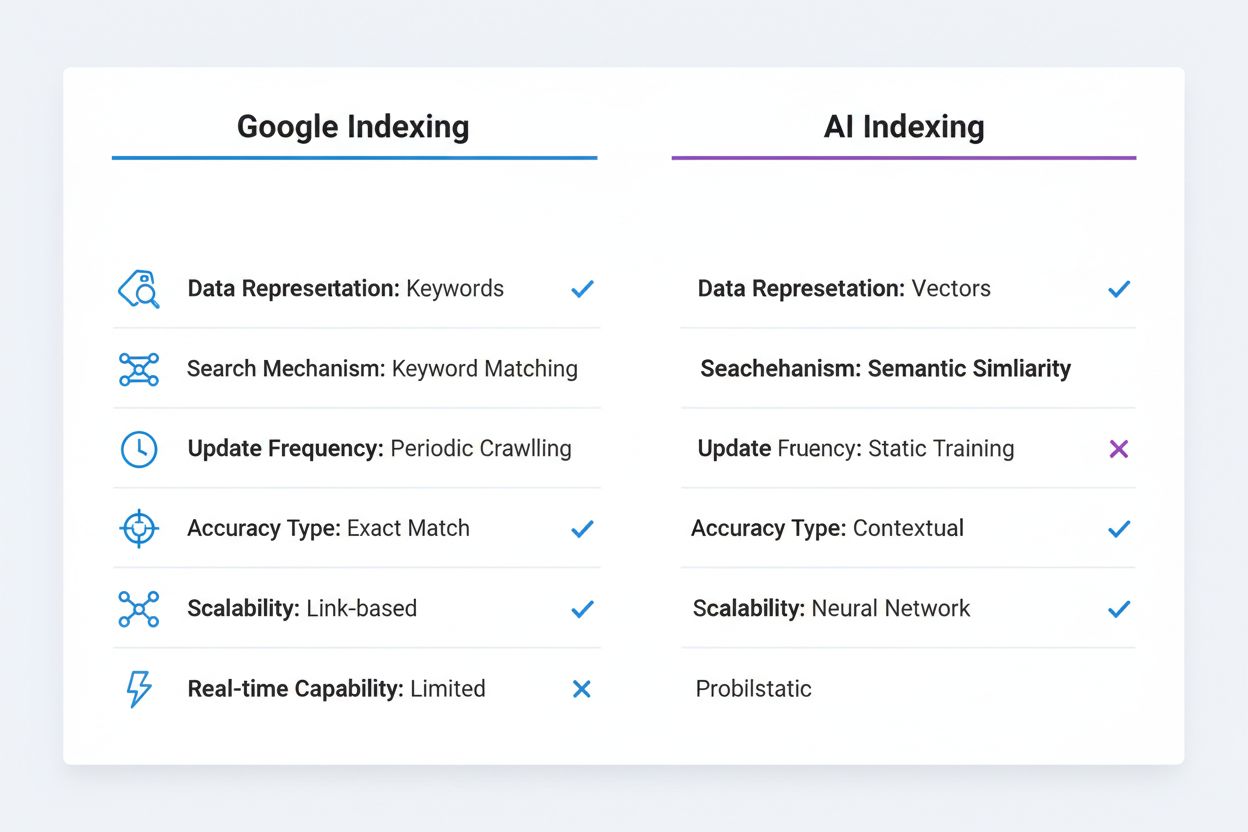

De tekniske forskelle mellem Google-indeksering og AI-indeksering skaber markante konsekvenser for indholdsopdagelse og synlighed. Nøjagtigt søgeordsmatch, som stadig er vigtigt i Googles algoritme, er stort set irrelevant i AI-systemer—en LLM forstår, at “automobil”, “bil” og “køretøj” er semantisk ækvivalente uden behov for eksplicit søgeordsoptimering. Googles indeksering er deterministisk og reproducerbar; den samme forespørgsel returnerer de samme rangerede resultater på tværs af brugere og tidsperioder (bortset fra personalisering). AI-indeksering er sandsynlighedsbaseret og variabel; den samme forespørgsel kan generere forskellige svar baseret på temperatursætninger og samplingparametre, selvom den underliggende viden forbliver konsistent. Googles system er stærkt til struktureret, diskret information som produktpriser, åbningstider og faktuelle datapunkter, som det kan udtrække og vise i rich snippets og knowledge panels. AI-systemer har svært ved denne type præcis, aktuel information, fordi deres træningsdata har en viden-cutoff og de ikke pålideligt kan tilgå realtidsinformation uden eksterne værktøjer. Omvendt excellerer AI-systemer i kontekstuel forståelse og syntese, ved at forbinde forskellige begreber og forklare komplekse relationer på naturligt sprog. Googles indeksering kræver eksplicit linking og citation—indhold skal offentliggøres på nettet og links skal pege på det for at blive opdaget. AI-indeksering fungerer på implicit viden kodet under træningen, hvilket betyder, at værdifuld information låst i PDF’er, betalingsmure eller private databaser forbliver usynlig for begge systemer, men af forskellige grunde.

| Sammenligningsaspekt | Google-indeksering | AI-indeksering |

|---|---|---|

| Datarepræsentation | Søgeord & links | Vektorembeddings |

| Søgemekanisme | Søgeordsmatch | Semantisk lighed |

| Opdateringsfrekvens | Periodisk crawling | Statisk træningsdata |

| Nøjagtighedstype | Fokus på nøjagtigt match | Kontekstuel forståelse |

| Skalerbarhedsmodel | Linkbaseret autoritet | Neurale netværksvægte |

| Realtidskapacitet | Ja (med crawling) | Begrænset (uden RAG) |

Fremkomsten af vektordatabaser udgør en afgørende bro mellem traditionel indeksering og AI-drevet genfinding og gør det muligt for organisationer at implementere semantisk søgning i stor skala. Vektordatabaser som Pinecone, Weaviate og Milvus gemmer højdimensionelle embeddings og udfører lighedssøgninger med metrikker som cosinuslighed og euklidisk afstand, så systemer kan finde semantisk relateret indhold, selv når nøjagtige søgeord ikke matcher. Denne teknologi driver Retrieval-Augmented Generation (RAG), en teknik hvor AI-systemer forespørger vektordatabaser for at hente relevant kontekst, før de genererer svar, hvilket dramatisk forbedrer nøjagtighed og muliggør adgang til proprietær eller aktuel information. RAG-systemer kan hente de mest semantisk lignende dokumenter til en brugers forespørgsel på millisekunder og give AI-modellen forankret information at citere og bygge videre på. Google har integreret semantisk forståelse i sin kernealgoritme gennem BERT og efterfølgende modeller og bevæger sig ud over ren søgeordsmatch til at forstå søgehensigt og indholdsbetydning. Vektordatabaser muliggør realtidsgenfinding af relevant information, så AI-systemer kan tilgå aktuelle data, virksomhedsspecifikke vidensbaser og specialiseret information uden at skulle genoplæres. Denne evne er særligt stærk til virksomhedsbrug, hvor organisationer har behov for, at AI-systemer kan besvare spørgsmål om proprietær information, samtidig med at de opretholder nøjagtighed og giver verificerbare citater.

Fremkomsten af AI-indeksering omformer fundamentalt, hvordan indhold opnår synlighed og driver trafik. Zero-click search-fænomenet—hvor Google besvarer forespørgsler direkte i søgeresultaterne uden at brugerne klikker sig videre til kildesider—er accelereret markant med AI-integration, og AI-chatbots tager dette skridt videre ved at generere svar uden nogen synlig attribution. Traditionel klikbaseret trafik bliver erstattet af AI-citater, hvor indholdsskabere opnår synlighed via omtaler i AI-genererede svar frem for brugerklik. Dette skift har store konsekvenser: et brand nævnt i et ChatGPT-svar når millioner af brugere, men genererer ingen direkte trafik og leverer ingen analysedata om engagement. Brandauthoritet og emneekspertise bliver i stigende grad vigtige, da AI-systemer trænes til at citere autoritative kilder og genkende domæneekspertise, hvilket gør det afgørende for organisationer at etablere klare autoritetssignaler i deres indhold. Struktureret datamarkering bliver mere værdifuld i dette miljø, fordi det hjælper både Google og AI-systemer med at forstå indholdets kontekst og troværdighed. Synlighed handler ikke længere kun om at rangere på søgeord—det handler om at blive anerkendt som en autoritativ kilde, der er værd at citere af AI-systemer, der behandler milliarder af dokumenter og skal skelne mellem troværdig information og misinformation.

I stedet for at AI-indeksering erstatter Google-indeksering, ser fremtiden ud til at være præget af konvergens og sameksistens. Google er allerede begyndt at integrere AI-funktioner direkte i søgningen via sin AI Overview-funktion (tidligere SGE), der genererer AI-drevne resuméer sammen med traditionelle søgeresultater og således skaber et hybridsystem, der kombinerer Googles indekseringsinfrastruktur med generative AI-evner. Denne tilgang gør det muligt for Google at bevare sin kernekompetence—omfattende webindeksering og linkanalyse—samtidig med at AI’s evne til at syntetisere og kontekstualisere information tilføjes. Andre søgemaskiner og AI-virksomheder forfølger lignende strategier, hvor Perplexity kombinerer websøgning med AI-generering, og Microsoft integrerer ChatGPT i Bing. De mest sofistikerede informationsgenfindingssystemer vil sandsynligvis benytte multimodale indekseringsstrategier, der udnytter både traditionel søgeordsbaseret genfinding for præcis information og semantisk/vektorbaseret genfinding for kontekstuel forståelse. Organisationer og indholdsskabere skal forberede sig på et landskab, hvor indhold skal optimeres til flere opdagelsesmekanismer samtidigt—traditionel SEO for Googles algoritme, strukturerede data til AI-systemer og semantisk rigdom til vektorbaseret genfinding.

Indholdsstrateger og marketingfolk skal nu tage en dobbelt optimeringsstrategi i brug, der adresserer både traditionelle søge- og AI-indekseringsmekanismer. Det betyder at opretholde stærk søgeordsoptimering og linkbuilding-strategier for Google, samtidig med at indholdet demonstrerer emneautoritet, semantisk dybde og kontekstuel rigdom, som AI-systemer genkender og citerer. Implementering af omfattende struktureret datamarkering (Schema.org) bliver essentielt, fordi det hjælper både Google og AI-systemer med at forstå indholdets kontekst, troværdighed og relationer—særligt vigtigt for E-E-A-T-signaler (Experience, Expertise, Authoritativeness, Trustworthiness), der påvirker både rangering og citationssandsynlighed. At skabe dybdegående, dækkende indhold, der grundigt udforsker emner, bliver mere værdifuldt end nogensinde, fordi AI-systemer oftere citerer autoritative, veldokumenterede kilder, der giver fuld kontekst, frem for tyndt, søgeordsoptimeret indhold. Organisationer bør implementere citationssporingssystemer for at overvåge omtaler i AI-genererede svar, på samme måde som de sporer backlinks, idet de forstår, at synlighed i AI-uddata udgør en ny form for fortjent omtale. At opbygge en vidensbase eller indholdshub, der demonstrerer klar ekspertise inden for bestemte domæner, øger sandsynligheden for at blive anerkendt som autoritativ kilde af AI-systemer. Endelig betyder fremkomsten af Generative Engine Optimization (GEO) som disciplin, at marketingfolk skal forstå, hvordan man strukturerer indhold, bruger naturlige sprogstrukturer og bygger autoritetssignaler, der appellerer til både algoritmiske rangeringssystemer og AI-citationsmekanismer—en mere nuanceret og sofistikeret tilgang end traditionel SEO alene.

Forskellen mellem AI-indeksering og Google-indeksering handler ikke om, at den ene erstatter den anden, men om en grundlæggende udvidelse af, hvordan information organiseres, genfindes og præsenteres for brugerne. Googles genfindingsbaserede tilgang forbliver stærk til hurtigt at finde specifik information, mens AI’s forudsigelsesbaserede tilgang excellerer i syntese, kontekst og forståelse af brugerhensigt. De mest succesfulde organisationer vil være dem, der anerkender denne dualitet og optimerer deres indhold og digitale tilstedeværelse til begge systemer samtidigt. Ved at forstå de tekniske forskelle mellem disse indekseringstilgange, implementere strukturerede data, opbygge emneautoritet og spore synlighed på tværs af både traditionelle søge- og AI-platforme kan organisationer sikre, at deres indhold forbliver opdageligt og værdifuldt i et stadigt mere komplekst informationslandskab. Søgningsfremtiden er ikke ental—den er flertal, distribueret og stadigt mere intelligent.

Google-indeksering er et genfindingssystem, der crawler internettet, katalogiserer indhold og returnerer rangerede links baseret på nøgleord og links. AI-indeksering er et forudsigelsessystem, der koder træningsdata ind i neurale netværk og genererer kontekstuelt relevante svar direkte. Google spørger 'hvor er denne information?', mens AI spørger 'hvad er det mest relevante svar?'

Vektorembeddings omdanner tekst og andre data til højdimensionelle numeriske arrays, der fanger semantisk betydning. Disse embeddings gør det muligt for AI-systemer at forstå, at 'bil', 'automobil' og 'køretøj' er semantisk ækvivalente uden eksplicit søgeords-match. Lignende begreber repræsenteres som vektorer tæt på hinanden i det højdimensionelle rum.

Traditionelle AI-modeller har en viden-cutoff og kan ikke pålideligt tilgå realtidsinformation. Men Retrieval-Augmented Generation (RAG)-systemer kan forespørge vektordatabaser og webkilder for at hente aktuelle informationer, før de genererer svar, og dermed bygge bro over denne kløft.

GEO er en fremvoksende disciplin, der fokuserer på at optimere indhold til AI-genererede svar i stedet for traditionelle søgerangeringer. Den lægger vægt på emneautoritet, strukturerede data, semantisk dybde og brandets troværdighed for at øge sandsynligheden for at blive citeret af AI-systemer.

Søgeordssøgning matcher nøjagtige eller lignende ord i dokumenter. Semantisk søgning forstår betydningen og hensigten bag forespørgsler og gør det muligt at finde relevante resultater, selv når der bruges forskelligt terminologi. For eksempel kan en semantisk søgning på 'smartphone' også returnere resultater for 'mobilenhed' eller 'mobiltelefon'.

I stedet for erstatning ser fremtiden ud til at være konvergens. Google integrerer AI-funktioner i sin søgning gennem funktioner som AI Overviews og skaber hybride systemer, der kombinerer traditionel indeksering med generativ AI. Organisationer skal optimere til begge systemer samtidigt.

En vektordatabase gemmer højdimensionelle embeddings og udfører lighedssøgninger med metrikker som cosinuslighed. Den er afgørende for implementering af semantisk søgning og Retrieval-Augmented Generation (RAG), så AI-systemer kan tilgå og hente relevant information i stor skala på millisekunder.

Marketingfolk bør anvende en dobbelt optimeringsstrategi: oprethold traditionel SEO for Google, mens de opbygger emneautoritet, implementerer strukturerede data, skaber omfattende indhold og sporer AI-citater. Fokusér på at demonstrere ekspertise og troværdighed for at blive anerkendt som en autoritativ kilde af AI-systemer.

Følg hvordan dit brand vises i AI-genererede svar på ChatGPT, Gemini, Perplexity og Google AI Overviews. Få realtidsindsigt i dine AI-citater og synlighed.

Lær hvordan AI-søgeindekser fungerer, forskellene mellem ChatGPT, Perplexity og SearchGPT's indekseringsmetoder, og hvordan du optimerer dit indhold for AI-søge...

Lær hvordan AI-motorer som ChatGPT, Perplexity og Gemini indekserer og behandler webindhold ved hjælp af avancerede crawlere, NLP og maskinlæring til at træne s...

Lær hvordan Googles AI-rangeringssystemer, herunder RankBrain, BERT og Neural Matching, fungerer for at forstå søgeforespørgsler og rangere websider for relevan...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.