AI-crawlere forklaret: GPTBot, ClaudeBot og flere

Få indsigt i hvordan AI-crawlere som GPTBot og ClaudeBot fungerer, hvordan de adskiller sig fra traditionelle søgemaskinecrawlere, og hvordan du optimerer dit s...

Lær at træffe strategiske beslutninger om blokering af AI-crawlere. Vurder indholdstype, trafikkilder, indtægtsmodeller og konkurrenceposition med vores omfattende beslutningsramme.

AI-crawlere er blevet en betydelig kraft i det digitale økosystem og ændrer fundamentalt, hvordan indhold opdages, indekseres og udnyttes på internettet. Disse automatiserede systemer er designet til systematisk at gennemse websites, udtrække data og fodre det ind i maskinlæringsmodeller, der driver alt fra søgemaskiner til generative AI-applikationer. Landskabet omfatter tre forskellige typer crawlere: datascrapere, der udtrækker specifikke oplysninger til kommercielle formål, søgemaskinecrawlere som Googlebot, der indekserer indhold til søgeresultater, og AI-assistentcrawlere, der indsamler træningsdata til store sproglige modeller. Eksempler inkluderer OpenAI’s GPTBot, Anthropics Claude-Web og Googles AI Overviews crawler, som hver har forskellige formål og indvirkningsprofiler. Ifølge nylige analyser har cirka 21% af de 1.000 største websites allerede implementeret en eller anden form for blokering af AI-crawlere, hvilket indikerer en voksende bevidsthed om behovet for at håndtere disse automatiserede besøgende. At forstå, hvilke crawlere der tilgår dit site, og hvorfor de gør det, er det første kritiske skridt til at træffe en informeret beslutning om, hvorvidt du skal blokere eller tillade dem. Indsatsen er høj, fordi denne beslutning direkte påvirker dit indholds synlighed, dine trafikmønstre og i sidste ende din indtægtsmodel.

I stedet for at træffe en generel beslutning om at blokere eller tillade alle AI-crawlere, indebærer en mere sofistikeret tilgang, at du vurderer din specifikke situation gennem BEDC-rammen, som står for Business Model (Forretningsmodel), Exposure Risk (Eksponeringsrisiko), Dependency on Organic Search (Afhængighed af organisk søgning) og Competitive Position (Konkurrenceposition). Hver af disse fire faktorer vægtes forskelligt afhængigt af dit websites karakteristika, og tilsammen skaber de en omfattende beslutningsmatrix, der tager højde for kompleksiteten i moderne digital publicering. Rammeværket anerkender, at der ikke findes et universelt svar – hvad der virker for en nyhedsorganisation, kan være helt forkert for en SaaS-virksomhed, og det, der gavner et etableret brand, kan skade en ny konkurrent. Ved systematisk at evaluere hver faktor kan du gå ud over følelsesmæssige reaktioner på AI og i stedet træffe datadrevne beslutninger, der stemmer overens med dine forretningsmål.

| Faktor | Anbefaling | Nøgleovervejelse |

|---|---|---|

| Forretningsmodel | Reklamefinansierede sider bør være mere forsigtige; abonnementsmodeller kan være mere tilladende | Indtægtsafhængighed af direkte brugerengagement vs. licensering |

| Eksponeringsrisiko | Original forskning og proprietært indhold bør blokeres; standardindhold kan være mere åbent | Konkurrencefordel knyttet til unikke indsigter eller data |

| Afhængighed af organisk søgning | Høj afhængighed (>40% trafik) tilsiger at tillade Google-crawlere, men blokere AI-assistenter | Balancering mellem søgesynlighed og beskyttelse af AI-træningsdata |

| Konkurrenceposition | Markedsledere kan tillade sig at blokere; nye aktører kan have fordel af AI-synlighed | Førstebegrupperet fordel i AI-partnerskaber vs. indholdsbeskyttelse |

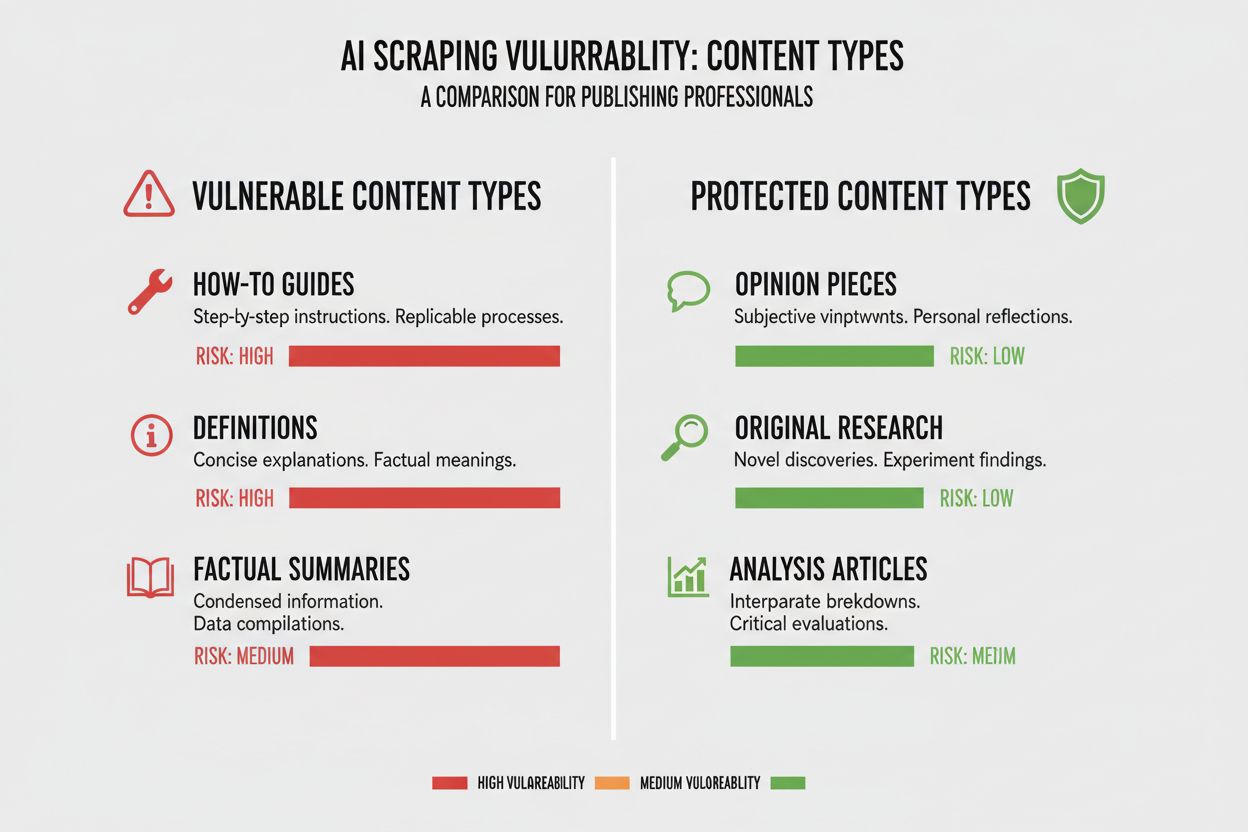

Forskellige indholdstyper har meget forskellige grader af sårbarhed over for AI-crawling, og at forstå dit indholds position i dette spektrum er afgørende for at træffe den rigtige beslutning. Original forskning og proprietære data er dine mest værdifulde aktiver og kræver den stærkeste beskyttelse, da AI-modeller, der trænes på dette indhold, direkte kan konkurrere med din monetariseringsstrategi. Nyheder og aktuelle informationer befinder sig i en mellemposition – selvom værdien hurtigt falder, er det stadig kritisk at blive indekseret af søgemaskiner for at få trafik, hvilket skaber en spænding mellem søgesynlighed og beskyttelse af AI-træningsdata. Standardindhold som guides, vejledninger og generelt referenceindhold er langt mindre sårbart, fordi det findes bredt på nettet og sjældent er din primære indtægtskilde. Stemmebaseret og multimedieindhold har en naturlig beskyttelse, da nuværende AI-crawlere har svært ved at udtrække meningsfuld værdi fra lyd og video, hvilket gør disse formater iboende sikrere mod AI-træningsdataudtrækning. Tidløst undervisningsindhold og holdningsprægede artikler ligger et sted imellem; de er værdifulde for søgetrafik, men mindre direkte truet af AI-konkurrence. Den centrale indsigt er, at din blokering bør stå mål med den konkurrencefordel, dit indhold giver – beskyt dine kronjuveler, men forbliv åben for crawlere på indhold, der nyder godt af bred distribution.

Din afhængighed af organisk søgetrafik er måske den mest konkrete faktor i AI-crawlerbeslutningen, fordi den direkte kvantificerer afvejningen mellem søgesynlighed og indholdsbeskyttelse. Websites, der får mere end 40% af deres trafik fra organisk søgning, står over for et kritisk vilkår: blokering af AI-crawlere betyder ofte også blokering eller begrænsning af Googles crawlere, hvilket ville ødelægge deres søgesynlighed og organiske trafik. Skellet mellem Google-Extended (der crawler til AI-træning) og Googlebot (der crawler til søgeindeksering) er afgørende her, da du teoretisk kan tillade den ene og blokere den anden – dog med større teknisk kompleksitet. Et sigende casestudie fra The New York Times illustrerer trafikindsatsen: publikationen modtog ca. 240.600 besøg fra AI-crawlere i en given periode, hvilket viser skalaen af AI-drevet trafik for store udgivere. Men den ubehagelige realitet, som Akamai-data afslører, er, at blokering af crawlere resulterer i 96% mindre henvisningstrafik fra de kilder, hvilket antyder, at AI-crawlernes trafikbidrag er minimal i forhold til traditionel søgning. Forholdet mellem crawl og henvisning for de fleste AI-crawlere er ekstremt lavt – ofte genererer mindre end 0,15% af det crawlede indhold egentlige tilbagevendende besøg – hvilket betyder, at blokering af disse crawlere har minimal effekt på din reelle brugertrafik. For websites med høj afhængighed af organisk søgetrafik skal beslutningen om at blokere AI-crawlere vejes op mod risikoen for ved en fejl at blokere søgemaskinecrawlere, hvilket ville være langt mere skadeligt for din forretning.

Din indtægtsmodel former grundlæggende, hvordan du bør forholde dig til AI-crawlere, fordi forskellige monetariseringsstrategier skaber forskellige incitamenter omkring indholdsdistribution og -beskyttelse. Reklamefinansierede websites oplever den største spænding i forhold til AI-crawlere, fordi deres indtægt afhænger af, at brugere besøger deres side og ser annoncer, og AI-modeller, der opsummerer deres indhold, mindsker incitamentet til at klikke sig ind. Abonnementsbaserede modeller kan i højere grad tillade AI-crawlere, da deres indtægter kommer fra direkte brugerabonnementer frem for annoncemålinger, og en vis AI-synlighed kan endda øge antallet af abonnementer. Hybridmodeller, der kombinerer annoncer, abonnementer og affiliateindtægter, kræver mere nuanceret tænkning, da blokering af crawlere måske beskytter annonceindtægter, men samtidig kan skade affiliate-muligheder eller abonnementsvækst. En ny mulighed, der fortjener opmærksomhed, er AI-henvisningsmodellen, hvor websites potentielt kan tjene penge ved at tillade AI-crawlere adgang mod kreditering og trafikhenvisninger – en model, der stadig er under udvikling, men som kan ændre økonomien i indholdsdistribution. For udgivere, der forsøger at forstå den fulde indvirkning af AI-crawlere på deres forretning, tilbyder værktøjer som AmICited.com afgørende overvågningsmuligheder til at spore, hvor dit indhold bliver citeret og brugt af AI-systemer, hvilket giver dig indsigt i den faktiske værdibytte, der finder sted med dit indhold. Nøglen er at forstå din indtægtsmodel tilstrækkeligt til at kunne forudsige, hvordan AI-crawlere påvirker hver indtægtsstrøm, i stedet for blot at træffe en generel beslutning af princip.

Når du har besluttet at blokere visse AI-crawlere, kræver den tekniske implementering, at du forstår både mulighederne og begrænsningerne ved de værktøjer, du har til rådighed. Den mest almindelige metode er at bruge robots.txt, en simpel tekstfil placeret i roden af dit website, der instruerer crawlere i, hvilke dele af dit site de må og ikke må tilgå. Men robots.txt har en væsentlig begrænsning: det er en frivillig standard, der er afhængig af, at crawlere respekterer dine instruktioner, og ondsindede eller aggressive crawlere kan ignorere den fuldstændigt. Her er et eksempel på, hvordan du blokerer specifikke AI-crawlere i din robots.txt-fil:

User-agent: GPTBot

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Claude-Web

Disallow: /

Ud over robots.txt bør du overveje at blokere disse større AI-crawlere:

For mere robust beskyttelse implementerer mange organisationer blokering på CDN-niveau gennem tjenester som Cloudflare, der kan blokere trafikken ved netværkskanten, før den overhovedet når dine servere, hvilket giver bedre ydeevne og sikkerhed. En dobbeltlags tilgang, hvor du kombinerer robots.txt med blokering på CDN-niveau, giver den stærkeste beskyttelse, da det fanger både respektfulde crawlere, der overholder robots.txt, og aggressive crawlere, der ignorerer den. Det er vigtigt at bemærke, at blokering af crawlere på CDN-niveau kræver større teknisk kunnen og kan have utilsigtede konsekvenser, hvis det ikke konfigureres korrekt, så denne tilgang egner sig bedst til organisationer med dedikerede tekniske ressourcer.

Den ubehagelige sandhed ved at blokere AI-crawlere er, at den faktiske trafikpåvirkning ofte er langt mindre, end den følelsesmæssige reaktion på AI-scraping kunne antyde, og dataene afslører et mere nuanceret billede, end mange udgivere forventer. Ifølge nyere analyser udgør AI-crawlere typisk kun 0,15% af den samlede websitetr afik for de fleste udgivere – et overraskende lille tal i forhold til den opmærksomhed, emnet får. Men vækstraten for AI-crawlertrafik har været dramatisk, med nogle rapporter der viser 7x vækst år-til-år i AI-crawlerforespørgsler, hvilket indikerer, at selvom den nuværende indflydelse er lille, er udviklingen stejl. ChatGPT står for cirka 78% af al AI-crawlertrafik, hvilket gør OpenAI’s crawler til den dominerende kraft på området, efterfulgt af væsentligt mindre bidrag fra andre AI-virksomheder. Forholdet mellem crawl og henvisning er særligt afslørende: Selvom AI-crawlere kan anmode om millioner af sider, genererer de faktiske tilbagevendende besøg i rater ofte under 0,15%, hvilket betyder, at blokering af dem har minimal indflydelse på din reelle brugertrafik. Blokering af AI-crawlere reducerer henvisningstrafik med 96%, men da denne henvisningstrafik allerede var minimal (ofte mindre end 0,15% af din samlede trafik), er den samlede effekt på din forretning ofte ubetydelig. Det skaber et paradoks: At blokere AI-crawlere føles som et principfast standpunkt mod indholdstyveri, men den faktiske forretningspåvirkning er ofte så lille, at den næsten ikke kan spores i din statistik. Det virkelige spørgsmål er ikke, om blokering af crawlere vil skade din trafik – det vil det som regel ikke – men om tilladelse giver strategiske muligheder eller risici, der opvejer det minimale trafikbidrag, de giver.

Din konkurrenceposition på markedet former grundlæggende, hvordan du bør forholde dig til AI-crawlere, fordi den optimale strategi for en markedsleder adskiller sig markant fra den optimale strategi for en ny konkurrent. Dominerende markedsaktører som The New York Times, Wall Street Journal og store nyhedsorganisationer kan tillade sig at blokere AI-crawlere, fordi deres brandgenkendelse og direkte publikumsrelationer betyder, at de ikke er afhængige af AI-opdagelse for at generere trafik. Nye aktører og nicheudgivere står over for en anden beregning: at blive indekseret af AI-systemer og optræde i AI-genererede opsummeringer kan være en af de få måder at opnå synlighed over for stærke konkurrenter. Første-mover-fordelen i AI-partnerskaber kan være betydelig – udgivere, der tidligt forhandler gunstige vilkår med AI-virksomheder, kan sikre sig bedre kreditering, trafikhenvisninger eller licensaftaler end dem, der venter. Der er også en subsidieeffekt: Når dominerende udgivere blokerer AI-crawlere, skaber det et incitament for AI-virksomheder til at læne sig tungere op ad indhold fra udgivere, der tillader crawling, hvilket potentielt giver disse udgivere uforholdsmæssig stor synlighed i AI-systemer. Det skaber en konkurrencesituation, hvor blokering faktisk kan skade din position, hvis dine konkurrenter tillader crawlere og opnår AI-synlighed som følge heraf. At forstå, hvor du står i dit konkurrencelandskab, er afgørende for at kunne forudsige, hvordan din blokering vil påvirke din markedsposition i forhold til konkurrenterne.

At træffe beslutning om at blokere eller tillade AI-crawlere kræver, at du systematisk evaluerer din specifikke situation ud fra konkrete kriterier. Brug denne tjekliste til at guide din beslutningsproces:

Vurdering af indholdseksponering

Analyse af trafikkomposition

Vurdering af markedsposition

Vurdering af indtægtsrisiko

Ud over denne indledende vurdering bør du implementere kvartalsvise gennemgange af din AI-crawlerstrategi, da landskabet udvikler sig hurtigt, og din optimale beslutning i dag kan ændre sig inden for få måneder. Brug værktøjer som AmICited.com til at spore, hvor dit indhold bliver citeret og brugt af AI-systemer, så du får konkrete data om værdibyttet omkring dit indhold. Den centrale indsigt er, at denne beslutning ikke bør træffes én gang og glemmes – den kræver løbende evaluering og tilpasning, efterhånden som AI-landskabet modnes, og dine forretningsforhold ændrer sig.

En væsentlig ny mulighed, der kan ændre hele AI-crawlerlandskabet, er Cloudflare’s pay-per-crawl-funktion, der indfører en tilladelsesbaseret internetmodel, hvor websiteejere kan tjene penge på AI-crawleradgang i stedet for blot at blokere eller tillade den. Denne tilgang anerkender, at AI-virksomheder får værdi af at crawle dit indhold, og i stedet for at føre en blokkeringskrig kan du i stedet forhandle om kompensation for adgangen. Modellen bygger på kryptografisk verificering for at sikre, at kun autoriserede crawlere kan tilgå dit indhold, hvilket forhindrer uautoriseret scraping, samtidig med at legitime AI-virksomheder kan betale for adgang. Dette skaber granulær kontrol over, hvilke crawlere der kan tilgå hvilket indhold, så du kan tjene penge på værdifuldt indhold, mens du forbliver åben for søgemaskiner og andre gavnlige crawlere. Pay-per-crawl-modellen muliggør også AI-revision, hvor du kan se præcis, hvilket indhold der er blevet crawlet, hvornår og af hvem, hvilket giver en gennemsigtighed, der er umulig med traditionelle blokeringstilgange. For udgivere, der implementerer denne strategi, bliver AmICited.com’s overvågningsmuligheder endnu mere værdifulde, da du ikke kun kan spore, hvor dit indhold optræder i AI-systemer, men også verificere, at du modtager passende kompensation for brugen. Selvom denne model stadig er under udvikling og kun har begrænset udbredelse, repræsenterer den en potentielt mere sofistikeret tilgang end det binære valg mellem blokering og tilladelse – en tilgang, der anerkender den gensidige værdi i forholdet mellem udgivere og AI-virksomheder, samtidig med at dine interesser beskyttes gennem kontraktlige og tekniske mekanismer.

Blokering af AI-crawlere forhindrer dem i at tilgå dit indhold via robots.txt eller blokering på CDN-niveau, hvilket beskytter dit indhold mod at blive brugt til AI-træning. Hvis du tillader crawlere, kan dit indhold indekseres af AI-systemer og potentielt optræde i AI-genererede opsummeringer og svar. Valget afhænger af din indholdstype, indtægtsmodel og konkurrenceposition.

At blokere AI-crawlere skader ikke direkte din SEO, hvis du kun blokerer AI-specifikke crawlere som GPTBot, mens du tillader Googlebot. Men hvis du ved en fejl blokerer Googlebot, vil dine søgerangeringer lide betydeligt. Nøglen er at bruge granulær kontrol til kun at blokere AI-træningscrawlere, mens du bevarer adgangen for søgemaskiner.

Ja, du kan bruge robots.txt til at blokere specifikke crawlere via deres user-agent-streng, mens du tillader andre. For eksempel kan du blokere GPTBot, men tillade Google-Extended, eller omvendt. Denne granulære tilgang giver dig mulighed for at beskytte dit indhold mod visse AI-virksomheder, mens du forbliver synlig for andre.

robots.txt er en frivillig standard, der bygger på, at crawlere respekterer dine instruktioner – nogle AI-virksomheder ignorerer den. Blokering på CDN-niveau (som Cloudflare's) blokerer trafikken ved netværkskanten, før den når dine servere, hvilket giver stærkere håndhævelse. En dobbeltlags tilgang med begge metoder giver den bedste beskyttelse.

Du kan tjekke dine serverlogs for user-agent-strenge fra kendte AI-crawlere såsom GPTBot, CCBot og Claude-Web. Værktøjer som AmICited.com giver overvågningsmuligheder, så du kan spore, hvor dit indhold optræder i AI-systemer, og hvor ofte AI-crawlere tilgår det.

Pay-per-crawl er en ny model, hvor AI-virksomheder betaler for adgang til dit indhold. Selvom den stadig er i beta med begrænset udbredelse, repræsenterer den en potentiel ny indtægtskilde. Levedygtigheden afhænger af mængden af AI-crawlertrafik og de priser, AI-virksomhederne er villige til at betale.

Hvis en AI-crawler ignorerer dine robots.txt-direktiver, kan du implementere blokering på CDN-niveau via tjenester som Cloudflare. Du kan også konfigurere din server til at returnere 403-fejl til kendte AI-crawler user-agents. Ved vedvarende overtrædelser kan du overveje juridiske skridt eller kontakte AI-virksomheden direkte.

Gennemgå din AI-crawlerstrategi kvartalsvist, da landskabet udvikler sig hurtigt. Overvåg ændringer i AI-crawlertrafik, nye crawlere på markedet og forskydninger i din konkurrenceposition. Brug værktøjer som AmICited.com til at spore, hvordan dit indhold bruges af AI-systemer, og tilpas din strategi derefter.

Spor hvor dit indhold optræder i AI-genererede svar, og forstå AI-crawleres indflydelse på din forretning med AmICited.com's omfattende overvågningsplatform.

Få indsigt i hvordan AI-crawlere som GPTBot og ClaudeBot fungerer, hvordan de adskiller sig fra traditionelle søgemaskinecrawlere, og hvordan du optimerer dit s...

Lær hvilke AI-crawlere du skal tillade eller blokere i din robots.txt. Omfattende guide, der dækker GPTBot, ClaudeBot, PerplexityBot og 25+ AI-crawlere med konf...

Lær hvordan du tillader AI-bots som GPTBot, PerplexityBot og ClaudeBot at crawle dit website. Konfigurer robots.txt, opsæt llms.txt og optimer for AI-synlighed....

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.