Hvordan casestudier klarer sig i AI-søgeresultater

Lær hvordan casestudier rangerer i AI-søgemaskiner som ChatGPT, Perplexity og Google AI Overviews. Opdag hvorfor AI-systemer citerer casestudier som autoritativ...

Lær hvordan du formaterer case-studier til AI-kilder. Opdag den optimale struktur for succeshistorier, som LLM’er citerer i AI Overviews, ChatGPT og Perplexity.

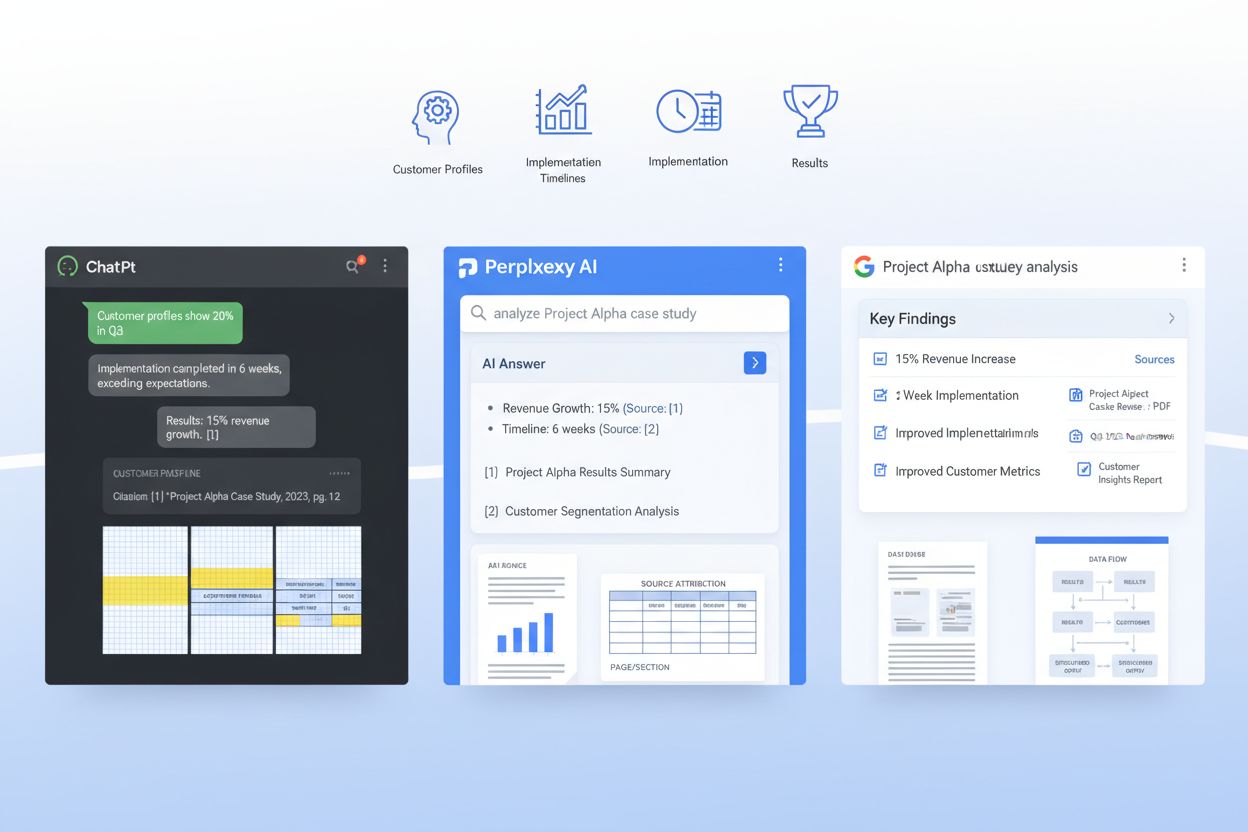

AI-systemer som ChatGPT, Perplexity og Googles AI Overviews ændrer grundlæggende måden, B2B-købere opdager og validerer case-studier på—men de fleste virksomheder udgiver dem stadig i formater, som LLM’er dårligt kan afkode. Når en virksomhedskøber spørger et AI-system “Hvilke SaaS-platforme er bedst til vores brugssag?”, gennemsøger systemet millioner af dokumenter for at finde relevante beviser, men dårligt formaterede case-studier forbliver usynlige for disse retrievemodeller. Det skaber et kritisk hul: mens traditionelle case-studier giver et grundlag på 21% win-rate i sene salgsfaser, kan AI-optimerede case-studier øge sandsynligheden for citation med 28-40%, når de er korrekt struktureret til maskinlæringsmodeller. De virksomheder, der vinder i dette nye landskab, forstår, at first-party datafordel kommer af at være synlig for AI-systemer, ikke kun for menneskelige læsere. Uden målrettet optimering til LLM-retrieval er dine mest overbevisende kundehistorier reelt låst væk fra de AI-systemer, der nu påvirker mere end 60% af virksomheders købsbeslutninger.

Et AI-klar case study er ikke bare en velskrevet fortælling—det er et strategisk struktureret dokument, der tjener både menneskelige læsere og maskinlæringsmodeller på samme tid. De mest effektive case-studier følger en ensartet arkitektur, der gør det muligt for LLM’er at udtrække nøgleoplysninger, forstå kontekst og citere din virksomhed med sikkerhed. Herunder er det essentielle blueprint, der adskiller AI-opdagelige case-studier fra dem, der forsvinder i retrieval-systemerne:

| Sektion | Formål | AI-optimering |

|---|---|---|

| TL;DR-resumé | Øjeblikkelig kontekst for travle læsere | Placeret øverst for tidligt token-forbrug; 50-75 ord |

| Kundeoversigt | Hurtig identifikation af virksomhedsprofil | Struktureret som: Branche / Virksomhedsstørrelse / Lokation / Rolle |

| Forretningskontekst | Problembeskrivelse og markedssituation | Brug konsistente termer; undgå jargon-variationer |

| Mål | Specifikke, målbare kundemål | Formater som nummereret liste; inkluder kvantificerede mål |

| Løsning | Hvordan dit produkt/service løste behovet | Forklar feature-til-benefit eksplicit |

| Implementering | Tidslinje, proces og implementeringsdetaljer | Opdel i faser; inkluder varighed og milepæle |

| Resultater | Kvantificerede resultater og effekttal | Præsenter som: Metrik / Baseline / Slut / Forbedringsprocent |

| Bevis | Data, screenshots eller tredjepartsvalidering | Inkludér tabeller for nøgletal; kildehenvisning tydeligt |

| Kundeudtalelser | Autentisk stemme og emotionel validering | Angiv navn, titel, virksomhed; 1-2 sætninger hver |

| Genbrugssignaler | Intern linking og krydspromovering | Foreslå relaterede case-studier, webinarer eller ressourcer |

Denne struktur sikrer, at hver sektion tjener et dobbelt formål: den læses naturligt for mennesker og giver semantisk klarhed for RAG (Retrieval-Augmented Generation)-systemer, som driver moderne LLM’er. Konsistensen i dette format på tværs af dit case study-bibliotek gør det markant lettere for AI-systemer at udtrække sammenlignelige datapunkter og citere din virksomhed med sikkerhed.

Ud over struktur har de specifikke formateringsvalg stor betydning for, om AI-systemer faktisk kan finde og citere dine case-studier. LLM’er behandler dokumenter anderledes end mennesker—de skimmer ikke eller bruger visuel hierarki som læsere, men er meget følsomme over for semantiske markører og ensartede formateringsmønstre. Her er de formateringselementer, der mest markant øger AI-retrieval:

Disse formateringsvalg handler ikke om æstetik—de handler om at gøre dit case study maskinlæsbart så det er din virksomheds historie, der bliver citeret, når en LLM søger efter relevante beviser.

Den mest avancerede tilgang til AI-klare case-studier indebærer at indlejre et JSON-skema direkte i dit case study-dokument eller metadatalag, og skabe en dobbeltstruktur, hvor mennesker læser fortællingen, mens maskiner læser de strukturerede data. JSON-skemaer giver LLM’er en utvetydig, maskinlæsbar repræsentation af case-studiets nøgletal, hvilket markant forbedrer nøjagtighed og relevans af citationer. Her er et eksempel på, hvordan det kan struktureres:

{

"@context": "https://schema.org",

"@type": "CaseStudy",

"name": "Enterprise SaaS Platform Reduces Onboarding Time by 60%",

"customer": {

"name": "TechCorp Industries",

"industry": "Financial Services",

"companySize": "500-1000 employees",

"location": "San Francisco, CA"

},

"solution": {

"productName": "Your Product Name",

"category": "Workflow Automation",

"implementationDuration": "8 weeks"

},

"results": {

"metrics": [

{"name": "Onboarding Time Reduction", "baseline": "120 days", "final": "48 days", "improvement": "60%"},

{"name": "User Adoption Rate", "baseline": "45%", "final": "89%", "improvement": "97%"},

{"name": "Support Ticket Reduction", "baseline": "450/month", "final": "120/month", "improvement": "73%"}

]

},

"datePublished": "2024-01-15",

"author": {"@type": "Organization", "name": "Your Company"}

}

Ved at implementere schema.org-kompatible JSON-strukturer giver du reelt LLM’er en standardiseret måde at forstå og citere dit case study. Denne metode integreres gnidningsløst med RAG-systemer, så AI-modeller kan udtrække præcise nøgletal, forstå kundekontekst og tilskrive citationer til din virksomhed med høj sikkerhed. Virksomheder, der bruger JSON-strukturerede case-studier, oplever 3-4x højere citeringsnøjagtighed i AI-genererede svar sammenlignet med rent narrative formater.

RAG-systemer behandler ikke hele dit case study som én stor blok—de deler det op i semantiske chunks, der passer ind i et LLM’s context window, og hvordan du strukturerer dit dokument afgør direkte, om de chunks er brugbare eller fragmenterede. Effektiv chunking handler om at organisere dit case study, så naturlige semantiske grænser stemmer overens med, hvordan RAG-systemer opdeler indholdet. Det kræver intentionel afsnitsstørrelse: hvert afsnit bør fokusere på én idé eller datapunkt, typisk 100-150 ord, så når et RAG-system udtrækker et chunk, indeholder det komplet, sammenhængende information og ikke løsrevne sætninger. Narrativ adskillelse er kritisk—brug tydelige sektionsovergang mellem problemformulering, løsningsbeskrivelse og resultater, så en LLM kan udtrække “resultatsektionen” som en samlet enhed uden at blande det med implementeringsdetaljer. Derudover betyder token-effektivitet noget: ved at bruge tabeller til nøgletal frem for prosa, reducerer du antallet af tokens, der kræves for at formidle samme information, så LLM’er kan inkludere mere af dit case study i deres svar uden at ramme context-grænser. Målet er at gøre dit case study “RAG-venligt”, så hvert chunk, et AI-system udtrækker, er værdifuldt og korrekt kontekstualiseret.

Udgivelse af case-studier til AI-systemer kræver balance mellem den specificitet, der gør dem troværdige, og de fortrolighedsforpligtelser, du har over for kunder. Mange virksomheder tøver med at publicere detaljerede case-studier af frygt for at afsløre følsom forretningsinformation, men strategisk anonymisering og redigering gør det muligt at bevare både transparens og tillid. Den mest effektive tilgang indebærer at skabe flere versioner af hvert case study: en fuldt detaljeret intern version med komplette kundenavne, præcise nøgletal og proprietære implementeringsdetaljer, og en offentlig AI-optimeret version, der anonymiserer kunden, men bevarer kvantificeret effekt og indsigt. Fx kan du i stedet for “TechCorp Industries sparede 2,3 mio. USD årligt” offentliggøre “Mellemstor finansvirksomhed reducerede driftsomkostninger med 34%"—tallet er stadig specifikt nok til, at LLM’er kan citere det, men kundens identitet er beskyttet. Versionskontrol og compliance-tracking er afgørende: hav styr på, hvad der er anonymiseret, hvorfor og hvornår, så dit case study-bibliotek altid er audit-klar. Denne governance-strategi styrker faktisk din AI-citeringsstrategi, fordi du kan udgive flere case-studier oftere uden juridiske barrierer, hvilket giver LLM’er flere beviser at finde og citere.

Før du publicerer et case study, valider at det faktisk performer godt, når det behandles af LLM’er og RAG-systemer—antag ikke, at god formatering automatisk betyder god AI-performance. Test dine case-studier mod rigtige AI-systemer for at se, om din struktur, metadata og indhold faktisk muliggør præcis citation og retrieval. Her er fem essentielle testmetoder:

Relevans-tjek: Indlæs dit case study i ChatGPT, Perplexity eller Claude med forespørgsler relateret til din løsningskategori. Henter og citerer AI-systemet dit case study ved relevante spørgsmål?

Opsummeringsnøjagtighed: Bed en LLM om at opsummere dit case study og verificér, at opsummeringen fanger nøgletal, kundekontekst og forretningsværdi uden forvrængning eller hallucination.

Metrik-udtræk: Test om AI-systemet kan udtrække specifikke tal korrekt fra dit case study (fx “Hvad var forbedringen i time-to-value?”). Tabeller bør give over 96% nøjagtighed; prosa bør testes særskilt.

Attributionspræcision: Kontrollér at når LLM citerer dit case study, tilskrives informationen korrekt til din virksomhed og kunde, ikke til en konkurrent eller generisk kilde.

Edge-case forespørgsler: Test med usædvanlige eller tangentiale spørgsmål for at sikre, at dit case study ikke fejlagtigt anvendes på brugssager, det ikke dækker.

Disse tests bør udføres kvartalsvis i takt med, at LLM-adfærd udvikler sig, og resultaterne skal informere løbende opdateringer af case study-formatering og struktur.

Måling af effekten af AI-optimerede case-studier kræver, at du tracker både AI-metrics (hvor ofte dine case-studier citeres af LLM’er) og menneske-metrics (hvordan disse citationer påvirker reelle handler). På AI-siden bruges AmICited.com til at måle citeringsfrekvens på ChatGPT, Perplexity og Google AI Overviews—track hvor ofte din virksomhed vises i AI-genererede svar på relevante forespørgsler, og om citationer stiger efter udgivelse af nye AI-optimerede case-studier. Etabler din nuværende citeringsrate, og sæt et mål om at øge citationer med 40-60% inden for seks måneder efter implementering af AI-klar formatering. På menneskesiden, sammenlign AI-citeringsstigninger med downstream-metrics: track hvor mange handler nævner “jeg fandt jer i en AI-søgning” eller “en AI anbefalede jeres case study”, mål win-rate forbedringer i handler, hvor dit case study blev citeret af et AI-system (mål: 28-40% forbedring over baseline på 21%), og overvåg salgsprocesforkortelse i konti, hvor prospects har mødt dit case study via AI. Overvåg også SEO-metrics—AI-optimerede case-studier med korrekt schema-markup rangerer ofte bedre i traditionel søgning og giver dobbelt effekt. Kvalitativ feedback fra salgsteamet er også vigtigt: spørg dem, om prospects ankommer med dybere produktviden, og om case study-citater reducerer indvendingstid. Det ultimative KPI er omsætning: track den ekstra ARR, der kan tilskrives handler påvirket af AI-citerede case-studier, og du har et klart ROI-grundlag for fortsat investering i dette format.

Optimering af case-studier til AI-citation giver kun ROI, hvis processen bliver operationaliseret og gentagelig, ikke en engangsopgave. Start med at gøre din AI-klare case study-skabelon til et standardformat, som marketing- og salgsteamet bruger på hver ny succeshistorie—det sikrer konsistens i biblioteket og reducerer tiden til publicering af nye case-studier. Integrér denne skabelon i dit CMS, så publicering automatisk genererer JSON-skema, metadata-headers og formateringsdele uden manuelt arbejde. Gør case study-udgivelse til en kvartalsvis eller månedlig rytme, ikke en årlig begivenhed, for LLM’er citerer virksomheder med dybere og nyere case study-biblioteker hyppigere. Positionér case-studier som en kernekomponent i din bredere revenue enablement-strategi: de skal indgå i salgsmaterialer, produktmarketing, demand generation-kampagner og playbooks for kundesucces. Etabler endelig en løbende forbedringscyklus, hvor du overvåger, hvilke case-studier genererer flest AI-citationer, hvilke nøgletal resonerer stærkest med LLM’er, og hvilke kundesegmenter oftest citeres—og brug denne indsigt til at forme næste generation af case-studier. De virksomheder, der vinder i AI-æraen, skriver ikke bare bedre case-studier; de behandler case-studier som strategiske indtægtsaktiver, der kræver løbende optimering, måling og forfining.

Start med at udtrække tekst fra dine PDF'er og kortlæg eksisterende indhold til et standardskema med felter som kundeprofil, udfordring, løsning og resultater. Opret derefter en let HTML- eller CMS-version af hver historie med tydelige overskrifter og metadata, og behold den oprindelige PDF som en downloadbar fil fremfor den primære kilde til AI-indhentning.

Marketing eller produktmarketing ejer typisk fortællingen, men salg, solutions engineering og kundesucces skal bidrage med rådata, implementeringsdetaljer og validering. Jura, privacy og RevOps hjælper med governance, korrekt anonymisering og sikrer tilpasning til eksisterende systemer som CRM og salgsplatforme.

Et headless CMS eller en struktureret content platform er ideel til lagring af skemaer og metadata, mens et CRM eller salgsværktøj kan fremhæve de rette historier i arbejdsgangen. Til AI-indhentning parres typisk en vektor-database med et LLM-orkestreringslag som LangChain eller LlamaIndex.

Transskriber video-testimonials og webinarer, og tag derefter udskrifterne med de samme felter og sektioner som dine skriftlige case-studier, så AI kan citere dem. For grafik og diagrammer, inkludér korte alt-tekster eller billedtekster, der beskriver hovedbudskabet, så retrievemodeller kan forbinde visuelle aktiver til specifikke spørgsmål.

Bevar din kerne-skema og ID'er ens globalt, og lav derefter oversatte varianter, der lokaliserer sprog, valuta og regulatorisk kontekst, mens du bevarer kanoniske nøgletal. Gem lokale versioner som separate, men forbundne objekter, så AI-systemer kan prioritere svar på brugerens sprog uden at fragmentere datamodellen.

Gennemgå vigtige case-studier mindst årligt, eller hurtigere ved større produktændringer, nye nøgletal eller ændringer i kundekontekst. Brug en simpel versioneringsproces med senest-gennemset datoer og statusflag for at signalere til AI-systemer og mennesker, hvilke historier der er mest aktuelle.

Integrér casestudy-indhentning direkte i de værktøjer, reps allerede bruger, og lav konkrete playbooks, der viser, hvordan de kan prompt'e assistenten efter relevant dokumentation. Styrk adoption ved at dele succeshistorier, hvor skræddersyede, AI-fremhævede case-studier hjalp med at lukke handler hurtigere eller åbne nye interessenter.

Traditionelle case-studier er skrevet til mennesker med narrativ flow og visuelt design. AI-optimerede case-studier bevarer fortællingen, men tilføjer strukturerede metadata, konsistent formatering, JSON-skemaer og semantisk klarhed, så LLM'er kan udtrække, forstå og citere specifik information med over 96% nøjagtighed.

Følg med i, hvordan AI-systemer citerer dit brand på ChatGPT, Perplexity og Google AI Overviews. Få indsigt i din AI-synlighed og optimer din indholdsstrategi.

Lær hvordan casestudier rangerer i AI-søgemaskiner som ChatGPT, Perplexity og Google AI Overviews. Opdag hvorfor AI-systemer citerer casestudier som autoritativ...

Lær hvad citationsoptimering for AI er, og hvordan du optimerer dit indhold til at blive citeret af ChatGPT, Perplexity, Google Gemini og andre AI-søgemaskiner....

Lær hvordan du skaber B2B thought leadership-indhold, der bliver citeret af AI-platforme som ChatGPT, Perplexity og Google AI Overviews. Strategisk indholdsopti...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.