LLM Meta Answers

Lær hvad LLM Meta Answers er, og hvordan du optimerer dit indhold for synlighed i AI-genererede svar fra ChatGPT, Perplexity og Google AI Overviews. Opdag bedst...

Lær hvordan du skaber LLM meta-svar, som AI-systemer citerer. Opdag strukturelle teknikker, strategier for svartæthed og formater til indhold klar til citation, der øger synligheden i AI-søgeresultater.

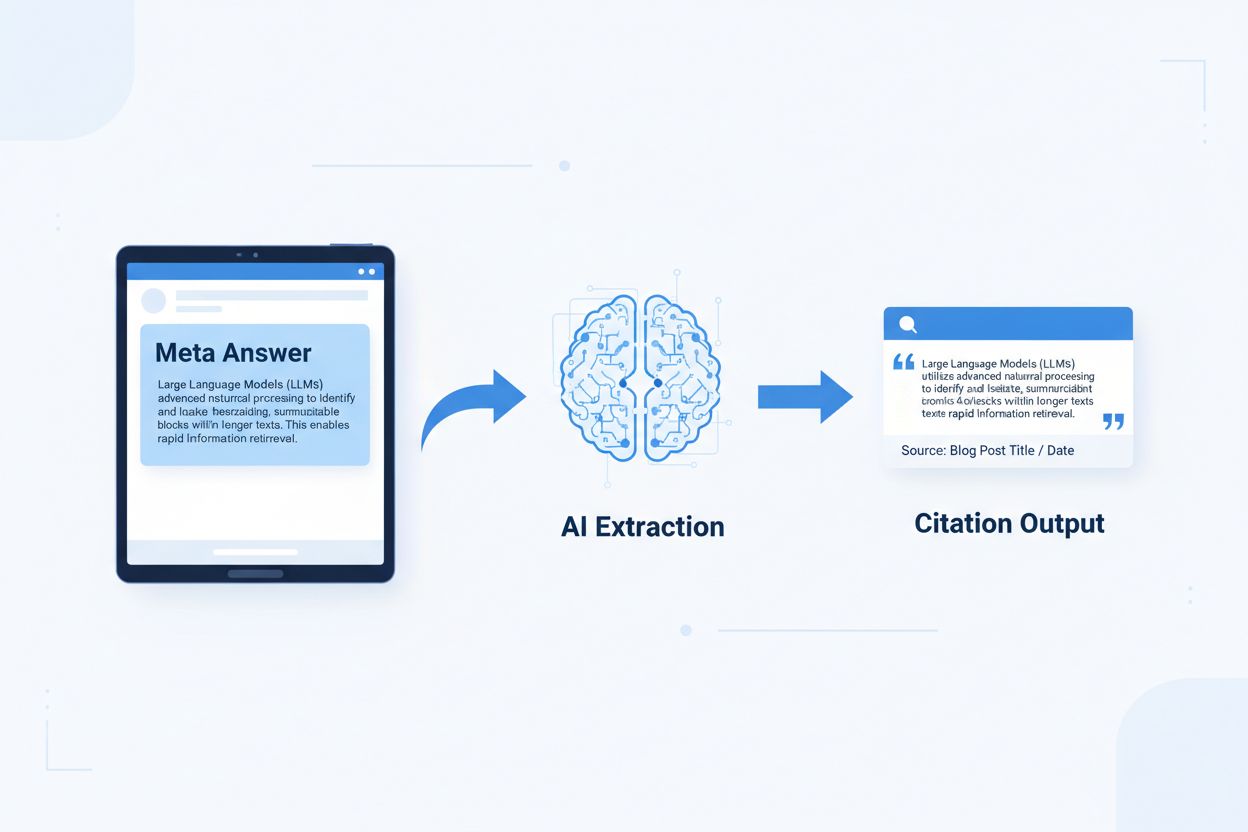

LLM meta-svar er selvstændige, AI-optimerede indholdsblokke designet til at blive udtrukket og citeret direkte af sprogmodeller uden behov for yderligere kontekst. I modsætning til traditionelt webindhold, der er afhængigt af navigation, overskrifter og omkringliggende kontekst for mening, fungerer meta-svar som selvstændige indsigter, der bevarer fuld semantisk værdi, når de isoleres. Forskellen er vigtig, fordi moderne AI-systemer ikke læser websites som mennesker—de opdeler indhold i stykker, vurderer relevans og udtrækker passager for at understøtte deres svar. Når AI møder velstrukturerede meta-svar, kan de trygt citere dem, fordi informationen er komplet, verificerbar og kontekstuelt uafhængig. Forskning fra Onely viser, at indhold optimeret til AI-citation får 3-5 gange flere omtaler i LLM-uddata sammenlignet med traditionelt formateret indhold, hvilket har direkte indflydelse på brandets synlighed i AI-genererede svar. Dette skift repræsenterer en grundlæggende ændring i, hvordan indhold præsterer: i stedet for at konkurrere om placeringer i søgning, konkurrerer meta-svar om at blive inkluderet i AI-svar. Overvågningsplatforme for citationer som AmICited.com sporer nu disse AI-omtaler som en kritisk præstationsmåling og viser, at organisationer med indhold klar til citation oplever målbare stigninger i AI-drevet trafik og brandautoritet. Sammenhængen er direkte—indhold struktureret som meta-svar bliver citeret oftere, hvilket øger brandsynligheden i informationslandskabet med AI i centrum.

Indhold klar til citation kræver specifikke strukturelle elementer, der signalerer til AI-systemer: “Dette er et komplet, citerbart svar.” De mest effektive meta-svar kombinerer klare emnesætninger, dokumentation og selvstændige konklusioner i en samlet logisk enhed. Disse elementer arbejder sammen for at skabe det, AI-systemer genkender som udtrækkelig viden—information der kan stå alene uden at brugeren behøver besøge kildesiden. Den strukturelle tilgang adskiller sig grundlæggende fra traditionelt webindhold, som ofte fragmenterer information på tværs af flere sider og er afhængig af interne links for at skabe kontekst.

| Element klar til citation | Hvorfor AI-systemer foretrækker det |

|---|---|

| Emnesætning med påstand | Signalerer straks svarets kerneværdi; AI kan vurdere relevans i de første 20 tokens |

| Dokumentation (data/eksempler) | Giver verificerbar opbakning; øger tillid til citationens nøjagtighed |

| Specifikke målinger eller statistik | Kvantificerbare påstande citeres oftere; mindsker tvetydighed |

| Definition eller forklaring | Sikrer selvstændig forståelse; AI behøver ikke ekstern kontekst |

| Handlingsorienteret konklusion | Signalerer fuldstændighed; fortæller AI-systemet at svaret er afsluttet |

| Kildeangivelse | Bygger tillid; AI-systemer foretrækker at citere indhold med klar oprindelse |

Tips til maksimal AI-ekstraktion:

Optimal chunk-størrelse for AI-ekstraktion ligger mellem 256-512 tokens, hvilket svarer til ca. 2-4 velstrukturerede afsnit. Dette interval er det ideelle, hvor AI-systemer kan udtrække meningsfuld information uden at miste kontekst eller inkludere irrelevant materiale. Chunks på under 256 tokens mangler ofte tilstrækkelig kontekst til sikker citation, mens chunks over 512 tokens tvinger AI-systemer til at sammenfatte eller afkorte, hvilket mindsker direkte citerbarhed. Chunking baseret på afsnit—hvor hvert afsnit udgør en afsluttet tanke—overgår tilfældig token-baseret opdeling, fordi det bevarer semantisk sammenhæng og fastholder den logiske strøm, AI-systemer bruger til at vurdere relevans.

God chunking bevarer semantiske grænser:

✓ GOD: "Indhold klar til citation kræver specifikke strukturelle elementer.

De mest effektive meta-svar kombinerer klare emnesætninger,

dokumentation og selvstændige konklusioner i en samlet

logisk enhed. Disse elementer arbejder sammen for at skabe det, AI-systemer

genkender som udtrækkelig viden."

✗ DÅRLIG: "Indhold klar til citation kræver specifikke strukturelle elementer

der signalerer til AI-systemer: 'Dette er et komplet, citerbart svar.' De

mest effektive meta-svar kombinerer klare emnesætninger, dokumentation

og selvstændige konklusioner i en samlet logisk enhed. Disse elementer

arbejder sammen for at skabe det, AI-systemer genkender som

udtrækkelig viden—information der kan stå alene uden at brugeren

behøver besøge kildesiden. Den strukturelle tilgang adskiller sig

grundlæggende fra traditionelt webindhold, som ofte fragmenterer

information på tværs af flere sider og er afhængig af interne links for at

skabe kontekst."

Det gode eksempel bevarer semantisk sammenhæng og slutter ved en naturlig konklusion. Det dårlige eksempel kombinerer flere idéer, hvilket tvinger AI-systemer til enten at afkorte midt i et tanke eller inkludere irrelevant kontekst. Overlap-strategier—hvor den sidste sætning i én chunk peger frem mod den næste—hjælper AI-systemer med at forstå indholdsrelationer uden at miste ekstraktionsmulighed. Praktisk tjekliste for chunking-optimering: Besvarer hver chunk et enkelt spørgsmål? Kan den forstås uden at læse omkringliggende afsnit? Indeholder den 256-512 tokens? Slutter den ved en naturlig semantisk grænse?

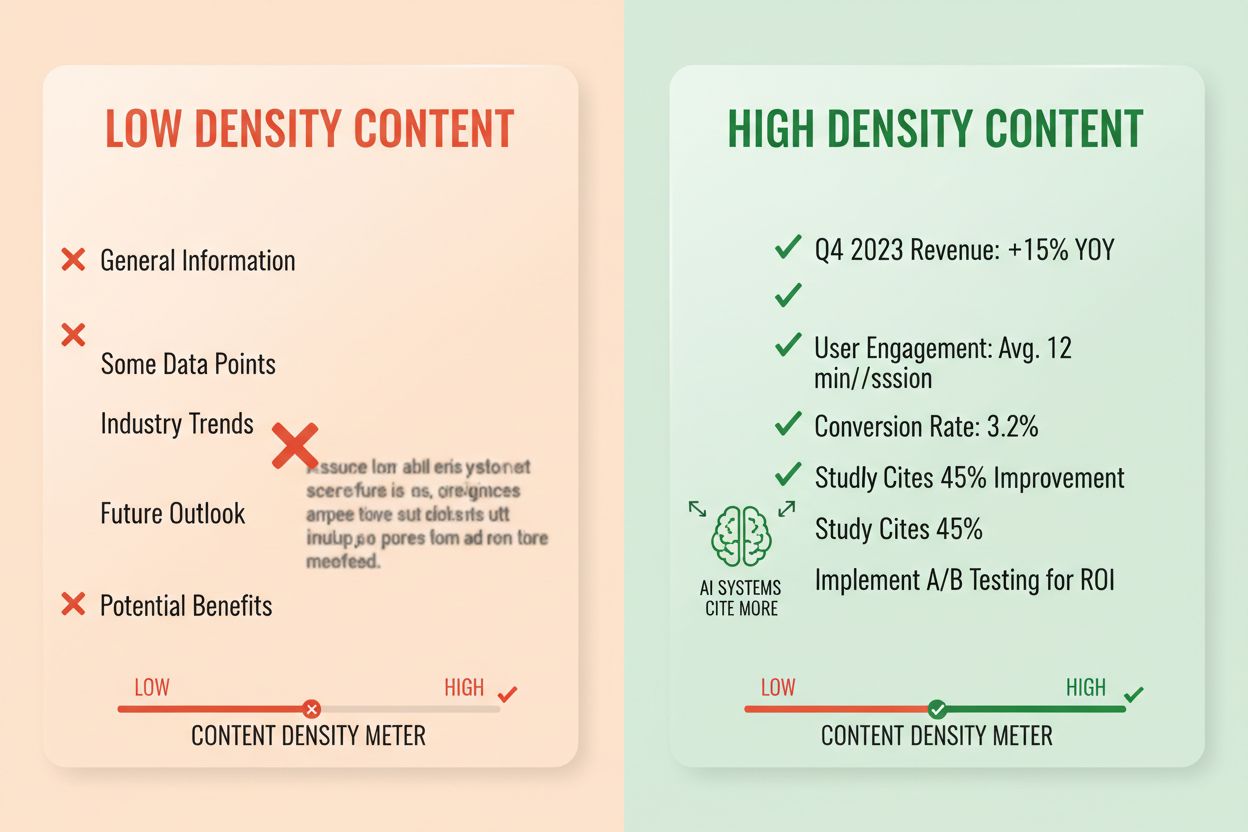

Svartæthed måler forholdet mellem handlingsorienteret information og samlet ordantal, og indhold med høj tæthed får 2-3 gange flere AI-citater end alternativer med lav tæthed. Et afsnit med en svartæthed på 80% indeholder hovedsageligt påstande, dokumentation og handlingsorienterede indsigter, mens et med 40% tæthed har meget fyld, gentagelse eller kontekst, der ikke direkte understøtter hovedsvaret. AI-systemer vurderer tæthed implicit—de udtrækker og citerer oftere passager, hvor hver sætning bidrager til at besvare brugerens spørgsmål. Elementer med høj tæthed omfatter specifikke statistikker, trinvise instruktioner, sammenligningsdata, definitioner og handlingsrettede anbefalinger. Mønstre med lav tæthed inkluderer lange introduktioner, gentagne koncepter, retoriske spørgsmål og fortællinger, der ikke styrker hovedargumentet.

Målingsmetode: Tæl sætninger, der direkte besvarer spørgsmålet, mod sætninger, der blot giver kontekst eller overgang. Et afsnit med høj tæthed kan lyde: “Indhold klar til citation får 3-5 gange flere AI-omtaler (statistik). Det sker fordi AI-systemer udtrækker komplette, selvstændige svar (forklaring). Brug svar-først format og semantisk chunking for at maksimere tæthed (handling).” En version med lav tæthed kunne tilføje: “Mange organisationer kæmper med AI-synlighed. Det digitale landskab ændrer sig hurtigt. Indholdsstrategier har ændret sig markant. Indhold klar til citation bliver mere og mere vigtigt…” Den anden version udvander hovedbudskabet med kontekst, der ikke direkte støtter svaret.

Faktiske effekt-tal: Indhold med svartæthed over 70% får i gennemsnit 4,2 citater pr. måned i AI-uddata, sammenlignet med 1,1 citater for indhold under 40% tæthed. Organisationer, der omstrukturerede eksisterende indhold for at øge tæthed, oplevede en gennemsnitlig stigning i citationer på 156% inden for 60 dage. Eksempel på høj tæthed: “Brug 256-512 tokens per chunk for optimal AI-ekstraktion (påstand). Dette interval bevarer kontekst og forhindrer afkortning (dokumentation). Implementér chunking baseret på afsnit for at opretholde semantisk sammenhæng (handling).” Version med lav tæthed: “Chunking er vigtigt for AI-systemer. Der findes forskellige metoder til at organisere indhold. Nogle foretrækker mindre chunks, mens andre foretrækker større. Den rigtige tilgang afhænger af dine behov.” Versionen med høj tæthed leverer handlingsrettet vejledning; versionen med lav tæthed opremser åbenlyse fakta uden præcision.

Specifikke indholdsstrukturer signalerer til AI-systemer at informationen er organiseret til udtræk, hvilket dramatisk øger sandsynligheden for citation. FAQ-sektioner er særligt effektive, fordi de eksplicit parrer spørgsmål med svar, hvilket gør det nemt for AI-systemer at identificere og udtrække relevante passager. Sammenligningstabeller gør det muligt for AI hurtigt at vurdere flere muligheder og citere specifikke rækker, der besvarer brugerens spørgsmål. Trinvise instruktioner skaber klare semantiske grænser og bliver ofte citeret, når brugere spørger “hvordan gør jeg…”. Definitionslister parrer begreber med forklaringer, hvilket skaber naturlige udtrækningspunkter. Opsummeringsbokse fremhæver hovedpointer, og lister nedbryder komplekse emner i adskilte, citerbare punkter.

Strukturelle elementer der maksimerer AI-hentbarhed:

Praktiske eksempler: En FAQ med spørgsmålet “Hvad er svartæthed?” efterfulgt af en komplet definition og forklaring bliver en direkte citeringskilde. En sammenligningstabel med “Element klar til citation | Hvorfor AI-systemer foretrækker det” (som i afsnit 2) citeres, når brugere stiller sammenlignende spørgsmål. En trin-for-trin guide med titlen “Sådan implementeres semantisk chunking” med nummererede trin bliver citerbar instruktionsindhold. Disse strukturer virker, fordi de matcher den måde AI-systemer opdeler og udtrækker information på—de leder efter klare spørgsmål-svar par, strukturerede sammenligninger og adskilte trin.

Semantisk HTML5-markup signalerer indholdsstruktur til AI-systemer, hvilket forbedrer ekstraktionsnøjagtighed og sandsynlighed for citation med 40-60%. Brug af korrekt overskrifthierarki (H1 til hovedemner, H2 til underemner, H3 til underpunkter) hjælper AI med at forstå indholdsrelationer og identificere udtrækningsgrænser. Semantiske elementer som <article>, <section>, og <aside> giver yderligere kontekst om indholdets formål. Schema.org-strukturerede data—særligt JSON-LD-format—fortæller eksplicit AI-systemer, hvilken information der findes, hvilket muliggør mere sikre citationer.

JSON-LD eksempel for FAQ-indhold:

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [{

"@type": "Question",

"name": "Hvad er svartæthed?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Svartæthed måler forholdet mellem handlingsorienteret information og samlet ordantal. Indhold med høj tæthed får 2-3 gange flere AI-citater end alternativer med lav tæthed."

}

}]

}

JSON-LD eksempel for artikelmetadata:

{

"@context": "https://schema.org",

"@type": "Article",

"headline": "Oprettelse af LLM Meta-svar",

"author": {"@type": "Organization", "name": "AmICited"},

"datePublished": "2024-01-15",

"articleBody": "..."

}

Meta-indhold—herunder metabeskrivelser og Open Graph-tags—hjælper AI-systemer med at forstå indholdets formål før parsing. Ydelses- og tilgængelighedsforbedringer (hurtig sideindlæsning, mobiloptimering, korrekt alt-tekst) understøtter indirekte AI-hentbarhed ved at sikre at indholdet er fuldt gennemgåeligt og indekserbart. Teknisk implementeringstjekliste: Er din HTML semantisk og korrekt struktureret? Har du implementeret schema.org-markup for din indholdstype? Opsummerer metabeskrivelser nøjagtigt indholdet? Er dit site mobiloptimeret og hurtig? Er billeder korrekt alt-mærket?

Citationssporing er blevet afgørende for måling af indholdspræstation, men de fleste organisationer mangler indsigt i, hvor ofte deres indhold optræder i AI-svar. Hentetestning indebærer at indsende dine målspørgsmål til store LLM’er (ChatGPT, Claude, Gemini) og dokumentere hvilke kilder, der citeres i svarene. Indholdsaudit gennemgår systematisk dit eksisterende indhold op mod kriterier for citation-klarhed og identificerer huller og optimeringsmuligheder. Præstationsmålinger bør spore citationsfrekvens, citationskontekst (hvordan indholdet bruges) og citationsvækst over tid. Iterativ optimering indebærer at teste strukturelle ændringer, måle deres effekt på citationsfrekvens og skalere det, der virker.

| Overvågningsværktøj | Primær funktion | Bedst til |

|---|---|---|

| AmICited.com | Omfattende AI-citationsovervågning på alle store LLM’er | Fuld citationsindsigt og konkurrenceanalyse |

| Otterly.AI | AI-indholdsdetektion og citationssporing | Identificere hvor dit indhold optræder i AI-uddata |

| Peec AI | Indholdsydelse i AI-systemer | Måle citationsfrekvens og trends |

| ZipTie | Overvågning af AI-genereret indhold | Sporing af brandomtaler i AI-svar |

| PromptMonitor | Analyse af LLM-uddata | Forstå hvordan AI-systemer bruger dit indhold |

AmICited.com skiller sig ud som den bedste løsning fordi den tilbyder realtids-overvågning på tværs af ChatGPT, Claude, Gemini og andre store LLM’er, med konkurrencebenchmarking og detaljeret citationskontekst. Platformen afslører ikke blot om dit indhold citeres, men hvordan det bruges—om det citeres direkte, omskrives eller bruges som dokumentation. Målingsmetode: Etabler baseline-citationsfrekvens for dine 20 bedste indholdsstykker. Implementér optimering til citation på 5-10 stykker. Mål ændringer i citationer over 30-60 dage. Skaler succesfulde mønstre til resten af indholdet. Spor målinger som citationsfrekvens, vækstrate, citationskontekst og konkurrenceandel.

Fejl 1: At gemme svaret i konteksten. Mange indholdsskabere starter med baggrund, historik eller problemstillinger, før det egentlige svar kommer. AI-systemer vurderer relevans i de første 50-100 tokens; hvis svaret ikke er der, går de videre til næste kilde. Problem: Brugere der spørger “Hvad er svartæthed?” møder et afsnit der starter med “Indholdsstrategier har ændret sig markant…” i stedet for definitionen. Løsning: Brug svar-først format—start med hovedindsigten, derefter kontekst.

Fejl 2: At skabe svar der kræver ekstern kontekst. Indhold, der henviser til “det foregående afsnit” eller “som nævnt tidligere” kan ikke udtrækkes selvstændigt. Problem: Et afsnit med “Følg den tilgang vi diskuterede, implementér disse trin…” fejler fordi tilgangen ikke er inkluderet i det udtrukne stykke. Løsning: Gør alle svar selvstændige; inkluder nødvendig kontekst, selv hvis det kræver mindre gentagelse.

Fejl 3: At blande flere svar i én chunk. Afsnit, der besvarer flere spørgsmål, tvinger AI til at afkorte eller inkludere irrelevant information. Problem: Et 600-ords afsnit om “Hvad er svartæthed?” OG “Hvordan måles det?” OG “Hvorfor er det vigtigt?” bliver for stort til sikker udtræk. Løsning: Skab separate, fokuserede chunks for hvert spørgsmål eller koncept.

Fejl 4: At bruge vagt sprog i stedet for specifikke målinger. Udtryk som “mange”, “nogle”, “ofte” og “typisk” mindsker citationssikkerheden fordi de er upræcise. Problem: “Mange organisationer ser forbedringer” er mindre citerbart end “Organisationer der omstrukturerede indhold så 156% flere citationer.” Løsning: Erstat kvalifikatorer med specifikke data; hvis eksakte tal mangler, brug intervaller (“40-60%”) i stedet for vage termer.

Fejl 5: At overse strukturel markup. Indhold uden korrekt HTML-struktur, overskrifter eller schema.org-markup er sværere for AI at parse og udtrække. Problem: Et afsnit uden overskrift, uden semantisk HTML og uden schema-markup behandles som generisk tekst i stedet for et særskilt svar. Løsning: Brug semantisk HTML5, korrekt overskrifthierarki og tilføj schema.org-markup for indholdstypen.

Fejl 6: At skabe svar, der er for korte eller for lange. Chunks under 150 tokens mangler kontekst; chunks over 700 tokens tvinger til afkortning. Problem: Et svar på 100 ord mangler dokumentation; et på 1000 ord opdeles i flere udtræk. Løsning: Sigt efter 256-512 tokens (2-4 afsnit); inkludér påstand, dokumentation og konklusion i dette interval.

Entitetskonsistens—at bruge identisk terminologi for det samme begreb gennem hele dit indhold—øger AI-citationsandsynligheden ved at signalere autoritativ viden. Hvis du definerer “svartæthed” ét sted, skal du bruge det præcise begreb konsekvent fremfor at skifte til “informationstæthed” eller “indholdstæthed”. AI-systemer genkender entitetskonsistens som et signal om ekspertise og citerer oftere indhold hvor terminologien er præcis og ensartet. Dette gælder produktnavne, metodenavne og tekniske begreber—konsistens bygger tillid til citationsnøjagtighed.

Tredjepartsomtaler og original forskning øger citationsfrekvens dramatisk. Indhold, der refererer til andre autoritative kilder (med klar kildeangivelse) signalerer troværdighed, mens original forskning eller egne data gør dit indhold unikt citerbart. Når du inkluderer statistikker fra egen forskning eller cases fra egne kunder, genkender AI dette som original indsigt, der ikke findes andre steder. Organisationer der offentliggør original forskning ser 3-4 gange højere citationsrate end dem, der kun sammenfatter andres information. Strategi: Udfør original forskning i din branche, offentliggør resultater med detaljeret metode, og referér til disse i dine meta-svar.

Friskhedssignaler—udgivelsesdatoer, opdateringsdatoer og henvisninger til nylige begivenheder—hjælper AI med at forstå indholdets aktualitet. Indhold opdateret indenfor de seneste 30 dage får højere prioritet, især for emner hvor information ændres ofte. Inkludér udgivelsesdatoer i din schema.org-markup og opdateringsdatoer når du reviderer indhold. Strategi: Opret en rutine for indholdsopdatering; opdater topindhold hver 30-60 dage med nye statistikker, aktuelle eksempler eller udvidede forklaringer.

E-E-A-T-signaler (Erfaring, Ekspertise, Autoritet, Troværdighed) påvirker AI’s citationsbeslutninger. Indhold forfattet af anerkendte eksperter, offentliggjort på autoritative domæner og bakket op af kvalifikationer får højere citationsprioritet. Inkludér forfatterbios med relevante kvalifikationer, publicér på domæner med etableret autoritet og opbyg backlinks fra andre autoritative kilder. Strategi: Brug ekspertforfattere, inkludér kvalifikationer i bios og få backlinks fra brancherelaterede medier.

Generativ brandtæthed—forholdet mellem brandede indsigter og generisk information—afgør om AI citerer dig eller konkurrenter. Indhold med egne rammeværk, metoder eller brandede tilgange bliver mere citerbart fordi det er unikt. Generisk indhold om “best practices” citeres sjældnere end indhold om “AmICiteds Citation Optimization Framework”, fordi det brandede er unikt og sporbart. Organisationer med høj generativ brandtæthed får 2-3 gange flere citationer end dem med generisk indhold. Strategi: Udvikl egne rammeværk, metoder eller terminologi; brug dem konsekvent i alt indhold; gør dem til fundament for dine meta-svar.

LLM meta-svar er designet specifikt til AI-ekstraktion og citation, mens featured snippets er optimeret til Googles søgeresultater. Meta-svar prioriterer selvstændig fuldstændighed og semantisk sammenhæng, hvorimod featured snippets fokuserer på kortfattethed og søgeords-match. Begge kan eksistere i dit indhold, men meta-svar kræver en anden strukturel optimering.

Optimal længde er 256-512 tokens, hvilket svarer til ca. 2-4 velstrukturerede afsnit eller 200-400 ord. Dette interval bevarer nok kontekst til sikker AI-ekstraktion uden afkortning. Kortere svar mangler kontekst; længere svar tvinger AI-systemer til at sammenfatte eller opdele på tværs af flere ekstraktioner.

Ja, men det kræver omstrukturering. Gennemgå eksisterende indhold for svar-først format, semantisk sammenhæng og selvstændig fuldstændighed. Det meste indhold kan tilpasses ved at flytte nøgleindsigter til begyndelsen, fjerne krydsreferencer og sikre at hvert afsnit besvarer et fuldstændigt spørgsmål uden ekstern kontekst.

Opdater toppræsterende indhold hver 30-60 dage med nye statistikker, nylige eksempler eller udvidede forklaringer. AI-systemer prioriterer indhold opdateret inden for de seneste 30 dage, især for emner hvor information ændrer sig ofte. Inkluder udgivelsesdatoer og opdateringstidspunkter i din schema.org-markering.

Svartæthed korrelerer direkte med citatfrekvens. Indhold med svartæthed over 70% får i gennemsnit 4,2 citater pr. måned i AI-uddata, sammenlignet med 1,1 citater for indhold under 40% tæthed. Indhold med høj tæthed leverer handlingsorienteret information uden fyld, hvilket gør det mere værdifuldt for AI-systemer at citere.

Brug overvågningsplatforme som AmICited.com, der sporer citater på tværs af ChatGPT, Claude, Gemini og andre store LLM'er. Udfør manuelle tests ved at indsende dine målspørgsmål til AI-systemer og dokumentér hvilke kilder der citeres. Mål baseline-citationsfrekvens, implementér optimeringer og følg ændringer over 30-60 dage.

Kernen i meta-svarstrukturen forbliver ens på tværs af platforme, men du kan optimere til platforms-specifikke præferencer. ChatGPT foretrækker omfattende, veldokumenteret indhold. Perplexity lægger vægt på nylig information og klare citater. Google AI Overviews prioriterer strukturerede data og E-E-A-T signaler. Test variationer og overvåg citeringsresultater på tværs af platforme.

AmICited leverer realtids-overvågning af dine indholdscitater på tværs af alle større AI-platforme og viser præcis hvor dine meta-svar vises, hvordan de bruges og andel af citater. Platformen afslører citatkontekst—om indholdet er citeret direkte, omskrevet eller brugt som dokumentation—så du kan optimere baseret på data.

Se præcis hvor dit indhold bliver citeret af ChatGPT, Perplexity, Google AI Overviews og andre AI-systemer. Spor citationstrends, overvåg konkurrenter og optimer din indholdsstrategi med AmICited.

Lær hvad LLM Meta Answers er, og hvordan du optimerer dit indhold for synlighed i AI-genererede svar fra ChatGPT, Perplexity og Google AI Overviews. Opdag bedst...

Lær hvordan du identificerer og målretter LLM-kildesider for strategiske backlinks. Oplev hvilke AI-platforme der citerer kilder mest, og optimer din linkbuildi...

Lær dokumenterede strategier for kildehenvisning, så dit indhold bliver LLM-troværdigt. Opdag, hvordan du får AI-citater fra ChatGPT, Perplexity og Google AI Ov...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.