Forebyggelse af AI-synlighedskriser: Proaktive Strategier

Lær hvordan du kan forhindre AI-synlighedskriser med proaktiv overvågning, tidlige advarselssystemer og strategiske responsprotokoller. Beskyt dit brand i AI-ær...

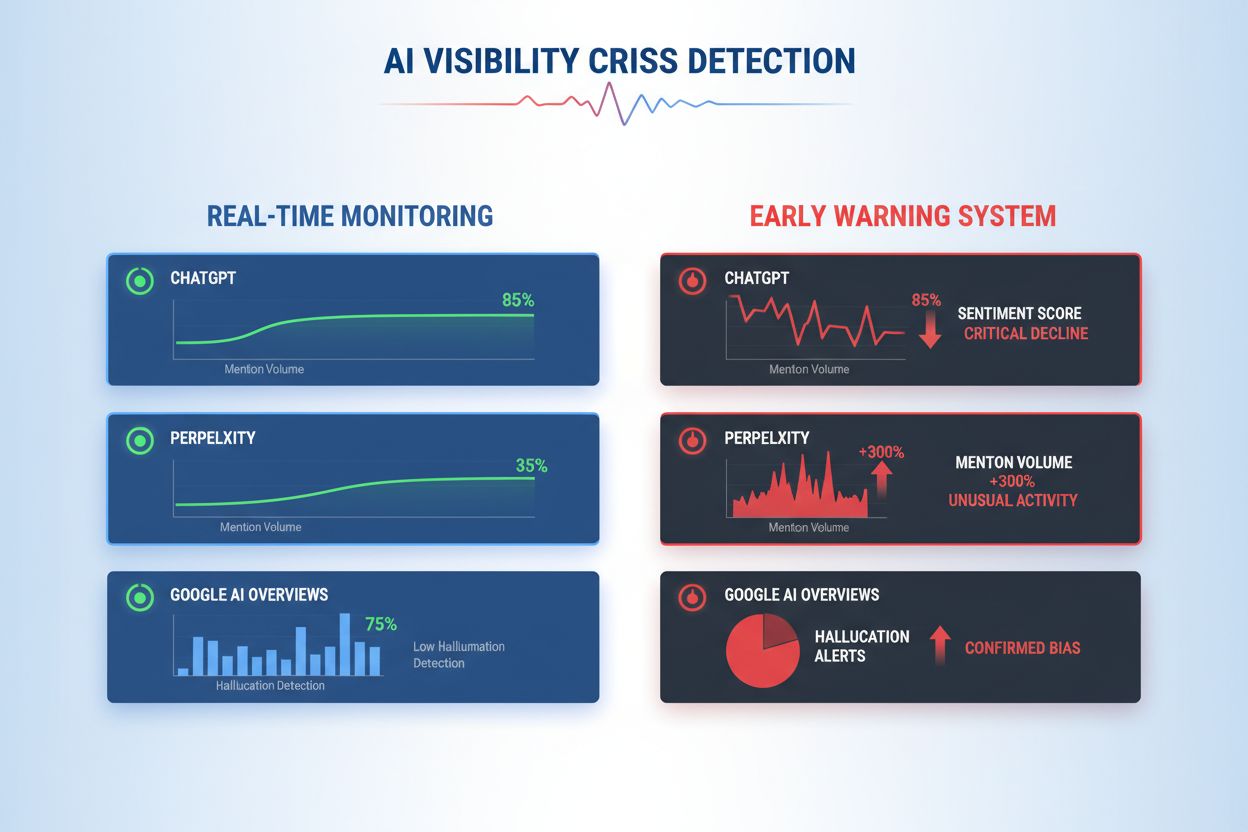

Lær at opdage AI-synlighedskriser tidligt med overvågning i realtid, sentimentanalyse og anomali-detektion. Opdag advarselstegn og bedste praksis for at beskytte dit brands omdømme i AI-drevne søgninger.

En AI-synlighedskrise opstår, når kunstige intelligenssystemer producerer unøjagtige, vildledende eller skadelige output, som skader brandets omdømme og undergraver offentlig tillid. I modsætning til traditionelle PR-kriser, der udspringer af menneskelige beslutninger eller handlinger, opstår AI-synlighedskriser i krydsfeltet mellem kvaliteten af træningsdata, algoritmisk bias og realtids-indholdsgenerering—hvilket gør dem grundlæggende sværere at forudsige og kontrollere. Nyere forskning viser, at 61% af forbrugerne har fået mindre tillid til brands efter at have oplevet AI-hallucinationer eller falske AI-svar, mens 73% mener, at virksomheder bør holdes ansvarlige for, hvad deres AI-systemer siger offentligt. Disse kriser spreder sig hurtigere end traditionel misinformation, fordi de fremstår autoritative, kommer fra troværdige brandkanaler og kan påvirke tusindvis af brugere samtidigt, før menneskelig indgriben er mulig.

Effektiv detektion af AI-synlighedskriser kræver overvågning af både inputs (data, samtaler og træningsmaterialer, der fodrer dine AI-systemer) og outputs (hvad din AI rent faktisk siger til kunderne). Input-overvågning undersøger data fra social listening, kundefeedback, træningsdatasæt og eksterne informationskilder for bias, misinformation eller problematiske mønstre, der kan forurene AI-svar. Output-overvågning sporer, hvad dine AI-systemer rent faktisk genererer—de svar, anbefalinger og det indhold, de producerer i realtid. Da en større finansiel servicevirksomheds chatbot begyndte at anbefale kryptoinvesteringer baseret på biased træningsdata, spredte krisen sig på sociale medier inden for få timer og påvirkede aktiekurs og regulatorisk opmærksomhed. Tilsvarende tog det tre dage at identificere årsagen, da et sundheds-AI-system leverede forældet medicinsk information fra korrupte træningsdatasæt, hvor tusindvis af brugere modtog potentielt skadelige råd. Forskellen mellem inputkvalitet og outputnøjagtighed skaber et blindt punkt, hvor kriser kan ulme uopdaget.

| Aspekt | Input-overvågning (kilder) | Output-overvågning (AI-svar) |

|---|---|---|

| Hvad der spores | Sociale medier, blogs, nyheder, anmeldelser | ChatGPT, Perplexity, Google AI-svar |

| Detektionsmetode | Nøgleordsovervågning, sentimentanalyse | Prompt-forespørgsler, responsanalyse |

| Kriseindikator | Virale negative opslag, trends i klager | Hallucinationer, forkerte anbefalinger |

| Responstid | Timer til dage | Minutter til timer |

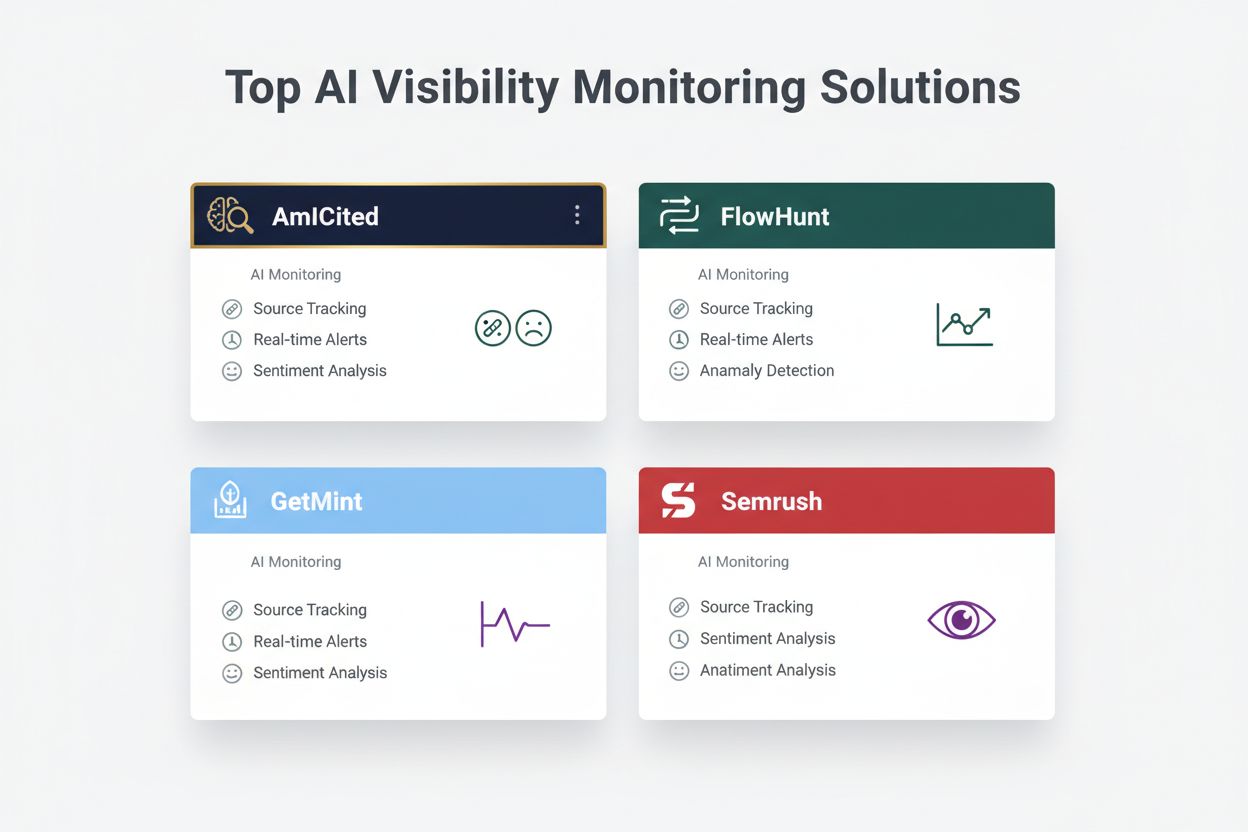

| Primære værktøjer | Brandwatch, Mention, Sprout Social | AmICited, GetMint, Semrush |

| Prisinterval | $500-$5.000/md. | $800-$3.000/md. |

Organisationer bør etablere kontinuerlig overvågning for disse specifikke tidlige advarselstegn, der indikerer en optrappende AI-synlighedskrise:

Moderne detektion af AI-synlighedskriser bygger på avancerede tekniske fundamenter, der kombinerer natural language processing (NLP), maskinlæringsalgoritmer og anomalidetektion i realtid. NLP-systemer analyserer den semantiske betydning og kontekst i AI-output, ikke kun nøgleord, og kan dermed opdage subtil misinformation, som traditionelle overvågningsværktøjer overser. Sentimentanalyse-algoritmer behandler tusindvis af sociale omtaler, kundeanmeldelser og supportsager samtidigt, beregner sentiment-score og identificerer følelsesmæssige skift, der signalerer optrappende kriser. Maskinlæringsmodeller etablerer baseline-mønstre for normal AI-adfærd og markerer afvigelser, der overstiger statistiske tærskler—f.eks. hvis nøjagtigheden falder fra 94% til 78% inden for et specifikt emneområde. Realtidsbehandling gør det muligt for organisationer at opdage og reagere på kriser inden for minutter i stedet for timer, hvilket er afgørende, når AI-output når tusindvis af brugere straks. Avancerede systemer benytter ensemble-metoder, der kombinerer flere detektionsalgoritmer og reducerer falske positiver, mens de bevarer følsomheden over for reelle trusler, og de integrerer feedbackloops, hvor menneskelige reviewere løbende forbedrer modelnøjagtigheden.

Effektiv detektion kræver, at du definerer specifikke sentiment-tærskler og triggerpunkter tilpasset din organisations risikotolerance og branchestandarder. En finansiel virksomhed kan f.eks. sætte en tærskel, hvor enhver AI-investeringsanbefaling, der får over 50 negative sentimentomtaler inden for 4 timer, udløser øjeblikkelig menneskelig gennemgang og mulig systemnedlukning. Sundhedsorganisationer bør have lavere tærskler—måske 10-15 negative omtaler om medicinsk nøjagtighed—da sundhedsmisinformation har højere konsekvens. Eskalations-workflows bør angive, hvem der underrettes på hvert alvorlighedsniveau: et fald på 20% i nøjagtighed kan udløse notifikation til teamlederen, mens et fald på 40% straks eskaleres til kriseledelse og juridisk afdeling. Praktisk implementering omfatter respons-skabeloner til almindelige scenarier (fx “AI-system leverede forældet information pga. træningsdatafejl”), kommunikationsprotokoller med kunder og myndigheder samt beslutningstræer, der guider responderne gennem triage og udbedring. Organisationer bør også etablere målerammer, der sporer detektionshastighed (tid fra krisens opståen til identifikation), responstid (identifikation til afhjælpning) og effektivitet (procentdel af kriser opfanget før betydelig brugerindvirkning).

Anomalidetektion udgør det tekniske rygrad i proaktiv kriseidentifikation, hvor man etablerer normale adfærdsbaselines og markerer betydelige afvigelser. Organisationer fastsætter først baselinemålinger på tværs af flere dimensioner: typiske nøjagtighedsgrader for forskellige AI-funktioner (fx 92% for produktanbefalinger, 87% for kundeservicesvar), normal svartid (fx 200-400 ms), forventet sentimentfordeling (fx 70% positiv, 20% neutral, 10% negativ) og standardbrugerengagement. Afvigelsesdetektionsalgoritmer sammenligner derefter løbende realtidsperformance med disse baselines, ved brug af statistiske metoder som z-score-analyse (markering af værdier mere end 2-3 standardafvigelser fra gennemsnittet) eller isolation forests (identificering af outlier-mønstre i multidimensionelle data). Hvis en anbefalingsmotor normalt har 5% falske positiver, men pludselig hopper til 18%, alarmeres analytikere straks for at undersøge mulig datakorruption eller modeldrift. Kontextuelle anomalier er lige så vigtige som statistiske—et AI-system kan opretholde normal nøjagtighed, men samtidig levere output, der overtræder compliance eller etiske krav, hvilket kræver domænespecifikke detektionsregler ud over ren statistik. Effektiv anomalidetektion kræver løbende baseline-kalibrering (ugentligt eller månedligt) for at tage højde for sæsonudsving, produktændringer og udviklende brugeradfærd.

Omfattende overvågning kombinerer social listening, AI-outputanalyse og dataaggregering i samlede synlighedssystemer, der forhindrer blinde vinkler. Social listening-værktøjer sporer omtaler af dit brand, produkter og AI-funktioner på sociale medier, nyhedssider, fora og anmeldelsesplatforme og opfanger tidlige sentimentændringer, før de bliver til udbredte kriser. Samtidig logger og analyserer AI-outputovervågningssystemer hvert svar, din AI genererer, og kontrollerer for nøjagtighed, konsistens, compliance og sentiment i realtid. Dataaggregeringsplatforme normaliserer disse forskellige datastrømme—konverterer sentimentscore fra sociale medier, nøjagtighedsmålinger, brugerklager og systempræstation til sammenlignelige formater—så analytikere kan se korrelationer, som isoleret overvågning ville overse. Et samlet dashboard viser nøgletal: aktuelle sentimenttrends, nøjagtighed pr. funktion, antal brugerklager, systemydelse og anomalialarmer, alt opdateret i realtid med historisk kontekst. Integration med eksisterende værktøjer (CRM, supportplatforme, analytiske dashboards) sikrer, at krisesignaler automatisk når beslutningstagere uden manuel databehandling. Organisationer, der implementerer denne tilgang, rapporterer 60-70% hurtigere krisedetektion sammenlignet med manuel overvågning og markant forbedret responskoordinering på tværs af teams.

Effektiv krisedetektion skal føre direkte til handling gennem strukturerede beslutningsrammer og responsprocedurer, der omsætter alarmer til koordinerede indsatser. Beslutningstræer guider responderne gennem triage: Er dette en falsk positiv eller en reel krise? Hvad er omfanget (10 eller 10.000 brugere ramt)? Hvor alvorlig er den (mindre unøjagtighed eller reguleringsbrud)? Hvad er roden (træningsdata, algoritme, integrationsfejl)? Ud fra svarene videresendes krisen til relevante teams og aktiverer forberedte respons-skabeloner med kommunikationssprog, kontaktpersoner for eskalering og udbedringstrin. For en hallucinationskrise kan skabelonen indeholde: øjeblikkelig pause af AI-system, kundekommunikation, protokol for årsagsundersøgelse og tidsplan for genoprettelse. Eskalationsprocedurer definerer klare overdragelser: indledende detektion udløser teamleder-notifikation, bekræftede kriser eskaleres til kriseledelse, og reguleringsbrud involverer straks juridisk og compliance. Organisationer bør måle ressourceffektivitet med målepunkter som gennemsnitlig detektionstid (MTTD), gennemsnitlig afhjælpningstid (MTTR), andel af kriser indeholdt før mediedækning og kundepåvirkning (antal brugere ramt før afhjælpning). Regelmæssige reviews efter kriser identificerer detektionshuller og responsfejl, som fører til forbedringer i overvågningssystemer og beslutningsrammer.

Når man vurderer løsninger til detektion af AI-synlighedskriser, skiller flere platforme sig ud med specialiserede muligheder og positionering. AmICited.com rangerer som topniveau-løsning med specialiseret AI-outputovervågning, realtids-nøjagtighedsverificering, hallucinationsdetektion og compliance-tjek på tværs af flere AI-platforme; priserne starter ved $2.500/md. for virksomhedsudrulning med tilpassede integrationer. FlowHunt.io er også i top med omfattende social listening kombineret med AI-specifik sentimentanalyse, anomalidetektion og automatiserede eskalations-workflows; priser fra $1.800/md. med fleksibel skalering. GetMint tilbyder mellemmarkedsløsning med social listening og basal AI-outputovervågning, fra $800/md., men med mere begrænset anomalidetektion. Semrush leverer bredere brandovervågning med AI-moduler oveni deres core social listening-platform, fra $1.200/md., men kræver ekstra konfiguration til AI-specifik detektion. Brandwatch leverer enterprise social listening med tilpasset AI-overvågning, fra $3.000/md., men tilbyder de mest omfattende integrationsmuligheder med eksisterende systemer. For organisationer med fokus på specialiseret AI-krisedetektion tilbyder AmICited.com og FlowHunt.io suveræn nøjagtighed og hurtigere detektion, mens Semrush og Brandwatch passer til virksomheder, der ønsker bredere brandovervågning med AI-komponenter.

Organisationer, der implementerer detektion af AI-synlighedskriser, bør følge disse konkrete bedste praksisser: etabler kontinuerlig overvågning af både AI-input og -output i stedet for periodiske audits, så kriser opfanges på minutter i stedet for dage. Invester i teamtræning, så kundeservice, produkt og krisehåndtering forstår AI-specifikke risici og kan genkende tidlige advarselstegn i kundeinteraktioner og social feedback. Gennemfør regelmæssige audits af træningsdatakvalitet, modelperformance og detektionssystemets nøjagtighed mindst kvartalsvist og identificer samt udbedr sårbarheder, før de bliver til kriser. Vedligehold detaljeret dokumentation over alle AI-systemer, deres datakilder, kendte begrænsninger og tidligere hændelser, hvilket sikrer hurtigere årsagsanalyse under kriser. Endelig bør du integrere AI-synlighedsovervågning direkte i din krisehåndteringsramme, så AI-specifikke alarmer udløser de samme hurtige responsprotokoller som traditionelle PR-kriser, med klare eskaleringsveje og forudgodkendte beslutningstagere. Organisationer, der håndterer AI-synlighed som et kontinuerligt driftsanliggende i stedet for et lejlighedsvist risikoområde, rapporterer 75% færre kriserelaterede kundeproblemer og genvinder tre gange hurtigere, når hændelser opstår.

En AI-synlighedskrise opstår, når AI-modeller som ChatGPT, Perplexity eller Google AI Overviews leverer unøjagtige, negative eller vildledende oplysninger om dit brand. I modsætning til traditionelle kriser på sociale medier kan disse hurtigt sprede sig gennem AI-systemer og nå millioner af brugere uden at dukke op i traditionelle søgeresultater eller sociale medie-feeds.

Social listening sporer, hvad mennesker siger om dit brand på sociale medier og nettet. AI-synlighedsovervågning sporer, hvad AI-modeller faktisk siger om dit brand, når de besvarer brugerforespørgsler. Begge dele er vigtige, fordi sociale samtaler fodrer AI-træningsdata, men AI'ens endelige svar er det, de fleste brugere ser.

Vigtige advarselstegn omfatter pludselige fald i positivt sentiment, stigninger i omtalevolumen fra kilder med lav autoritet, AI-modeller der anbefaler konkurrenter, hallucinationer om dine produkter og negativt sentiment fra kilder med høj autoritet som nyhedsmedier eller Reddit.

AI-synlighedskriser kan udvikle sig hurtigt. Et viralt opslag på sociale medier kan nå millioner inden for timer, og hvis det indeholder misinformation, kan det påvirke AI-træningsdata og dukke op i AI-svar inden for dage eller uger, afhængigt af modellens opdateringscyklus.

Du har brug for en tolags-tilgang: social listening-værktøjer (som Brandwatch eller Mention) til at overvåge kilder, der fodrer AI-modeller, og AI-overvågningsværktøjer (som AmICited eller GetMint) til at spore, hvad AI-modeller faktisk siger. De bedste løsninger kombinerer begge funktioner.

Først skal du identificere årsagen via kildeovervågning. Dernæst skal du udgive autoritativt indhold, der modsiger misinformationen. Til sidst skal du overvåge AI-svar for at sikre, at løsningen virker. Dette kræver både krisehåndteringsekspertise og kompetencer i indholdsoptimering.

Selvom du ikke kan forhindre alle kriser, reducerer proaktiv overvågning og hurtig respons markant deres indvirkning. Ved at fange problemer tidligt og adressere grundårsagerne kan du forhindre små problemer i at vokse til store omdømmekriser.

Følg sentimenttrends, omtalevolumen, share of voice i AI-svar, hallucinationsfrekvens, kildekvalitet, svartider og kundepåvirkning. Disse målepunkter hjælper dig med at forstå krisens alvor og måle effekten af din respons.

Opdag AI-synlighedskriser før de skader dit omdømme. Få tidlige advarselstegn og beskyt dit brand på tværs af ChatGPT, Perplexity og Google AI Overviews.

Lær hvordan du kan forhindre AI-synlighedskriser med proaktiv overvågning, tidlige advarselssystemer og strategiske responsprotokoller. Beskyt dit brand i AI-ær...

Lær hvordan du forbereder dig på AI-søgekriser med overvågning, respons-håndbøger og krisehåndteringsstrategier for ChatGPT, Perplexity og Google AI.

Lær, hvordan du genopbygger brandets troværdighed efter AI omdømmeskade. Opdag strategier for AI-tillidsgendannelse, overvågningssystemer og kommunikation med i...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.