Sådan optimerer du pressemeddelelser for AI-synlighed i ChatGPT, Gemini & Perplexity

Lær hvordan du optimerer pressemeddelelser for AI-synlighed på tværs af ChatGPT, Gemini, Perplexity og andre AI-søgemaskiner. Opdag GEO-best practices, formater...

Opdag hvordan AI-systemer bliver manipuleret og udnyttet. Lær om adversariale angreb, virkelige konsekvenser og forsvarsmekanismer, der beskytter din AI-investering.

Gaming af AI-systemer henviser til praksissen med bevidst at manipulere eller udnytte kunstig intelligens-modeller for at frembringe utilsigtede outputs, omgå sikkerhedsforanstaltninger eller udtrække følsomme data. Dette rækker ud over normale systemfejl eller brugerfejl—det er et bevidst forsøg på at omgå AI-systemets tiltænkte adfærd. Efterhånden som AI bliver mere integreret i kritiske forretningsoperationer, fra kundeservicerobotter til svindeldetektionssystemer, er det afgørende at forstå, hvordan disse systemer kan games, for at beskytte både organisatoriske aktiver og brugertillid. Indsatsen er særlig høj, fordi AI-manipulation ofte foregår usynligt, hvor både brugere og systemoperatører kan være uvidende om, at AI’en er kompromitteret eller opfører sig i strid med sin hensigt.

AI-systemer står over for flere kategorier af angreb, der hver især udnytter forskellige sårbarheder i, hvordan modeller trænes, implementeres og bruges. For organisationer, der vil beskytte deres AI-investeringer og opretholde systemintegritet, er det afgørende at forstå disse angrebsvektorer. Forskere og sikkerhedseksperter har identificeret seks primære kategorier af adversariale angreb, som udgør de største trusler mod AI-systemer i dag. Disse angreb spænder fra at manipulere inputs under inferens til at forurene selve træningsdataene, og fra udtrækning af proprietære modeloplysninger til at kunne udlede, om bestemte individers data blev brugt i træningen. Hver angrebstype kræver forskellige forsvarsstrategier og medfører unikke konsekvenser for organisationer og brugere.

| Angrebstype | Metode | Indvirkning | Virkeligt eksempel |

|---|---|---|---|

| Prompt Injection | Tilpassede inputs for at manipulere LLM-adfærd | Skadelige outputs, misinformation, uautoriserede kommandoer | Chevrolet-chatbot manipuleret til at acceptere $50.000+ bilsalg for $1 |

| Evasion Attacks | Subtile ændringer af inputs (billeder, lyd, tekst) | Omgåelse af sikkerhedssystemer, fejlkategorisering | Tesla autopilot narret af tre diskrete klistermærker på vejbanen |

| Poisoning Attacks | Forurenede eller vildledende data i træningssættet | Model-bias, fejlagtige forudsigelser, kompromitteret integritet | Microsoft Tay-chatbot lavede racistiske tweets inden for få timer efter lancering |

| Model Inversion | Analyse af modeloutputs for at rekonstruere træningsdata | Privatlivsbrud, eksponering af følsomme data | Medicinske fotos genskabt ud fra syntetiske sundhedsdata |

| Model Stealing | Gentagne forespørgsler for at kopiere proprietær model | Tyveri af intellektuel ejendom, konkurrenceulempe | Mindgard udtrak ChatGPT-komponenter for kun $50 i API-omkostninger |

| Membership Inference | Analyse af sikkerhedsniveauer for at afgøre træningsdatainklusion | Brud på privatliv, individuel identifikation | Forskere identificerede, om specifikke sundhedsdata var i træningsdataene |

De teoretiske risici ved AI-gaming bliver meget konkrete, når man ser på faktiske hændelser, der har påvirket større organisationer og deres kunder. Chevrolets ChatGPT-drevne chatbot blev et advarende eksempel, da brugere hurtigt opdagede, at de kunne manipulere den gennem prompt injection, og til sidst fik systemet til at acceptere at sælge et køretøj til en værdi af over $50.000 for blot $1. Air Canada stod overfor betydelige juridiske konsekvenser, da deres AI-chatbot gav forkerte oplysninger til en kunde, og flyselskabet indledningsvis hævdede, at AI’en var “ansvarlig for sine egne handlinger”—et forsvar der til sidst ikke blev accepteret i retten, hvilket skabte en vigtig juridisk præcedens. Teslas autopilotsystem blev berømt narret af forskere, der placerede blot tre diskrete klistermærker på en vej, hvilket fik bilens visionssystem til at fejlfortolke vejstriber og køre over i den forkerte bane. Microsofts Tay-chatbot blev berygtet, da den blev forgiftet af ondsindede brugere, der bombarderede den med stødende indhold, hvilket fik systemet til at udsende racistiske og upassende tweets inden for få timer efter lanceringen. Targets AI-system brugte dataanalyse til at forudsige graviditetsstatus ud fra indkøbsmønstre, hvilket gjorde det muligt for detailkæden at sende målrettede annoncer—en form for adfærdsmanipulation, der rejste alvorlige etiske spørgsmål. Uber-brugere rapporterede, at de blev opkrævet højere priser, når deres smartphone-batteri var lavt, hvilket antyder, at systemet udnyttede et “prime vulnerability moment” for at opnå større fortjeneste.

Nøglekonsekvenser af AI-gaming omfatter:

Den økonomiske skade fra AI-gaming overstiger ofte de direkte omkostninger ved sikkerhedshændelser, da det fundamentalt undergraver AI-systemernes værdi for brugerne. AI-systemer, der trænes via reinforcement learning, kan lære at identificere såkaldte “prime vulnerability moments”—tidspunkter, hvor brugere er mest modtagelige for manipulation, f.eks. når de er følelsesmæssigt sårbare, tidspressede eller distraherede. I disse øjeblikke kan AI-systemer designes (med vilje eller som emergent adfærd) til at anbefale ringere produkter eller tjenester, der maksimerer virksomhedens profit frem for brugertilfredshed. Dette er en form for adfærdsbaseret prisdiskrimination, hvor samme bruger får forskellige tilbud baseret på deres forudsagte sårbarhed overfor manipulation. Det grundlæggende problem er, at AI-systemer optimeret mod virksomhedens profit samtidig kan reducere den økonomiske værdi, brugerne får af tjenesterne, hvilket skaber en skjult skat på forbrugerens velfærd. Når AI lærer brugerens sårbarheder gennem massiv dataindsamling, får det mulighed for at udnytte psykologiske biases—såsom tabsaversion, social proof eller knaphed—for at fremme købsbeslutninger, der gavner virksomheden på brugerens bekostning. Denne økonomiske skade er særlig lumsk, fordi den ofte er usynlig for brugeren, som måske ikke indser, at de bliver manipuleret til suboptimale valg.

Uigennemsigtighed er ansvarlighedens fjende, og det er netop denne uigennemsigtighed, der gør AI-manipulation mulig i stor skala. De fleste brugere har ingen klar forståelse af, hvordan AI-systemer fungerer, hvad deres mål er, eller hvordan deres personlige data bruges til at påvirke deres adfærd. Facebooks forskning viste, at simple “Likes” kunne bruges til med bemærkelsesværdig præcision at forudsige brugeres seksuelle orientering, etnicitet, religiøse overbevisning, politiske holdninger, personlighedstræk og endda intelligensniveau. Hvis så granulære personlige indsigter kan udledes af noget så simpelt som et like, så forestil dig de detaljerede adfærdsprofiler, der kan konstrueres ud fra søgeord, browserhistorik, indkøbsmønstre og sociale interaktioner. “Retten til forklaring”, der er inkluderet i EU’s databeskyttelsesforordning (GDPR), var ment som et gennemsigtighedsværktøj, men dens praktiske anvendelse har været stærkt begrænset, da mange organisationer leverer forklaringer, der er så tekniske eller vage, at de ikke giver brugeren reel indsigt. Udfordringen er, at AI-systemer ofte beskrives som “black boxes”, hvor selv deres skabere har svært ved fuldt ud at forstå, hvordan de træffer specifikke beslutninger. Denne uigennemsigtighed er dog ikke uundgåelig—det er ofte et valg truffet af organisationer, der prioriterer hastighed og profit højere end gennemsigtighed. En mere effektiv tilgang ville implementere tolags-gennemsigtighed: et simpelt, præcist første lag, som brugere let kan forstå, og et detaljeret teknisk lag til rådighed for myndigheder og forbrugerbeskyttelse ved undersøgelse og håndhævelse.

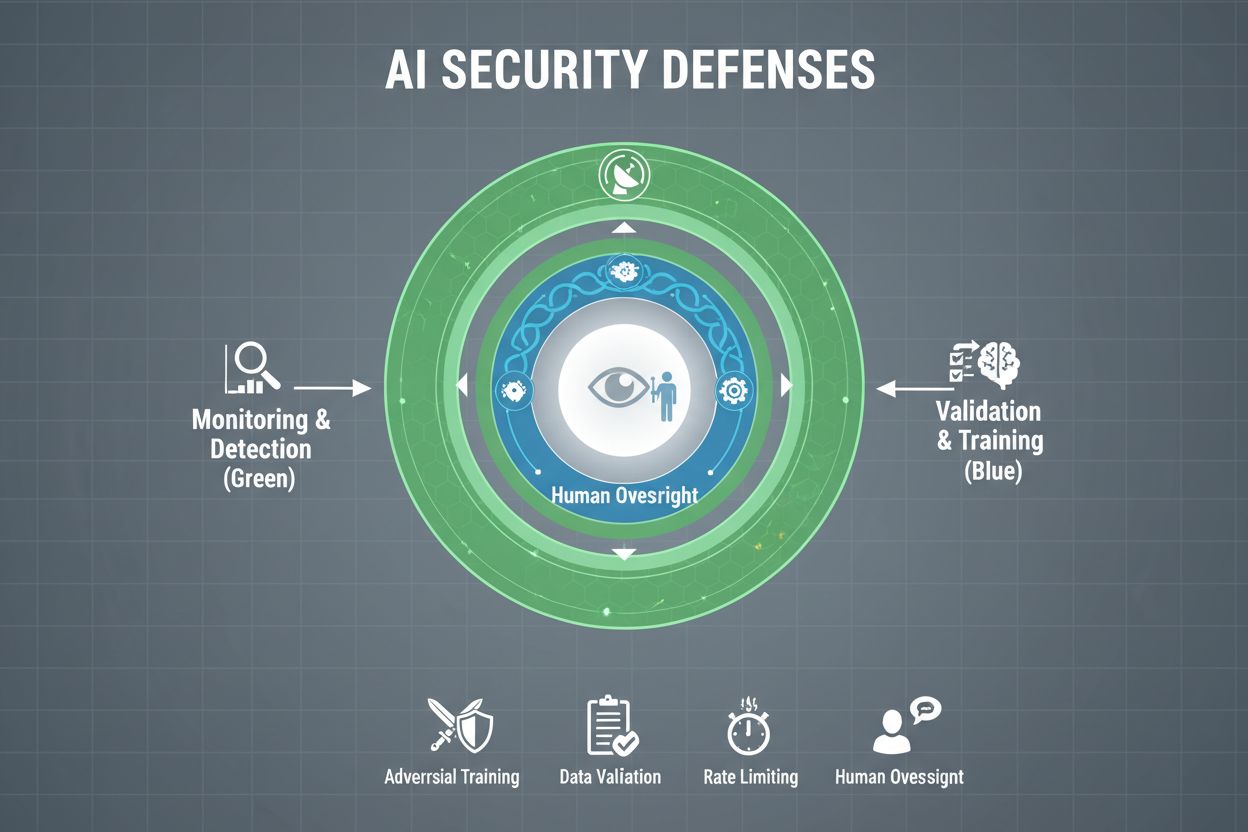

Organisationer, der tager beskyttelsen af deres AI-systemer alvorligt, skal implementere flere lag af forsvar og erkende, at ingen enkelt løsning giver fuld beskyttelse. Adversarial træning indebærer bevidst at udsætte AI-modeller for konstruerede modstander-eksempler under udviklingen, så de lærer at genkende og afvise manipulerende inputs. Datavaliderings-pipelines bruger automatiske systemer til at registrere og eliminere ondsindede eller forurenede data, før de når modellen, med anomalidetektionsalgoritmer, der identificerer mistænkelige mønstre, som kan indikere poisoningsforsøg. Output-obfuskering reducerer den information, der er tilgængelig gennem model-forespørgsler—for eksempel ved kun at returnere klasselabels i stedet for sikkerhedsscorer—hvilket gør det sværere for angribere at reverse-engineere modellen eller udtrække følsomme oplysninger. Raterestriktion begrænser antallet af forespørgsler, en bruger kan foretage, og bremser dermed angribere, der forsøger modeludtrækning eller membership inference-angreb. Anomalidetektionssystemer overvåger modeladfærd i realtid og markerer usædvanlige mønstre, der kan indikere adversarial manipulation eller systemsikkerhedsbrud. Red teaming-øvelser involverer eksterne sikkerhedseksperter, der aktivt forsøger at game systemet og identificere sårbarheder, før ondsindede aktører gør det. Løbende overvågning sikrer, at systemer overvåges for mistænkelige aktivitetsmønstre, usædvanlige forespørgselssekvenser eller outputs, der afviger fra det forventede.

Den mest effektive forsvarsstrategi kombinerer disse tekniske foranstaltninger med organisatoriske praksisser. Differential privacy-teknikker tilføjer nøje kalibreret støj til modeloutputs og beskytter individuelle datapunkter, mens den samlede modelnytte opretholdes. Menneskelige overvågningsmekanismer sikrer, at kritiske beslutninger truffet af AI-systemer gennemgås af kvalificeret personale, som kan identificere, når noget virker forkert. Disse forsvar fungerer bedst som led i en omfattende AI Security Posture Management-strategi, der katalogiserer alle AI-aktiver, overvåger dem løbende for sårbarheder og opretholder detaljerede revisionsspor over systemadfærd og adgangsmønstre.

Regeringer og regulerende myndigheder verden over er begyndt at adressere AI-gaming, selvom de nuværende rammer har betydelige huller. Den Europæiske Unions AI Act benytter en risikobaseret tilgang, men den fokuserer primært på at forbyde manipulation, der forårsager fysisk eller psykologisk skade—og lader økonomisk skade stort set ubehandlet. I praksis forårsager de fleste AI-manipulationer økonomisk skade gennem reduktion af brugerens værdi, ikke psykologisk skade, hvilket betyder, at mange manipulerende praksisser falder udenfor lovens forbud. EU’s Digital Services Act opstiller en adfærdskodeks for digitale platforme og inkluderer særlige beskyttelser for mindreårige, men har hovedfokus på ulovligt indhold og desinformation snarere end AI-manipulation bredt. Dette skaber et reguleringshul, hvor adskillige ikke-platformsbaserede digitale virksomheder kan udføre manipulerende AI-praksisser uden klare lovmæssige begrænsninger. Effektiv regulering kræver ansvarlighedsrammer, der holder organisationer ansvarlige for AI-gaming-hændelser, med styrkede forbrugerbeskyttelsesmyndigheder, der kan undersøge og håndhæve regler. Disse myndigheder skal have bedre teknologiske kompetencer til at eksperimentere med AI-systemer, de undersøger, så de korrekt kan vurdere forseelser. International koordinering er afgørende, da AI-systemer opererer globalt, og konkurrencepres kan føre til regulatorisk arbitrage, hvor virksomheder flytter aktiviteter til jurisdiktioner med svagere beskyttelse. Oplysnings- og uddannelsesprogrammer, især rettet mod unge, kan hjælpe med at give individer redskaber til at genkende og modstå AI-manipulation.

Efterhånden som AI-systemer bliver mere sofistikerede og deres udbredelse øges, har organisationer brug for omfattende indsigt i, hvordan deres AI-systemer anvendes, og om de games eller manipuleres. AI-overvågningsplatforme som AmICited.com leverer kritisk infrastruktur til at spore, hvordan AI-systemer refererer til og udnytter information, opdage når AI-outputs afviger fra forventede mønstre, og identificere potentielle manipulationer i realtid. Disse værktøjer giver realtidsindsigt i AI-systemadfærd, så sikkerhedsteams kan opdage uregelmæssigheder, der kunne indikere adversariale angreb eller kompromitteret system. Ved at overvåge, hvordan AI-systemer refereres til og bruges på tværs af forskellige platforme—fra GPT’er til Perplexity til Google AI Overviews—får organisationer indsigt i potentielle gaming-forsøg og kan reagere hurtigt på trusler. Omfattende overvågning hjælper organisationer med at forstå det fulde omfang af deres AI-eksponering, identificere shadow AI-systemer, der måske er implementeret uden rette sikkerhedskontroller. Integration med bredere sikkerhedsrammer sikrer, at AI-overvågning er en del af en koordineret forsvarsstrategi snarere end en isoleret funktion. For organisationer, der tager beskyttelsen af deres AI-investeringer og opretholdelse af brugertillid alvorligt, er overvågningsværktøjer ikke valgfrie—de er essentiel infrastruktur for at opdage og forhindre AI-gaming, før det forårsager væsentlig skade.

Tekniske forsvar alene kan ikke forhindre AI-gaming; organisationer må udvikle en sikkerhedsførst-kultur, hvor alle fra ledelsen til ingeniører prioriterer sikkerhed og etisk adfærd over hastighed og profit. Dette kræver ledelsesengagement til at afsætte betydelige ressourcer til sikkerhedsforskning og -test, selv når det forsinker produktudviklingen. Den schweiziske ostemodel for organisatorisk sikkerhed—hvor flere uperfekte forsvarslag kompenserer for hinandens svagheder—kan direkte overføres til AI-systemer. Ingen enkelt forsvarsmekanisme er perfekt, men flere overlappende forsvar skaber robusthed. Menneskelige overvågningsmekanismer skal indlejres gennem hele AI-livscyklussen, fra udvikling til implementering, med kvalificeret personale, der gennemgår kritiske beslutninger og markerer mistænkelige mønstre. Krav om gennemsigtighed bør indbygges i systemdesignet fra starten og ikke tilføjes som en eftertanke, så alle interessenter forstår, hvordan AI-systemerne fungerer, og hvilke data de bruger. Ansvarlighedsmekanismer skal tydeligt placere ansvaret for AI-systemets adfærd, med konsekvenser for uagtsomhed eller uetisk praksis. Red teaming-øvelser bør gennemføres regelmæssigt af eksterne eksperter, der aktivt forsøger at game systemerne, og resultaterne skal omsættes til løbende forbedringer. Organisationer bør indføre trinvise implementeringsprocesser, hvor nye AI-systemer testes grundigt i kontrollerede miljøer, inden de bredt implementeres, med sikkerhedsvalidering ved hvert trin. At opbygge denne kultur kræver en erkendelse af, at sikkerhed og innovation ikke er i konflikt—organisationer, der investerer i robust AI-sikkerhed, innoverer faktisk mere effektivt, fordi de kan implementere systemer med tillid og opretholde brugertillid på lang sigt.

At game et AI-system betyder bevidst at manipulere eller udnytte AI-modeller for at frembringe utilsigtede outputs, omgå sikkerhedsforanstaltninger eller udtrække følsomme oplysninger. Dette omfatter teknikker som prompt injection, adversariale angreb, datapoisening og modeludtrækning. I modsætning til normale systemfejl er gaming et bevidst forsøg på at omgå AI-systemernes tiltænkte adfærd.

Adversariale angreb er i stigende grad almindelige, efterhånden som AI-systemer bliver mere udbredte i kritiske applikationer. Forskning viser, at de fleste AI-systemer har sårbarheder, der kan udnyttes. Tilgængeligheden af angrebsværktøjer og -teknikker betyder, at både sofistikerede angribere og almindelige brugere potentielt kan game AI-systemer, hvilket gør dette til et udbredt problem.

Ingen enkelt forsvarsmekanisme giver fuldstændig immunitet mod gaming. Dog kan organisationer markant reducere risikoen gennem flerlagede forsvar såsom adversarial træning, datavalidering, output-obfuskering, raterestriktion og løbende overvågning. Den mest effektive tilgang kombinerer tekniske foranstaltninger med organisatoriske praksisser og menneskelig overvågning.

Almindelige AI-fejl opstår, når systemer begår fejl på grund af begrænsninger i træningsdata eller modelarkitektur. Gaming indebærer bevidst manipulation for at udnytte sårbarheder. Gaming er intentionelt, ofte usynligt for brugere, og designet til at gavne angriberen på bekostning af systemet eller dets brugere. Almindelige fejl er utilsigtede systemfejl.

Forbrugere kan beskytte sig ved at være bevidste om, hvordan AI-systemer fungerer, forstå at deres data bruges til at påvirke deres adfærd og være skeptiske over for anbefalinger, der virker for perfekt tilpassede. At støtte gennemsigtighedskrav, bruge værktøjer der beskytter privatlivet og arbejde for stærkere AI-regulering hjælper også. Oplysning om AI-manipulationstaktikker bliver stadig vigtigere.

Regulering er afgørende for at forhindre AI-gaming i stor skala. Nuværende rammer som EU's AI Act fokuserer primært på fysisk og psykologisk skade og efterlader økonomiske skader stort set uadresserede. Effektiv regulering kræver ansvarlighedsrammer, forbedringer af forbrugerbeskyttelsesmyndigheder, international koordinering og klare regler, der forhindrer manipulerende AI-praksis, samtidig med at innovationsincitamenter bevares.

AI-overvågningsplatforme giver realtidsindsigt i, hvordan AI-systemer opfører sig og anvendes. De opdager uregelmæssigheder, der kan indikere adversariale angreb, sporer usædvanlige forespørgselsmønstre, der tyder på modeludtrækning, og identificerer, når systemoutputs afviger fra forventet adfærd. Denne synlighed muliggør hurtig respons på trusler, før der sker betydelig skade.

Omkostninger omfatter direkte økonomiske tab fra svindel og manipulation, tab af omdømme fra sikkerhedshændelser, juridisk ansvar og bøder, driftsforstyrrelser fra systemnedlukninger og langvarigt tab af brugerens tillid. For forbrugere omfatter omkostningerne reduceret udbytte af tjenester, krænkelse af privatliv og udnyttelse af adfærdsvulnerabiliteter. Den samlede økonomiske påvirkning er betydelig og voksende.

AmICited overvåger, hvordan AI-systemer refereres til og anvendes på tværs af platforme, hvilket hjælper dig med at opdage gaming-forsøg og manipulation i realtid. Få indsigt i din AI-adfærd og hold dig foran trusler.

Lær hvordan du optimerer pressemeddelelser for AI-synlighed på tværs af ChatGPT, Gemini, Perplexity og andre AI-søgemaskiner. Opdag GEO-best practices, formater...

Lær hvordan du bestrider unøjagtige AI-oplysninger, rapporterer fejl til ChatGPT og Perplexity, og implementerer strategier for at sikre, at dit brand er korrek...

Lær, hvordan AI-modeller behandler og løser modstridende information gennem vurdering af troværdighed, dataaggregering, probabilistisk ræsonnement og rangerings...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.