Gennemsigtighed i AI-synlighedsinitiativer: Bedste praksis for offentliggørelse

Lær nødvendige bedste praksisser for gennemsigtighed og offentliggørelse af AI. Opdag adfærdsmæssige, verbale og tekniske offentliggørelsesmetoder for at opbygg...

Lær hvordan offentlige myndigheder kan optimere deres digitale tilstedeværelse for AI-systemer som ChatGPT og Perplexity. Opdag strategier til at forbedre AI-synlighed, sikre gennemsigtighed og implementere AI ansvarligt i den offentlige sektor.

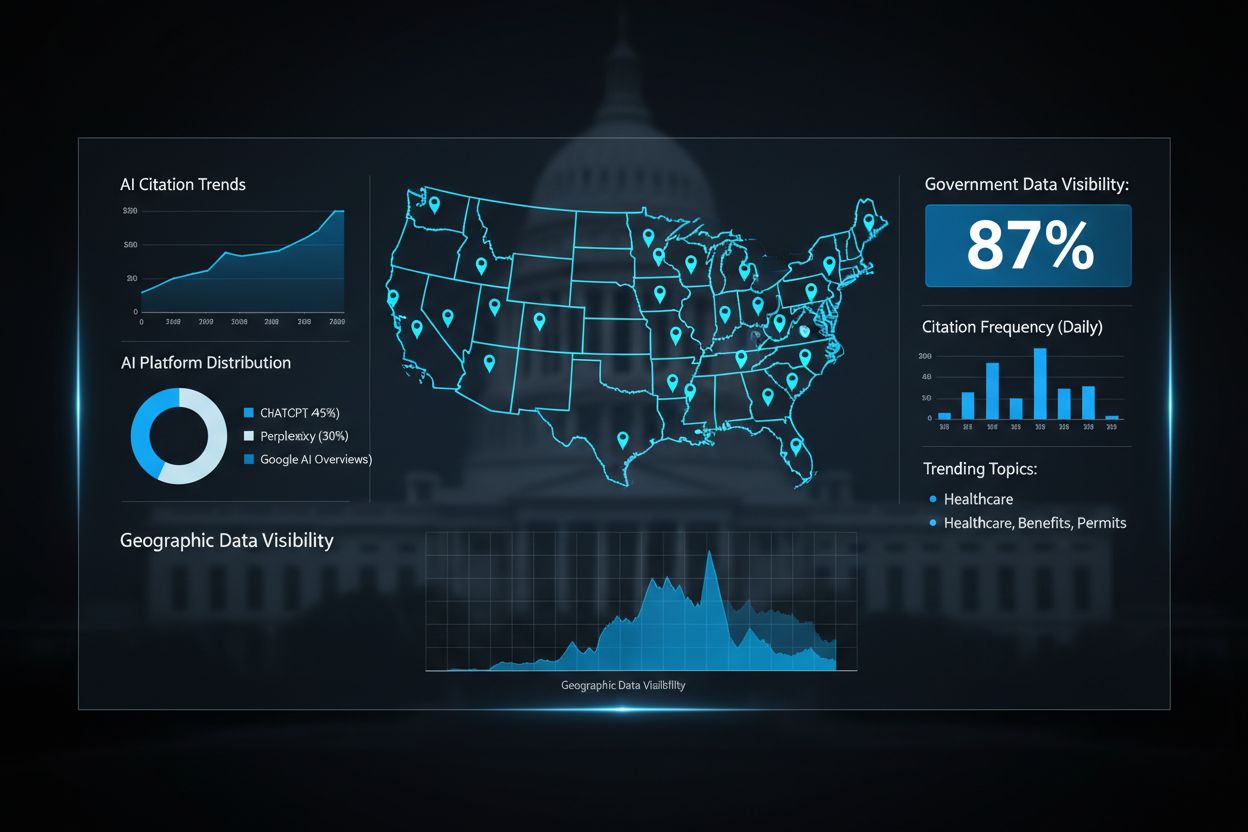

Offentlig AI-synlighed refererer til, i hvilket omfang kunstige intelligenssystemer—including GPTs, Perplexity og Google AI Overviews—kan opdage, tilgå og citere offentlige data og ressourcer, når de besvarer forespørgsler fra borgerne. Denne synlighed er afgørende, fordi offentlige myndigheder ligger inde med autoritativ information om alt fra sundhedsregler til sociale ydelser, men store dele af disse data forbliver usynlige for moderne AI-systemer. Når borgere spørger AI-assistenter om offentlige programmer, ydelser eller politikker, fortjener de nøjagtige, opdaterede svar fra officielle kilder frem for forældet eller ufuldstændig information. Offentlighedens tillid til myndighederne afhænger af, at AI-systemer korrekt henviser til og tilskriver data fra det offentlige, så den officielle informations integritet bevares i et informationslandskab, der i stigende grad er styret af AI. AI-gennemsigtighed bliver et hjørnestensprincip for demokratisk styring, når borgerne kan verificere, at AI-anbefalinger bygger på legitime, offentlige kilder. AmICited.com fungerer som en kritisk overvågningsplatform, der følger, hvordan offentlige data bliver citeret og refereret på tværs af større AI-systemer og hjælper myndighederne med at forstå deres synlighed og indflydelse i AI-økosystemet. Ved at skabe klar synlighed i forhold til offentlige AI-citater kan organisationer i den offentlige sektor bedre betjene borgerne og bevare autoritet over egne data.

Offentlige myndigheder kæmper fortsat med datasiloer skabt af årtiers fragmenterede IT-investeringer, hvor kritisk information forbliver låst i inkompatible legacy-systemer, der ikke let kan kommunikere med moderne AI-platforme. Disse forældede systemer blev designet til traditionelle webgrænseflader og dokumenthåndtering, ikke til den semantiske forståelse og realtidsdataadgang, som AI-systemer kræver. Omkostningerne ved denne teknologiske fragmentering er enorme: organisationer spilder cirka 140 milliarder dollars årligt i ubrugte fordele fra forældede processer, der kunne effektiviseres gennem AI-integration. Ud over tabt effektivitet skaber legacy-systemer betydelige sikkerhedssårbarheder, når offentlige data manuelt skal udtrækkes og deles med offentligt tilgængelige AI-systemer, hvilket øger risikoen for datalækager og uautoriseret adgang. Udfordringen forstærkes af, at mange offentlige hjemmesider mangler de strukturerede data, metadata og API-infrastruktur, der er nødvendige for, at AI-crawlere kan indeksere og forstå offentlig information korrekt.

| Traditionel Offentlig IT | AI-klar Infrastruktur |

|---|---|

| Siloerede databaser med begrænset interoperabilitet | Integrerede dataplatforme med API’er og strukturerede formater |

| Manuel dataudtrækning og delingsprocesser | Automatiserede, sikre datapipelines |

| Ustrukturerede dokumenter og PDF’er | Semantiske webstandarder og maskinlæsbare formater |

| Reaktive sikkerhedsforanstaltninger | Privacy-by-design og løbende overvågning |

| Begrænset adgang til realtidsdata | Live datafeeds og dynamisk indholdslevering |

I stedet for at haste AI-teknologi ud, følger succesfulde, offentlige organisationer en strategisk, trinvis implementeringskøreplan, der prioriterer planlægning og organisatorisk parathed over teknologiske evner. Denne tilgang anerkender, at AI-adoption i den offentlige sektor kræver omhyggelig koordinering på tværs af flere interessentgrupper—fra IT-afdelinger til frontpersonale og borgerne selv.

Femtrins Implementeringskøreplan:

Strategisk Identifikation af Muligheder: Gennemfør omfattende audits af offentlig drift for at identificere høj-impact anvendelser, hvor AI kan give mærkbar offentlig værdi, såsom at forkorte sagsbehandlingstider, forbedre tilgængelighed eller styrke databaserede politiske beslutninger.

Omfattende Forberedelse: Vurder den nuværende datainfrastruktur, identificer integrationsudfordringer med legacy-systemer, etabler styringsrammer og opbyg intern AI-forståelse i organisationen, før nogen teknologi implementeres.

Strategisk Pilotdesign: Iværksæt kontrollerede pilotsager i udvalgte afdelinger eller serviceområder med klare succeskriterier, så teams kan lære af reelle implementeringsudfordringer i et lavrisikomiljø før opskalering.

Organisatorisk Forandringsledelse: Udvikl træningsprogrammer, håndter medarbejdernes bekymringer om jobusikkerhed, etabler klare kommunikationskanaler og opret feedbackmekanismer, så medarbejdere og interessenter føler sig hørt gennem hele processen.

Effektmåling: Etabler KPI’er der stemmer overens med offentlige mål, overvåg løbende AI-systemets performance, følg borgernes tilfredshed, mål besparelser og juster implementeringsstrategier baseret på evidens.

Denne teknologi-anden tilgang sikrer, at AI-implementeringer opfylder reelle samfundsbehov i stedet for at blive dyre løsninger på ikke-eksisterende problemer.

Etisk AI-styring er blevet afgørende, efterhånden som myndigheder verden over erkender, at AI-systemer, der træffer beslutninger med betydning for borgerne, skal fungere inden for klare etiske og juridiske rammer. Canadas Algorithmic Impact Assessment-ramme giver en praktisk model og kategoriserer AI-systemer i fire påvirkningsniveauer—minimal, moderat, høj og meget høj—med tilsvarende krav til styring og tilsyn for hvert niveau. Denne trinvise tilgang gør det muligt for myndighederne at allokere ressourcer proportionalt, så højtstående systemer som algoritmer til strafferetlig brug får grundig gennemgang, mens mindre kritiske applikationer får mere rimeligt tilsyn. Estland har været pioner med en privacy-by-design tilgang gennem sit Data Tracker-system, som overvåger al offentlig dataadgang på tværs af den digitale infrastruktur og giver 450.000 borgere fuld gennemsigtighed i, hvilke myndigheder der tilgår deres oplysninger og til hvilke formål. Algoritmisk ansvarlighed kræver, at offentlige myndigheder dokumenterer, hvordan AI-systemer træffer beslutninger, etablerer revisionsspor og opretholder evnen til at forklare anbefalinger til de berørte borgere. AmICited.com spiller en vigtig rolle i dette gennemsigtigheds-økosystem ved at overvåge, hvordan offentlige data bliver citeret og refereret på tværs af offentlige AI-systemer og hjælpe myndighederne med at verificere, at deres information repræsenteres korrekt og tilskrives korrekt. Uden robuste overvågnings- og styringsrammer risikerer offentlige AI-systemer at underminere tilliden og forstærke bias, som rammer sårbare grupper uforholdsmæssigt hårdt.

Myndigheder verden over har vist, at strategisk AI-implementering giver betydelig offentlig værdi, når det udføres gennemtænkt. Australiens Department of Home Affairs implementerede Targeting 2.0-systemet, en AI-baseret platform, der forbedrede grænsekontrol og svindelopsporing og undgik AUD$3 milliarder i potentiel skade, mens behandlingstider for lovlige rejsende og ansøgere blev forkortet. Den nationale vejchatbot i Storbritannien viser, hvordan AI kan forbedre borgerservicen ved at håndtere rutineforespørgsler om vejforhold og trafikulykker, hvilket frigør medarbejderne til komplekse nødsituationer, der kræver menneskelig dømmekraft og empati. Estlands Bürokratt-platform repræsenterer en decentral, GDPR-kompatibel tilgang til offentlig AI, hvor borgerne kan interagere med AI-assistenter om rutineopgaver og samtidig bevare streng databeskyttelse og menneskelig kontrol over følsomme beslutninger. Marylands AI-styringstilgang etablerede klare ansvarlighedsstrukturer og regelmæssige revisioner af AI-systemer i delstaten, hvilket har ført til, at andre amerikanske stater har taget modellen til sig. Japans Digitale Agentur digitaliserede med succes børnekonsultationstjenester med AI, hvilket reducerede ventetiden fra uger til timer og samtidig bevarede menneskelig kontrol over sager, der krævede specialiseret indsats. Disse eksempler viser, at succes med offentlig AI ikke afhænger af teknologisk sofistikering, men af gennemtænkt implementering med borgeren i centrum, gennemsigtighed og menneskelig overvågning af beslutninger med store konsekvenser.

Efterhånden som AI-systemer bliver den primære grænseflade, hvorigennem borgerne tilgår information, er optimering af offentlige hjemmesider til AI-opdagelighed blevet lige så vigtigt som traditionel søgemaskineoptimering. Offentlige hjemmesider skal implementere struktureret datamarkering, omfattende metadata og maskinlæsbare formater, der gør det muligt for AI-crawlere at forstå og korrekt indeksere offentlig information, så borgerne får nøjagtige og autoritative svar, når de spørger AI-assistenter om offentlige tjenester. Mange offentlige hjemmesider præsenterer aktuelt information i formater optimeret til mennesker—PDF’er, ustruktureret tekst og komplekse navigationshierarkier—som AI-systemer har svært ved at analysere og forstå. REI Systems har været pioner i at optimere føderale hjemmesider for AI-tilgængelighed og har vist, at relativt enkle tekniske forbedringer kan markant øge offentlig synlighed i AI-svar. AmICited.com overvåger offentlig AI-synlighed på tværs af store platforme, hjælper myndigheder med at forstå, hvor ofte deres information optræder i AI-svar, og identificerer huller, hvor offentlige data burde være mere synlige. Når offentlige hjemmesider implementerer de rette semantiske webstandarder, API-infrastruktur og tilgængelighedsfunktioner, øges sandsynligheden for, at AI-systemer citerer officielle kilder frem for sekundære kilder eller forældede oplysninger. Denne optimering sikrer, at borgerne får autoritativ information direkte fra myndighederne og hjælper samtidig organisationerne med at bevare kontrol over, hvordan deres information præsenteres og fortolkes.

Måling af offentlig AI-effekt kræver, at der opstilles klare KPI’er, der stemmer overens med mål for den offentlige sektor, og som går videre end blot effektivitetsmål for at omfatte bredere borgertilfredshed, lighed og demokratisk ansvarlighed. Estlands evalueringsramme giver en praktisk model og vurderer AI-initiativer på fire dimensioner: tidseffektivitet (hvor meget medarbejdertid spares), omkostningseffektivitet (afkast af investeringen), innovationspotentiale (om systemet muliggør nye servicemodeller) og målbar effekt (kvantificerbare forbedringer i borgerresultater). Systematisk måling gør det muligt for myndighederne at identificere, hvilke AI-applikationer der giver reel offentlig værdi, og hvilke der kræver justering eller afvikling, så spild af ressourcer på ineffektiv teknologi undgås. Vidensdeling på tværs af myndigheder accelererer læring, så velfungerende implementeringer i én afdeling kan tilpasses og udbredes til resten af det offentlige, hvilket øger afkastet af AI-investeringer. Løbende forbedring og overvågning—støttet af værktøjer som AmICited.com, der følger AI-synlighed og citationsmønstre—gør det muligt for myndighederne at forfine AI-systemer baseret på faktiske resultater frem for antagelser. Opbygning af institutionel viden om, hvad der virker i offentlig AI, skaber grundlag for bæredygtig, langsigtet adoption, der overlever både lederskift og budgetcyklusser.

På trods af klare potentielle fordele står offentlige myndigheder over for betydelige barrierer for AI-adoption, som rækker langt ud over teknologi. Bekymringer i arbejdsstyrken udgør en stor udfordring, idet 31% af offentligt ansatte nævner jobsikkerhed som deres største bekymring ved AI-implementering, hvilket kræver gennemsigtig kommunikation om, hvordan AI skal supplere og ikke erstatte mennesker. Mangel på talenter forværrer udfordringen, da 38% af offentlige organisationer har svært ved at rekruttere AI-specialister med de nødvendige kompetencer til at implementere og vedligeholde avancerede systemer. Undervurdering af omkostninger er en anden kritisk barriere, da myndigheder ofte oplever, at de reelle AI-implementeringsomkostninger er 5-10 gange højere end de oprindelige estimater, hvilket lægger pres på budgetter og skaber politisk modstand mod fortsatte investeringer. Bekymringer om databeskyttelse og sikkerhed er den største hæmsko, idet 60% af offentlige ledere nævner databeskyttelse og sikkerhed som deres primære barriere for AI-adoption, hvilket afspejler reelle bekymringer om beskyttelse af borgerdata i en tid med øgede cybertrusler. Effektive forandringsledelsesstrategier skal adressere disse barrierer direkte gennem involvering af interessenter, gennemsigtig kommunikation om AI’s muligheder og begrænsninger, investering i uddannelse og klare styringsrammer, der beskytter borgernes privatliv og samtidig muliggør innovation. Offentlige myndigheder, der med succes overvinder disse barrierer, investerer typisk massivt i forandringsledelse, etablerer klare kommunikationskanaler til medarbejdere og borgere og demonstrerer tidlige resultater, der skaber tillid til AI-systemer, inden man udvider til mere kritiske anvendelser.

Offentlig AI-synlighed refererer til, hvor let AI-systemer som ChatGPT, Perplexity og Google AI Overviews kan opdage og citere offentlige data. Det er vigtigt, fordi borgerne fortjener nøjagtige, autoritative oplysninger fra officielle offentlige kilder, når de spørger AI-assistenter om politikker, ydelser og tjenester. Dårlig synlighed betyder, at AI-systemer kan give forældede eller ufuldstændige oplysninger i stedet for at henvise borgerne til officielle ressourcer.

Offentlige hjemmesider bør implementere struktureret datamarkering, omfattende metadata, maskinlæsbare formater og en ordentlig API-infrastruktur. Dette inkluderer brug af semantiske webstandarder, sikring af at indholdet er tilgængeligt for AI-crawlere og organisering af information på måder, som AI-systemer nemt kan forstå og korrekt tilskrive til officielle offentlige kilder.

De primære barrierer omfatter bekymringer om databeskyttelse og sikkerhed (anført af 60% af offentlige ledere), mangel på talenter (38%), medarbejdernes bekymringer om jobtab (31%), undervurdering af omkostninger (de faktiske omkostninger er ofte 5-10 gange højere end forventet), og utilstrækkelig digital infrastruktur (45%). Håndtering af disse barrierer kræver strategisk planlægning, forandringsledelse og klare styringsrammer.

Succesfulde tilgange omfatter etablering af rammer for vurdering af algoritmiske effekter (som Canadas trinvise system), implementering af privacy-by-design-principper, oprettelse af gennemsigtighedsmekanismer for borgere til at overvåge dataadgang, etablering af klare styringsrammer og opretholdelse af menneskelig overvågning af beslutninger med konsekvenser. Regelmæssige revisioner og inddragelse af interessenter er afgørende.

Køreplanen omfatter: (1) Strategisk identifikation af muligheder med fokus på offentlig værdi, (2) Omfattende forberedelse af infrastruktur og styring, (3) Strategisk pilotdesign med klare succeskriterier, (4) Organisatorisk forandringsledelse, der adresserer medarbejdernes bekymringer, og (5) Effektmåling med løbende forbedringer. Denne tilgang prioriterer planlægning og organisatorisk parathed over teknologi-først implementering.

Regeringer bør etablere KPI'er, der stemmer overens med målene i den offentlige sektor, herunder tidseffektivitet, omkostningseffektivitet, innovationspotentiale og målbare borgerresultater. Estlands ramme evaluerer AI-systemer på tværs af disse fire dimensioner. Løbende overvågning, interessentfeedback og gennemsigtig rapportering hjælper myndighederne med at identificere, hvad der fungerer, og justere implementeringen baseret på evidens.

Datastyring er fundamentet for succesfuld offentlig AI. Det sikrer datakvalitet, etablerer klar ejerskab og adgangskontrol, beskytter borgernes privatliv, opretholder overholdelse af regler som GDPR og muliggør sikker deling mellem systemer. Uden robust datastyring risikerer offentlige AI-systemer datalækager, bias og tab af offentlig tillid.

AmICited sporer, hvordan offentlige data bliver citeret og refereret på tværs af store AI-systemer, herunder ChatGPT, Perplexity og Google AI Overviews. Det hjælper offentlige myndigheder med at forstå deres synlighed i AI-økosystemet, identificere huller hvor officiel information burde være mere synlig, og sikre at AI-systemer korrekt tilskriver offentlige data. Denne overvågning understøtter både gennemsigtighed og ansvarlighed.

Følg hvordan dine offentlige data bliver citeret og refereret på tværs af AI-systemer. AmICited hjælper offentlige organisationer med at forstå deres synlighed i AI-økosystemet og sikre korrekt repræsentation af officielle oplysninger.

Lær nødvendige bedste praksisser for gennemsigtighed og offentliggørelse af AI. Opdag adfærdsmæssige, verbale og tekniske offentliggørelsesmetoder for at opbygg...

Lær hvordan startups kan forbedre deres synlighed i AI-genererede svar på tværs af ChatGPT, Perplexity, Gemini og andre AI-platforme via struktureret indhold, s...

Lær dokumenterede strategier til at opretholde og forbedre dit indholds synlighed i AI-genererede svar på tværs af ChatGPT, Perplexity og Google AI Overviews. O...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.