YMYL (Your Money Your Life)

YMYL-indhold kræver høje E-E-A-T-standarder. Lær hvad der kvalificerer som Your Money Your Life-indhold, hvorfor det er vigtigt for SEO og AI-synlighed, og hvor...

Lær hvordan sundhedsorganisationer kan optimere medicinsk indhold for LLM-synlighed, navigere YMYL-krav og overvåge AI-citater med AmICited.com’s AI-overvågningsplatform.

Your Money or Your Life (YMYL)-indhold omfatter emner, der direkte påvirker brugerens trivsel, herunder sundhed, økonomi, sikkerhed og samfundsoplysninger—og sundhedsplejen befinder sig øverst i Googles kontrolhierarki. Efter Googles kerneopdatering i marts 2024 reducerede søgegiganten synligheden af indhold af lav kvalitet med 40%, hvilket signalerer en hidtil uset indsats mod utroværdig medicinsk information. Udfordringen for sundhedsorganisationer har dog fundamentalt ændret sig: Indhold skal nu ikke kun være synligt for søgemaskiner, men også for store sprogmodeller (LLM’er), der i stigende grad fungerer som det første stop for personer, der søger sundhedsoplysninger. Med 5% af alle Google-søgninger relateret til sundhed og 58% af patienter, der nu bruger AI-værktøjer til sundhedsoplysninger, står sundhedsudbydere over for et kritisk synlighedsgab—deres indhold kan rangere højt i traditionel søgning, men forbliver usynligt for de AI-systemer, som patienterne faktisk konsulterer. Dette dobbeltkrav om synlighed repræsenterer en helt ny front inden for strategi for sundhedsindhold.

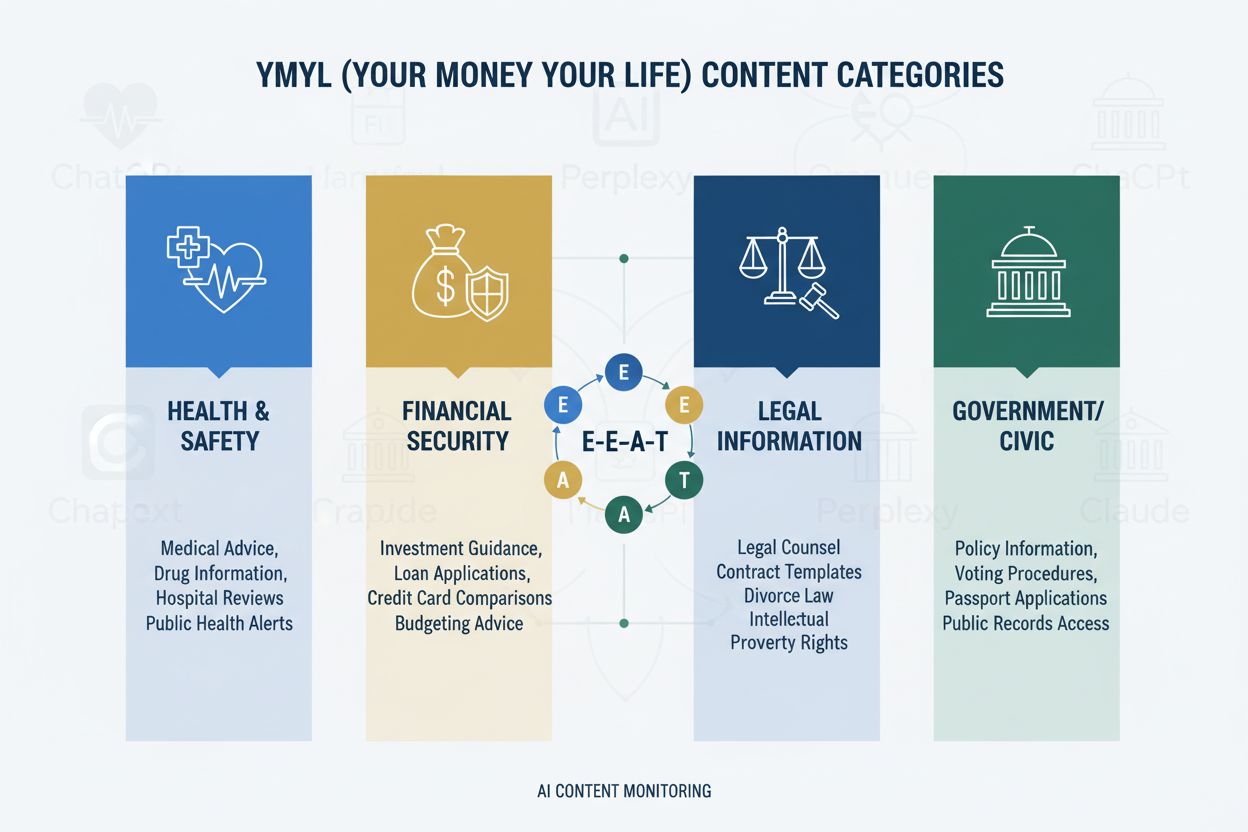

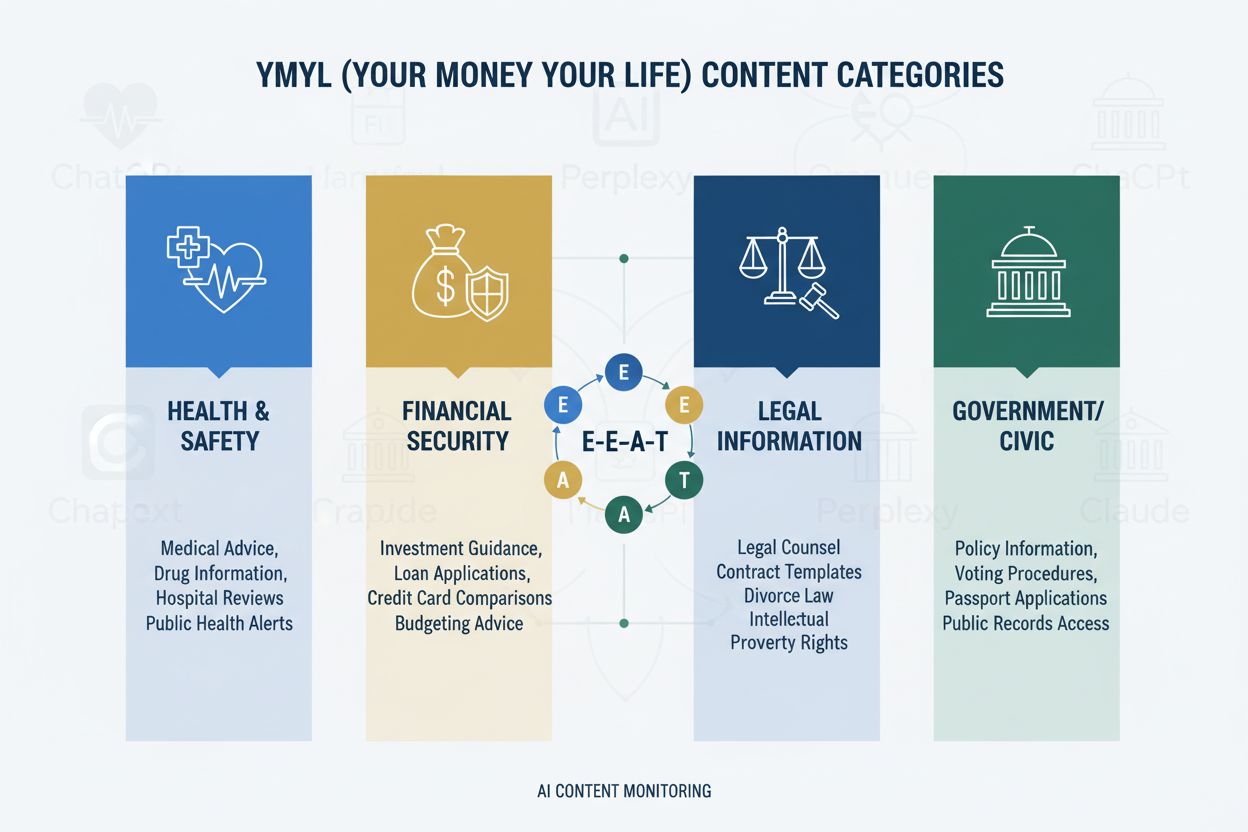

YMYL-rammen kategoriserer indhold i fire kritiske domæner: Sundhed (medicinske tilstande, behandlinger, velvære), Økonomi (investeringsrådgivning, økonomisk planlægning), Sikkerhed (nødsituationer, sikkerhed), og Samfund (valg, juridiske anliggender)—hvor sundhedsplejen kræver det højeste kontrolniveau på grund af dens direkte indvirkning på menneskers trivsel. Googles E-E-A-T-ramme (Experience, Expertise, Authoritativeness, Trustworthiness) fungerer som evalueringsstandard og kræver, at sundhedsindhold demonstrerer ægte medicinsk viden, professionelle kvalifikationer og verificerbar nøjagtighed. Quality Rater Guidelines understreger eksplicit, at sundhedsindhold skal være skabt eller gennemgået af kvalificerede medicinske fagfolk, med tydelige forfatteroplysninger og institutionel opbakning. Sundhedsorganisationer skal forstå, at E-E-A-T ikke er valgfrit—det er grundkravet for både søgesynlighed og LLM-optagelse. Herunder ses indflydelseshierarkiet for YMYL-kategorier:

| YMYL-kategori | Indflydelsesniveau | Kontrolintensitet | Relevans for sundhedspleje |

|---|---|---|---|

| Sundhed | Kritisk | Højest | Direkte patientsikkerhed |

| Økonomi | Høj | Høj | Forsikring, omkostninger |

| Sikkerhed | Høj | Høj | Nødprotokoller |

| Samfund | Medium | Medium | Sundhedspolitik |

Selv med deres sofistikering viser LLM’er alarmerende fejlprocenter, når de behandler medicinsk information, hvor Stanford HAI-forskning dokumenterer 30-50% uunderbyggede udsagn i sundhedsrelaterede svar. GPT-4 med Retrieval-Augmented Generation (RAG) producerer stadig svar, hvor 50% indeholder uunderbyggede påstande, selv når de er trænet på autoritative kilder—et fænomen kendt som hallucination, der kan give sig udslag i anbefalinger af ikke-eksisterende medicinsk udstyr, forkerte behandlingsprotokoller eller opdigtede lægemiddelinteraktioner. Et bemærkelsesværdigt tilfælde var, da Men’s Journal udgav en AI-genereret artikel med 18 specifikke medicinske fejl, herunder farlige behandlingsanbefalinger, der kunne skade læserne. Det grundlæggende problem er, at AI mangler “Experience”—den førstehåndskliniske viden, der adskiller eksperter fra statistiske mønstergenkendelsessystemer. Denne mangel betyder, at uden korrekt struktureret, autoritativt indhold fra verificerede medicinske fagfolk, vil LLM’er selvsikkert generere overbevisende, men potentielt farlige medicinske vejledninger.

AI Overviews og tilsvarende LLM-baserede svarsystemer ændrer fundamentalt, hvordan patienter opdager sundhedsoplysninger ved at give direkte svar uden at kræve besøg på hjemmesider, hvilket reelt eliminerer den traditionelle klikgennemgang, der i årtier har drevet webtrafik til sundhedssektoren. Indholdssynlighed afhænger nu af citation i AI-svar frem for placering i søgeresultater, hvilket betyder, at en sundhedsudbyders artikel kan blive syntetiseret i et AI-svar uden nogensinde at modtage trafik eller anerkendelse. LLM’er syntetiserer information fra flere kilder samtidigt og skaber en ny informationsarkitektur, hvor individuelle websites konkurrerer om at blive inkluderet i AI-genererede sammendrag frem for om topplaceringer i søgning. Sundhedsudbydere skal erkende, at Share of Model (SOM)—procentdelen af AI-svar, der citerer deres indhold—er blevet den kritiske synlighedsmetrik, der erstatter traditionelle klikrater. Dette paradigmeskifte kræver en grundlæggende nytænkning af indholdsstrategien: I stedet for at optimere for klik skal sundhedsorganisationer optimere for citationskvalitet, nøjagtighed og strukturel klarhed, så deres indhold bliver det foretrukne udgangspunkt for LLM-syntese.

LLM’er behandler medicinsk indhold mest effektivt, når det er organiseret med klar hierarkisk struktur, der afspejler klinisk beslutningstagning: definition af tilstand → symptompræsentation → diagnostiske kriterier → behandlingsmuligheder → prognose. Progressiv afsløringsarkitektur—præsentation af enkle begreber før komplekse—giver LLM’er mulighed for at opbygge nøjagtige mentale modeller i stedet for at forveksle beslægtede, men forskellige tilstande. Spørgsmålsbaseret indholdsdesign (besvarelse af “Hvad er tilstand X?” før “Hvordan behandles det?”) stemmer overens med, hvordan LLM’er henter og syntetiserer information på tværs af dokumenter. Semantisk rigdom og sammenkædede begreber—eksplicit sammenkobling af beslægtede tilstande, behandlinger og risikofaktorer—hjælper LLM’er med at forstå relationer, der ellers ville forblive implicitte. Implementering af Schema.org medicinsk markup (MedicalCondition, MedicalProcedure, MedicalTreatment) giver strukturerede data, som LLM’er kan analysere og citere pålideligt. Naturligt sprog, der efterligner ekspertforklaring—brug af terminologi, som læger ville bruge, men stadig tilgængeligt—signalerer autenticitet til både LLM’er og læsere. Sundhedsorganisationer bør gennemgå eksisterende indhold ift. disse strukturelle krav, da traditionelt SEO-optimeret indhold ofte mangler den hierarkiske klarhed og semantiske rigdom, som LLM’er kræver for nøjagtig syntese.

Tilstedeværelse på flere platforme forstærker autoritetssignaler på måder, som enkelt-site-strategier ikke kan opnå, da LLM’er anerkender konsistent ekspertise på tværs af flere autoritative kanaler. Medicinske Q&A-platforme som HealthTap og Figure 1 giver direkte interaktion mellem læge og patient, som LLM’er genkender som ægte ekspertise, med verificerede kvalifikationer og realtidsengagement. Faglige netværk som Doximity og medicinfokuserede LinkedIn-fællesskaber etablerer kollegial anerkendelse og professionel status, som LLM’er vægter tungt i autoritetsvurdering. Bidrag til Medical Wikipedia og lignende kollektive vidensbaser signalerer vilje til at bidrage til offentlig medicinsk viden uden kommercielle motiver, et tillidssignal LLM’er genkender. Omfattende forfatterprofilsider—med speciallægecertificeringer, publikationer, klinisk erfaring og institutionelle tilknytninger—skal være til stede på hovedsitet og linkes konsekvent på tværs af platforme. Konsistens på tværs af platforme ift. kvalifikationer, specialer og kliniske perspektiver forstærker autenticitet; modstridende information vækker LLM-skepsis. Sundhedsorganisationer bør udvikle en platformsoverskridende autoritetsstrategi, der betragter hver platform som et forstærkende signal frem for en separat kanal, så lægefaglig ekspertise er synlig og verificerbar i hele det digitale økosystem.

Traditionel sundhedsanalyse—overvågning af organisk trafik, klikrater og søgerangeringer—overser fuldstændig AI-synlighedshistorien og skaber en farlig blind vinkel, hvor indhold fremstår succesfuldt efter gamle målinger, men forbliver usynligt for LLM’er. Share of Model (SOM) opstår som den kritiske nye metrik, der måler, hvor stor en andel af AI-genererede svar om en given tilstand, der citerer din organisations indhold. Effektiv overvågning kræver systematisk test på tværs af flere LLM-platforme (ChatGPT, Claude, Perplexity og nye konkurrenter) med ensartede forespørgsler inden for dine specialområder, hvor citationsfrekvens og placering i svar dokumenteres. Citationskvalitet er lige så vigtig som citationsfrekvens—at blive citeret som primær kilde vægtes højere end at fremgå på en liste over sekundære kilder, og LLM’er genkender, når indhold citeres for specifik ekspertise frem for generisk information. Overvågningsværktøjer spænder fra manuelle tests (køre forespørgsler og dokumentere resultater) til automatiserede platforme, der følger SOM-udviklingen over tid og advarer om ændret synlighed. Indirekte indikatorer såsom branded søgevolumen, patientfeedback, der nævner AI-anbefalinger, og henvisningsmønstre fra AI-platforme giver supplerende data, der bekræfter SOM-tendenser. Sundhedsorganisationer bør etablere baseline-SOM-målinger straks, da konkurrencesituationen ændrer sig hurtigt og tidlige synlighedsfordele akkumuleres over tid.

Sundhedsorganisationer bør starte med et enkelt specialområde i stedet for at forsøge en total transformation med det samme, så teams kan opbygge erfaring og forfine processer, før de skalerer. Indholdsaudits med LLM-briller kræver vurdering af eksisterende artikler for hierarkisk klarhed, semantisk rigdom, spørgsmålsbaseret arkitektur og forfatterautoritet—ofte afsløres det, at ellers højt rangeret indhold mangler den struktur, LLM’er kræver. Synlighedstest på AI-platforme med specialespecifikke forespørgsler etablerer baseline-SOM og identificerer, hvilke tilstande og behandlinger der aktuelt er synlige versus usynlige. Implementering af spørgsmålsbaseret arkitektur indebærer omstrukturering af eksisterende indhold eller oprettelse af nyt indhold, der begynder med patientspørgsmål (“Hvorfor har jeg dette symptom?”) før kliniske forklaringer. Forfatterprofilsider bør oprettes for hver lægebidragsyder med speciallægecertifikater, specialer, publikationer og klinisk erfaring, med konsekvente links fra alt forfattet indhold. Indholdsklynger om tilstande—oprettelse af sammenhængende indhold, der dækker symptomer, diagnose, behandlingsmuligheder og prognose—hjælper LLM’er med at forstå helhedsorienteret information frem for isolerede artikler. Denne faseopdelte tilgang gør det muligt for sundhedsorganisationer at måle effekt, forfine strategi og opbygge intern ekspertise, før de udvider til flere specialer.

HIPAA-overholdelse forbliver altafgørende, også når indhold gøres synligt for LLM’er; patientfortrolighed gælder uanset, om informationen tilgås via søgemaskiner eller AI-systemer, hvilket kræver omhyggelig anonymisering og de-identificering af eventuelle cases. Medicinske ansvarsfraskrivelser og nøjagtighedskrav skal være eksplicitte og tydelige, med klare erklæringer om, at AI-syntetiseret information ikke erstatter professionel lægelig rådgivning, og at individuelle forhold kan afvige fra generel vejledning. Faktatjek og kildeangivelse bliver kritiske compliance-elementer, da sundhedsorganisationer er ansvarlige for nøjagtigheden af deres publicerede information, og LLM’er vil forstærke fejl på tværs af tusindvis af brugere. Regulatorisk kontrol af AI-genereret medicinsk indhold intensiveres, idet FDA og FTC i stigende grad undersøger, hvordan AI-systemer præsenterer medicinske oplysninger; sundhedsorganisationer skal sikre, at alt indhold—uanset om det er menneskeskrevet eller AI-assisteret—overholder regulatoriske standarder. Menneskelig medicinsk gennemgang af kvalificerede læger skal forblive obligatorisk for alt sundhedsindhold, med dokumenterede processer, der demonstrerer engagement i nøjagtighed og sikkerhed. Ansvarsmæssige overvejelser rækker ud over traditionel lægelig ansvarspådragelse og omfatter potentielt ansvar for information, som LLM’er syntetiserer og præsenterer for patienter; sundhedsorganisationer bør rådføre sig med juridisk ekspertise om deres ansvar for, hvordan deres indhold bruges i AI-systemer. Overholdelse og sikkerhed må ikke blive sekundære hensyn i jagten på AI-synlighed.

AI vil fortsat omforme opdagelsen af sundhedsoplysninger i accelererende tempo, hvor LLM’er bliver stadig mere sofistikerede i medicinsk ræsonnement og stadig mere centrale for, hvordan patienter undersøger helbredstilstande. Sundhedsorganisationer, der tilpasser deres indholdsstrategi nu, positionerer sig som pålidelige kilder i dette nye økosystem, mens de, der tøver, risikerer at blive usynlige for de AI-systemer, deres patienter faktisk bruger. Tidlige adoptører opnår konkurrencemæssig fordel gennem etablerede autoritetssignaler, højere Share of Model-målinger og patienttillid skabt gennem konsistent synlighed i AI-svar—fordele, der forstærkes, efterhånden som LLM’er lærer at genkende og prioritere pålidelige kilder. Integration af traditionel SEO og LLM-optimering er ikke et enten-eller valg, men en supplerende strategi, da søgemaskiner i stigende grad inkorporerer LLM-teknologi, og patienter fortsat bruger flere informationskilder. Langsigtet bæredygtighed afhænger af ægte ekspertise og ikke af optimeringstricks; sundhedsorganisationer, der investerer i ægte medicinsk viden, gennemsigtige kvalifikationer og korrekt information, vil trives uanset, hvordan opdagelsesmekanismer udvikler sig. Landskabet for sundhedsindhold har ændret sig fundamentalt, og organisationer, der ser denne overgang som en mulighed frem for en trussel, vil definere fremtiden for opdagelse af patientinformation.

YMYL (Your Money Your Life) refererer til indhold, der kan have betydelig indflydelse på folks sundhed, økonomiske stabilitet eller sikkerhed. Sundhedspleje er den kategori med størst kontrol, fordi medicinsk misinformation kan forårsage alvorlig skade eller død. Google anvender strengere algoritmiske standarder på YMYL-indhold, og LLM'er bruges i stigende grad af patienter til at undersøge sundhedsoplysninger, hvilket gør YMYL-overholdelse afgørende for synlighed.

LLM'er syntetiserer information fra flere kilder for at give direkte svar, mens søgemaskiner rangerer individuelle sider. Sundhedsindhold skal nu struktureres til citation af AI-systemer, ikke kun til Google-rangeringer. Det betyder, at dit indhold kan uddanne tusinder gennem AI-svar uden at modtage direkte webtrafik, hvilket kræver en grundlæggende anderledes optimeringsmetode.

E-E-A-T står for Experience, Expertise, Authoritativeness og Trustworthiness. Sundhedsindhold kræver de højeste E-E-A-T-standarder med vægt på førstehånds medicinsk erfaring og verificerede kvalifikationer. Googles Quality Rater Guidelines nævner E-E-A-T 137 gange, hvilket afspejler dets kritiske betydning for synlighed af sundhedsindhold både i søgning og LLM-systemer.

Undersøgelser viser, at AI producerer uunderbyggede medicinske udsagn 30-50 % af tiden og hallucinere medicinsk information. AI mangler reel medicinsk erfaring og kan ikke verificere information mod gældende medicinske standarder. Derfor er menneskelig medicinsk gennemgang og ekspertforfatterskab fortsat afgørende—AI bør støtte sundhedsprofessionelle, ikke erstatte dem.

Test dit indhold på tværs af ChatGPT, Claude og Perplexity med almindelige patientspørgsmål inden for dit speciale. Følg Share of Model (SOM)-målinger—procentdelen af AI-svar, der citerer dit indhold. AmICited.com automatiserer denne overvågning og giver realtidsindsigt i, hvordan dit sundhedsbrand vises på tværs af flere LLM-platforme.

Traditionel SEO fokuserer på at rangere individuelle sider for nøgleord. LLM-optimering lægger vægt på omfattende dækning, semantisk rigdom og struktureret indhold, som AI-systemer kan forstå og citere. Begge tilgange supplerer hinanden—sundhedsorganisationer har brug for integrerede strategier, der optimerer til både søgemaskiner og LLM'er.

AI bør kun bruges som et værktøj til at støtte menneskelige medicinske eksperter, ikke til at erstatte dem. Alt sundhedsindhold skal gennemgås og godkendes af kvalificerede medicinske fagfolk inden offentliggørelse. Risikoen er for stor til at stole på AI-genereret sundhedsindhold uden ekspertkontrol og -verificering.

AmICited.com overvåger, hvordan sundhedsbrands og medicinsk indhold vises i AI-svar på ChatGPT, Perplexity, Google AI Overviews og andre LLM-platforme. Det giver synlighedsmetrikker, følger Share of Model (SOM) og tilbyder optimeringsanbefalinger, så sundhedsorganisationer kan sikre, at deres ekspertise er synlig gennem AI-drevet patientforskning.

Følg hvordan dit medicinske indhold vises i ChatGPT, Perplexity, Google AI Overviews og andre LLM-platforme. Få indsigt i realtid om din Share of Model (SOM) og optimer til AI-drevet patientopdagelse.

YMYL-indhold kræver høje E-E-A-T-standarder. Lær hvad der kvalificerer som Your Money Your Life-indhold, hvorfor det er vigtigt for SEO og AI-synlighed, og hvor...

Fællesskabsdiskussion om, hvordan AI-systemer håndterer YMYL (Your Money or Your Life) emner. Ægte indsigter om synlighed af sundheds-, finans- og juridisk indh...

Lær hvad YMYL-emner er i AI-søgning, hvordan de påvirker din brands synlighed i ChatGPT, Perplexity og Google AI Overviews, og hvorfor det er vigtigt at overvåg...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.