Multimodal AI-søgning

Lær, hvordan multimodale AI-søgningssystemer behandler tekst, billeder, lyd og video sammen for at levere mere præcise og kontekstuelle relevante resultater end...

Lær hvordan du optimerer tekst, billeder og video til multimodale AI-systemer. Opdag strategier til at forbedre AI-citater og synlighed på tværs af ChatGPT, Gemini og Perplexity.

Multimodal AI repræsenterer et grundlæggende skift i, hvordan kunstige intelligenssystemer behandler og forstår information. I modsætning til unimodale systemer, der kun håndterer tekst, billeder eller video uafhængigt, integrerer multimodal AI flere datatyper samtidig for at skabe en mere omfattende forståelse af kompleks information. Denne tilgang afspejler, hvordan mennesker naturligt opfatter verden—vi adskiller ikke, hvad vi ser, fra hvad vi hører eller læser, men syntetiserer alle input samlet. Markedet for multimodal AI, værdisat til 1,6 milliarder dollars i 2024, oplever eksplosiv vækst med en årlig vækstrate (CAGR) på 32,7 %, hvilket afspejler teknologiens afgørende betydning for virksomheders AI-strategier. Brancheanalytikere forudser, at 40 % af alle generative AI-løsninger vil være multimodale i 2027 ifølge Gartner. Denne overgang er ikke blot inkrementel; det er et paradigmeskifte i, hvordan organisationer udnytter AI for at opnå konkurrencefordel. Sammenfletningen af tekst-, billede- og videobehandlingskapaciteter gør det muligt for AI-systemer at levere indsigter og funktioner, der tidligere var umulige med enkeltmodalitets-tilgange.

Multimodale AI-systemer anvender sofistikerede arkitekturkomponenter til problemfrit at håndtere forskellige datainput. Encodere er specialiserede neurale netværk, der omdanner hver datatype—tekst, billeder og video—til en samlet numerisk repræsentation kaldet embeddings. Disse embeddings indfanger den semantiske betydning af hver modalitet i et delt matematisk rum, hvilket gør det muligt for systemet at sammenligne og relatere information på tværs af forskellige indholdstyper. Fusionsmekanismen kombinerer derefter disse embeddings, enten gennem sammenkædning, addition eller mere avancerede lærte fusionsteknikker, der bestemmer, hvor meget vægt hver modalitet skal bidrage med til det endelige output. Krydsopmærksomhedsmekanismer gør det muligt for modellen dynamisk at fokusere på relevant information på tværs af modaliteter; for eksempel kan systemet, når det analyserer et produktbillede med tilhørende tekst, fokusere på visuelle træk, der svarer til tekstbeskrivelser. Denne flertrinsproces gør det muligt for multimodale systemer at opnå kontekstuel forståelse, som enkeltmodalitets-systemer ikke kan efterligne. Tabellen nedenfor illustrerer kapabilitetsforskellene:

| Kapabilitet | Unimodal AI | Multimodal AI |

|---|---|---|

| Tekstanalyse | Fremragende | Fremragende |

| Billedforståelse | Begrænset/Ingen | Fremragende |

| Videobehandling | Begrænset/Ingen | Fremragende |

| Krydsmodal ræsonnement | Ikke muligt | Fremragende |

| Kontekstintegration | Enkeltkilde | Flere kilder |

| Præcision i praksis | 60-75% | 85-95% |

| Behandlingshastighed | Hurtig | Optimeret hurtig |

Det multimodale AI-landskab domineres af flere stærke platforme, der har sat nye standarder for integreret behandling. GPT-4o fra OpenAI repræsenterer en flagskibs-multimodalmodel, der problemfrit håndterer tekst, billeder og video med indbygget integration på tværs af alle modaliteter. Google Gemini tilbyder multimodale egenskaber i enterprise-klasse med særlig styrke inden for forståelse af komplekse visuelle dokumenter og lang form videoindhold. Claude fra Anthropic leverer sofistikeret multimodalt ræsonnement med vægt på nøjagtighed og nuanceret forståelse på tværs af tekst og billede. Metas ImageBind-teknologi demonstrerer en anden arkitektonisk tilgang og skaber et samlet embedding-rum på tværs af seks modaliteter, herunder tekst, billede, lyd, dybde, termisk og IMU-data. Disse platforme repræsenterer spydspidsen af multimodal teknologi, hvor hver især bringer distinkte arkitektoniske innovationer og optimeringsstrategier. Organisationer, der vælger multimodale platforme, skal ikke kun vurdere kapabilitetsbredde, men også performance-optimering, omkostningseffektivitet og integration med eksisterende arbejdsgange.

Multimodal AI ændrer driftsprocesser i stort set alle brancher og leverer målbare forbedringer i effektivitet, nøjagtighed og kundeoplevelse. Organisationer, der implementerer disse teknologier, rapporterer bemærkelsesværdige resultater:

Sundhedsvæsen: Radiologer bruger multimodal AI til at analysere medicinske billeder kombineret med patientjournaler og kliniske noter, hvilket forbedrer diagnostisk nøjagtighed og reducerer analysetiden med op til 40 %. AI-systemer kan korrelere visuelle fund med tekstbaseret sygehistorie for at identificere mønstre, mennesker kunne overse.

Detailhandel: Mode- og e-handelsvirksomheder udnytter multimodal AI til at matche kundebeskrivelser med visuelle lagre, hvilket muliggør “søg via beskrivelse” og øger konverteringsrater. Produktanbefalinger forbedres væsentligt, når AI forstår både visuelle præferencer og tekstlig feedback.

Produktion: Kvalitetskontrolprocesser accelereres dramatisk med multimodale inspektionssystemer, der kombinerer visuel fejldetektion med sensordata og vedligeholdelseslogs og opnår 100x hurtigere katalogisering af produktionsproblemer sammenlignet med manuelle processer.

Indholdsskabelse: Medievirksomheder bruger multimodal AI til automatisk at generere billedtekster, transskriptioner og metadata til videoindhold, hvor 72 % af mediechefer, der anvender generativ AI, rapporterer positiv ROI på deres investeringer.

Kundeservice: Chatbots med multimodale funktioner kan behandle kundebilleder af problemer sammen med tekstbeskrivelser og levere mere præcise og kontekstuelle supportløsninger.

Landbrug: Landmænd anvender multimodale systemer, der analyserer afgrødebilleder, vejrdata og sensorsignaler fra jorden for at optimere vanding, gødskning og skadedyrsbekæmpelse.

Robotik: Autonome systemer bruger multimodal perception til at navigere i komplekse miljøer og kombinerer visuelle input med lydsignaler og taktil feedback for sikrere og mere intelligent drift.

For at maksimere effektiviteten af multimodale AI-systemer kræver tekstindhold bevidste optimeringsstrategier, der øger maskinlæsbarheden og kontekstforståelsen. Struktureret data markup ved hjælp af schema.org-standarder hjælper AI-systemer med at forstå de semantiske relationer i dit indhold og muliggør mere præcise krydsmodalforbindelser. Implementering af samtalesprog frem for udelukkende formelt sprog gør det lettere for multimodale systemer at forstå hensigt og kontekst, især når tekst behandles sammen med visuelle eller videoelementer. Beskrivende overskrifter og underoverskrifter tjener et dobbelt formål: de guider menneskelige læsere og giver afgørende strukturelle signaler, som hjælper AI-systemer med at organisere og prioritere information. Inkludering af relevante søgeord i naturlige sammenhænge—frem for tvungen søgeordsfyldning—sikrer, at tekstindhold matcher, hvordan multimodale systemer identificerer emnerelationer på tværs af modaliteter. Metadataoptimering, herunder titeltags, metabeskrivelser og strukturerede datafelter, giver eksplicitte signaler om indholdets betydning, som multimodale systemer kan udnytte. Organisationer bør også overveje, hvordan tekst komplementerer visuelt indhold; billedtekster og alt-tekst er ikke kun tilgængelighedsfunktioner—de er kritiske optimeringselementer, der gør det muligt for multimodal AI at forstå forholdet mellem tekstuelle og visuelle oplysninger.

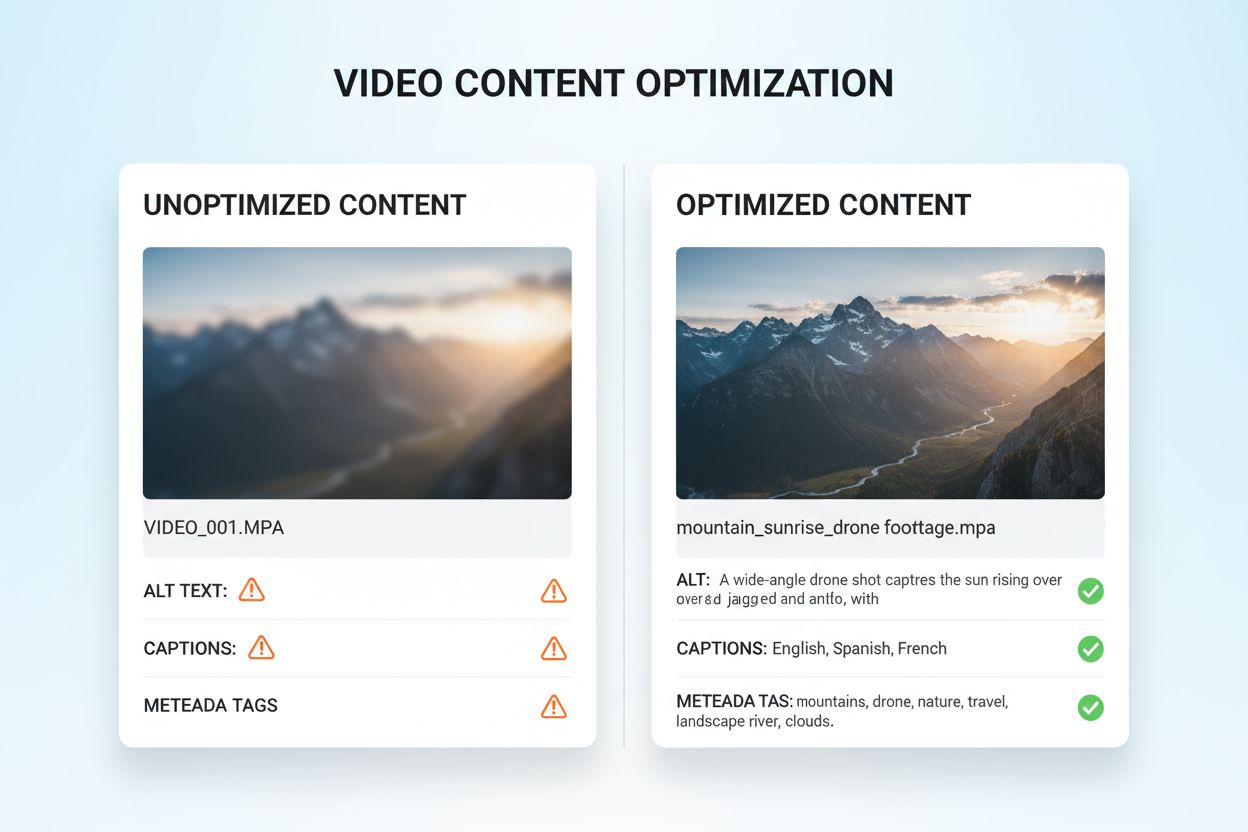

Optimering af visuelle og videoindhold til multimodal AI kræver en omfattende tilgang, der rækker langt ud over traditionel SEO. Beskrivende alt-tekst er grundlæggende; i stedet for generiske beskrivelser bør alt-tekst indfange den semantiske betydning, kontekst og relevante detaljer, der hjælper AI-systemer med at forstå, hvad billedet formidler. Filnavngivningskonventioner er meget vigtige—beskrivende filnavne som “produkt-sammenlignings-diagram-2024.jpg” giver afgørende kontekst, som AI-systemer bruger til at forstå indholdets formål. Billedtekster og transskriptioner til video er essentielle optimeringselementer; de gør det muligt for multimodale systemer at korrelere talt indhold med visuelle elementer, hvilket væsentligt forbedrer forståelsen af komplekst videomateriale. Metadatafelter som titel, beskrivelse og tags skal udfyldes med præcision og nøjagtighed, da disse felter direkte påvirker, hvordan AI-systemer kategoriserer og relaterer visuelt indhold til andre modaliteter. Billedkomprimering og teknisk optimering sikrer, at den visuelle kvalitet forbliver høj nok til AI-analyse, samtidig med at indlæsningstiderne forbliver hurtige. Strukturerede data for visuelle elementer, herunder markup for billeder, videoer og mediegallerier, giver eksplicitte signaler om indholdsrelationer. Organisationer bør også overveje tidsmæssig metadata for videoindhold—markering af nøgleøjeblikke, sceneskift og emneskift hjælper multimodale systemer med at forstå narrativ struktur og udtrække relevante segmenter.

Multimodale AI-systemer anvender to primære arkitektoniske tilgange, hver med sine fordele og kompromiser. Samlede arkitekturer behandler alle modaliteter gennem et enkelt, integreret neuralt netværk, der lærer fælles repræsentationer fra starten af behandlingen. Denne tilgang leverer typisk overlegent krydsmodal ræsonnement, fordi systemet udvikler dyb forståelse af, hvordan modaliteter relaterer sig til hinanden, men det kræver flere beregningsressourcer og længere træningstid. Modulære arkitekturer bevarer separate specialiserede netværk for hver modalitet og kombinerer derefter deres output via fusionsmekanismer. Denne tilgang giver større fleksibilitet, så organisationer kan udskifte individuelle modalitetsprocessorer uden at træne hele systemet, og kræver typisk færre ressourcer. Mixture of Experts (MoE)-modeller repræsenterer en fremvoksende hybridtilgang, hvor forskellige ekspertnetværk specialiserer sig i forskellige modaliteter eller opgaver, og en styringsmekanisme ruter input til de relevante eksperter. Denne arkitektur opnår effektivitetsforbedringer på 30-50 % sammenlignet med tætte samlede modeller, mens den bevarer sammenlignelig nøjagtighed. Valget mellem arkitektoniske tilgange afhænger af specifikke anvendelsesområder: samlede arkitekturer excellerer ved komplekse ræsonnementopgaver, der kræver dyb krydsmodal forståelse, mens modulære tilgange egner sig bedst, hvor fleksibilitet og ressourceeffektivitet er i fokus.

Effektiv implementering af multimodal AI kræver robuste målerammer, der sporer både teknisk performance og forretningsmæssig effekt. Nøglepræstationsindikatorer (KPI’er) bør inkludere nøjagtighedsmålinger for hver modalitet, kvalitet af krydsmodal ræsonnement, behandlingstid og omkostning pr. inferens. Analysetjenester bør opfange, hvordan multimodal AI påvirker forretningsnøgletal: konverteringsrater i detailhandel, diagnostisk nøjagtighed i sundhedsvæsenet, produktionseffektivitet i industrien. Organisationer skal implementere attributionstracking for at forstå, hvilken modalitet der bidrager mest til specifikke resultater—denne indsigt styrer optimeringsindsatsen og ressourceallokeringen. ROI-måling skal tage højde for både direkte besparelser (som de 100x hurtigere katalogiseringer rapporteret af produktionsvirksomheder) og indirekte fordele som forbedret kundetilfredshed eller reducerede fejlprocenter. Overvågningsværktøjer bør spore modelperformance over tid, da datadrift i praksis kan reducere multimodale systemers nøjagtighed, hvis det ikke aktivt håndteres. For organisationer, der benytter AI-genereret indhold og indsigter, bliver citerings- og attributionstracking stadig vigtigere; værktøjer som AmICited.com hjælper med at overvåge, hvordan AI-systemer citerer kilder og attribuerer information, hvilket giver indsigt i AI’s beslutningsprocesser og sikrer efterlevelse af krav til indholdsoprindelse. Regelmæssige performance-audits og optimeringscyklusser sikrer, at multimodale systemer fortsat leverer værdi, efterhånden som forretningsbehov og dataprofiler udvikler sig.

Det multimodale AI-landskab udvikler sig fortsat hurtigt, med flere transformative trends, der ændrer, hvordan organisationer vil udnytte disse teknologier. Stemmeintegration repræsenterer den næste grænse, da systemer i stigende grad kombinerer lydinput med visuelle og tekstuelle data, hvilket muliggør virkelig omfattende forståelse af menneskelig kommunikation og miljøkontekst. Agentisk AI—AI-agenter, der autonomt kan planlægge og udføre flertrinsopgaver—vil udnytte multimodal perception til at navigere i komplekse virkelige scenarier, fra autonome køretøjer til robotprocesautomatisering i virksomheder. Realtidsbehandling rykker hurtigt fremad og muliggør multimodal analyse af live videostrømme, lydfeeds og sensordata på samme tid, hvilket åbner for øjeblikkelig beslutningstagning i tidskritiske applikationer. Effektivitetsforbedringer via teknikker som distillation og kvantisering vil gøre avancerede multimodale muligheder tilgængelige for organisationer med begrænsede ressourcer og dermed demokratisere adgang til avanceret AI. Specialiserede domænemodeller vil opstå, hvor multimodale systemer finjusteres til specifikke brancher som sundhed, jura eller finans og leverer ydeevne, der overgår generalistmodeller. Sammenfletningen af disse trends indikerer, at multimodal AI vil gå fra at være en konkurrencefordel til at være et grundlæggende krav for organisationer, der ønsker at forblive relevante i et stadigt mere AI-drevet landskab. Organisationer, der begynder at optimere deres indhold og processer til multimodal AI i dag, vil stå bedst rustet til at udnytte fremtidens muligheder.

Multimodal AI behandler flere datatyper (tekst, billeder, lyd, video) samtidig, mens traditionel unimodal AI kun håndterer én type. Dette muliggør en rigere kontekstforståelse og mere præcise resultater. Multimodale systemer kan forstå relationer mellem forskellige modaliteter og levere indsigter, som enkeltmodalitets-systemer ikke kan efterligne.

Efterhånden som multimodal AI bliver standarden for generative AI-løsninger (forventet 40 % i 2027), sikrer optimering af dit indhold bedre synlighed i AI-genererede svar. Organisationer, der optimerer på tværs af tekst, billede og video, oplever forbedrede AI-citater, højere synlighed på platforme som ChatGPT og Gemini samt bedre overordnet indholdsperformance.

Følg nøglemålinger, herunder nøjagtighed på tværs af modaliteter, kvalitet af krydsmodal ræsonnement, behandlingstid og forretningspåvirkning (konverteringsrater, engagement osv.). Brug værktøjer som AmICited.com til at overvåge, hvordan AI-systemer citerer dit indhold, og implementér analyser for at forstå, hvilke modaliteter der bidrager mest til dine forretningsresultater.

Vigtige udfordringer inkluderer at sikre ensartet metadata på tværs af modaliteter, opretholde høj kvalitet af alt-tekst og billedtekster, tilpasse tidsdata i videoer og håndtere de nødvendige beregningsressourcer. Organisationer bør også planlægge dataforberedelse (10-20 % af projektbudgettet) og forandringsledelse, når teams tilpasser sig nye optimeringspraksisser.

Sundhedsvæsen, detailhandel, produktion, indholdsskabelse, kundeservice, landbrug og robotteknologi oplever alle betydelige fordele. Sundhedsvæsenet bruger det til diagnostisk nøjagtighed, detailhandel til produktopdagelse, produktion til kvalitetskontrol (100x hurtigere katalogisering), og medievirksomheder rapporterer 72 % ROI på generative AI-investeringer.

AmICited.com overvåger, hvordan AI-systemer som ChatGPT, Perplexity og Google AI Overviews citerer dit indhold på tværs af forskellige modaliteter. Det giver realtidsindsigt i din AI-søgetilstedeværelse og hjælper dig med at forstå, hvordan dit tekst-, billede- og videoindhold bliver refereret i AI-genererede svar.

Samlede arkitekturer behandler alle modaliteter gennem et enkelt integreret netværk og leverer overlegent krydsmodal ræsonnement, men kræver flere beregningsressourcer. Modulære arkitekturer har separate netværk for hver modalitet og tilbyder større fleksibilitet og effektivitet. Mixture of Experts (MoE)-modeller giver en hybrid tilgang med 30-50 % effektivitetsforbedringer.

Optimer tekst med strukturerede data og samtalesprog, tilføj beskrivende alt-tekst og metadata til billeder, inkluder billedtekster og transskriptioner til video og brug ensartede filnavne. Sørg for, at alle modaliteter arbejder sammen for at give fuld kontekst, og implementér schema markup for at hjælpe AI-systemer med at forstå semantiske relationer.

Følg hvordan multimodale AI-systemer citerer dit indhold på tværs af ChatGPT, Perplexity, Google AI Overviews og andre platforme. Få realtidsindsigt i din AI-søgetilstedeværelse.

Lær, hvordan multimodale AI-søgningssystemer behandler tekst, billeder, lyd og video sammen for at levere mere præcise og kontekstuelle relevante resultater end...

Lær hvad multi-modal indhold for AI er, hvordan det fungerer, og hvorfor det er vigtigt. Udforsk eksempler på multi-modale AI-systemer og deres anvendelse på tv...

Bliv ekspert i optimering af multimodal AI-søgning. Lær, hvordan du optimerer billeder og stemmeforespørgsler til AI-drevne søgeresultater, med strategier til G...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.