Multimodal AI-søgning

Lær, hvordan multimodale AI-søgningssystemer behandler tekst, billeder, lyd og video sammen for at levere mere præcise og kontekstuelle relevante resultater end...

Bliv ekspert i optimering af multimodal AI-søgning. Lær, hvordan du optimerer billeder og stemmeforespørgsler til AI-drevne søgeresultater, med strategier til GPT-4o, Gemini og LLMs.

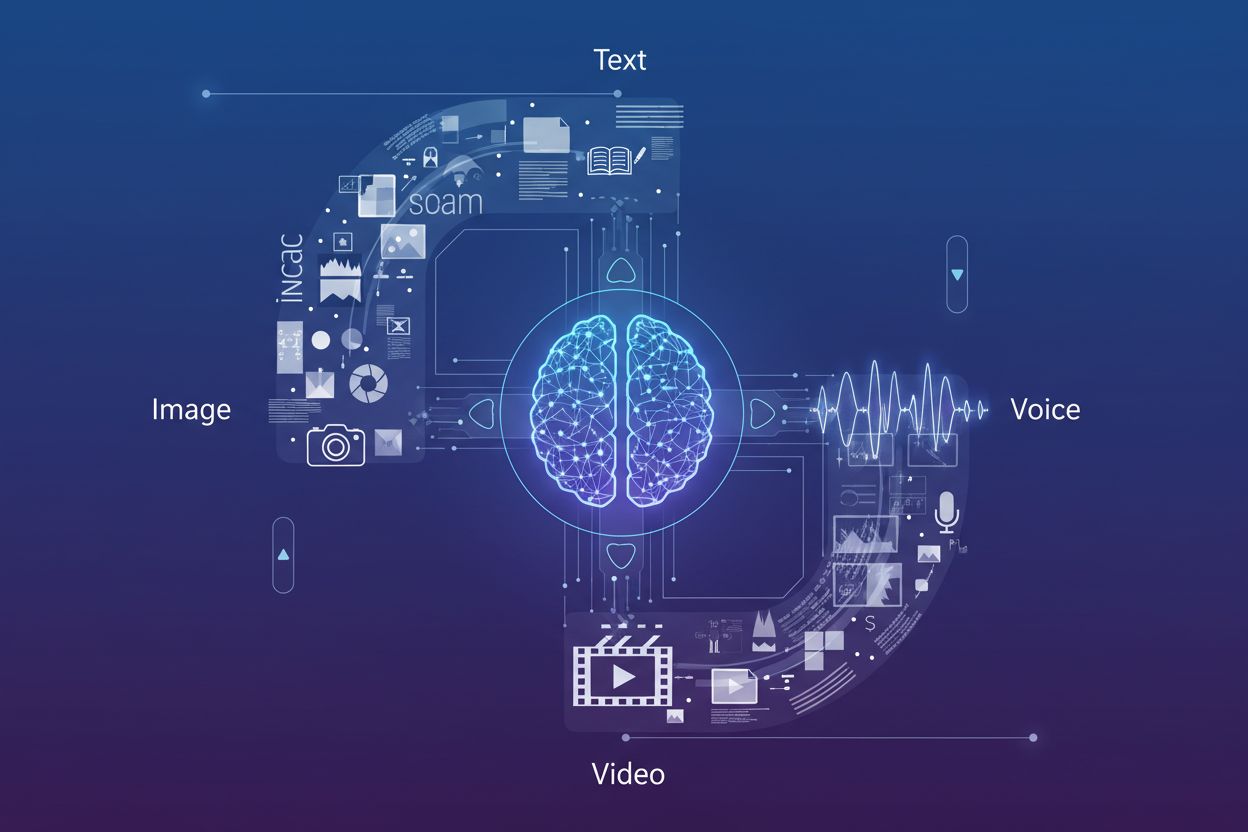

Multimodal AI-søgning repræsenterer et grundlæggende skift i, hvordan søgemaskiner behandler og forstår brugerforespørgsler ved at integrere flere datatyper—tekst, billeder, stemme og video—i én samlet søgeoplevelse. I stedet for at behandle hver modalitet som en separat kanal udnytter moderne søgesystemer nu multimodale AI-modeller, der kan analysere og sammenkæde information på tværs af forskellige formater på samme tid, hvilket muliggør mere kontekstuelle og nøjagtige resultater. Denne udvikling fra søgning med én modalitet (hvor tekstforespørgsler gav tekstresultater) til integrerede multimodale systemer afspejler, hvordan brugere naturligt interagerer med information—ved at kombinere talte spørgsmål med visuelle referencer, uploade billeder for kontekst og forvente resultater, der sammenfatter flere indholdstyper. Betydningen af dette skift kan ikke overvurderes: Det ændrer grundlæggende, hvordan indholdsskabere skal optimere deres digitale tilstedeværelse, og hvordan brands skal overvåge deres synlighed på tværs af søgekanaler. At forstå optimering af multimodal søgning er ikke længere valgfrit for virksomheder, der ønsker at bevare konkurrencemæssig synlighed i AI-drevne søgemiljøer.

Fremkomsten af avancerede multimodale modeller har forvandlet søgefunktionerne, og flere førende platforme tilbyder nu sofistikerede vision-language modeller, der kan behandle og forstå indhold på tværs af flere modaliteter samtidigt. Her er, hvordan de største aktører sammenlignes:

| Modelnavn | Skaber | Nøglefunktioner | Bedst til |

|---|---|---|---|

| GPT-4o | OpenAI | Realtids billedanalyse, stemmebehandling, 320ms svartid | Kompleks visuel ræsonnement, multimodale samtaler |

| Gemini | Integreret søgning, videoforståelse, tværmodal ræsonnement | Søgeintegration, omfattende indholdsanalyse | |

| Claude 3.7 | Anthropic | Dokumentanalyse, billedfortolkning, nuanceret forståelse | Teknisk dokumentation, detaljeret visuel analyse |

| LLaVA | Open-source community | Letvægts vision-language behandling, effektiv inferens | Ressourcebegrænsede miljøer, edge-udrulning |

| ImageBind | Meta | Tværmodal indlejring, audio-visuel forståelse | Multimedieindholdskorrelation, semantisk søgning |

Disse modeller repræsenterer den nyeste AI-søgningsteknologi, hver især optimeret til forskellige anvendelser og implementeringsscenarier. Organisationer skal forstå, hvilke modeller der driver deres målrettede søgeplatforme for effektivt at optimere indhold til opdagelse. Den hurtige udvikling i disse teknologier betyder, at strategier for søgesynlighed skal forblive fleksible og tilpasningsdygtige for at rumme nye funktioner og rangeringsfaktorer.

Optimering til billedsøgning er blevet kritisk, da visuelle søgefunktioner udvider sig dramatisk—Google Lens alene registrerede 10 millioner besøg i maj 2025, hvilket viser den eksplosive vækst i billedbaserede søgeforespørgsler. For at maksimere synligheden i billedsøgning AI-resultater bør indholdsskabere implementere en omfattende optimeringsstrategi:

Denne flerstrengede tilgang sikrer, at billeder ikke kun kan findes via traditionel billedsøgning, men også gennem multimodale AI-systemer, der analyserer visuelt indhold i sammenhæng med omgivende tekst og metadata.

Integrationen af store sprogmodeller i stemmesøgning har fundamentalt ændret, hvordan søgemaskiner fortolker og besvarer talte forespørgsler, langt ud over simpel søgeords-matchning og mod avanceret kontekstuel forståelse. Traditionel stemmesøgning byggede på fonetisk matchning og basal sprogbehandling, men moderne LLM-drevne stemmesøgningssystemer forstår nu hensigt, kontekst, nuancer og samtalemønstre med bemærkelsesværdig nøjagtighed. Dette betyder, at optimering til stemmesøgning ikke længere kan fokusere udelukkende på eksakt søgeords-match; i stedet skal indholdet struktureres, så det adresserer den underliggende hensigt bag samtalebaserede forespørgsler, som brugerne naturligt udtaler. Konsekvenserne er markante: En bruger, der spørger “Hvad er den bedste måde at reparere en utæt køkkenvandhane på?” adskiller sig grundlæggende fra at skrive “reparer utæt vandhane”, og indholdet skal adressere både spørgsmålet og det implicitte behov for trinvis vejledning. Featured snippets er blevet den primære kilde til svar ved stemmesøgning, hvor søgemaskiner foretrækker korte, direkte svar placeret øverst i søgeresultaterne. At forstå denne hierarki—hvor stemmesøgningssvar trækkes fra featured snippets—er afgørende for enhver indholdsstrategi, der retter sig mod stemmeaktiverede enheder og assistenter.

Optimering til samtalebaserede forespørgsler kræver en grundlæggende omstrukturering af, hvordan indhold organiseres og præsenteres, væk fra søgeords-tunge afsnit og hen mod naturlige spørgsmål-svar-formater, der afspejler, hvordan folk faktisk taler. Indholdet bør struktureres med spørgsmål-baserede overskrifter, der direkte adresserer almindelige forespørgsler, brugerne kan stille, efterfulgt af korte, autoritative svar, der giver øjeblikkelig værdi uden nødvendighed for at gennemgå lange forklaringer. Denne tilgang stemmer overens med, hvordan naturlig sprogbehandling udtrækker svar fra webindhold—de leder efter klare spørgsmål-svar-par og direkte udsagn, der kan isoleres og læses op af stemmeassistenter. Implementering af struktureret data markup, der eksplicit markerer spørgsmål og svar, hjælper søgemaskiner med at forstå dit indholds samtaleprægede karakter og øger sandsynligheden for at blive udvalgt til stemmesøgningsresultater. Lange, samtalebaserede sætninger bør naturligt integreres i hele dit indhold i stedet for at blive presset ind på unaturlige steder. Målet er at skabe indhold, der lyder naturligt, når det læses højt, og samtidig er optimeret til AI-systemer, der udtrækker information fra dine sider. Denne balance mellem menneskelig læsbarhed og maskinforståelse er grundstenen i effektiv optimering til stemmesøgning.

Korrekt implementering af schema markup er afgørende for at signalere til multimodale AI-systemer, hvad dit indhold repræsenterer, og hvordan det skal tolkes på tværs af forskellige søgekontekster. De mest effektive strukturerede data-implementeringer til multimodal søgning omfatter FAQ schema (der eksplicit markerer spørgsmål-svar-par til stemmesøgning), HowTo schema (som giver trin-for-trin-vejledninger i maskinlæsbar form) og Local Business schema (som hjælper til lokalbaserede multimodale forespørgsler). Ud over disse hovedtyper sikrer implementering af Article schema, Product schema og Event schema, at dit indhold kategoriseres og forstås korrekt af AI-systemer, der analyserer dine sider. Googles Rich Results Test bør bruges regelmæssigt for at validere, at din schema markup er implementeret korrekt og bliver genkendt af søgesystemerne. Det tekniske SEO-grundlag—ren HTML-struktur, hurtige indlæsningstider, mobilvenlighed og korrekt kanonisering—bliver endnu vigtigere i multimodale søgemiljøer, hvor AI-systemer hurtigt skal analysere og forstå dit indhold på tværs af flere formater. Organisationer bør gennemgå hele deres indholdsbibliotek for muligheder for schema-implementering og prioritere sider med høj trafik og indhold, der passer naturligt til spørgsmål-svar- eller instruktionsformater.

Måling af performance i multimodal søgning kræver et skift i metrics ud over traditionel organisk trafik, med særligt fokus på featured snippet-visninger, engagement i stemmesøgning og konverteringsrater fra multimodale kilder. Google Search Console giver indsigt i featured snippet-performance og viser, hvor ofte dit indhold vises i position nul, og hvilke forespørgsler der udløser dine snippets—data, der direkte korrelerer med synlighed i stemmesøgning. Mobil-engagement bliver stadig vigtigere, da stemmesøgning primært tilgås via mobile enheder og smart speakers, hvilket gør mobilkonverteringsrater og sessionvarighed til kritiske KPI’er for stemmeoptimeret indhold. Analyseplatforme bør konfigureres til at spore trafikkilder fra stemmeassistenter og billedsøgning separat fra traditionel organisk søgning, så du kan forstå, hvilke multimodale kanaler der driver den mest værdifulde trafik. Stemme-søgemetrics bør ikke kun inkludere trafikvolumen, men også konverteringskvalitet, da stemmesøgende ofte har andre hensigter og adfærdsmønstre end tekstsøgende. Overvågning af brandnævnelser i AI Overblik og andre AI-genererede søgeresultater giver indsigt i, hvordan dit brand bliver repræsenteret i disse nye søgeformater. Regelmæssige audits af din featured snippet-performance kombineret med analyse af stemmesøgningstrafik giver et komplet billede af din multimodale søgesynlighed og ROI.

Udviklingen for multimodal søgning peger mod stadig mere avancerede AI-søgningstendenser, der udvisker grænserne mellem søgning, browsing og direkte opgaveløsning, hvor AI Overblik allerede udviser over 10% stigning i brug, efterhånden som brugere tager AI-genererede resuméer til sig. Fremtidige muligheder omfatter agentisk AI, der kan handle på brugernes vegne—booke reservationer, foretage køb eller planlægge aftaler—baseret på multimodale forespørgsler, der kombinerer stemme, billede og kontekstinformation. Personalisering bliver stadig mere detaljeret, hvor AI-systemer forstår ikke kun, hvad brugeren spørger om, men også deres præferencer, placering, købshistorik og adfærdsmønstre for at levere hyperrelevante resultater på tværs af modaliteter. Realtidssøgningsfunktioner udvides, så brugere kan stille spørgsmål om live events, aktuelle forhold eller breaking news med forventning om øjeblikkelige, nøjagtige svar sammenfattet fra flere kilder. Videosøgning vil modnes som en primær modalitet, hvor AI-systemer ikke kun forstår videometadata, men det faktiske indhold i videoer, så brugerne kan søge efter specifikke øjeblikke, begreber eller information i videobiblioteker. Det konkurrenceprægede landskab vil i stigende grad favorisere brands, der er optimeret på tværs af alle modaliteter, da synlighed i én kanal (featured snippets, billedsøgning, stemmeresultater) direkte vil påvirke synligheden i andre via tværmodal rangeringssignaler.

Efterhånden som multimodal søgning bliver det dominerende paradigme, har AI-overvågning udviklet sig fra simpel sporing af søgerangeringer til omfattende brandcitationsovervågning på tværs af billedsøgning, stemmeresultater og AI-genererede overblik. AmICited giver essentiel indsigt i, hvordan dit brand vises i AI Overblik, featured snippets og stemmesøgningsresultater—ikke kun om du rangerer, men også hvordan dit brand bliver repræsenteret og citeret af AI-systemer, der sammenfatter information fra flere kilder. Platformen sporer billedcitater i visuelle søgeresultater og sikrer, at dit visuelle indhold bliver korrekt krediteret og linket tilbage til dit domæne, hvilket beskytter både din SEO-autoritet og brandsynlighed. Stemme-nævnelser overvåges på tværs af smart speakers og stemmeassistenter, så du kan se, hvordan dit indhold bliver læst højt og præsenteret for brugere i stemmebaserede kontekster, hvor traditionelle klik-metrics ikke gælder. Med AI-genererede søgeresultater, der nu udgør en væsentlig del af brugerinteraktioner, er forståelse af din synlighed i disse nye formater afgørende—AmICited leverer det overvågningsgrundlag, der er nødvendigt for at spore, måle og optimere din tilstedeværelse i alle multimodale søgekanaler. For brands, der ønsker at opretholde konkurrencemæssig synlighed i det AI-drevne søgelandskab, er omfattende multimodal overvågning via platforme som AmICited ikke længere valgfrit, men afgørende for at forstå og beskytte din digitale tilstedeværelse.

Multimodal AI-søgning integrerer flere datatyper—tekst, billeder, stemme og video—i en samlet søgeoplevelse. Moderne søgesystemer udnytter nu multimodale AI-modeller, der samtidig kan analysere og sammenkæde information på tværs af forskellige formater, hvilket gør det muligt at levere mere kontekstuelle og nøjagtige resultater end søgning med én modalitet.

Optimer billeder ved at bruge billeder af høj kvalitet og originale billeder med beskrivende filnavne og udførlig alt-tekst. Implementer schema markup, giv kontekstuel omgivende tekst, inkluder flere vinkler af det samme motiv, og komprimer filer for hurtig indlæsning. Disse tiltag sikrer synlighed både i traditionel billedsøgning og i multimodale AI-systemer.

Featured snippets er den primære kilde til svar ved stemmesøgning. Stemmeassistenter trækker korte, direkte svar fra position nul-resultater på søgemaskinens resultatsider. Optimering af indhold til at optræde som featured snippets er afgørende for synlighed og placering i stemmesøgning.

Strukturer indhold med spørgsmål-baserede overskrifter, der direkte besvarer almindelige stemmeforespørgsler, efterfulgt af korte svar. Brug naturligt, samtalebaseret sprog, og implementer struktureret data markup (FAQ schema, HowTo schema) for at hjælpe AI-systemer med at forstå dit indholds samtaleprægede karakter.

De store multimodale modeller inkluderer GPT-4o (OpenAI), Gemini (Google), Claude 3.7 (Anthropic), LLaVA (open source) og ImageBind (Meta). Hver har forskellige funktioner og anvendelsesscenarier. At vide, hvilke modeller der driver dine målrettede søgeplatforme, hjælper dig med at optimere indholdet effektivt.

Følg med i featured snippet-visninger i Google Search Console, overvåg mobil-engagement, analyser stemmesøgningstrafik separat fra traditionel organisk søgning, og mål konverteringsrater fra multimodale kilder. Overvåg brandnævnelser i AI Overblik og følg med i, hvordan dit indhold vises på tværs af forskellige modaliteter.

AmICited overvåger, hvordan dit brand vises i AI Overblik, featured snippets, billedsøgningsresultater og stemmesøgningssvar. Efterhånden som AI-genererede søgeresultater bliver dominerende, er omfattende multimodal overvågning afgørende for at forstå og beskytte din digitale tilstedeværelse på tværs af alle søgekanaler.

Fremtiden byder på stadig mere avancerede AI-systemer med agentiske egenskaber, der kan handle på brugernes vegne, hyper-personaliserede resultater baseret på brugerpræferencer og adfærd, realtidssøgning for live events og modne videosøgningsfunktioner. Brands, der er optimeret på tværs af alle modaliteter, vil have konkurrencemæssige fordele.

Følg med i, hvordan dit brand vises i AI Overblik, billedsøgningsresultater og stemmesøgningssvar. Få realtidsindsigt i din tilstedeværelse i multimodal søgning.

Lær, hvordan multimodale AI-søgningssystemer behandler tekst, billeder, lyd og video sammen for at levere mere præcise og kontekstuelle relevante resultater end...

Lær hvad multi-modal indhold for AI er, hvordan det fungerer, og hvorfor det er vigtigt. Udforsk eksempler på multi-modale AI-systemer og deres anvendelse på tv...

Lær hvordan du optimerer tekst, billeder og video til multimodale AI-systemer. Opdag strategier til at forbedre AI-citater og synlighed på tværs af ChatGPT, Gem...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.