PerplexityBot

Lær om PerplexityBot, Perplexitys webcrawler, der indekserer indhold til dens AI-svarmotor. Forstå hvordan den fungerer, overholdelse af robots.txt, og hvordan ...

Komplet guide til PerplexityBot crawleren – forstå hvordan den fungerer, styr adgang, overvåg citater og optimer for synlighed på Perplexity AI. Lær om stealth crawling-bekymringer og best practice.

PerplexityBot er den officielle webcrawler udviklet af Perplexity AI, designet til at indeksere og vise hjemmesider i Perplexitys AI-drevne søgeresultater. I modsætning til nogle AI-crawlere, der indsamler data til træning af store sprogmodeller, har PerplexityBot et specifikt formål: at opdage, crawle og linke til hjemmesider, der giver relevante svar på brugerforespørgsler. Crawleren opererer med en klart defineret user-agent-streng (Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; PerplexityBot/1.0; +https://perplexity.ai/perplexitybot)) og offentliggør sine IP-adresseområder offentligt, så hjemmesideejere kan identificere og styre crawlertrafikken. At forstå hvad PerplexityBot gør er essentielt for hjemmesideejere, der vil kontrollere deres indholds synlighed i Perplexitys svarmotor og samtidig opretholde gennemsigtighed omkring, hvordan deres sider tilgås.

PerplexityBot fungerer som en almindelig webcrawler, der løbende scanner internettet for at opdage og indeksere websider. Når den støder på en hjemmeside, læser den robots.txt-filen for at forstå, hvilket indhold den må tilgå, og crawler derefter systematisk siderne for at udtrække og indeksere deres indhold. Denne indekserede information indgår i Perplexitys søgealgoritme, som bruger det til at give citerede svar på brugerforespørgsler. Perplexity driver dog faktisk to forskellige crawlere med forskellige formål, hver med sin egen user-agent og adfærdsmønstre. At forstå forskellen mellem disse crawlere er afgørende for hjemmesideejere, der vil finjustere deres adgangspolitikker.

| Funktion | PerplexityBot | Perplexity-User |

|---|---|---|

| Formål | Indekserer hjemmesider til søgeresultater og citater | Henter specifikke sider i realtid, når der besvares brugerforespørgsler |

| User-Agent-streng | PerplexityBot/1.0 | Perplexity-User/1.0 |

| robots.txt-overholdelse | Respekterer robots.txt-disallow-direktiver | Ignorerer generelt robots.txt (brugerinitierede forespørgsler) |

| IP-områder | Offentliggjort på perplexity.com/perplexitybot.json | Offentliggjort på perplexity.com/perplexity-user.json |

| Frekvens | Kontinuerlig, planlagt crawling | On-demand, udløst af brugerforespørgsler |

| Brugssag | Opbygning af søgeindeks | Hentning af aktuel information til svar |

Distinktionen mellem disse to crawlere er vigtig, fordi de kan styres hver for sig gennem robots.txt-regler og firewall-konfigurationer. PerplexityBots regelmæssige indeks-crawling respekterer dine robots.txt-direktiver, mens Perplexity-User kan omgå dem, da den henter indhold som svar på en specifik brugerforespørgsel. Begge crawlere offentliggør deres IP-adresseområder, så hjemmesideejere kan implementere præcise firewall-regler, hvis de vil blokere eller tillade specifik crawlertrafik.

I 2025 offentliggjorde Cloudflare en detaljeret undersøgelse, der afslørede, at Perplexity brugte ikke-deklarerede crawlere til at omgå hjemmesiders restriktioner. Ifølge deres fund, når Perplexitys deklarerede crawlere (PerplexityBot og Perplexity-User) blev blokeret via robots.txt eller firewall-regler, indsatte virksomheden yderligere crawlere, der brugte generiske browser-user-agents (som Chrome på macOS) og roterende IP-adresser fra forskellige ASNs (Autonomous System Numbers) for fortsat at kunne tilgå begrænset indhold. Denne adfærd står i direkte modstrid med webcrawler-standarder beskrevet i RFC 9309, som understreger gennemsigtighed og respekt for hjemmesideejeres præferencer. Undersøgelsen testede dette ved at oprette helt nye domæner med eksplicitte robots.txt-disallow-regler, men Perplexity leverede stadig detaljeret information om deres indhold, hvilket antyder brug af ikke-deklarerede datakilder eller stealth crawling-teknikker.

Dette står i skarp kontrast til, hvordan OpenAI håndterer crawlerstyring. OpenAIs GPTBot identificerer sig tydeligt, respekterer robots.txt-direktiver og stopper med at crawle, når den blokeres – hvilket demonstrerer, at gennemsigtig, etisk crawleradfærd både er mulig og praktisk. Cloudflares fund rejste betydelige bekymringer om, hvorvidt Perplexitys erklærede forpligtelse til at respektere hjemmesidepræferencer er ægte, især for hjemmesideejere, der eksplicit ønsker at forhindre deres indhold i at blive indekseret eller citeret af AI-systemer. For hjemmesideejere, der er bekymrede for indholdskontrol og gennemsigtighed, fremhæver denne kontrovers vigtigheden af at overvåge crawleradfærd og bruge flere lag af beskyttelse (robots.txt, WAF-regler og IP-blokering) for at håndhæve deres præferencer.

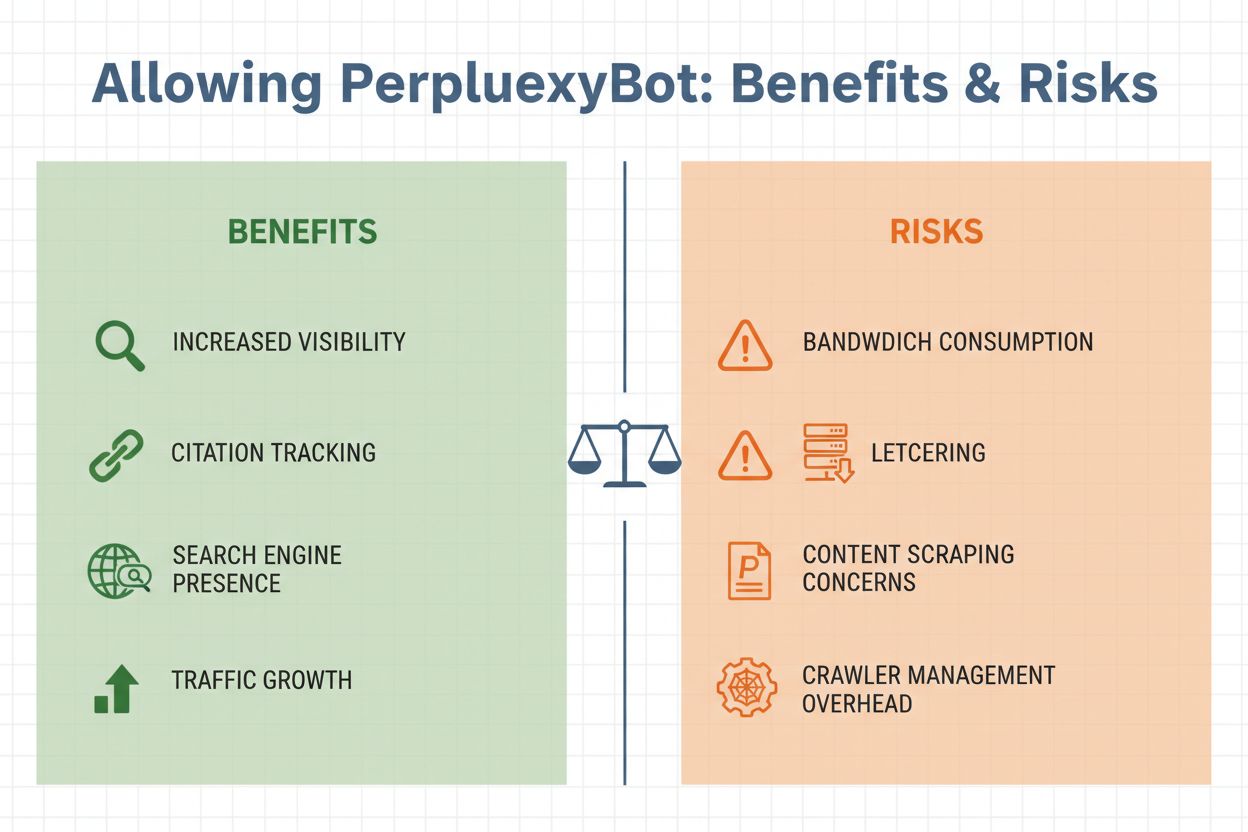

At beslutte, om du vil tillade PerplexityBot på din hjemmeside, kræver at du afvejer flere vigtige faktorer. På den ene side giver det betydelige fordele at tillade crawleren: dit indhold bliver berettiget til at blive citeret i Perplexitys svar, hvilket potentielt kan drive henvisningstrafik fra brugere, der ser dit site nævnt i AI-genererede svar. På den anden side er der legitime bekymringer om båndbreddeforbrug, indholdsskrab og tab af kontrol over, hvordan dine informationer bruges. Beslutningen afhænger i sidste ende af dine forretningsmål, indholdsstrategi og dit komfortniveau med, at AI-systemer får adgang til dine data.

Vigtige overvejelser ved tilladelse af PerplexityBot:

Styring af PerplexityBots adgang er ligetil og kan udføres på flere måder afhængigt af din tekniske infrastruktur og specifikke krav. Den mest almindelige metode er at bruge din robots.txt-fil, som giver klare instruktioner til alle velopdragne crawlere om, hvilket indhold de må tilgå.

For at tillade PerplexityBot i din robots.txt-fil:

User-agent: PerplexityBot

Allow: /

For at blokere PerplexityBot i din robots.txt-fil:

User-agent: PerplexityBot

Disallow: /

Hvis du vil blokere PerplexityBot fra bestemte mapper, men tillade adgang til andre, kan du bruge mere detaljerede regler:

User-agent: PerplexityBot

Disallow: /admin/

Disallow: /private/

Allow: /public/

For mere robust beskyttelse, især hvis du er bekymret for stealth crawling, implementer firewallregler på Web Application Firewall (WAF)-niveau. Cloudflare WAF-brugere kan oprette brugerdefinerede regler for at blokere PerplexityBot ved at kombinere user-agent- og IP-adresse-matching:

AWS WAF-brugere bør oprette IP-sæt med de offentliggjorte PerplexityBot IP-områder fra https://www.perplexity.com/perplexitybot.json og derefter oprette regler, der matcher både IP-sættet og PerplexityBot user-agent-strengen. Brug altid de officielle IP-områder offentliggjort af Perplexity, da de opdateres regelmæssigt og er den autoritative kilde til legitim crawlertrafik.

Når du har besluttet din PerplexityBot-politik, hjælper overvågning af faktisk crawleraktivitet dig med at bekræfte, at dine regler virker korrekt og forstå påvirkningen på din infrastruktur. Du kan identificere PerplexityBot-forespørgsler i dine serverlogs ved at lede efter den karakteristiske user-agent-streng: PerplexityBot/1.0 eller den generiske browser-user-agent, hvis stealth crawling forekommer. De fleste webanalyseplatforme og værktøjer til serverloganalyse gør det muligt at filtrere trafik efter user-agent, så du nemt kan isolere PerplexityBot-forespørgsler og analysere deres mønstre.

Nøgletal at overvåge inkluderer hyppigheden af crawlerbesøg, hvilke sider der tilgås, og det båndbreddeforbrug der finder sted. Hvis du bemærker usædvanlige mønstre – såsom hurtig crawling af følsomme sider eller forespørgsler fra IP-adresser, der ikke er i Perplexitys offentliggjorte områder – kan det indikere stealth crawling-aktivitet. Ud over grundlæggende trafikovervågning giver brug af specialiserede værktøjer som AmICited.com dybere indsigt i, hvordan dit indhold faktisk citeres på tværs af AI-platforme, herunder Perplexity. AmICited sporer omtaler af dit brand og indhold i AI-genererede svar, så du kan måle den reelle effekt af at tillade PerplexityBot og forstå, hvilke af dine sider der er mest værdifulde for AI-systemer. Disse data hjælper dig med at træffe informerede beslutninger om fremtidig crawlerstyring og indholdsoptimeringsstrategier.

Effektiv styring af PerplexityBot kræver en balanceret tilgang, der beskytter dine interesser og anerkender værdien af AI-drevet synlighed. Først, etabler en klar politik baseret på dine forretningsmål: beslut, om den potentielle trafik og brandeksponering fra Perplexity-citater opvejer dine bekymringer om båndbredde og indholdskontrol. Dokumentér denne beslutning i din robots.txt-fil og kommuniker den til dit team, så alle forstår din crawlerstyringsstrategi.

For det andet, implementer lagdelt beskyttelse, hvis du vælger at blokere PerplexityBot. Stol ikke udelukkende på robots.txt, da stealth crawling-kontroversen viser, at nogle crawlere kan ignorere disse direktiver. Kombinér robots.txt-regler med WAF-regler og IP-blokering for forsvar i dybden. For det tredje, hold dig opdateret om crawleradfærd ved løbende at overvåge dine logs og følge branchens diskussioner om AI-crawleretik og gennemsigtighed. Landskabet udvikler sig hurtigt, og nye crawlere eller taktikker kan opstå, som kræver justeringer af politikken.

Endelig, brug overvågningsværktøjer strategisk for at måle den faktiske effekt af dine beslutninger. Værktøjer som AmICited.com giver synlighed i, hvordan AI-systemer citerer dit indhold, så du kan forstå, om tilladelse til PerplexityBot giver de forventede synlighedsfordele. Hvis du tillader crawleren, hjælper disse data dig med at optimere dit indhold for AI-citation. Hvis du blokerer den, bekræfter overvågning, at dine blokeringer er effektive, og at dit indhold ikke optræder i Perplexity-resultater ad andre veje.

PerplexityBot opererer i et landskab med mange AI-crawlere, der hver har forskellige formål og gennemsigtighedsstandarder. GPTBot, drevet af OpenAI, er bredt anerkendt som et forbillede for gennemsigtig crawleradfærd – den identificerer sig tydeligt, respekterer robots.txt-direktiver og stopper, når den blokeres. Googles crawlere til AI Overviews og andre AI-funktioner opretholder tilsvarende gennemsigtighed og respekterer hjemmesidepræferencer. I kontrast hertil udgør Perplexitys stealth crawling-adfærd, som dokumenteret af Cloudflare, et bekymrende brud med disse standarder.

Den vigtigste forskel ligger i gennemsigtighed og respekt for hjemmesideejeres præferencer. Velopdragne crawlere som GPTBot gør det let for hjemmesideejere at forstå, hvad de foretager sig, og giver klare muligheder for kontrol. Perplexitys brug af ikke-deklarerede crawlere og IP-rotation for at omgå restriktioner underminerer denne tillid. For hjemmesideejere betyder det, at du bør være mere varsom over for Perplexitys erklærede politikker og implementere stærkere tekniske kontroller, hvis du vil sikre, at dine præferencer faktisk respekteres. Efterhånden som AI-crawler-økosystemet modnes, kan du forvente stigende pres på virksomheder som Perplexity for at indføre mere gennemsigtige, etiske praksisser, der er i overensstemmelse med etablerede webstandarder og respekterer hjemmesideejeres autonomi.

PerplexityBot er Perplexity AI's officielle webcrawler designet til at indeksere hjemmesider og vise dem i Perplexitys AI-drevne søgeresultater. I modsætning til nogle AI-crawlere, der indsamler data til træning, opdager PerplexityBot specifikt og linker til hjemmesider, der giver relevante svar på brugernes forespørgsler. Den opererer gennemsigtigt med en offentliggjort user-agent-streng og IP-adresseområder.

Nej. Ifølge Perplexitys officielle dokumentation er PerplexityBot designet til at vise og linke til hjemmesider i søgeresultater på Perplexity. Den bruges ikke til at crawle indhold til AI-fundamentmodeller eller træningsformål. Crawlerens eneste funktion er at indeksere indhold til inkludering i Perplexitys svarmotor.

Du kan blokere PerplexityBot via din robots.txt-fil ved at tilføje 'User-agent: PerplexityBot' efterfulgt af 'Disallow: /' for at forhindre al adgang. For stærkere beskyttelse kan du implementere WAF-regler på Cloudflare eller AWS WAF, der blokerer forespørgsler, der matcher PerplexityBot user-agent og IP-områder. Vær dog opmærksom på, at stealth crawling kan omgå disse kontroller.

Perplexity offentliggør officielle IP-adresseområder for PerplexityBot på https://www.perplexity.com/perplexitybot.json og for Perplexity-User på https://www.perplexity.com/perplexity-user.json. Disse områder opdateres regelmæssigt og bør være den autoritative kilde til dine firewall- og WAF-konfigurationer. Brug altid de officielle endpoints i stedet for at stole på forældede IP-lister.

PerplexityBot hævder at respektere robots.txt-direktiver, men Cloudflares undersøgelse i 2025 fandt beviser for stealth crawling ved brug af ikke-deklarerede user-agents og roterende IP-adresser for at omgå robots.txt-begrænsninger. Mens den deklarerede PerplexityBot crawler burde overholde dine robots.txt-regler, anbefales det at implementere yderligere WAF-beskyttelse, hvis du vil sikre, at dine præferencer håndhæves.

Båndbreddeforbruget varierer afhængigt af din sides størrelse og indholdsmængde. PerplexityBot udfører kontinuerlig, planlagt crawling på samme måde som Googles crawler. Hjemmesider med meget trafik kan opleve mærkbart båndbreddeforbrug. Du kan overvåge det faktiske forbrug ved at filtrere dine serverlogs for PerplexityBot-forespørgsler og analysere datamængden for at afgøre, om det påvirker din infrastruktur.

Ja. Du kan manuelt søge på Perplexity med forespørgsler relateret til dit indhold for at se, om din side citeres i svarene. For mere omfattende overvågning kan du bruge værktøjer som AmICited.com, der sporer hvordan dit brand og indhold vises på tværs af AI-platforme, herunder Perplexity, og giver realtidsindsigt i din AI-synlighed og citatmønstre.

PerplexityBot er den planlagte crawler, der kontinuerligt indekserer hjemmesider til Perplexitys søgeindeks. Perplexity-User aktiveres on-demand, når brugere stiller spørgsmål, og Perplexity skal hente specifikke sider for realtidsinformation. PerplexityBot respekterer robots.txt, mens Perplexity-User generelt ignorerer det, da den responderer på brugerforespørgsler. Begge har separate user-agent-strenge og IP-områder.

Følg hvordan Perplexity og andre AI-platforme citerer dit brand. Få realtidsindsigt i din AI-synlighed og optimer din indholdsstrategi for maksimal effekt på generative søgemaskiner.

Lær om PerplexityBot, Perplexitys webcrawler, der indekserer indhold til dens AI-svarmotor. Forstå hvordan den fungerer, overholdelse af robots.txt, og hvordan ...

Få indsigt i hvordan AI-crawlere som GPTBot og ClaudeBot fungerer, hvordan de adskiller sig fra traditionelle søgemaskinecrawlere, og hvordan du optimerer dit s...

Lær hvad GPTBot er, hvordan den fungerer, og om du bør blokere den fra dit websted. Forstå effekten på SEO, serverbelastning og brandets synlighed i AI-søgeresu...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.