JavaScript-rendering til AI

Lær hvordan JavaScript-rendering påvirker AI-synlighed. Opdag hvorfor AI-crawlere ikke kan afvikle JavaScript, hvilket indhold der skjules, og hvordan prerender...

Lær hvordan prerendering gør JavaScript-indhold synligt for AI-crawlere som ChatGPT, Claude og Perplexity. Opdag de bedste tekniske løsninger til AI-søgeoptimering og forbedr din synlighed i AI-drevne søgeresultater.

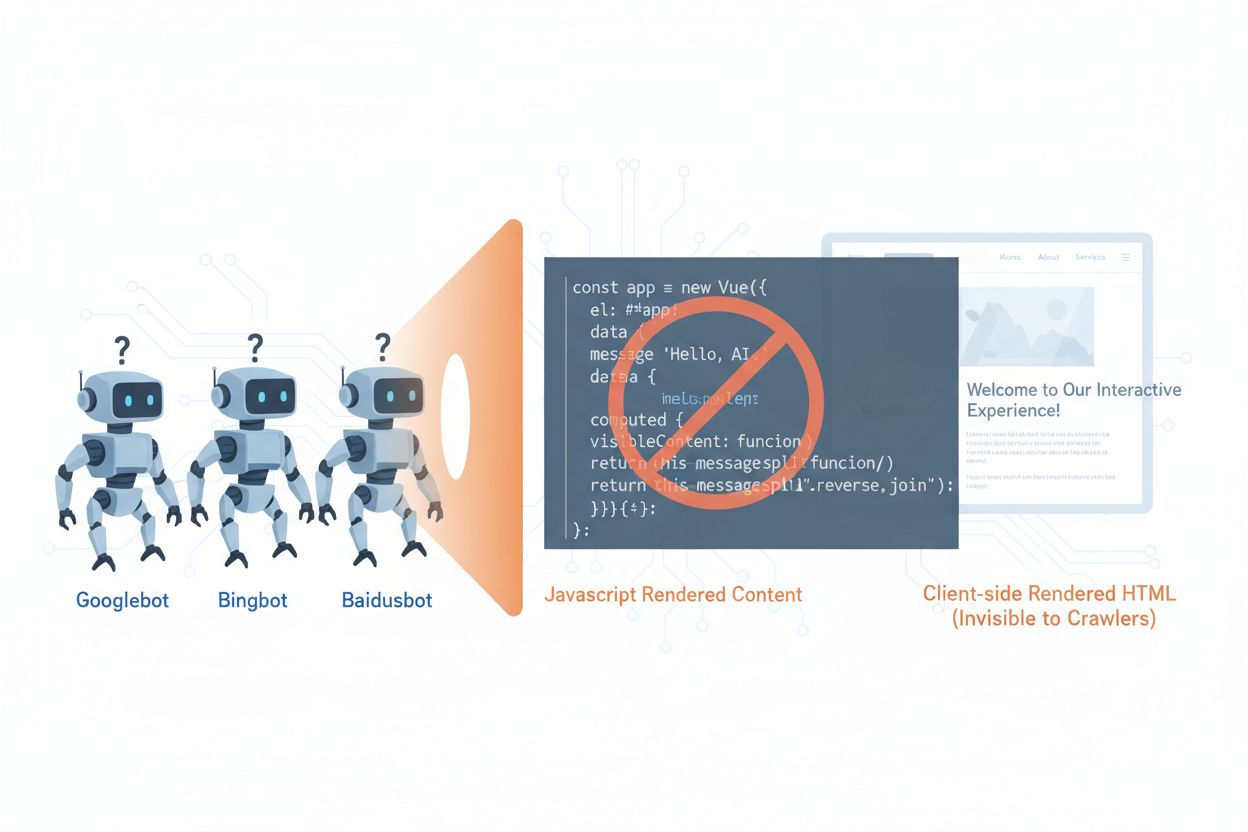

AI-crawlere som GPTBot, ClaudeBot og PerplexityBot har fundamentalt ændret måden, indhold opdages og indekseres på nettet, men de står over for en kritisk begrænsning: de kan ikke eksekvere JavaScript. Det betyder, at alt indhold, der renderes dynamisk via JavaScript—som driver moderne single-page applikationer (SPA’er), dynamiske produktsider og interaktive dashboards—er fuldstændig usynligt for disse crawlere. Ifølge nyere data udgør AI-crawlere nu cirka 28 % af Googlebots trafik, hvilket gør dem til en betydelig del af dit websites crawl-budget og en afgørende faktor for indholdstilgængelighed. Når en AI-crawler anmoder om en side, modtager den den indledende HTML-skabelon uden det renderede indhold og ser i praksis en tom eller ufuldstændig version af dit site. Dette skaber et paradoks: dit indhold er perfekt synligt for menneskelige brugere med JavaScript-aktiverede browsere, men usynligt for de AI-systemer, der i stigende grad påvirker indholdsopdagelse, opsummering og placering i AI-drevne søgemaskiner og applikationer.

De tekniske årsager bag AI-crawleres JavaScript-begrænsninger stammer fra grundlæggende arkitektoniske forskelle på, hvordan browsere og crawlere behandler webindhold. Browsere har en fuld JavaScript-motor, der eksekverer kode, manipulerer DOM (Document Object Model) og gengiver det endelige visuelle output, mens AI-crawlere typisk opererer med minimale eller ingen JavaScript-evner på grund af ressourcebegrænsninger og sikkerhedshensyn. Asynkron indlæsning—hvor indhold hentes fra API’er efter den indledende sideindlæsning—udgør en anden stor udfordring, da crawlere kun modtager den indledende HTML, før indholdet ankommer. Single-page applikationer (SPA’er) forstærker dette problem ved udelukkende at basere sig på client-side routing og rendering, så crawlere kun ser en JavaScript-bundle. Her er, hvordan forskellige renderingsmetoder sammenlignes i forhold til AI-crawler-synlighed:

| Renderingsmetode | Hvordan det fungerer | AI-crawler-synlighed | Ydeevne | Omkostning |

|---|---|---|---|---|

| CSR (Client-Side Rendering) | Browseren eksekverer JavaScript for at gengive indhold | ❌ Dårlig | Hurtig for brugere | Lav infrastruktur |

| SSR (Server-Side Rendering) | Serveren gengiver HTML ved hver forespørgsel | ✅ Fremragende | Langsommere første indlæsning | Høj infrastruktur |

| SSG (Static Site Generation) | Indhold forbygges ved buildtid | ✅ Fremragende | Hurtigst | Medium (buildtid) |

| Prerendering | Statisk HTML caches efter behov | ✅ Fremragende | Hurtig | Medium (balanceret) |

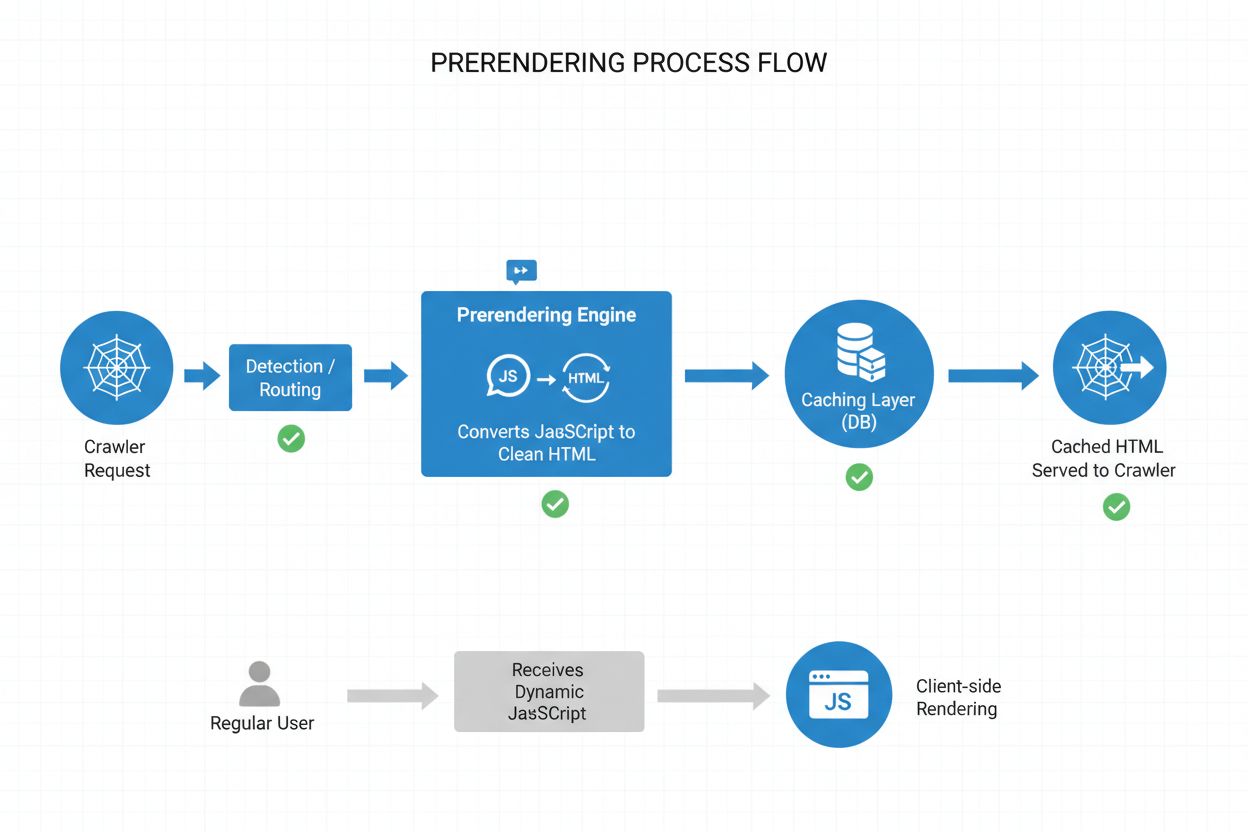

Prerendering tilbyder et elegant kompromis mellem de ressourcekrævende krav ved server-side rendering og begrænsningerne ved buildtid i static site generation. I stedet for at gengive indhold ved hver forespørgsel (SSR) eller ved buildtid (SSG), genererer prerendering statiske HTML-snapshots efter behov, når en crawler eller bot anmoder om en side, og cacher derefter denne gengivne version til senere forespørgsler. Dette betyder, at AI-crawlere modtager fuldt gengivet, statisk HTML med alt det indhold, der normalt ville blive genereret af JavaScript, mens almindelige brugere fortsat får den dynamiske, interaktive version af dit site uden ændringer i deres oplevelse. Prerendering er særligt omkostningseffektivt, fordi det kun gengiver sider, som faktisk anmodes af crawlere, hvilket undgår overhead ved at prerenderere hele dit site eller vedligeholde dyr server-side rendering-infrastruktur. Vedligeholdelsesbyrden er minimal—din applikationskode forbliver uændret, og prerendering-laget fungerer gennemsigtigt i baggrunden, hvilket gør det til en ideel løsning for teams, der ønsker AI-crawler-tilgængelighed uden arkitektoniske ændringer.

Prerendering-processen fungerer gennem et sofistikeret men enkelt workflow, der sikrer, at AI-crawlere får optimeret indhold, mens brugerne ikke oplever nogen forstyrrelse. Når en forespørgsel ankommer til din server, detekteres brugeragenten først for at identificere, om det er en AI-crawler (GPTBot, ClaudeBot, PerplexityBot) eller en almindelig browser. Hvis en AI-crawler detekteres, rutes forespørgslen til prerendering-motoren, som starter en headless browser, eksekverer al JavaScript, venter på asynkront indhold og genererer et komplet statisk HTML-snapshot af den renderede side. Denne HTML caches (typisk i 24-48 timer) og serveres direkte til crawleren, uden om din applikation og med reduceret serverbelastning. Almindelige browser-forespørgsler omgår helt prerendering-laget og modtager din dynamiske applikation som normalt, så brugerne får den fulde interaktive oplevelse med realtidsopdateringer og dynamisk funktionalitet. Hele processen er gennemsigtig—crawlere ser fuldt gengivet indhold, brugerne ser din applikation uændret, og din infrastruktur forbliver effektiv, fordi prerendering kun aktiveres for bot-trafik.

Selvom både prerendering og server-side rendering (SSR) løser JavaScript-synlighedsproblemet, adskiller de sig markant i implementering, omkostning og skalerbarhed. SSR gengiver indhold ved hver enkelt forespørgsel, hvilket betyder, at din server skal starte en JavaScript-runtime, køre hele din applikationskode og generere HTML for hver besøgende—en proces, der bliver ekstremt dyr i stor skala og kan øge Time to First Byte (TTFB) for alle brugere. Prerendering derimod cacher renderede sider og regenererer dem kun, når indhold ændres eller cachen udløber, hvilket drastisk reducerer serverbelastning og forbedrer svartider for både crawlere og brugere. SSR giver mening for meget personaliseret indhold eller ofte skiftende data, hvor hver bruger skal have unik HTML, mens prerendering er bedst for relativt statisk indhold eller indhold, der sjældent ændrer sig—produktsider, blogindlæg, dokumentation og markedsføringsindhold. Mange avancerede implementeringer anvender en hybrid tilgang: prerendering til AI-crawlere og statisk indhold, SSR til personaliserede brugeroplevelser og client-side rendering til interaktive funktioner. Denne lagdelte strategi giver det bedste fra alle verdener—fremragende AI-crawler-tilgængelighed, hurtig ydeevne for brugere og rimelige infrastrukturudgifter.

Strukturerede data i JSON-LD-format er afgørende for at hjælpe AI-crawlere med at forstå betydningen og konteksten af dit indhold, men de fleste implementeringer tager ikke højde for AI-crawler-begrænsninger. Når strukturerede data injiceres via JavaScript—en almindelig praksis med Google Tag Manager og lignende tag management-systemer—ser AI-crawlere dem aldrig, fordi de ikke eksekverer den JavaScript, der opretter disse datastrukturer. Dette betyder, at rich snippets, produktinformation, virksomhedsdetaljer og anden semantisk markup forbliver usynlig for AI-systemer, selvom de er fuldt synlige for traditionelle søgemaskiner, der har udviklet sig til at håndtere JavaScript. Løsningen er enkel: sørg for, at alle kritiske strukturerede data er til stede i den server-renderede HTML, ikke indsat via JavaScript. Det kan betyde at flytte JSON-LD-blokke fra din tag manager til din applikations server-side-skabelon eller bruge prerendering til at fange JavaScript-injicerede strukturerede data og levere dem som statisk HTML til crawlere. AI-crawlere er stærkt afhængige af strukturerede data for at udtrække fakta, relationer og entitetsinformation, så server-side implementering af strukturerede data er afgørende for AI-drevne søgemaskiner og integration i knowledge graphs.

Implementering af prerendering kræver en strategisk tilgang, der balancerer dækning, omkostninger og vedligeholdelse. Følg disse trin for at komme i gang:

Identificer JavaScript-tunge sider: Gennemgå dit site for at finde sider, hvor kritisk indhold renderes via JavaScript—typisk SPA’er, dynamiske produktsider og interaktive dashboards. Brug værktøjer som Lighthouse eller manuel inspektion til at identificere sider, hvor den indledende HTML adskiller sig væsentligt fra den renderede version.

Vælg en prerendering-tjeneste: Vælg en prerendering-udbyder som Prerender.io, der håndterer headless browser-rendering, caching og crawler-detektion. Vurder ud fra pris, cache-varighed, API-pålidelighed og understøttelse til dit teknologiske setup.

Konfigurer brugeragent-detektion: Sæt din server eller CDN op til at detektere AI-crawler-brugeragenter (GPTBot, ClaudeBot, PerplexityBot, Bingbot, Googlebot) og rute dem til prerendering-tjenesten, mens almindelige browsere fortsætter normalt.

Test og valider: Brug værktøjer som curl med brugerdefinerede brugeragenter for at verificere, at crawlere modtager fuldt gengivet HTML. Test med faktiske AI-crawler-brugeragenter for at sikre, at indholdet er synligt og strukturerede data er til stede.

Overvåg resultater: Opsæt logning og analyse for at spore prerendering-effektivitet, cache-hit rates og eventuelle rendering-fejl. Overvåg dit prerendering-dashboard for ydeevnemålinger og fejl.

Effektiv overvågning er afgørende for at sikre, at din prerendering fortsat fungerer korrekt, og at AI-crawlere kan få adgang til dit indhold. Loganalyse er dit primære værktøj—undersøg dine serverlogs for at identificere forespørgsler fra AI-crawler-brugeragenter, følg hvilke sider de besøger, og identificer eventuelle mønstre i crawl-adfærd eller fejl. De fleste prerendering-tjenester som Prerender.io tilbyder dashboards, der viser cache-hit rates, rendering-succes/fejl-målinger og ydeevnestatistik, så du kan se, hvor effektivt dit prerenderede indhold leveres. Nøglemålinger at følge inkluderer cache hit rate (procent af forespørgsler leveret fra cache), rendering success rate (procent af sider, der gengives uden fejl), gennemsnitlig renderingstid og crawler-trafikmængde. Opsæt advarsler for rendering-fejl eller usædvanlige crawl-mønstre, der kan indikere problemer med dit sites JavaScript eller dynamiske indhold. Ved at sammenholde prerendering-målinger med din AI-søgemaskinetrafik og indholdssynlighed kan du måle effekten af din prerendering og finde optimeringsmuligheder.

Succesfuld prerendering kræver opmærksomhed på detaljer og kontinuerlig vedligeholdelse. Undgå disse typiske faldgruber:

Prerender ikke 404-sider: Konfigurer din prerendering-tjeneste til at springe sider over, der returnerer 404-statuskoder, da caching af fejlsider spilder ressourcer og forvirrer crawlere om din sites struktur.

Sikre indholdets friskhed: Sæt passende cache-udløbstider afhængigt af, hvor ofte dit indhold ændres. Sider med meget trafik og hyppige opdateringer kan have brug for 12–24 timers cache-vinduer, mens statisk indhold kan have længere varighed.

Overvåg løbende: Lad være med at sætte prerendering op og så glemme det igen. Tjek jævnligt, at sider gengives korrekt, strukturerede data er til stede, og crawlere modtager det forventede indhold.

Undgå cloaking: Servér aldrig forskelligt indhold til crawlere end til brugere—det overtræder søgemaskinernes retningslinjer og underminerer tilliden. Prerendering bør vise crawlere det samme indhold, som brugerne ser, blot i statisk form.

Test med faktiske crawlere: Brug rigtige AI-crawler-brugeragenter i dine tests, ikke bare generiske bot-identifikatorer. Forskellige crawlere kan have forskellige renderingskrav eller begrænsninger.

Hold indhold opdateret: Hvis dit prerenderede indhold bliver forældet, vil crawlere indeksere forældet information. Implementer cache-invalideringsstrategier, der opdaterer prerenderede sider, når indhold ændres.

Vigtigheden af AI-crawler-optimering vil kun vokse, efterhånden som disse systemer bliver stadig mere centrale for indholdsopdagelse og videnudtrækning. Mens nuværende AI-crawlere har begrænsede JavaScript-evner, antyder nye teknologier som Comet og Atlas-browsere, at fremtidige crawlere kan få mere avancerede renderingsmuligheder, selvom prerendering fortsat vil være værdifuldt af hensyn til ydeevne og pålidelighed. Ved at implementere prerendering nu løser du ikke kun det nuværende AI-crawler-problem—du fremtidssikrer dit indhold mod udviklende crawler-evner og sikrer, at dit site forbliver tilgængeligt, uanset hvordan AI-systemer udvikler sig. Sammenfaldet mellem traditionel SEO og AI-crawler-optimering betyder, at du skal tænke helhedsorienteret: optimer både for mennesker og AI-systemer, sørg for, at dit indhold er tilgængeligt i flere formater, og bevar fleksibilitet til at tilpasse dig, når landskabet ændrer sig. Prerendering repræsenterer en pragmatisk, skalerbar løsning, der bygger bro mellem moderne JavaScript-tunge applikationer og tilgængelighedskravene fra AI-drevne søge- og opdagelsessystemer og gør det til en uundværlig del af enhver fremtidsorienteret SEO- og indholdsstrategi.

Prerendering genererer statiske HTML-snapshots efter behov og cacher dem, mens server-side rendering (SSR) gengiver indhold ved hver eneste forespørgsel. Prerendering er mere omkostningseffektiv og skalerbar til de fleste brugsscenarier, mens SSR er bedre til meget personaliseret eller hyppigt ændrende indhold, der kræver unik HTML for hver bruger.

Nej, prerendering påvirker kun, hvordan crawlere ser dit indhold. Almindelige brugere modtager fortsat din dynamiske, interaktive JavaScript-applikation præcis som før. Prerendering fungerer gennemsigtigt i baggrunden og har ingen indflydelse på brugerens funktionalitet eller ydeevne.

Cache-udløbstider afhænger af, hvor ofte dit indhold ændrer sig. Sider med meget trafik og hyppige opdateringer kan have brug for 12-24 timers cache-vinduer, mens statisk indhold kan have længere varigheder. De fleste prerendering-tjenester giver dig mulighed for at konfigurere cache-tider pr. side eller skabelon.

Ja, prerendering fungerer godt med dynamisk indhold. Du kan sætte kortere cache-udløbstider for sider, der ændres ofte, eller implementere cache-invalideringsstrategier, der opdaterer prerenderede sider, når indholdet ændres. Dette sikrer, at crawlere altid ser relativt frisk indhold.

De vigtigste AI-crawlere at optimere til er GPTBot (ChatGPT), ClaudeBot (Claude) og PerplexityBot (Perplexity). Du bør også fortsætte med at optimere til traditionelle crawlere som Googlebot og Bingbot. De fleste prerendering-tjenester understøtter konfiguration for alle større AI- og søgecrawlere.

Hvis du allerede bruger SSR, har du god tilgængelighed for AI-crawlere. Men prerendering kan stadig give fordele ved at reducere serverbelastning, forbedre ydeevne og tilbyde et cachelag, der gør din infrastruktur mere effektiv og skalerbar.

Overvåg dit prerendering-tjenestes dashboard for cache-hit rates, rendering-succes-målinger og ydeevnestatistik. Tjek dine serverlogs for AI-crawler-forespørgsler og verificer, at de modtager fuldt gengivet HTML. Følg udviklingen i din AI-søgesynlighed og indholdscitater over tid.

Omkostninger til prerendering varierer efter tjeneste og brugsmængde. De fleste udbydere tilbyder trinvist prissatte abonnementer baseret på antal sider, der renderes pr. måned. Omkostningerne er typisk langt lavere end at vedligeholde server-side rendering-infrastruktur, hvilket gør prerendering til en omkostningseffektiv løsning for de fleste websites.

Følg med i, hvordan AI-platforme som ChatGPT, Claude og Perplexity refererer til dit indhold med AmICited. Få indsigt i realtid om din AI-søgesynlighed og optimer din indholdsstrategi.

Lær hvordan JavaScript-rendering påvirker AI-synlighed. Opdag hvorfor AI-crawlere ikke kan afvikle JavaScript, hvilket indhold der skjules, og hvordan prerender...

Lær hvordan JavaScript påvirker AI-crawleres synlighed. Opdag hvorfor AI-bots ikke kan gengive JavaScript, hvilket indhold der bliver skjult, og hvordan du opti...

Lær hvordan du implementerer uendelig scroll, mens du bevarer gennemsøgelighed for AI-crawlere, ChatGPT, Perplexity og traditionelle søgemaskiner. Opdag paginer...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.