Påvirker sidehastighed AI-søgesynlighed? Komplet guide til AEO-ydeevne

Lær hvordan sidehastighed påvirker din synlighed i AI-søgemaskiner som ChatGPT, Perplexity og Gemini. Opdag optimeringsstrategier og vigtige målepunkter for AI ...

Opdag hvordan sidehastighed direkte påvirker AI-synlighed og citater i ChatGPT, Gemini og Perplexity. Lær om 2,5-sekunders grænsen og optimeringsstrategier for AI-crawlere.

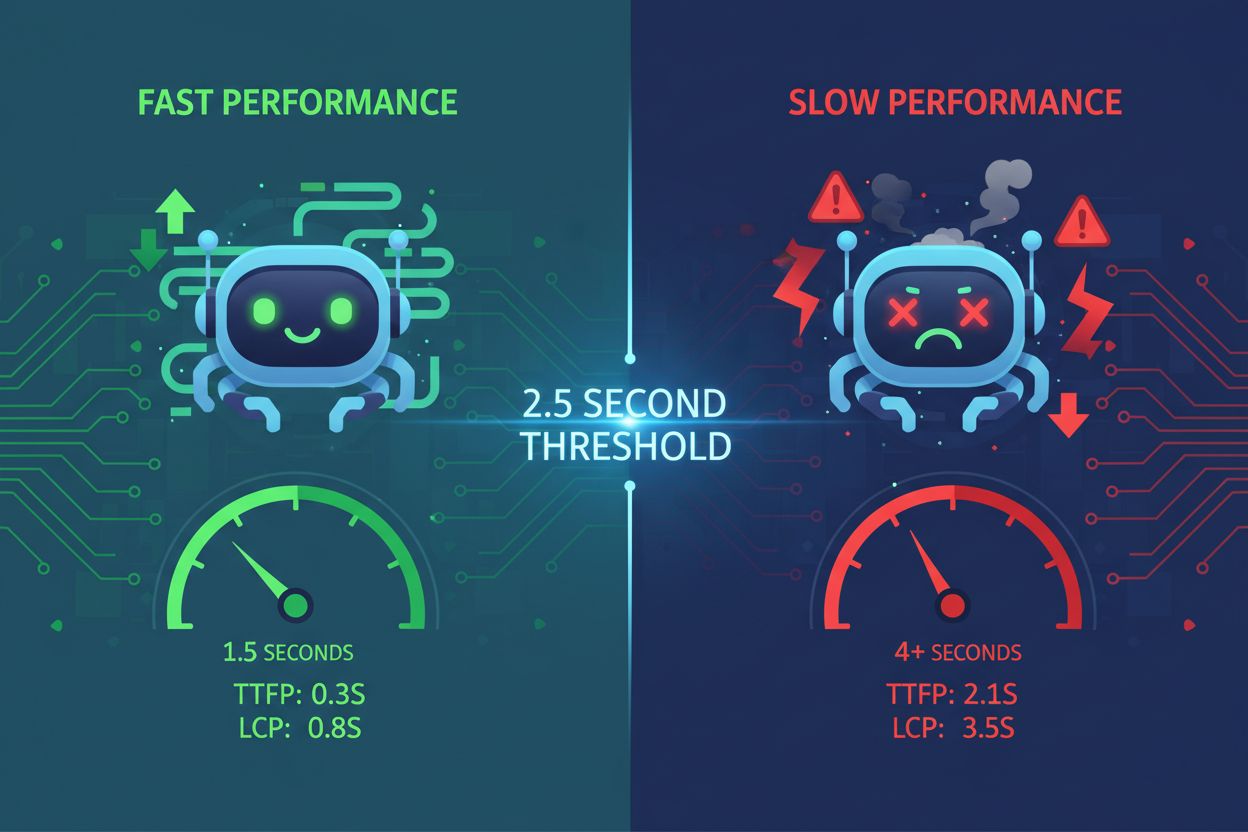

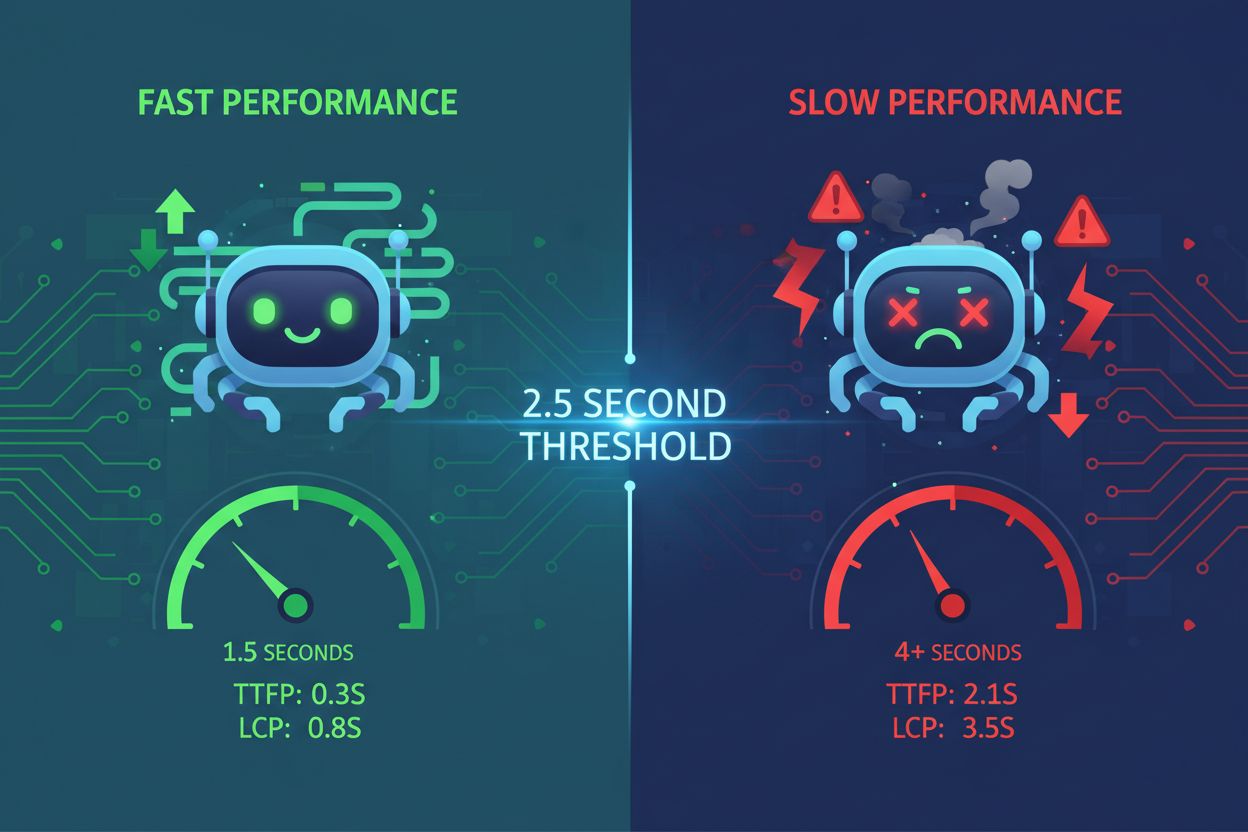

Sidehastighed er blevet en afgørende faktor for AI-synlighed og ændrer grundlæggende, hvordan indhold bliver opdaget og citeret af store sprogmodeller. AI-systemer som ChatGPT, Gemini og Perplexity opererer med stramme latenstidsbudgetter—de har ikke råd til at vente på langsomme websites, når de henter information til brugerforespørgsler. Når en side tager mere end 2,5 sekunder at indlæse, springer AI-crawlere den ofte helt over og vælger hurtigere alternativer, der kan levere samme information mere effektivt. Dette skaber et hårdt præstationsgulv: sider, der ikke lever op til denne grænse, er reelt usynlige for AI-systemer uanset indholdskvalitet. Konsekvenserne er markante—dårlig sidehastighed oversættes direkte til færre AI-citater og reduceret synlighed i AI-drevne søgeresultater. At forstå denne grænse er første skridt mod at optimere for AI-synlighed.

AI-systemer benytter fire forskellige indhentningstilstande, når de samler information: pre-training (historiske data indlæst under modeltræning), real-time browsing (live webcrawling under inferens), API connectors (direkte integrationer med datakilder) og RAG (Retrieval-Augmented Generation-systemer, der henter frisk indhold). Hver tilstand har forskellige ydelseskrav, men alle er følsomme over for core web vitals og serverresponsmålinger. Når AI-crawlere vurderer en side, ser de på TTFB (Time to First Byte), LCP (Largest Contentful Paint), INP (Interaction to Next Paint) og CLS (Cumulative Layout Shift)—målinger, der direkte afgør, om crawleren effektivt kan udtrække og indeksere indhold. Langsom TTFB betyder, at crawleren venter længere, før den modtager data; dårlig LCP betyder, at kritisk indhold vises for sent; høj INP tyder på JavaScript-overhead; og CLS indikerer ustabile layouts, der gør indholdsudtrækning besværlig.

| Måling | Hvad måler den | Indvirkning på LLM-indhentning |

|---|---|---|

| TTFB | Tid indtil første byte modtages fra serveren | Bestemmer initial crawl-hastighed; langsom TTFB giver timeouts |

| LCP | Hvornår det største synlige indholdselement vises | Forsinker indholdstilgængelighed for udtræk og indeksering |

| INP | Respons på brugerinteraktioner | Høj INP indikerer tung JavaScript, som sinker parsing |

| CLS | Visuel stabilitet under sideindlæsning | Ustabile layouts forvirrer algoritmer til indholdsudtrækning |

Forskning fra Cloudflare Radar afslører en bekymrende forskel: AI-bots crawler websites langt oftere, end de faktisk henviser trafik eller citater. Dette crawl-til-henvisning-forhold viser, at ikke al crawlingaktivitet giver synlighed—nogle AI-systemer indekserer blot indhold uden at citere det i svar. Anthropics crawler har for eksempel et 70.900:1-forhold, hvilket betyder, at den crawler 70.900 sider for hvert citat, den genererer. Det antyder, at crawl-frekvens alene ikke er en pålidelig indikator for AI-synlighed; det afgørende er, om crawleren effektivt kan behandle dit indhold og vurdere det som værdifuldt nok til citation. Konklusionen er klar: optimering for crawlbarhed er nødvendig men ikke tilstrækkelig—du skal også sikre, at dit indhold er hurtigt nok til at blive behandlet og relevant nok til at blive udvalgt. At forstå dette forhold forklarer, hvorfor nogle højt trafikerede sider stadig kæmper med AI-citater trods stor crawleraktivitet.

AI-systemer tager i stigende grad højde for regional latenstid, når de udvælger kilder til brugerforespørgsler, især ved lokationsfølsomme søgninger. En side, der hostes på én server i USA, indlæses måske hurtigt for amerikanske crawlere, men langsomt for crawlere fra andre regioner, hvilket påvirker global AI-synlighed. CDN-placering og dataresidens bliver derfor afgørende faktorer—indhold leveret fra geografisk distribuerede edge-lokationer indlæses hurtigere for crawlere over hele verden og øger sandsynligheden for at blive valgt. For forespørgsler med “nær mig” eller lokationsmodifikatorer prioriterer AI-systemer kilder med hurtig regional ydeevne, hvilket gør lokal optimering essentiel for virksomheder med geografisk målretning. Sider, der investerer i global CDN-infrastruktur, opnår en konkurrencefordel i AI-synlighed på tværs af regioner. Grænsen for ydeevne gælder globalt: en 2,5-sekunders indlæsningstid skal kunne opnås fra flere geografiske regioner, ikke kun dit primære marked.

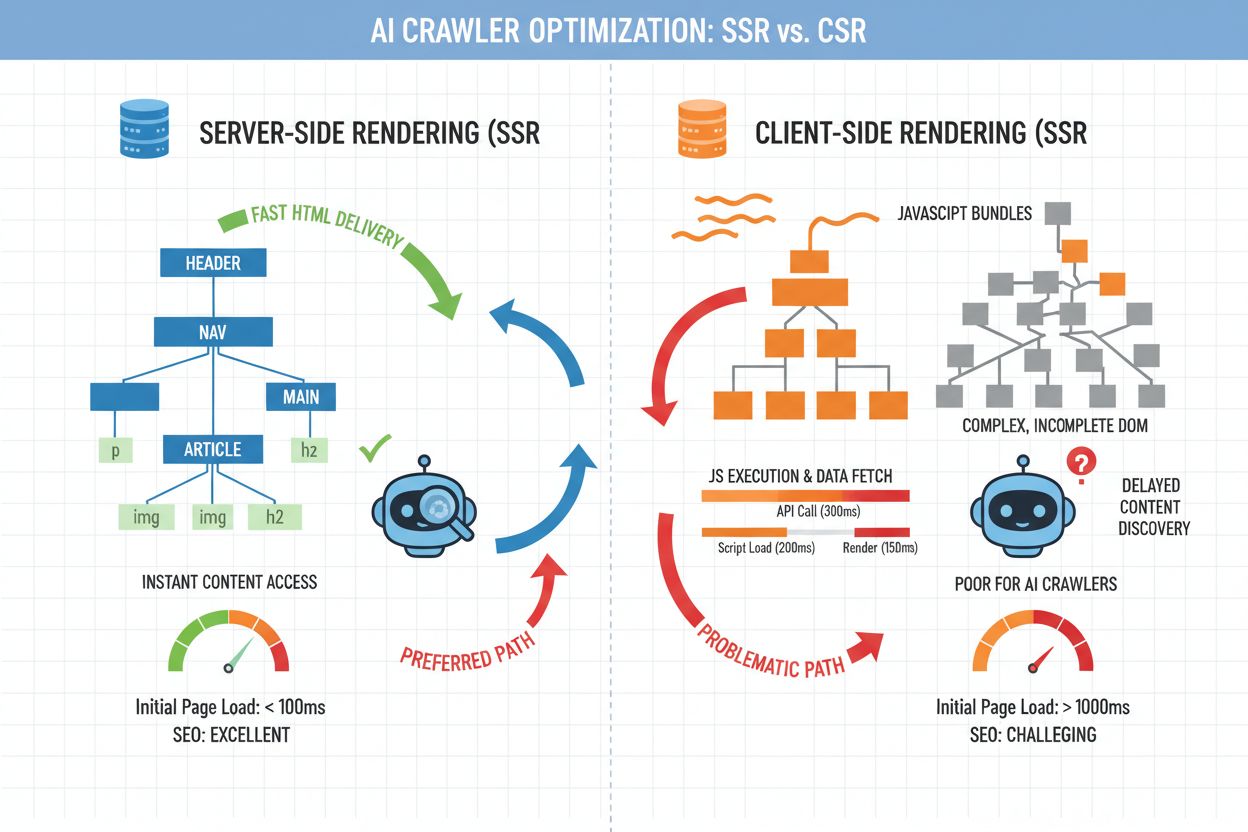

Valget mellem server-side rendering (SSR) og client-side rendering (CSR) har stor betydning for AI-synlighed. AI-crawlere foretrækker klart ren, semantisk HTML leveret i det indledende svar frem for JavaScript-tunge sider, der kræver client-side rendering for at vise indhold. Når en side er afhængig af client-side rendering, skal crawleren udføre JavaScript, vente på API-kald og rendere DOM’en—en proces, der tilføjer latenstid og kompleksitet. Minimalt JavaScript, semantisk markup og logiske overskriftsniveauer gør indholdet straks tilgængeligt for AI-systemer, reducerer behandlingstiden og forbedrer crawl-effektiviteten. Server-side rendering sikrer, at kritisk indhold findes i den indledende HTML, så crawlere kan udtrække information uden at eksekvere kode. Sider, der prioriterer hurtig, enkel HTML over komplekse client-side frameworks, opnår konsekvent bedre AI-synlighed. Arkitekturvalget handler ikke om at opgive moderne frameworks—det handler om at sikre, at kerneindholdet er tilgængeligt i det indledende svar, med progressiv forbedring for brugerinteraktioner.

Optimering for AI-synlighed kræver en systematisk tilgang til ydeevne. Følgende tjekliste dækker de mest effektfulde optimeringer, der hver især reducerer latenstid og forbedrer crawlbarhed:

Servér kerneindhold i indledende HTML: Sørg for, at hovedindhold, overskrifter og nøgleinformation er med i serverresponsen, ikke gemt bag JavaScript eller lazy-loading. AI-crawlere skal kunne udtrække det vigtigste indhold uden at eksekvere kode.

Hold TTFB og HTML-størrelse nede: Optimer serverresponsen ved at reducere databaseforespørgsler, implementere caching og minimere HTML-payload. En TTFB under 600 ms og indledende HTML under 50KB er realistiske mål for de fleste indholdssider.

Minimer render-blokerende scripts og CSS: Udskyd ikke-kritisk JavaScript og inlin kun nødvendig CSS. Render-blokerende ressourcer forsinker indholdstilgængelighed og øger oplevet latenstid for crawlere.

Brug semantisk HTML og logiske overskrifter: Strukturer indhold med korrekt overskriftshierarki (H1, H2, H3), semantiske tags (article, section, nav) og beskrivende alt-tekst. Dette hjælper AI-systemer med at forstå indholdsstruktur og vigtighed.

Begræns DOM-kompleksitet på vigtige sider: Sider med tusindvis af DOM-noder tager længere tid at parse og rendere. Forenkle layouts på hjørnestensindhold for at mindske behandlingsomkostningen.

Lav letvægtsvarianter af hjørnestensindhold: Overvej at servere forenklede, tekstbaserede versioner af dine vigtigste sider til AI-crawlere, mens du bevarer rige oplevelser for brugere. Dette kan gøres via user-agent-detektering eller separate URL’er.

At etablere et udgangspunkt er afgørende, før du optimerer for AI-synlighed. Brug værktøjer som Google PageSpeed Insights, WebPageTest og Lighthouse til at måle nuværende ydeevne på nøgleparametre. Kør kontrollerede eksperimenter ved at optimere specifikke sider og overvåge, om AI-citatfrekvensen stiger over tid—det kræver sporingsværktøjer, der sammenholder ydeevneændringer med synlighedsforbedringer. AmICited.com giver infrastrukturen til at overvåge AI-citater på tværs af flere LLM-platforme, så du kan måle den direkte effekt af ydeevneoptimeringer. Sæt alarmer op for ydeevneforværring og etabler månedlige reviews af både hastighedsmålinger og AI-synlighedstendenser. Målet er at skabe et feedback-loop: mål baseline, implementer optimeringer, følg citatstigning og iterer. Uden måling kan du ikke bevise sammenhængen mellem hastighed og AI-synlighed—og uden bevis er det svært at retfærdiggøre fortsatte investeringer i ydeevneoptimering.

AmICited.com har vist sig som det uundværlige værktøj til at spore AI-citater og overvåge synlighed på tværs af ChatGPT, Gemini, Perplexity og andre AI-systemer. Ved at integrere AmICited med din ydeevneovervågning får du indsigt i, hvordan hastighedsforbedringer hænger sammen med citatstigning—en sammenhæng, der ellers er svær at afdække. Komplementære værktøjer som FlowHunt.io giver yderligere indblik i AI-crawleradfærd og indekseringsmønstre. Konkurrencefordelen opstår ved at kombinere ydeevneoptimering med AI-synlighedsovervågning: du kan identificere, hvilke hastighedsforbedringer der giver de største citatgevinster, og prioritere dem. Sider, der systematisk tracker begge parametre—ydeevne og AI-citater—kan træffe databaserede beslutninger om, hvor de skal investere udviklingsressourcer. Denne integrerede tilgang forvandler sidehastighed fra en generel best practice til en målbar driver for AI-synlighed og organisk rækkevidde.

Mange sites begår kritiske fejl ved optimering for AI-synlighed. Overoptimering, der fjerner indhold er en almindelig faldgrube—at fjerne billeder, forklarende tekst eller skjule indhold bag faner for bedre hastighedsmålinger giver ofte bagslag ved at gøre indholdet mindre værdifuldt for AI-systemer. At fokusere udelukkende på desktop-hastighed og ignorere mobilydelse er en anden fejl, da AI-crawlere i stigende grad simulerer mobile user agents. At stole på platformens standardindstillinger uden at teste er risikabelt; standardkonfigurationer prioriterer ofte brugeroplevelse over crawlbarhed. At jage PageSpeed Insights-scores i stedet for faktiske indlæsningstider kan føre til vildledende optimeringer, der forbedrer målinger uden reel effekt. Billige hostingvalg for at spare penge på serverressourcer resulterer ofte i langsom TTFB og dårlig ydeevne under belastning—en falsk økonomi, der koster mere i tabt AI-synlighed. Endelig fører det at betragte ydeevneoptimering som et engangsprojekt frem for løbende vedligeholdelse til forringet ydeevne over tid, når indhold vokser og koden bliver mere kompleks.

Sidehastighed vil fortsat være vigtig, efterhånden som AI-søgning udvikler sig og bliver mere sofistikeret. 2,5-sekunders grænsen kan blive strammere, når AI-systemer bliver mere selektive med kilder, eller den kan ændres, efterhånden som nye indhentningsteknologier opstår—men grundprincippet består: hurtige sider er mere synlige for AI-systemer. Betragt ydeevneoptimering som en løbende praksis, ikke et afsluttet projekt. Revider regelmæssigt dit websites hastighedsmålinger, overvåg AI-citatudviklingen, og tilpas din tekniske arkitektur, når nye best practices opstår. De sites, der vil dominere AI-drevne søgeresultater, er dem, der tilpasser optimeringsindsatsen til både brugeroplevelse og AI-crawlerkrav. Ved at fastholde stærke ydeevnefundamenter—hurtig TTFB, semantisk HTML, minimalt JavaScript og ren arkitektur—sikrer du, at dit indhold forbliver synligt og citerbart uanset, hvordan AI-systemer udvikler sig. Fremtiden tilhører de sites, der betragter hastighed som en strategisk fordel, ikke en eftertanke.

Traditionel SEO betragter hastighed som en af mange rangeringsfaktorer, men AI-systemer har stramme latenstidsbudgetter og springer helt over langsomme sider. Hvis din side tager mere end 2,5 sekunder at indlæse, opgiver AI-crawlere ofte siden, før de udtrækker indholdet, hvilket gør hastighed til et hårdt krav frem for en præference for AI-synlighed.

Den kritiske grænse er 2,5 sekunder for fuld sideindlæsning. Time to First Byte (TTFB) bør dog være under 600 ms, og den indledende HTML skal indlæses inden for 1-1,5 sekunder. Disse målinger sikrer, at AI-crawlere effektivt kan tilgå og behandle dit indhold uden timeout.

Test ydeevnen månedligt med værktøjer som Google PageSpeed Insights, WebPageTest og Lighthouse. Endnu vigtigere er det at sammenholde disse målinger med AI-citatsporing gennem værktøjer som AmICited.com for at måle den reelle effekt af ydeevneændringer på din synlighed.

Ja, i stigende grad. AI-crawlere simulerer ofte mobile user agents, og mobilydeevne er ofte langsommere end desktop. Sørg for, at din mobile indlæsningstid matcher din desktop-ydelse—det er afgørende for global AI-synlighed på tværs af regioner og netværk.

Du kan lave gradvise forbedringer gennem caching, CDN-optimering og billedkomprimering. Dog kræver betydelige gevinster arkitektoniske ændringer som server-side rendering, reducering af JavaScript og forenklet DOM-struktur. De bedste resultater opnås ved at optimere både infrastruktur og kode.

Brug AmICited.com til at spore dine AI-citater på tværs af platforme, og sammenhold derefter citatudviklingen med ydeevnemålinger fra Google PageSpeed Insights. Hvis citater falder efter en ydeevneforringelse eller stiger efter optimering, har du tydeligt bevis for sammenhængen.

Core Web Vitals (LCP, INP, CLS) påvirker AI-crawleres effektivitet direkte. Dårlig LCP forsinker indholdsadgang, høj INP indikerer JavaScript-overhead, og CLS forvirrer udtrækning af indhold. Selvom disse målinger er vigtige for brugeroplevelsen, er de lige så afgørende for, at AI-systemer effektivt kan behandle og indeksere dit indhold.

Optimer for begge samtidig—de samme forbedringer, der gør dit site hurtigt for mennesker (ren kode, semantisk HTML, minimalt JavaScript), gør det også hurtigt for AI-crawlere. 2,5-sekunders grænsen gavner begge målgrupper, og der er ingen modsætning mellem brugeroplevelse og AI-synlighed.

Følg med i, hvordan din sidehastighed påvirker AI-synlighed på tværs af ChatGPT, Gemini og Perplexity. Få indsigt i realtid i dine AI-citater og optimer for maksimal synlighed.

Lær hvordan sidehastighed påvirker din synlighed i AI-søgemaskiner som ChatGPT, Perplexity og Gemini. Opdag optimeringsstrategier og vigtige målepunkter for AI ...

Opdag de kritiske faktorer, der påvirker AI-indekseringshastighed, herunder websitets ydeevne, crawl-budget, indholdsstruktur og teknisk optimering. Lær hvordan...

Fællesskabsdiskussion om hvorvidt sidehastighed påvirker synlighed i AI-søgning. Reelle data fra performance-ingeniører og SEO-fagfolk, der analyserer sammenhæn...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.