AI Crawler Reference Card: Alle Bots på et Øjeblik

Komplet referenceguide til AI-crawlere og bots. Identificer GPTBot, ClaudeBot, Google-Extended og 20+ andre AI-crawlere med brugeragenter, crawl-hastigheder og ...

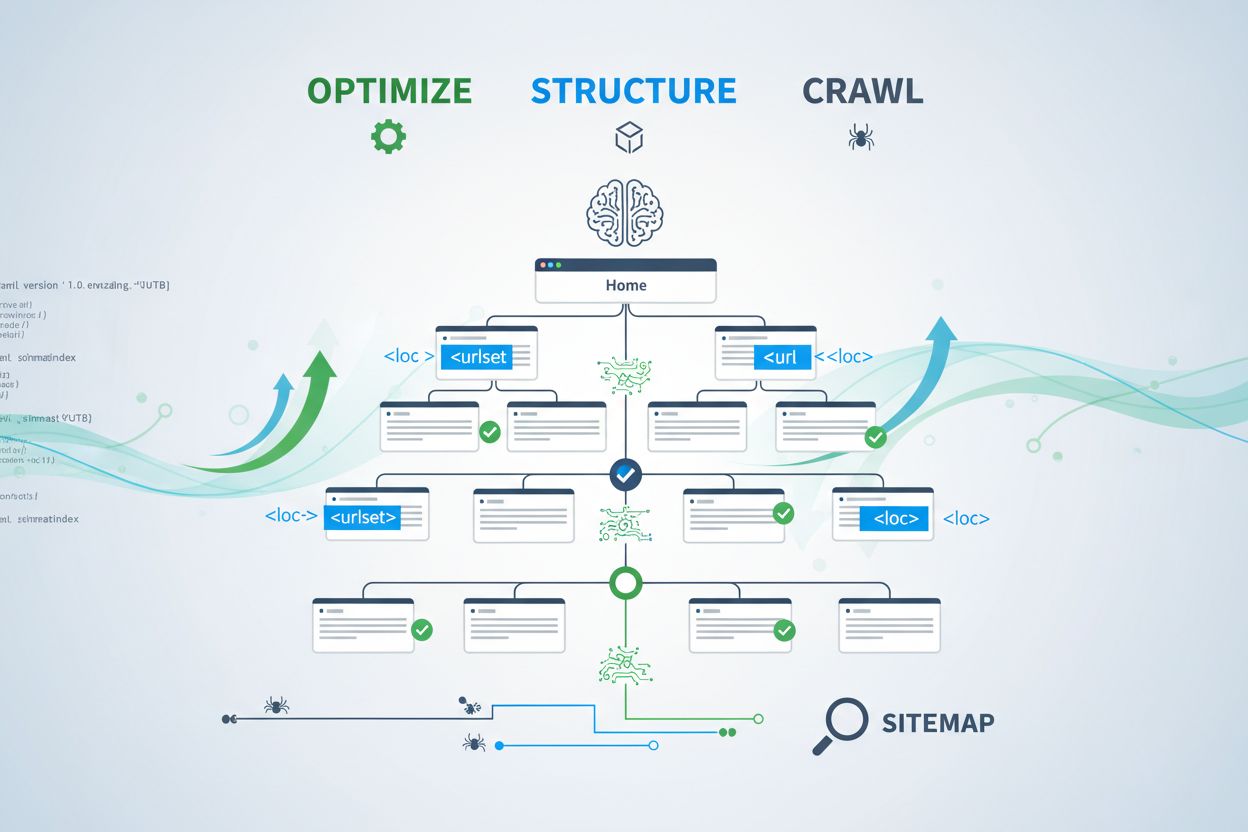

Lær at optimere XML-sitemaps til AI-crawlere som GPTBot og ClaudeBot. Bliv ekspert i sitemap-best practices for at forbedre synligheden i AI-genererede svar og LLM-indeksering.

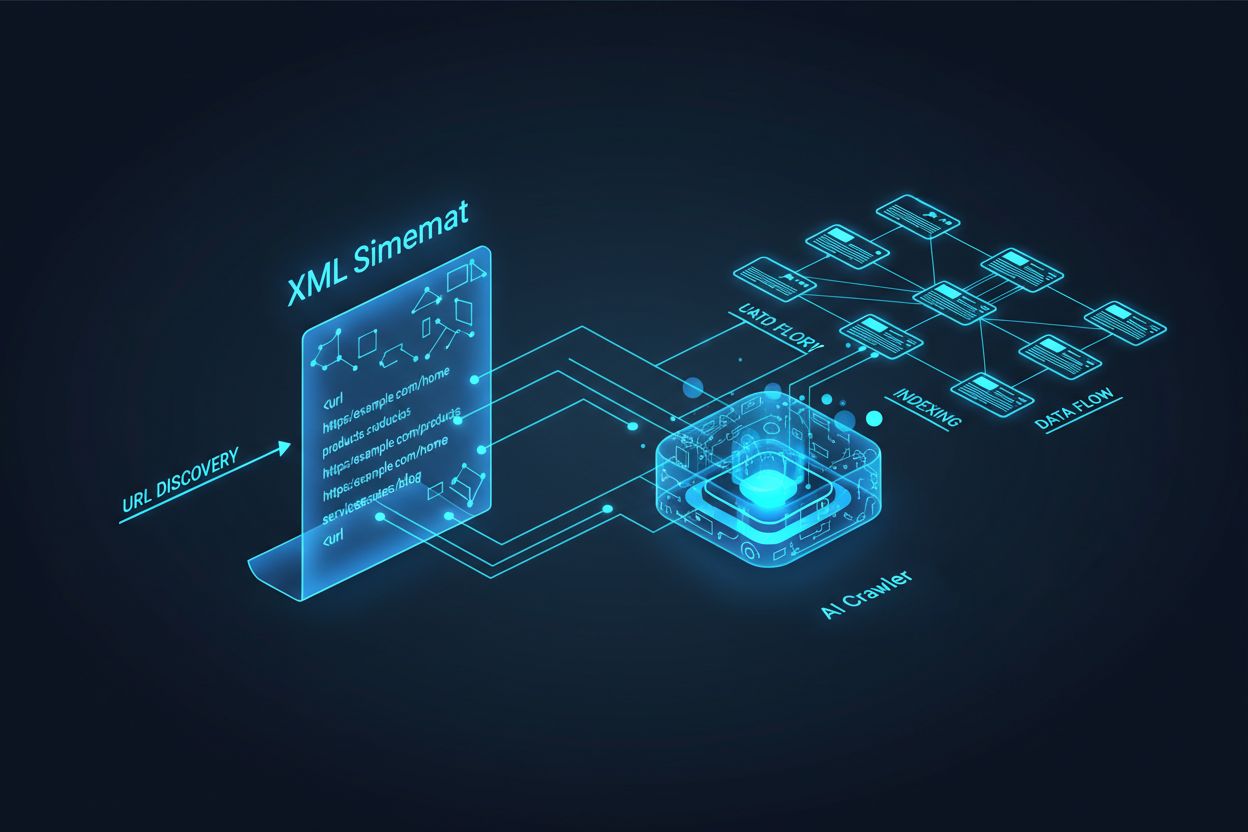

AI-crawlere som GPTBot, ClaudeBot og PerplexityBot opererer grundlæggende anderledes end traditionelle søgemaskinebots. Hvor Googlebot indekserer sider for rangering i søgeresultater, udtrækker AI-crawlere viden til at træne og informere store sprogmodeller, der driver samtalesøgning og AI-genererede svar. Uden et korrekt optimeret XML-sitemap forbliver dit indhold usynligt for disse kritiske systemer, uanset hvor velskrevet eller autoritativt det måtte være. Tænk på dit sitemap som et vejkort, der fortæller AI-systemer præcis, hvor dit mest værdifulde indhold findes, og hvordan det er organiseret.

Forskellen mellem traditionelle søgecrawlere og AI-crawlere er afgørende for at forstå, hvorfor sitemap-optimering er vigtigere end nogensinde. Traditionelle søgemaskiner som Google fokuserer på at rangere individuelle sider for specifikke søgeord, mens AI-crawlere prioriterer vidensudtræk og semantisk forståelse. Her er, hvordan de adskiller sig:

| Aspekt | Traditionelle crawlere (Googlebot) | AI-crawlere (GPTBot, ClaudeBot) |

|---|---|---|

| Primært formål | Rangere sider i søgeresultater | Udtrække viden til LLM-træning og realtidssvar |

| Fokus | Metadata, interne links, rangsignaler | Indholdsstruktur, semantisk betydning, fakta-tæthed |

| Crawl-prioritet | Baseret på PageRank og aktualitet | Baseret på autoritet, emnerelevans og vidensværdi |

| Citationspåvirkning | Driver trafik via blå links | Afgør om dit indhold indgår i AI-genererede svar |

| JavaScript-håndtering | Eksekverer og gengiver JavaScript | Springer ofte JavaScript over; prioriterer server-renderet HTML |

Denne grundlæggende forskel betyder, at optimering for traditionel SEO alene ikke længere er tilstrækkelig. Dit sitemap skal nu tjene et dobbelt formål: hjælpe traditionelle søgemaskiner med at forstå din sitestruktur, samtidig med at det guider AI-systemer til dine mest værdifulde vidensaktiver.

Et XML-sitemap fungerer som dit websites køreplan og fortæller eksplicit crawlere, hvilke sider der findes, og hvordan de relaterer sig til din overordnede indholdsstrategi. For AI-systemer har sitemaps en endnu mere kritisk funktion end for traditionel søgning. AI-crawlere bruger sitemaps til at forstå dit sites tematiske arkitektur, identificere højtprioriteret indhold og afgøre, hvilke sider der fortjener dybere analyse. Når dit sitemap er omfattende og velorganiseret, kan AI-systemer mere effektivt opdage og vurdere dit indhold med henblik på at inkludere det i generative svar. Omvendt skaber et ufuldstændigt eller forældet sitemap blinde vinkler, der forhindrer AI-systemer i nogensinde at støde på dine vigtigste sider. Effekten er direkte: sider, der ikke er i dit sitemap, er markant mindre tilbøjelige til at blive citeret af AI-systemer, uanset deres kvalitet eller relevans.

At skabe et effektivt sitemap for AI-crawlere kræver mere end blot at opliste alle URLs på dit site. Dit sitemap skal være strategisk udvalgt og kun indeholde sider, der reelt giver værdi for brugere og AI-systemer. Her er de vigtigste best practices:

Et velstruktureret sitemap fungerer som et kvalitetsfilter og fortæller AI-systemer, at du omhyggeligt har udvalgt dit indhold, og at hver URL fortjener opmærksomhed. Denne strategiske tilgang øger markant dine chancer for at blive udvalgt til citation i AI-genererede svar.

Aktualitet er en af de stærkeste rangeringsfaktorer i AI-drevne søgesystemer. Når AI-crawlere vurderer, hvilke kilder de skal citere i genererede svar, lægger de stor vægt på indholdets friskhed. Lastmod-tidsstemplet i dit XML-sitemap er det primære signal, der fortæller AI-systemer, hvornår dit indhold sidst blev opdateret. Forældede eller manglende tidsstempler kan få selv autoritativt indhold til at blive nedprioriteret til fordel for friskere kilder. Hvis dit sitemap viser, at en side ikke er blevet opdateret i årevis, kan AI-systemer antage, at informationen er forældet og i stedet vælge konkurrenternes indhold. Omvendt signalerer nøjagtige lastmod-tidsstempler, der afspejler reelle indholdsopdateringer, til AI-crawlere, at dine oplysninger er aktuelle og pålidelige. For tidsfølsomme emner som priser, regler eller branchens tendenser bliver nøjagtige tidsstempler endnu vigtigere. Automatiske tidsstempel-opdateringer via dit CMS sikrer, at enhver indholdsændring straks afspejles i dit sitemap, hvilket maksimerer din synlighed i AI-genererede svar.

Mens sitemaps inviterer crawlere til at indeksere dit indhold, styrer robots.txt-filer, hvilke dele af dit site crawlere må tilgå. Disse to filer skal arbejde sammen for at maksimere din AI-synlighed. En almindelig fejl er at lave et omfattende sitemap, mens man samtidig blokerer AI-crawlere i robots.txt-filen, hvilket skaber en modstrid, der forvirrer crawlere og reducerer din synlighed. Din robots.txt bør eksplicit tillade større AI-crawlere som GPTBot, ClaudeBot og PerplexityBot adgang til dit indhold. Du kan bruge robots.txt strategisk til kun at blokere sider, der ikke skal indekseres, såsom admin-dashboards, loginsider eller dubletversioner af indhold. Nøglen er at sikre, at dine robots.txt-regler stemmer overens med din sitemap-strategi—hvis en side er i dit sitemap, bør den være tilgængelig ifølge robots.txt. Regelmæssige audits af begge filer hjælper med at identificere fejlkonfigurationer, der måske i stilhed begrænser din AI-synlighed.

De mest effektive AI-optimeringsstrategier behandler sitemaps og strukturerede data som komplementære systemer, der understøtter hinanden. Når dit sitemap fremhæver en side som vigtig, og denne side indeholder relevant schema markup, sender du ensartede signaler til AI-crawlere om sidens formål og værdi. Hvis dit sitemap for eksempel prioriterer en how-to-guide, bør siden inkludere HowTo-schema, der giver struktureret information om trinene. Tilsvarende bør produktsider i dit sitemap indeholde Product-schema med pris, tilgængelighed og anmeldelser. Denne justering skaber et sammenhængende dataprodukt, som AI-systemer let kan tolke og have tillid til. Når sitemaps og strukturerede data er i konflikt eller divergerer, bliver AI-crawlere usikre på sidens egentlige formål, hvilket reducerer sandsynligheden for citation. Ved at sikre, at din sitemap-strategi flugter med dit schema-setup, skaber du et samlet signal, der dramatisk forbedrer dine chancer for at blive udvalgt til AI-genererede svar.

Forskellige typer indhold kræver forskellige sitemap-strategier for at maksimere AI-synligheden. Blogindlæg, produktsider, servicebeskrivelser og FAQ-indhold tjener alle forskellige formål og bør optimeres tilsvarende:

| Indholdstype | Sitemap-strategi | Anbefalet schema markup | Prioriteringshensyn |

|---|---|---|---|

| Blogindlæg & artikler | Inkludér med nøjagtige udgivelses- og opdateringsdatoer | Article, NewsArticle, BlogPosting | Prioritér aktuelt, evergreen-indhold; opdatér lastmod jævnligt |

| Produktsider | Inkludér med lagerstatus-opdateringer; overvej separat produktsitemap | Product, Offer, AggregateRating | Fremhæv bestsellere og nye produkter; opdatér priser hyppigt |

| Servicesider | Inkludér med serviceopdateringsdatoer | Service, LocalBusiness, ProfessionalService | Prioritér kerneydelser; opdatér tilgængelighed og priser |

| FAQ-sider | Inkludér med indholdsopdateringsdatoer | FAQPage, Question, Answer | Prioritér omfattende FAQs; opdatér svar, når information ændrer sig |

| Videoindhold | Inkludér i videositemap med thumbnail og varighed | VideoObject, Video | Inkludér transskriptioner; opdatér visninger og engagement |

| Billedindhold | Inkludér i billedsitemap med billedtekster | ImageObject, Product (for produktbilleder) | Optimer alt-tekst; medtag beskrivende billedtekster |

Denne differentierede tilgang sikrer, at hver indholdstype får den rette optimering for AI-opdagelse. Ved at tilpasse din sitemap-strategi til dit indholdsmix maksimerer du sandsynligheden for, at AI-systemer finder og citerer dine mest værdifulde aktiver.

llms.txt-standarden, foreslået i slutningen af 2024, repræsenterer en eksperimentel tilgang til at hjælpe AI-systemer med at forstå websitestruktur. I modsætning til XML-sitemaps er llms.txt en Markdown-baseret fil, der giver en menneskelæsbart indholdsfortegnelse for dit site. Den oplister dine vigtigste sider og ressourcer i et format, der er lettere for sprogmodeller at parse og forstå. Selvom konceptet er lovende, tyder nuværende beviser på, at llms.txt har minimal indflydelse på AI-synlighed sammenlignet med traditionelle XML-sitemaps. Større AI-crawlere som GPTBot og ClaudeBot er fortsat afhængige af XML-sitemaps til URL-opdagelse og aktualitetssignaler. I stedet for at erstatte dit XML-sitemap bør llms.txt ses som et supplement, der muligvis kan give yderligere kontekst til AI-systemer. Hvis du implementerer llms.txt, skal du sikre, at den supplerer og ikke erstatter din kerne-sitemap-strategi, og fokusere først på at perfektionere dit XML-sitemap med nøjagtige tidsstempler og strategisk indholdsudvælgelse.

Selv velmenende websites begår ofte kritiske sitemap-fejl, der i stilhed begrænser deres AI-synlighed. At forstå og undgå disse fejl er afgørende for at maksimere din tilstedeværelse i AI-genererede svar:

At rette disse almindelige fejl kan straks forbedre din AI-synlighed. Start med at auditere dit nuværende sitemap ud fra denne tjekliste og udbedr eventuelle identificerede problemer.

At vedligeholde et optimeret sitemap kræver løbende overvågning og validering. Flere værktøjer kan hjælpe dig med at sikre, at dit sitemap forbliver effektivt for AI-crawlere. Google Search Console tilbyder indbygget sitemap-validering og viser, hvor mange URLs Google har indekseret fra dit sitemap. Screaming Frog SEO Spider giver dig mulighed for at crawle hele dit site og sammenligne resultaterne med dit sitemap og identificere manglende eller brudte URLs. XML-sitemapvalideringsværktøjer tjekker din sitemap-syntaks og sikrer, at den overholder XML-sitemap-protokollen. For større virksomheder inkluderer dedikerede SEO-platforme som Semrush og Ahrefs sitemap-analysefunktioner, der følger ændringer over tid. Regelmæssige audits—helst månedligt—hjælper dig med at fange problemer, før de påvirker din AI-synlighed. Sæt kalenderpåmindelser til at gennemgå dit sitemap, når du foretager væsentlige indholdsændringer, lancerer nye sektioner eller opdaterer din sitestruktur.

At forstå, hvordan AI-crawlere interagerer med dit sitemap, kræver aktiv overvågning og analyse. Dine serverlogs indeholder værdifulde data om, hvilke AI-crawlere der besøger dit site, hvor ofte de crawler, og hvilke sider de prioriterer. Ved at analysere disse logs kan du identificere mønstre og optimere dit sitemap derefter. Værktøjer som AmICited.com hjælper dig med at overvåge, hvor ofte dit indhold bliver citeret af AI-systemer som ChatGPT, Claude, Perplexity og Googles AI Overviews, hvilket giver direkte feedback på dit sitemaps effektivitet. Google Analytics kan konfigureres til at spore henvisningstrafik fra AI-systemer og vise dig, hvilke sider der genererer mest AI-drevet synlighed. Ved at korrelere disse data med din sitemap-struktur kan du identificere, hvilke indholdstyper og emner der resonerer mest med AI-systemer. Denne datadrevne tilgang gør det muligt løbende at forfine din sitemap-strategi og prioritere det indhold, der genererer flest AI-citater og synlighed.

Ud over basal sitemap-optimering kan avancerede strategier markant forbedre din AI-synlighed. At oprette separate sitemaps for forskellige indholdstyper—såsom dedikerede blogsitemaps, produktsitemaps og videositemaps—gør det muligt at anvende type-specifikke optimeringsstrategier. Dynamisk sitemap-generering, hvor dit sitemap opdateres i realtid, efterhånden som indhold ændres, sikrer, at AI-crawlere altid ser dit mest aktuelle indhold. For store virksomhedssites med tusindvis af sider hjælper implementering af sitemap-hierarkier og strategisk prioritering AI-crawlere med at fokusere på dit mest værdifulde indhold. Nogle organisationer laver AI-specifikke sitemaps, der kun fremhæver deres mest autoritative og citeringsværdige indhold og signalerer til AI-systemer, hvilke sider der fortjener prioriteret opmærksomhed. At integrere din sitemap-strategi med dit content management system sikrer, at optimeringen sker automatisk frem for manuelt. Disse avancerede tilgange kræver større teknisk ekspertise, men kan give betydelige forbedringer i AI-synlighed for organisationer med komplekse indholdsøkosystemer.

AI-crawler-landskabet udvikler sig hurtigt, med nye crawlere der dukker op jævnligt og standarder som llms.txt, der vinder indpas. At fremtidssikre din sitemap-strategi betyder at bygge fleksibilitet ind i dine systemer og holde dig informeret om branchens udvikling. Implementér sitemap-genereringssystemer, der nemt kan tilpasses nye crawler-krav uden behov for manuel omkonfigurering. Overvåg meddelelser fra større AI-virksomheder om nye crawlere, og opdatér dine robots.txt- og sitemap-strategier i overensstemmelse hermed. Overvej den langsigtede værdi af AI-synlighed kontra indholdskontrol—mens nogle organisationer vælger at blokere AI-crawlere, antyder tendensen, at AI-citater vil blive stadig vigtigere for brandsynlighed. Udarbejd klare politikker for, hvordan din organisation vil håndtere AI-crawler-adgang og indholdsbrug. Ved at behandle dit sitemap som et levende dokument, der udvikler sig med AI-landskabet, sikrer du, at dit indhold forbliver opdageligt og citerbart, efterhånden som søge- og opdagelsesmekanismer fortsat transformeres.

Du bør opdatere dit sitemap, hver gang du udgiver nyt indhold eller foretager væsentlige ændringer på eksisterende sider. Ideelt set bør du implementere automatiseret sitemap-generering, så opdateringer sker med det samme. For sider med hyppige indholdsændringer anbefales daglige opdateringer. For statiske sider er månedlige gennemgange tilstrækkelige.

De fleste større AI-crawlere som GPTBot og ClaudeBot respekterer robots.txt-direktiver, men ikke alle gør det. Den bedste praksis er eksplicit at tillade AI-crawlere i din robots.txt-fil frem for at stole på standardadfærd. Overvåg dine serverlogs for at verificere, at crawlere opfører sig som forventet.

XML-sitemaps er maskinlæsbare filer, der lister alle dine URLs med metadata som lastmod-tidsstempler. llms.txt er en nyere Markdown-baseret standard designet til at give AI-systemer et menneskelæsbart indholdsfortegnelse. XML-sitemaps er i øjeblikket vigtigere for AI-synlighed, mens llms.txt bør ses som et supplement.

Tjek dine serverlogs for user agents som 'GPTBot', 'ClaudeBot', 'PerplexityBot' og 'Google-Extended'. Du kan også bruge værktøjer som AmICited.com til at overvåge, hvor ofte dit indhold bliver citeret af AI-systemer, hvilket indikerer succesfuld crawling og indeksering.

Ja, oprettelse af separate sitemaps for blogs, produkter, videoer og billeder gør det muligt at anvende type-specifikke optimeringsstrategier. Det hjælper også AI-crawlere med at forstå din indholdsstruktur tydeligere og kan forbedre crawl-effektiviteten for store sider.

XML-sitemaps bør indeholde højst 50.000 URLs pr. fil. For større sider bør du bruge sitemap-indekser til at organisere flere sitemap-filer. AI-crawlere kan håndtere store sitemaps, men opdeling i logiske sektioner forbedrer crawl-effektiviteten og gør administrationen lettere.

Lastmod-tidsstempler signalerer indholdsaktualitet til AI-crawlere. Aktualitet er en stærk rangeringsfaktor i AI-systemer, så nøjagtige tidsstempler hjælper dit indhold med at konkurrere om citater. Brug altid automatiserede systemer til at opdatere tidsstempler kun, når indholdet faktisk ændres – angiv aldrig falske tidsstempler manuelt.

Ja, et dårligt vedligeholdt sitemap kan i høj grad skade din AI-synlighed. Brudte links, forældede URLs, unøjagtige tidsstempler og ufuldstændig dækning reducerer alle dine chancer for at blive citeret af AI-systemer. Regelmæssige audits og vedligeholdelse er afgørende for at beskytte din AI-synlighed.

Følg hvor ofte dit indhold bliver citeret af ChatGPT, Claude, Perplexity og Google AI Overviews. Optimer din sitemap-strategi baseret på reel AI-citationsdata.

Komplet referenceguide til AI-crawlere og bots. Identificer GPTBot, ClaudeBot, Google-Extended og 20+ andre AI-crawlere med brugeragenter, crawl-hastigheder og ...

Lær hvilke AI-crawlere du skal tillade eller blokere i din robots.txt. Omfattende guide, der dækker GPTBot, ClaudeBot, PerplexityBot og 25+ AI-crawlere med konf...

Få indsigt i hvordan AI-crawlere som GPTBot og ClaudeBot fungerer, hvordan de adskiller sig fra traditionelle søgemaskinecrawlere, og hvordan du optimerer dit s...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.