AI Crawler Reference Card: Alle Bots på et Øjeblik

Komplet referenceguide til AI-crawlere og bots. Identificer GPTBot, ClaudeBot, Google-Extended og 20+ andre AI-crawlere med brugeragenter, crawl-hastigheder og ...

Opdag hvordan SSR- og CSR-renderingstrategier påvirker AI-crawleres synlighed, brandcitater i ChatGPT og Perplexity samt din samlede AI-søgepræsentation.

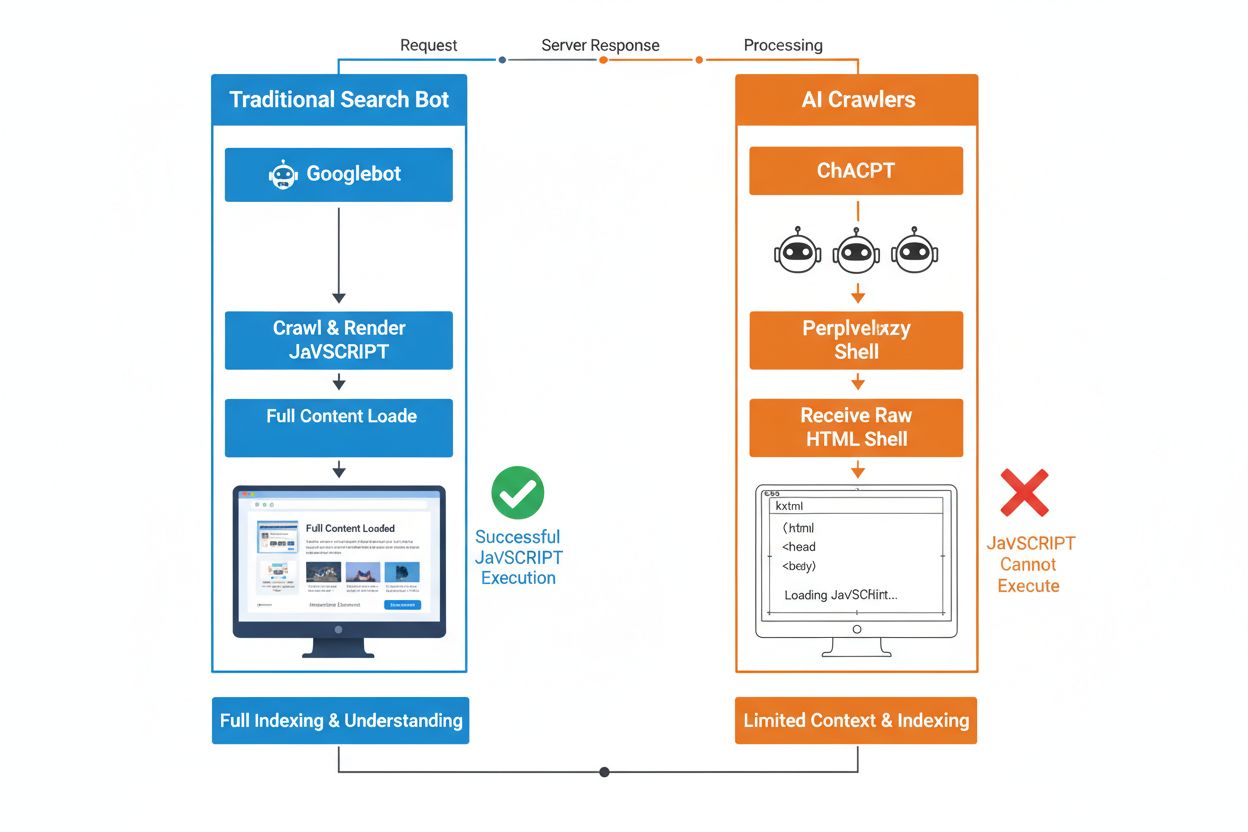

Den grundlæggende forskel mellem traditionelle søgebots og AI-crawlere ligger i deres tilgang til JavaScript-eksekvering. Hvor Googlebot og andre traditionelle søgemaskiner kan rendere JavaScript (dog med ressourcebegrænsninger), eksekverer AI-crawlere som GPTBot, ChatGPT-User og OAI-SearchBot slet ikke JavaScript—de ser kun den rå HTML, der leveres ved den første sidelæsning. Denne kritiske forskel betyder, at hvis dit websites indhold afhænger af klient-side JavaScript for at blive vist, vil AI-systemer modtage et ufuldstændigt eller tomt snapshot af dine sider, hvor produktdetaljer, prisoplysninger, anmeldelser og andet dynamisk indhold, som brugerne ser i deres browsere, mangler. At forstå denne forskel er essentielt, fordi AI-drevne søgeresultater hurtigt bliver en primær kanal til opdagelse for brugere, der søger information.

Server-side rendering (SSR) forbedrer grundlæggende AI-synligheden ved at levere fuldt rendret HTML direkte fra serveren ved den første anmodning, hvilket eliminerer behovet for, at AI-crawlere skal eksekvere JavaScript. Med SSR er alt kritisk indhold—overskrifter, brødtekst, produktoplysninger, metadata og strukturerede data—til stede i HTML’en, som bots modtager, hvilket gør det straks tilgængeligt for optagelse i AI-træningskorpusser og søgeindekser. Denne tilgang sikrer ensartet indholdslevering på tværs af alle crawlere, hurtigere indekseringshastigheder og fuld metadata-synlighed, som AI-systemer er afhængige af for at forstå og citere dit indhold korrekt. Følgende tabel illustrerer, hvordan forskellige renderingstrategier påvirker AI-crawleres synlighed:

| Renderingtype | Hvad AI-crawlere ser | Indekseringshastighed | Indholdskomplethed | Metadata-synlighed |

|---|---|---|---|---|

| Server-side rendering (SSR) | Fuldt rendret HTML med alt indhold | Hurtig (straks) | Komplet | Fremragende |

| Client-side rendering (CSR) | Minimal HTML-shell, mangler dynamisk indhold | Langsom (hvis det overhovedet renderes) | Ufuldstændig | Dårlig |

| Static site generation (SSG) | Forudbygget, cachet HTML | Meget hurtig | Komplet | Fremragende |

| Hybrid/incremental | Blandede statiske og dynamiske ruter | Moderat til hurtig | God (hvis kritiske sider pre-renderes) | God |

Client-side rendering (CSR) giver væsentlige udfordringer for AI-synlighed, fordi det tvinger crawlere til at vente på JavaScript-eksekvering—noget AI-bots ganske enkelt ikke gør grundet ressourcebegrænsninger og stramme tidsgrænser. Når et CSR-baseret site indlæses, indeholder det første HTML-svar kun et minimalt shell med loading-spinnere og pladsholdere, mens det egentlige indhold indlæses asynkront via JavaScript. AI-crawlere har stramme tidsgrænser på 1-5 sekunder og eksekverer ikke scripts, hvilket betyder, at de fanger et tomt eller næsten tomt side-snapshot, der mangler produktbeskrivelser, priser, anmeldelser og anden kritisk information. Dette skaber et kædereaktionsproblem: ufuldstændige indholdssnapshots fører til ringe chunking og embedding-kvalitet, hvilket reducerer sandsynligheden for, at dine sider udvælges til AI-genererede svar. For e-handelssider, SaaS-platforme og indholdstunge applikationer, der benytter CSR, fører dette direkte til tabt synlighed i AI Overviews, ChatGPT-svar og Perplexity-besvarelser—de kanaler, der driver opdagelse i AI-tidsalderen.

Den tekniske årsag til, at AI-bots ikke kan eksekvere JavaScript, skyldes grundlæggende skalerbarheds- og ressourcebegrænsninger i deres arkitektur. AI-crawlere prioriterer hastighed og effektivitet over fuldstændighed, da de opererer med stramme tidsgrænser, fordi de skal behandle milliarder af sider for at træne og opdatere sprogmodeller. Eksekvering af JavaScript kræver opstart af headless browsere, tildeling af hukommelse og ventetid på asynkrone operationer—luksusser, der ikke kan skaleres, når der skal crawles i det omfang, LLM-træning kræver. I stedet fokuserer AI-systemer på at udtrække ren, semantisk struktureret HTML, der er øjeblikkeligt tilgængelig, og betragter statisk indhold som den kanoniske version af dit site. Dette designvalg afspejler en grundlæggende sandhed: AI-systemer er optimeret til statisk HTML-levering, ikke til rendering af komplekse JavaScript-rammer som React, Vue eller Angular.

Indvirkningen på AI-genererede svar og brandsynlighed er markant og har direkte betydning for dine forretningsresultater. Når AI-crawlere ikke kan tilgå dit indhold på grund af JavaScript-rendering, bliver dit brand usynligt i AI Overviews, mangler i citater og er fraværende i LLM-drevne søgeresultater—selv hvis du rangerer højt i traditionel Google-søgning. For e-handelssider betyder det, at produktoplysninger, priser og lagerstatus aldrig når AI-systemerne, hvilket resulterer i ufuldstændige eller forkerte produktanbefalinger og tabte salgsmuligheder. SaaS-virksomheder mister synlighed for sammenligninger og prissider, der ellers ville drive kvalificerede leads gennem AI-drevne researchværktøjer. Nyheds- og indholdssider ser deres artikler udeladt fra AI-sammendrag, hvilket reducerer henvisningstrafik fra platforme som ChatGPT og Perplexity. Forskellen mellem, hvad mennesker ser og hvad AI-systemer ser, skaber et to-niveau-synlighedsproblem: dit site kan virke sundt i traditionelle SEO-målinger, mens det samtidig bliver usynligt for den hurtigst voksende opdagelseskanal.

Pre-rendering og hybride løsninger tilbyder praktiske måder at kombinere fordelene fra begge renderingtilgange uden at kræve et komplet arkitektur-skifte. I stedet for at vælge mellem CSR’s interaktivitet og SSR’s crawlbarhed, anvender moderne teams strategiske kombinationer, der tjener forskellige formål:

Disse tilgange gør det muligt at opretholde rige, interaktive brugeroplevelser, samtidig med at AI-crawlere modtager komplet, fuldt rendret HTML. Frameworks som Next.js, Nuxt og SvelteKit gør hybrid rendering tilgængelig uden behov for omfattende specialudvikling. Nøglen er at identificere de sider, der driver acquisition, omsætning eller support—disse kritiske sider bør altid pre-renderes eller server-renderes for at sikre AI-synlighed.

Renderingstrategien påvirker direkte, hvordan AI-systemer henviser til og citerer dit brand, hvilket gør det essentielt at overvåge din synlighed på tværs af AI-platforme. Værktøjer som AmICited.com tracker, hvordan AI-systemer citerer dit brand på tværs af ChatGPT, Perplexity, Google AI Overviews og andre LLM-drevne platforme, så du kan se, om dit indhold faktisk når frem til disse systemer. Når dit site benytter CSR uden pre-rendering, viser AmICited-data ofte en tydelig kløft: du kan ligge højt i traditionelle søgeresultater, men modtage nul citater i AI-genererede svar. Denne overvågning afslører de reelle omkostninger ved JavaScript-rendering—not only i crawl-effektivitet, men i tabt brandsynlighed og citatmuligheder. Ved at implementere SSR eller pre-rendering og derefter følge resultaterne via AmICited, kan du kvantificere den direkte indvirkning af renderingbeslutninger på AI-synlighed, hvilket gør det lettere at retfærdiggøre investeringer over for interessenter med fokus på trafik og konverteringer.

At auditere og optimere din renderingstrategi for AI-synlighed kræver en systematisk, trinvis tilgang. Start med at identificere, hvilke sider der giver mest værdi: produktsider, prissider, kerne-dokumentation og blogindlæg med høj trafik bør prioriteres. Brug værktøjer som Screaming Frog (i “Text Only”-tilstand) eller Chrome DevTools til at sammenligne, hvad bots ser kontra brugere—hvis kritisk indhold mangler i sidens kilde, er det JavaScript-afhængigt og usynligt for AI-crawlere. Vælg derefter din renderingstrategi baseret på krav til indholdsaktualitet: statiske sider kan bruge SSG, ofte opdateret indhold har fordel af SSR eller ISR, og interaktive funktioner kan lægges ovenpå server-renderet HTML med JavaScript. Test derefter med faktiske AI-bots ved at indsende dine sider til ChatGPT, Perplexity og Claude for at verificere, at de kan tilgå dit indhold. Til sidst, overvåg crawl-logs for AI-user-agents (GPTBot, ChatGPT-User, OAI-SearchBot) for at bekræfte, at disse bots crawler dine pre-renderede eller server-renderede sider. Denne iterative tilgang gør rendering fra et teknisk detalje til et målbart synlighedsværktøj.

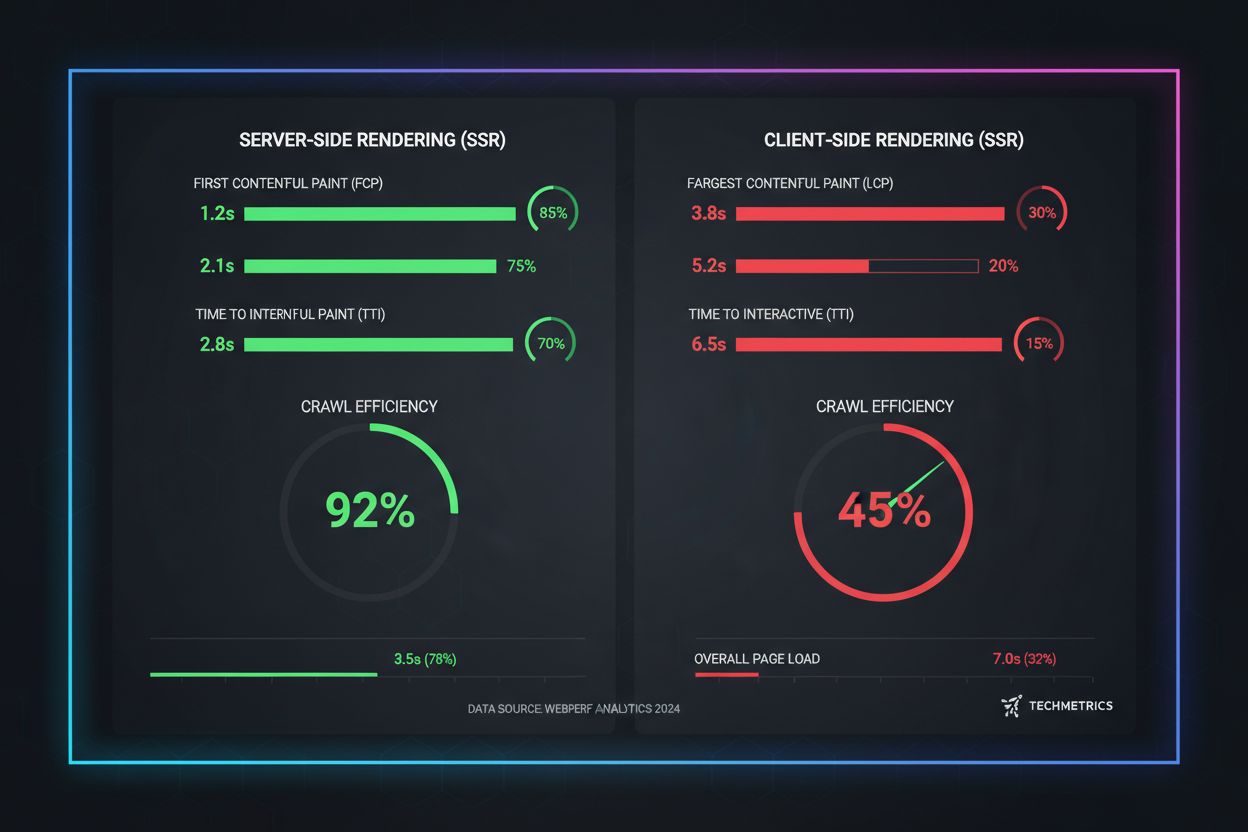

Virkelige ydelsesdata afslører de markante forskelle mellem renderingtilgange, når det gælder AI-crawlbarhed. SSR og pre-renderede sider opnår First Contentful Paint (FCP) på 0,5-1,5 sekunder, mens CSR-sider ofte kræver 2-4 sekunder eller mere, da JavaScript skal downloades og eksekveres. For AI-crawlere, der arbejder med tidsgrænser på 1-5 sekunder, er denne forskel forskellen på komplet synlighed og total usynlighed. Crawleffektiviteten forbedres markant med SSR: et pre-renderet e-handelssite kan fuldt crawles og indekseres på få timer, mens et CSR-ækvivalent kan tage uger, da crawlere kæmper med JavaScript-rendering. Indekseringshastigheden forbedres også betydeligt—SSR-sider får nyt indhold indekseret inden for 24-48 timer, mens CSR-sider ofte oplever 7-14 dages forsinkelse. For tidssensitivt indhold som nyhedsartikler, produktlanceringer eller tidsbegrænsede tilbud betyder denne forsinkelse direkte tabt synlighed i det kritiske vindue, hvor brugerne aktivt søger.

SEO’s fremtid er uadskillelig fra AI-søgesynlighed, hvilket gør renderingstrategi til en kritisk, langsigtet investering frem for en teknisk eftertanke. AI-drevet søgning vokser eksplosivt—13,14% af alle Google-søgninger udløser nu AI Overviews, og platforme som ChatGPT har over fire milliarder besøg hver måned, mens Perplexity og Claude hurtigt vinder indpas. Efterhånden som AI-systemer bliver den primære opdagelseskanal for flere brugere, vil de renderingbeslutninger, du træffer i dag, afgøre din synlighed i morgen. Løbende overvågning er essentielt, fordi AI-crawleradfærd, tidsgrænser og JavaScript-understøttelse udvikler sig, efterhånden som disse systemer modnes. Teams, der behandler rendering som en engangsmigrering, oplever ofte at blive usynlige igen inden for få måneder, når AI-platforme ændrer crawl-strategi. Indbyg i stedet renderingoptimering i din kvartalsvise planlægning, inkluder AI-synlighedstjek i regressionstests, og brug værktøjer som AmICited til at følge, om dit brand bevarer synligheden, efterhånden som AI-landskabet skifter. De brands, der vinder i AI-søgning, er dem, der behandler renderingstrategi som en kernekonkurrencefordel, ikke som teknisk gæld, der skal adresseres senere.

AI-crawlere som GPTBot og ChatGPT-User arbejder under strenge ressourcebegrænsninger og stramme tidsgrænser (1-5 sekunder), fordi de skal behandle milliarder af sider for at træne sprogmodeller. Eksekvering af JavaScript kræver opstart af headless browsere og ventetid på asynkrone operationer—luksusser, der ikke kan skaleres til det volumen, der kræves for LLM-træning. I stedet fokuserer AI-systemer på at udtrække ren, statisk HTML, der er tilgængelig med det samme.

Server-side rendering leverer fuldt rendret HTML ved den første anmodning, hvilket gør alt indhold umiddelbart tilgængeligt for AI-crawlere uden JavaScript-eksekvering. Dette sikrer, at dine produktoplysninger, priser, anmeldelser og metadata når AI-systemerne pålideligt, hvilket øger chancerne for, at dit brand bliver citeret i AI-genererede svar og vises i AI Overviews.

Server-side rendering (SSR) renderer sider on-demand, når en anmodning ankommer, mens pre-rendering genererer statiske HTML-filer ved build-tidspunktet. Pre-rendering fungerer bedst til indhold, der ikke ændrer sig ofte, mens SSR er bedre til dynamisk indhold, der opdateres regelmæssigt. Begge tilgange sikrer, at AI-crawlere modtager komplet HTML uden JavaScript-eksekvering.

Ja, men med væsentlige begrænsninger. Du kan bruge pre-rendering-værktøjer til at generere statiske HTML-snapshots af dine CSR-sider eller implementere hybrid rendering, hvor kritiske sider server-renderes, mens mindre vigtige sider forbliver client-renderede. Uden disse optimeringer er CSR-sider dog stort set usynlige for AI-crawlere.

Brug værktøjer som Screaming Frog (Text Only-tilstand), Chrome DevTools eller Google Search Console til at sammenligne, hvad bots ser kontra hvad brugere ser. Hvis kritisk indhold mangler i sidens kilde, er det afhængigt af JavaScript og usynligt for AI-crawlere. Du kan også teste direkte med ChatGPT, Perplexity og Claude for at verificere, at de kan tilgå dit indhold.

SSR og pre-renderede sider opnår typisk First Contentful Paint (FCP) på 0,5-1,5 sekunder, mens CSR-sider ofte kræver 2-4+ sekunder. Da AI-crawlere arbejder under 1-5 sekunders tidsgrænser, betyder hurtigere rendering direkte bedre AI-crawlbarhed. Forbedrede Core Web Vitals gavner også brugeroplevelsen og traditionelle SEO-placeringer.

AmICited overvåger, hvordan AI-systemer citerer dit brand på tværs af ChatGPT, Perplexity og Google AI Overviews. Ved at følge din AI-synlighed før og efter implementering af SSR eller pre-rendering kan du kvantificere den direkte effekt af renderingbeslutninger på brandcitater og AI-søgepræsentation.

Det afhænger af dine krav til indholdsaktualitet og forretningsprioriteter. Statisk indhold drager fordel af SSG, ofte opdateret indhold af SSR, og interaktive funktioner kan lægges ovenpå server-renderet HTML med JavaScript. Start med at identificere sider med høj værdi (produktsider, priser, dokumentation) og prioriter dem til SSR eller pre-rendering først.

Overvåg hvordan ChatGPT, Perplexity og Google AI Overviews henviser til dit brand. Forstå den reelle effekt af din renderingstrategi på AI-citater.

Komplet referenceguide til AI-crawlere og bots. Identificer GPTBot, ClaudeBot, Google-Extended og 20+ andre AI-crawlere med brugeragenter, crawl-hastigheder og ...

Lær hvordan du gør dit indhold synligt for AI-crawlere som ChatGPT, Perplexity og Googles AI. Opdag tekniske krav, bedste praksis og overvågningsstrategier for ...

Lær hvordan prerendering gør JavaScript-indhold synligt for AI-crawlere som ChatGPT, Claude og Perplexity. Opdag de bedste tekniske løsninger til AI-søgeoptimer...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.