Offentlig Websteds AI-synlighed: Optimering af den Offentlige Sektor

Lær hvordan offentlige myndigheder kan optimere deres digitale tilstedeværelse for AI-systemer som ChatGPT og Perplexity. Opdag strategier til at forbedre AI-sy...

Lær nødvendige bedste praksisser for gennemsigtighed og offentliggørelse af AI. Opdag adfærdsmæssige, verbale og tekniske offentliggørelsesmetoder for at opbygge tillid og sikre overholdelse af de udviklende AI-regler.

AI-gennemsigtighed er blevet et kritisk krav i en tid, hvor kunstig intelligens påvirker alt fra indholdsskabelse til ansættelsesbeslutninger og finansielle anbefalinger. Efterhånden som AI-genereret indhold breder sig på digitale platforme, oplever organisationer et stigende pres for at offentliggøre, hvornår og hvordan de bruger disse teknologier – ikke kun som et juridisk krav, men som en grundlæggende forudsætning for at opretholde tillid og troværdighed hos deres publikum. Indsatsen er især høj for brands og indholdsskabere, da forbrugerne i stigende grad kræver at vide, om den information, de modtager, stammer fra menneskelig ekspertise eller algoritmisk generering. Uden gennemsigtige offentliggørelsespraksisser risikerer organisationer at underminere den tillid, der har taget år at opbygge, og kan stå over for omdømmeskade, regulatoriske sanktioner og tab af publikums tillid. Forholdet mellem gennemsigtighed og troværdighed er symbiotisk – organisationer, der proaktivt offentliggør deres AI-brug, udviser integritet og respekt for deres interessenter og positionerer sig selv som ærlige aktører i et stadigt mere AI-drevet landskab.

Udbredelsen af AI-genereret indhold har skabt et grundlæggende tillidsparadoks: publikum har svært ved at skelne mellem autentisk menneskeskabt arbejde og sofistikerede AI-genererede alternativer, mens gennemsigtighed om AI-brug stadig er inkonsekvent på tværs af brancher. Denne forvirring underminerer den grundlæggende kontrakt mellem skabere og forbrugere, hvor publikum forventer at kende det sande ophav til det indhold, de møder. Når AI-genereret indhold præsenteres uden offentliggørelse, bryder det denne implicitte aftale og skaber et “ægte vs. falsk”-skel, der rækker ud over simple spørgsmål om autenticitet – det berører spørgsmål om bedrag, manipulation og informeret samtykke. Paradokset forstærkes, fordi noget AI-genereret indhold kan være uadskilleligt fra menneskearbejde i kvalitet og stil, hvilket gør visuelle eller stilistiske kendetegn upålidelige som indikatorer for ophav. Gennemsigtighed er vigtig netop fordi det løser dette paradoks ved at give publikum den information, de behøver for at træffe informerede valg om det indhold, de forbruger og har tillid til. Organisationer, der omfavner klare offentliggørelsespraksisser, omdanner potentiel skepsis til tillid og viser, at de intet har at skjule og alt at vinde ved ærlig kommunikation.

Det regulatoriske miljø omkring AI-offentliggørelse udvikler sig hurtigt, og flere jurisdiktioner implementerer eller foreslår krav, som organisationer skal navigere omhyggeligt. EU’s AI-forordning, en af de mest omfattende rammer, kræver, at AI-genereret eller stærkt AI-redigeret indhold skal indeholde synlig eller metadata-baseret offentliggørelse, med specifikke krav til højrisiko-AI-systemer og gennemsigtighedsforpligtelser for udviklere. I USA har FTC udsendt advarsler om, at manglende opdatering af brugsvilkår og privatlivspolitikker ved AI-brug kan udgøre vildledende praksis, mens statslige regler – især Californiens nylige AI frontier model offentliggørelseslov – pålægger øget gennemsigtighed og rapporteringsforpligtelser for udviklere af store AI-systemer. Ophavsret og immaterielle rettigheder tilføjer endnu et lag af kompleksitet, da organisationer skal offentliggøre, om træningsdata inkluderede ophavsretligt beskyttet materiale, og hvordan AI-systemerne blev trænet. Derudover omfatter GDPR og CCPA krav også AI-systemer, der behandler persondata, hvilket kræver, at organisationer skal offentliggøre automatiseret beslutningstagning og give personer meningsfuld information om AI-behandling. Følgende tabel opsummerer de vigtigste regulatoriske krav på tværs af større jurisdiktioner:

| Jurisdiktion | Regulering | Centrale krav | Ikrafttrædelsesdato |

|---|---|---|---|

| Den Europæiske Union | EU AI-forordning | Offentliggørelse for højrisiko-AI; gennemsigtighedsrapporter; metadata-mærkning af AI-genereret indhold | Faseinddelt (2024-2026) |

| USA (føderalt) | FTC-retningslinjer | Opdater privatlivspolitikker; offentliggør AI-brug; undgå vildledende praksis | Løbende |

| Californien | AI Frontier Model Law | Standardiseret offentliggørelse; rapporteringsforpligtelser; sikkerhedsforanstaltninger | 2025 |

| Den Europæiske Union | GDPR | Offentliggør automatiseret beslutningstagning; giv information om AI-behandling | Løbende |

| USA (flere stater) | CCPA & lignende | Offentliggør dataanvendelse i AI-systemer; giv fravalgs-muligheder | Varierer efter stat |

| Internationalt | Ophavsretlige hensyn | Offentliggør træningsdatas kilder; adresser ophavsret i AI-output | Under udvikling |

Organisationer, der opererer på tværs af flere jurisdiktioner, bør implementere offentliggørelsespraksisser, der opfylder de strengeste krav, da overholdelse af én standard ofte overstiger minimumskravet for andre.

Adfærdssignaler repræsenterer den mest subtile, men kraftfulde form for AI-offentliggørelse ved at virke gennem præsentation, stil, stemme og kreative valg, som publikum ubevidst behandler, når de vurderer indholds ægthed. Disse signaler inkluderer karakteristiske mønstre i skrivestil, stemmekonsistens, visuelle kompositionsvalg, avatar- eller personae-kendetegn samt den overordnede “fidelitet” af skaberen – altså i hvilken grad indholdet afspejler ægte menneskelig personlighed og beslutningstagning. For eksempel udviser AI-genereret tekst ofte særlige mønstre i sætningsstruktur, ordvalg og logisk flow, der adskiller sig fra menneskelig skrivning, mens AI-genererede billeder kan have subtile uoverensstemmelser i belysning, anatomi eller baggrundsdetaljer, som trænede observatører kan opdage. Begrebet skaberfidelitet er centralt her: publikum udvikler forventninger til, hvordan en bestemt skaber bør lyde, se ud og præsentere sig, og afvigelser fra dette mønster kan signalere AI-involvering. At stole udelukkende på adfærdssignaler er dog problematisk, fordi AI-systemer hurtigt bliver bedre til at efterligne menneskelige egenskaber, og publikum ikke kan forventes at blive AI-forensikere. Derfor bør adfærdssignaler supplere – ikke erstatte – eksplicitte offentliggørelsesmetoder og fungere som et sekundært lag af gennemsigtighed, der styrker snarere end erstatter klar, direkte kommunikation om AI-brug.

Verbale offentliggørelsesstrategier giver eksplicit, direkte kommunikation om AI-brug gennem sproglige signaler, der efterlader ingen tvivl om indholdets ophav og AI-involvering. Disse metoder er vigtige, fordi de skaber en klar, dokumenteret registrering af offentliggørelsen og sikrer, at publikum modtager utvetydig information om AI-brug. Organisationer kan implementere verbal offentliggørelse gennem flere supplerende tilgange:

Hver metode er mest egnet afhængigt af kontekst: mærkater fungerer godt til sociale medier og visuelt indhold, vandmærker egner sig til video og lyd, bylines passer til journalistisk og kreativt arbejde, offentliggørelsesfelter er velegnede til længere indhold, og anerkendelser giver omfattende kontekst for komplekse projekter. Organisationer bør vælge offentliggørelsesmetoder, der matcher deres indholdsformat og publikumsforventninger, så offentliggørelsen er umulig at overse, men stadig ikke forstyrrer brugeroplevelsen.

Tekniske signaler og metadata giver maskinlæsbar, standardiseret information om AI-involvering, som muliggør automatiseret detektion, verificering og sporing af AI-genereret indhold på tværs af digitale økosystemer. Disse tilgange anvender indlejrede data og kryptografiske teknikker til at skabe permanente, manipulationssikre optegnelser over indholdets ophav og behandlingshistorik. IPTC-standarderne, der for nylig er opdateret til at inkludere AI-specifikke metadataegenskaber, gør det muligt for skabere at indlejre struktureret information om AI-brug direkte i billedfiler, herunder oplysninger om hvilke AI-systemer, der blev brugt, hvilken behandling der blev anvendt, og hvilke menneskelige ændringer der blev foretaget. C2PA (Coalition for Content Provenance and Authenticity) repræsenterer en ny industristandard, der bruger kryptografiske signaturer og indholdslegitimation til at etablere verificerbare kæder for digitalt indhold, så publikum kan spore indholdet tilbage til dets oprindelige kilde og forstå alle anvendte ændringer. Disse tekniske tilgange løser en vigtig begrænsning ved menneskeligt læsbar offentliggørelse: de skaber permanente, verificerbare optegnelser, der ikke nemt kan fjernes eller ændres, og de gør det muligt for automatiserede systemer at identificere og markere AI-genereret indhold i stor skala. Organisationer, der implementerer teknisk offentliggørelse, bør overveje at bruge C2PA-legitimation til indhold med høj værdi, indlejre IPTC-metadata i billeder og mediefiler og føre detaljeret digital kilde-type dokumentation, der sporer AI-involvering gennem hele indholdets livscyklus. Fordelen ved tekniske signaler er deres varighed og verificerbarhed; udfordringen er at sikre, at publikum og platforme forstår og respekterer disse signaler.

Succesfuld AI-offentliggørelse kræver, at gennemsigtighedspraksis bliver en integreret del af hele indholdsskabelsesprocessen, så offentliggørelse går fra at være en eftertanke til at være et fundamentalt element i indholdsstyring. Organisationer bør implementere strukturerede indholdsrammer, der registrerer AI-involvering på hvert trin i skabelsen – fra den indledende research og udarbejdelse til redigering og publicering – og sikrer, at offentliggørelsesoplysninger flyder naturligt gennem eksisterende indholdsadministrationssystemer. Automatisering og workflow-integration er essentielt: indholdsadministrationssystemer bør have obligatoriske felter for AI-offentliggørelse, automatiske påmindelser, der kræver, at skabere dokumenterer AI-brug før publicering, og godkendelsesworkflows, der verificerer offentliggørelsens fuldstændighed, før indholdet går live. Denne tilgang behandler offentliggørelse som et krav til kvalitetssikring snarere end et valgfrit tillæg, ligesom organisationer håndterer faktatjek, juridisk gennemgang eller brand compliance. Organisationer bør også etablere klare politikker for, hvad der udgør AI-brug, der kræver offentliggørelse (fx skal brug af AI til research offentliggøres? Hvad med AI-assisteret redigering?), så der sikres konsistens på tværs af teams og undgås offentliggørelseshuller. Træning og dokumentation er ligeledes vigtigt: indholdsskabere har brug for tydelig vejledning i, hvordan de skal offentliggøre AI-brug korrekt for forskellige indholdstyper og platforme. Ved at indlejre offentliggørelse i indholdsmodeller og workflows, forvandler organisationer gennemsigtighed fra en compliance-byrde til en standardprocedure, der beskytter både organisationen og dens publikum.

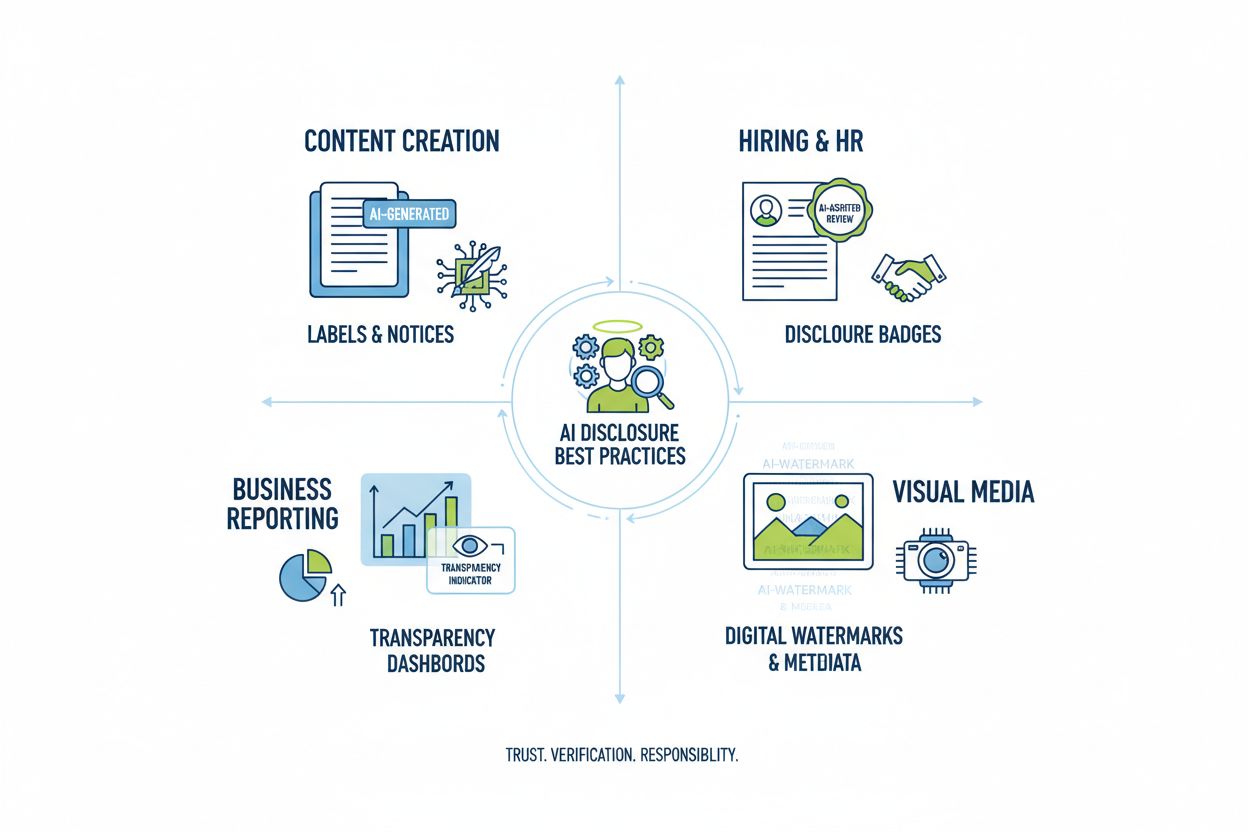

Forskellige anvendelser af AI kræver tilpassede offentliggørelsesmetoder, der tager højde for kontekst, publikumsforventninger og regulatoriske krav. Indholdsskabelse (artikler, sociale medier, marketingtekster) bør inkludere tydelige mærkater eller ændrede bylines, der angiver AI-involvering, med yderligere offentliggørelsesfelter, der forklarer, hvilke AI-værktøjer der blev brugt, og hvilken menneskelig overvågning der blev anvendt; dette er især vigtigt for nyheds- og redaktionelt indhold, hvor publikums tillid afhænger af forståelsen af indholdets ophav. Ansættelse og rekruttering kræver den mest grundige offentliggørelse, da kandidater har ret til at vide, når AI-systemer vurderer deres ansøgninger eller gennemfører indledende screening, med detaljerede forklaringer på, hvordan AI-beslutninger træffes, og hvilke menneskelige gennemgange der følger. Rapportering og analyse (finansielle rapporter, markedsundersøgelser, dataanalyse) bør inkludere tekniske offentliggørelser og metadata, der angiver, hvilke analyser der var AI-assisterede, især når AI-systemer identificerede mønstre eller genererede indsigter, der påvirkede konklusionerne. Visuelt indhold (billeder, videoer, grafik) kræver både visuelle vandmærker og metadata-offentliggørelse, da publikum ikke kan skelne AI-genererede visuelle elementer fra autentiske; dette er især afgørende for nyhedsfotografi, produktbilleder og alt indhold, hvor autenticitet påvirker køb eller tillid. Kundeorienteret kommunikation (chatbots, automatiserede svar, kundeservice) bør klart identificere AI-involvering fra begyndelsen af interaktionen, så kunder kan anmode om menneskelig hjælp, hvis ønsket. Organisationer bør kortlægge deres AI-brug på tværs af disse kontekster og implementere offentliggørelsespraksisser, der står mål med følsomheden og betydningen af hvert brugstilfælde, idet de anerkender, at gennemsigtighedskravene varierer afhængig af, hvordan AI-beslutninger påvirker publikum.

Fremtiden for AI-offentliggørelse afhænger af branchedækkende standardisering og udvikling af interoperable rammeværker, der muliggør ensartet, sammenlignelig gennemsigtighed på tværs af organisationer og platforme. Fremspirende standarder som C2PA, IPTC-metadata-specifikationer og NIST’s AI Risk Management Framework giver grundlæggende strukturer, men udbredt anvendelse kræver koordineret indsats fra teknologiplatforme, indholdsskabere, regulatorer og brancheorganisationer. EU’s AI-forordning og lignende regulatoriske rammer driver standardisering ved at kræve specifikke offentliggørelsesformater og informationskategorier, hvilket lægger pres på branchen for at vedtage fælles standarder frem for idiosynkratiske tilgange. Brancheinitiativer som PRSA’s etiske AI-retningslinjer og forskellige gennemsigtighedsrapporteringsrammer viser en voksende konsensus om bedste praksis for offentliggørelse, selvom frivillig anvendelse stadig er inkonsekvent. Det næste afgørende skridt er overgangen fra frivillige standarder til lovkrav, der påbyder standardiseret offentliggørelse, ligesom FDA-ernæringsmærkater har standardiseret fødevaregennemsigtighed. Overvågnings- og synlighedsplatforme – som AmICited.com – spiller en stadig vigtigere rolle i dette økosystem ved at spore, hvordan AI refererer til brands og indhold i AI-genererede svar, hvilket giver organisationer indsigt i, hvordan deres arbejde fremstår i AI-output, og om korrekt kreditering og offentliggørelse finder sted. Efterhånden som AI-systemer bliver mere sofistikerede og allestedsnærværende, bliver evnen til at overvåge, verificere og revidere AI-offentliggørelsespraksis afgørende for at bevare tilliden til digitale informationsøkosystemer. Organisationer, der investerer i robuste offentliggørelsespraksisser og overvågningsmuligheder i dag, vil stå stærkest til at navigere i det udviklende regulatoriske landskab og bevare publikums tillid i en AI-drevet fremtid.

Adfærdsmæssig offentliggørelse bruger præsentationsvalg (stil, stemme, avatar) til at signalere AI-involvering. Verbal offentliggørelse bruger eksplicitte udsagn, mærkater og vandmærker. Teknisk offentliggørelse indlejrer maskinlæsbare metadata og kryptografiske signaturer. Hver metode tjener forskellige målgrupper og kontekster, og organisationer bør bruge flere metoder sammen for omfattende gennemsigtighed.

Lovkrav varierer efter jurisdiktion. EU's AI-forordning kræver offentliggørelse for højrisiko-AI-systemer. FTC kræver offentliggørelse, når AI-brug kan påvirke forbrugernes beslutninger. Statlige love som Californiens AI Frontier Model Law pålægger rapporteringsforpligtelser. Ophavsretsloven kræver offentliggørelse af AI-genereret indhold. Organisationer bør rådføre sig med juridiske eksperter for krav, der er specifikke for deres jurisdiktion.

AI-genererede billeder bør inkludere både visuelle vandmærker og metadata-offentliggørelse. Visuelle vandmærker skal være synlige, men diskrete, og tydeligt angive AI-generering. Metadata skal inkludere IPTC digital kilde-type information og C2PA-legitimation, når det er tilgængeligt. Billedtekster og offentliggørelsesfelter skal eksplicit angive, at billederne er AI-genererede, især for nyheder, produkter eller reklameindhold.

IPTC-standarder leverer strukturerede metadatafelter til dokumentation af AI-brug i billeder og mediefiler. De muliggør automatisk detektion og sporing af AI-genereret indhold på tværs af platforme. IPTC digitale kilde-type kategorier inkluderer 'Trained Algorithmic Media', 'Composite Synthetic' og 'Algorithmic Media'. Disse standarder er vigtige, fordi de skaber permanente, verificerbare optegnelser over AI-involvering, som ikke let kan fjernes eller ændres.

Virksomheder bør udføre et AI-tjek for at identificere alle AI-brugstilfælde, implementere offentliggørelsespolitikker i overensstemmelse med gældende regler, integrere offentliggørelse i indholdsadministrations-workflows, træne teams i offentliggørelseskrav og overvåge overholdelse regelmæssigt. Det er essentielt at konsultere juridiske eksperter med kendskab til AI-regulering i din jurisdiktion, da kravene varierer betydeligt mellem regioner.

Konsekvenserne inkluderer regulatoriske sanktioner (FTC-bøder, overtrædelser af statslove), omdømmeskade og tab af publikums tillid, juridisk ansvar for ophavsretskrænkelser eller vildledende praksis samt potentielle retssager fra berørte parter. Organisationer, der undlader at offentliggøre AI-brug, risikerer at underminere den troværdighed, der har taget år at opbygge, hvilket gør proaktiv offentliggørelse til en strategisk investering i langsigtet tillid.

Forskellige interessenter har brug for forskellige informationsniveauer. Brede målgrupper har brug for simple, klare udsagn om AI-involvering. Tilsynsmyndigheder har brug for detaljeret teknisk dokumentation og beviser for overholdelse. Journalister og indholdsskabere har brug for specifik information om AI-værktøjer og menneskelig overvågning. Kunder skal forstå, hvordan AI påvirker deres oplevelse. Tilpas offentliggørelsesformat og detaljer til hver målgruppes behov og forventninger.

C2PA (Coalition for Content Provenance and Authenticity) leverer kryptografiske legitimationsoplysninger til indholdsverificering. IPTC-standarder muliggør metadata-indlejring i billeder. Indholdsadministrationssystemer inkluderer i stigende grad AI-offentliggørelsesfelter. Overvågningsplatforme som AmICited.com sporer AI-referencer og synlighed. Branche-rammeværker fra PRSA, NIST og andre giver vejledning. Anvendelsen af disse værktøjer og standarder accelererer, efterhånden som reguleringen strammes.

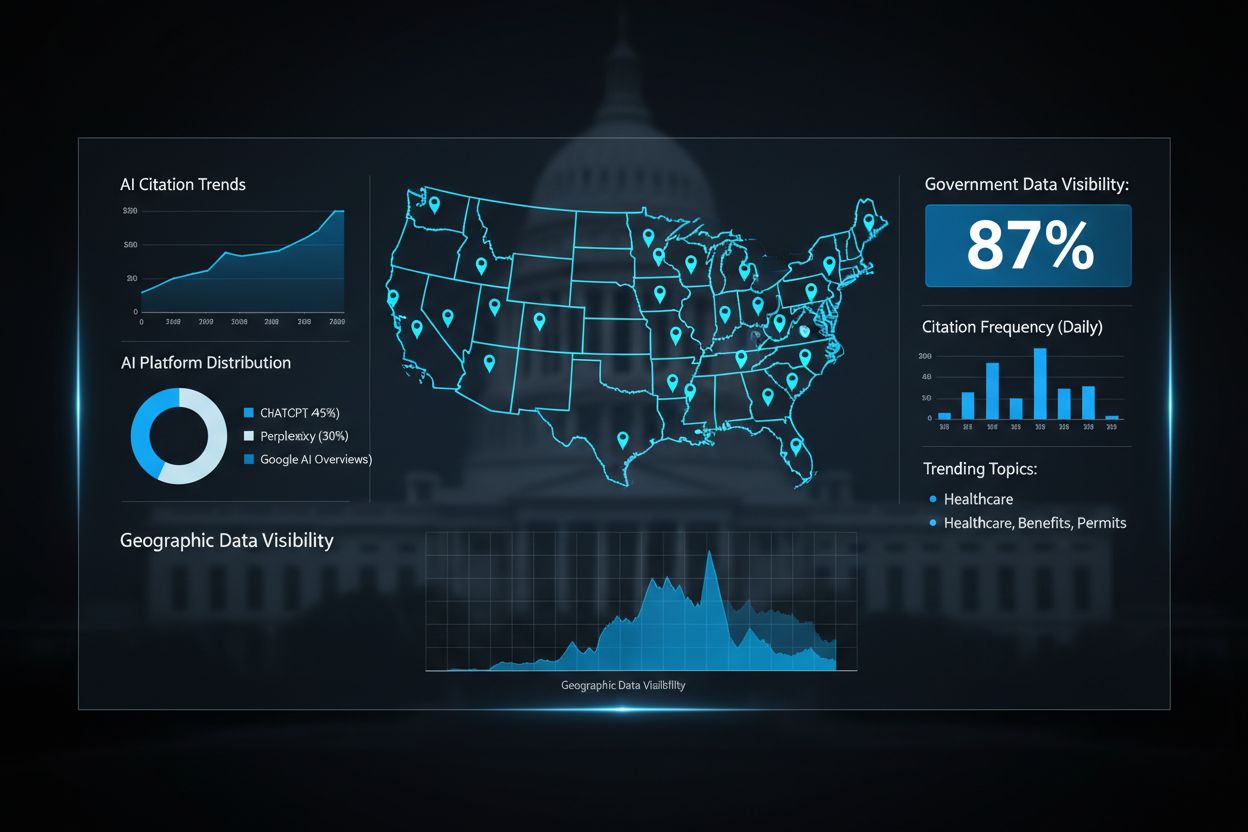

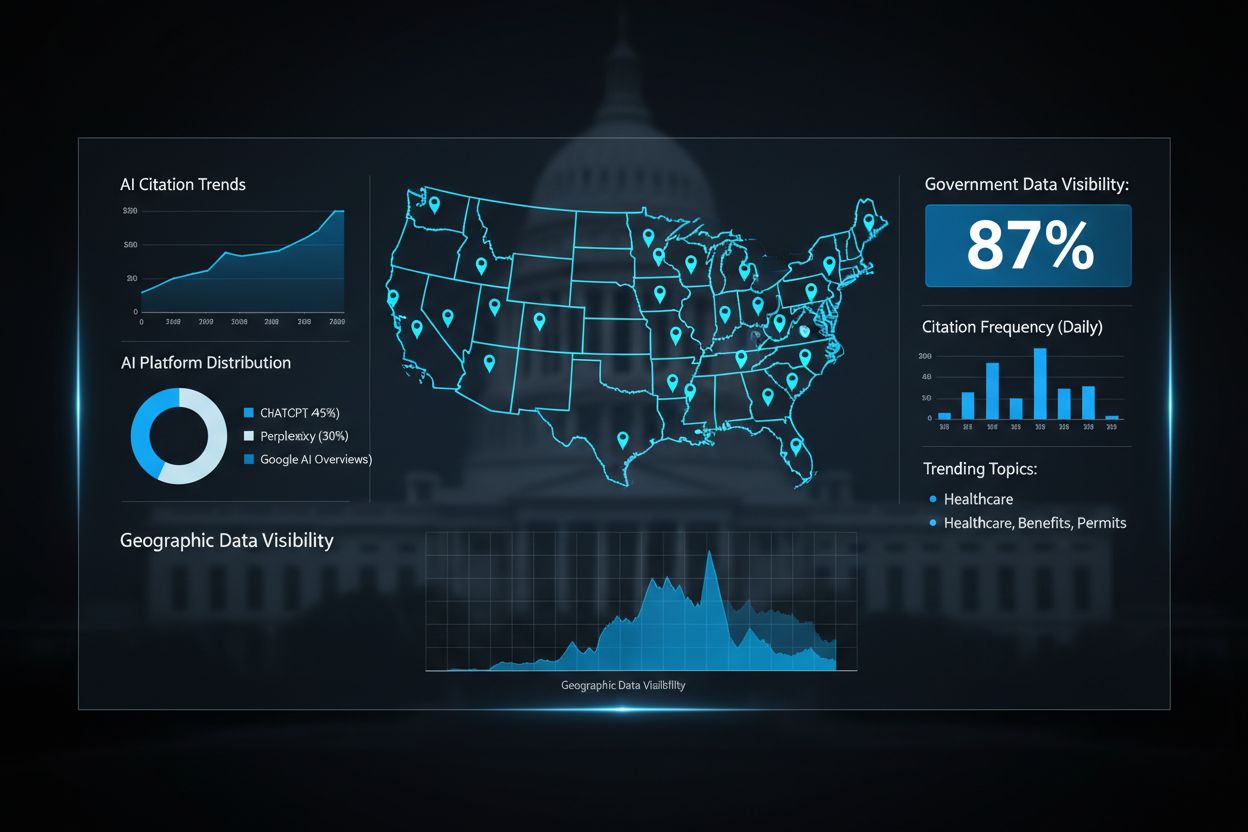

Følg, hvordan AI-systemer refererer til dit brand på tværs af GPT'er, Perplexity og Google AI Overviews. Sikr, at dit indhold modtager korrekt kreditering og synlighed i AI-genererede svar.

Lær hvordan offentlige myndigheder kan optimere deres digitale tilstedeværelse for AI-systemer som ChatGPT og Perplexity. Opdag strategier til at forbedre AI-sy...

Lær hvad AI-rangeringsgennemsigtighed betyder, hvorfor det er vigtigt for indholdsskabere og brugere, og hvordan forskellige AI-platforme som Perplexity, Google...

Lær hvordan du opbygger tillidssignaler for AI-søgemaskiner som ChatGPT, Perplexity og Google AI Overviews. Opdag E-E-A-T principper, autoritetssignaler og cita...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.