Hvad påvirker AI-indekseringshastighed? Nøglefaktorer for hurtigere AI-opdagelse

Opdag de kritiske faktorer, der påvirker AI-indekseringshastighed, herunder websitets ydeevne, crawl-budget, indholdsstruktur og teknisk optimering. Lær hvordan...

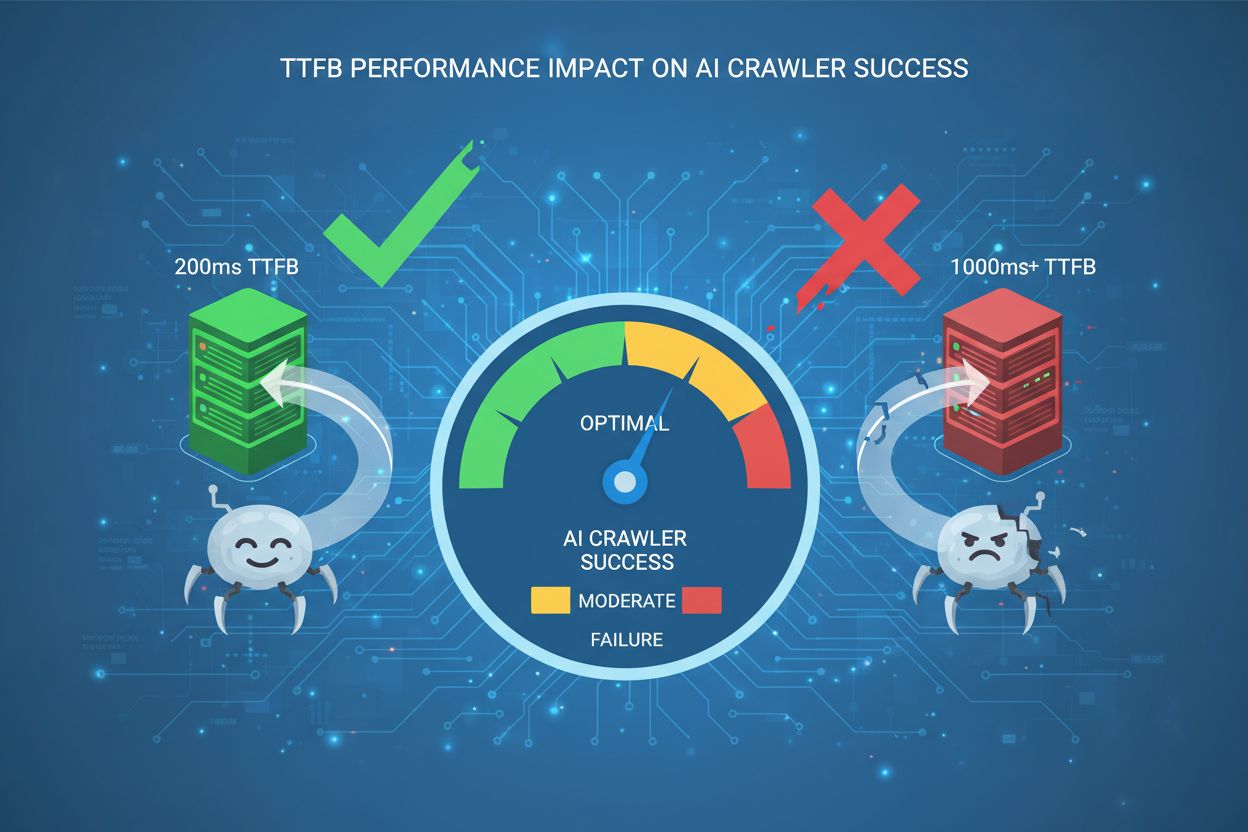

Lær, hvordan Time to First Byte påvirker AI-crawler succes. Opdag hvorfor 200ms er den gyldne grænse og hvordan du optimerer serverens svartider for bedre synlighed i AI-genererede svar.

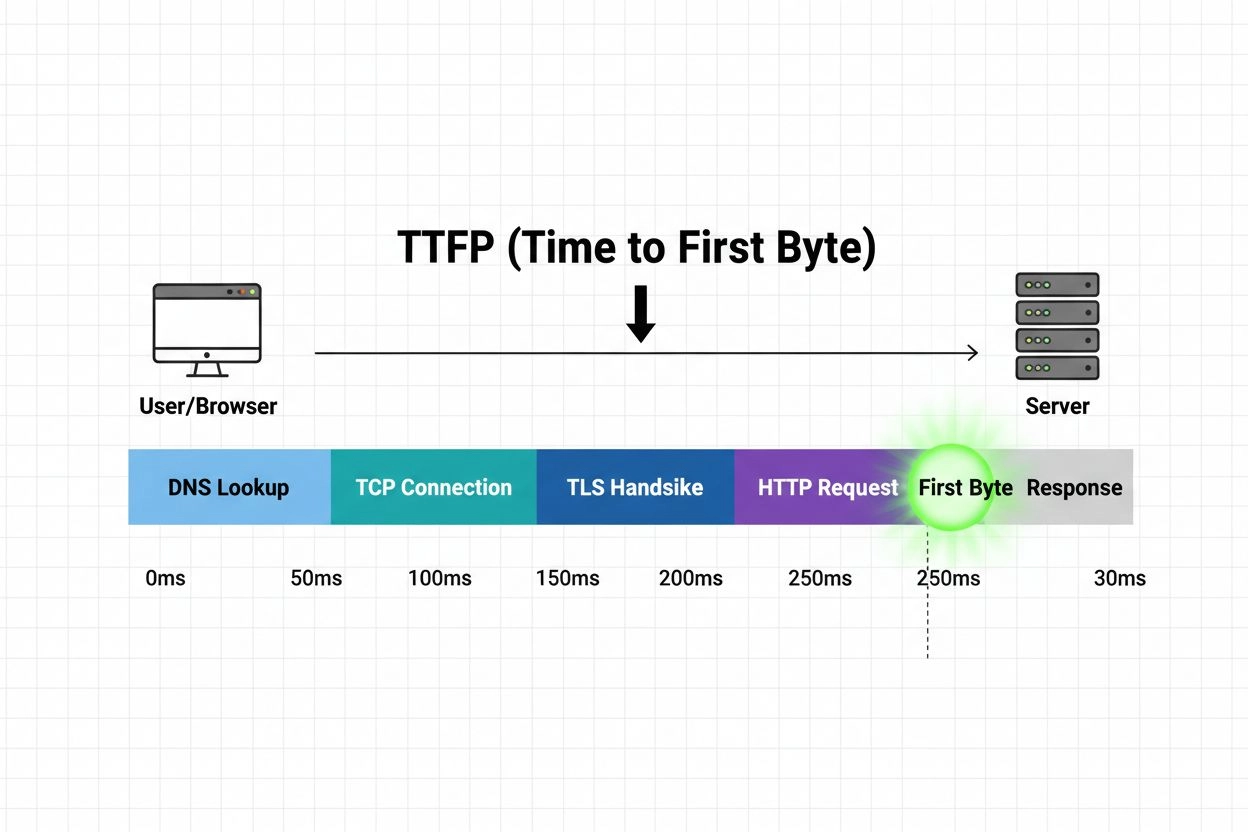

Time to First Byte (TTFB) er den tid, der går fra en brugers browser sender en HTTP-anmodning, til den første byte data modtages fra serveren. Denne måling afspejler både serverrespons og netværkslatens og er en grundlæggende indikator for hjemmesidens samlede ydeevne. For AI-crawlere, der indekserer dit indhold til GPTs, Perplexity, Google AI Overviews og andre store sprogmodeller, er TTFB kritisk, fordi det direkte afgør, hvor hurtigt disse bots kan tilgå og behandle dine sider. I modsætning til traditionelle søgemaskiner, der aggressivt cacher og crawler mindre hyppigt, arbejder AI-crawlere efter andre mønstre og prioriteter—de har brug for hurtig adgang til frisk indhold for at træne og opdatere deres modeller. En langsom TTFB tvinger AI-crawlere til at vente længere, før de overhovedet kan begynde at analysere dit indhold, hvilket kan føre til ufuldstændig indeksering, reduceret synlighed i AI-genererede svar og lavere citeringsrater. Kort sagt er TTFB den portvogter-metrik, der afgør, om AI-systemer effektivt kan opdage og indarbejde dit indhold i deres svar.

AI-crawlere fungerer grundlæggende anderledes end traditionelle søgemaskinebots som Googlebot og udviser mere aggressive crawl-mønstre og andre prioriteringsstrategier. Hvor traditionelle søgebots respekterer crawl-budgetter og fokuserer på indeksering for søgeordbaseret genfinding, prioriterer AI-crawlere indholdets friskhed og semantisk forståelse og foretager ofte flere anmodninger til de samme sider inden for kortere tidsrammer. Traditionelle bots crawler typisk et site en gang hver få uger eller måneder, mens AI-crawlere fra systemer som ChatGPT, Claude og Perplexity kan genbesøge værdifuldt indhold flere gange om ugen eller endda dagligt. Denne aggressive adfærd betyder, at din serverinfrastruktur skal kunne håndtere markant højere samtidige anmodningsvolumener alene fra AI-kilder.

| Karakteristika | Traditionelle søgebots | AI-crawlere |

|---|---|---|

| Crawl-frekvens | Ugentligt til månedligt | Dagligt til flere gange dagligt |

| Samtidig anmodning | Lav til moderat | Høj og variabel |

| Indholdsprioritet | Søgeordsrelevans | Semantisk forståelse & friskhed |

| Cache-adfærd | Aggressiv caching | Minimal caching, hyppige gen-crawls |

| Følsomhed overfor svartid | Moderat tolerance | Høj følsomhed overfor forsinkelser |

| User-Agent-mønstre | Konsistente, genkendelige | Diverse, nogle gange maskeret |

Vigtige forskelle i bot-karakteristika:

Konklusionen er klar: din infrastruktur skal optimeres ikke kun til menneskelige besøgende og traditionelle søgemaskiner, men specifikt til de krævende mønstre fra AI-crawlere. En TTFB, der er acceptabel for traditionel SEO, kan være utilstrækkelig for AI-synlighed.

TTFB-grænsen på 200ms er blevet den gyldne standard for AI-crawler succes, da det er det punkt, hvor serverens svartider forbliver hurtige nok til effektiv indholdsindtagelse uden at udløse timeout-mekanismer. Denne grænse er ikke tilfældig—den er baseret på driftskrav fra større AI-systemer, som typisk har timeout-vinduer på 5-10 sekunder for komplette sidelæsninger. Når TTFB overstiger 200ms, reduceres den resterende tid til download, parsing og behandling af sideindhold markant, hvilket øger risikoen for, at AI-crawlere opgiver anmodningen eller modtager ufuldstændige data. Forskning viser, at sites med TTFB under 200ms opnår væsentligt højere citeringsrater i AI-genererede svar, med nogle studier, der viser 40-60% forbedring i AI-synlighed sammenlignet med sider med TTFB mellem 500-1000ms. 200ms-benchmarken korrelerer også direkte med LLM-modelvalg—AI-systemer er mere tilbøjelige til at prioritere og citere indhold fra hurtigsvarende domæner, når flere kilder leverer tilsvarende information. Hver yderligere forsinkelse på 100ms forværrer problemet og mindsker sandsynligheden for, at dit indhold bliver fuldt behandlet og indarbejdet i AI-svar.

TTFB fungerer som den grundlæggende måling, som alle andre performance-indikatorer afhænger af, og påvirker direkte Largest Contentful Paint (LCP) og First Contentful Paint (FCP)—to vigtige Core Web Vitals, der påvirker både traditionelle søgeplaceringer og AI-crawler adfærd. Når TTFB er langsom, skal browseren vente længere, før den modtager den første byte HTML, hvilket forsinker hele rendering-processen og skubber LCP- og FCP-målinger ind i dårlige områder. LCP måler, hvornår det største synlige element på siden bliver interaktivt, mens FCP markerer, hvornår browseren viser det første DOM-indhold—begge målinger starter først deres tidtagning, når TTFB er gennemført. Et site med TTFB på 800ms vil have svært ved at opnå en LCP under 2,5 sekunder (Googles “god”-grænse), selv med optimeret rendering og ressourcelevering. Forholdet er multiplikativt snarere end additivt: dårlig TTFB tilføjer ikke bare forsinkelse, men forplanter sig gennem hele performance-kæden, hvilket påvirker oplevet indlæsningstid, brugerengagement og ikke mindst AI-crawler effektivitet. For AI-systemer betyder det, at langsom TTFB direkte reducerer sandsynligheden for, at dit indhold bliver fuldt indekseret og tilgængeligt for citat i AI-genererede svar.

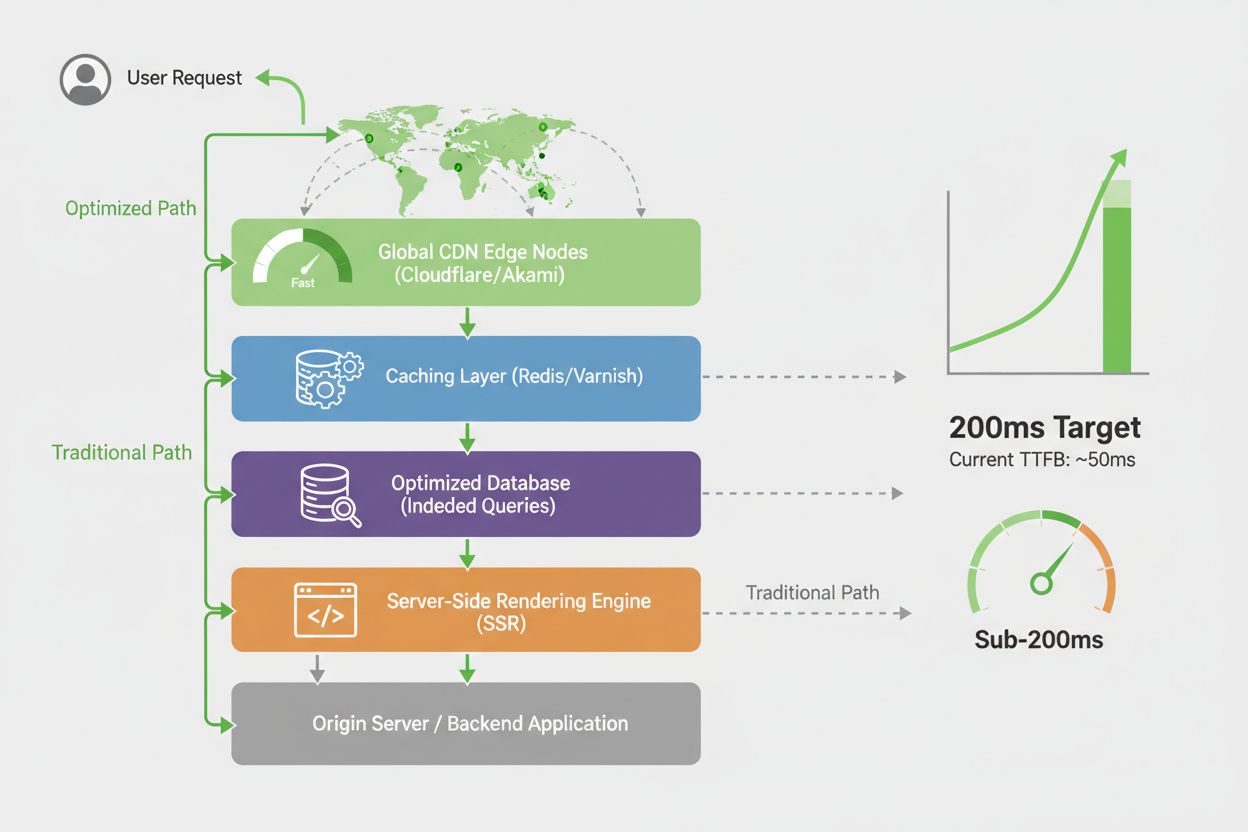

Geografisk placering og netværksinfrastruktur skaber markante variationer i TTFB på tværs af regioner, hvilket direkte påvirker, hvor effektivt AI-crawlere kan tilgå dit indhold fra forskellige steder i verden. En AI-crawler, der arbejder fra et datacenter i Singapore, kan opleve 300-400ms latenstid til en server, der hostes i Virginia, mens samme crawler, der tilgår et CDN-distribueret site, kan opnå 50-80ms latenstid via en regional edge-server. Content Delivery Networks (CDN’er) er afgørende for at opretholde konsekvent TTFB på tværs af regioner, idet de distribuerer dit indhold til edge-servere geografisk tættere på crawler-oprindelsen og reducerer antallet af nødvendige netværkshop. Uden CDN-optimering risikerer sites, der kun hostes i én region, en kritisk ulempe: AI-crawlere fra fjerntliggende geografiske områder vil opleve forringet TTFB og potentielt helt miste dit indhold, hvis timeouts udløses. Virkelige eksempler viser tydeligt denne effekt—en nyhedsorganisation, der primært betjener amerikanske brugere, men hostes på én østkystserver, kan opnå 80ms TTFB for lokale crawlere, men 400ms+ for crawlere fra Asien og Stillehavsregionen. Denne geografiske forskel betyder, at AI-systemer i forskellige regioner kan have inkonsekvent adgang til dit indhold, hvilket fører til ujævne citeringsrater og lavere global synlighed. Implementering af en global CDN-strategi sikrer, at AI-crawlere over hele verden oplever konsekvent, sub-200ms TTFB uanset deres oprindelsessted.

Nøjagtig TTFB-måling kræver de rette værktøjer og en konsekvent testmetode, da forskellige målemetoder kan give varierende resultater afhængigt af netværksforhold, serverstatus og testlokation. Flere branchestandard-værktøjer giver pålidelig TTFB-data:

Google PageSpeed Insights – Giver real-world TTFB-data fra Chrome User Experience Report, viser faktiske bruger- og crawler-målinger. Gratis, integreret med Google Search Console og afspejler, hvordan Googles systemer opfatter din sides ydeevne.

WebPageTest – Tilbyder detaljeret TTFB-måling fra flere geografiske lokationer og forbindelsestyper, så du kan teste fra regioner, hvor AI-crawlere stammer fra. Giver vandfaldsdiagrammer med eksakt tidsopdeling.

GTmetrix – Kombinerer Lighthouse og WebPageTest-data, tilbyder TTFB-målinger sammen med andre performancemålinger. Brugbar til at følge TTFB-trends over tid med historiske data og performance-anbefalinger.

Cloudflare Analytics – Hvis du bruger Cloudflares CDN, får du realtids TTFB-data fra faktisk trafik, der viser, hvordan dit site performer for rigtige crawlere og brugere i forskellige regioner.

New Relic eller Datadog – Enterprise-overvågningsløsninger, der tracker TTFB for både syntetiske tests og real user monitoring (RUM), og giver detaljeret indsigt i serverperformance og flaskehalse.

curl og kommandolinje-værktøjer – For tekniske teams kan kommandolinjeværktøjer som curl -w måle TTFB direkte, nyttigt til automatiseret overvågning og integration i CI/CD pipelines.

Når du måler TTFB, så test fra flere geografiske lokationer for at forstå regionale variationer, mål i perioder med høj trafik for at identificere flaskehalse under belastning, og etabler basismålinger før optimeringer. En ensartet målemetode sikrer, at du nøjagtigt kan spore forbedringer og identificere, når TTFB overstiger acceptable grænser.

At opnå og opretholde TTFB under 200ms kræver en flerlaget optimering, der adresserer serverinfrastruktur, cachingstrategier og indholdsleveringsmekanismer. Her er de mest effektive strategier:

Implementer server-side caching – Cache databaseforespørgsler, renderet HTML og API-svar på applikationsniveau. Redis eller Memcached kan reducere databasetilkørsler fra 50-200ms til 1-5ms og forbedre TTFB dramatisk.

Brug et globalt CDN – Distribuer statisk og dynamisk indhold til edge-servere globalt og reducer netværkslatens fra oprindelsesservere. CDN’er som Cloudflare, Akamai eller AWS CloudFront kan reducere TTFB med 60-80% for geografisk fjerne crawlere.

Optimer databaseforespørgsler – Profilér langsomme forespørgsler, tilføj relevante indekser og implementer caching af forespørgselsresultater. Databaseoptimering giver ofte de største TTFB-forbedringer, da databaseadgang ofte udgør 30-60% af serverens svartid.

Brug server-side rendering (SSR) – Pre-render indhold på serveren i stedet for at stole på klient-side JavaScript. SSR sikrer, at AI-crawlere straks modtager fuldt renderet HTML og eliminerer JavaScript-forsinkelser.

Implementer HTTP/2 eller HTTP/3 – Moderne HTTP-protokoller reducerer forbindelsesoverhead og muliggør multiplexing, hvilket forbedrer TTFB med 10-30% sammenlignet med HTTP/1.1.

Optimer serverhardware og konfiguration – Sørg for tilstrækkelige CPU-, hukommelses- og I/O-ressourcer. Fejlkonfigurerede servere med utilstrækkelige ressourcer vil konsekvent overskride TTFB-grænser uanset kodeoptimering.

Reducer påvirkningen fra tredjepartsscripts – Minimer blokerende tredjepartsscripts, der kører før serveren sender første byte. Udskyd ikke-kritiske scripts eller indlæs dem asynkront for at undgå TTFB-forsinkelser.

Implementer edge computing – Brug serverløse funktioner eller edge workers til at behandle forespørgsler tættere på brugere og crawlere, hvilket reducerer latens og forbedrer TTFB for dynamisk indhold.

Server-side rendering (SSR) er væsentligt bedre end client-side rendering (CSR) for AI-crawler tilgængelighed og TTFB-performance, da det leverer fuldt renderet HTML til crawlere med det samme i stedet for at kræve JavaScript-udførelse. Ved CSR sender serveren et minimalt HTML-skrog og JavaScript-bundles, som skal downloades, parses og eksekveres i browseren, før indholdet bliver tilgængeligt—en proces, der kan tilføje 500ms til over 2 sekunder til den tid, før AI-crawlere kan tilgå det egentlige indhold. SSR eliminerer denne forsinkelse ved at rendere hele siden på serveren, før den sendes til klienten, så første byte HTML allerede indeholder hele sidestrukturen og indholdet. For AI-crawlere med stramme timeout-vinduer er denne forskel afgørende: et CSR-site kan time ud, før JavaScript er færdig, hvilket resulterer i, at crawlere kun modtager det tomme HTML-skrog uden egentligt indhold at indeksere. SSR giver også mere konsekvent TTFB på tværs af netværksforhold, da rendering kun sker én gang på serveren i stedet for at afhænge af klient-side JavaScript-performance. Selvom SSR kræver flere serverressourcer og omhyggelig implementering, gør performancefordelene for AI-crawler succes det essentielt for sites, der prioriterer AI-synlighed. Hybride tilgange, hvor SSR bruges til første sidelæsning kombineret med klient-side hydration, kan give det bedste fra begge verdener—hurtig TTFB for crawlere og interaktive oplevelser for brugere.

Den praktiske effekt af TTFB-optimering på AI-synlighed er betydelig og målbar på tværs af brancher og indholdstyper. En teknologinyhedsudgiver reducerede TTFB fra 850ms til 180ms gennem CDN-implementering og databaseoptimering, hvilket resulterede i en stigning på 52% i citater inden for AI-genererede artikler over tre måneder. En e-handelsside med produktinformation forbedrede TTFB fra 1,2 sekunder til 220ms ved at implementere Redis-caching af produktdata og skifte til SSR for kategorisider, hvilket gav en tilsvarende stigning på 38% i produktomtaler i AI-shoppingassistenter. En forskningsinstitution, der publicerer akademiske artikler, opnåede TTFB under 150ms gennem edge computing og statisk sidegenerering, hvilket gjorde deres artikler til hyppigere citater i AI-genererede forskningsoverblik og litteraturgennemgange. Disse forbedringer blev ikke opnået gennem enkeltstående optimeringer, men gennem systematiske tilgange, der adresserede flere TTFB-flaskehalse samtidigt. Fælles for succesfulde implementeringer er, at hver 100ms reduktion i TTFB korrelerer med målbare stigninger i AI-crawler succesrate og citeringshyppighed. Organisationer, der fastholder TTFB konsekvent under 200ms, rapporterer 3-5 gange højere synlighed i AI-genereret indhold sammenlignet med konkurrenter med TTFB over 800ms, hvilket viser, at denne grænse direkte omsættes til forretningsværdi gennem øget AI-drevet trafik og citater.

Etablering af solid TTFB-overvågning er afgørende for at opretholde optimal performance og hurtigt identificere forringelser, før de påvirker AI-crawler succes. Start med at sætte basismålinger ved hjælp af værktøjer som WebPageTest eller Google PageSpeed Insights, mål TTFB fra flere geografiske lokationer for at forstå regionafhængige forskelle og identificere problemområder. Implementer kontinuerlig overvågning med syntetiske tests, der regelmæssigt måler TTFB fra forskellige regioner og netværksforhold, og giv dit team besked, når målinger overstiger grænseværdier—de fleste organisationer bør sætte alarmer ved 250ms for at fange problemer, før de når 200ms-grænsen. Real User Monitoring (RUM) giver supplerende data om faktisk TTFB oplevet af crawlere og brugere og afslører performancevariationer, som syntetiske tests måske ikke fanger. Etabler en testproces for ændringer: mål TTFB-effekt i staging-miljøer, før du udruller infrastruktur- eller kodeændringer, så du sikrer, at optimeringer faktisk forbedrer performance og ikke indfører regressioner. Opret et performancedashboard, som hele dit team kan se, så TTFB bliver et fælles ansvar og ikke kun et teknisk anliggende. Planlæg regelmæssige performance reviews—månedligt eller kvartalsvist—for at analysere trends, identificere kommende flaskehalse og planlægge optimeringsinitiativer. Denne kontinuerlige forbedringsmentalitet sikrer, at TTFB forbliver optimeret efterhånden som dit site vokser, trafikmønstre ændrer sig og nye funktioner tilføjes.

AmICited.com tilbyder specialiseret overvågning af, hvordan AI-systemer citerer og refererer dit indhold og giver unikke indsigter i forholdet mellem TTFB og AI-synlighed, som generelle performanceværktøjer ikke kan levere. Hvor traditionelle overvågningsværktøjer måler TTFB isoleret, tracker AmICited, hvordan TTFB-performance direkte korrelerer med citeringsfrekvens på tværs af GPTs, Perplexity, Google AI Overviews og andre større AI-systemer. Platformen overvåger AI-crawler adfærd, identificerer hvornår crawlere tilgår dit indhold, hvor ofte de vender tilbage, og om langsom TTFB fører til ufuldstændig indeksering eller timeouts. AmICiteds analyser viser, hvilket indhold der får citater i AI-genererede svar, så du kan koble disse data med dine TTFB-målinger og forstå den direkte forretningsmæssige effekt af performanceoptimering. Platformen giver besked, når AI-crawler adgangsmønstre ændrer sig, hvilket potentielt indikerer TTFB-problemer eller andre tekniske forhold, der påvirker AI-synlighed. For organisationer, der vil maksimere AI-drevet trafik og citater, tilbyder AmICited den nødvendige indsigt til at forstå, om TTFB-optimeringer faktisk omsættes til forbedret AI-synlighed. Ved at kombinere AmICiteds AI-citationsovervågning med traditionelle TTFB-måleværktøjer får du et komplet billede af, hvordan serverperformance direkte påvirker din tilstedeværelse i AI-genereret indhold—det vigtigste mål for moderne indholdssynlighed.

Den gyldne standard for TTFB til AI-crawler succes er under 200ms. Denne grænse sikrer, at AI-systemer effektivt kan tilgå og behandle dit indhold inden for deres timeout-vinduer. TTFB mellem 200-500ms er acceptabelt, men ikke optimalt, mens TTFB over 800ms markant reducerer AI-synlighed og citeringsrater.

TTFB fungerer som en kvalificerende faktor for AI-inklusion snarere end et direkte rangeringssignal. Langsom TTFB kan få AI-crawlere til at time ud eller modtage ufuldstændigt indhold, hvilket mindsker sandsynligheden for, at dine sider bliver indekseret og citeret. Sider med TTFB under 200ms oplever 40-60% højere citeringsrater sammenlignet med langsommere konkurrenter.

Ja, flere optimeringer kan forbedre TTFB uden at skifte webhotel: implementer server-side caching (Redis/Memcached), brug et CDN, optimer databaseforespørgsler, aktiver HTTP/2, og minimer render-blokerende scripts. Disse ændringer giver ofte 30-50% forbedring af TTFB. Dog kan delt hosting have indbyggede begrænsninger, der forhindrer at nå 200ms-grænsen.

Brug værktøjer som Google PageSpeed Insights, WebPageTest, GTmetrix eller Cloudflare Analytics til at måle TTFB. Test fra flere geografiske lokationer for at forstå regionale forskelle. Etabler basismålinger før optimeringer og overvåg løbende med syntetiske tests og real user monitoring for at spore forbedringer.

Begge har betydning, men de tjener forskellige formål. Indholdskvalitet afgør, om AI-systemer ønsker at citere dit indhold, mens TTFB afgør, om de effektivt kan tilgå det. Fremragende indhold med dårlig TTFB bliver måske aldrig indekseret, mens middelmådigt indhold med fremragende TTFB altid er tilgængeligt. Optimer begge dele for maksimal AI-synlighed.

Implementer kontinuerlig overvågning med alarmer sat til 250ms for at fange problemer, før de påvirker AI-synlighed. Udfør detaljerede performance reviews månedligt eller kvartalsvist for at identificere tendenser og planlægge optimeringer. Overvåg hyppigere under større infrastrukturændringer eller trafikspidser for at sikre, at TTFB forbliver stabil.

TTFB måler kun tiden indtil den første byte af svaret ankommer fra serveren, mens sideindlæsningstid inkluderer download af alle ressourcer, rendering og JavaScript-udførelse. TTFB er fundamentalt—det er udgangspunktet for alle andre performancemålinger. Hurtig TTFB er nødvendig, men ikke tilstrækkelig for hurtige samlede indlæsningstider.

Geografisk afstand mellem crawlerens oprindelse og din server påvirker TTFB markant. En crawler i Singapore, der tilgår en server i Virginia, kan opleve 300-400ms latenstid, mens et CDN-distribueret site opnår 50-80ms via regionale edge-servere. Implementering af et globalt CDN sikrer konsekvent TTFB under 200ms uanset crawlerens oprindelseslokation.

Følg, hvordan AI-crawlere tilgår dit site og optimer for bedre synlighed i AI-svar. AmICited hjælper dig med at forstå det direkte forhold mellem TTFB og AI-citater.

Opdag de kritiske faktorer, der påvirker AI-indekseringshastighed, herunder websitets ydeevne, crawl-budget, indholdsstruktur og teknisk optimering. Lær hvordan...

Lær dokumenterede strategier til at øge, hvor ofte AI-crawlere besøger din hjemmeside, forbedre indholdsopdagelse i ChatGPT, Perplexity og andre AI-søgemaskiner...

Fællesskabsdiskussion om at øge AI-crawleres frekvens. Rigtige data og strategier fra webmasters, der har forbedret hvor ofte ChatGPT, Perplexity og andre AI-cr...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.