Differentiel Crawler-adgang

Lær at tillade eller blokere AI-crawlere selektivt baseret på forretningsmål. Implementer differentiel crawler-adgang for at beskytte indhold, mens synligheden ...

Lær hvordan webapplikationsfirewalls giver avanceret kontrol over AI-crawlere ud over robots.txt. Implementer WAF-regler for at beskytte dit indhold mod uautoriseret AI-scraping og overvåg AI-citater med AmICited.

Utilstrækkeligheden af robots.txt som et enkeltstående forsvarsmiddel er blevet stadig mere tydelig i en tid med AI-drevet indholdsforbrug. Hvor traditionelle søgemaskiner generelt respekterer robots.txt-direktiver, opererer moderne AI-crawlere med fundamentalt andre incitamenter og håndhævelsesmekanismer, hvilket gør simple tekstbaserede politikker utilstrækkelige til indholdsbeskyttelse. Ifølge Cloudflares analyse udgør AI-crawlere nu næsten 80% af al bottrafik til websites, hvor træningscrawlere forbruger enorme mængder indhold og returnerer minimal henvisningstrafik—OpenAI’s crawlere opretholder et crawl-til-henvisningsforhold på 400:1, mens Anthropics når op på hele 38.000:1. For udgivere og indholdsejere udgør dette asymmetriske forhold en kritisk forretningstrussel, da AI-modeller, der er trænet på deres indhold, direkte kan reducere organisk trafik og mindske værdien af deres intellektuelle ejendom.

En Web Application Firewall (WAF) fungerer som en reverse proxy placeret mellem brugere og webservere, hvor den i realtid inspicerer hver HTTP-forespørgsel for at filtrere uønsket trafik baseret på konfigurerbare regler. I modsætning til robots.txt, der bygger på frivillig crawler-overholdelse, håndhæver WAF’er beskyttelse på infrastrukturniveau, hvilket gør dem markant mere effektive til at kontrollere AI-crawler-adgang. Følgende sammenligning illustrerer, hvordan WAF’er adskiller sig fra traditionelle sikkerhedstilgange:

| Funktion | Robots.txt | Traditionel firewall | Moderne WAF |

|---|---|---|---|

| Håndhævelsesniveau | Vejledende/frivillig | IP-baseret blokering | Applikationsbevidst inspektion |

| AI-crawlerdetektion | Kun user-agent-match | Begrænset botgenkendelse | Adfærdsanalyse + fingerprinting |

| Realtids-tilpasning | Statisk fil | Kræver manuelle opdateringer | Kontinuerlig trusselsefterretning |

| Granulær kontrol | Kun på stiniveau | Bredt IP-område | Politik på forespørgselsniveau |

| Maskinlæring | Ingen | Ingen | Avanceret botklassificering |

WAF’er giver granulær botklassificering ved brug af device fingerprinting, adfærdsanalyse og maskinlæring til at profilere bots ud fra hensigt og sofistikering, hvilket giver langt mere nuanceret kontrol end simple tillad/bloker-regler.

AI-crawlere falder i tre forskellige kategorier, der hver især udgør forskellige trusler og kræver forskellige afværgestrategier. Træningscrawlere som GPTBot, ClaudeBot og Google-Extended indsamler systematisk webindhold for at opbygge datasæt til udvikling af store sprogmodeller, hvilket tegner sig for ca. 80% af al AI-crawlertrafik og returnerer ingen henvisningsværdi til udgivere. Søge- og citatcrawlere som OAI-SearchBot og PerplexityBot indekserer indhold til AI-drevne søgeoplevelser og kan give visse henvisninger via citater, dog i markant lavere omfang end traditionelle søgemaskiner. Brugerudløste fetchers aktiveres kun, når brugere specifikt anmoder om indhold via AI-assistenter, og opererer i meget lav volumen med enkeltstående forespørgsler frem for systematisk crawling. Trusselsbilledet omfatter:

Moderne WAF’er anvender sofistikerede tekniske detektionsmetoder, der rækker langt ud over simpel user-agent-string-match for at identificere og klassificere AI-crawlere med høj præcision. Disse systemer benytter adfærdsanalyse til at undersøge forespørgselsmønstre, herunder crawl-hastighed, sekvensering af forespørgsler og responsbehandling, som adskiller bots fra menneskelige brugere. Device fingerprinting analyserer HTTP-headere, TLS-signaturer og browserkarakteristika for at identificere forfalskede user-agents, der forsøger at omgå traditionelle forsvar. Maskinlæringsmodeller trænet på millioner af forespørgsler kan i realtid opdage nye crawler-signaturer og bot-taktikker, og tilpasse sig nye trusler uden manuelle regelopdateringer. Derudover kan WAF’er verificere crawler-legitimitet ved at krydstjekke forespørgsels-IP-adresser mod officielle IP-intervaller vedligeholdt af store AI-virksomheder—OpenAI offentliggør verificerede IP’er på https://openai.com/gptbot.json, mens Amazon tilbyder deres på https://developer.amazon.com/amazonbot/ip-addresses/—og sikrer, at kun autentificerede crawlere fra legitime kilder tillades.

Effektiv implementering af WAF-regler for AI-crawlere kræver en flerlaget tilgang, der kombinerer user-agent-blokering, IP-verifikation og adfærdspolitikker. Følgende kodeeksempel viser en grundlæggende WAF-regelkonfiguration, der blokerer kendte træningscrawlere, mens legitim søgefunktionalitet tillades:

# WAF-regel: Blokér AI-træningscrawlere

Regelnavn: Block-AI-Training-Crawlers

Betingelse 1: HTTP User-Agent matcher (GPTBot|ClaudeBot|anthropic-ai|Google-Extended|Meta-ExternalAgent|Amazonbot|CCBot|Bytespider)

Handling: Blokér (returner 403 Forbidden)

# WAF-regel: Tillad verificerede søge-crawlere

Regelnavn: Allow-Verified-Search-Crawlers

Betingelse 1: HTTP User-Agent matcher (OAI-SearchBot|PerplexityBot)

Betingelse 2: Kilde-IP i verificeret IP-interval

Handling: Tillad

# WAF-regel: Rate limit mistænkelig bottrafik

Regelnavn: Rate-Limit-Suspicious-Bots

Betingelse 1: Forespørgselsrate overstiger 100 forespørgsler/minut

Betingelse 2: User-Agent indeholder bot-indikatorer

Betingelse 3: Ingen verificeret IP-match

Handling: Udfordring (CAPTCHA) eller blokér

Organisationer bør implementere regelpræcedens omhyggeligt, så mere specifikke regler (som IP-verifikation for legitime crawlere) kører før bredere blokeringer. Regelmæssig test og overvågning af regelets effektivitet er essentiel, da crawler-user-agenter og IP-intervaller ofte ændres. Mange WAF-udbydere tilbyder forudbyggede regelsæt specifikt designet til AI-crawlerstyring, hvilket reducerer kompleksiteten og samtidig opretholder omfattende beskyttelse.

IP-verifikation og tilladelseslister er den mest pålidelige metode til at skelne legitime AI-crawlere fra forfalskede forespørgsler, da user-agent-strenge nemt kan forfalskes, mens IP-adresser er langt sværere at spoofe i stor skala. Store AI-virksomheder offentliggør officielle IP-intervaller i JSON-format, hvilket muliggør automatiseret verifikation uden manuel vedligeholdelse—OpenAI tilbyder separate IP-lister for GPTBot, OAI-SearchBot og ChatGPT-User, mens Amazon har en samlet liste for Amazonbot. WAF-regler kan konfigureres til kun at tillade forespørgsler fra disse verificerede IP-intervaller, hvilket effektivt forhindrer ondsindede aktører i at omgå restriktioner blot ved at ændre user-agent-headeren. For organisationer, der bruger serverniveau-blokering via .htaccess eller firewall-regler, giver kombination af IP-verifikation med user-agent-match et lagdelt forsvar, som virker uafhængigt af WAF-konfiguration. Ydermere respekterer nogle crawlere HTML meta-tags som <meta name="robots" content="noarchive">, hvilket signalerer til kompatible crawlere, at indholdet ikke må anvendes til modeltræning, og giver en supplerende kontrolmekanisme til udgivere, der ønsker detaljeret, side-for-side-beskyttelse.

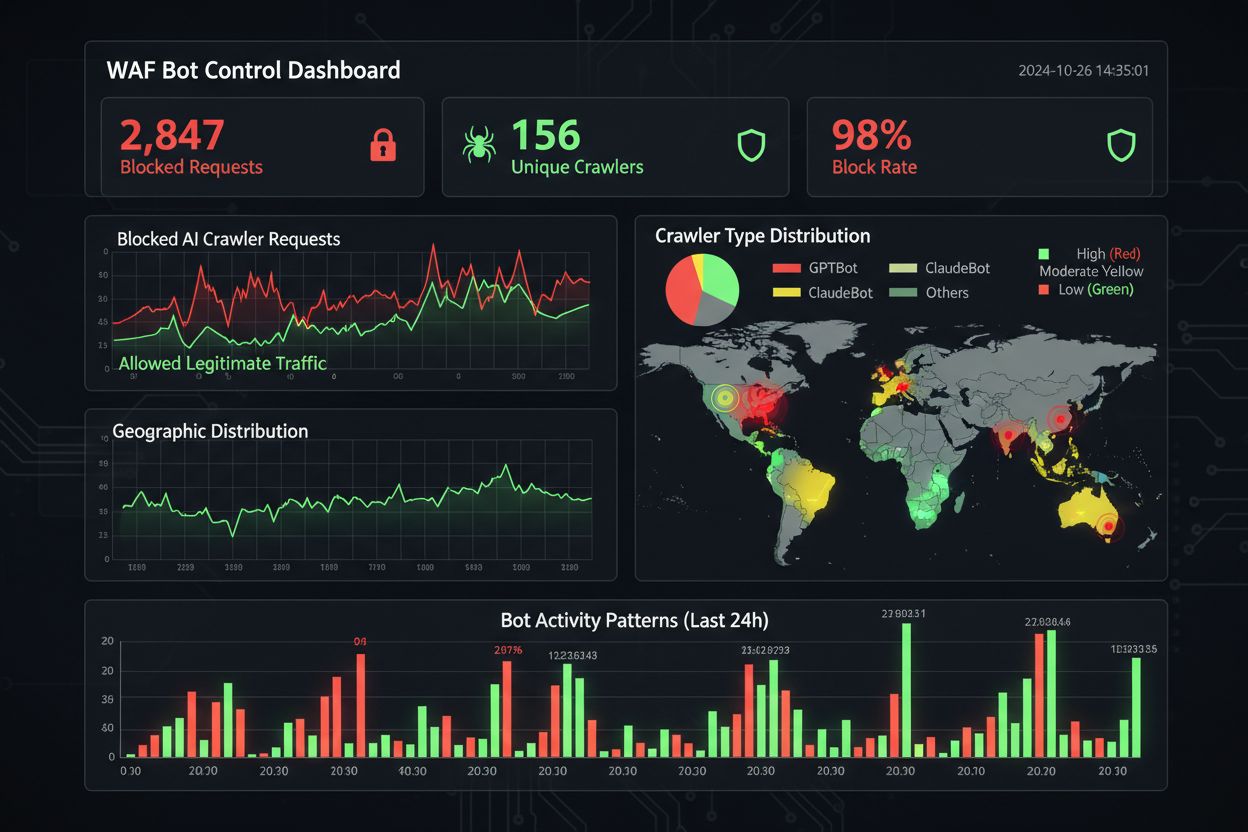

Effektiv overvågning og compliance kræver kontinuerligt overblik over crawleraktivitet og verifikation af, at blokering fungerer efter hensigten. Organisationer bør regelmæssigt analysere server access logs for at identificere, hvilke crawlere der tilgår deres sites, og om blokerede crawlere stadig forsøger at tilgå—Apache-logs ligger typisk i /var/log/apache2/access.log, mens Nginx-logs findes i /var/log/nginx/access.log, og grep-baseret filtrering kan hurtigt identificere mistænkelige mønstre. Analyseplatforme skelner i stigende grad mellem bottrafik og menneskelige besøgende, så teams kan måle effekten af crawler-blokering på legitime målepunkter som bounce rate, konverteringssporing og SEO-performance. Værktøjer som Cloudflare Radar giver globalt overblik over AI-bottrafik og kan identificere nye crawlere, der endnu ikke er på din blokliste. Set fra et compliance-perspektiv genererer WAF-logs revisionsspor, der viser, at organisationen har implementeret rimelige sikkerhedsforanstaltninger til at beskytte kundedata og intellektuel ejendom, hvilket er stadigt vigtigere for GDPR, CCPA og andre databeskyttelsesregler. Kvartalsvise gennemgange af din crawler-blokliste er afgørende, da der løbende opstår nye AI-crawlere og eksisterende crawlere opdaterer deres user-agent-strenge—det community-drevne ai.robots.txt-projekt på GitHub

er en værdifuld ressource til at overvåge nye trusler.

At balancere indholdsbeskyttelse med forretningsmål kræver omhyggelig analyse af, hvilke crawlere der skal blokeres eller tillades, da for aggressiv blokering kan mindske synligheden i nye AI-drevne kanaler. At blokere træningscrawlere som GPTBot og ClaudeBot beskytter intellektuel ejendom, men har ingen direkte trafikpåvirkning, da disse crawlere aldrig sender henvisningstrafik. Til gengæld kan blokering af søge-crawlere som OAI-SearchBot og PerplexityBot reducere synligheden i AI-drevne søgeresultater, hvor brugere aktivt søger citater og kilder—et kompromis, der afhænger af din indholdsstrategi og målgruppe. Nogle udgivere udforsker alternative tilgange, såsom at tillade søge-crawlere, mens de blokerer træningscrawlere, eller implementerer pay-per-crawl-modeller, hvor AI-virksomheder kompenserer udgivere for adgang til indhold. Værktøjer som AmICited.com hjælper udgivere med at spore, om deres indhold citeres i AI-genererede svar, og giver data til at informere blokkeringsbeslutninger. Den optimale WAF-konfiguration afhænger af forretningsmodellen: nyhedsudgivere kan prioritere at blokere træningscrawlere for at beskytte indholdet, mens de tillader søge-crawlere for synlighed, mens SaaS-virksomheder måske vælger at blokere alle AI-crawlere for at forhindre konkurrentanalyse af priser og funktioner. Regelmæssig overvågning af trafikmønstre og indtægtsmålepunkter efter implementering af WAF-regler sikrer, at din beskyttelsesstrategi stemmer overens med faktiske forretningsresultater.

Når man sammenligner WAF-løsninger til AI-crawlerstyring, bør organisationer vurdere flere nøglefunktioner, der adskiller erhvervsplatforme fra basale tilbud. Cloudflares AI Crawl Control integrerer med dets WAF for at tilbyde forudbyggede regler for kendte AI-crawlere, med mulighed for at blokere, tillade eller implementere pay-per-crawl for specifikke crawlere—platformens regelpræcedens sikrer, at WAF-regler kører før andre sikkerhedslag. AWS WAF Bot Control tilbyder både grundlæggende og målrettet beskyttelse, hvor det målrettede niveau bruger browser-interrogation, fingerprinting og adfærdsheuristik til at opdage sofistikerede bots, der ikke selv-identificerer, samt valgfri maskinlæringsanalyse af trafikstatistik. Azure WAF giver lignende muligheder med sine managed rule sets, dog med mindre AI-specialisering end Cloudflare eller AWS. Ud over disse større platforme tilbyder specialiserede bot management-løsninger fra leverandører som DataDome avancerede maskinlæringsmodeller, der er trænet specifikt på AI-crawleradfærd, dog til en højere pris. Valget mellem løsninger afhænger af din eksisterende infrastruktur, budget og det ønskede sofistikeringsniveau—organisationer, der allerede bruger Cloudflare, får fordel af problemfri integration, mens AWS-kunder kan udnytte Bot Control i deres eksisterende WAF-infrastruktur.

Best practices for AI-crawlerstyring understreger en defense-in-depth-tilgang, hvor flere kontrolmekanismer kombineres frem for at stole på én enkelt løsning. Organisationer bør gennemføre kvartalsvise bloklistegennemgange for at fange nye crawlere og opdaterede user-agent-strenge, opretholde serverlog-analyse for at verificere, at blokerede crawlere ikke omgår regler, og regelmæssigt teste WAF-konfigurationer for at sikre, at regler eksekveres i korrekt rækkefølge. Fremtiden for WAF-teknologi vil i stigende grad omfatte AI-drevet trusselsdetektion, der i realtid tilpasser sig nye crawler-taktikker, med integration i bredere sikkerhedsøkosystemer for kontekstbevidst beskyttelse. I takt med at reguleringen strammes omkring dataskrabning og AI-træningsdata, bliver WAF’er essentielle compliance-værktøjer frem for valgfrie sikkerhedsfunktioner. Organisationer bør begynde at implementere omfattende WAF-regler for AI-crawlere allerede nu, før nye trusler som browserbaserede AI-agenter og headless-browser-crawlere bliver udbredte—prisen for inaktivitet, målt i tabt trafik, kompromitteret analyse og potentiel juridisk eksponering, overstiger langt investeringen i et robust beskyttelsesinfrastruktur.

Robots.txt er en vejledende fil, der bygger på at crawlere frivilligt respekterer dine direktiver, mens WAF-regler håndhæves på infrastrukturniveau og gælder for alle forespørgsler uanset crawlerens overholdelse. WAF'er giver realtidsdetektion og blokering, hvorimod robots.txt er statisk og nemt kan omgås af ikke-kompatible crawlere.

Ja, mange AI-crawlere ignorerer robots.txt-direktiver, fordi de er designet til at maksimere indsamling af træningsdata. Velopdragne crawlere fra store virksomheder respekterer generelt robots.txt, men ondsindede aktører og nogle nye crawlere gør ikke. Derfor giver WAF-regler mere pålidelig beskyttelse.

Tjek dine server access logs (typisk i /var/log/apache2/access.log eller /var/log/nginx/access.log) for user-agent-strenge, der indeholder bot-identifikatorer. Værktøjer som Cloudflare Radar giver globalt overblik over AI-crawler trafikmønstre, og analyseplatforme skelner i stigende grad mellem bottrafik og menneskelige besøgende.

Blokering af træningscrawlere som GPTBot har ingen direkte SEO-effekt, da de ikke sender henvisningstrafik. Men blokering af søge-crawlere som OAI-SearchBot kan reducere synligheden i AI-drevne søgeresultater. Googles AI Overviews følger standard Googlebot-regler, så blokering af Google-Extended påvirker ikke almindelig søgeindeksering.

Cloudflares AI Crawl Control, AWS WAF Bot Control og Azure WAF tilbyder alle effektive løsninger. Cloudflare har de mest AI-specifikke funktioner med forudbyggede regler og pay-per-crawl-muligheder. AWS tilbyder avanceret maskinlæringsdetektion, mens Azure har solide managed rule sets. Vælg ud fra din eksisterende infrastruktur og dit budget.

Gennemgå og opdater dine WAF-regler mindst kvartalsvist, da nye AI-crawlere opstår løbende og eksisterende crawlere opdaterer deres user-agent-strenge. Overvåg det community-drevne ai.robots.txt-projekt på GitHub for nye trusler, og tjek serverlogfiler månedligt for at identificere nye crawlere, der rammer dit site.

Ja, dette er en almindelig strategi. Du kan konfigurere WAF-regler til at blokere træningscrawlere som GPTBot og ClaudeBot, mens du tillader søge-crawlere som OAI-SearchBot og PerplexityBot. Dette beskytter dit indhold mod at blive brugt i modeltræning, mens du bevarer synlighed i AI-drevne søgeresultater.

WAF-priser varierer afhængigt af udbyder. Cloudflare tilbyder WAF fra $20/måned med AI Crawl Control-funktioner. AWS WAF opkræver pr. web ACL og regel, typisk $5-10/måned for grundbeskyttelse. Azure WAF er inkluderet i Application Gateway. Implementeringsomkostningerne er minimale i forhold til værdien ved at beskytte dit indhold og bevare præcise analyser.

AmICited sporer AI-crawler aktivitet og overvåger, hvordan dit indhold citeres på tværs af ChatGPT, Perplexity, Google AI Overviews og andre AI-platforme. Få synlighed i din AI-tilstedeværelse og forstå, hvilke crawlere der får adgang til dit indhold.

Lær at tillade eller blokere AI-crawlere selektivt baseret på forretningsmål. Implementer differentiel crawler-adgang for at beskytte indhold, mens synligheden ...

Fællesskabsdiskussion om konfiguration af robots.txt til AI-crawlere som GPTBot, ClaudeBot og PerplexityBot. Reelle erfaringer fra webansvarlige og SEO-speciali...

Opdag hvordan stealth crawlere omgår robots.txt-direktiver, de tekniske mekanismer bag crawler-unddragelse, og løsninger til at beskytte dit indhold mod uautori...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.