Perplexity AI

Perplexity AI er en AI-drevet svarmotor, der kombinerer realtidssøgning på nettet med LLM'er for at levere citerede, præcise svar. Lær hvordan den fungerer og d...

Jeg har brugt Perplexity meget og forsøger at reverse-engineere, hvordan det fungerer. Det er tydeligvis anderledes end både traditionel søgning og ChatGPT.

Hvad jeg har observeret:

Mit gæt på arkitekturen:

Hvad jeg forsøger at forstå:

Leder efter nogen, der har studeret Perplexitys arkitektur i dybden.

Daniel, dit arkitektur-gæt er ret tæt på. Lad mig tilføje detaljer:

Den firetrins pipeline:

| Trin | Funktion | Teknologi |

|---|---|---|

| Forespørgselsbehandling | Intentionsgenkendelse, entitetsudtræk | NLP + tokenisering |

| Informationshentning | Søg webindeks for relevante dokumenter | Semantisk søgning + API’er |

| Svargenerering | Syntetiser fra hentet indhold | LLM (GPT-4, Claude) |

| Forfinelse | Faktatjek, formatering, forslag til opfølgning | Efterbehandling |

Trin 1: Forespørgselsbehandling

Ikke kun nøgleordsudtræk:

Eksempel: “Seneste udvikling inden for kvantecomputing” →

Trin 2: Hentning

Bruger semantisk søgning, ikke kun nøgleords-match. Et dokument om “kunstig neurale netværk” kan hentes på en “deep learning”-forespørgsel, fordi den semantiske betydning er ens.

Den semantiske søgedel er interessant. Så den bruger embeddings til at finde konceptuelt relateret indhold, ikke kun nøgleordsmatch?

Og til svargenereringen – bruger den flere kilder samtidigt eller behandles de sekventielt?

Embedding-baseret hentning:

Ja, præcis. Processen:

Multi-kildebehandling:

Perplexity behandler kilder parallelt, ikke sekventielt:

Hentede dokumenter (5-10 kilder)

↓

Parallel udtrækning af relevante passager

↓

Passager rangeres efter relevans

↓

Kombineret kontekst + forespørgsel → LLM

↓

Syntetiseret svar med inline citater

Citeringsmekanismen:

Når LLM’et genererer hvert udsagn, opretholder det kildehenvisning. Derfor vises citater inline – modellen sporer, hvilken kilde der understøtter hvert udsagn.

Konfliktløsning:

Når kilder er uenige, gør Perplexity ofte:

LLM-laget fortjener mere analyse.

Modellvalg:

Perplexity bruger flere LLM’er:

Sådan genererer LLM’et citerede svar:

LLM’et kopierer ikke bare tekst. Det:

Eksempeltransformation:

Kilde 1: “Kvantecomputere bruger qubits, som kan eksistere i superposition.” Kilde 2: “De største aktører inkluderer IBM, Google og IonQ.” Kilde 3: “Seneste gennembrud viser 1000+ qubit-processorer.”

Perplexity-output: “Kvantecomputere udnytter qubits, der opererer i superpositions-tilstande [1]. Branchens ledere IBM, Google og IonQ [2] har for nylig opnået gennembrud inklusive 1000+ qubit-processorer [3].”

Syntesen skaber ny tekst, mens korrekt kildehenvisning opretholdes.

For indholdsskabere – her er hvad der betyder noget for at blive citeret:

Faktorer for kildeudvælgelse:

| Faktor | Vægt | Sådan optimeres |

|---|---|---|

| Relevans | Meget høj | Svar på præcise spørgsmål direkte |

| Troværdighed | Høj | Forfatteroplysninger, institutionel støtte |

| Aktualitet | Høj | Opdateringsdatoer, frisk indhold |

| Klarhed | Høj | Struktureret, let-udtrækkeligt format |

| Domæneautoritet | Medium | Opbyg sides autoritet |

Format der bliver citeret:

Perplexity udtrækker bedst information fra:

Hvad springes over:

Quick Search vs Pro Search – den tekniske forskel:

Quick Search:

Pro Search:

Opgavedelingen:

Pro Search deler komplekse forespørgsler op i underforespørgsler:

“Bedste CRM til healthcare startups med HIPAA overholdelse” bliver til:

Hver underforespørgsel henter forskellige kilder, og resultaterne kombineres bagefter.

Hallucinationsforebyggelse i Perplexity:

Sådan reduceres hallucinationer:

Begrænsningen:

Perplexity kan stadig hallucinere hvis:

Sammenlignet med ChatGPT:

| Aspekt | Perplexity | ChatGPT |

|---|---|---|

| Realtids-hentning | Ja | Begrænset (plugins) |

| Citering påkrævet | Altid | Valgfrit |

| Vidensgrænse | Ingen (live) | Træningsdato |

| Hallucinationsrisiko | Lavere | Højere |

Den tvungne citeringsmekanisme er Perplexitys vigtigste forsvar mod hallucinationer.

Det kontekstuelle hukommelsessystem:

Inden for en session:

Perplexity husker samtalehistorik:

Eksempel: Q1: “Hvad er de seneste udviklinger inden for kvantecomputing?” Q2: “Hvordan sammenlignes dette med klassisk computing?”

Ved Q2 forstår Perplexity, at “dette” henviser til kvantecomputing fra Q1.

Opmærksomhedsmekanismen:

Bruger attention weights til at afgøre, hvilken tidligere kontekst er relevant for ny forespørgsel. Ikke alt videreføres – kun kontekstuelt relevante dele.

Begrænsningen:

Hukommelsen er kun sessionsbaseret. Lukker du samtalen = kontekst tabt. Ingen vedvarende personalisering på tværs af sessioner.

Dette er et privatlivsvalg, ikke en teknisk begrænsning.

Fokus-tilstand er undervurderet til at forstå Perplexitys arkitektur:

Tilgængelige fokusområder:

| Fokus | Kildepool | Bedst til |

|---|---|---|

| Alle | Hele nettet | Generelle forespørgsler |

| Akademisk | Forskningartikler | Videnskabelige spørgsmål |

| Kun Reddit | Fællesskabsmeninger | |

| YouTube | Videoinhold | How-to, tutorials |

| Nyheder | Nyhedsmedier | Aktuelle begivenheder |

| Skrivning | (ingen) | Ingen hentning, ren generering |

Hvad det viser:

Fokus-tilstand viser, at Perplexity kan begrænse sin hentning til specifikke kildepools. Det betyder, at de har:

Til optimering:

Hvis du vil have akademiske citater – sørg for, at din forskning er indekseret i akademiske databaser. Hvis du vil have generelle citater – fokuser på web-tilgængeligt indhold.

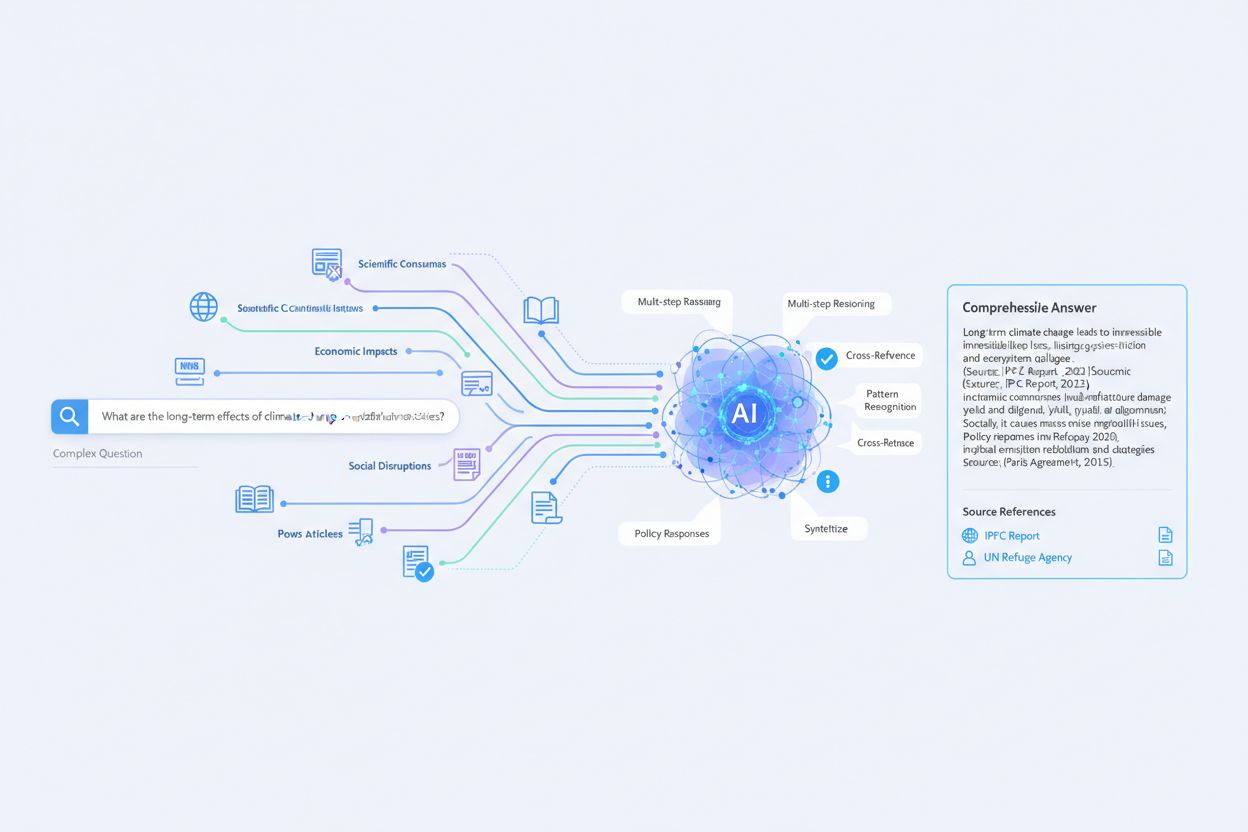

Denne tråd udfyldte hullerne i min forståelse. Her er mit opdaterede arkitekturdiagram:

Perplexity live-søgningspipeline:

Brugerforespørgsel

↓

Trin 1: Forespørgselsbehandling

├── NLP-tokenisering

├── Intentionklassificering

├── Entitetsudtræk

├── Forespørgselsreformulering (flere underforespørgsler)

↓

Trin 2: Informationshentning

├── Semantisk søgning (embedding-baseret)

├── API-kald til webindeks

├── Kildefiltrering (Fokus-tilstand)

├── Passageudtrækning

├── Relevansrangering

↓

Trin 3: Svargenerering

├── Kontekstvindues-populering

├── LLM-syntese (GPT-4/Claude)

├── Inline-citeringssporing

├── Konfliktløsning

↓

Trin 4: Forfinelse

├── Faktatjek mod kilder

├── Sammenhængsvurdering

├── Generering af forslag til opfølgning

├── Citeringsformatering

↓

Endeligt output (svar + citater + forslag)

Vigtige indsigter:

Til indholdsoptimering:

For at blive citeret i Perplexity:

Tak til alle for den tekniske dybdegående diskussion.

Get personalized help from our team. We'll respond within 24 hours.

Overvåg når Perplexity citerer dit domæne i sine live-søgningssvar. Forstå hvordan platformen opdager og bruger dit indhold.

Perplexity AI er en AI-drevet svarmotor, der kombinerer realtidssøgning på nettet med LLM'er for at levere citerede, præcise svar. Lær hvordan den fungerer og d...

Lær om Perplexity Pro Search, en avanceret AI-søgetilstand der udfører flertrins ræsonnement og analyserer 20-25+ kilder for omfattende research. Opdag hvordan ...

Lær hvordan du optimerer dit indhold til Perplexity AI og bliver citeret i realtidssøgningsresultater. Opdag citeringsklare indholdsstrategier, teknisk optimeri...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.