Sitehastighed og AI-synlighed: Påvirker ydeevne antallet af citater?

Opdag hvordan sidehastighed direkte påvirker AI-synlighed og citater i ChatGPT, Gemini og Perplexity. Lær om 2,5-sekunders grænsen og optimeringsstrategier for ...

Opdag de kritiske faktorer, der påvirker AI-indekseringshastighed, herunder websitets ydeevne, crawl-budget, indholdsstruktur og teknisk optimering. Lær hvordan du optimerer dit website til hurtigere AI-søgemaskineindeksering.

AI-indekseringshastighed påvirkes af flere faktorer, herunder websitets ydeevne og indlæsningstider, tilgængelig crawl-budget, indholdskvalitet og -struktur, teknisk SEO-konfiguration, effektivitet af databaseindeksering, implementering af schema markup og kompleksiteten af din webstedsarkitektur. Optimering af disse elementer sikrer, at AI-crawlere effektivt kan opdage, behandle og indeksere dit indhold.

AI-indekseringshastighed bestemmer, hvor hurtigt dit indhold bliver synligt i AI-drevne søgemaskiner som ChatGPT, Perplexity og Googles AI Overviews. I modsætning til traditionelle søgemaskiner, der blot matcher søgeord til sider, skal AI-systemer crawle, forstå og syntetisere dit indhold for at generere præcise svar. Hastigheden, hvormed dette sker, afhænger af adskillige sammenhængende faktorer, der direkte påvirker din synlighed i AI-genererede svar og din evne til at tiltrække trafik fra AI-søgeplatforme.

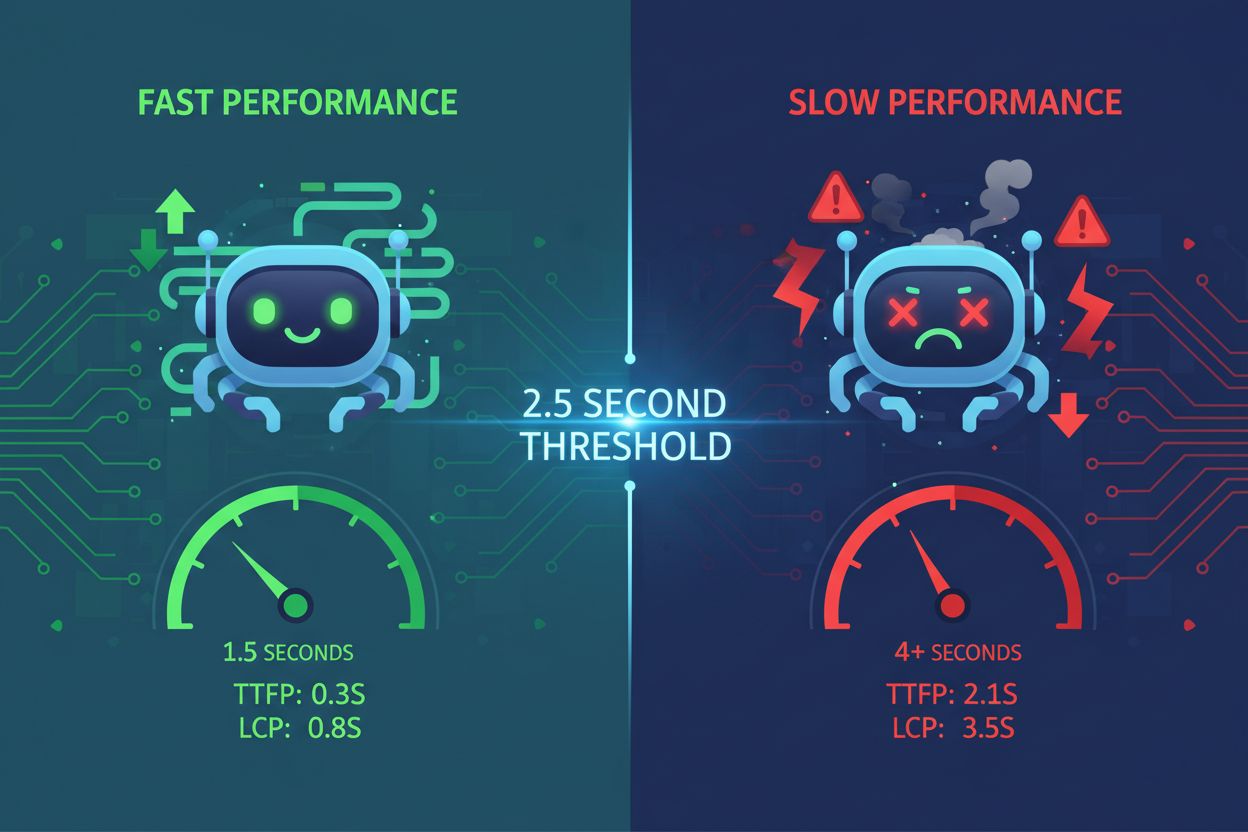

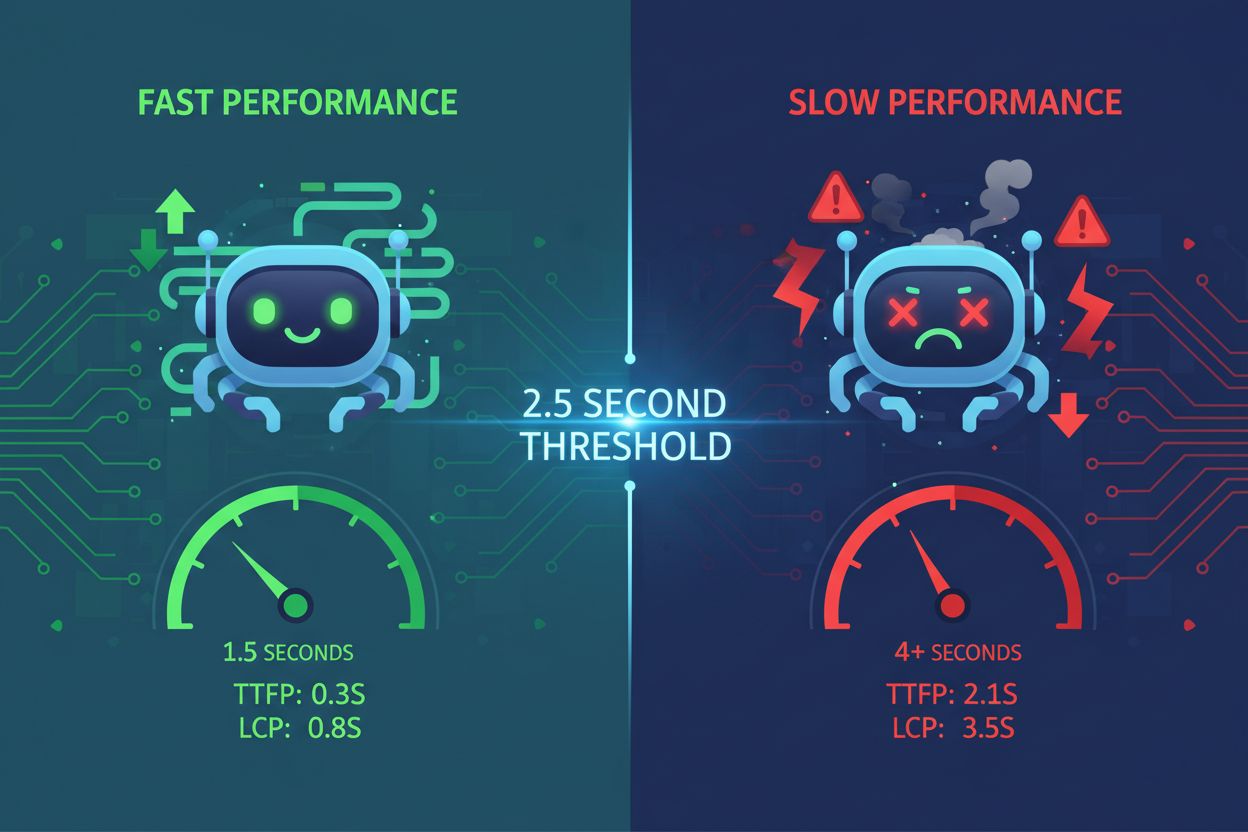

Sideindlæsningshastighed er en af de mest kritiske faktorer, der påvirker AI-indekseringshastighed. AI-crawlere arbejder inden for stramme ressourcebegrænsninger og tidsrammer—typisk mellem 1-5 sekunder pr. sideanmodning. Når dit website indlæses langsomt, bruger crawlere mere tid på at hente indhold, hvilket betyder, at færre sider bliver indekseret inden for deres tildelte crawl-vindue. Dette skaber en kaskadeeffekt, hvor dårlig ydeevne direkte reducerer antallet af dine sider, som AI-systemer kan behandle og indeksere.

Langsomt indlæsende sider signalerer dårlig vedligeholdelse til AI-systemer. Når sider tager for lang tid at gengive, kan AI-crawlere time out, før de får adgang til dit faktiske indhold, hvilket efterlader kun dit HTML-skelet indekseret. Dette er især problematisk for JavaScript-tunge websites, hvor indholdet indlæses dynamisk på klientsiden. Den to-trins renderingsproces, der kræves for JavaScript, tilføjer betydelig latenstid og gør det sværere for AI-systemer at udtrække meningsfuld information. Komprimering af billeder, minificering af kode, implementering af lazy loading og brug af Content Delivery Networks (CDN’er) kan dramatisk forbedre indlæsningstiderne og give AI-crawlere mulighed for at behandle flere sider effektivt.

| Performance Metric | Target | Impact on AI Indexing |

|---|---|---|

| Sideindlæsningstid | Under 3 sekunder | Giver mulighed for at crawle flere sider pr. session |

| Largest Contentful Paint (LCP) | Under 2,5 sekunder | Sikrer, at AI ser meningsfuldt indhold hurtigt |

| First Input Delay (FID) | Under 100ms | Forbedrer crawlerens responsivitet |

| Cumulative Layout Shift (CLS) | Tæt på nul | Forhindrer fejl ved udtrækning af indhold |

Crawl-budget refererer til det begrænsede antal sider, AI-systemer kan besøge inden for et specifikt tidsrum. Hver hjemmeside modtager en begrænset crawl-allokering fra AI-søgemaskiner, ligesom Google tildeler crawl-budget. Når dit crawl-budget er brugt op, stopper AI-systemerne med at indeksere nyt indhold, uanset kvalitet. Denne begrænsning bliver især problematisk for store websites med hundreder eller tusinder af sider, der konkurrerer om begrænsede indekseringsressourcer.

Optimering af crawl-budgetallokering er afgørende for hurtigere AI-indeksering. Du bør prioritere højværdissider—dem, der genererer indtjening, tiltrækker trafik eller indeholder kritisk information—over sider med lav værdi som dublerede kategorifiltre eller overflødige tag-sider. Ved strategisk brug af robots.txt-filer kan du blokere AI-crawlere fra at få adgang til sider, der ikke behøver at blive indekseret, og dermed bevare dit crawl-budget til indhold, der betyder noget. Desuden hjælper vedligeholdelse af et opdateret XML-sitemap og korrekt intern linkstruktur AI-systemer med at opdage dine vigtigste sider hurtigere, så de bliver indekseret, før dit crawl-budget løber ud.

AI-systemer straffer i høj grad dubleret og tyndt indhold, hvilket sænker indekseringshastigheden betydeligt. Når AI-crawlere støder på indhold, der mangler originalitet eller substans, nedprioriterer de crawl af lignende sider på dit website. Dette skyldes, at AI-systemer vurderer indholdskvalitet ved hjælp af E-E-A-T-signaler (Experience, Expertise, Authoritativeness, and Trustworthiness). Indhold, der fremstår som lavindsats, AI-genereret uden menneskelig gennemgang, eller kopieret fra andre kilder, får lavere prioritet i indekseringskøen.

Højkvalitets, omfattende indhold bliver hurtigere indekseret af AI-systemer. Indhold på over 3.000 ord, der grundigt besvarer brugerens spørgsmål fra flere vinkler, får prioriteret indeksering. AI-systemer foretrækker indhold, der inkluderer understøttende data, statistikker, virkelige eksempler og cases, fordi disse elementer demonstrerer ekspertise og troværdighed. Når du skaber originalt, veldokumenteret indhold, der giver ægte værdi, allokerer AI-crawlere flere ressourcer til at indeksere dine sider, hvilket resulterer i hurtigere opdagelse og inkludering i AI-genererede svar.

Forkert robots.txt-konfiguration kan utilsigtet blokere AI-crawlere fra at indeksere dit indhold. Mange websites forhindrer utilsigtet AI-søgebots i at få adgang til deres sider ved fejlkonfiguration af robots.txt-filer. Forskellige AI-systemer bruger forskellige crawler-identifikatorer—ChatGPT bruger OAI-SearchBot, Perplexity bruger PerplexityBot, og andre bruger AndiBot eller ExaBot. Hvis din robots.txt ikke eksplicit tillader disse crawlere, kan de ikke indeksere dit indhold, uanset kvalitet eller relevans.

Ren HTML-struktur og semantisk markup fremskynder AI-indeksering. AI-crawlere har svært ved JavaScript-tunge implementeringer og komplekse, indlejrede strukturer. Brug af semantiske HTML5-tags (article, section, nav), korrekte overskriftsniveauer (H1-H6), beskrivende linktekst og alt-tekst på billeder gør dit indhold umiddelbart tilgængeligt for AI-systemer. Server-side rendering (SSR) frameworks som Next.js eller Gatsby forud-renderer indhold på serveren, hvilket sikrer, at AI-crawlere modtager fuldt færdige sider uden at skulle eksekvere JavaScript, hvilket betydeligt øger indekseringshastigheden.

Over-indeksering i din database skaber latenstid, der sænker AI-indekseringshastigheden. Når databaser har for mange, overflødige eller overlappende indekser, skal hver indsættelse, opdatering og sletning opdatere flere indekser, hvilket skaber flaskehalse i skriveydelsen. Denne overhead påvirker direkte, hvor hurtigt dit content management-system kan levere sider til AI-crawlere. Overflødige indekser optager lagerplads, introducerer latenstid og tvinger forespørgselsplanlæggere til at træffe suboptimale beslutninger, hvilket alt sammen sænker indholdsleveringen til AI-systemer.

Optimering af databaseindekser forbedrer indholdsleveringshastigheden til AI-crawlere. Gennemgå regelmæssigt din database for at identificere ubrugte eller overflødige indekser ved hjælp af værktøjer som pg_stat_user_indexes (PostgreSQL) eller sys.schema_unused_indexes (MySQL). Fjern indekser, der ikke har været brugt i uger eller måneder, konsolider overlappende indekser, og sørg for, at din databasestruktur matcher nuværende forespørgselsmønstre. En veloptimeret database leverer indhold hurtigere til AI-crawlere, hvilket muliggør hurtigere indeksering og inkludering i AI-genererede svar.

Manglende eller ufuldstændig schema markup forsinker AI’s forståelse og indeksering af indhold. Schema markup giver strukturerede data, der hjælper AI-systemer med hurtigt at forstå dit indholds kontekst, betydning og relationer. Uden korrekt schema-implementering skal AI-crawlere bruge ekstra processeringstid på at udlede indholdsstruktur og udtrække nøgledetaljer. Denne ekstra behandlingstid reducerer indekseringshastigheden, da crawlere bruger flere ressourcer pr. side.

Implementering af omfattende schema markup fremskynder AI-indeksering. FAQ-schema, How-To-schema, Article-schema og Product-schema giver AI-systemer præstruktureret information, der straks kan forstås og indekseres. Når du inkluderer forfatteroplysninger, udgivelsesdatoer, bedømmelser og andre strukturerede data, kan AI-systemer hurtigt kategorisere og indeksere dit indhold uden yderligere behandling. Forskning viser, at 36,6% af søgeord udløser fremhævede uddrag baseret på schema markup, hvilket viser, hvordan strukturerede data direkte påvirker AI-synlighed og indekseringshastighed.

Svag intern linkstruktur forhindrer AI-crawlere i effektivt at opdage dit indhold. Interne links fungerer som et vejkort, der guider AI-crawlere gennem din webstedsarkitektur. Uden strategisk intern linkning kan AI-systemer have svært ved at opdage vigtige sider, især nyt indhold, der er begravet dybt i strukturen. Denne forsinkelse i opdagelsen fører direkte til langsommere indeksering, da crawlere bruger mere tid på at finde sider, der skal indekseres.

Strategisk intern linkstruktur fremskynder AI’s opdagelse og indeksering af indhold. At linke nyt indhold fra relevante eksisterende sider hjælper AI-crawlere med at finde og indeksere det hurtigere. Brug af beskrivende ankertekst, der klart angiver, hvad den linkede side indeholder, hjælper AI-systemer med at forstå indholdsrelationer og kontekst. En korrekt intern linkstruktur sikrer, at højværdissider får mere crawl-opmærksomhed, hvilket resulterer i hurtigere indeksering og højere prioritet i AI-genererede svar.

Dårlig brugeroplevelse signalerer til AI-systemer, at dit indhold måske ikke er værdifuldt. Høje afvisningsprocenter, korte sessionsvarigheder og lave engagement-metrics indikerer for AI-crawlere, at dit indhold ikke opfylder brugerbehovene. AI-systemer bruger i stigende grad adfærdssignaler til at vurdere indholdskvalitet, og sider med dårlig brugeroplevelse får lavere indekseringsprioritet. Når brugere hurtigt forlader dine sider, tolker AI-systemer det som et tegn på manglende værdi, hvilket forsinker inkluderingen i AI-genererede svar.

Læsevenlig indholdsstruktur forbedrer AI-indekseringshastighed. Indhold formateret med korte afsnit (2-3 sætninger), beskrivende underoverskrifter, punktlister, nummererede lister og tabeller er lettere for både brugere og AI-systemer at behandle. Denne forbedrede overskuelighed tillader AI-crawlere hurtigt at udtrække nøgledetaljer og forstå indholdsstrukturen uden omfattende behandling. Når dit indhold er velorganiseret og tilgængeligt, kan AI-systemer indeksere det hurtigere og med større tillid til dets kvalitet og relevans.

Langsom hosting-infrastruktur skaber flaskehalse, der forsinker AI-indeksering. Delte hostingmiljøer har ofte begrænsede ressourcer og langsommere svartider, hvilket betyder, at AI-crawlere må vente længere på, at hver side indlæses. Denne ventetid reducerer antallet af sider, der kan indekseres inden for crawlerens tildelte tidsvindue. Serverrespons-tiden påvirker direkte crawl-effektiviteten—hver millisekunds forsinkelse reducerer det samlede antal sider, der indekseres pr. session.

Opgradering til hurtig, skalerbar hosting fremskynder AI-indeksering. Administrerede WordPress-hosts, VPS-løsninger og cloud-platforme som Google Cloud eller AWS giver hurtigere serverrespons og bedre ressourceallokering. CDN’er som Cloudflare cacher indhold globalt og leverer sider hurtigere til crawlere, uanset deres geografiske placering. Når din hosting-infrastruktur leverer sider hurtigt, kan AI-crawlere behandle mere indhold pr. session, hvilket resulterer i hurtigere samlet indeksering og bedre synlighed i AI-genererede svar.

Kontinuerlig overvågning af AI-indekseringsperformance muliggør proaktiv optimering. Værktøjer som Google Search Console, SE Ranking’s AI Results Tracker og Peec.ai hjælper dig med at spore, hvor hurtigt dit indhold vises i AI-søgeresultater, og identificere sider, der ikke bliver indekseret. Ved at overvåge disse metrics kan du finde flaskehalse og implementere målrettede forbedringer, der direkte påvirker indekseringshastigheden.

Regelmæssige audits og opdateringer opretholder optimal AI-indekseringshastighed. Udfør periodiske performance-audits ved hjælp af værktøjer som Google PageSpeed Insights, GTmetrix og WebPageTest for at identificere hastighedsflaskehalse. Opdater dit XML-sitemap regelmæssigt, opdater indhold for at opretholde friskhedssignaler, og optimer kontinuerligt din database og infrastruktur. Konsistent optimering sikrer, at din AI-indekseringshastighed forbliver konkurrencedygtig, og at dit indhold fortsat hurtigt vises i AI-genererede svar.

Spor hvor hurtigt dit indhold vises i AI-søgeresultater som ChatGPT, Perplexity og andre AI-svar-generatorer. Få indsigt i realtid i din AI-indekseringsperformance.

Opdag hvordan sidehastighed direkte påvirker AI-synlighed og citater i ChatGPT, Gemini og Perplexity. Lær om 2,5-sekunders grænsen og optimeringsstrategier for ...

Lær hvordan sidehastighed påvirker din synlighed i AI-søgemaskiner som ChatGPT, Perplexity og Gemini. Opdag optimeringsstrategier og vigtige målepunkter for AI ...

Community-diskussion om AI-indekseringens tidslinjer. Reelle data om hvor hurtigt ChatGPT, Perplexity og andre AI-systemer opdager og citerer nyt indhold.

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.