GPTBot

Lær hvad GPTBot er, hvordan den fungerer, og om du bør blokere den fra dit websted. Forstå effekten på SEO, serverbelastning og brandets synlighed i AI-søgeresu...

Lær hvad GPTBot er, hvordan det fungerer, og om du bør tillade eller blokere OpenAI’s webcrawler. Forstå indflydelsen på dit brands synlighed i AI-søgemaskiner og ChatGPT.

GPTBot er OpenAI's webcrawler, der indsamler data fra offentligt tilgængelige websites for at træne AI-modeller som ChatGPT. Om du skal tillade det, afhænger af dine prioriteter: tillad det for bedre synlighed af dit brand i AI-søgeresultater og ChatGPT-svar, eller bloker det, hvis du har bekymringer om brugen af dit indhold, intellektuel ejendomsret eller serverressourcer.

GPTBot er OpenAI’s officielle webcrawler, designet til systematisk at scanne offentligt tilgængelige websites og indsamle data til træning af store sprogmodeller som ChatGPT og GPT-4. I modsætning til traditionelle søgemaskinecrawlere som Googlebot, der indekserer indhold til søgeresultater, tjener GPTBot et fundamentalt andet formål: at indsamle information for at forbedre AI’ens forståelse af sprog, aktuelle begivenheder og viden om den virkelige verden. Når GPTBot besøger dit website, identificerer den sig med en tydelig user agent-streng, der vises i dine serverlogs som Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; GPTBot/1.3; +https://openai.com/gptbot), hvilket gør det let for webmastere at genkende og overvåge dens aktivitet.

Crawleren opererer med gennemsigtighed og respekt for etablerede webstandarder. Før den får adgang til noget indhold på dit site, tjekker GPTBot din robots.txt-fil, som er den standardmekanisme, webmastere bruger til at kommunikere med automatiserede bots om, hvilke dele af deres site der kan eller ikke kan tilgås. Hvis du tilføjer en afvisningsregel for GPTBot i din robots.txt-fil, vil crawleren respektere dit ønske og undlade at tilgå dit site. Denne frivillige overholdelse af robots.txt demonstrerer OpenAI’s engagement i ansvarlige crawl-praksisser, selvom det er vigtigt at bemærke, at håndhævelsen i sidste ende afhænger af crawleroperatørens integritet.

GPTBot scanner kun offentligt tilgængeligt indhold og kan ikke omgå betalingsmure, login-sider eller begrænsede sektioner af dit website. Crawleren forsøger ikke at få adgang til private oplysninger, autentificerede områder eller indhold markeret som privat. Denne begrænsning betyder, at følsomme data, kun-for-medlemmer-indhold og abonnementsbaseret materiale forbliver beskyttet mod GPTBots adgang. De oplysninger, som GPTBot indsamler, bruges udelukkende til at forbedre AI’ens forståelse af sprog, kontekst og aktuelle begivenheder, uden direkte indflydelse på dine traditionelle søgemaskinerangeringer eller hvordan dit site vises i Google Search-resultater.

Nye data afslører den dramatiske stigning af GPTBot som en dominerende aktør inden for webcrawling. Mellem maj 2024 og maj 2025 steg GPTBots andel af AI-crawlertrafik fra blot 5% til 30%, hvilket repræsenterer en svimlende stigning på 305% i antallet af forespørgsler. Denne eksplosive vækst afspejler OpenAI’s massive investering i indsamling af træningsdata og den stigende betydning af AI-modeller i det digitale økosystem. GPTBot er blevet den næstmest blokerede crawler på nettet i dag og den mest blokerede crawler via robots.txt-filer, med mere end 3,5% af websites, der aktuelt har implementeret blokeringsregler mod den.

Store udgivere og indholdsskabere har bemærket denne tendens. The New York Times, CNN og mere end 30 af de 100 største websites har allerede implementeret blokeringsregler mod GPTBot, hvilket signalerer voksende bekymring om brugen af indhold og ophavsrettigheder. Men denne blokeringsbølge fortæller ikke hele historien. Mens nogle sites ser GPTBot som en trussel mod deres forretningsmodel, anerkender andre det som en mulighed for at sikre, at deres indhold når de milliarder af brugere, der dagligt interagerer med ChatGPT og andre AI-systemer. Beslutningen om at tillade eller blokere GPTBot er blevet et strategisk valg, der afspejler den enkelte organisations værdier, forretningsmodel og langsigtede vision for deres digitale tilstedeværelse.

| Metrik | Værdi | Betydning |

|---|---|---|

| GPTBot-vækst (maj 2024 - maj 2025) | +305% | Hurtigst voksende AI-crawler |

| Nuværende andel af AI-crawlertrafik | 30% | Dominerende AI-crawler målt på volumen |

| Websites, der blokerer GPTBot | 3,5%+ | Næstmest blokerede crawler |

| Top 100 websites, der blokerer | 30+ | Store udgivere blokerer adgang |

| ChatGPT ugentlige brugere | 800 millioner | Potentiel rækkevidde |

Websideejere vælger at blokere GPTBot af flere legitime og sammenhængende årsager, der afspejler ægte bekymringer om brug af indhold, forretningsmæssig bæredygtighed og databeskyttelse. Den mest fremtrædende bekymring handler om brug af indhold uden kompensation. Udgivelse af indhold af høj kvalitet kræver betydelig tid, ressourcer og ekspertise. Når AI-systemer henter det arbejde for at træne modeller, der besvarer brugerens spørgsmål—ofte uden at linke tilbage til den oprindelige kilde—føles det arrangement grundlæggende uretfærdigt for mange indholdsskabere. Denne bekymring er særlig udtalt for udgivere, journalister og specialiserede indholdsskabere, der er afhængige af trafik og attribution for at opretholde deres aktiviteter. Frygten er, at efterhånden som AI-systemer bliver mere sofistikerede til at besvare spørgsmål direkte, vil brugerne have mindre incitament til at besøge de oprindelige websites, hvilket dermed udhuler trafikken og værdien af den originale indholdsindsats.

Sikkerhed og serverressource-bekymringer udgør en anden vigtig faktor i beslutningen om at blokere. Selvom GPTBot respekterer robots.txt-regler som andre crawlere, er der stadig spørgsmål om den kumulative effekt af flere AI-crawlere, der tilgår dit indhold samtidigt. GPT-crawlere som GPTBot og ClaudeBot kan forbruge betydelige mængder båndbredde, og nogle websites rapporterer stigninger på op til 30 terabyte trafik, hvilket lægger betydeligt pres på servere—særligt i shared hosting-miljøer. Selv hvis GPTBot ikke er ondsindet, tilføjer endnu et automatiseret system, der tilgår dit indhold, kompleksitet til overvågning af sitet, firewall-konfigurationer og bot management-strategier. Der er også bekymring for dataeksponering via mønstergenkendelse, hvor tilsyneladende harmløse indholdsdele afslører mere end tiltænkt, når de kombineres og analyseres af maskinlæringssystemer.

Juridisk usikkerhed skaber yderligere tøven hos mange websideejere. AI-drevne værktøjer som GPTBot eksisterer i et gråt område, når det gælder databeskyttelse, ophavsret og immaterielle rettigheder. Nogle marketingfolk bekymrer sig om, at tilladelse til, at GPTBot crawlers indholdet, utilsigtet kan overtræde regler som GDPR eller CCPA, især hvis personoplysninger eller brugergenereret indhold er involveret. Selvom indholdet er offentligt tilgængeligt, er den juridiske argumentation omkring fair use i AI-træning stadig uafklaret og omdiskuteret. Det intellektuelle ejendomsaspekt tilføjer endnu et lag af kompleksitet: hvis din originale tekst ender omskrevet i et ChatGPT-svar, hvem ejer så det output? Lige nu findes der ingen klar juridisk præcedens, der afgør dette endegyldigt. For brands i regulerede brancher som finans, sundhed eller jura giver det strategisk mening at vælge en forsigtig tilgang og blokere adgangen, mens det juridiske landskab fortsat udvikler sig.

På trods af de legitime bekymringer ved blokering, findes der stærke argumenter for at tillade GPTBot adgang til dit indhold. Den mest betydningsfulde fordel er brandsynlighed i ChatGPT og AI-drevne søgeresultater. ChatGPT har cirka 800 millioner ugentlige brugere og håndterer milliarder af forespørgsler hver måned. Mange af disse brugere stiller spørgsmål, som dit indhold kan besvare. Hvis GPTBot ikke kan få adgang til dit site, må modellen støtte sig til sekundære oplysninger eller forældede kilder, når den omtaler dit brand, dine produkter eller din ekspertise. Det udgør en forpasset mulighed og en potentiel risiko for dit omdømme. Ved at tillade GPTBot at crawle dit indhold, hjælper du med at sikre, at ChatGPT’s svar præcist afspejler dit budskab, dine tilbud og din ekspertise. Det er i bund og grund omdømmestyring på autopilot—dit indhold bliver repræsenteret i et af verdens mest anvendte AI-systemer.

AI-søgetrafik konverterer markant bedre end traditionel organisk søgetrafik. Tidlige data viser, at besøgende fra AI-søgeplatforme konverterer 23 gange bedre end traditionelle organiske søgebesøgende. Selvom AI-søgning i øjeblikket står for mindre end 1% af den samlede webtrafik, fortæller kvaliteten af disse besøg en overbevisende historie. AI-søgebrugere befinder sig typisk længere fremme i beslutningsprocessen. De har allerede brugt AI til at undersøge muligheder, sammenligne funktioner og indsnævre deres valg, før de klikker videre til dit website. Det betyder, at de er mere kvalificerede, bedre informerede og mere tilbøjelige til at konvertere til kunder eller foretage ønskede handlinger. Efterhånden som AI-værktøjer bliver en primær måde, hvorpå folk søger, opdager og engagerer sig med indhold, kan en fuldstændig ignorering af AI-søgning betyde, at du falder bagud i forhold til konkurrenter, der aktivt optimerer til denne nye kanal.

Fremtidssikring af din digitale tilstedeværelse er endnu en central overvejelse. Efterhånden som AI-værktøjer bliver mere centrale for, hvordan folk opdager information, kan en fuldstændig blokering af AI-crawlere betyde, at du fravælger fremtidens søgning. Generativ engine optimization repræsenterer den næste udvikling inden for søgesynlighed, og ChatGPT står for over 80% af AI-henvisningstrafik, hvilket gør OpenAI’s crawler særligt vigtig for langsigtet synlighed. Web- og søgelandskabet ændrer sig hurtigt, og organisationer, der allerede nu positionerer sig til at være en del af AI-økosystemet, vil have betydelige fordele, efterhånden som teknologierne modnes og bliver endnu mere centrale for informationssøgning.

Blokering af GPTBot er ligetil og reversibel via din robots.txt-fil, som er standardmekanismen til at kommunikere med webcrawlere. For at blokere GPTBot fuldstændigt fra hele dit website, tilføj disse linjer til din robots.txt-fil:

User-agent: GPTBot

Disallow: /

Dette fortæller OpenAI’s crawler at undgå hele dit site. Hvis du ønsker mere detaljeret kontrol, kan du tillade delvis adgang ved at erstatte / med specifikke mapper eller sider, du vil gøre tilgængelige. For eksempel, for at blokere GPTBot fra at tilgå din /private/-mappe, mens resten af sitet er åbent:

User-agent: GPTBot

Disallow: /private/

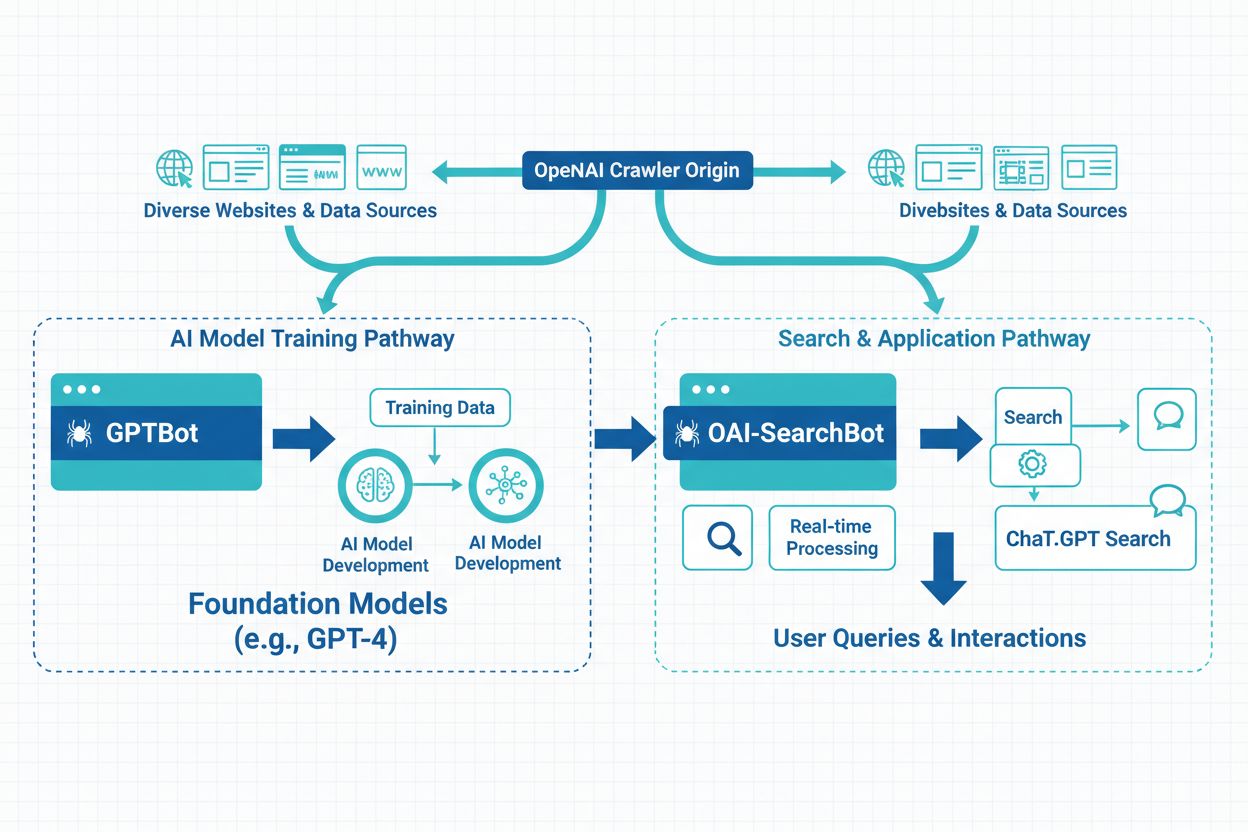

Hvis du vil blokere alle OpenAI-relaterede crawleaktiviteter, bør du tilføje regler for de tre forskellige bots, som OpenAI opererer:

User-agent: GPTBot

Disallow: /

User-agent: ChatGPT-User

Disallow: /

User-agent: OAI-SearchBot

Disallow: /

Alternative blokeringsmetoder giver større kontrol, men kræver mere teknisk ekspertise. IP-blokering gør det muligt at nægte adgang for OpenAI’s IP-adresseintervaller via din serverfirewall eller hostingkontrolpanel, selvom denne metode kræver, at IP-listen opdateres, efterhånden som OpenAI’s infrastruktur ændrer sig. Rate limiting sætter grænser for antallet af forespørgsler pr. minut eller time for at forhindre serveroverbelastning. Web Application Firewalls (WAFs) implementerer server-side blokeringsregler baseret på en bots IP-adresse eller user agent-streng og tilbyder mere sofistikeret kontrol over bottrafik. Du kan overvåge crawleraktivitet i dine serverlogs eller via værktøjer som Cloudflare eller Google Search Console for at sikre, at GPTBot respekterer dine instruktioner.

Visse brancher har særligt stærke grunde til at begrænse botadgang for at beskytte data, indtjening og brugerinteresser. Forlags- og medievirksomheder står over for direkte trusler mod deres forretningsmodel, da de er afhængige af trafik og annonceindtægter. Udgivere ønsker, at brugerne besøger deres sites direkte og ikke bliver omdirigeret til AI-genererede resuméer. Store eksempler inkluderer The New York Times, Associated Press og Reuters, som alle har implementeret blokeringsregler. E-handelsplatforme beskytter unikke produktbeskrivelser og prissætning mod konkurrenter og dataskrabeværktøjer for at bevare deres konkurrencefordel. Brugergenererede indholdsplatforme som Reddit beskytter fællesskabsskabt indhold og licenserede data mod ubegrænset scraping, der kan udhule værdien af deres aktiver. Højautoritets-datasites i følsomme brancher som jura, medicin og finans kontrollerer adgangen til specialiseret, forskningsbaseret indhold for at opretholde compliance og beskytte fortrolige oplysninger.

Du kan bekræfte, om GPTBot besøger dit site, på flere måder. Tjek af serverlogs er den mest direkte metode—se efter user agent-strenge, der indeholder “GPTBot” i dine adgangslogs for at se, hvornår og hvor ofte crawleren besøger. Brug af analysetools giver en anden mulighed, da mange analyseplatforme viser bottrafik og gør det muligt at filtrere via user agent, hvilket gør identifikationen enkel. SEO-overvågningssoftware rapporterer om crawleraktivitet, herunder OpenAI’s bots, hvilket giver dig indsigt i, hvor ofte GPTBot tilgår dit indhold. Regelmæssig overvågning hjælper dig med at forstå hyppigheden af GPTBot-besøg og om crawleren påvirker dit sites ydeevne. Hvis du bemærker GPTBot-aktivitet og ønsker at styre adgangen, kan du nemt administrere tilladelser via din robots.txt-fil eller implementere mere avancerede blokeringsmetoder via din hostingudbyder eller webapplikationsfirewall.

Beslutningen om at tillade eller blokere GPTBot skal afstemmes med dine specifikke forretningsmål, indholdsstrategi og langsigtede vision. Blokér GPTBot, hvis du udgiver proprietært indhold eller opererer i et stærkt reguleret område, hvor databeskyttelse er altafgørende, du ikke er klar til at fodre AI-økosystemet og foretrækker fuld kontrol over brugen af dit indhold, du prioriterer indholdskontrol, juridisk compliance eller sikkerhed frem for mulig AI-synlighed, dine serverressourcer er begrænsede, og bottrafik giver mærkbare ydelsesproblemer, eller du har stærke bekymringer om immaterielle rettigheder og ejerskab af indhold. Tillad GPTBot, hvis du vil øge din synlighed, brand-indflydelse og relevans i AI-æraen på tværs af generative platforme, du ønsker præcis brandrepræsentation over for ChatGPT’s 800 millioner ugentlige brugere, du bygger til fremtiden og vil være en del af AI-søgeøkosystemet, du ønsker at forbedre din sides generative engine optimization og fange højt-konverterende AI-søgetrafik, eller du stræber efter langsigtet synlighed og brandrækkevidde i et stadig mere AI-drevet digitalt landskab.

Web og søgning ændrer sig hurtigt, og uanset hvad skal du beslutte, hvor dit indhold skal passe ind i den fremtid og handle derefter. Valget mellem at tillade og blokere GPTBot er ikke permanent—du kan til enhver tid justere din robots.txt-fil for at ændre din præference. Det vigtigste er at træffe en informeret beslutning baseret på dine forretningsprioriteter, forstå konsekvenserne for din brands synlighed i AI-systemer og overvåge resultaterne af dit valg over tid.

Følg med i, hvordan dit brand vises i ChatGPT, Perplexity og andre AI-svar generatorer. Få indsigt i realtid i din AI-søgesynlighed og optimer din indholdsstrategi.

Lær hvad GPTBot er, hvordan den fungerer, og om du bør blokere den fra dit websted. Forstå effekten på SEO, serverbelastning og brandets synlighed i AI-søgeresu...

Lær de vigtigste forskelle mellem GPTBot og OAI-SearchBot crawlere. Forstå deres formål, crawl-adfærd, og hvordan du kan administrere dem for optimal synlighed ...

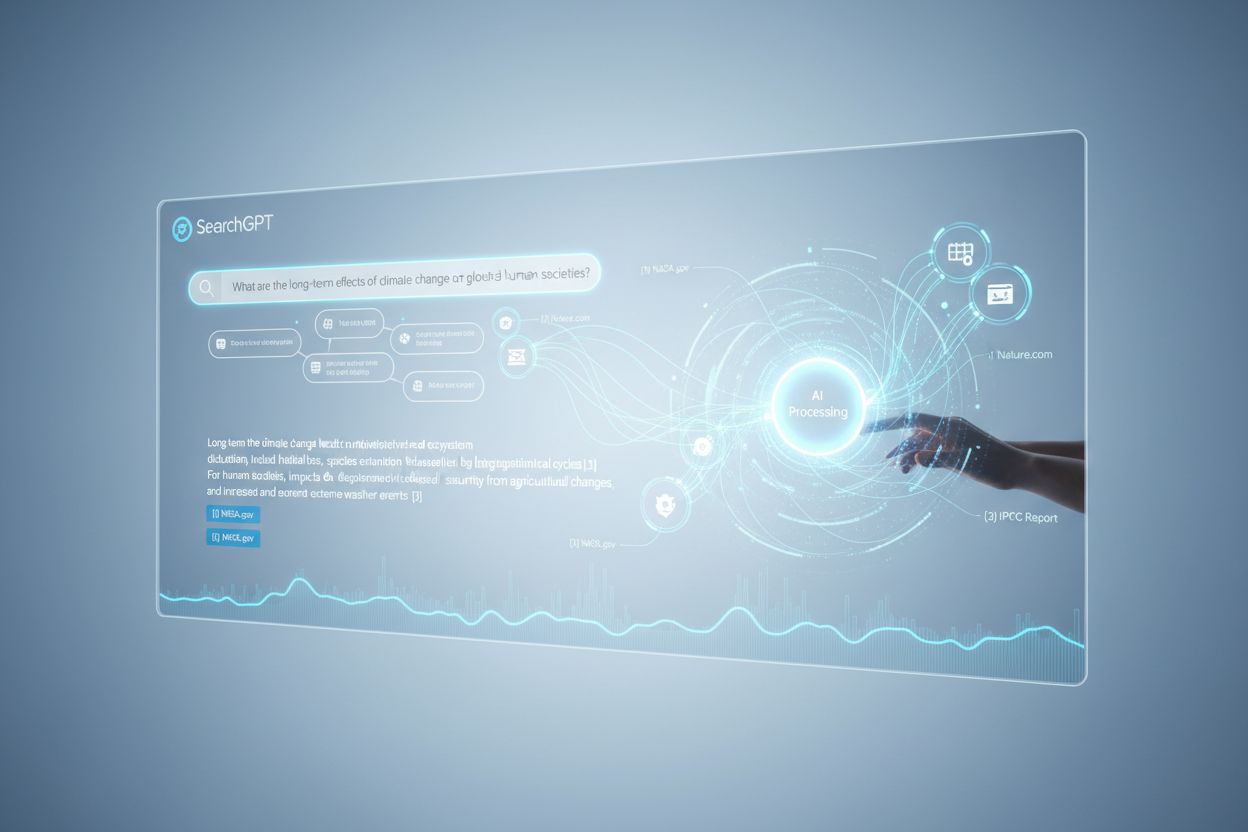

Lær hvad SearchGPT er, hvordan det fungerer, og dets indflydelse på søgning, SEO og digital markedsføring. Udforsk funktioner, begrænsninger og fremtiden for AI...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.