Perpleksitets-score

Perpleksitets-score måler tekstforudsigelighed i sprogmodeller. Lær hvordan denne centrale NLP-måling kvantificerer modelusikkerhed, dens beregning, anvendelser...

Lær hvad perpleksitet score betyder i indhold og sprogmodeller. Forstå hvordan det måler modellens usikkerhed, prædiktionsnøjagtighed og vurdering af tekstkvalitet.

Perpleksitet score er en måleenhed, der viser, hvor godt en sprogmodel forudsiger det næste ord i en sekvens. Den kvantificerer modellens usikkerhed i forudsigelserne, hvor lavere score indikerer højere selvtillid og bedre præstation.

Perpleksitet score er en grundlæggende måleenhed, der bruges inden for naturlig sprogbehandling og maskinlæring til at vurdere, hvor godt en sprogmodel klarer sig ved tekstforudsigelser. I sin essens måler den usikkerhedsgraden en model har, når den tildeler sandsynligheder til ord i en sekvens. Måleenheden er især vigtig for at forstå modellens præstation i opgaver som tekstgenerering, maskinoversættelse og konversationel AI. Når en sprogmodel behandler tekst, tildeler den sandsynlighedsværdier til mulige næste ord baseret på konteksten fra de foregående ord. Perpleksitet indfanger, hvor sikker modellen er i disse forudsigelser, hvilket gør det til et essentielt værktøj for udviklere og forskere, der arbejder med store sprogmodeller.

Begrebet perpleksitet stammer fra informationsteori, hvor det repræsenterer en måling af usikkerhed i sandsynlighedsfordelinger. I sprogmodellens kontekst indikerer lavere perpleksitet score, at modellen er mere sikker i sine forudsigelser og derfor genererer mere sammenhængende og flydende tekst. Omvendt antyder højere perpleksitet score, at modellen er usikker på, hvilket ord der skal komme næste, hvilket potentielt kan føre til mindre sammenhængende eller mindre relevante output. Forståelsen af denne måleenhed er afgørende for alle, der arbejder med AI-drevet indholdsgenerering, da den direkte påvirker kvaliteten og pålideligheden af genereret tekst.

Beregningen af perpleksitet score involverer flere matematiske trin, der omdanner rå sandsynlighedsforudsigelser til en enkelt fortolkelig måleenhed. Den grundlæggende formel er baseret på entropien i modellens forudsigelser, som måler graden af usikkerhed i outputtet. Den matematiske repræsentation er: Perpleksitet = 2^H(p), hvor H(p) repræsenterer entropien i modellens forudsigelser. Denne formel viser, at perpleksitet er direkte afledt af entropi, hvor lavere entropiværdier resulterer i lavere perpleksitet score.

Den praktiske beregningsproces følger en struktureret tilgang med flere trin. Først forudsiger sprogmodellen sandsynligheden for næste token baseret på inputtekst og given kontekst. Dernæst anvendes den logaritmiske transformation på disse sandsynligheder, hvilket hjælper med at omsætte dem til et mere anvendeligt mål til analyse. Tredje trin er at beregne gennemsnitlig log-likelihood for alle forudsagte ord i testdatasættet på tværs af hele sekvensen. Til sidst foretages eksponentiering af den gennemsnitlige log-likelihood for at opnå den endelige perpleksitet score. Den komplette formel for beregning af perpleksitet for en sekvens af ord er: Perpleksitet = exp(-1/N × Σ log p(w_i | w_{i-1}, w_{i-2}, …, w_1)), hvor p(w_i | w_{i-1}, …, w_1) er den forudsagte sandsynlighed for det i’te ord givet alle foregående ord, og N er det samlede antal ord i sekvensen.

| Beregningstrin | Beskrivelse | Formål |

|---|---|---|

| Token-forudsigelse | Modellen forudsiger sandsynlighed for næste ord | Etabler basisforudsigelser |

| Log-transformation | Anvend logaritme på sandsynligheder | Omsæt til brugbart mål |

| Gennemsnitsberegning | Udregn gennemsnitlig log-likelihood på sekvens | Normaliser på tekstlængde |

| Eksponentiering | Hæv e til minus gennemsnitlig eksponent | Opnå endelig perpleksitet score |

Perpleksitet score fungerer som en kritisk evalueringsmåleenhed til at vurdere sprogmodellens præstation på flere dimensioner. Måleenheden er vigtig, fordi den giver direkte indsigt i forudsigelsesnøjagtighed, hvilket hjælper udviklere med at forstå, hvor godt en model kan forudsige ord og generere sammenhængende tekst. En lav perpleksitet score indikerer, at modellen laver sikre forudsigelser og sandsynligvis genererer flydende, kontekstuelt passende indhold. Dette er særligt værdifuldt for applikationer som chatbots, virtuelle assistenter og indholdsgenereringssystemer, hvor tekstkvaliteten direkte påvirker brugeroplevelsen. Derudover hjælper perpleksitet med at evaluere modellens sikkerhedsniveau i sine forudsigelser—hvis perpleksiteten er høj, er modellen usikker på det næste ord, hvilket kan føre til usammenhængende eller irrelevant tekstgenerering.

Måleenheden er også essentiel til model sammenligning og udvælgelse. Ved evaluering af forskellige sprogmodeller eller sammenligning af versioner af den samme model under finjustering, giver perpleksitet et kvantificerbart mål for forbedring eller forringelse. Udviklere kan bruge perpleksitet score til at afgøre, om en model er egnet til specifikke opgaver som tekstgenerering, maskinoversættelse, opsummering eller spørgsmål-svar. Desuden muliggør perpleksitet realtidsevaluering under modellens træning, så udviklere straks kan vurdere modellens præstation og justere løbende. Denne egenskab er især værdifuld under finjustering, hvor overvågning af perpleksitet sikrer, at modellen bliver bedre til at lave sikre forudsigelser fremfor blot at overtilpasse træningsdata.

At forstå hvordan man fortolker perpleksitet scores er afgørende for at kunne træffe informerede beslutninger om modellens præstation og egnethed til specifikke applikationer. En lavere perpleksitet score indikerer, at modellen er mere sikker i sine forudsigelser og typisk genererer tekst af højere kvalitet og større sammenhæng. For eksempel antyder en perpleksitet score på 15, at modellen vælger mellem cirka 15 mulige ord ved hvert forudsigelsestrin, hvilket indikerer relativt høj sikkerhed. Omvendt antyder en højere perpleksitet score på 50 eller derover, at modellen er usikker og overvejer mange flere muligheder, hvilket ofte hænger sammen med mindre sammenhængende eller mindre relevante output. Fortolkningen af, hvad der udgør en “god” perpleksitet score, afhænger af den specifikke opgave, datasættet og den modelarkitektur, der evalueres.

Forskellige typer indhold og modeller udviser forskellige baseline perpleksitet intervaller. For eksempel opnår modeller, der er trænet på velstruktureret, formel tekst som Wikipedia-artikler, typisk lavere perpleksitet score end modeller, der er trænet på konversationelt eller kreativt indhold. Ved sammenligning af perpleksitet scores på tværs af forskellige modeller er det afgørende at sikre, at de evalueres på det samme datasæt og med samme tokeniseringsmetode, da disse faktorer har stor indflydelse på resultaterne. En model med en perpleksitet score på 20 på ét datasæt kan ikke nødvendigvis sammenlignes direkte med en anden model med en score på 25 på et andet datasæt. Derudover påvirker sekvenslængde beregningen af perpleksitet—længere sekvenser giver ofte mere stabile scores, mens kortere sekvenser kan have højere varians og give outliers, der forvrænger resultaterne.

Selvom perpleksitet score er en værdifuld måleenhed, har den vigtige begrænsninger, som skal forstås, når man evaluerer sprogmodeller. En væsentlig begrænsning er, at perpleksitet ikke måler forståelse—en model med lav perpleksitet kan stadig generere usammenhængende, irrelevant eller faktuelt forkert tekst. Måleenheden måler kun modellens evne til at forudsige det næste ord baseret på statistiske mønstre i træningsdataene, ikke om modellen reelt forstår betydningen eller konteksten af indholdet. Det betyder, at en model kan opnå fremragende perpleksitet scores, mens den genererer tekst, der er grammatisk korrekt, men semantisk meningsløs eller faktuelt forkert.

En anden vigtig overvejelse er, at perpleksitet ikke effektivt indfanger langtidssammenhæng. Måleenheden er baseret på umiddelbare ordforudsigelser og afspejler ikke nødvendigvis, hvor godt en model opretholder sammenhæng og konsistens over længere tekststykker. Derudover er følsomhed over for tokenisering en kritisk faktor—forskellige tokeniseringsmetoder kan have stor indflydelse på perpleksitet scores, hvilket gør direkte sammenligninger mellem modeller, der bruger forskellige tokeniseringsformer, problematiske. For eksempel kan tegnbaserede modeller opnå lavere perpleksitet end ord-baserede modeller, men det betyder ikke nødvendigvis, at de genererer bedre tekst. Desuden er perpleksitet primært designet til autoregressive eller kausale sprogmodeller og er ikke veldefineret for maskerede sprogmodeller som BERT, der anvender andre forudsigelsesmekanismer.

For at opnå en fyldestgørende vurdering af sprogmodellens præstation bør perpleksitet bruges sammen med andre evalueringsmålinger og ikke som et enkeltstående mål. BLEU, ROUGE og METEOR er udbredte målinger, der sammenligner genereret tekst med reference-tekster og er særligt værdifulde for opgaver som maskinoversættelse og opsummering. Menneskelig evaluering foretaget af kvalificerede dommere giver indsigt i aspekter, som automatiske målinger ikke kan indfange, herunder flydende, relevans, sammenhæng og overordnet kvalitet. Faktuel nøjagtighed vurderes med vidensbaserede QA-systemer eller faktatjek, så det sikres, at genereret indhold ikke kun er flydende, men også korrekt. Diversity og kreativitet målinger såsom gentagelsesrate, nyhedsscore og entropi måler, hvor varieret og original den genererede tekst er, hvilket er vigtigt for kreative anvendelser.

Derudover sikrer evaluering af modeller for bias og fairness, at de kan implementeres sikkert i virkelige applikationer, hvor skadelige skævheder kan give store problemer. Ved at kombinere perpleksitet med disse ekstra måleenheder kan udviklere bedre evaluere modellens forudsigelsesnøjagtighed, flydende og anvendelighed i praksis. Denne helhedsorienterede tilgang gør det muligt at identificere modeller, der ikke bare forudsiger korrekt, men også gør det med sikkerhed, sammenhæng og pålidelighed. Kombinationen af målinger giver et mere komplet billede af modellens præstation og hjælper med at sikre, at udvalgte modeller lever op til de specifikke krav, deres tiltænkte applikation stiller.

Perpleksitet score bruges bredt i mange virkelige applikationer, hvor sprogmodellens præstation direkte påvirker brugeroplevelsen og indholdskvaliteten. I tekstgenerering hjælper perpleksitet med at sikre, at genereret indhold er sammenhængende og flydende ved at bekræfte, at modellens forudsigelser er sikre og kontekstuelt passende. For maskinoversættelsessystemer vurderer perpleksitet, hvor godt oversættelsesmodellen forudsiger det næste ord på målsproget, hvilket er afgørende for at producere oversættelser af høj kvalitet, der bevarer betydning og nuance fra kildesproget. I chatbots og virtuelle assistenter sikrer lav perpleksitet, at svarene er flydende og kontekstuelt passende, hvilket direkte forbedrer brugerens tilfredshed og interaktion.

Opsummeringsmodeller drager fordel af perpleksitetsevaluering ved at sikre, at genererede resuméer er læsbare og sammenhængende, mens de bevarer vigtig information fra kildeteksten. Indholdsskabere og AI-platforme bruger perpleksitet til at vurdere kvaliteten af AI-genereret indhold, før det offentliggøres eller præsenteres for brugerne. Efterhånden som AI-drevet indholdsgenerering bliver stadig mere udbredt på søgemaskiner og svarplatforme, hjælper forståelse og overvågning af perpleksitet score med at sikre, at genereret indhold lever op til kvalitetsstandarder. Organisationer, der arbejder med AI-systemer, kan bruge perpleksitetsmålinger til at identificere, hvornår modeller har behov for genoptræning, finjustering eller udskiftning for at opretholde ensartet indholdskvalitet og brugerens tillid til AI-genererede svar.

Spor hvordan dit indhold vises i AI-svar på tværs af ChatGPT, Perplexity og andre AI-søgemaskiner. Sikr at dit brand får korrekt kildeangivelse i AI-genererede svar.

Perpleksitets-score måler tekstforudsigelighed i sprogmodeller. Lær hvordan denne centrale NLP-måling kvantificerer modelusikkerhed, dens beregning, anvendelser...

Fællesskabsdiskussion om perplexity score i indhold og sprogmodeller. Forfattere og AI-eksperter diskuterer, om det har betydning for indholdsskabelse og optime...

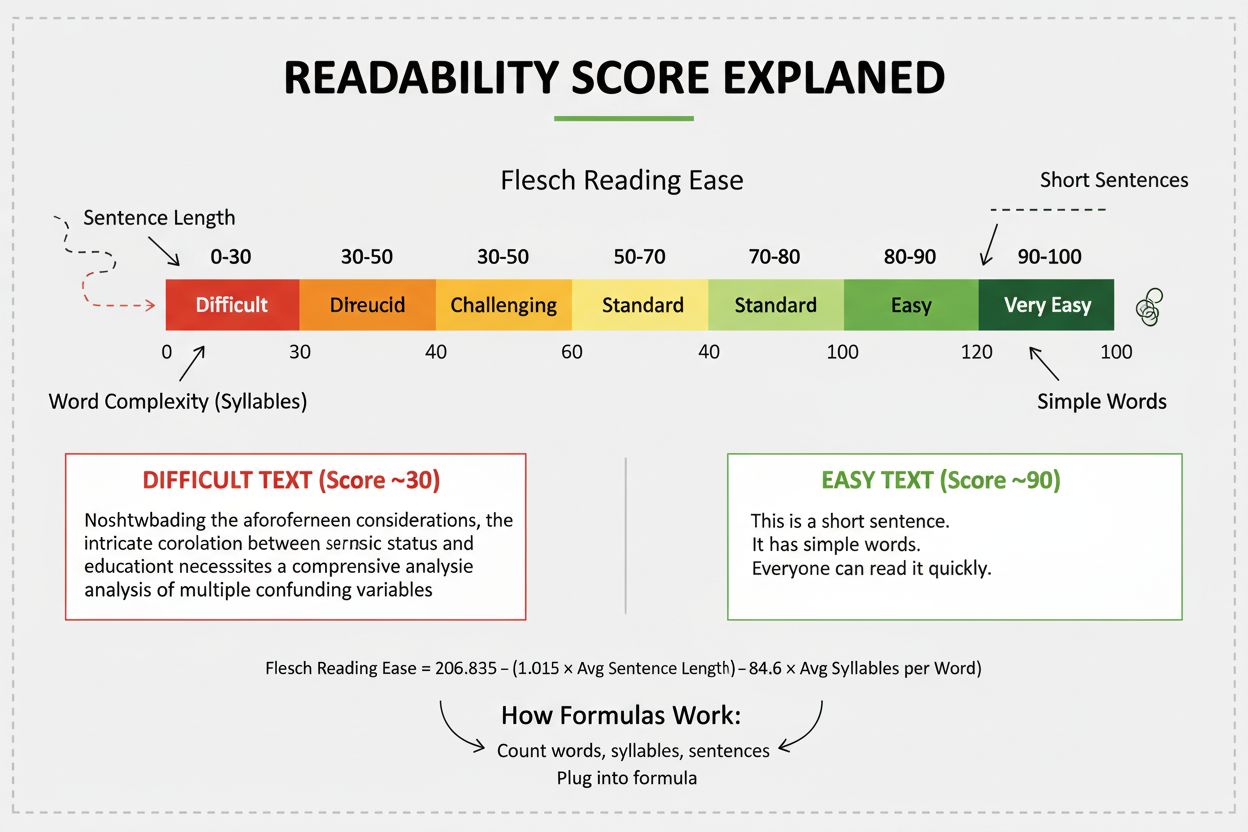

Læselighedsscore måler hvor svært indhold er at forstå baseret på sproglig analyse. Lær hvordan Flesch, Gunning Fog og andre formler påvirker SEO, brugerengagem...

Cookie Samtykke

Vi bruger cookies til at forbedre din browsingoplevelse og analysere vores trafik. See our privacy policy.